TimeSformer 是首個(gè)完全基于 Transformer 的視頻架構(gòu)。近年來,Transformer 已成為自然語言處理(NLP)領(lǐng)域中許多應(yīng)用的主導(dǎo)方法,包括機(jī)器翻譯、通用語言理解等。

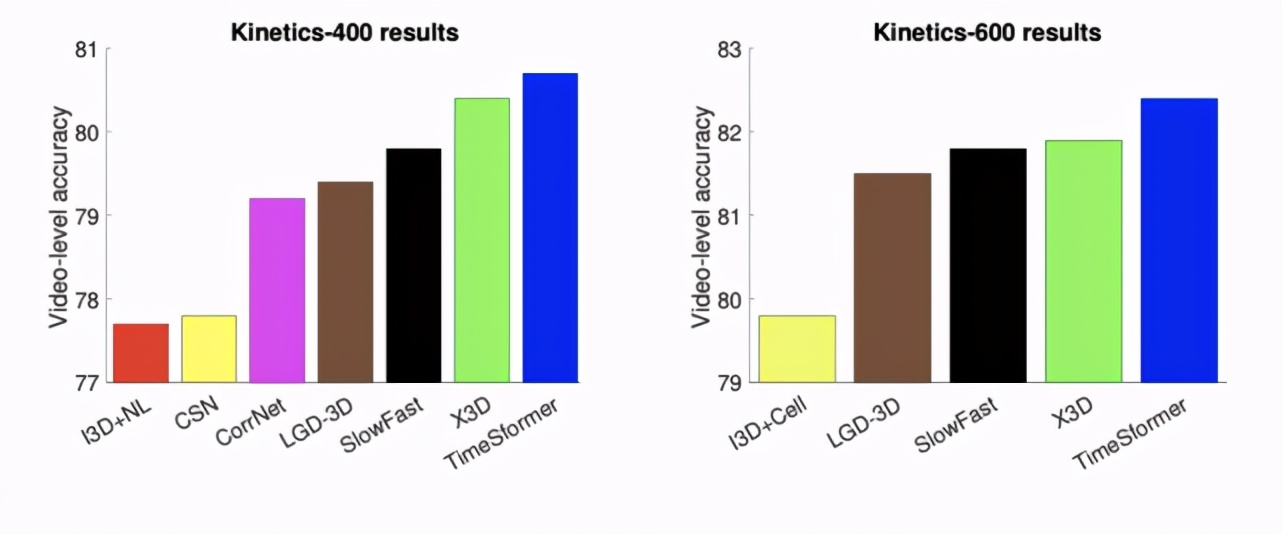

TimeSformer 在一些具有挑戰(zhàn)性的動(dòng)作識(shí)別基準(zhǔn)(包括 Kinetics-400 動(dòng)作識(shí)別數(shù)據(jù)集)上實(shí)現(xiàn)了最佳的性能。此外,與 3D 卷積神經(jīng)網(wǎng)絡(luò)(CNN)相比,TimeSformer 的訓(xùn)練速度大約快了 3 倍,而推斷所需的計(jì)算量不足其十分之一。

論文鏈接:

https://arxiv.org/pdf/2102.05095.pdf

此外,TimeSformer 的可擴(kuò)展性使得在更長的視頻片段上訓(xùn)練更大的模型成為可能。這為 AI 系統(tǒng)理解視頻中更復(fù)雜的人類行為打開了大門,對需要理解人類復(fù)雜行為的 AI 應(yīng)用來說是極為有益的。

在 Kinetics-400(左) 和 Kinetics-600(右) 兩個(gè)動(dòng)作識(shí)別基準(zhǔn)上,TimeSformer 與當(dāng)前具有 SOTA 性能的 3D 卷積神經(jīng)網(wǎng)絡(luò)的視頻分類準(zhǔn)確率比較結(jié)果。TimeSformer 在這兩個(gè)數(shù)據(jù)集上都達(dá)到了最優(yōu)的準(zhǔn)確率。

TimeSformer:全新的視頻理解架構(gòu)

傳統(tǒng)的視頻分類模型利用了 3D 卷積濾波器。然而這樣的濾波器在捕獲局部時(shí)空區(qū)域內(nèi)的短程模式方面是有效的,但是它們不能對超出其接受域的時(shí)空依賴關(guān)系進(jìn)行建模。

TimeSformer 僅建立在 Transformer 模型中使用的自注意力機(jī)制上,這使得捕獲整個(gè)視頻的時(shí)空依賴關(guān)系成為可能。為了將 Transformer 應(yīng)用到視頻中,該模型將輸入視頻解釋為從每個(gè)幀中提取的圖像 patch 的時(shí)間 - 空間序列。

這種格式類似于 NLP 中使用的格式,在 NLP 中,Transformer 將句子視為從每個(gè)單詞中計(jì)算出的特征向量序列。正如 NLP Transformer 通過將每個(gè)單詞與句子中的其他單詞進(jìn)行比較來推斷其含義一樣,該模型通過顯式地將每個(gè) patch 與視頻中的其他 patch 進(jìn)行比較來捕獲每個(gè) patch 的含義。這也是所謂的自注意力機(jī)制,這使得捕獲相鄰 patch 之間的短程依賴性以及遠(yuǎn)距離 patch 之間的遠(yuǎn)程關(guān)聯(lián)成為可能。

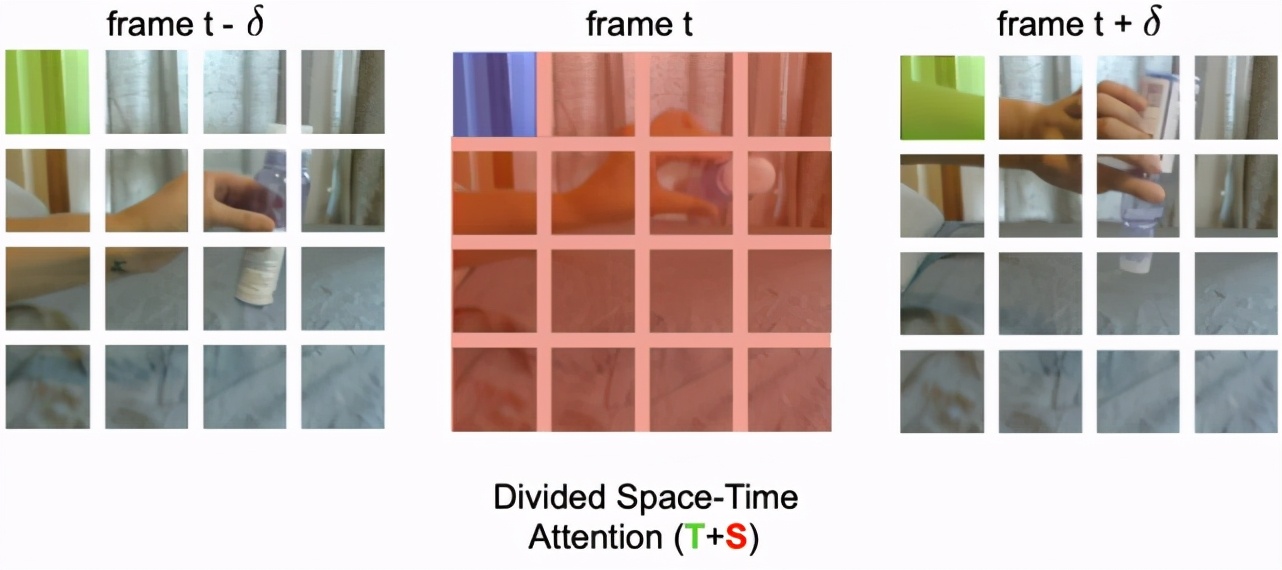

傳統(tǒng)的 3D 卷積神經(jīng)網(wǎng)絡(luò)計(jì)算成本比較高昂,因?yàn)樗鼈冃枰谝曨l中所有的空間 - 時(shí)間位置上使用大量的濾波器。而 TimeSformer 具有較低的計(jì)算成本,因?yàn)樗海?)將視頻分解成一組不重疊的 patch;(2)采用自注意力,避免對所有 patch 對進(jìn)行詳盡的比較。研究者將此方案稱為分割空間 - 時(shí)間注意力,其思想是依次應(yīng)用時(shí)間注意力和空間注意力。

當(dāng)使用時(shí)間注意力時(shí),每個(gè) patch(例如在下圖中,藍(lán)色的正方形)只與其他幀中相同空間位置的 patch(綠色正方形)進(jìn)行比較。如果視頻包含 T 幀,則每個(gè) patch 只進(jìn)行 T 次時(shí)間上的比較。當(dāng)使用空間注意力時(shí),每個(gè) patch 僅與同一幀內(nèi)的 patch(紅色 patch)進(jìn)行比較。

因此,如果 N 是每幀中的 patch 數(shù),則分割空間 - 時(shí)間注意力只對每個(gè) patch 執(zhí)行一共(T+N)次比較,而不是聯(lián)合空間 - 時(shí)間注意力的方法所需的(T×N)次比較。此外,該研究發(fā)現(xiàn)與聯(lián)合空間 - 時(shí)間注意力相比,分割空間 - 時(shí)間注意力不僅更有效,而且更準(zhǔn)確。

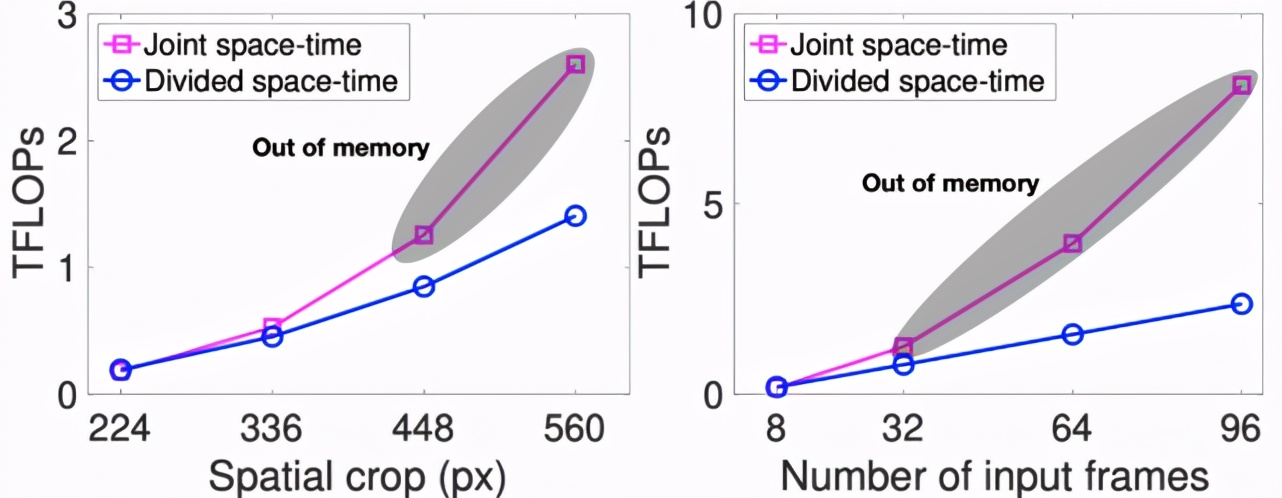

TimeSformer 的可擴(kuò)展性讓它能夠在極長的片段(例如,102 秒時(shí)長的 96 幀序列)上運(yùn)行,以執(zhí)行超長程時(shí)間建模,這明顯不同于當(dāng)前的 3D CNN。后者僅限于處理至多幾秒鐘的片段。而識(shí)別長時(shí)間活動(dòng)是一種重要需求。

例如,假設(shè)有一個(gè)制作法式吐司的視頻。一次分析幾秒鐘的 AI 模型可能會(huì)識(shí)別出一些原子動(dòng)作(例如打雞蛋或?qū)⑴D痰谷胪胫校5珜γ總€(gè)單獨(dú)動(dòng)作進(jìn)行分類,對于分類復(fù)雜活動(dòng)是遠(yuǎn)遠(yuǎn)不夠的。TimeSformer 則可以在更長的時(shí)間范圍內(nèi)分析視頻,從而揭示出原子動(dòng)作之間明確的依賴關(guān)系(例如將牛奶和已經(jīng)打好的雞蛋混合)。

TimeSformer 的高效讓在高空間分辨率(例如高達(dá) 560x560 像素的幀)和長視頻(包括高達(dá) 96 幀)上訓(xùn)練模型成為可能。

上圖展示了由 TimeSformer 學(xué)習(xí)的自注意力熱圖的可視化。第一行是原始幀,第二行通過自注意力給出的視頻分類重要性來加權(quán)每個(gè)像素的顏色(被認(rèn)為不重要的像素會(huì)變暗)。TimeSformer 學(xué)習(xí)參與視頻中的相關(guān)區(qū)域,以執(zhí)行復(fù)雜的時(shí)空推理。

促進(jìn)更多領(lǐng)域的發(fā)展

為了訓(xùn)練視頻理解模型,目前最好的 3D CNN 只能使用幾秒長的視頻片段。使用 TimeSformer 可以在更長的視頻片段(長達(dá)幾分鐘)上進(jìn)行訓(xùn)練。這可能會(huì)極大地促進(jìn)研究工作,以教會(huì)機(jī)器理解視頻中復(fù)雜的長動(dòng)作。對于許多旨在了解人類行為的 AI 應(yīng)用程序(例如 AI 助手)而言,這是重要的一步。

此外,TimeSformer 的低推理成本是邁向未來實(shí)時(shí)視頻處理應(yīng)用的重要一步,例如 AR/VR,以及為可穿戴攝像機(jī)視頻提供服務(wù)的智能助手。研究者相信該方法的成本降低將使更多的研究人員致力于解決視頻分析問題,從而加快該領(lǐng)域的研究進(jìn)展。