超強寫作AI竟然學會象棋和作曲,語言模型跨界操作引熱議,在線求戰

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

一個搞文本生成的模型,還能用來干嘛?

好奇心很強的網友便拿OpenAI的GPT-2做了個實驗。

原來,GPT-2除了能生成文本,竟然還能下象棋、做音樂!

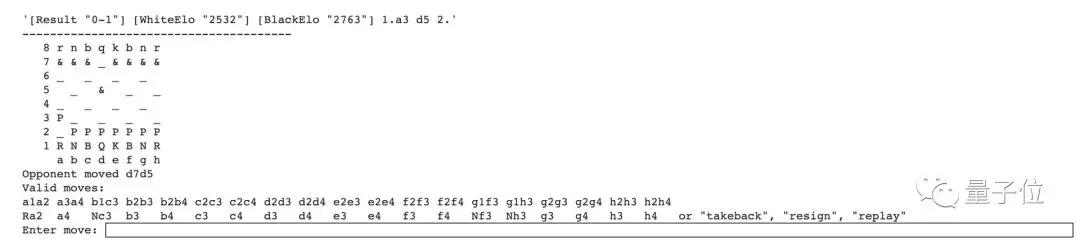

△訓練GPT-2下國際象棋

作者表示:

事實證明,只要讓 GPT-2預測下一步棋,就可以訓練它下國際象棋。

這只是花費了幾天的小項目,但結果是相當令人興奮。

除此之外,在更早的實驗中,研究人員還發現GPT-2能作曲。

這也引起了網友們的熱烈討論。

這簡直太瘋狂了,和玩得較差的人類尚可一搏。

GPT-2學會了下國際象棋,盡管它只是一種文本AI,但是還是能夠從象棋符號文本的語料庫中學習。

而且它對“棋盤”的概念一無所知。

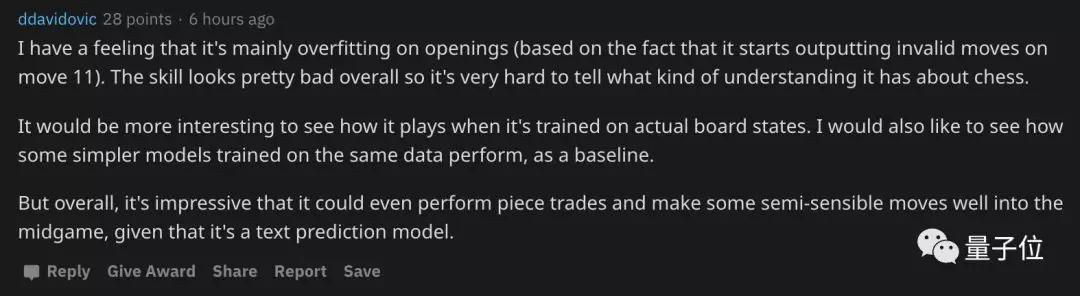

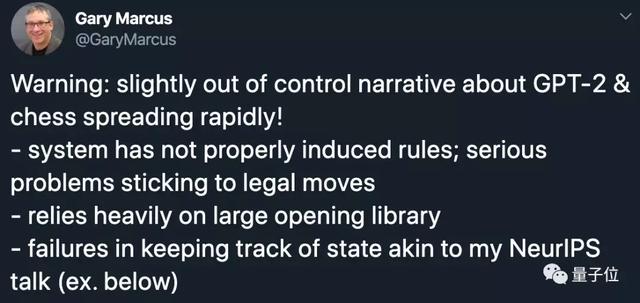

不過,也有網友對此提出了質疑。

我有一種感覺,它只是在開局的較為配合,從第11步開始就輸出無效的“招式”了。

總的來說,這個技術看起來很糟糕,所以很難判斷它對國際象棋有什么樣的理解。

不過作為一個文本預測模型,在這樣的游戲中能做出一些智能的舉動,還是令人印象深刻的。

那么,GPT-2下國際象棋、做音樂,到底是怎么一回事呢?

下象棋、做音樂,GPT-2成跨界選手

用GPT-2來下象棋,最開始大概只是一個娛樂項目。作者肖恩·普萊斯(Shawn Presser)只用了一周的時間就完成了Demo。

之所以做出這樣大膽的嘗試,是因為他的胖友格溫·布蘭文(Gwern Branwen)不僅教會了GPT-2寫詩:

美麗的湖,美麗的樹林,(Fair is the lake, and bright the wood,)

垂滿魅惑的花朵:(With many a flower-full glamour hung:)

美麗的淺灘,溫柔的潮水(Fair are the banks; and soft the flood)

我們的舌頭發出金色的歡笑。(With golden laughter of our tongue.)

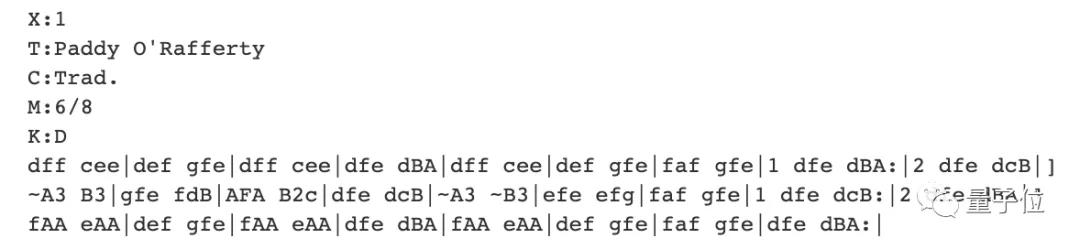

還讓GPT-2寫出了愛爾蘭民歌:

音樂_2.mp3

00:50.058

乍一聽這個開頭,甚至有點像孫燕姿的《遇見》。

實際上,布蘭文是用Session & ABCnotation.com上的20多萬首音樂作品對GPT-2模型進行了訓練,這些作品將樂曲以字母文本的形式體現。

所以,能不能通過e2e4(將棋子從e2位置移動到e4位置)這樣的國際象棋指令集來訓練GPT-2,讓這個文本生成模型學會下棋呢?

答案是:可以。

普萊斯發現,僅僅經過一個小時的訓練,GPT-2 1.5B模型就表現出了國際象棋“天賦”。

雖然在下了幾步棋之后,就會出現無效移動,但這次實驗還是證明了,制造GPT-2國際象棋引擎并非不可能。

△第9步出現無效移動

于是,普萊斯又用2.4M數據訓練了GPT-2 1.5B模型一整天,模型有所進步:直到第14步,它才出現了bug。

接著,普萊斯“編寫了一些代碼以計算所有有效移動的概率”(作者并未作出具體解釋),GPT-2可以將棋局推至殘局了。

普萊斯已經把他的代碼部署到了Colab上,如果你想試試這只會下棋的GPT-2棋商如何,可以親身前往挑戰:

逆天的語言AI—GPT-2

去年2月,OpenAI發布了一個“逆天”的語言AI,名為GPT-2。

整個模型包含15億個參數。

這個AI寫起文章來文思泉涌毫無違和感,無需針對性訓練就能橫掃各種特定領域的語言建模任務,還具備閱讀理解、問答、生成文章摘要、翻譯等等能力。

然而,當時假新聞實在編的太真實,所以OpenAI說:我們不敢放出完整模型。

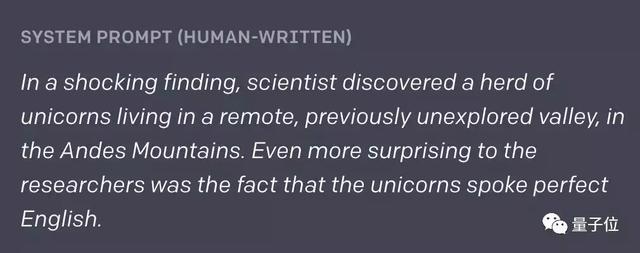

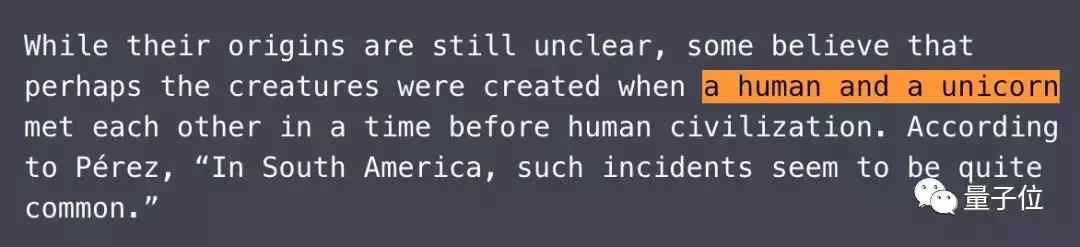

人類只給了它兩句話的開頭:

科學家們有個令人震驚的發現,在安第斯山脈一個偏遠且沒被開發過的山谷里,生活著一群獨角獸。更加讓人訝異的是,這些獨角獸說著完美的英文。

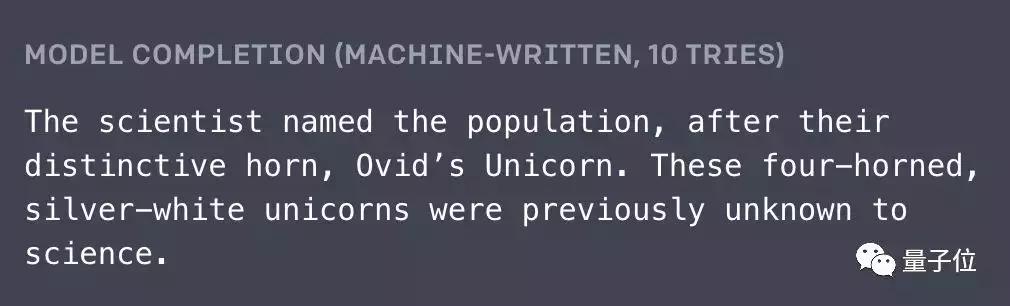

AI就順著這胡言亂語的設定,一本正經地編了下去:

這些生物有著獨特的角,科學家們就以此為它們命名,叫Ovid’s Unicorn。長著四只角的銀白色生物,在這之前并不為科學界所知。

雖然,這些生物的起源還不清楚,但有些人相信,它們是一個人和一個獨角獸相交而誕生的,那時人類文明還不存在。Pérez教授說:“在南美洲,這樣的現象很常見。”

效果驚人外,在各種特定領域數據集的語言建模測試中,GPT-2都取得了優異的分數。

網友們對其完全開源的呼聲越發強烈,于是在接下來的時間里,GPT-2經歷了“擠牙膏式的開源”。

它初出茅廬時先放出了124M版本的模型,然后是355M,再然后是774M。

經過9個月斷斷續續發布,OpenAI最終把15億參數的完整模型放了出來。

實測結果如何?

OpenAI在博客里說,GPT-2的生成結果,有獨立客觀第三方的檢驗,令人信服:

團隊在康奈爾大學的合作伙伴,對人類做了問卷調查,給GPT-2輸出的文本打出可信分 (Credibility Score) ,各種大小的模型都參與了。

滿分10分,大家給15億參數模型的可信分是6.91。比7.74億參數的模型 (6.72分) 和 3.55億參數的模型 (6.07分) 都要高。

也就是說在人類眼里,15億參數模型,比之前放出的那些模型,寫出的文章更逼真了。

語言模型跨界引熱議

超會編故事的NLP模型,現在還能寫曲子、下象棋了,這件事引發了網友的熱議,甚至吸引來了馬庫斯。

英國作家Tom Chivers認為,這或許將打開通向AGI(通用人工智能)的新思路。

有網友質疑說,這并不是對下棋這件事的“學習”,只是在統計學上將給定的開局動作與其相應的后續動作關聯起來。GPT-2僅僅是給出了符合已知模式的結果。

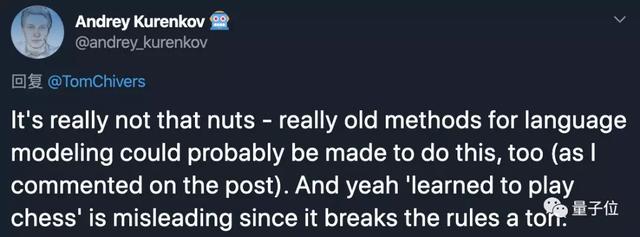

一位斯坦福CS博士則直言,可能使用非常古早的語言建模方法同樣能實現這一結果。說GPT-2“學會下棋”是一種誤導。

那么,你怎么看呢?

作者介紹

△Shawn Presser

Shawn Presser,具有豐富的C++游戲引擎編程經驗,是一位圖形學編程人員、工具開發者。

2010年至2011年,就職于S2 Games,參與Heroes of Newerth游戲項目的相關工作。

2005年至2008年,就職于Simutronics,主要從事基于C++的項目開發工作。

傳送門

Reddit:

https://www.reddit.com/r/MachineLearning/comments/elf66h/p_using_gpt2_to_play_chess/

博客:

https://slatestarcodex.com/2020/01/06/a-very-unlikely-chess-game/

作者資料:

https://www.linkedin.com/in/shawnpresser/

Demo:

https://colab.research.google.com/drive/12hlppt1f2N0L9Orp8YCLgon6EF5V3vuR#scrollTo=8gxTLCKBQ3-F&forceEdit=true&sandboxMode=true