運行LIama2得8400萬元!最快AI推理芯片成本推算引熱議

想實現(xiàn)史上最快大模型推理,得要1171萬美元(8410萬元)???

同等項目下,使用英偉達GPU成本只需30萬美元……

關(guān)于最強AI芯片易主Groq,可能得讓子彈再飛一會兒了。

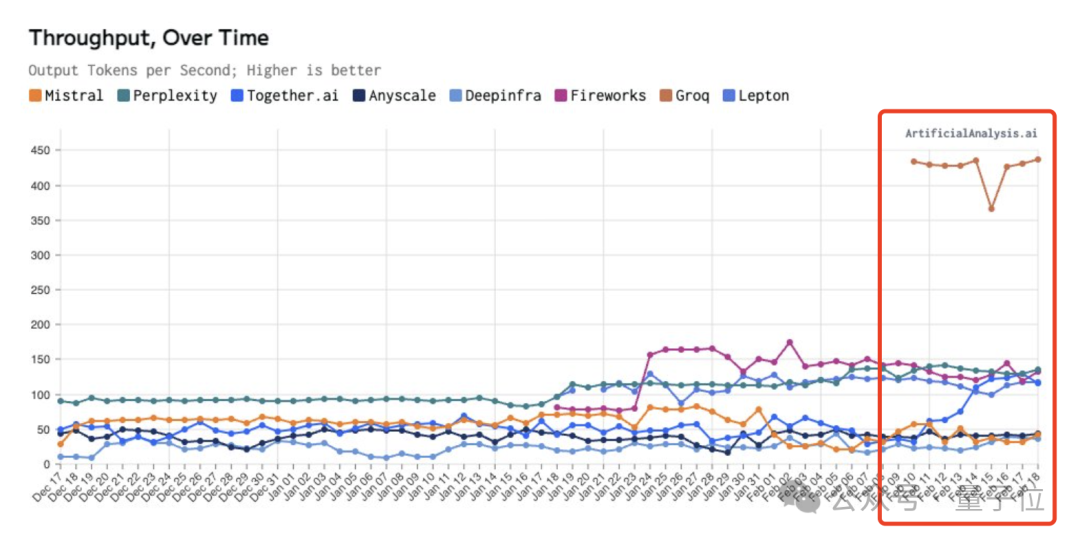

這兩天,Groq驚艷亮相。它以號稱“性價比高英偉達100倍”的芯片,實現(xiàn)每秒500tokens大模型生成,感受不到任何延遲。外加谷歌TPU團隊這樣一個高精尖人才Buff,讓不少人直呼:英偉達要被碾壓了……

喧囂過后開始出現(xiàn)一些理智討論,其中主要還是針對Groq的效益成本問題。

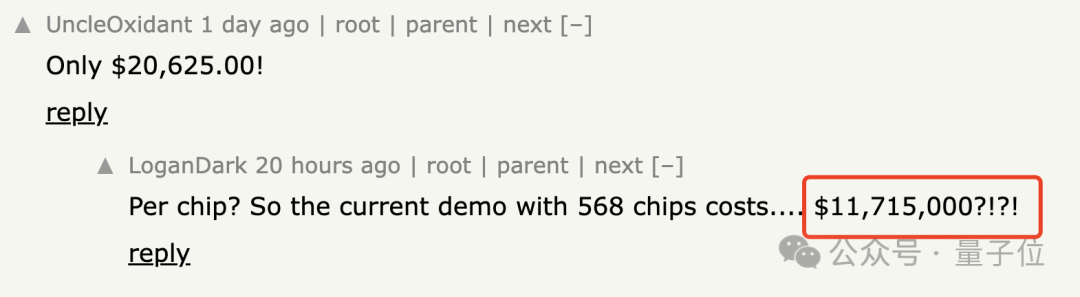

網(wǎng)友粗略一算,現(xiàn)在演示Demo就需要568塊芯片,花費1171萬美元。

于是乎,業(yè)內(nèi)業(yè)外各界人士不約而同地展開了一場算術(shù)大法。

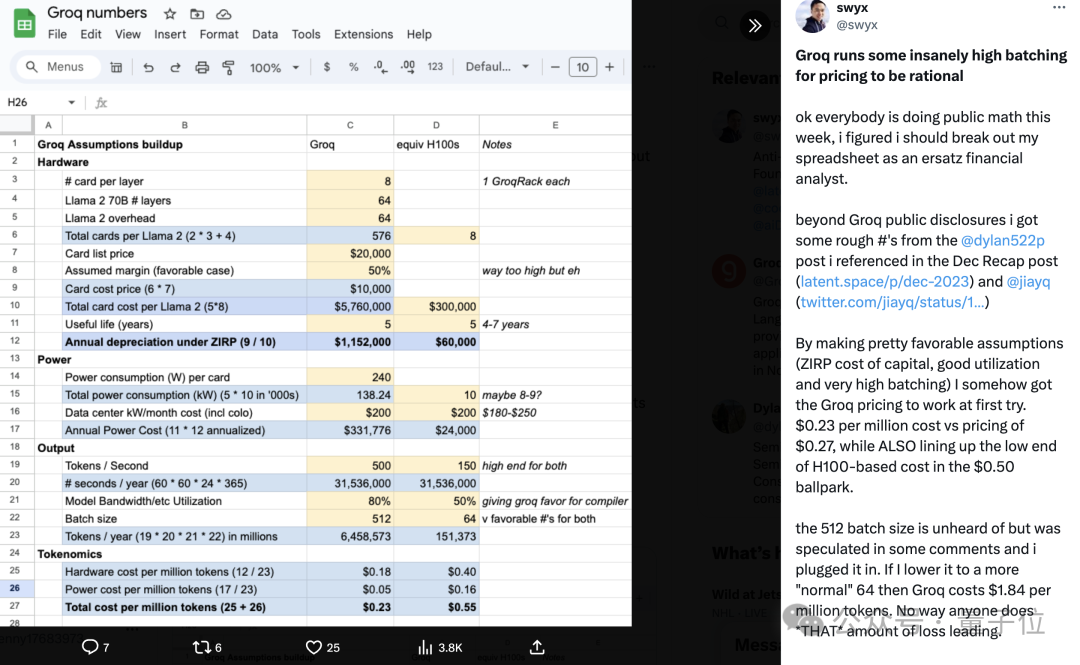

甚至出現(xiàn)了位分析師,拿著表格現(xiàn)身說法……

并感嘆了句:OK,everybody is doing public math this week.

不過Groq也第一時間在社交網(wǎng)絡(luò)上進行了回應(yīng)。

“每個人都在做數(shù)學(xué)”

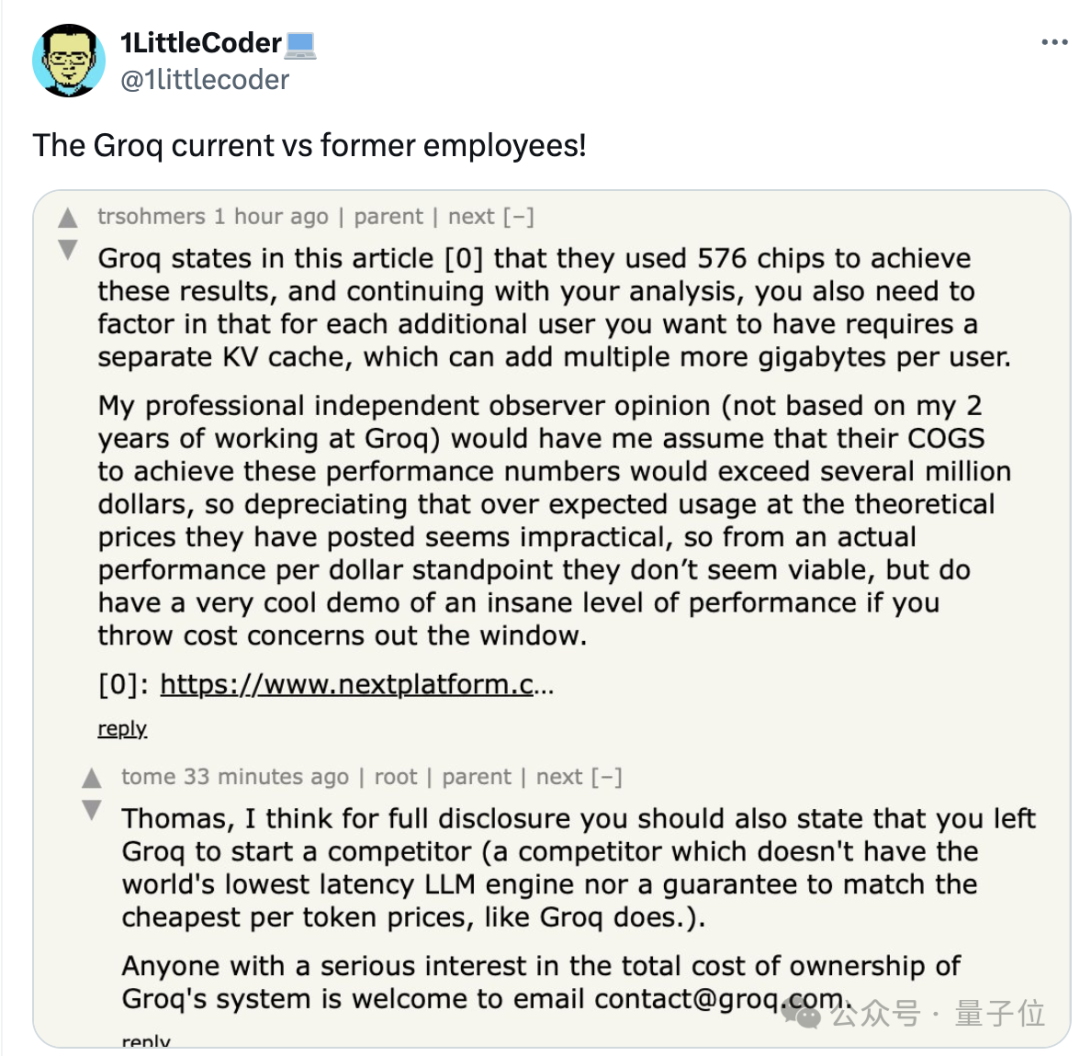

參與到Groq成本問題討論的,有計算機學(xué)生,也有同提供推理服務(wù)的云廠商,甚至還有Groq前員工大戰(zhàn)現(xiàn)員工……好不熱鬧。

摘取幾個有代表性的,我們來看看大家都是如何看待的。

首先一個粗略估計,一張卡的價格約為2萬美元,內(nèi)存又僅為0.23GB。

那么為單個LLama 70B模型服務(wù),就需要購買大約320張卡(實際上更多),包括服務(wù)器在內(nèi)大約花費1千萬美元……

而要是跟英偉達的H100對比,情況又是如何?

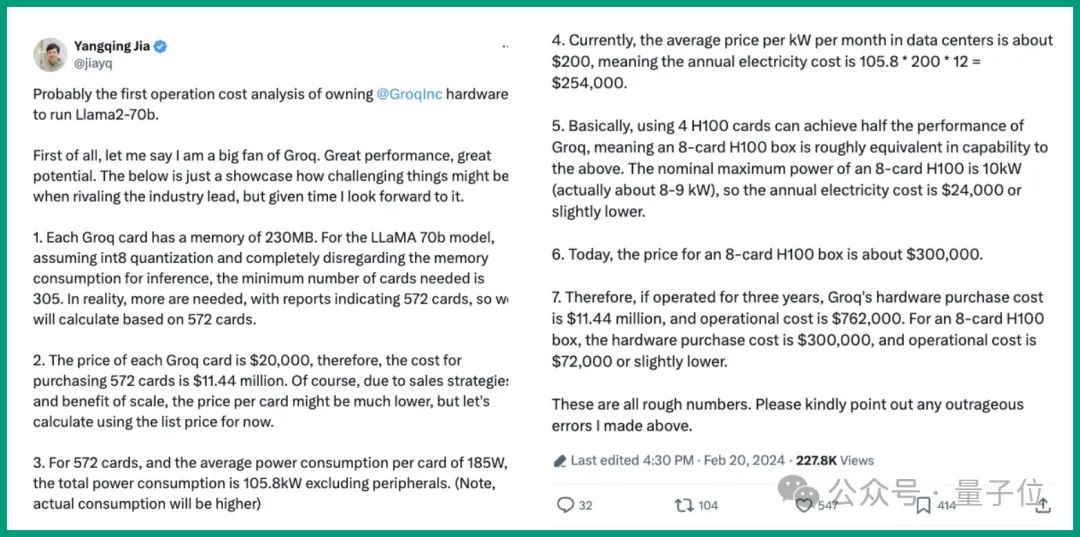

Lepton的賈揚清也參與進來,算了一筆賬。除了基本價格,他還從能源功耗、性能、運營成本等角度進行了分析。

最終總結(jié)出這幾個核心觀點:

- 對于LLaMA 70b模型,使用572張卡來計算,每年電費將花費25.4萬美元;

- 使用4張H100卡可以實現(xiàn)Groq一半的性能,如今8卡H100盒子的價格約為30萬美元。

- 如果運營三年,Groq 的硬件采購成本為1144萬美元,運營成本為76.2萬美元。相比起來H100采購和運營成本更低。

值得一提的是,在Groq給出的基準(zhǔn)測試中,也包括了Lepton在內(nèi),推理速度大概是Lepton的三倍。

賈揚清還透露,他跟Groq創(chuàng)始人是舊相識了:

在谷歌時就相互知道。

不過在這些討論中,也有其他算法。

比如有網(wǎng)友反應(yīng),按照單個Token價格這個維度來計算,情況又是如何呢?

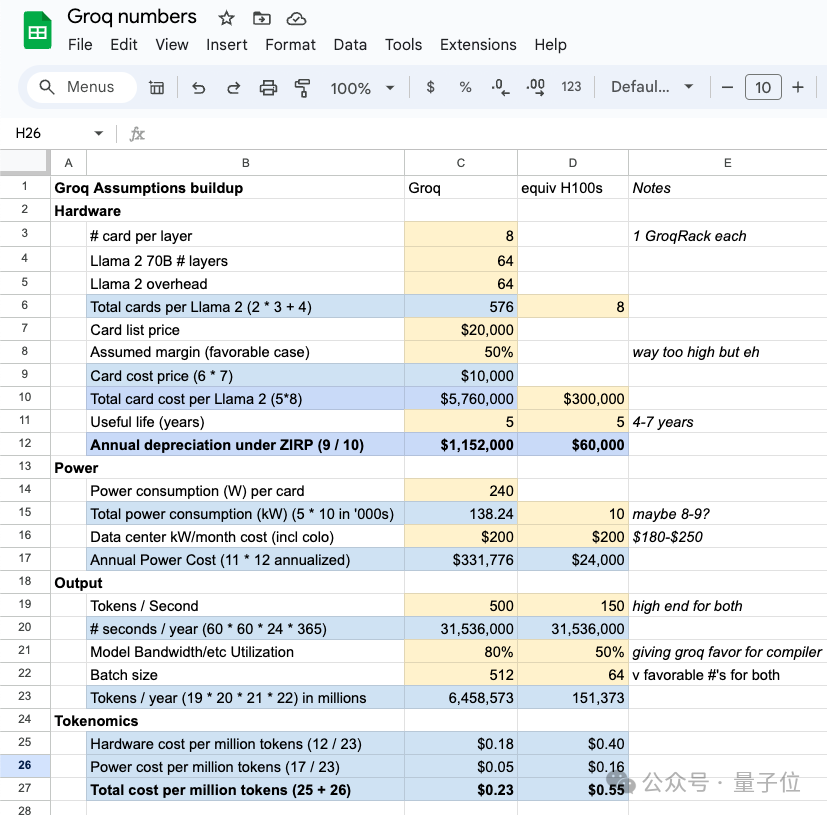

沒關(guān)系,還有更專業(yè)的分析師會出手。

不過根據(jù)他的計算,每100萬Tokens的花費,Groq性價比是要高一些。

除此之外,還有一些其他的討論,像是否支持加速任何Transformer?

Groq在線答疑

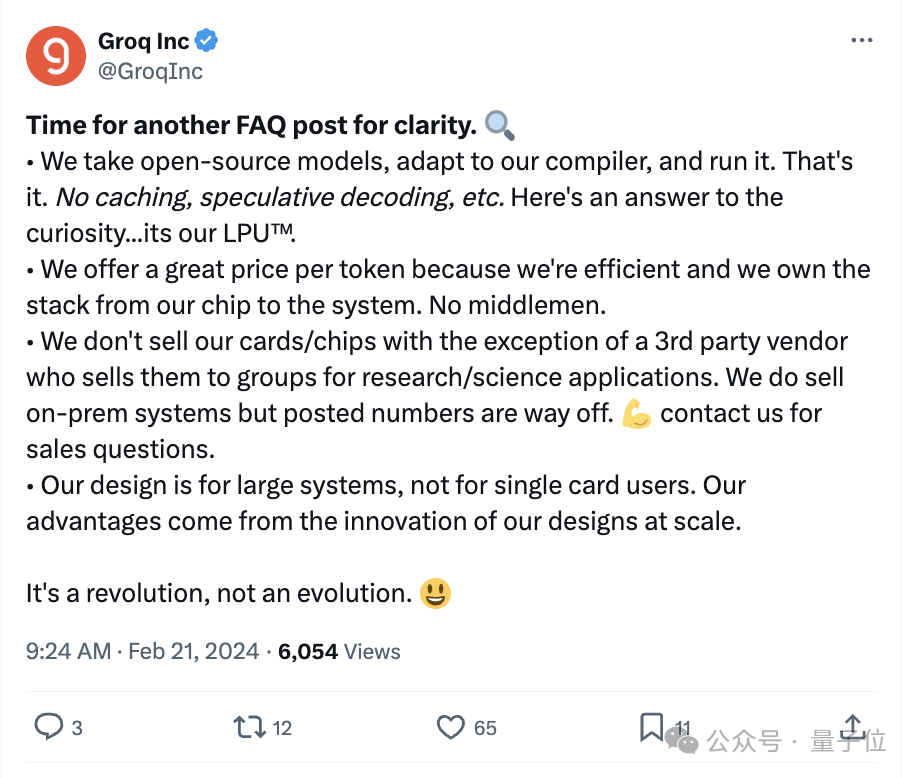

由于大家過于關(guān)注,Groq忍不住親自下場解答。

是時候再發(fā)一個常見問題帖子來澄清了。

主要有以下幾點:

- 采用開源模型,適應(yīng)我們的編譯器,然后運行它,僅此而已。

- 我們token價格很實惠很高效,因為從芯片到系統(tǒng)都自己搞,沒有中間商;

- 不會出售芯片,但第三方供應(yīng)商除外;公布的銷售數(shù)據(jù)有偏差。

- 我們的目標(biāo)客戶不是單卡用戶。

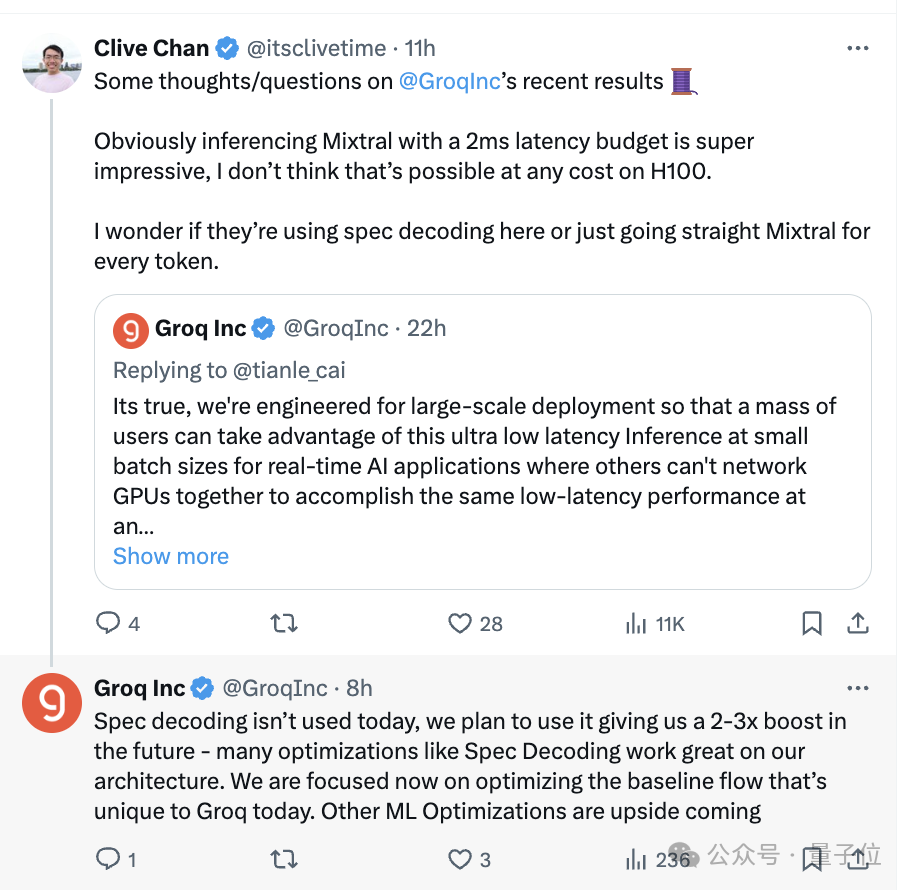

另外還在持續(xù)地在線答疑中……

所以Groq是否能真的撼動住英偉達的地位,估計還得再等一等。

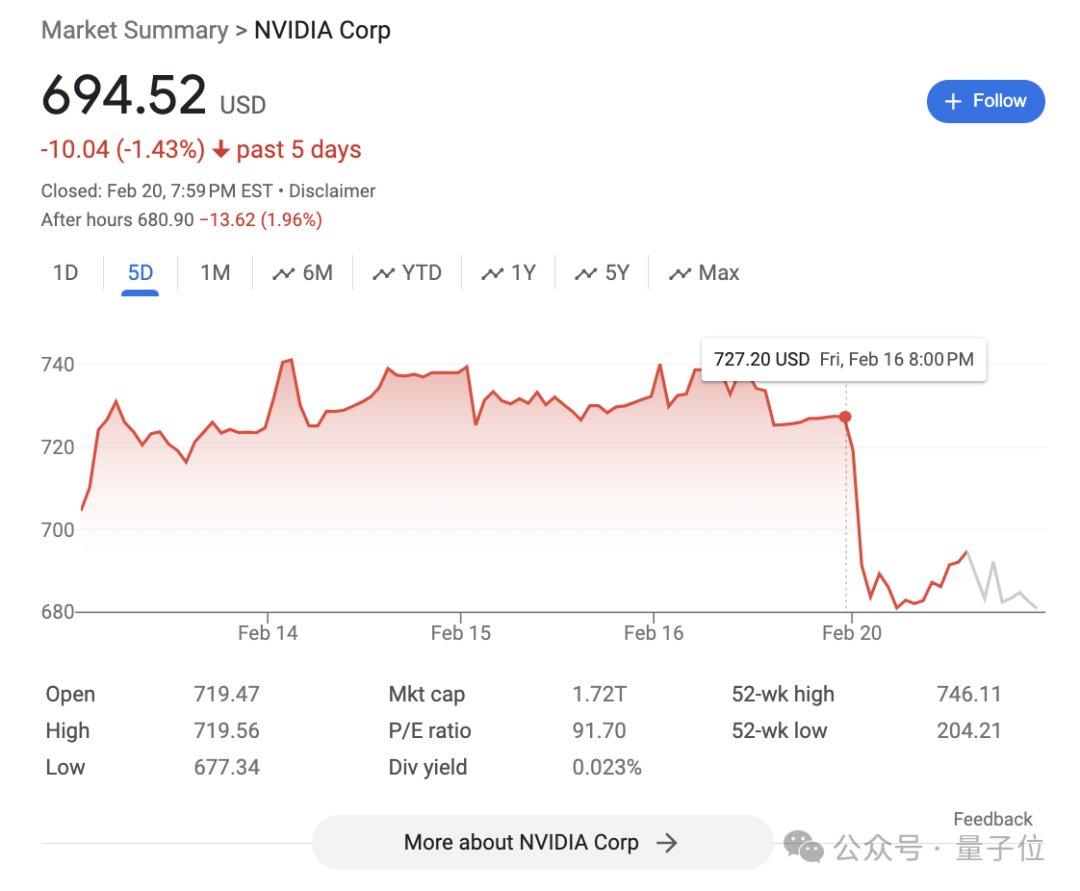

不過昨天英偉達股價倒是異動了一波……