知識圖譜數據構建的“硬骨頭”,阿里工程師如何拿下?

阿里妹導讀:搜索“西紅柿”,你不但能知道它的營養功效、熱量,還能順帶學會煲個牛腩、炒個雞蛋!搜索引擎何時變成“暖男”了?原來背后有“知識圖譜”這個強大的秘密武器。

作為近年來搜索領域和自然語言處理領域的熱點,知識圖譜正引領著搜索引擎向知識引擎的轉變。在阿里的“神馬搜索”中,知識圖譜及其相關技術的廣泛應用不僅能幫助用戶找到最想要的信息,更能讓用戶有意想不到的知識收獲。

背景簡介

為了不斷提升搜索體驗,神馬搜索的知識圖譜與應用團隊,一直在不斷探索和完善圖譜的構建技術。其中,開放信息抽取(Open Information Extraction),或稱通用信息抽取,旨在從大規模無結構的自然語言文本中抽取結構化信息。它是知識圖譜數據構建的核心技術之一,決定了知識圖譜可持續擴增的能力。

“神馬搜索”界面

本文聚焦于開放信息抽取中的重要子任務——關系抽取,首先對關系抽取的各種主流技術進行概述,而后結合業務中的選擇與應用,重點介紹了基于 DeepDive 的方法,并詳述它在神馬知識圖譜數據構建工作中的應用進展。

關系抽取概述

關系抽取技術分類

現有的關系抽取技術主要可分為三種 :

- 有監督的學習方法 :該方法將關系抽取任務當做分類問題,根據訓練數據設計有效的特征,從而學習各種分類模型,然后使用訓練好的分類器預測關系。該方法的問題在于需要大量的人工標注訓練語料,而語料標注工作通常非常耗時耗力。

- 半監督的學習方法 :該方法主要采用 Bootstrapping 進行關系抽取。對于要抽取的關系,該方法首先手工設定若干種子實例,然后迭代地從數據從抽取關系對應的關系模板和更多的實例。

- 無監督的學習方法 :該方法假設擁有相同語義關系的實體對擁有相似的上下文信息。因此可以利用每個實體對對應上下文信息來代表該實體對的語義關系,并對所有實體對的語義關系進行聚類。

這三種方法中,有監督學習法因為能夠抽取并有效利用特征,在獲得高準確率和高召回率方面更有優勢,是目前業界應用最廣泛的一類方法。

遠程監督算法

為了打破有監督學習中人工數據標注的局限性,Mintz 等人提出了遠程監督(Distant Supervision)算法,該算法的核心思想是將文本與大規模知識圖譜進行實體對齊,利用知識圖譜已有的實體間關系對文本進行標注。遠程監督基于的基本假設是:如果從知識圖譜中可獲取三元組R(E1,E2)(注:R代表關系,E1、E2 代表兩個實體),且 E1 和 E2 共現與句子S中,則S表達了 E1 和 E2 間的關系R,標注為訓練正例。

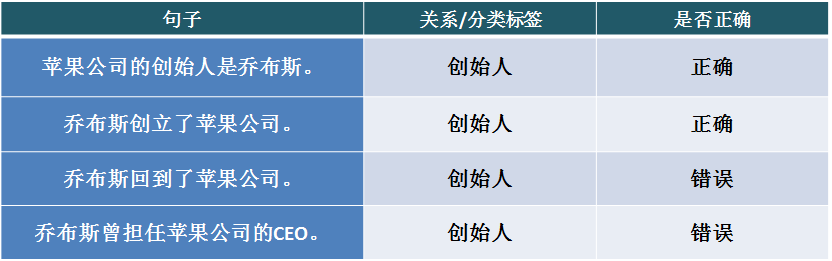

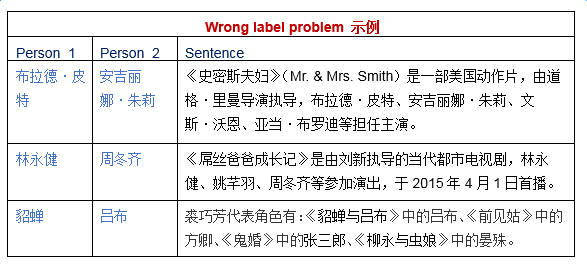

遠程監督算法是目前主流的關系抽取系統廣泛采用的方法,也是該領域的研究熱點之一。該算法很好地解決了數據標注的規模問題,但它基于的基本假設過強,會引入大量噪音數據。例如,從知識圖譜獲取三元組:創始人(喬布斯,蘋果公司),下表句 1 和句 2 正確表達了該關系,但句 3 和句 4 并沒有表達這樣的關系,因此對句 3 和句 4 應用基本假設時會得到錯誤的標注信息。這個問題通常稱為 the wrong label problem。

出現 the wrong label problem 的根本原因,是遠程監督假設一個實體對只對應一種關系,但實際上實體對間可以同時具有多種關系,如上例中還存在 CEO(喬布斯,蘋果公司)的關系,實體對間也可能不存在通常定義的某種關系,而僅因為共同涉及了某個話題才在句中共現。

為了減小 the wrong label problem 的影響,學術界陸續提出了多種改進算法,主要包括:

- 基于規則的方法:通過對 wrong label cases 的統計分析,添加規則,將原本獲得正例標注的 wrong label cases 直接標為負例,或通過分值控制,抵消原有的正標注。

- 基于圖模型的方法:構建因子圖(factor graph)等能表征變量間關聯的圖模型,通過對特征的學習和對特征權重的推算減小 wrong label cases 對全局的影響。

- 基于多示例學習(multi-instance learning)的方法:將所有包含(E1,E2)的句子組成一個 bag,從每個 bag 對句子進行篩選來生成訓練樣本。此類方法最早提出時假設如果知識圖譜中存在R(E1,E2),則語料中含(E1,E2)的所有 instance 中至少有一個表達了關系R。一般與無向圖模型結合,計算出每個包中置信度最高的樣例,標為正向訓練示例。該假設比遠程監督的假設合理,但可能損失很多訓練樣本,造成有用信息的丟失和訓練的不充分。為了能得到更豐富的訓練樣本,又提出了 multi-instance multi-labels 的方法。該方法的假設是,同一個包中,一個 sentence 只能表示(E1,E2)的一種關系,也就是只能給出一個 label,但是不同的 sentence 可以表征(E1,E2)的不同關系,從而得到不同的 label。多 label 標注的 label 值不是正或負,而是某一種關系。它為同時挖掘一個實體對的多種關系提供了可能的實現途徑。另一種改進的方法是從一個包中選取多個 valid sentences 作為訓練集,一般與深度學習方法相結合,這種方法更詳細的講解和實現會安排在后續介紹深度學習模型的章節中。

神馬知識圖譜構建中的關系抽取方法選擇

知識圖譜的數據構建,就數據源而言,分為結構化數據,半結構化數據和無結構數據三類。其中,無結構數據是最龐大、最易獲取的資源,同時也是在處理和利用方面難度最大的資源。神馬知識圖譜構建至今,已經發展為一個擁有近 5000 萬實體,近 30 億關系的大規模知識圖譜。在經歷了前期以結構化和半結構化數據為主的領域圖譜構建階段,神馬知識圖譜的數據構建重點已經逐漸轉移為如何準確高效地利用無結構數據進行實體與關系的自動識別與抽取。這一構建策略使得神馬知識圖譜在通用領域的建設和可持續擴增方面有很強的競爭力。

遠程監督算法利用知識圖譜的已有信息,使得有監督學習中所需的大規模文本標注成為可能。一方面,遠程監督在很大程度上提升了有監督學習關系抽取的規模和準確率,為大規模的知識圖譜數據構建和補充提供了可能;另一方面,遠程監督對現有知識圖譜的數據和規模有較強的依賴,豐富的標注數據對機器學習能力的提升有很大幫助。為了充分利用知識圖譜規模和遠程監督學習這種相輔相成的特性,在神馬知識圖譜的現階段數據構建業務中,我們采用了以圖譜現有的大規模實體與關系數據為依托,以遠程監督算法為工具的關系抽取技術。

在上一章的綜述中,我們介紹過多種基于遠程監督思想的改進方法。在具體的業務實現中,我們選取了領域內與業務需求最為契合的兩種代表性方法:基于 DeepDive 的抽取系統和基于深度學習抽取算法。兩種方法相輔相成,各有優勢:DeepDive 系統較多依賴于自然語言處理工具和基于上下文的特征進行抽取,在語料規模的選擇上更為靈活,能進行有針對性的關系抽取,且能方便地在抽取過程中進行人工檢驗和干預;而深度學習的方法主要應用了詞向量和卷積神經網絡,在大規模語料處理和多關系抽取的人物中有明顯的優勢。在下面的章節中,我們來更詳細地了解這兩種方法的實現與應用。

DeepDive 系統介紹

DeepDive 概述

DeepDive (http://deepdive.stanford.edu/) 是斯坦福大學開發的信息抽取系統,能處理文本、表格、圖表、圖片等多種格式的無結構數據,從中抽取結構化的信息。系統集成了文件分析、信息提取、信息整合、概率預測等功能。Deepdive 的主要應用是特定領域的信息抽取,系統構建至今,已在交通、考古、地理、醫療等多個領域的項目實踐中取得了良好的效果;在開放領域的應用,如 TAC-KBP 競賽、維基百科的 infobox 信息自動增補等項目中也有不錯的表現。

DeepDive 系統的基本輸入包括:

- 無結構數據,如自然語言文本

- 現有知識庫或知識圖譜中的相關知識

- 若干啟發式規則

DeepDive 系統的基本輸出包括:

- 規定形式的結構化知識,可以為關系(實體1,實體2)或者屬性(實體,屬性值)等形式

- 對每一條提取信息的概率預測

DeepDive 系統運行過程中還包括一個重要的迭代環節,即每輪輸出生成后,用戶需要對運行結果進行錯誤分析,通過特征調整、更新知識庫信息、修改規則等手段干預系統的學習,這樣的交互與迭代計算能使得系統的輸出不斷得到改進。

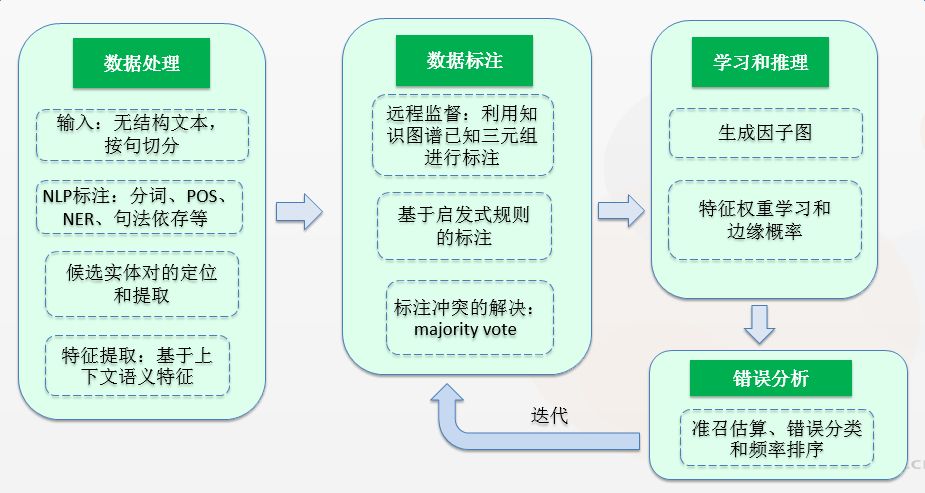

DeepDive 系統架構和工作流程

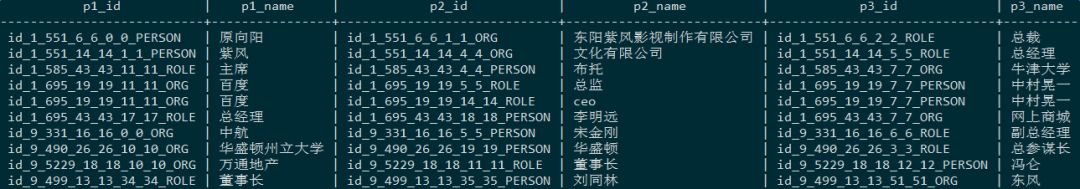

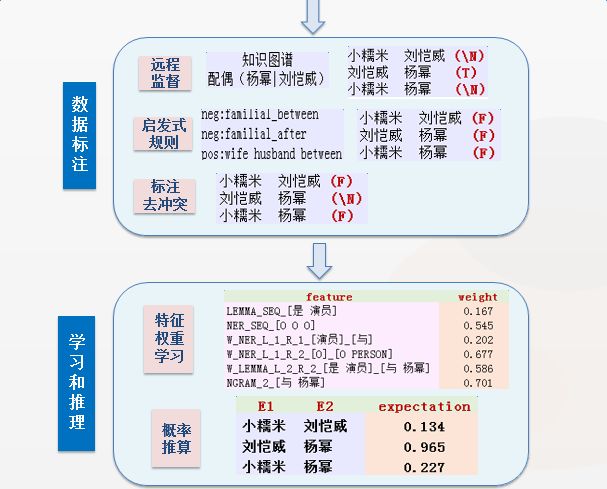

DeepDive 的系統架構如下圖所示,大致分為數據處理、數據標注、學習推理和交互迭代四個流程:

數據處理

1、 輸入與切分

在數據處理流程中,DeepDive 首先接收用戶的輸入數據,通常是自然語言文本,以句子為單位進行切分。同時自動生成文本 id 和每個句子在文本中的 index。doc_id + sentence_index 構成了每個句子的全局唯一標識。

2、 NLP 標注

對于每個切分好的句子,DeepDive 會使用內嵌的 Stanford CoreNLP 工具進行自然語言處理和標注,包括 token 切分,詞根還原、POS 標注、NER 標注、token 在文本中的起始位置標注、依存文法分析等。

3、 候選實體對提取

根據需要抽取的實體類型和 NER 結果,首先對實體 mentions 進行定位和提取,而后根據一定的配對規則生成候選實體對。需要特別注意,在 DeepDive 中,每一個實體 mention 的標定都是全局唯一的,由 doc_id、sentence_index 以及該 mention 在句子中的起始和結束位置共同標識。因此,不同位置出現的同名的實體對(E1,E2)將擁有不同的(E1_id,E2_id),最終的預測結果也將不同。

4、 特征提取

該步驟的目的是將每一個候選實體對用一組特征表示出來,以便后續的機器學習模塊能夠學習到每個特征與所要預測關系的相關性。Deepdive 內含自動特征生成模塊 DDlib,主要提取基于上下文的語義特征,例如兩個實體 mention 間的 token sequence、NER tag sequence、實體前后的n-gram 等。Deepdive 也支持用戶自定義的特征提取算法。

數據標注

在數據標注階段,我們得到了候選實體對以及它們對應的特征集合。在數據標注階段,我們將運用遠程監督算法和啟發式規則,對每個候選實體對進行 label 標注,得到機器學習所需的正例和負例樣本。

1、 遠程監督

實現遠程監督標注,首先需要從已知的知識庫或知識圖譜中獲取相關的三元組。以婚姻關系為例,DeepDive 從 DBpedia 中獲取已有的夫妻實體對。若候選實體對能在已知的夫妻實體對中找到匹配映射時,該候選對標記為正例。負例的標注針對需要抽取的不同關系有不同的可選方法。例如可以將沒有在知識庫中出現的實體對標注為負例,但在知識庫收入不完整的情況下該方法會引入噪音負例;也可以用知識庫中互斥關系下的實例來做負例標注,例如父母-子女關系,兄弟姐妹關系,都與婚姻關系互斥,用于標注負例基本不會引入噪音。

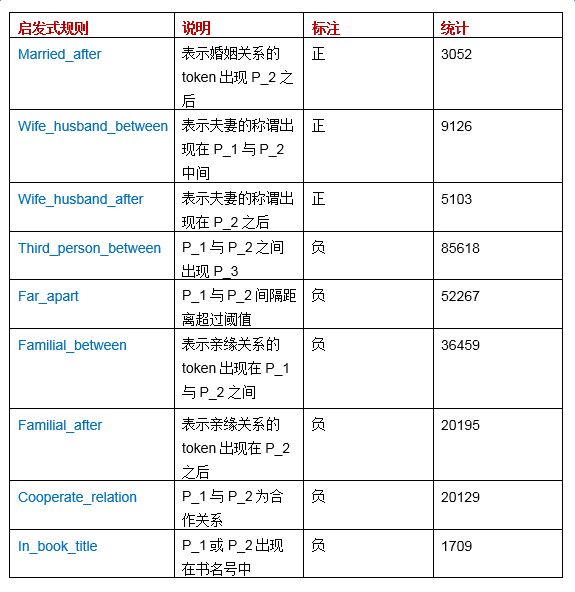

2、 啟發式規則

正負樣本的標注還可以通過用戶編寫啟發式規則來實現。以抽取婚姻關系為例,可以定義如下規則:

- Candidates with person mentions that are too far apart in the sentence are marked as false.

- Candidates with person mentions that have another person in between are marked as false.

- Candidates with person mentions that have words like "wife" or "husband" in between are marked as true.

用戶可以通過預留的 user defined function 接口,對啟發式規則進行編寫和修改。

3、 Label 沖突的解決

當遠程監督生成和啟發式規則生成的 label 沖突,或不同規則生成的 label 產生沖突時,DeepDive 采用 majority vote 算法進行解決。例如,一個候選對在 DBpedia 中找到了映射,label 為1,同時又滿足 2 中第 2 條規則,得到 label 為-1,majority vote 對所有 label 求和:sum = 1 - 1 = 0,最終得到的 label 為 doubt。

學習與推理

通過數據標注得到訓練集后,在學習與推理階段,Deepdive 主要通過基于因子圖模型的推理,學習特征的權重,并最終得到對候選三元組為真的概率預測值。

因子圖是一種概率圖模型,用于表征變量和變量間的函數關系,借助因子圖可以進行權重的學習和邊緣概率的推算。DeepDive 系統中,因子圖的頂點有兩種,一種是隨機變量,即提取的候選實體對,另一種是隨機變量的函數,即所有的特征和根據規則得到的函數,比方兩個實體間的距離是否大于一定閾值等。因子圖的邊表示了實體對和特征及規則的關聯關系。

當訓練文本的規模很大,涉及的實體眾多時,生成的因子圖可能非常復雜龐大,DeepDive 采用吉布斯采樣(Gibbs sampling)進行來簡化基于圖的概率推算。在特征權重的學習中,采用標準的 SGD 過程,并根據吉布斯采樣的結果預測梯度值。為了使特征權重的獲得更靈活合理,除了系統默認的推理過程,用戶還可以通過直接賦值來調整某個特征的權重。篇幅關系,更詳細的學習與推理過程本文不做展開介紹,更多的信息可參考 DeepDive 的官網。

交互迭代

迭代階段保證通過一定的人工干預對系統的錯誤進行糾正,從而使得系統的準召率不斷提升。交互迭代一般包括以下幾個步驟:

1、 準召率的快速估算

- 準確率:在P集中隨機挑選 100 個,看為 TP 的比例。

- 召回率:在輸入集中隨機挑選 100 個 positive case,看有多少個落在計算出的P集中。

2、 錯誤分類與歸納

將得到的每個 extraction failure(包括 FP 和 FN)按錯誤原因進行分類和歸納,并按錯誤發生的頻率進行排序,一般而言,最主要錯誤原因包括:

- 在候選集生成階段沒有捕獲應捕獲的實體,一般是 token 切分、token 拼接或 NER 問題

- 特征獲取問題,沒能獲取到區分度高的特征

- 特征計算問題,區分度高的特征在訓練中沒有獲得相應的高分(包括正負高分)

3、 錯誤修正

根據錯誤原因,通過添加或修改規則、對特征進行添加或刪除、對特征的權重進行調整等行為,調整系統,重新運行修改后的相應流程,得到新的計算結果。

神馬知識圖譜構建中的 DeepDive 應用與改進

在了解了 DeepDive 的工作流程之后,本章將介紹我們如何在神馬知識圖譜的數據構建業務中使用 DeepDive。為了充分利用語料信息、提高系統運行效率,我們在語料處理和標注、輸入規模的控制、輸入質量的提升等環節,對 DeepDive 做了一些改進,并將這些改進成功運用到業務落地的過程中。

中文 NLP 標注

NLP 標注是數據處理的一個重要環節。DeepDive 自帶的 Stanford CoreNLP 工具主要是針對英文的處理,而在知識圖譜的應用中,主要的處理需求是針對中文的。因此,我們開發了中文 NLP 標注的外部流程來取代 CoreNLP,主要變動如下:

- 使用 Ali 分詞代替 CoreNLP 的 token 切分,刪除詞根還原、POS 標注和依存文法分析,保留 NER 標注和 token 在文本中的起始位置標注。

- token 切分由以詞為單位,改為以實體為單位。在 NER 環節,將 Ali 分詞切碎的 token 以實體為粒度重新組合。例如分詞結果“華盛頓”、“州立”、“大學”將被組合為“華盛頓州立大學”,并作為一個完整的實體獲得“University”的 NER 標簽。

- 長句的切分:文本中的某些段落可能因為缺少正確的標點或包含眾多并列項等原因,出現切分后的句子長度超過一定閾值(如 200 個中文字符)的情況,使 NER 步驟耗時過長。這種情況將按預定義的一系列規則進行重新切分。

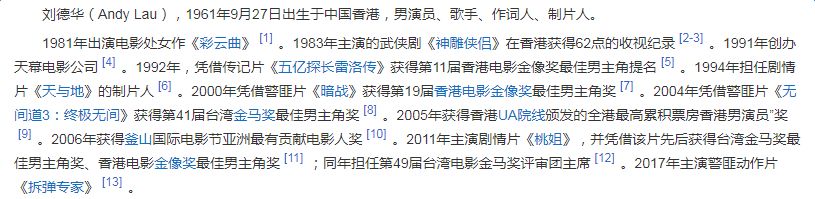

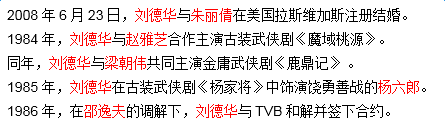

主語自動增補

數據處理環節的另一個改進是添加了主語自動補充的流程。以中文百科文本為例,統計發現,有將近 40% 的句子缺少主語。如下圖劉德華的百科介紹,第二段中所有句子均缺少主語。

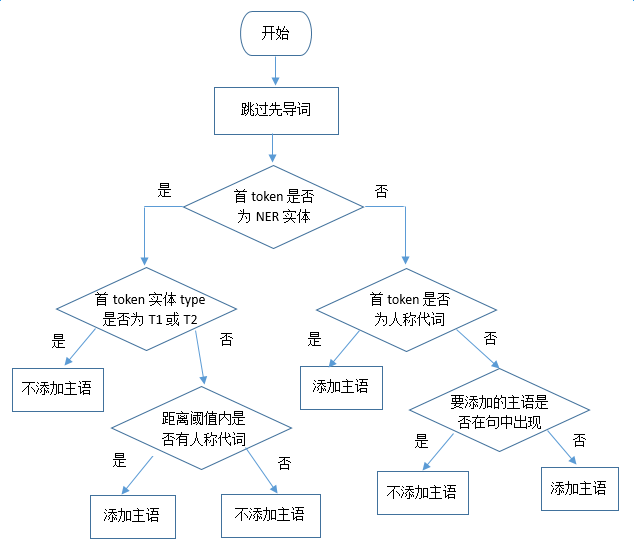

主語的缺失很多時候直接意味著候選實體對中其中一個實體的缺失,這將導致系統對大量含有有用信息的句子無法進行學習,嚴重影響系統的準確率和召回率。主語的自動補充涉及兩方面的判斷:

- 主語缺失的判斷

- 缺失主語的添加

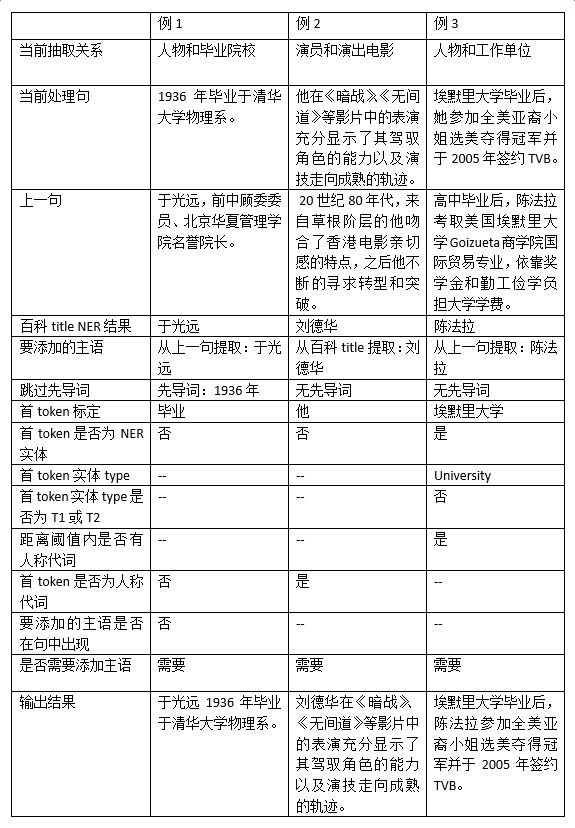

由于目前業務應用中涉及的絕大多數是百科文本,缺失主語的添加采用了比較簡單的策略,即從當前句的上一句提取主語,如果上一句也缺失主語,則將百科標題的 NER 結果作為要添加的主語。主語缺失的判斷相對復雜,目前主要采用基于規則的方法。假設需要提取的候選對(E1, E2)對應的實體類型為(T1, T2),則判定流程如下圖所示:

具體的主語補充實例和處理過程舉例如下:

以百科文本為例,經實驗統計,上述主語自動補充算法的準確率大約在 92%。從關系抽取的結果來看,在所有的錯誤抽取 case 中,由主語增補導致的錯誤比例不超過2%。

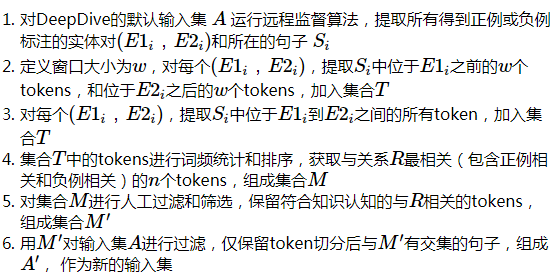

基于關系相關關鍵詞的輸入過濾

DeepDive 是一個機器學習系統,輸入集的大小直接影響系統的運行時間,尤其在耗時較長的特征計算和學習推理步驟。在保證系統召回率的前提下,合理減小輸入集規模能有效提升系統的運行效率。

假設需要提取的三元組為R(E1, E2)且(E1, E2)對應的實體類型為(T1, T2)。DeepDive 的默認運行機制是:在數據處理階段,提取所有滿足類型為(T1,T2)的實體對作為候選,不考慮上下文是否有表達關系R的可能性。例如,抽取婚姻關系時,只要一個句子中出現大于等于兩個的人物實體,該句子就會作為輸入參與系統整個數據處理、標注和學習的過程。以下五個例句中,除了句1,其它 4 句完全不涉及婚姻關系:

尤其當句中的兩個人物實體無法通過遠程監督獲取正例或負例標簽時,此類輸入無法在學習環節為系統的準確率帶來增益。為減小此類輸入帶來的系統運行時間損耗,我們提出了以下改進算法:

實驗證明,利用改進算法得到的輸入集規模有顯著的減小,以百科文本的抽取為例,婚姻關系的輸入集可縮小至原輸入集的 13%,人物和畢業院校關系的輸入集可縮小至原輸入集的 36%。輸入集的縮小能顯著減少系統運行時間,且實驗證明,排除了大量 doubt 標注實體候選對的干擾,系統的準確率也有較大幅度的提升。

需要指出的是,雖然在輸入環節通過關系相關關鍵詞進行過濾減小輸入規模,能最有效地提高系統運行效率(因為跳過了包含特征提取在內的所有后續計算步驟),但該環節的過濾是以句子為單位,而非作用于抽取的候選實體對。來看一個婚姻關系提取的多人物示例:

- 除了孫楠、那英等表演嘉賓盛裝出席外,擔任本場音樂會監制的華誼兄弟總裁王中磊先生、馮小剛導演和夫人徐帆,以及葛優、宋丹丹、李冰冰等演藝明星也一一現身紅毯,到場支持此次音樂會。

因為含有婚姻關系相關的關鍵詞“夫人”,該句子將被保留為系統輸入。從該句提取的多個人物候選實體對需要依靠更完善的啟發式規則來完成進一步的標注和過濾。

實體對到多實體的擴展

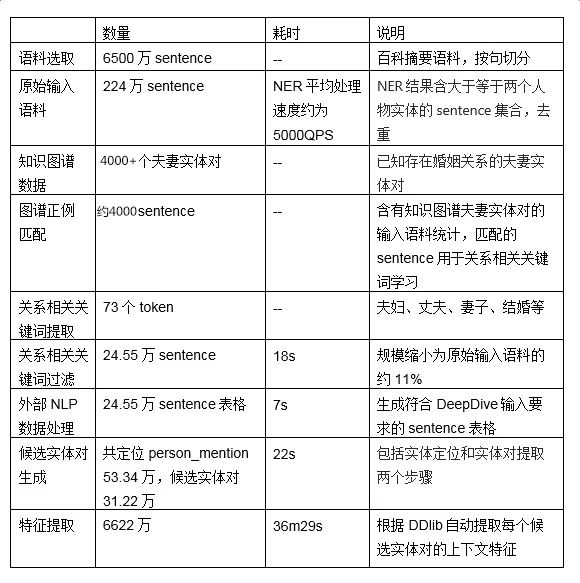

關系抽取的絕大部分任務僅涉及三元組的抽取。三元組一般有兩種形式,一種是兩個實體具有某種關系,形如R(E1, E2),例如:婚姻關系(劉德華,朱麗倩);另一種是實體的屬性值,形如P(E,V),例如:身高(劉德華,1.74 米)。DeepDive 默認的關系抽取模式都是基于三元組的。但在實際應用中,有很多復雜的關系用三元組難以完整表達,例如,人物的教育經歷,包括人物、人物的畢業院校、所學專業、取得學位、畢業時間等。這些復雜的多實體關系在神馬知識圖譜中用復合類型來表示。因此,為使抽取任務能兼容復合類型的構建時,我們對 DeepDive 的代碼做了一些修改,將候選實體對的提取,擴展為候選實體組的提取。代碼修改涉及主抽取模塊中的 app.ddlog、底層用于特征自動生成的 DDlib 和 udf 中的 map_entity_mention.py、extract_relation_features.py 等文件。下圖展示了一個擴展后的實體組抽取實例,抽取關系為(人物、所在機構、職位):

應用 DeepDive 的數據構建工作

本節首先給出一個輸入示例以及該示例在 DeepDive 運行過程中每一步的輸出結果,如下圖所示。通過這個示例,我們可以對 DeepDive 各模塊的功能和輸出有更直觀的認識。

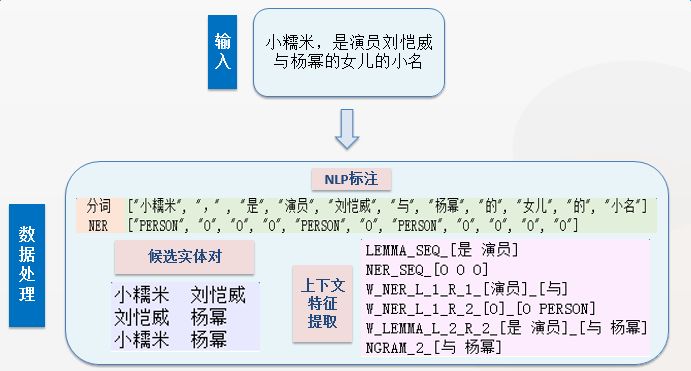

為了更詳細地了解 DeepDive 的應用和改進算法的效果,以下我們給出一個具體的婚姻關系抽取任務的相關運行數據。

下表顯示了該抽取任務在數據處理階段各步驟的的耗時和產出數量:

在數據標注的遠程監督階段,我們除了使用知識圖譜中已有的夫妻關系做正例標注,還使用了已有的父母-子女關系和兄弟姐妹關系做負例標注,得到正例數千個,正負標注候選實體的比例約為1:2。

在 DeepDive 系統中,遠程監督的 wrong label problem 可以依靠合理編寫的啟發式規則得到一定程度的糾正。觀察婚姻關系的 wrong label 樣例,我們發現較大比例的 wrong label 是夫妻實體以某種合作形式(如合作演出、合作演唱、合作著書等)共現在一個句子中,夫妻實體有一個出現在書名號中時,也容易發生誤判。例如:

類似的觀察和總結可以編寫成啟發式規則,依靠從規則得到的負標注抵償遠程監督得到的正標注,減小系統在學習和推理時的偏差。

雖然啟發式規則的編寫大多依靠專家知識或人工經驗完成,但規則的完善和擴充可以依靠某些自動機制來輔助實現。例如,規則定義:句中出現“P_1 和P_2 結婚”,則(P_1,P_2)得到正標注。根據對“和”和“結婚”等 token 的擴展,我們可以得到“P_1 與P_2 結婚”、“P_1 和 P2 婚后”、“P_1 和P_2 的婚禮”等類似應該標注為正的語境。這里,token 的擴展可以通過 word2vec 算法加人工過濾實現。下表給出了該抽取任務中用到的規則和相應的統計數據。整個數據標注過程耗為 14m21s。

學習與推理過程耗時約 38m50s。我們隨機截取了部分知識圖譜未收錄的預測實體對的輸出結果展示如下

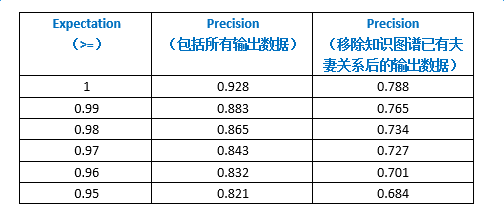

對于系統的準確率,我們取 expectation 為 [0.95,1][0.95,1] 區間內的輸出結果進行分段統計,統計結果如下列圖表所示:

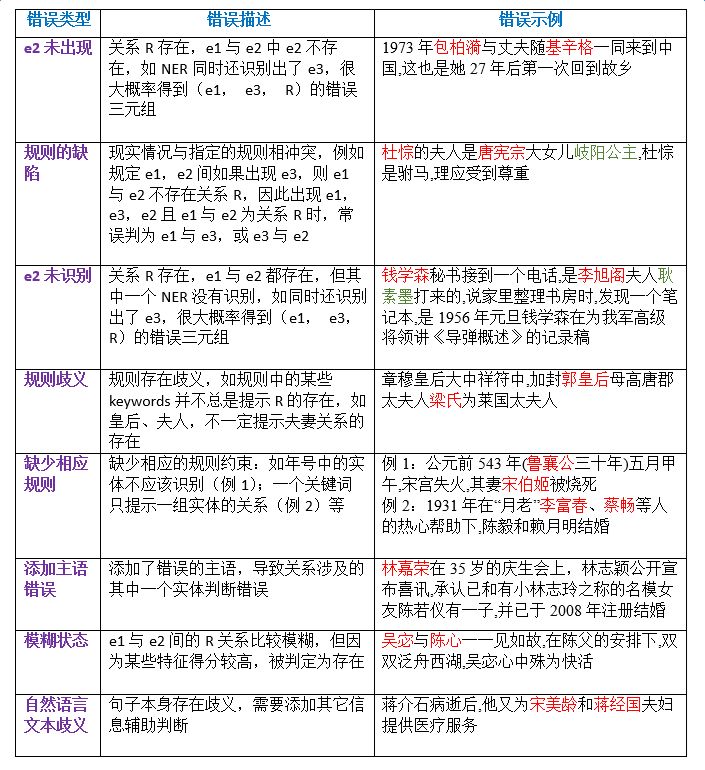

對系統預測的錯誤樣例進行分析,我們總結了幾種錯誤類型,下表按照出現頻率從高到低,給出了錯誤描述和錯誤示例:

系統召回率的計算相比準確率的計算更為復雜,在語料規模較大的情況下,準確估算召回率將耗費大量的人力。我們采用了抽樣檢測的方式來估算召回率,具體實踐了以下三種方法(統計中 expectation 均取>=0.95):

- 抽樣含有某個指定實體的所有 sentences,計算召回:含實體 “楊冪” 的 sentences 共 78 例,含 (楊冪, 劉愷威)實體對的 sentences 共 13 例,人工判斷其中 9 例描述了該實體對的婚姻關系,其中 5 例被召回,召回率為 0.556。

- 用于遠程監督正例標注的知識圖譜實體對超過 4000 對,統計表明,其中 42.7% 的實體對出現在了語料中,26.5% 的實體對被召回,召回率為 0.621。

- 輸入集隨機挑選 100 例 positive cases,其中 49 例的 expectation 值>=0.95, 召回率為 0.49。

基于 DeepDive 的關系抽取研究目前已較為完整,并已經在神馬知識圖譜的構建業務中落地。目前在數據構建中的應用涉及人物、歷史、組織機構、圖書、影視等多個核心領域,已抽取關系包括人物的父母、子女、兄弟姐妹、婚姻、歷史事件及人物的合稱、圖書的作者、影視作品的導演和演員、人物的畢業院校和就業單位等。以百科全量語料為例,每個關系抽取任務候選 sentence 集合的規模在 80w 至 1000w,經改進算法過濾,輸入規模在 15w 至 200w 之間,生成的候選實體對規模在 30w 至 500w 之間。系統每輪迭代運行的時間在 1 小時至 8 小時之間,約經過3-4 輪迭代可產出準確率和召回率都較高的數據給運營審核環節。系統運行至今,已累計產出候選三元組近 3 千萬。

除此之外,基于深度學習模型的關系抽取技術及其在神馬知識圖譜數據構建中的應用,我們也在不斷探索和實踐。明天,阿里妹將繼續為大家介紹相關的技術進展和業務落地過程中遇到的一些挑戰,敬請關注哦。

參考文獻

[1]. 林衍凱、劉知遠,基于深度學習的關系抽取

[2]. Daojian Zeng, Kang Liu, Yubo Chen, and Jun Zhao. 2015. Distant Supervision for Relation Extraction via Piecewise Convolutional Neural Networks. In EMNLP. 1753–1762.

[3]. Guoliang Ji, Kang Liu, Shizhu He, Jun Zhao. 2017. Distant Supervision for Relation Extraction with Sentence-Level Attention and Entity Descriptions. Proceedings of the Thirty-First AAAI Conference on Artificial Intelligence

[4]. Siliang Tang, Jinjian Zhang, Ning Zhang, Fei Wu, Jun Xiao, Yueting Zhuang. 2017. ENCORE: External Neural Constraints Regularized Distant Supervision for Relation Extraction. SIGIR'17

[5]. Zeng, D.; Liu, K.; Chen, Y.; and Zhao, J. 2015. Distant supervision for relation extraction via piecewise convolutional neural networks. EMNLP.

[6]. Riedel, S.; Yao, L.; and McCallum, A. 2010. Modeling relations and their mentions without labeled text. In Machine Learning and Knowledge Discovery in Databases. Springer. 148–163.

[7]. Ce Zhang. 2015. DeepDive: A Data Management System for Automatic Knowledge Base Construction. PhD thesis.

[8]. Hoffmann, R.; Zhang, C.; Ling, X.; Zettlemoyer, L.; and Weld, D. S. 2011. Knowledge-based weak supervision for information extraction of overlapping relations. In Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies-Volume 1, 541–550. Association for Computational Linguistics.

[9]. Surdeanu, M.; Tibshirani, J.; Nallapati, R.; and Manning, C. D. 2012. Multi-instance multi-label learning for relation extraction. In Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning, 455–465. Association for Computational Linguistics.

[10]. Shingo Takamatsu, Issei Sato and Hiroshi Nakagawa. 2012. Reducing Wrong Labels in Distant Supervision for Relation Extraction. Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics, pages 721–729

[11]. Zeng, D.; Liu, K.; Lai, S.; Zhou, G.; Zhao, J.; et al. 2014. Relation classification via convolutional deep neural network. In COLING, 2335–2344.

[12]. Ce zhang, Cheistopher Re; et al. 2017. Communications of the ACM CACM Homepage archive Volume 60 Issue 5, Pages 93-102

[13]. Mintz, M.; Bills, S.; Snow, R.; and Jurafsky, D. 2009. Distant supervision for relation extraction without labeled data. In Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP: Volume 2, 1003–1011. Association for Computational Linguistics.

[14]. http://deepdive.stanford.edu/