Adobe推出超分辨率,細(xì)節(jié)豐富視頻模型VideoGigaGAN

視頻超分辨率是計(jì)算機(jī)視覺(jué)領(lǐng)域一個(gè)非常有難度的課題,主要是將低分辨率的視頻轉(zhuǎn)換為高分辨率。在轉(zhuǎn)換的過(guò)程中,會(huì)面臨著兩大難題。

第一個(gè)是保持輸出視頻幀在時(shí)間上的連貫性,確保幀到幀之間平滑過(guò)渡,不出現(xiàn)閃爍或抖動(dòng)的情況;第二個(gè)則是要在放大的視頻幀中重建高頻細(xì)節(jié),以提供清晰和逼真的紋理效果。

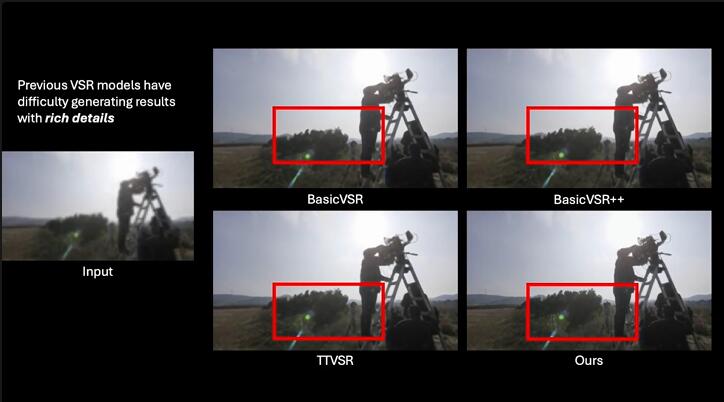

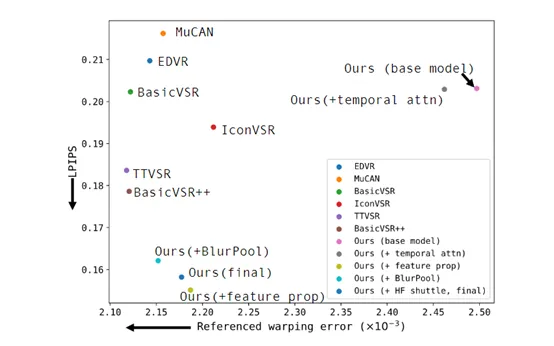

雖然目前很多超分辨率視頻模型在保持時(shí)間連貫性方面取得了顯著進(jìn)展,但是以犧牲圖像清晰度為代價(jià),整體看起來(lái)非常模糊缺乏更加生動(dòng)的細(xì)節(jié)和紋理。

因此,全球多媒體巨頭Adobe和馬里蘭大學(xué)的研究人員推出了VideoGigaGAN,這是一個(gè)兼顧幀率連貫性和豐富細(xì)節(jié)的超分辨率視頻模型。

論文地址:https://arxiv.org/abs/2404.12388

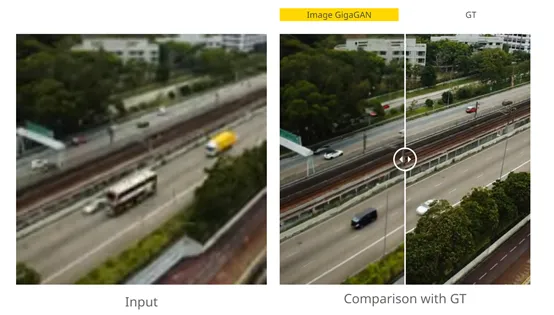

VideoGigaGAN是基于Adobe、卡內(nèi)基梅隆大學(xué)和浦項(xiàng)科技大學(xué)之前推出的,大規(guī)模圖像超分辨率模型GigaGAN的基礎(chǔ)之上開(kāi)發(fā)而成。GigaGAN經(jīng)過(guò)數(shù)十億張圖像的訓(xùn)練,能夠在8倍放大的情況下,依然生成逼真細(xì)膩的高分辨率圖像。

但直接將GigaGAN應(yīng)用在每個(gè)低分辨率視頻幀,會(huì)導(dǎo)致嚴(yán)重的時(shí)間抖動(dòng)和混疊偽影。為了解決這個(gè)問(wèn)題,研究人員對(duì)GigaGAN模型進(jìn)行了創(chuàng)新。

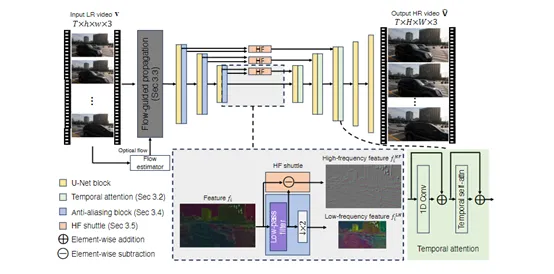

通過(guò)添加時(shí)序卷積和自注意力層,將GigaGAN從2D圖像模型擴(kuò)展為3D視頻模型,同時(shí)引入了光流引導(dǎo)模塊,更好地對(duì)齊不同幀的特征,提高視頻的時(shí)間一致性和細(xì)節(jié)豐富性。

時(shí)序卷積和自注意力層

時(shí)序卷積是一種用于處理時(shí)間序列數(shù)據(jù)的卷積操作,主要用于提取時(shí)間序列數(shù)據(jù)中的特征。

在視頻超分辨率的上下文中,時(shí)序卷積模塊使模型能夠捕捉視頻幀之間的時(shí)間依賴性,從而提高超分辨率視頻的時(shí)間一致性。

與傳統(tǒng)的空間卷積不同的是,時(shí)序卷積考慮了時(shí)間維度的關(guān)系,并在卷積過(guò)程中引入時(shí)間上的權(quán)重。這樣可以使得生成的每一幀都受到相鄰幀的影響,從而保持了視頻序列的時(shí)序一致性。

在VideoGigaGAN模型中,時(shí)序卷積層被放置在解碼器塊中,緊隨空間自注意力層之后。

這種設(shè)計(jì)允許模型首先在空間維度上提煉特征,然后在時(shí)間維度上進(jìn)一步加工這些特征。通過(guò)這種方式,使模型能夠更好地理解視頻中的時(shí)間動(dòng)態(tài),例如,運(yùn)動(dòng)、變形、切換場(chǎng)景等。

為了更好地捕獲視頻的細(xì)節(jié)、紋理以及重建超分辨率,VideoGigaGAN使用了自注意力層與時(shí)序卷積一起協(xié)同工作。

在解碼器塊的空間自注意力層中,會(huì)計(jì)算每個(gè)空間位置對(duì)當(dāng)前位置的影響,從而捕捉空間上的細(xì)節(jié)和紋理信息。然后在時(shí)間自注意力層中,計(jì)算序列中每個(gè)時(shí)間步對(duì)當(dāng)前時(shí)間步的影響,進(jìn)一步增強(qiáng)時(shí)間的一致性。

光流引導(dǎo)

光流是描述圖像中物體運(yùn)動(dòng)的向量場(chǎng),可以捕捉和預(yù)測(cè)視頻幀之間的像素級(jí)運(yùn)動(dòng),是計(jì)算機(jī)視覺(jué)中用于估計(jì)場(chǎng)景動(dòng)態(tài)信息的重要技術(shù)。光流不僅能夠提供物體運(yùn)動(dòng)的信息,還能夠揭示場(chǎng)景的3D結(jié)構(gòu)。

VideoGigaGAN會(huì)先使用一個(gè)光流估計(jì)器來(lái)預(yù)測(cè),輸入低分辨率視頻的雙向光流圖。這些光流圖描述了視頻幀中每個(gè)像素點(diǎn)的運(yùn)動(dòng)向量。

然后通過(guò)一個(gè)雙向循環(huán)神經(jīng)網(wǎng)絡(luò)來(lái)處理光流圖和原始幀像素,學(xué)習(xí)時(shí)間感知的特征,并能夠處理長(zhǎng)序列數(shù)據(jù),捕捉長(zhǎng)期依賴關(guān)系。

最后,通過(guò)一個(gè)反向變形層,將學(xué)習(xí)到的特征根據(jù)預(yù)先計(jì)算的光流顯式地變形。這一流程確保了在超分辨率過(guò)程中,即使在物體快速運(yùn)動(dòng)的情況下,也能夠保持特征的空間一致性。

在光流引導(dǎo)的幫助下,使得VideoGigaGAN模型能夠更準(zhǔn)確地估計(jì)物體的運(yùn)動(dòng)軌跡,并在超分辨率過(guò)程中保留更多的高頻細(xì)節(jié),從而生成清晰的超分辨率視頻。

本文轉(zhuǎn)自 AIGC開(kāi)放社區(qū) ,作者:AIGC開(kāi)放社區(qū)