從低清到4K的魔法:FlashVideo突破高分辨率視頻生成計算瓶頸(港大&港中文&字節)

論文鏈接:https://arxiv.org/pdf/2502.05179

項目鏈接:https://github.com/FoundationVision/FlashVideo

亮點直擊

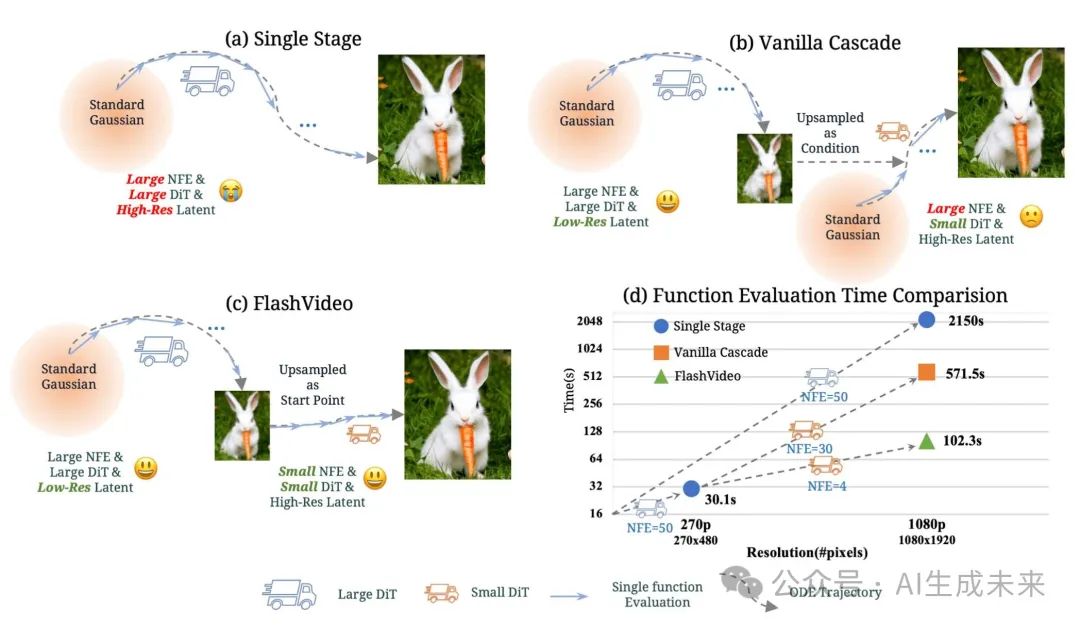

- 提出了FlashVideo,一種將視頻生成解耦為兩個目標的方法:提示匹配度和視覺質量。通過在兩個階段分別調整模型規模、分辨率和優化策略,本文的方法相比現有方法實現了更高的效果和效率。

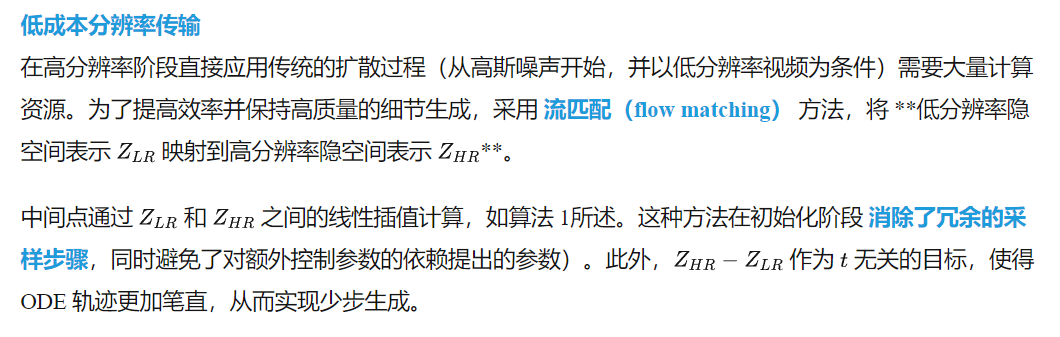

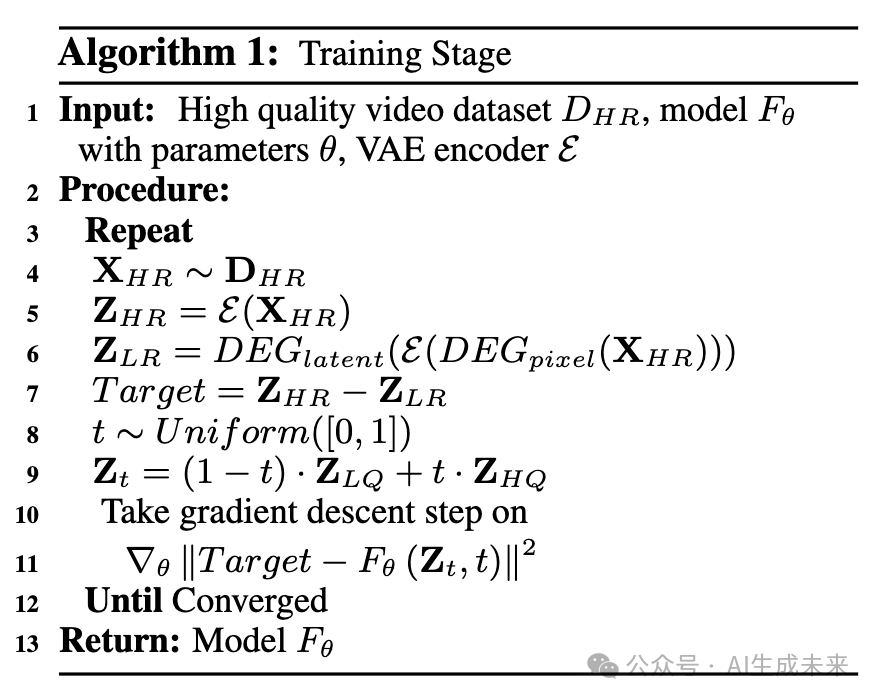

- 通過流匹配(flow matching)構造了從低質量視頻到高質量視頻的近乎直線的 ODE 軌跡,使得視頻在僅 4 次函數評估內即可融入豐富細節。

- 本文的方法在 VBench-Long 上達到了82.99的頂級分數,同時實現了極快的函數評估時間。兩階段設計使用戶能夠在全分辨率生成前預覽初始輸出,從而降低計算成本和等待時間。

總結速覽

解決的問題

- 現有 DiT 生成的視頻模型需要大規模參數和大量計算資源,導致計算成本高昂。

- 生成高質量視頻需要高分辨率和大量去噪步驟,進一步增加計算負擔。

- 現有的兩階段方法仍然依賴從高斯噪聲重建高分辨率視頻,計算效率低下。

提出的方案

- 設計 FlashVideo 兩階段框架:

- 第一階段低分辨率視頻生成,保證內容和運動的語義一致性。

- 第二階段通過流匹配(flow matching)提升分辨率,增強細節,同時減少計算開銷。

- 采用流匹配技術,直接優化 ODE 軌跡,使第二階段生成不依賴高斯噪聲。

應用的技術

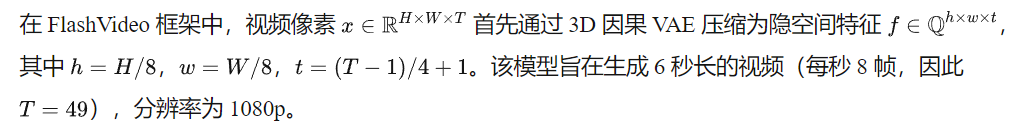

- DiT(Diffusion Transformer)架構,利用 3D 全注意力機制建模時間和空間關系。

- 流匹配(flow matching),直接優化低分辨率到高分辨率的 ODE 軌跡,避免從高斯噪聲重建。

- 計算優化,第一階段使用 5B 參數模型,第二階段降至 2B 參數,并減少函數評估步驟至 4 步。

達到的效果

- 大幅提升計算效率:1080p 視頻生成時間從單階段 2150s 降至 102s,比傳統兩階段方法快 5 倍。

- 保障生成質量:低分辨率階段保證語義一致性,高分辨率階段增強細節,確保視覺質量。

- 更高的商業可行性:允許用戶在低分辨率階段預覽結果,減少不必要的計算成本。

方法

總覽

低分辨率階段 I

在第一階段,目標是生成與輸入提示高度匹配的內容和運動模式。為此,初始化了一個大規模模型 CogVideoX-5B,其包含 50 億 參數。為了提高計算效率,采用 參數高效微調(PEFT),使模型適應 270p 的低分辨率。

調整 MMDiT 架構的目標分辨率相對簡單,可通過在所有 注意力層、前饋網絡(FFN) 以及 自適應層歸一化(adaptive layer normalization) 中應用 LoRA(秩設為 128)來實現。

與全參數微調相比,PEFT 在小批量(batch size = 32)訓練時表現出更強的魯棒性,而全參數微調在如此小的批量下會顯著降低生成質量。所有其他配置設置(包括去噪調度器和預測目標)均與 CogVideoX-5B 保持一致。

高分辨率階段 II

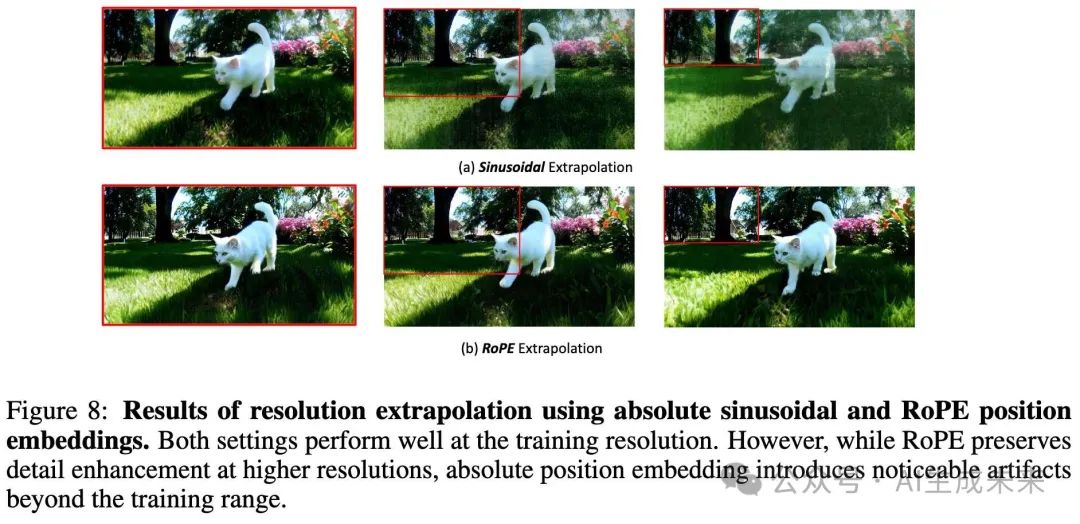

模型架構

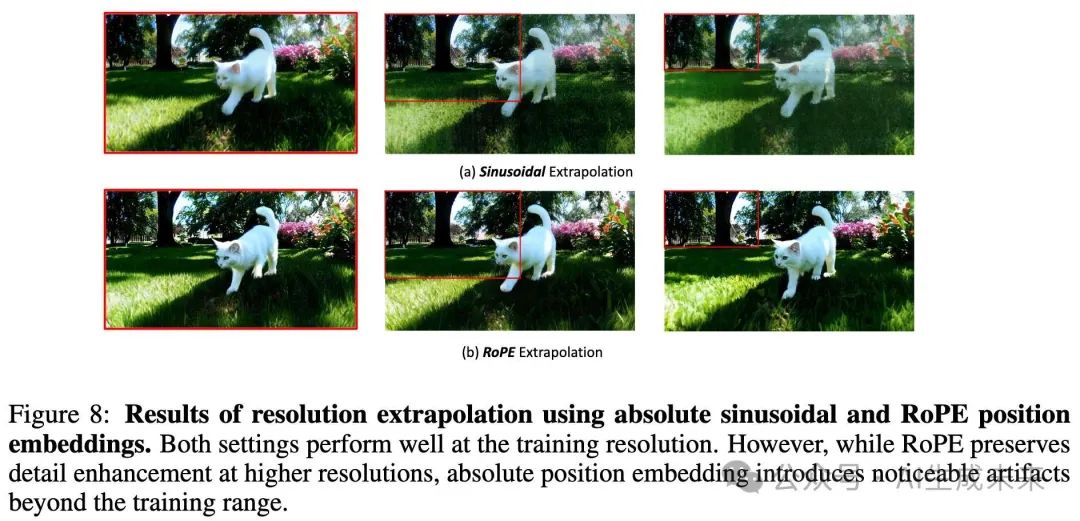

為了增強細粒度細節,本文采用了另一種遵循 CogVideoX-2B設計的模型。用 3D RoPE 替換了原始位置頻率嵌入,以在推理時更好地擴展至更高分辨率(見下圖 8)。

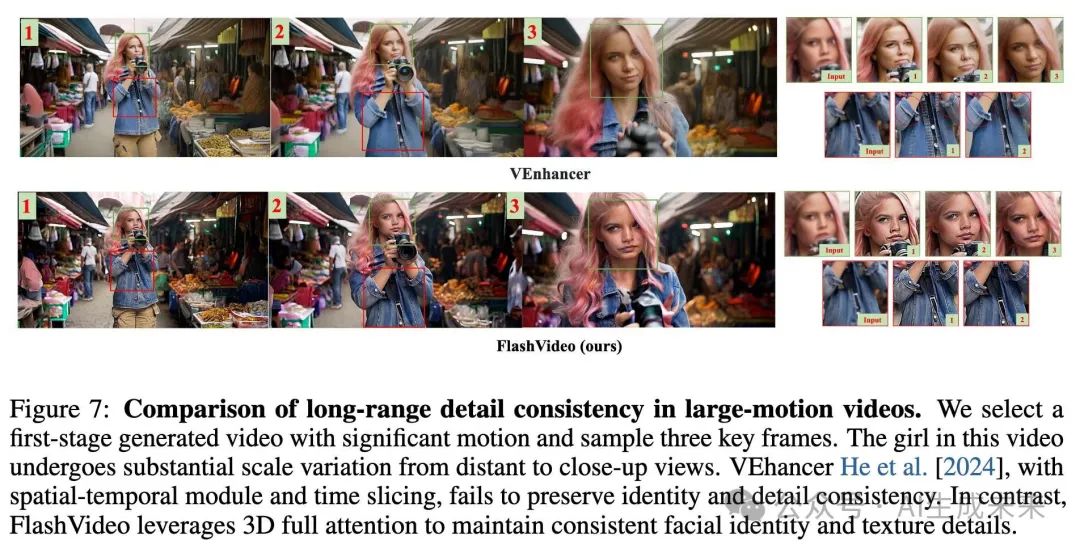

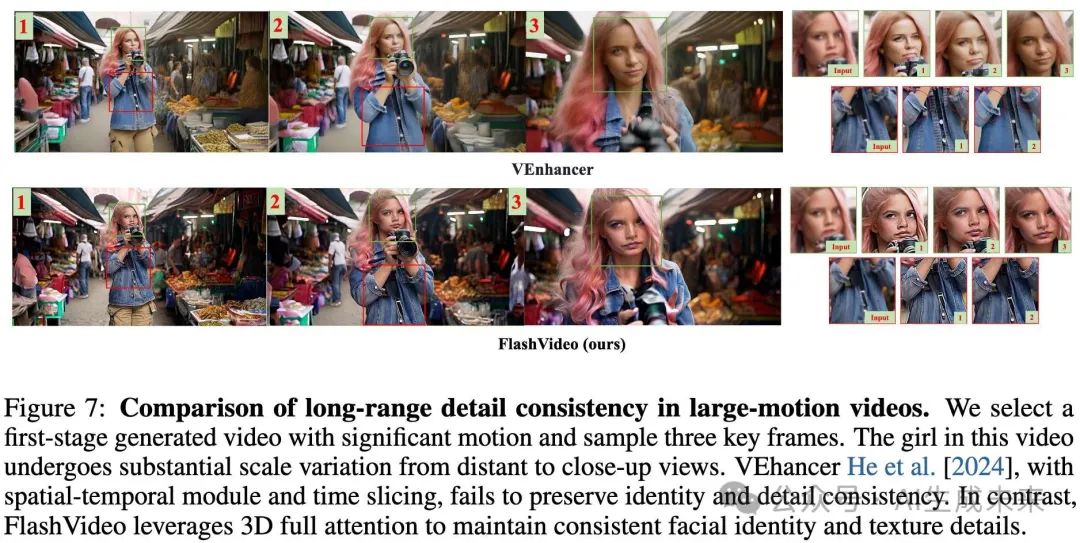

與 [He et al. 2024] 采用的 時空分解(spatial-temporal decomposition) 和 時間切片注意力(time-slicing attention) 方法不同,完整的 3D 注意力機制 對于保持視頻在劇烈運動和尺度變化情況下的增強視覺細節一致性至關重要(見下圖 7)。如上圖 2所示,第一階段的語言嵌入被直接用于該階段。

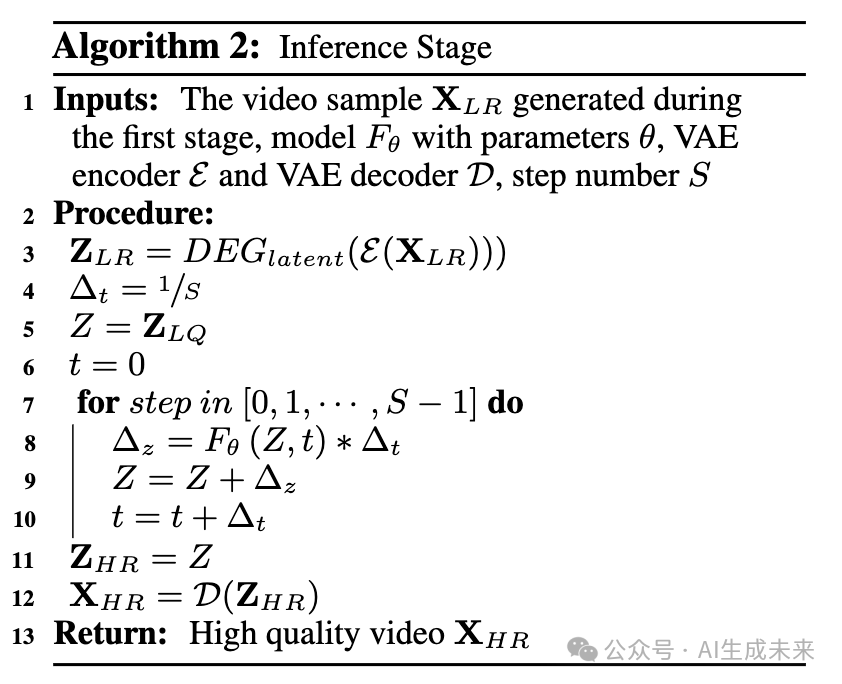

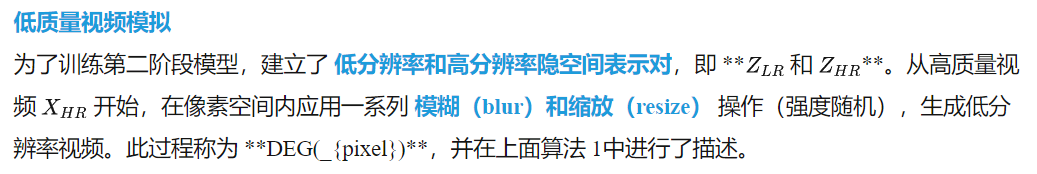

在此模擬數據上訓練,使模型能夠增強高頻細節,從而改善整體清晰度(見下圖 3)。然而,僅通過 DEG(_{pixel}) 進行低分辨率數據模擬會使低、高分辨率視頻之間保持較強的保真度,這限制了模型在高分辨率下對小物體的結構再生能力,尤其是在第一階段輸出中存在偽影時。例如,當結構表現較差時,小物體可能會變得模糊,如下圖 3中的樹枝,或下圖 5(e) 中失真的眼部特征。

為了解決這個問題,本文引入了 隱空間退化(latent degradation, DEG({latent})**),即在隱空間表示中加入高斯噪聲。這一方法允許模型在輸入數據的基礎上產生偏離,從而為小物體生成更合理的結構。如上圖 3所示,相比 **DEG({pixel}),DEG(_{latent}) 組合策略能夠生成更加清晰且細節豐富的樹枝及背景小物體,顯著提升視覺質量。

訓練過程中的整體模擬流程如下所述:

首先,對高質量視頻在像素空間進行退化處理,得到退化版本;然后,該退化視頻被編碼至隱空間空間,表示為

參數 step 決定了噪聲增強的強度。為了確保模型能夠感知隱空間空間中的噪聲強度,我們引入了噪聲強度嵌入,并將其添加到時間嵌入中。在推理階段,僅對第一階段的輸出應用 DEGlatent。

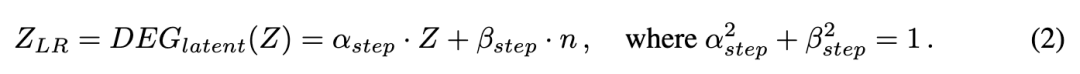

為了確定合適的 DEGlatent 強度,在初始訓練時使用較寬的噪聲步長范圍(600-900)。然后,我們在不同的噪聲步長下評估模型的結果(如圖 9 (c) 和表 10 所示)。根據這些結果,我們在后續訓練階段將噪聲范圍限制在 650-750。

粗到精訓練

直接在高分辨率上訓練需要大量計算成本。3D RoPE作為一種相對時空編碼,為我們的模型提供了良好的分辨率可擴展性。因此,首先在低分辨率圖像和視頻(540×960)上進行大規模預訓練,然后再擴展到目標分辨率 1080p(1080 ×1920)。在后期訓練中,觀察到明顯的性能波動,因此進一步使用一小部分符合人類偏好的高質量樣本進行微調。這個低成本的額外微調階段顯著提升了模型的性能。

實驗

數據收集

首先收集了大量 1080p 視頻,并通過美學和運動特征篩選,構建了一個高質量數據集,最終獲得 200 萬個高質量樣本。運動篩選使用 RAFT 計算平均光流,并丟棄運動得分低于 1.1 的片段。

為了確保第二階段模型學習多樣化的紋理細節,進一步收集了 150 萬張分辨率為 2048 ×2048 的高質量圖像。所有視頻和圖像均使用內部字幕生成模型進行詳細標注。此外,手動篩選了 50,000 個視頻,這些視頻具有高美學質量、豐富的紋理和顯著的運動多樣性,以用于人類偏好對齊。

訓練設置

對于第一階段模型的訓練,我們僅使用視頻數據,并將其調整為 270p 分辨率。模型訓練了 50,000 次迭代,批次大小為 32,基礎學習率為 4 ×10??。使用 AdamW 優化器,β1 = 0.9,β2 = 0.95,權重衰減為 1 ×10??,并將梯度裁剪設置為 0.1。

第二階段模型,包括預訓練和人類偏好對齊,使用批次大小為 64,其他超參數與第一階段相同。預訓練分為三個階段:(1)在 540 ×960 的圖像補丁上訓練 25,000 次迭代,這些補丁來自 2048 ×2048 的高分辨率圖像;(2)在混合數據集上訓練 30,000 次迭代,數據集包括 540 ×960 的圖像補丁和視頻,比例為 1:2;(3)在全分辨率的 1080 ×1920 視頻上訓練 5000 次迭代。最后,在人類偏好對齊數據集上進行 700 次迭代的微調。

對于隱空間退化,在階段(1)、(2)和(3)的前 1000 次迭代中,初步應用了 600–900 的噪聲步長范圍。根據下表 10 中的發現,我們隨后將噪聲范圍縮小到 650–750,用于(3)和(4)中的剩余訓練。

定性結果

本節展示了基于不同用戶提示的二階段視頻生成結果的可視化。第一階段的輸出優先保證內容和運動的高保真度,而第二階段進一步細化細節,減少生成偽影,從而增強整體視覺質量。

二階段生成結果

如下圖 4 所示,第一階段輸出(頂部行)展現了強烈的提示保真度和流暢的運動。提示中指定的關鍵視覺元素(加粗部分)被準確生成。然而,仍可能存在偽影和細節不足的紋理問題(由紅色框標出)。相比之下,第二階段的輸出(底部行)通過精細化小物體的結構和增強紋理豐富度,顯著提高了視覺質量。顯著的改進包括人臉細節的細化(a, d)、動物毛發的精細渲染(b, c)、植物結構的復雜細節(a, b)以及織物紋理的提升(d),這些都在第二行的綠色框中突出顯示。此外,盡管存在大量運動,由于第二階段集成了完整的注意力機制,高頻細節依然保持了時間一致性。更多未壓縮的案例可見于我們的項目頁面。

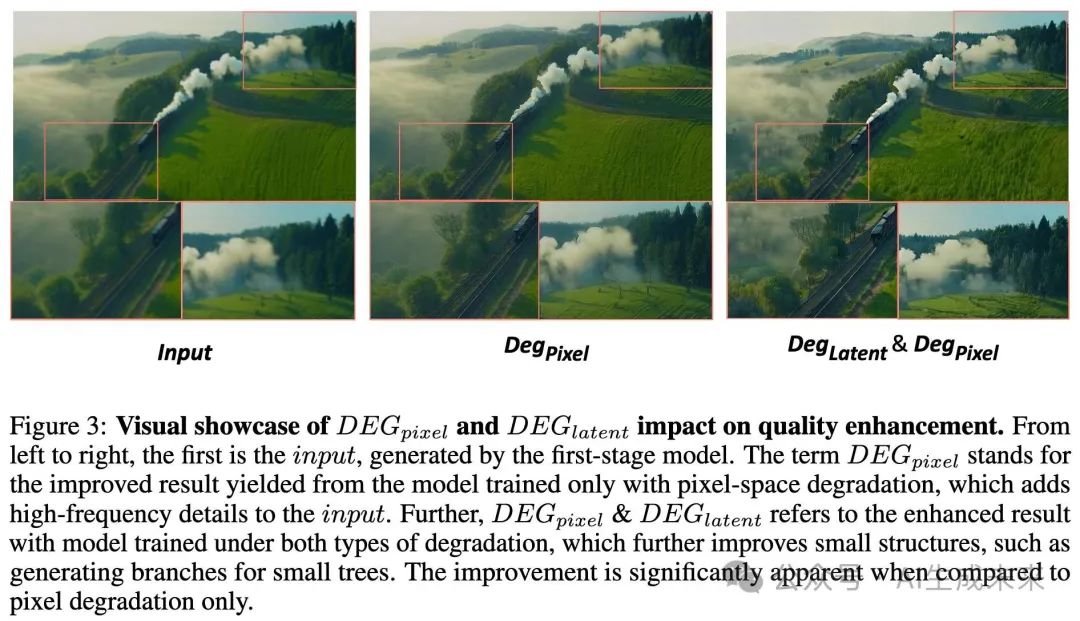

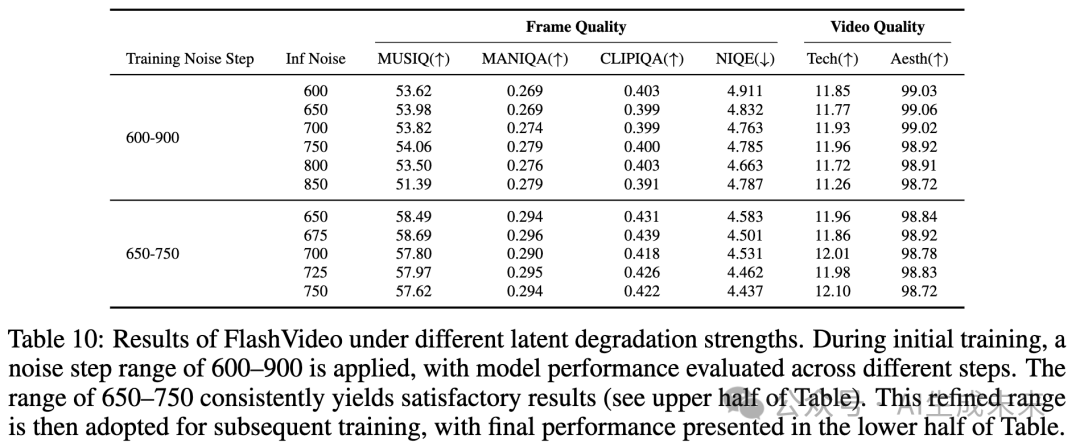

第二階段的偽影修正與細節增強

為了進一步展示第二階段細化的有效性,在下圖 5 中提供了關鍵幀的額外示例。與第一階段的輸出(紅色標記)相比,第二階段的結果(綠色標記)通過抑制偽影和豐富細節,表現出了顯著的改進。這些增強表現為:更連貫的油畫風格向日葵(a)、更精細的皺紋和發絲渲染(b)、動物和植物紋理結構的改善(c, d)以及面部和物體偽影的修正(e)。

定量結果

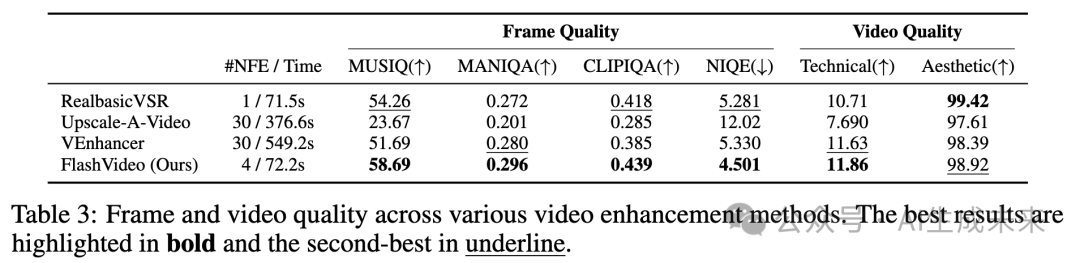

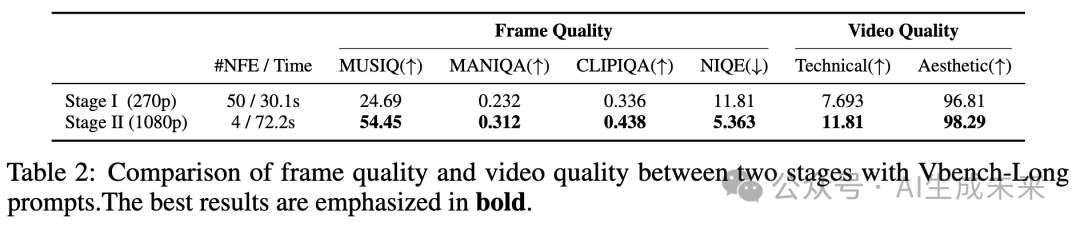

首先在 VBench-Long基準上評估我們的模型,使用其長提示進行評估。通過使用多種廣泛使用的非參考圖像和視頻質量評估指標,評估第二階段的視覺質量提升。

VBench-Long 基準遵循 VBench-Long 的標準評估協議,每個提示生成五個視頻。需要注意的是,由于 VBench 的評估指標傾向于偏好較高的幀率,應用了一個實時視頻幀插值方法 ,將幀率從 8 fps 升級到 24 fps。這個插值過程幾乎沒有后處理時間(在 4 秒以內),確保了與高幀率方法的公平比較。關于 VBench 幀率偏好的更詳細討論,見補充材料。

如下表 1 所示,8fps 和 24fps 模型都取得了超過 81 的高語義分數。然而,僅使用第一階段模型時,審美和成像質量分數低于頂級方法,270p 的得分分別為 60.47 和 61.39。應用第二階段后,兩個質量分數顯著提高,分別達到了大約 62.29 和 66.21,如表 1 所示。這些結果驗證了本文的方法,即在第一階段初步降低分辨率,以確保在較低計算成本下保持高提示保真度,隨后在第二階段進行質量提升。另一方面,整個功能評估只需約 2 分鐘,顯著優于其他方法的效率。例如,Hunyuan Video使用一個較大的 13B 單階段模型,生成 720p(720 ×1280)結果的總評估時間為 1742 秒。相比之下,本文的方法不僅展示了更高的效率,還生成了更高分辨率的輸出。此外,用戶可以在僅 30 秒內獲得 270p 的初步預覽,從而決定是否繼續進行第二階段或調整輸入提示。這種靈活性顯著提升了用戶體驗。

與視頻增強方法的比較

本節通過將第二階段方法與幾種最先進的視頻增強方法進行比較,全面評估其有效性。這些方法包括VEnhancer、Upscale-a-Video和RealBasicVSR 。本文的評估包括基于第一階段輸出的定量和定性分析。

為了進行此評估,創建了一個精心挑選的測試集Texture100,該測試集包含100個多樣化的文本提示,描述了角色、動物、織物、景觀等視覺元素。這些提示被用來生成低分辨率的6秒49幀視頻,作為視頻增強比較的輸入。

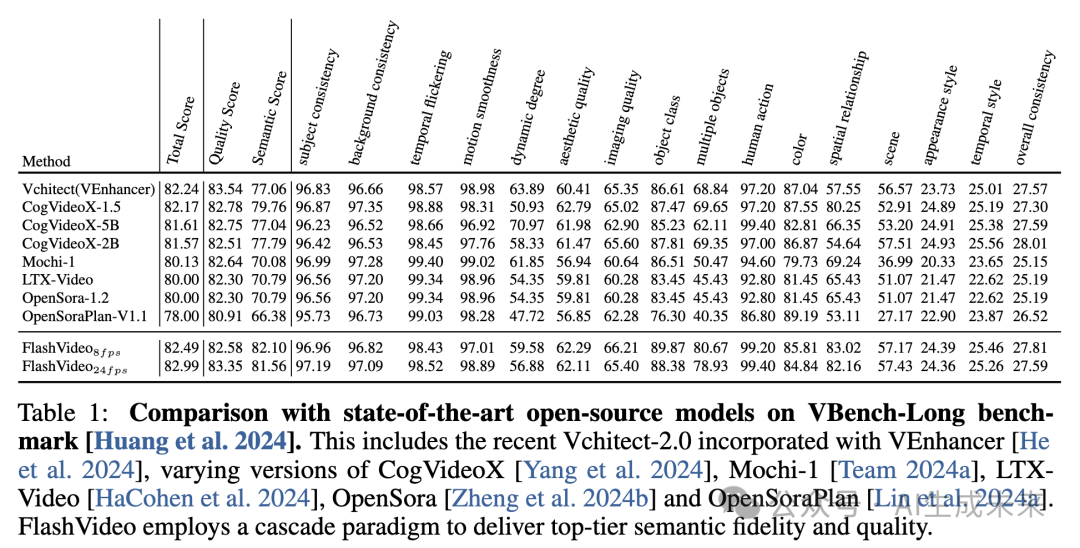

定量分析

如下表2所示,FlashVideo在各種質量指標上始終優于競爭方法,展示了在視覺質量和效率上的顯著優勢。盡管RealBasicVSR(基于GAN的方法)在一些指標上取得了有競爭力的結果,但其輸出常常表現出過度平滑,這可能與人類的感知偏好不一致。因此,建議將定量指標視為補充參考,重點關注定性評估。

與此同時,基于擴散的VEnhancer展示了更強的生成能力,但它的輸出經常與輸入視頻偏離,導致保真度受到損害。它的輸出通常經歷了顯著的結構性變化,這與我們增強視覺質量的設計原則相違背。此外,VEnhancer使用了獨立的空間-時間模塊和時間切片,這可能會減少在擴展視頻序列中的內容一致性——這是我們將在后續討論中進一步探討的限制。另外,它的高NFE(網絡函數評估)導致了更大的計算開銷,使得高分辨率生成變得更加耗時。

與此相比,FlashVideo在速度上幾乎比VEnhancer快了七倍,同時生成更清晰的高頻細節,如上表2所示。

定性分析

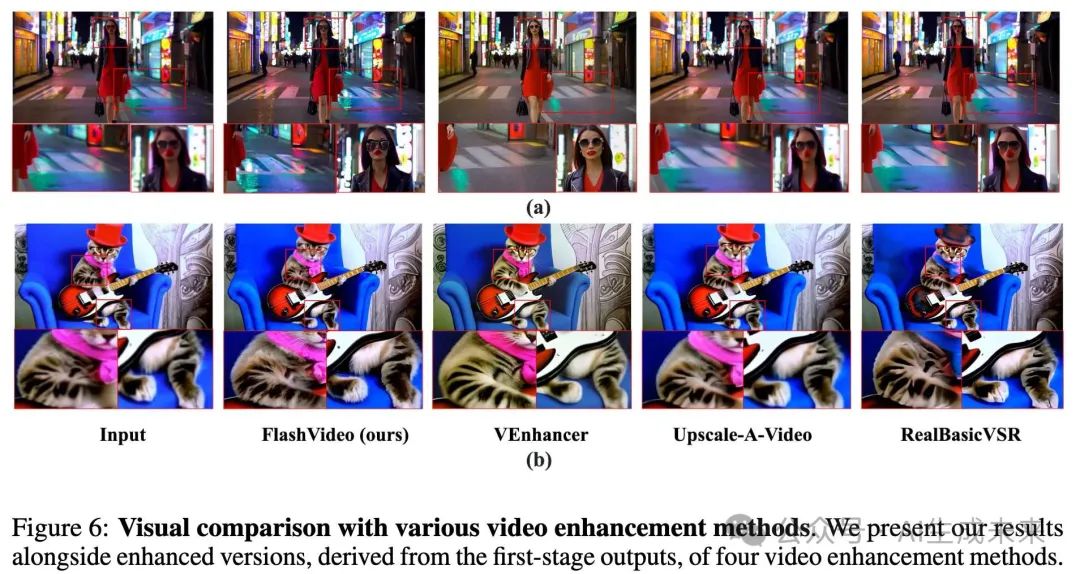

下圖6和圖7提供了FlashVideo與其他方法的視覺質量比較。

- 圖6 (a):這是一場展示女人面部和模糊背景的場景,突出了性能差異。本文的方法有效地重建了復雜的面部細節,并通過高頻紋理豐富了背景,同時保持了結構完整性和保真度。相比之下,VEnhancer提高了面部清晰度,但顯著改變了背景,失去了場景中重要的視覺元素,如“站立水域”和暗色調。其他方法,如Upscale-a-Video和RealBasicVSR未能糾正面部偽影,并引入了過度平滑,降低了逼真度。

- 圖6 (b):在這個案例中,FlashVideo增強了貓體上的紋理細節,同時保持了原始輸入的一致性,并生成了更清晰的個體毛發。我們模型中的全注意力機制確保了內容一致性,超越了VEnhancer,后者在細節上出現不一致。

- 圖7:在這個序列中,攝像機從遠景過渡到近景,導致了顯著的運動和尺度變化。FlashVideo和VEnhancer在初始輸入上都顯示了改進。然而,VEnhancer在保持面部身份方面遇到困難,并引入了夾克紋理和背景元素的不一致。FlashVideo有效地緩解了這些問題,確保了整個序列中的視覺質量穩定一致。

消融研究

本節進行了一系列消融研究,以評估本文方法中的關鍵設計。首先,比較了LoRA微調與全參數微調在將第一階段適配到新分辨率時的優勢。接著,評估了Stage II中RoPE的有效性。然后,我們詳細描述了用于訓練Stage II模型的低質量視頻模擬策略。此外,還探討了將模型輸出與人類偏好對齊的重要性。最后,分析了不同推理超參數對最終性能的影響。

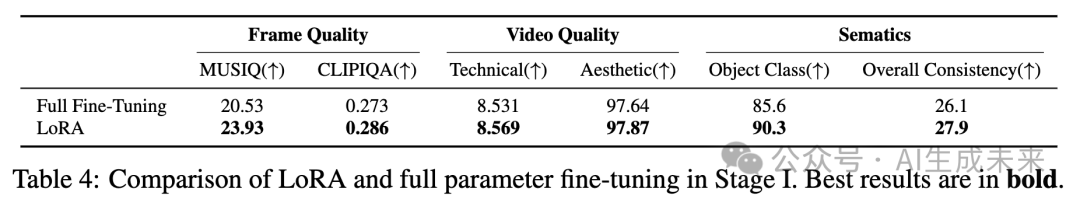

LoRA與全參數微調在第一階段的比較

在批量大小為32的設置中,將LoRA微調與全參數微調進行了比較,目的是在相同的迭代次數下訓練第一階段模型,并將其適配到270p分辨率。使用Texture100評估幀和視頻質量,使用VBench-Long評估與語義相關的分數,如下表4所示。在這種配置下,全參數微調傾向于產生更多的偽影,導致視覺質量和語義保真度的下降。相反,LoRA微調在有效適配到較低分辨率的同時,保留了原始模型的生成能力。根據效率和性能的綜合考慮,選擇了LoRA策略。

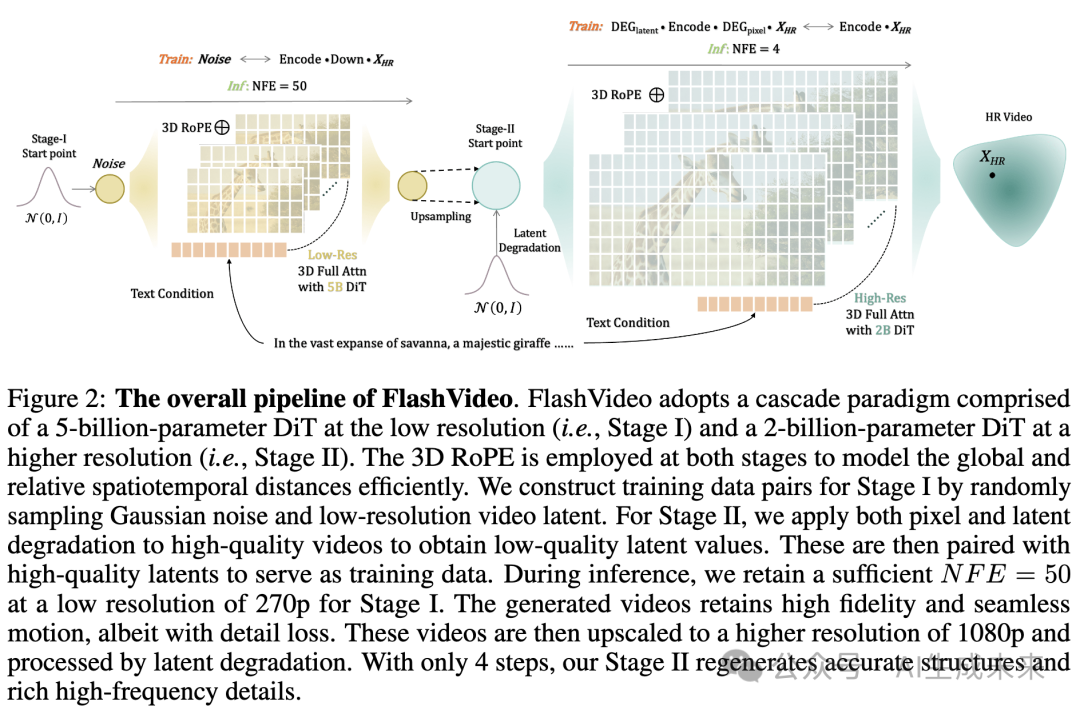

第二階段中的位置嵌入

為了實現高效訓練,首先在低分辨率下訓練第二階段模型,然后在更高分辨率下應用微調。此外,我們的目標是使模型能夠生成比訓練時使用的分辨率更高質量的視頻。為了實現有效的分辨率泛化,我們探索了使用代表性的位置嵌入。具體而言,我們比較了來自2億DiT模型的默認絕對位置嵌入 和旋轉位置嵌入(RoPE),發現RoPE在此類視頻增強任務中表現更優。

使用兩種位置嵌入在540×960分辨率下訓練模型,并在三個設置下進行測試:540×960、1080×1920和1440×2560。對于更大的分辨率,我們使用位置嵌入外推。如下圖8所示,雖然兩種位置嵌入在訓練分辨率下都能產生令人滿意的結果,但RoPE在推理更大分辨率時能夠始終增強細節。相比之下,絕對位置嵌入在超過訓練分辨率時顯現出明顯的偽影。基于這些發現,在訓練第二階段模型時采用了RoPE。

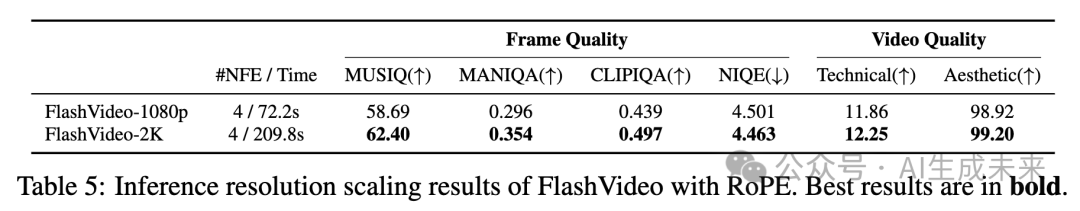

在使用RoPE訓練完1080p(1080×1920)分辨率的模型后,我們進一步擴展推理分辨率到2K(1440×2560),并使用基于RoPE的外推方法。如下表5所示,本文的模型在2K分辨率下的視覺質量有所提升,從視覺比較中可以觀察到。然而,推理時間顯著增加,從74.4秒增加到209.8秒。推測,更大的分辨率更好地激發了我們模型的細節生成能力,這與在大型語言模型中觀察到的推理擴展規律相一致。

第二階段中的低質量視頻模擬

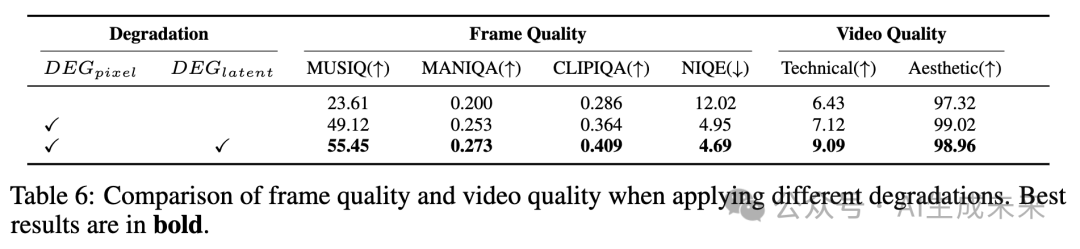

本文通過視覺示例(見前面圖3)展示了在第二階段訓練過程中,結合隱空間和像素降解模擬低質量視頻的重要性。在本節中,提供了更為詳細的定量評估。

為了提高計算效率,使用5幀1080p視頻輸入進行實驗。訓練了兩個模型,迭代10,000次:一個僅應用像素降解,另一個同時應用像素和隱空間降解。如下表6所示,基線表示第一階段的結果。當在第二階段模型中應用像素降解(DEGpixel)時,第一階段的輸出得到了顯著改善,高頻紋理被加入,整體視覺質量得到了提升。此外,結合隱空間降解(DEGlatent)進一步增強了效果,產生了更清晰、更真實的小物體和背景細節。

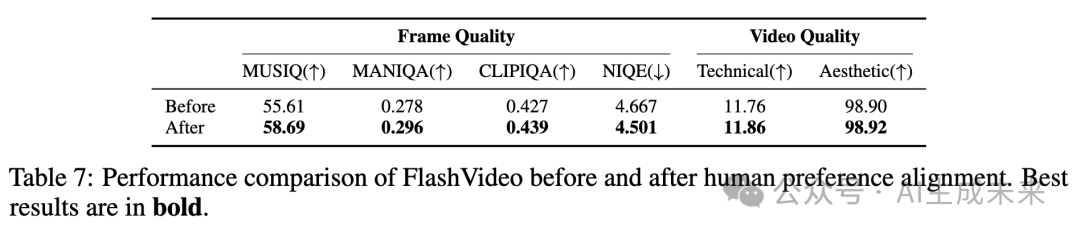

第二階段中的人類偏好對齊

在實驗中,1080p分辨率下的訓練表現出不穩定性,表現為不同檢查點(每500次迭代)間性能波動。我們將這種不一致歸因于訓練樣本質量的變化。為了解決這個問題,我們手動策劃了一個包含50,000個樣本的高質量數據集,特別根據強烈的人類偏好選擇。我們的模型在這個精細化的數據集上進行快速微調,以穩定訓練并提高性能,然后在Texture100基準上進行評估,如下表7所示。盡管選定數據集的大小相對較小,但我們觀察到美學質量和細節豐富度方面的顯著提升。這些結果突出了在微調過程中融入人類偏好的有效性。

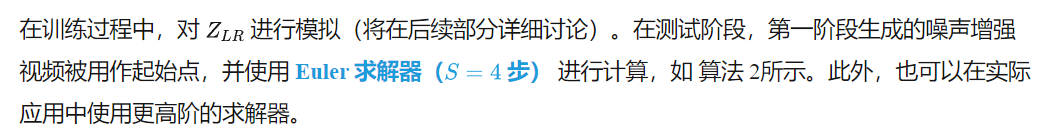

推理超參數

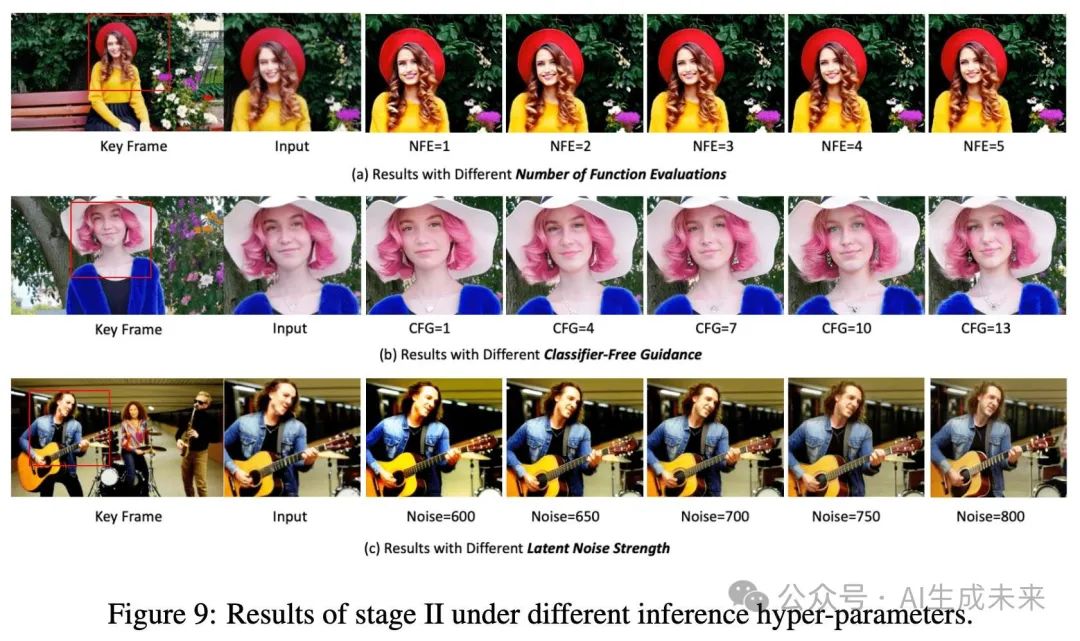

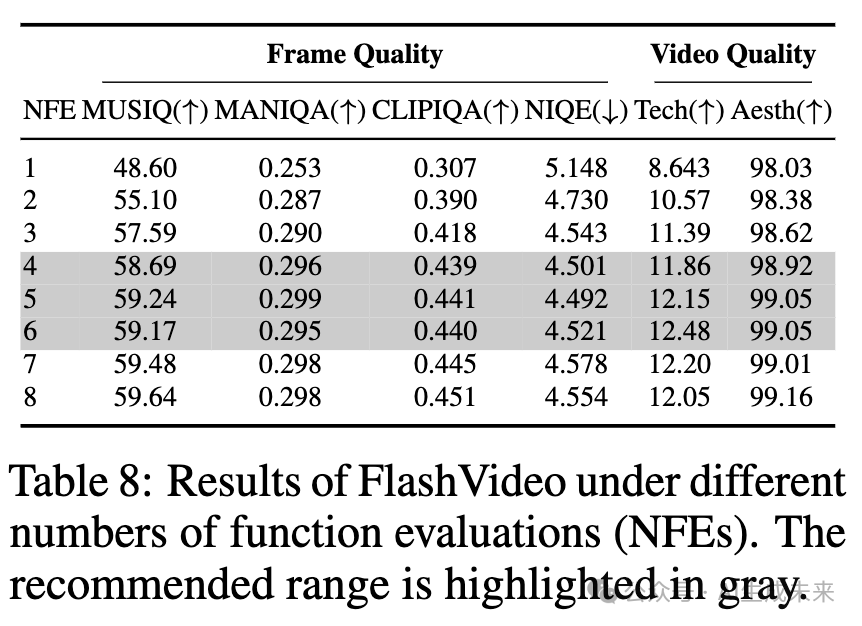

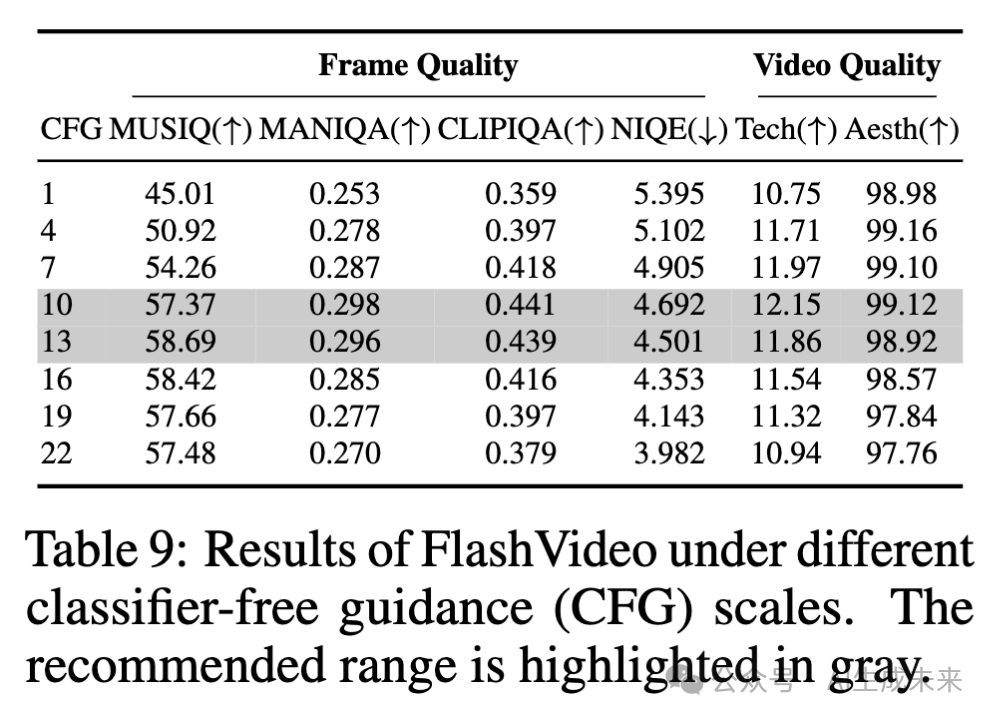

在測試階段,用戶可以靈活調整多個超參數——即函數評估次數(NFE)、無分類器引導(CFG)和隱空間降解強度(噪聲強度)——以滿足特定需求。在圖9中提供了這些超參數如何影響性能的詳細分析,并在表8、9和10中報告了相應的質量評分。除非另有說明,否則這些超參數的默認值設置為NFE=4、CFG=13和NOISE=675。

函數評估次數(NFE)

如下圖9(a)所示,當NFE=1時,處理后的視頻呈現輕微的模糊感。增加NFE可以提高視覺質量,面部細節更加清晰,例如牙齒和頭發,樹葉和毛衣等元素的紋理更加銳利,在NFE=4時表現尤為明顯。當NFE超過4時(即NFE=5或更高),大多數情況下增加該值不會帶來顯著的視覺提升。下表8中報告的某些指標的定性結果驗證了這一趨勢,與視覺觀察一致。建議用戶在實際使用中將NFE調整至4到6之間。

無分類器引導(CFG)

圖9(b)展示了CFG尺度的影響。當CFG=1時,結果仍然模糊,細節不足。隨著CFG值的增加,視頻內容變得更加清晰且細節更為豐富,例如耳環等細節變得更加明顯。具體而言,CFG值在10到13之間可以獲得令人滿意的結果,能夠平衡銳度和細節。然而,CFG值超過13后,銳度過高,導致紋理顯得不自然。如下表9所示,隨著CFG從1增加到13,圖像和視頻質量評分都有所提高,但當CFG超過13時,多個指標的評分下降。

隱空間降解強度

隱空間降解強度通過公式2中的NOISE步驟量化,表示施加到第一階段視頻隱空間變量上的降解程度。如圖9(c)所示,在較低的降解水平下,增強后的視頻保持較高的與原始輸入的一致性。這種一致性有助于維持整體內容的完整性,但可能會妨礙偽影的修復,并限制細節的生成,如手指、吉他弦和表面紋理等。然而,增加噪聲強度有助于生成更多的視覺細節,但如果噪聲過多,可能會扭曲結構或引入模糊,這是由于第二階段生成能力的固有限制。在初始訓練階段,使用了600-900的廣泛噪聲步長范圍。通過評估不同噪聲步長下的模型性能(如前面表10上部所示),發現650-750的范圍能夠獲得與視覺觀察一致的令人滿意的結果。因此,在后續訓練階段,采用了更窄的范圍,最終性能如表10下部所示。

討論與局限性

討論

在這一部分,分享了一些洞見,旨在幫助讀者更清晰地理解我們工作設計原則和定位,并為隱空間的未來改進提供指導。

隱空間降解強度的調整原則

選擇合適的隱空間降解強度對于訓練Stage II模型至關重要。我們認為,最小化偽影和保持原始內容完整性之間的平衡是關鍵。我們建議根據信噪比(SNR)調整隱空間降解強度,即當分辨率或視頻幀數增加時,應增加噪聲步長。值得注意的是,幀數對噪聲步長的影響大于分辨率,因為跨多個幀的視覺內容展現出更強的相關性,不容易被干擾。例如,在初步實驗中,當使用17幀視頻時,輸入中的偽影可以通過噪聲步長500得到糾正,而當幀數增加到49幀時,最佳噪聲范圍則為650到750,明顯高于前者。

保真度與視覺質量提升的平衡

在維持保真度與提高視覺質量之間存在微妙的平衡。與真實世界的視頻增強不同,輸入視頻通常缺乏高頻細節,而第一階段生成的視頻往往包含一些微妙的結構缺陷或偽影,需要進一步修復。傳統的超分辨率方法專注于保持高保真度,無法有效地解決這些問題。相反,將第一階段輸出作為粗略指導并再生新內容也無法達到理想效果,因為這與我們的設計理念相沖突。我們將第一階段的輸出視為低成本的預覽,它必須與最終結果密切對齊。為實現這一平衡,我們仔細調整了兩種策略的強度,確保在不妥協原始內容完整性的情況下提高視覺質量。

Stage II是否可以作為通用的視頻增強模型?

值得注意的是,目前的訓練設置是專門為1080p設計的,不適合作為處理不同分辨率或幀數視頻的通用增強方法。然而,我們相信,隨著進一步的優化,例如引入關于分辨率和幀數的更多輸入信息,模型可以適應處理更廣泛的場景。我們計劃在未來的工作中探索這一方向。

視頻長度增加帶來的挑戰

視頻增強比單張圖像處理更具挑戰性,因為它需要確保在整個視頻序列中新增細節的一致性。這要求模型不僅要提高視覺質量,還要管理跨幀的復雜視覺關系和運動。在Stage II中,通過采用3D全注意力機制和調整降解強度來解決這些挑戰。然而,隨著視頻長度的增加,3D全注意力的計算需求呈平方級增長。此外,如果降解強度沒有仔細調整,模型可能會通過直接引用多個幀來恢復細節,從而在推理過程中妥協其生成能力。

Stage II中的稀疏注意力

可視化了Stage II中的注意力圖,發現空間上的稀疏性特別顯著,相較于時間上的稀疏性。我們將這一現象歸因于當前第一階段輸出中的適度運動強度。為減少Stage II的計算成本,應用了FlexAttention,通過實現基于窗口的時空注意力(H=11, W=11, T=7)。結果表明,當第一階段的輸出包含低運動時,該方法具有顯著提高的效率表現。然而,當運動較大時,我們觀察到再生的視覺細節存在不一致和模糊的情況。建議,未來的工作可以通過根據運動強度動態調整窗口大小來解決這一問題。

兩階段的分辨率無論是在第一階段(從270p到360p,結果見補充材料)還是在第二階段(從1080p到2K),提高分辨率都會改善我們的結果。在足夠的計算資源下,可以在兩個階段都追求更高的分辨率。選擇270p作為第一階段的分辨率,是因為它能夠在僅30秒的時間內生成初步結果,使用戶能夠迅速評估是否需要在Stage II中進行進一步計算。這相比于當代方法具有明顯的優勢。

局限性

高分辨率視頻的VAE解碼耗時

由于GPU內存限制,解碼1080p視頻需要進行空間和時間切片,這一過程十分耗時。并行處理的工程進展以及更高效的VAE架構對于加速高分辨率視頻的生成至關重要。

推理時的長文本提示

訓練中采用的文本描述通常較長且詳細,這可能增加用戶在推理時提供提示的復雜性。未來的研究可以通過聯合訓練短文本提示或使用專門用于提示重寫的語言模型來改進。這一進展能夠顯著提升用戶體驗。

快速運動的挑戰由于數據量、質量和多樣性的限制,Stage II可能在處理快速運動的視頻時失敗。隱空間的解決方案包括增加更多包含大運動的數據和擴大模型容量。

結論

FlashVideo,一種新穎的兩階段框架,分別優化了提示保真度和視覺質量。這種解耦使得模型能力和函數評估次數(NFE)能夠在兩個分辨率之間進行策略性分配,從而大大提高了計算效率。在第一階段,FlashVideo優先考慮低分辨率下的保真度,利用較大的參數和足夠的NFE;第二階段則在低分辨率和高分辨率之間進行流匹配,利用較少的NFE有效生成細節。大量實驗和消融研究驗證了我們方法的有效性。此外,FlashVideo能夠在極低成本下提供初步結果,使用戶能夠決定是否繼續進入增強階段。這一決策能力可以顯著降低用戶和服務提供商的成本,具有巨大的商業價值。

本文轉自AI生成未來 ,作者:AI生成未來