人物照片+文字 = 定制化視頻,騰訊光子開(kāi)源ID-Animator

近年來(lái),定制化的人物生成技術(shù)在社區(qū)中引起了廣泛關(guān)注。一系列創(chuàng)新性的模型,如 IP-Adapter、Photomaker、InstantID 等,已在圖像生成領(lǐng)域取得了令人矚目的成果。這些定制化內(nèi)容生成方法逐漸成為主流,其一個(gè)重要的優(yōu)勢(shì)便是即插即用,取代了那些需要逐例微調(diào)的 Dreambooth,LoRA 等方法。

然而,盡管在圖像生成領(lǐng)域取得了巨大的成功,這些方法在視頻生成領(lǐng)域卻遇到了阻礙。相較于圖像,視頻生成模型的訓(xùn)練需要更大的算力投入。同時(shí),在視頻數(shù)據(jù)集方面,迄今為止仍缺乏類似圖像生成領(lǐng)域高質(zhì)量的文本 - 視頻配對(duì)人臉數(shù)據(jù)集。此外,如何提取人物身份一致性的特征也是一個(gè)難題。

為了應(yīng)對(duì)這些挑戰(zhàn),騰訊光子近期發(fā)布的工作 ID-Animator,提出了一種文本驅(qū)動(dòng)的人物視頻生成框架。該框架旨在根據(jù)給定的一張參考圖片,生成一致性的角色 定制化視頻。通過(guò)這一創(chuàng)新性技術(shù),研究者可以期待在不久的將來(lái),人們將能夠更輕松地實(shí)現(xiàn)定制化的人物視頻生成,從而為各種應(yīng)用場(chǎng)景帶來(lái)更加豐富的視覺(jué)體驗(yàn)。

- 論文地址: https://arxiv.org/abs/2404.15275

- Github 地址: https://github.com/ID-Animator/ID-Animator

- Huggingface 地址: https://huggingface.co/spaces/ID-Animator/ID-Animator

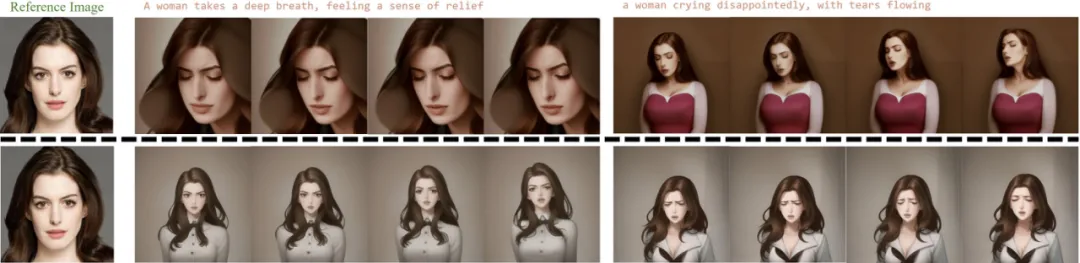

首先,讓我們直觀感受一下 ID-Animator 生成的視頻效果,能夠輕松的讓不同的角色做起豐富的動(dòng)作:

ID-Animator 不僅能生成 ID 一致的人類視頻,還具備人臉特征融合的能力:

此外,ID-Animator 還可以兼容開(kāi)源社區(qū)上的多種權(quán)重,為視頻生成帶來(lái)更多可能性:

方法概覽

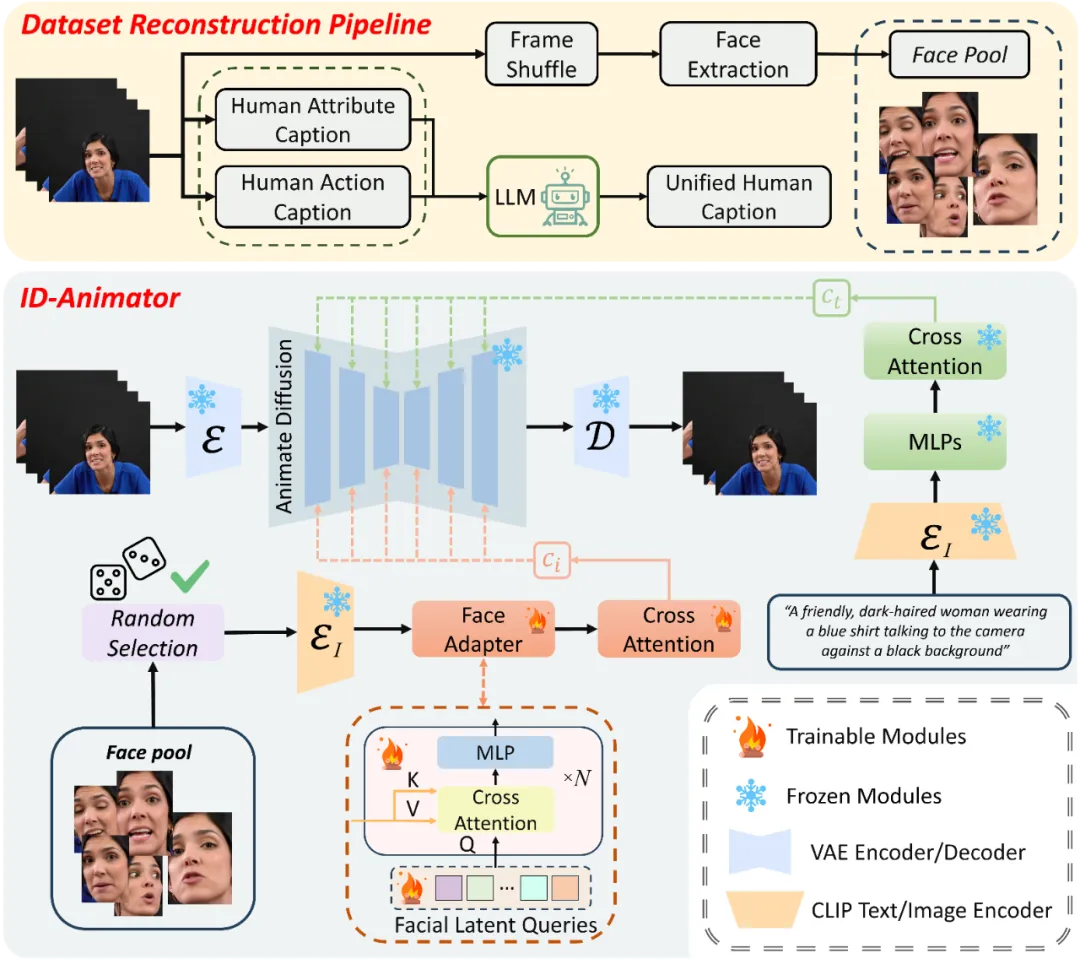

研究團(tuán)隊(duì)提出的方法可以概括為三個(gè)核心組件,如圖所示。這三個(gè)部分包括:面向 ID 的視頻數(shù)據(jù)集重構(gòu)流程、隨機(jī)人臉參考的訓(xùn)練方法,以及 ID-Animator 模型框架。通過(guò)這三個(gè)關(guān)鍵組成部分,ID-Animator 成功實(shí)現(xiàn)了高保真的一致性人物視頻生成。

ID-Animator 框架

ID-Animator 框架由一個(gè)輕量級(jí)的人臉適配器模塊和一個(gè)視頻生成主干網(wǎng)絡(luò)組成。其視頻生成主干網(wǎng)絡(luò)權(quán)重在訓(xùn)練過(guò)程中保持固定,無(wú)需微調(diào)。人臉適配器模塊則由交叉注意力模塊和可學(xué)習(xí)的面部特征查詢組成,負(fù)責(zé)從 CLIP 編碼的特征中提取與身份相關(guān)的表征,并將身份表征注入主干網(wǎng)絡(luò)。利用這種輕量級(jí)的適配器模塊,ID-Animator 只需要很小的訓(xùn)練開(kāi)銷就能實(shí)現(xiàn)人物一致性的視頻生成。

面向 ID 的數(shù)據(jù)集構(gòu)建

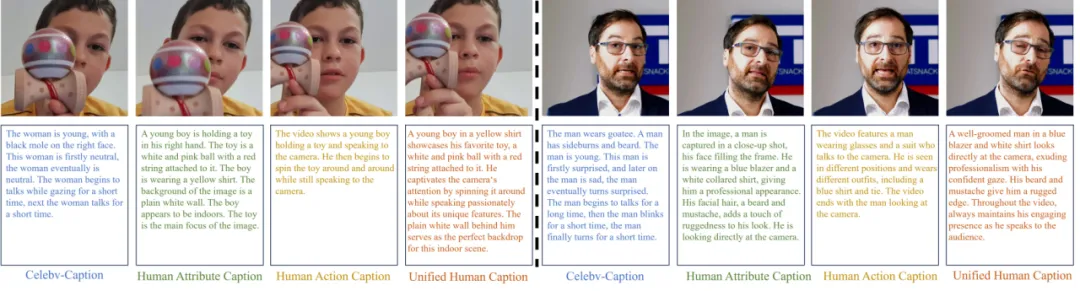

為了應(yīng)對(duì)以 ID 為核心的成對(duì)視頻 - 文本數(shù)據(jù)集在視頻生成領(lǐng)域的稀缺挑戰(zhàn),研究者們提出了一套巧妙的數(shù)據(jù)集重構(gòu)策略。他們利用現(xiàn)有的 Celebv-HQ 數(shù)據(jù)集,將其重構(gòu)為以 ID 為中心的人類視頻數(shù)據(jù)集。這一策略分為兩個(gè)主要步驟:文本重寫(xiě)和面部圖像資源庫(kù)構(gòu)建。

現(xiàn)有的 Celebv 數(shù)據(jù)集的文本描述采用固定模板,主要關(guān)注人物表情的變化,卻忽略了人物屬性與所處環(huán)境,同時(shí)缺乏對(duì)動(dòng)作的描述,因此不適用于文本生成視頻的訓(xùn)練。為了解決這一問(wèn)題,研究者們提出了一種新穎的文本重寫(xiě)方法,旨在生成更貼切的人類視頻描述文本。考慮到視頻整體特征和人物靜態(tài)屬性,他們采用了一種解耦式的文本重寫(xiě)方法,分別描述人物屬性和環(huán)境,生成人類屬性描述;同時(shí)描述視頻中人物的整體動(dòng)作,生成動(dòng)作描述。最后,借助大型語(yǔ)言模型將兩種描述整合,生成連貫且豐富的全新文本。

如圖所示,重寫(xiě)后的文本描述更接近人類的語(yǔ)言風(fēng)格,并能更好地描述人物的運(yùn)動(dòng)和屬性。這一創(chuàng)新性方法為視頻生成領(lǐng)域提供了一個(gè)更實(shí)用、更高質(zhì)量的數(shù)據(jù)集基礎(chǔ)。

為了進(jìn)一步提升生成視頻的身份保持能力,研究者們引入了一種隨機(jī)面部提取技術(shù)。這種技術(shù)的特點(diǎn)在于,它并不直接采用整個(gè)視頻幀作為生參考圖像,而是構(gòu)建數(shù)據(jù)集時(shí)專門(mén)針對(duì)人臉區(qū)域進(jìn)行隨機(jī)采樣,從而形成一個(gè)獨(dú)立的面部圖像資源庫(kù)。這一策略有效地過(guò)濾了大量非身份決定性的視覺(jué)信息,如背景變化、衣著裝飾等,使得生成模型能夠更加專注于學(xué)習(xí)和重現(xiàn)個(gè)體的面部特征與表情細(xì)節(jié)。

隨機(jī)參考人臉訓(xùn)練方法

利用數(shù)據(jù)集面部資源庫(kù),研究者們提出了一種隨機(jī)參考人臉的訓(xùn)練方法。這種方法的核心在于利用與視頻內(nèi)容弱相關(guān)的參考圖像作為條件輸入,引導(dǎo)模型在生成視頻內(nèi)容時(shí),更多地關(guān)注指令指導(dǎo)的動(dòng)作和 ID 無(wú)關(guān)特征。

具體操作上,研究者們從人臉資源庫(kù)中隨機(jī)選取參考圖像,使得每次訓(xùn)練迭代都能為模型提供一個(gè)新的、與目標(biāo)視頻序列關(guān)聯(lián)較弱的面部圖像作為參考。這種方法實(shí)現(xiàn)了視頻內(nèi)容與人臉參考圖像的解耦,有助于模型更好地學(xué)習(xí)和生成符合指令的動(dòng)作,同時(shí)減弱與身份無(wú)關(guān)的特征的影響。

實(shí)驗(yàn)結(jié)果

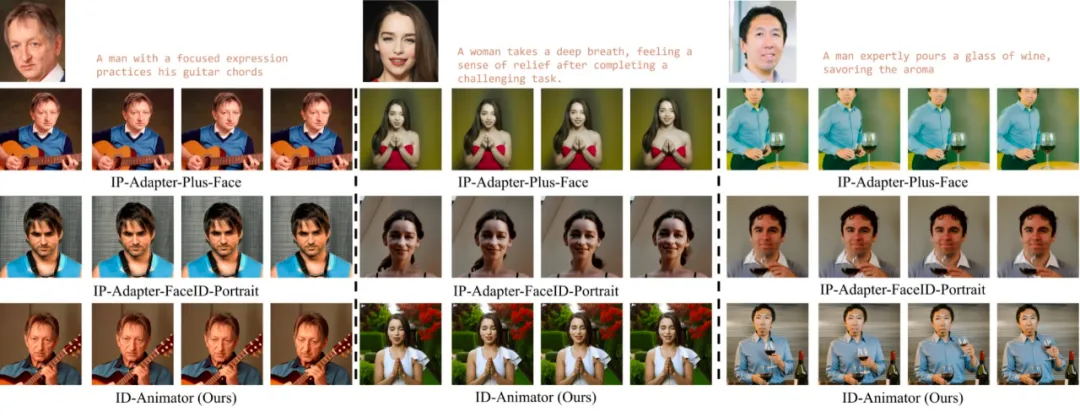

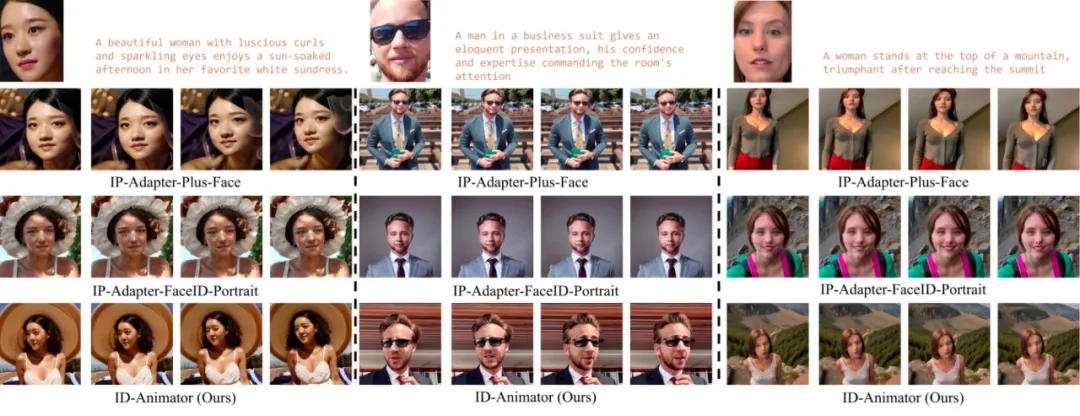

與 IP-Adapter 對(duì)比

研究者們首先將 ID-Animator 與常用的零樣本定制化圖像生成模型 IP-Adapter 的變體進(jìn)行對(duì)比。將零樣本定制化圖像生成模型直接應(yīng)用于視頻生成時(shí),可能會(huì)導(dǎo)致指令跟隨能力和 ID 一致性的降低。為了證明 ID-Animator 的優(yōu)越性能,研究者們展示了在 3 個(gè)名人和普通人上的對(duì)比結(jié)果。

如圖所示,ID-Animator 在視頻場(chǎng)景下展現(xiàn)出了更強(qiáng)大的指令跟隨能力和 ID 保真度。

應(yīng)用展示

- 上下文重塑:ID-Animator 能夠利用文本引導(dǎo),動(dòng)態(tài)調(diào)整角色的多維度屬性,包括發(fā)型、服飾、性別,執(zhí)行特定的動(dòng)作和改變角色所處環(huán)境等。

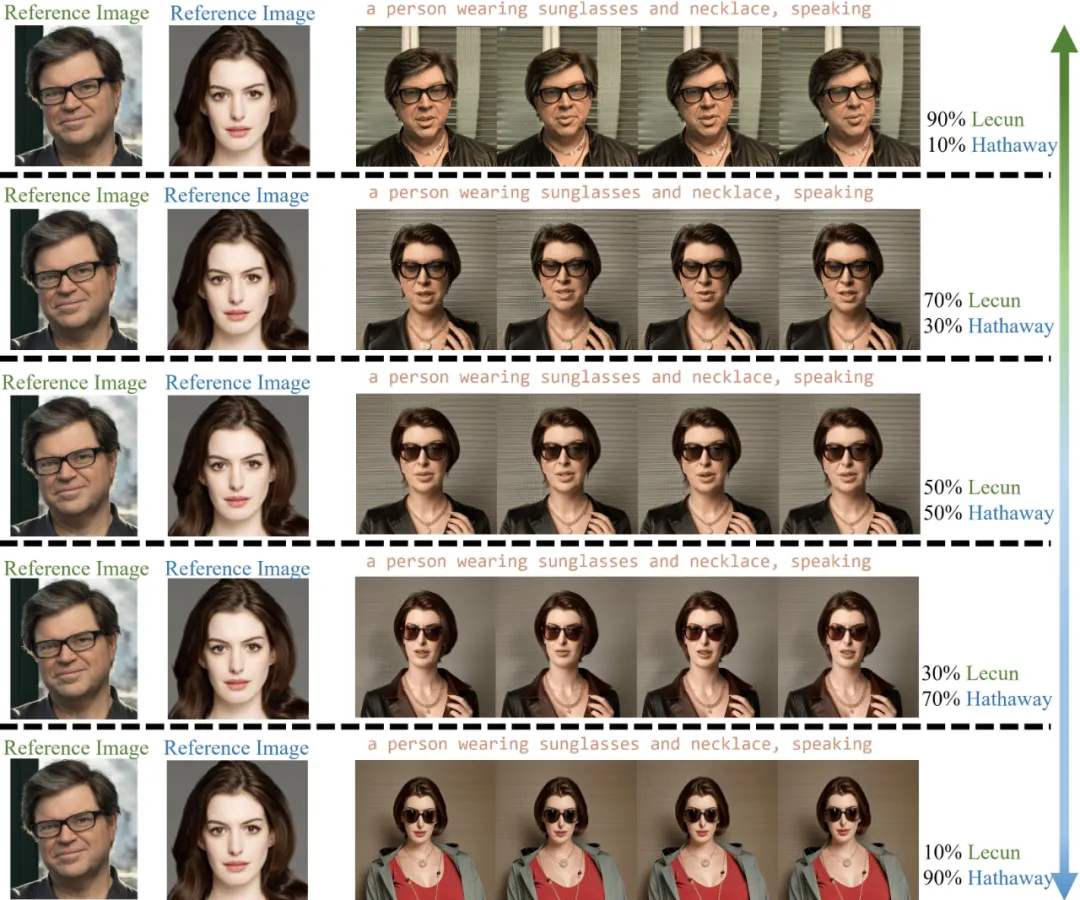

- ID 特征融合: ID-Animator 能夠?qū)⒉煌矸莸奶卣饕圆煌壤旌希瑥亩山Y(jié)合兩種身份特征的視頻。

- 與 ControlNet 結(jié)合:ID-Animator 具有與 ControlNet 等現(xiàn)有細(xì)粒度條件模塊的兼容性,這意味著用戶能通過(guò)上傳特定的引導(dǎo)圖像或圖像序列,精確指引視頻中每一幀的生成細(xì)節(jié)。

- 社區(qū)模型推理:ID-Animator 能夠和 Civitai 社區(qū)的多種模型兼容,即使在未曾訓(xùn)練過(guò)的模型權(quán)重上也能保持有效性,能夠生成多種風(fēng)格的視頻。

更多詳細(xì)內(nèi)容,請(qǐng)閱讀原論文。

本文轉(zhuǎn)自 機(jī)器之心 ,作者:機(jī)器之心