在對齊 AI 時,為什么在線方法總是優于離線方法? 精華

在 AI 對齊問題上,在線方法似乎總是優于離線方法,但為什么會這樣呢?近日,Google DeepMind 一篇論文試圖通過基于假設驗證的實證研究給出解答。

- 論文標題:Understanding the performance gap between online and offline alignment algorithms

- 論文地址:???https://arxiv.org/abs/2405.08448???

根據人類反饋的強化學習(RLHF)隨著大型語言模型(LLM)發展而日漸成為一種用于 AI 對齊的常用框架。不過近段時間,直接偏好優化(DPO)等離線方法異軍突起 —— 無需主動式的在線交互,使用離線數據集就能直接對齊 LLM。這類方法的效率很高,也已經得到實證研究的證明。但這也引出了一個關鍵問題:

AI 對齊是否必需在線強化學習?

對于這個問題,人們希望既知道其理論上的答案,也希望明晰實驗給出的解答。

從實證角度看,相比于大家常用的在線 RLHF(由偏好建模和從模型采樣組成),離線算法實現起來要簡單得多,成本也低得多。因此,收集有關離線算法的充分性的證據可讓 AI 對齊變得更加簡單。另一方面,如果能明晰常用在線 RLHF 的優勢,也能讓我們理解在線交互的基本作用,洞見離線對齊方法的某些關鍵挑戰。

在線算法與離線算法的對比

要公平地比較在線和離線算法并非易事,因為它們存在許多實現和算法方面的差異。舉個例子,在線算法所需的計算量往往大于離線算法,因為它需要采樣和訓練另一個模型。因此,為了比較公平,需要在衡量性能時對不同算法所耗費的預算進行一定的校準。

在 DeepMind 的這項研究中,研究團隊在比較時并未將計算量作為一個優先考慮因素,而是采用了 Gao et al. (2023) 的論文《Scaling laws for reward model overoptimization》中的設置:使用 RLHF 策略和參考 SFT 策略之間的 KL 散度作為預算的衡量指標。

在不同的算法和超參數設置中,KL 散度是以一種統一的方式衡量 RLHF 策略與 SFT 策略的偏離程度,從而能以一種經過校準的方式對算法進行比較。

基于古德哈特定律比較在線和離線算法的性能

首先,該團隊比較了在線和離線算法的過度優化(over-optimization)行為 —— 該行為可通過將古德哈特定律外推至 AI 對齊領域而預測得到。

簡單總結起來,古德哈特定律(Goodhart’s law)可以表述成:一項指標一旦變成了目標,它將不再是個好指標。

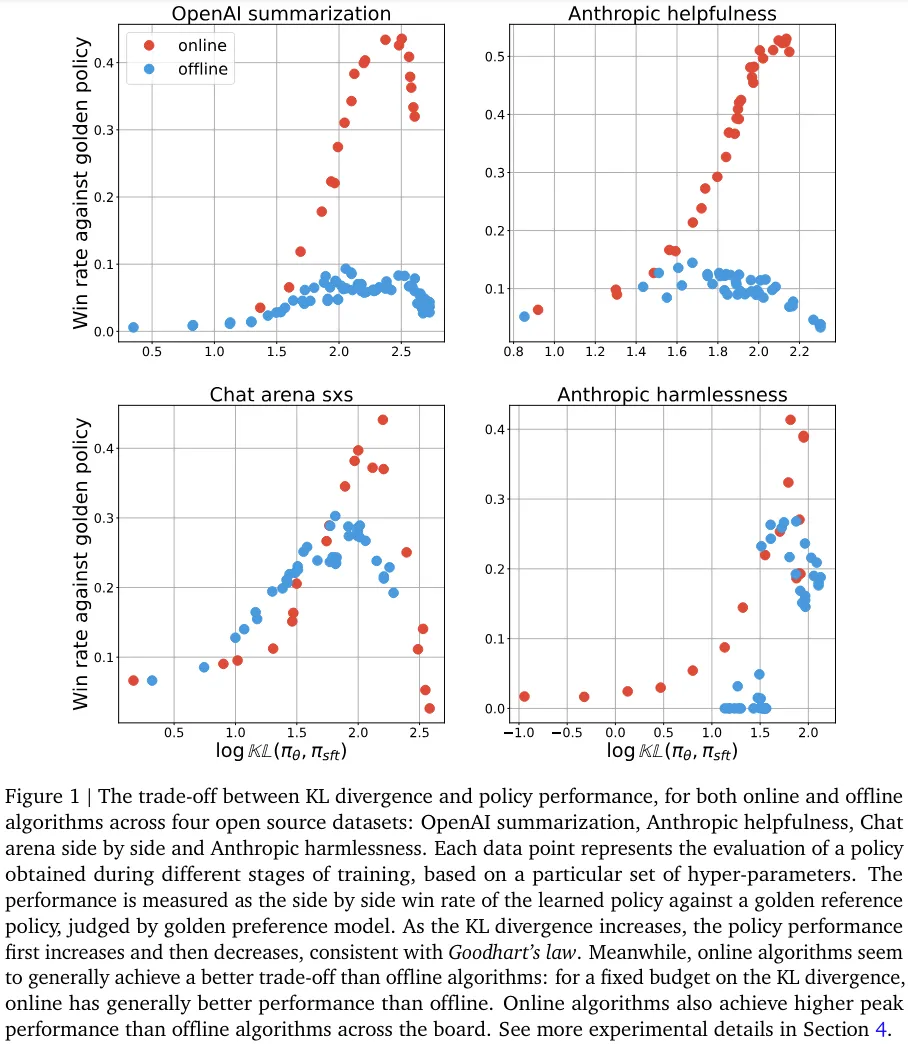

該團隊采用了與 Gao et al. (2023) 類似的設置,基于一組開源數據集進行了實驗,結果表明:在同等的優化預算(相對于 SFT 策略的 KL 散度)下,在線算法的性能表現通常優于離線算法。

圖 1 給出了在線和離線算法在四個不同的開源數據集上表現出的 KL 散度與策略性能之間的權衡。圖中的每個數據點代表了在訓練過程中某個特定檢查點下,針對特定一組超參數的策略評估結果。

其中,對于在線算法,超參數并未被大量調整,而是始終使用一組固定的超參數;對于離線算法,則是將不同超參數的結果池化后得出。可以觀察到如下結果:

- 符合古德哈特定律的過度優化。不管是在線還是離線算法,性能都會隨 KL 散度先升后降。后期下降的原因是過度優化效應,這符合古德哈特定律的預測。

- 在線算法能比離線算法更高效地使用 KL 散度預算。相比于離線算法,在線算法似乎通常能實現更好的權衡。具體而言,在 KL 散度度量的預算一樣時,在線算法得到的性能通常優于離線算法。在不同的 KL 散度層級上,在線算法在所有任務上的峰值性能都高于離線算法。其中,在 OpenAI 摘要和 Anthropic 輔助任務上的峰值性能差異顯著,在另兩個任務上的峰值差異較小。

總之,在線算法完全勝過離線算法,這也奠定了后續研究的基礎。

對于在線和離線算法性能差異的假設

為了更好地理解在線和離線算法性能差異的根源,該團隊通過假設驗證的形式進行了研究。

也就是說首先提出一些假設,然后驗證它是否正確。先來看看他們提出了怎樣的假設。

假設 1:數據覆蓋情況。在線算法更優的原因是其覆蓋的數據比離線數據集更多樣化(即隨時間變化采樣自不同的學習器策略)。

假設 2:次優的離線數據集。離線算法處于劣勢,因為其初始的偏好數據集是由一個次優的策略生成的。如果使用有更高絕對質量的響應訓練離線算法,則性能會更好。

假設 3:分類能力更好,則性能更好。離線算法通常是將策略作為分類器進行訓練。但是,作為分類器,它們可能并不如代理偏好模型那樣準確(因為對分類進行參數化的有效方式不同)。如果準確度提升,則其性能也會提升。

假設 4:非對比式損失函數。在這樣的性能差異中,有多大部分可歸因于對比式的損失函數,而不是離線的樣本?

假設 5:擴展策略就足夠了。要彌合在線和離線算法之間的差距,只需提升策略大小就足夠了。

實驗和結果

實驗設置

為了驗證上述假設,該團隊進行了大量對照實驗。

所有實驗都使用 T5X 模型,并搭配了 T5X 數據和計算框架。為了較好地覆蓋 RLHF 問題,他們研究了四種任務:OpenAI 摘要、Anthropic 輔助、聊天競技場、Anthropic 無害性。

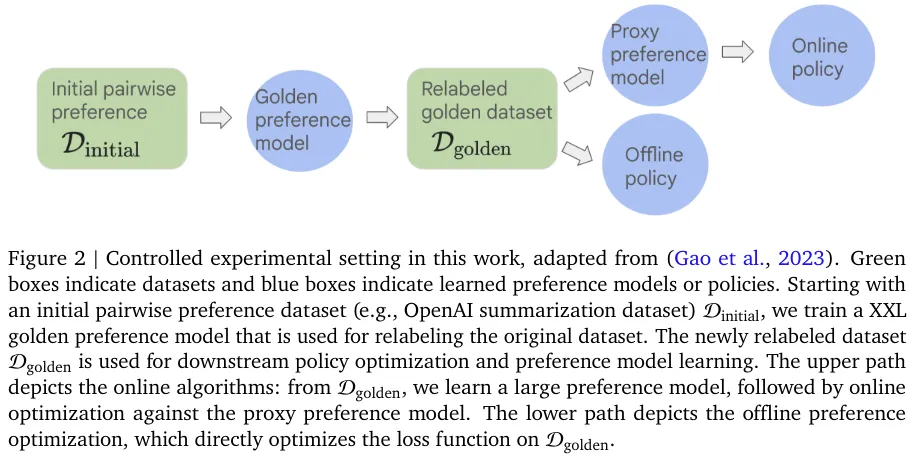

圖 2 給出了這些對照實驗的設置情況,其整體上基于 Gao et al., 2023。其中,綠框表示數據集,藍框表示學習到的偏好模型或策略。

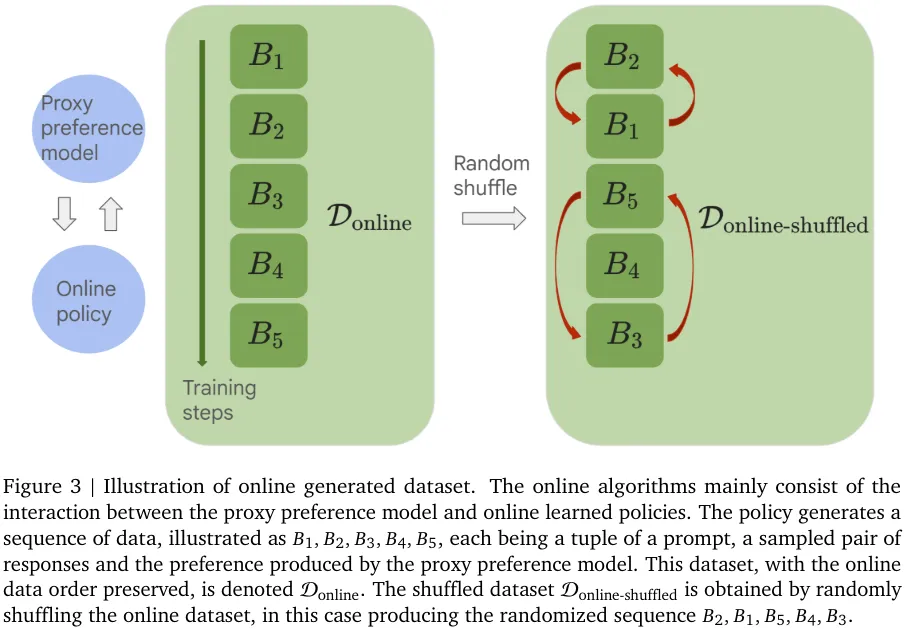

圖 3 則給出了在線生成數據集的圖示。這里的在線算法主要由代理偏好模型和在線學習的策略之間的交互組成。

該團隊的實驗研究涉及多個維度,其得到的主要結果如下。

數據

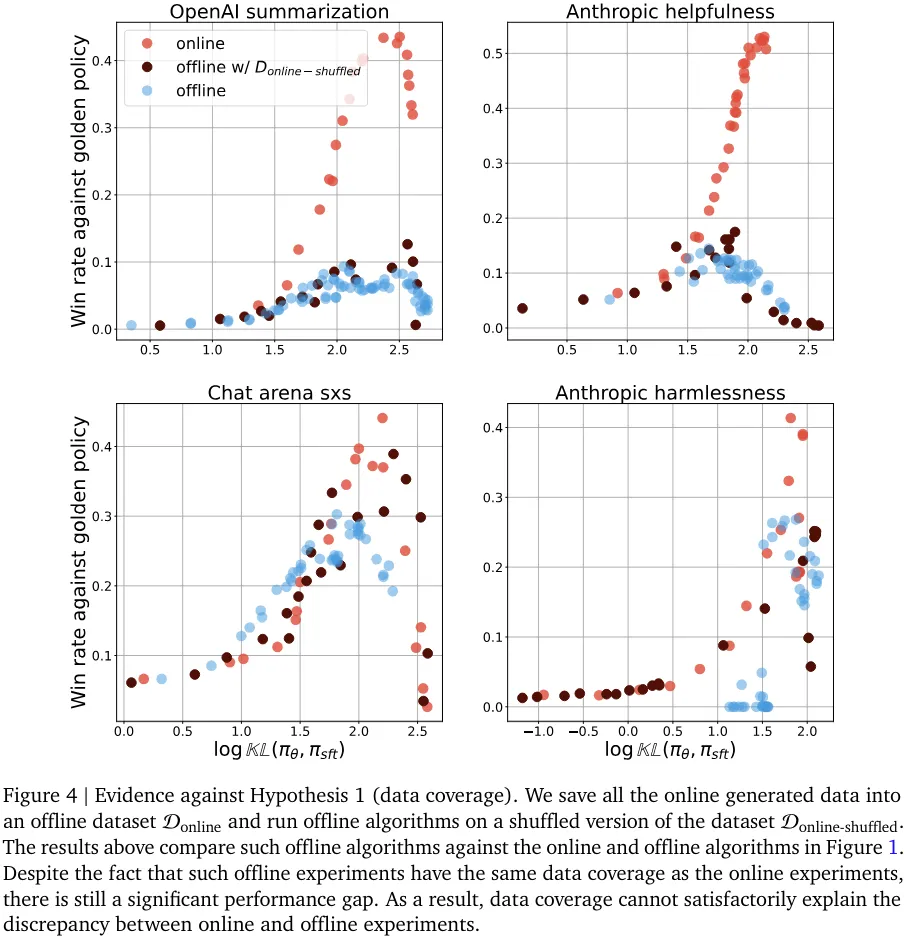

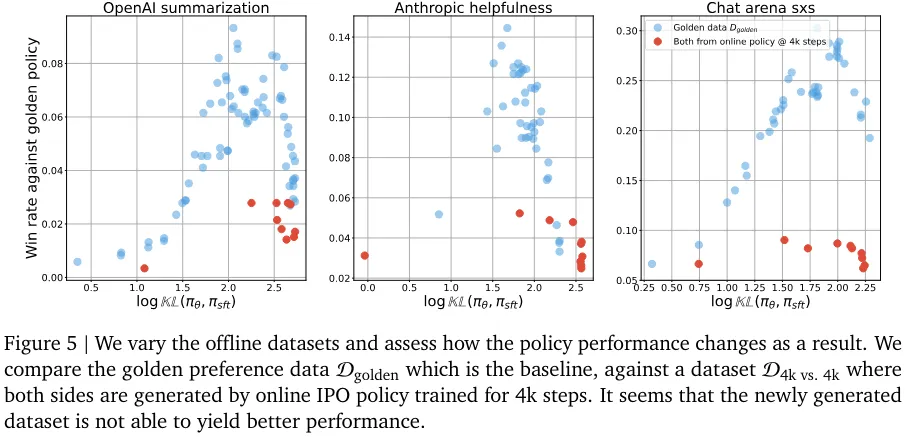

該團隊提出的一些假設涉及到離線數據集的性質。其中包括假設離線數據集的覆蓋情況比在線生成的數據集差;假設離線算法對離線數據集更敏感,而離線數據集中響應的絕對質量要差一些。(圖 4 和圖 5 分別證否了這兩個假設)。

盡管這些假設聽上去似乎是對的,但實驗結果表明它們無法可信地解釋在線和離線算法的性能差距。

他們通過消融研究發現,提升離線優化的一種有效方法是生成分布上接近起始 RLHF 策略(這里就剛好是 SFT 策略)的數據,這本質上就模仿了在線算法的起始階段。

優化性質

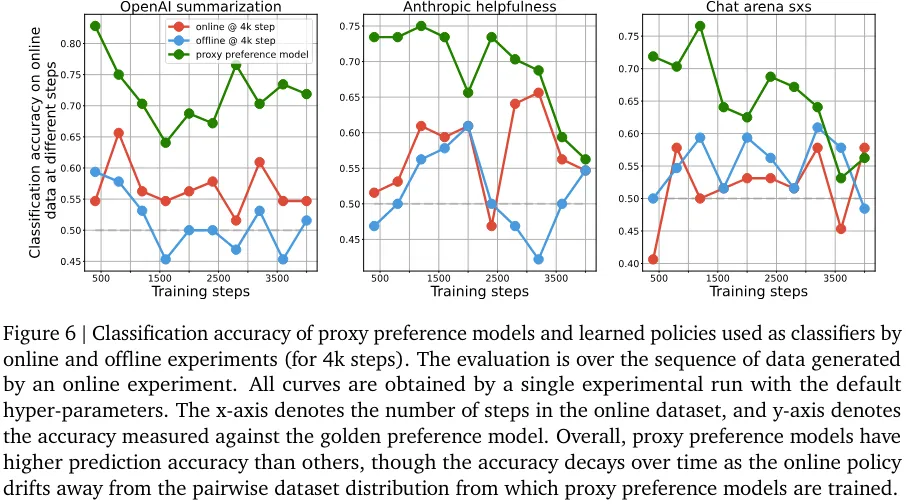

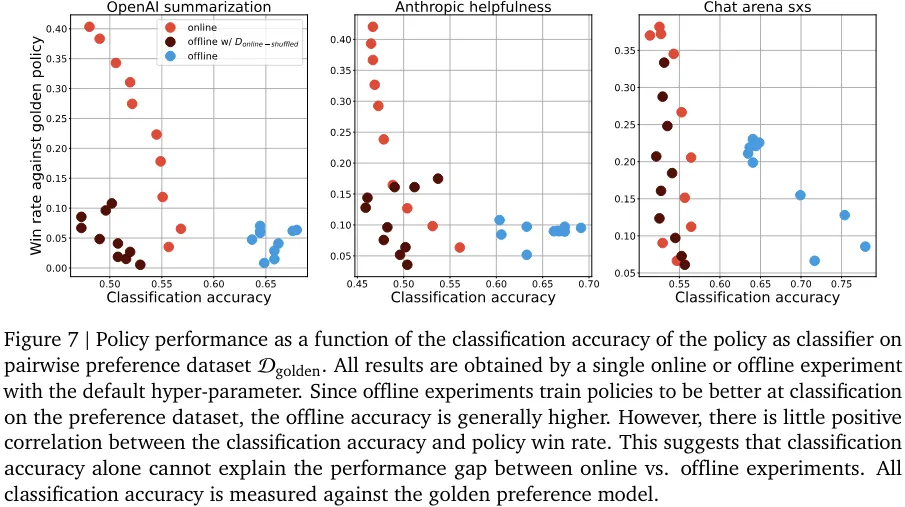

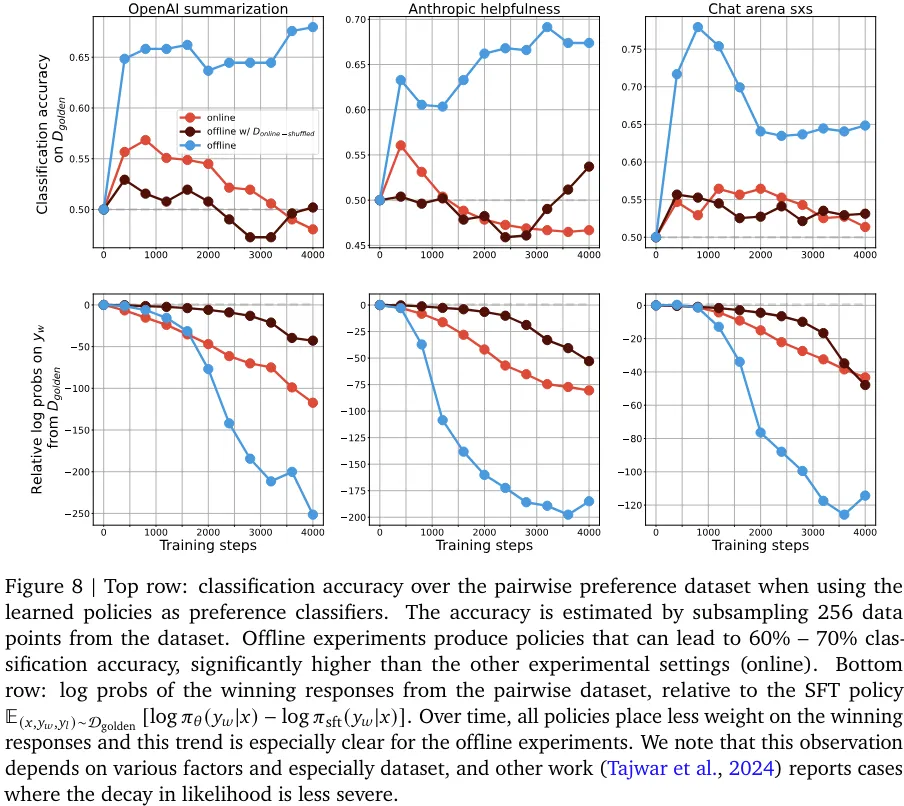

該團隊發現判別能力和生成能力之間存在一種有趣的相互作用:盡管離線策略的分類能力勝過在線策略,但離線策略生成的響應卻更差(見圖 6、7、8)。

不管是類間分類還是類內分類實驗,分類性能和生成性能之間的關聯似乎都不大。盡管離線和在線采樣都是針對一個判別目標優化的,但離線采樣是提升在一個靜態數據集上的分類準確度,而在線采樣則是通過不斷改變采樣分布來提升生成質量。實驗表明,離線策略的生成性能提升不如在線策略的直接。

損失函數與擴展

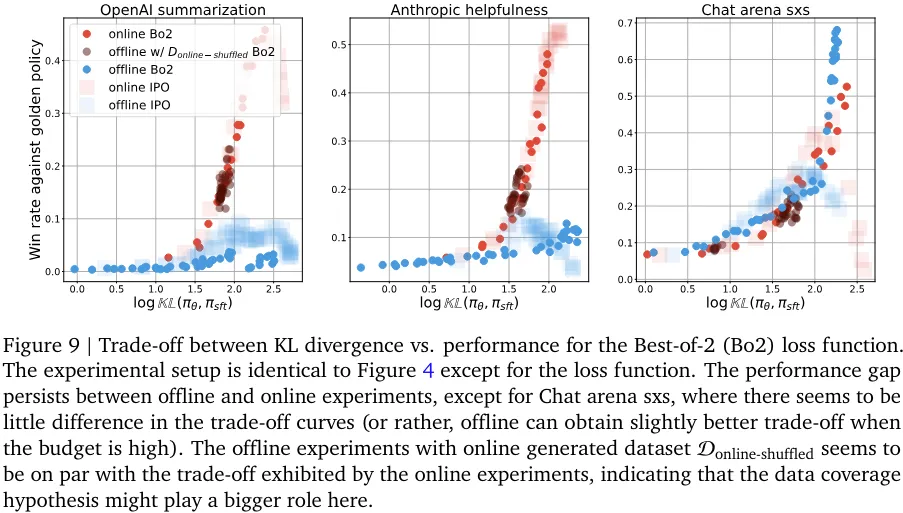

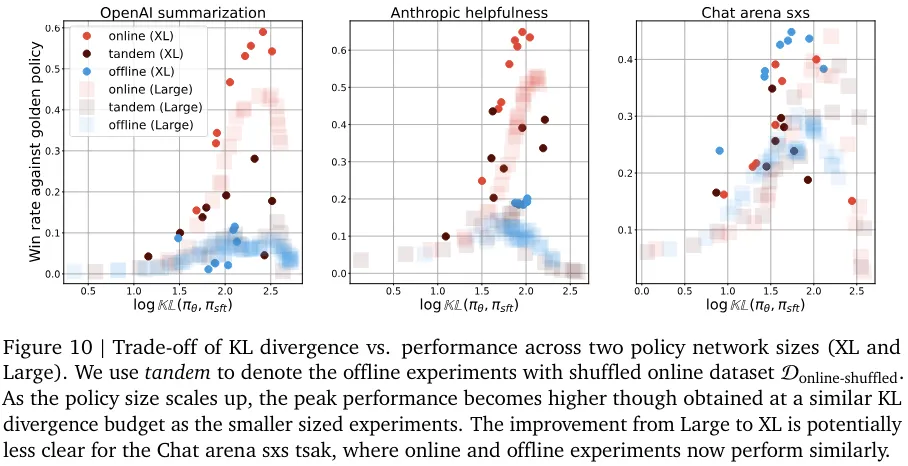

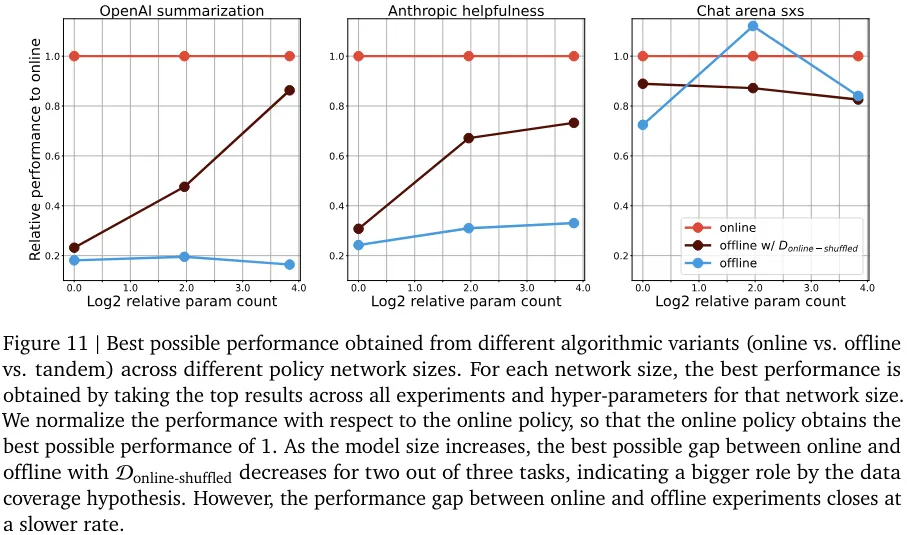

為了確保所得結果更普適,他們還研究了用于 RLHF 的對比式和非對比式損失函數。

在線與離線性能之間的差距似乎總體上持續存在,盡管這種差異的根本原因可能與算法有關。他們也研究了性能差距隨策略網絡規模擴展的變化情況(見圖 10 和 11)。性能差距一直存在這一事實說明:只是擴展模型規模可能無法解決采樣問題。

盡管實驗結果暗示了在策略采樣對模型對齊的根本重要性,但這些結果也許有助于揭示離線對齊算法的實驗內部工作原理,并揭示性能差異的根源。總而言之,這些發現為 RLHF 實踐者提供了有趣的見解和挑戰,并為更有效的 AI 對齊實踐鋪平了道路。

根據現有的強化學習研究成果,在線比離線更好似乎是顯而易見的結論。在線和離線強化學習算法之間的性能差距也已經被多項研究發現,所以這項研究給出了什么不一樣的結論呢?

最重要的是,在線 RLHF 算法依賴于一個學習后的獎勵模型,該獎勵模型是使用與離線 RLHF 算法一樣的成對偏好數據集訓練得到的。這與常規強化學習設置存在根本性差異 —— 常規強化學習假設能以在線方式獲取基本真值獎勵,在這種情況下,在線強化學習的優勢明顯。假設 RLHF 受到獎勵信號的瓶頸限制,我們就不清楚在線與離線的差距是否還會這樣顯著。

從更技術性的角度來看,許多 RLHF 算法采用了上下文賭博機的設計形式,并針對參考策略應用了正則化。這樣的算法細節讓 RLHF 偏離了常規的強化學習設置,這可能會影響離策略學習問題的嚴重程度。

本文轉自機器之心 ,作者:機器之心