Still-Moving效果驚艷!無需定制視頻數據,DeepMind讓文生定制視頻變得簡單! 精華

文章鏈接: https://arxiv.org/pdf/2407.08674

github鏈接: https://still-moving.github.io/

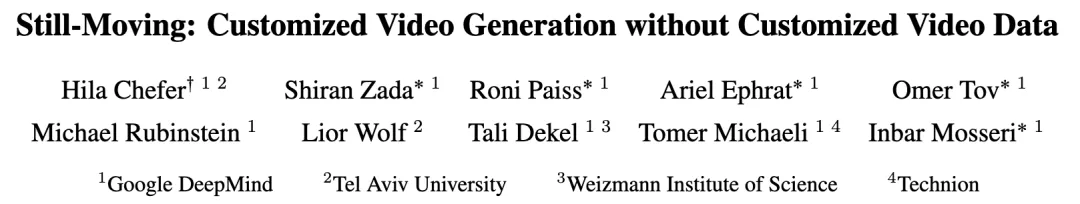

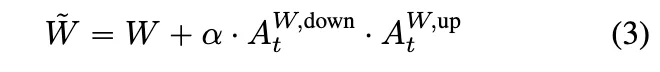

自定義文本生成圖像(T2I)模型最近取得了巨大進展,尤其是在個性化、風格化和條件生成等領域。然而,將這些進展擴展到視頻生成仍處于初期階段,主要原因是缺乏定制視頻數據。

本文介紹了Still-Moving,是一種無需定制視頻數據即可自定義文本生成視頻(T2V)模型的新穎通用框架。該框架適用于T2V模型的主要設計,其中視頻模型是在文本生成圖像(T2I)模型的基礎上構建的(例如,通過擴展)。

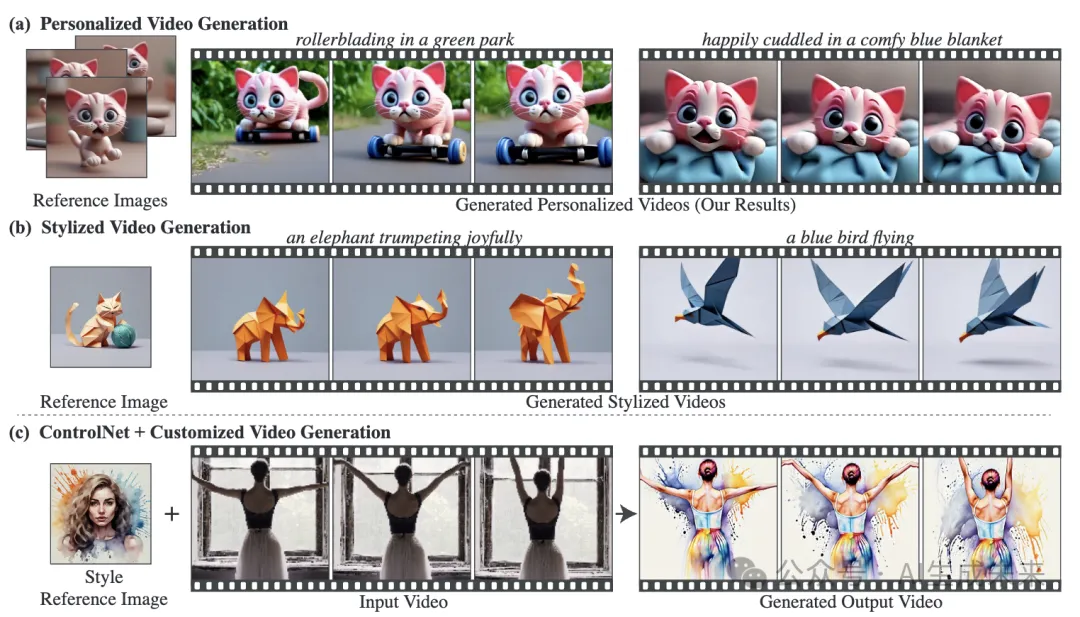

假設能夠訪問僅在靜態圖像數據上訓練的定制版本的T2I模型(例如,使用DreamBooth或StyleDrop)。直接將定制T2I模型的權重插入T2V模型通常會導致顯著的偽影或對定制數據的依從性不足。為了解決這個問題,本文訓練了輕量級的Spatial Adapters來調整由注入的T2I層產生的特征。重要的是,Adapters是在“凍結視頻”(即重復圖像)上訓練的,這些視頻是由定制T2I模型生成的圖像樣本構建的。

這種訓練通過一種新穎的Motion Adapters模塊得以實現,能夠在靜態視頻上進行訓練,同時保留視頻模型的運動先驗。在測試時,移除Motion Adapter 模塊,僅保留訓練好的Spatial Adapters。這恢復了T2V模型的運動先驗,同時遵循了定制T2I模型的空間先驗。在包括個性化、風格化和條件生成在內的多種任務中展示了本文方法的有效性。在所有評估場景中,本文的方法無縫集成了定制T2I模型的空間先驗和T2V模型提供的運動先驗。

方法

給定一個從T2I模型擴展而來的視頻模型,以及一個從微調而來的定制T2I模型,本文的目標是實現將定制權重無縫插入V中。簡單地將M替換為的方法由于特征分布的變化導致不滿意的結果(下圖2)。

為了緩解這種變化,本文提出訓練輕量級的Spatial Adapters,這些Adapters的任務是將注入的層的輸出激活投影回的時間層的分布。該方法的一個主要挑戰是Adapters應該在定制視頻數據上進行訓練,而這種數據通常難以獲得。注意,雖然靜態圖像可以復制形成(凍結)視頻,但在這些凍結視頻上進行原始訓練會導致運動生成能力的喪失。為了解決這個問題,本文提出采用新穎的Motion Adapters來使能在圖像數據上進行訓練而不喪失模型的運動先驗。

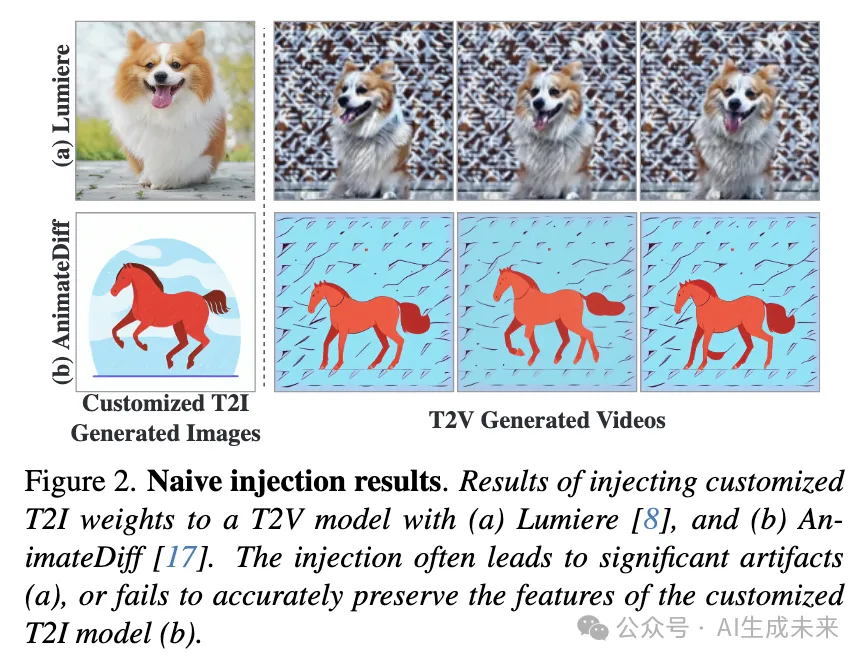

Motion Adapters

本文方法的一個關鍵組件是能夠在凍結圖像數據上訓練視頻模型V的權重。為了在不引入分布外輸入的情況下實現這一目標,提出訓練輕量級的Motion Adapters,以控制模型生成視頻中運動的存在。Motion Adapters在普通、非定制的T2V模型上訓練一次。本文的實現基于時間注意力投影矩陣的低秩適應(LoRA)(見下圖3(a))

所有的 。這里, 是adapter scale,而 和 是adapter 矩陣。矩陣 以隨機值初始化,而 初始化為零,這樣在訓練之前,模型等同于 。

在訓練過程中,設置 ,并使用模型訓練集中的一小部分視頻。對于每個視頻,隨機選擇一個幀,復制 次,并用擴散去噪目標訓練adapter層。換句話說,Motion Adapters被訓練生成展示從視頻模型分布中復制的隨機幀的凍結視頻(見上面圖3(a))。一旦訓練完成,Motion Adapters就能夠在凍結數據上訓練視頻模型權重。需要注意的是,通過設置 ,模型保留其生成運動的能力。

Motion Adapters控制運動量的能力可以推廣到負尺度。例如,當設置 時,模型生成運動量增加的視頻。因此,除了允許在圖像上定制T2V模型外,Motion Adapters還可以在推理過程中用于控制生成視頻中的運動量。

Spatial Adapters

本文方法的核心前提是特征分布的偏差可以通過簡單的線性投影來修正。因此,建議在每個注入的定制T2I層之后添加Spatial Adapters(見上面圖3(b))。這些adapters的任務是修正時間層輸入的分布差距。因此,它們的訓練需要通過整個視頻模型傳播梯度。與Motion Adapters類似,Spatial Adapters實現為低秩矩陣的乘法。

其中, 和 是特定層的低秩adapter矩陣。與Motion Adapters類似, 和 分別以隨機值和零值初始化,這樣在訓練之前,模型等同于。使用擴散重建損失在圖像和視頻的組合上訓練Spatial Adapters。具體來說,使用由定制T2I模型M1生成的圖像和40個非定制視頻來保留擴展模型的先驗,按照DreamBooth 的方法進行(見上面圖3(b))。對凍結視頻使用尺度為 的Motion Adapters,對先驗保留視頻使用尺度為 的Motion Adapters。

實驗

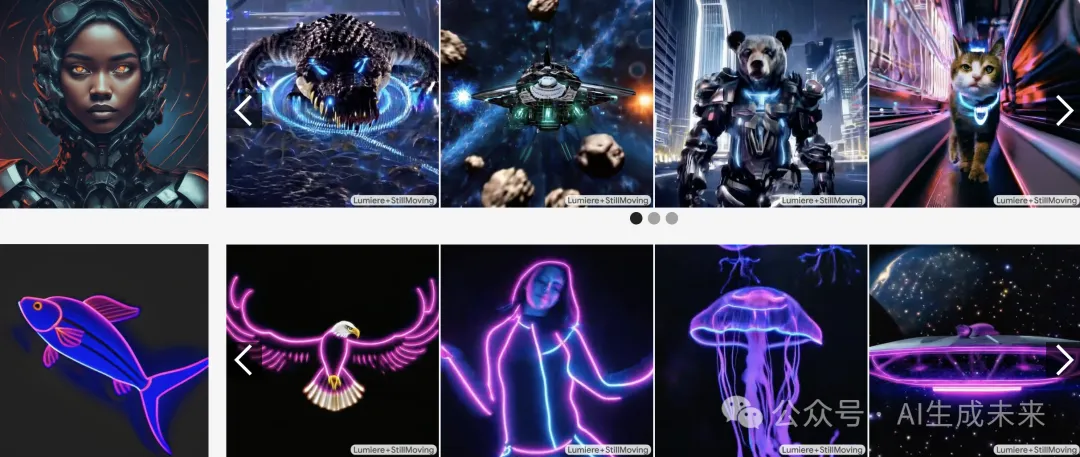

這里展示了廣泛的定性和定量評估,并將本文的方法與主要baseline進行比較。在使用DreamBooth進行個性化和使用StyleDrop進行風格化的強大定制任務上進行了評估。此外,展示了本文的方法與ControlNet的結合,ControlNet能夠在保持原始結構的同時,將現有視頻定制為個性化對象或給定風格。在兩個著名的擴展T2V模型上展示了結果,分別是基于Imagen構建的Lumiere和基于Stable Diffusion構建的AnimateDiff,以證明本文方法的魯棒性。

Baselines

研究者們考慮了三種主要的baselines方法:

- 原始權重注入:在T2V模型中用定制T2I權重替換T2I模型權重,正如Guo等人和Liew等人所應用的那樣;

- 權重插值:在定制權重和預訓練T2I權重之間進行插值,正如Bar-Tal等人所應用的那樣;

- 交錯訓練:受T2V訓練常用方法的啟發,使用以下方法微調視頻模型中的T2I權重:(i) 禁用時間層的定制圖像,和(ii) 啟用時間層的自然視頻。這個baseline方法與本文方法的關鍵區別在于,最終生成的視頻沒有像本文的方法框架那樣,明確地使用定制圖像數據進行監督。

評估數據

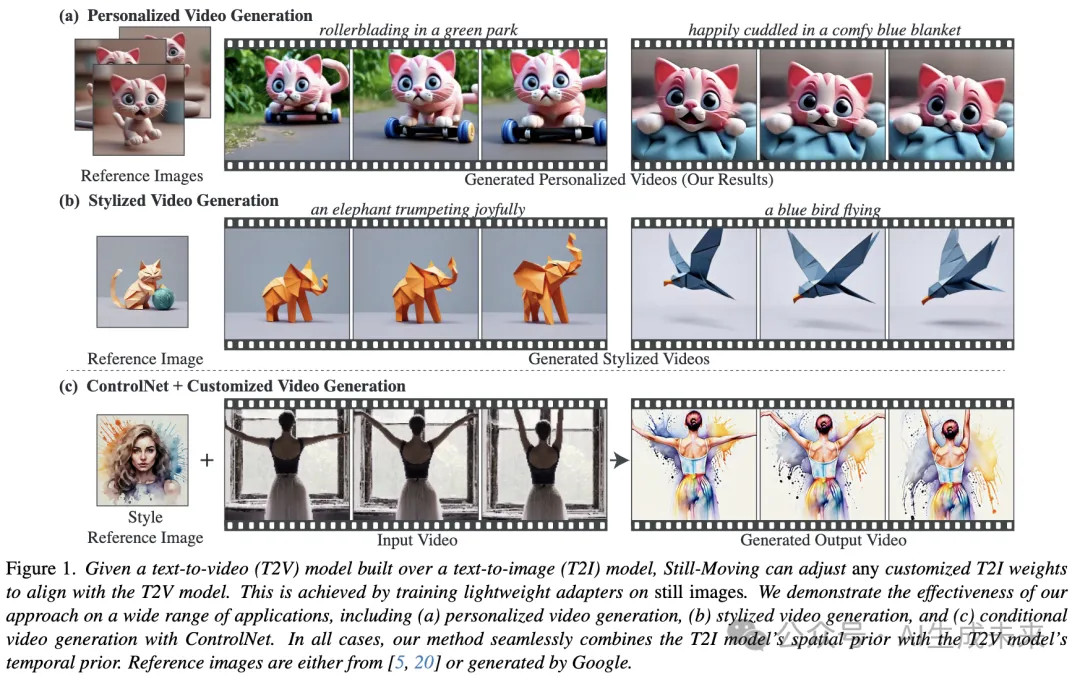

本文構建了一個包含個性化對象和風格的多樣化數據集。對于個性化,包括了來自DreamBooth數據集的五個不同對象,包括現實的(例如狗、貓)和分布外的(例如玩具)對象。對于風格化評估,使用了Lumiere中展示的三種風格,另外還有兩種具有挑戰性的現實和高度詳細的風格,見圖4。每種風格都能夠全面評估包含不同場景和對象的廣泛提示。這構成了一個包含10種不同個性化對象和風格的數據集。對于數據集中的每個項目,生成了10個在相同隨機種子和不同提示下的對比視頻,共計每個baseline100個對比視頻。

定性結果

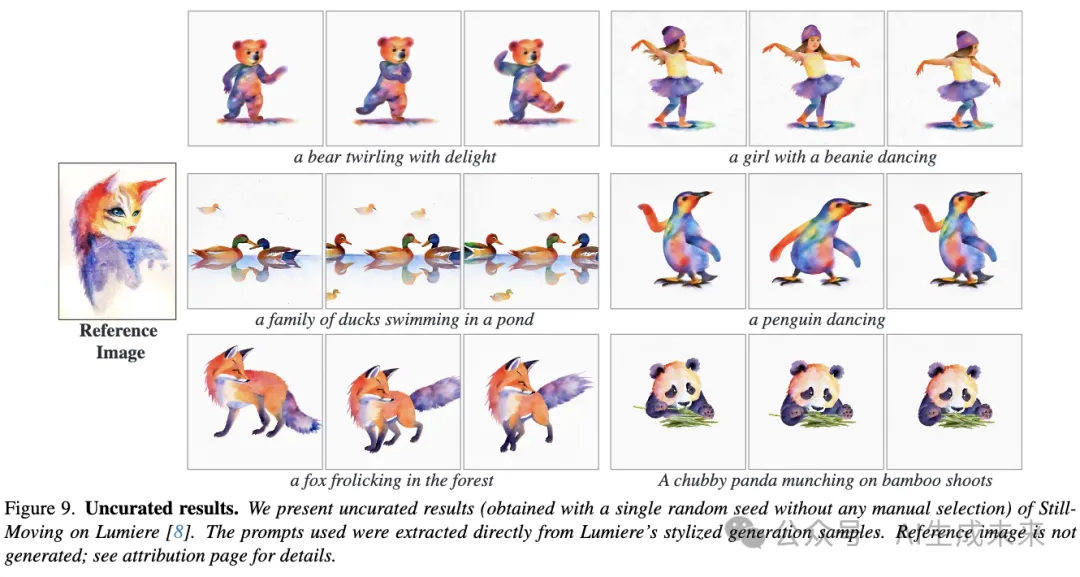

前面圖1、下圖4和圖9展示了本文的方法在Lumiere上應用于視頻個性化和風格化時,在各種具有挑戰性的定制T2I模型上獲得的結果。個性化角色來自Avrahami等人或由Google生成。同樣,風格參考來自Hertz等人、Sohn等人或由Google生成。可以看出,本文的方法保持了M1的空間先驗,同時匹配了來自V的創意運動先驗。例如,“水彩飛濺”風格(圖4(b))伴隨著飛濺的顏色運動,“恐怖電影”風格(圖4(b))結合了霧氣運動等。對于個性化,本文的方法展示了對現實(例如圖4(a)中的女人)和動畫角色(例如圖1中的貓)的內在動畫能力,同時生成了多樣的背景、場景和動態(例如沖浪、跳舞)。

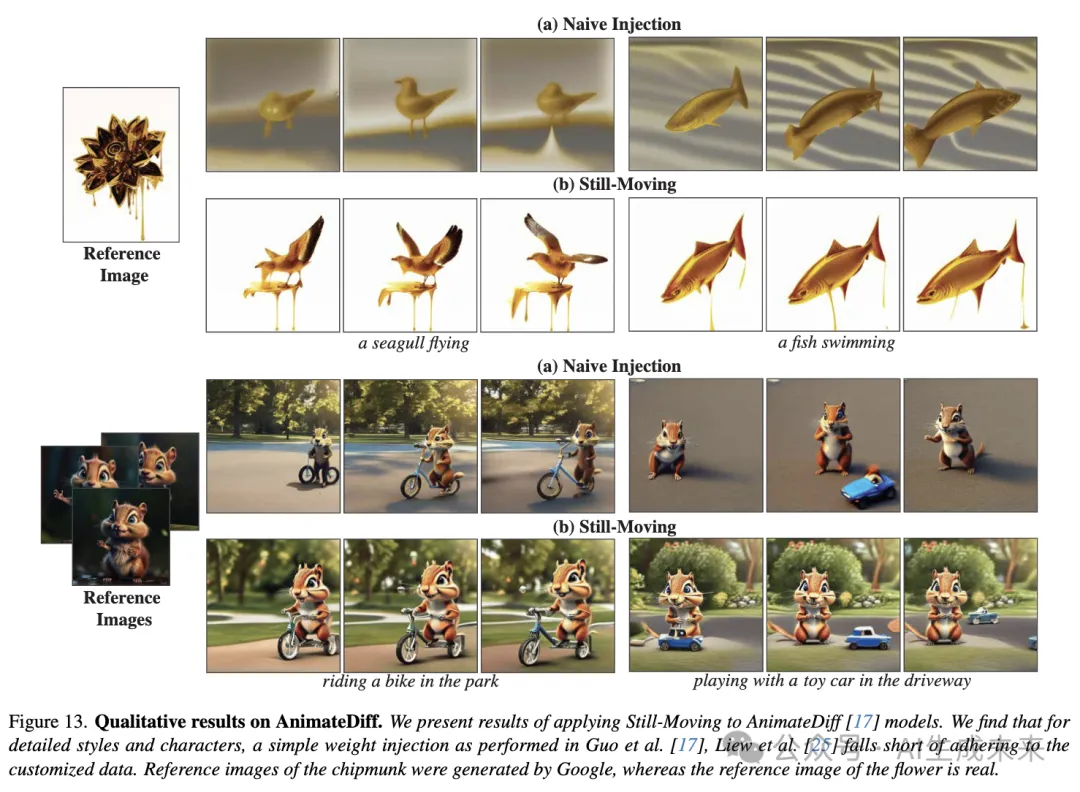

下圖13展示了本文的方法與在AnimateDiff上的原始注入baseline的定性比較。重要的是,AnimateDiff的作者強調了模型無縫插入微調T2I權重的能力。可以看出,這種方法對于復雜的定制數據往往會產生不滿意的結果。對于風格化,“融化的金色”風格(頂部行)顯示出背景失真,并且缺乏該風格特有的融化滴落效果。對于個性化,小松鼠的特征沒有被準確捕捉(例如臉頰和前額的顏色)。此外,小松鼠的身份在不同幀中發生了變化。相比之下,應用本文的方法時,“融化的金色”背景與參考圖像相匹配,模型生成了滴落的運動。同樣,小松鼠保持了一致的身份,與參考圖像相符。

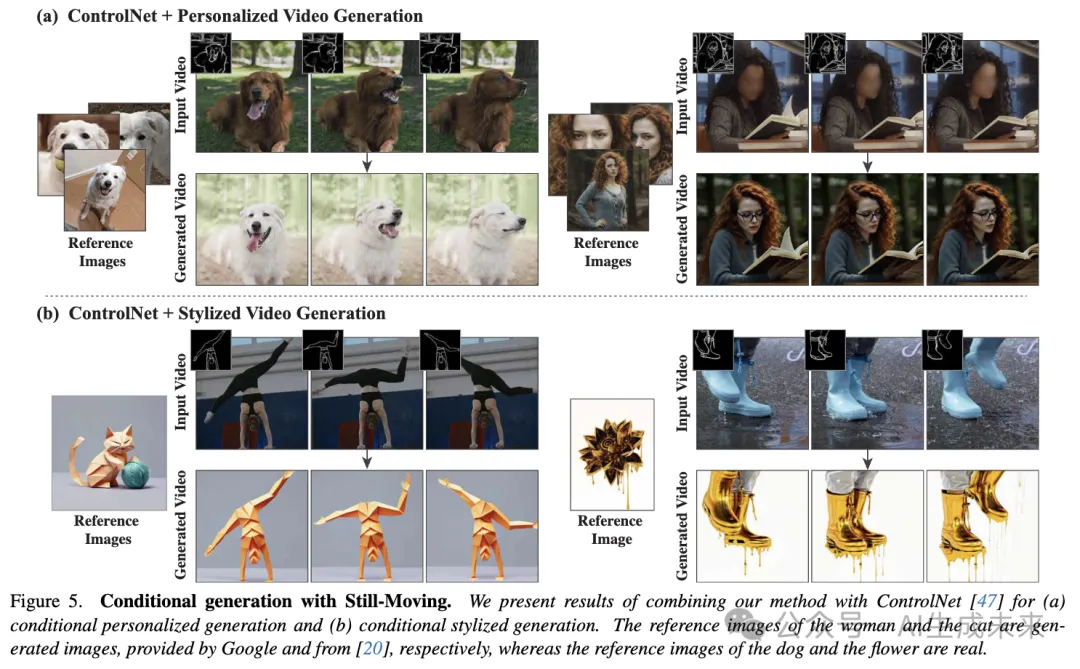

接下來,前面圖1和下圖5展示了本文的方法與ControlNet結合的結果。在給定驅動視頻的情況下,本文的方法能夠生成一個遵循其結構的定制視頻,同時加入風格或角色。例如,圖5頂部一行的視頻被轉換為展示參考女性形象,同時保持驅動視頻的主要特征。有趣的是,ControlNet與Still-Moving的結合不僅能加入由條件決定的運動,還能加入由風格決定的動態運動。例如,圖5中的“融化的金色”風格為場景添加了滴落的運動。

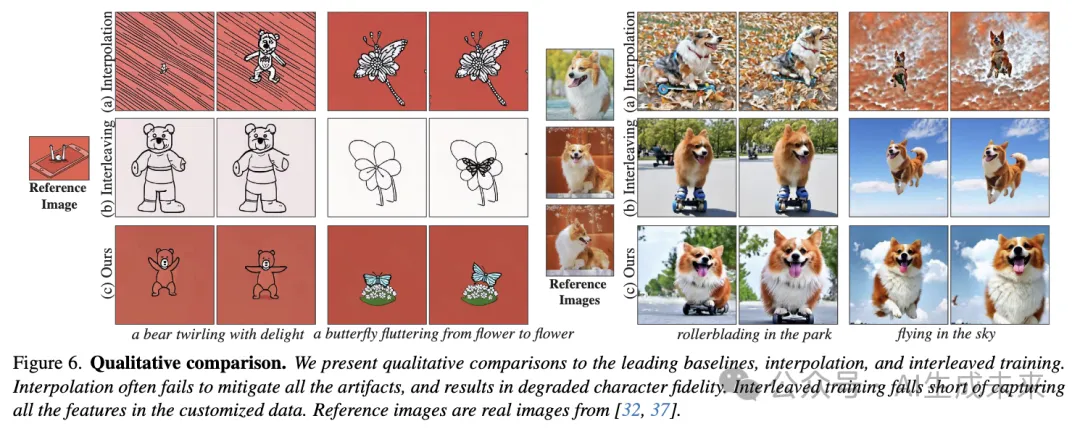

下圖6展示了本文的方法與領先的baseline方法(即插值和交錯訓練)在評估數據集示例上的定性比較。可以看到,插值baseline在插值過程中本質上丟失了M1的信息。這在圖6中的個性化示例中最為明顯,插值過程中狗的身份丟失了。此外,可以看到插值并不總是足以克服分布差距,可能會保留顯著的偽影。交錯訓練baseline在兩種情況下都無法準確捕捉參考圖像。這可以歸因于baseline方法使用定制數據來修改模型的T2I層,同時忽略了時間層。如前面圖2所示,微調后的空間層與預訓練的時間層的結合經常會導致分布偏移,從而導致無法嚴格遵循定制數據。

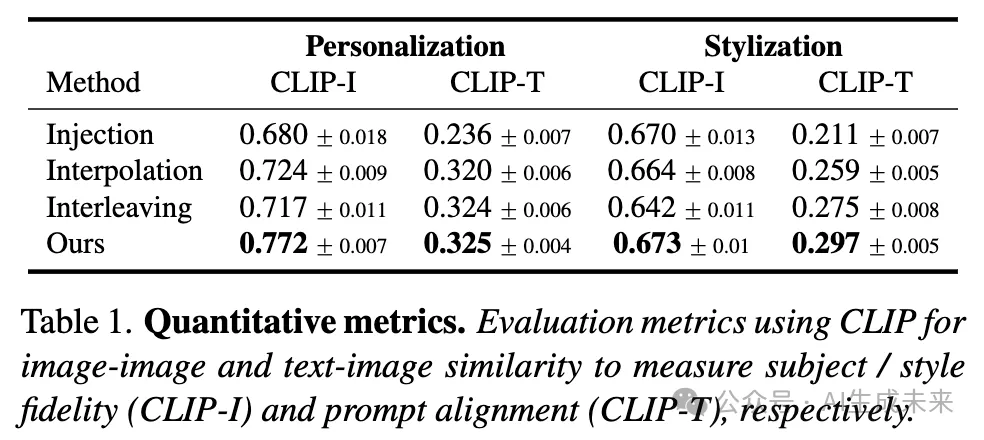

定量結果

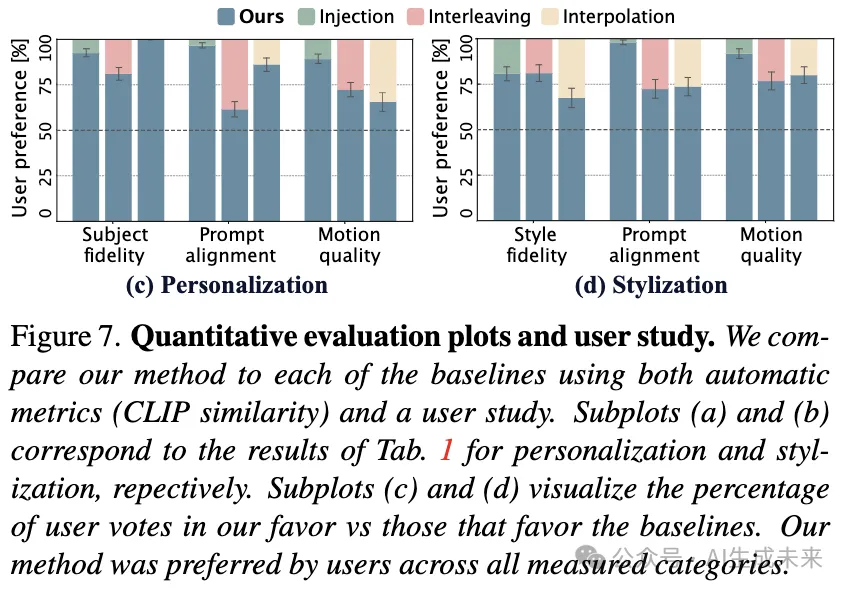

通過自動指標和用戶研究對baseline方法進行了定量比較。

指標。根據圖像定制領域類似工作的常見做法,研究者們考慮每幀相對于驅動提示的CLIP文本-圖像相似度(CLIP-T)和每幀相對于定制數據的圖像-圖像相似度(CLIP-I)。在數據集的兩個子集(個性化、風格化)上的自動評估結果報告在下表1和圖7(a)、(b)中。本文的方法在所有評估子集和所有評估標準上均顯著優于所有baseline方法,如圖7和表1中報告的標準誤差(SME)所示。圖7中的趨勢與在定性比較(上圖6)中觀察到的趨勢類似。插值和注入baseline在風格化方面表現更好,這可以歸因于個性化T2I模型的更大分布差距。相反,交錯訓練baseline無法適應新風格,因為它僅在定制數據上訓練T2I模型權重。

重要的是,簡單地使用定制T2I模型生成單個圖像并將其復制形成凍結視頻,可以獲得非常高的CLIP-I和CLIP-T分數。在缺乏評估生成運動質量的運動指標的情況下(正如多篇工作指出的[8, 16, 21]),采用用戶研究進一步評估生成視頻的質量。研究有31名參與者,每位參與者需對包含3個問題的20個比較進行投票。這共計1860票。在每個比較中,參與者會看到兩個隨機選自比較數據集的視頻——一個由本文的方法生成,另一個由baseline生成,兩個視頻都描繪了相同的參考主體/風格,并使用相同的提示和種子生成。參與者被要求回答3個問題:

- “哪個視頻更好地遵循了提供的參考圖像?”

- “哪個視頻與提供的文本提示更一致?”

- “哪個視頻顯示了更好的運動質量?”。

如上如圖7(c)、(d)所示,用戶研究結果在主體保真度和提示一致性方面與自動指標一致。此外,研究表明,與baseline方法相比,本文的方法生成的視頻在運動質量方面顯著優越,如SME所示。

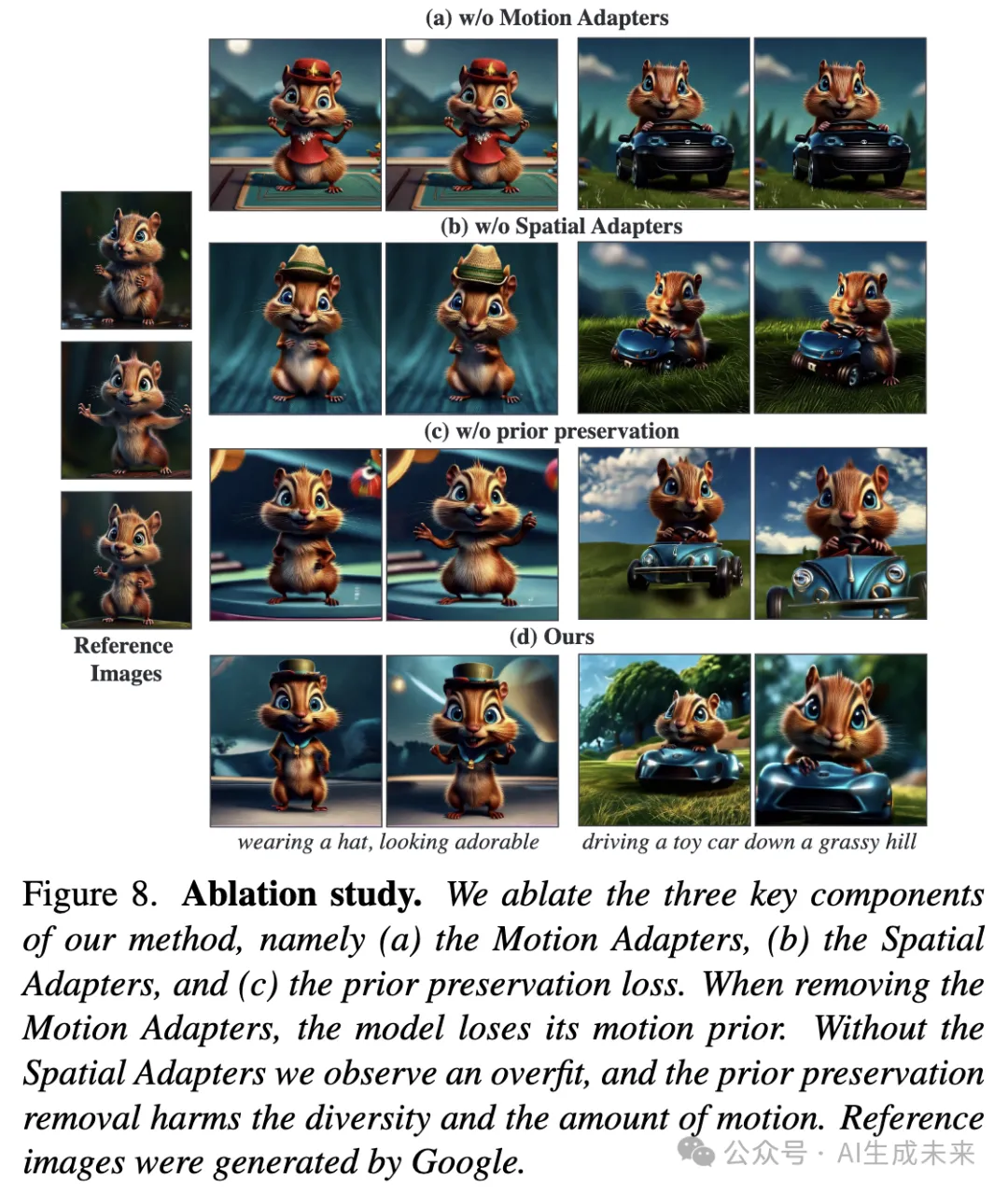

消融研究

對方法的三個主要設計選擇進行了消融實驗,即(i)應用Motion Adapters,(ii)應用Spatial Adapters,和(iii)使用先驗保持損失。下圖8展示了這些消融的結果。當移除Motion Adapters并在靜態視頻上訓練時,模型生成的幾乎是靜態視頻(頂行)。當移除Spatial Adapters并改為訓練所有網絡權重時,觀察到運動仍然顯著減少(第二行),并且背景不那么多樣化。這可以歸因于優化參數數量的顯著增加,即使在存在Motion Adapters的情況下,模型也容易過擬合。這兩個消融實驗表明,本文方法的兩個主要新穎組件都是獲得有意義運動結果所必需的。最后,當移除先驗保持組件時(圖8第三行),模型在一定程度上失去了泛化能力,例如在圖8第一列中,小松鼠沒有戴帽子。此外,發現先驗保持有助于模型更好地保持其運動先驗,沒有它,運動有所減少。

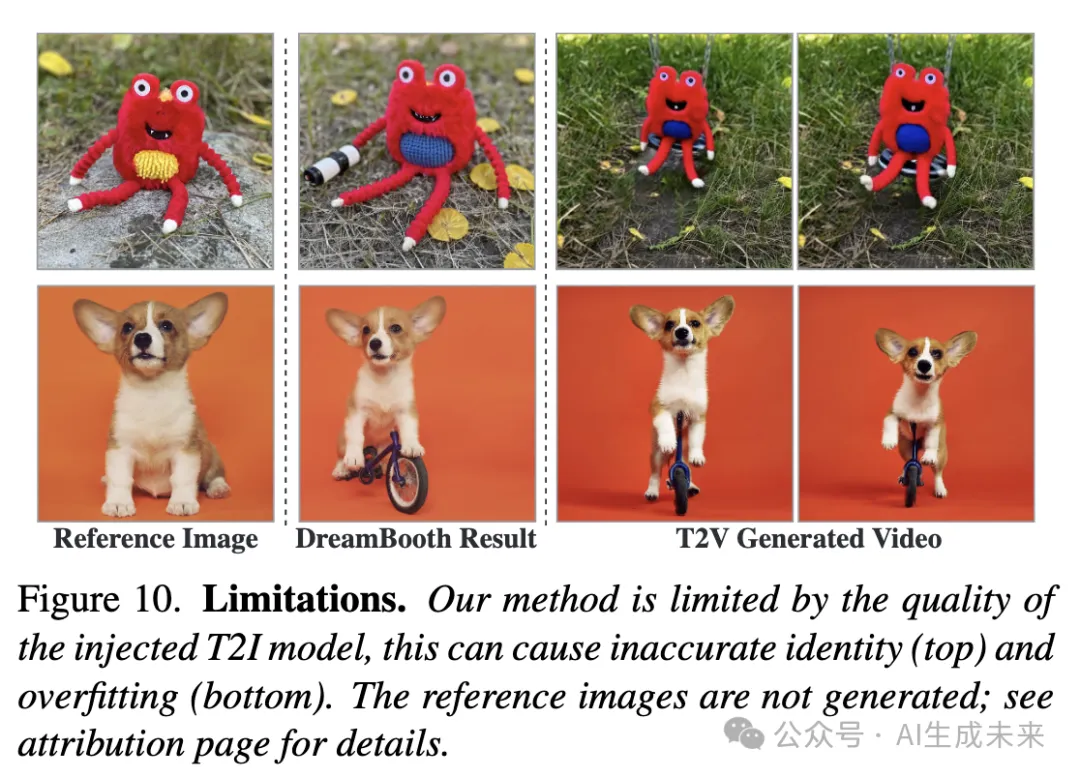

限制

本工作實現了定制T2I權重向T2V模型的即插即用注入。因此,結果本質上受限于定制T2I模型的結果。例如,當T2I模型未能準確捕捉定制對象的某些特征時,本文模型生成的視頻可能會表現出類似的行為。同樣,如果T2I定制模型對場景背景過擬合,本文的方法往往會產生類似的過擬合(圖10)。

結論

文本到視頻(T2V)模型變得越來越強大,現在可以生成復雜的高分辨率電影鏡頭。然而,如果生成的內容能夠被整合到包含特定角色、風格和場景的更大敘事中,這些模型在實際應用中的潛力才能得到充分實現。因此,視頻定制任務變得至關重要,但實現這一目標的方法論仍然探索不足。

這項工作克服了實現這一目標的一個主要挑戰,即缺乏定制視頻數據。開發了一個新穎的框架,直接將圖像領域的巨大進展轉化到視頻領域。重要的是,本文的方法是通用的,可以應用于任何基于預訓練的T2I模型構建的視頻模型。本文的框架揭示了T2V模型所學習到的強大先驗,正如成功生成從未見過運動的特定主題的運動所證明的那樣。

本文轉自 AI生成未來 ,作者:Google 等