騰訊的混源視頻模型HunyuanVideo:大視頻生成模型訓練的系統框架 原創

01、概述

隨著人工智能技術的飛速發展,視頻生成作為AI領域的重要突破,已經開始展現出令人驚艷的潛力。從圖像到視頻的生成,不僅要求算法具有強大的視覺理解能力,還要能準確捕捉動作和語義之間的微妙關系。而在這個領域,HunyuanVideo作為一款全新的開源視頻生成大模型,以其卓越的表現和創新的技術架構,正逐步打破傳統視頻生成模型的局限,成為AI視頻生成的領先者之一。

本文將深入探討HunyuanVideo的核心技術、架構設計以及其如何在行業中掀起波瀾。無論你是對AI技術感興趣的開發者,還是熱衷于視頻創作的內容創作者,HunyuanVideo的創新性都值得你一探究竟。

02、什么是HunyuanVideo?

HunyuanVideo是一款由騰訊開發的、具有130億參數的視頻生成大模型。它的目標是通過強大的技術架構,提供與領先的閉源模型相媲美甚至超越的生成表現。

與大多數現有的視頻生成模型不同,HunyuanVideo并不局限于單一的數據結構或技術。它采用了一個全面的框架,集成了數據整理、圖像-視頻聯合訓練和高效的基礎設施,能夠支持大規模模型訓練和推理。這一創新設計使得HunyuanVideo在視頻生成領域取得了顯著突破,成為最大的開源視頻生成模型之一。

03、HunyuanVideo的核心優勢

1)高質量的視覺效果與運動表現

為了確保生成的視頻擁有高質量的視覺效果、豐富的運動表現、精準的文本-視頻對齊和生成穩定性,HunyuanVideo在架構設計上進行了大量的實驗和優化。根據業內專業評估人員的反饋,HunyuanVideo在綜合指標上超越了以往最先進的閉源視頻生成模型,包括Runway Gen-3、Luma 1.6,以及三款中文社區表現最強的模型。

這種突破性的成果,正是HunyuanVideo通過深度優化架構和技術細節,努力消除生成視頻過程中的噪聲和不確定性所取得的。

2)打破數據壁壘,彌合開源與閉源模型的差距

傳統的視頻生成模型往往面臨著閉源和開源之間的技術鴻溝。而HunyuanVideo的出現,正是希望通過開源的方式,將最前沿的視頻生成技術帶給更多開發者和研究人員。通過開源基礎模型和應用模型的代碼與權重,HunyuanVideo旨在彌合開源和閉源視頻基礎模型之間的差距,幫助社區中的每一位開發者都能自由探索并嘗試自己的創意,推動視頻生成生態的更加動態與活躍。

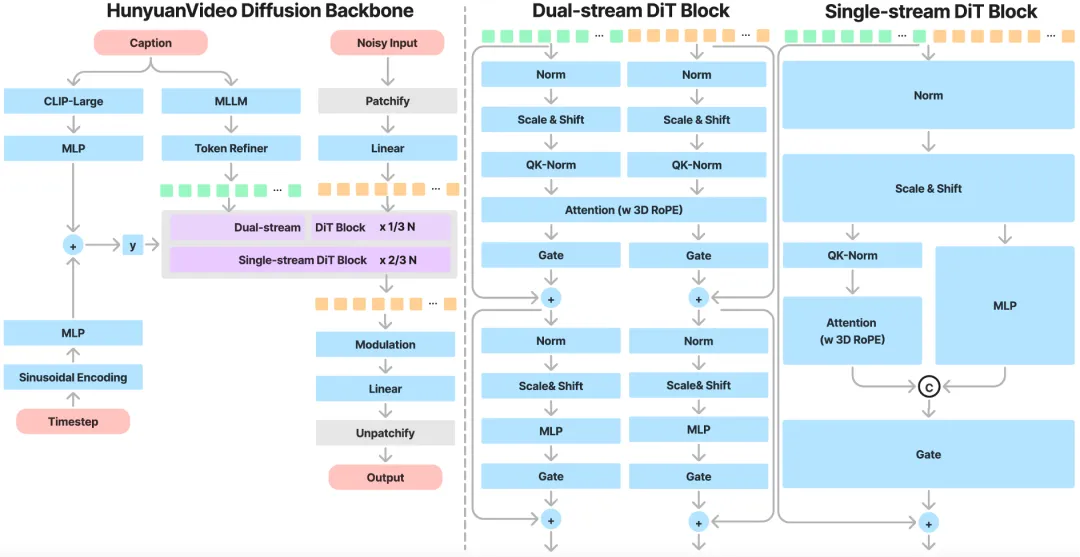

3) 強大的多模態信息融合能力

HunyuanVideo采用了一種獨特的雙流到單流混合模型設計。這種設計在視頻生成過程中首先獨立處理文本和視頻的token(符號),避免了不同模態之間的干擾,讓每個模態可以各自學習到最合適的調制機制;隨后,它會將視頻和文本的token連接在一起,通過后續的Transformer模塊進行有效的信息融合,從而提升生成視頻的質量。

這種架構能夠有效捕捉視覺和語義信息之間的復雜交互,顯著增強模型的整體性能,最終生成更符合用戶需求的視頻內容。

04、HunyuanVideo的架構設計

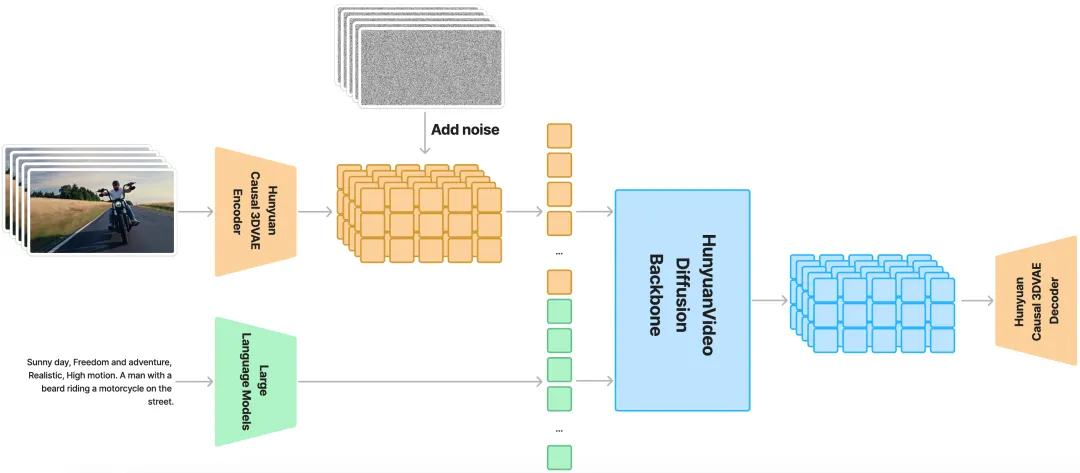

HunyuanVideo采用了一種基于隱空間模型的設計,其訓練過程涉及到壓縮視頻的時間維度和空間維度。通過使用3D VAE(變分自編碼器),HunyuanVideo能夠有效地將時間和空間維度的特征壓縮為更緊湊的表示。具體來說,時間維度壓縮4倍,空間維度壓縮8倍,最終將其轉化為16個通道,從而顯著減少了后續Transformer模型處理的token數量。

這種方法不僅提高了生成效率,還能夠在不犧牲視頻質量的情況下,保持較高的分辨率和幀率,使得視頻生成變得更加靈活與高效。

MLLM文本編碼器:更加精準的文本理解

在視頻生成過程中,文本提示是至關重要的。為了確保HunyuanVideo能夠準確理解文本指令并生成高質量的視頻,HunyuanVideo采用了一個預訓練的Multimodal Large Language Model(MLLM)作為文本編碼器。

與傳統的CLIP和T5-XXL相比,MLLM在圖文對齊和復雜推理方面具有更強的優勢。通過對大規模圖文數據進行微調,MLLM能夠在特征空間中實現更精準的圖文對齊,從而使得生成的文本與視頻內容更加契合。此外,MLLM還具備零樣本生成能力,能夠根據系統指令進行更為精準的文本特征提取,進而優化視頻生成過程。

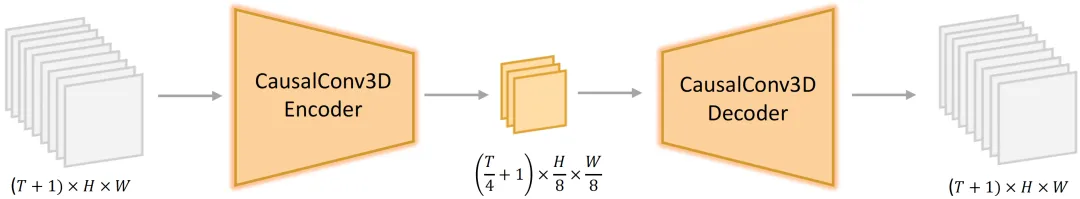

3D VAE:壓縮空間,提升效率

HunyuanVideo采用的3D VAE不僅具備時間和空間壓縮的優勢,還在編碼器和解碼器中使用了CausalConv3D(因果卷積3D)技術,這一創新設計讓視頻的生成更加高效。通過4倍壓縮時間維度和8倍壓縮空間維度,HunyuanVideo在保持視頻質量的同時,大大減少了計算量,為大規模視頻生成提供了強有力的技術支持。

05、視頻生成的創新:Prompt改寫模型

為了幫助用戶更好地與模型互動,HunyuanVideo還提供了一個獨特的Prompt改寫模型。該模型通過將用戶輸入的文本提示進行優化,確保模型能夠更準確地理解用戶的意圖,生成更加符合要求的視頻。

HunyuanVideo提供了正常模式和導演模式兩種改寫模式。正常模式旨在增強視頻生成模型對用戶指令的理解,而導演模式則專注于提升視頻的視覺質量,包括構圖、光照和攝像機的運動等方面。雖然導演模式能夠生成更具視覺沖擊力的視頻,但有時也可能會犧牲一些語義細節,因此用戶可以根據自己的需求進行選擇。

06、HunyuanVideo的能力評估

為了驗證HunyuanVideo的生成能力,我們與四個閉源視頻生成模型進行了對比。在與其他模型的比較中,我們使用了1,533個文本提示,并通過單次推理生成了相同數量的視頻樣本。評估標準包括文本對齊、運動質量和視覺質量。結果表明,HunyuanVideo在綜合指標上表現最為優秀,尤其在運動質量方面,表現優于其他所有對比模型。

07、結語

隨著HunyuanVideo的開源發布,AI視頻生成技術迎來了一個新的時代。它不僅為開發者提供了一個強大、靈活的創作平臺,也為AI視頻生成的未來奠定了基礎。通過HunyuanVideo,我們有理由相信,在不久的將來,更多的創作者將能夠借助AI技術,輕松生成高質量的視頻內容,創造出更豐富、更生動的視覺世界。

參考:

本文轉載自公眾號Halo咯咯 作者:基咯咯

原文鏈接:??https://mp.weixin.qq.com/s/UaHVpYIuFyVC4cxvKHM21w??