超越傳統(tǒng)AI!新型多智能體系統(tǒng)MESA,探索效率大幅提升

探索多智能體強化學習的協(xié)同元探索 —— MESA 算法深度解讀在多智能體強化學習(MARL)的征途中,如何高效探索以發(fā)現(xiàn)最優(yōu)策略一直是研究者們面臨的挑戰(zhàn)。特別是在稀疏獎勵的環(huán)境中,這一問題變得更加棘手。《MESA: Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure》這篇論文為我們帶來了一種新穎的解決方案——MESA算法,它通過利用狀態(tài)-動作空間的結(jié)構(gòu),實現(xiàn)了多智能體間的協(xié)同元探索,顯著提升了在復(fù)雜任務(wù)中的探索效率。Zhicheng Zhang、Yancheng Liang、Yi Wu和Fei Fang等研究者們精心設(shè)計的MESA算法,在多步矩陣游戲和連續(xù)控制任務(wù)中展現(xiàn)了其卓越的性能。它不僅能夠有效地促進智能體在測試任務(wù)中的學習,還能泛化至更具挑戰(zhàn)性的未見任務(wù)。

通過這篇文章,您將獲得:

- 高效探索策略:了解MESA如何通過元探索方法提升多智能體學習的探索效率。

- 結(jié)構(gòu)化學習方法:探索MESA如何識別高獎勵的狀態(tài)-動作子空間,并訓練多樣化的探索策略。

- 實際應(yīng)用案例:通過MESA在多智能體粒子環(huán)境和MuJoCo環(huán)境中的實驗,見證其在實際應(yīng)用中的顯著成效。

引言:多智能體系統(tǒng)中的探索挑戰(zhàn)

在多智能體系統(tǒng)(MAS)中,探索是一個核心問題,尤其是在合作或競爭環(huán)境下。有效的探索策略可以顯著提高學習效率,幫助智能體更快地適應(yīng)環(huán)境并找到最優(yōu)策略。然而,多智能體環(huán)境的復(fù)雜性,如狀態(tài)空間的指數(shù)增長和部分可觀測性,使得傳統(tǒng)的單智能體探索方法往往不再適用。

在多智能體環(huán)境中,每個智能體的行為不僅影響自己的收益,還可能影響其他智能體的收益,這增加了探索的難度。例如,一個智能體的探索行為可能會導(dǎo)致環(huán)境狀態(tài)變化,從而影響到其他智能體的決策。此外,智能體需要在探索新策略和利用已知策略之間找到平衡,這在多智能體設(shè)置中尤為復(fù)雜。

為了應(yīng)對這些挑戰(zhàn),研究者們提出了多種多智能體探索策略,旨在通過協(xié)作或競爭來優(yōu)化整體或個體的性能。這些方法通常需要在探索效率和計算復(fù)雜性之間做出權(quán)衡。有效的多智能體探索不僅能加速學習過程,還能在復(fù)雜的環(huán)境中促進更高級別的策略和協(xié)作形成。

論文基本信息

標題:MESA: Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure

作者:

- Zhicheng Zhang, Carnegie Mellon University, Pittsburgh, Pennsylvania, United States

- Yancheng Liang, University of Washington, Seattle, Washington, United States

- Yi Wu, Tsinghua University, Beijing, China

- Fei Fang, Carnegie Mellon University, Pittsburgh, Pennsylvania, United States

機構(gòu):

- Carnegie Mellon University

- University of Washington

- Tsinghua University

論文鏈接:https://arxiv.org/pdf/2405.00902.pdf

MESA方法概述

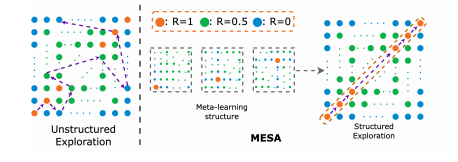

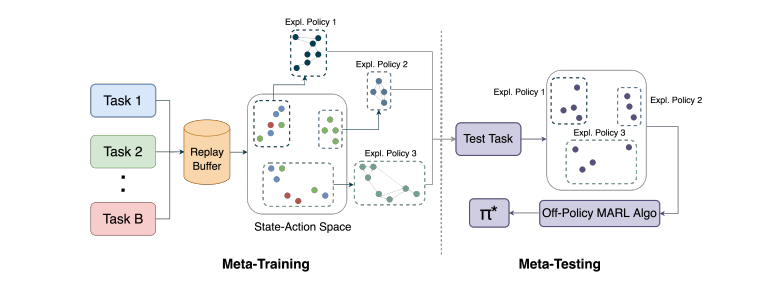

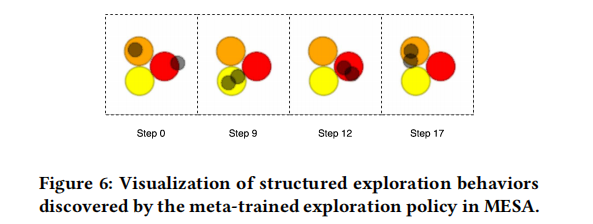

MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure)是一種針對多智能體學習的元探索方法,旨在通過利用狀態(tài)-動作空間結(jié)構(gòu)來提高探索效率。在多智能體強化學習(MARL)中,探索效率尤為關(guān)鍵,因為環(huán)境的復(fù)雜性和智能體間的交互增加了學習的難度。MESA通過在元訓練階段識別高獎勵的狀態(tài)-動作子空間,并訓練一組多樣化的探索策略來覆蓋這一子空間,從而實現(xiàn)高效的探索。這些探索策略在元測試階段被用來輔助智能體在新任務(wù)中的學習。

元訓練階段詳解

1. 高獎勵狀態(tài)-動作子空間的識別

在元訓練階段的第一步,MESA需要確定哪些狀態(tài)-動作對能夠帶來高獎勵。這一過程涉及到在多個訓練任務(wù)中收集數(shù)據(jù),并從中篩選出獎勵高于某個閾值的狀態(tài)-動作對。這些被認為是有價值的狀態(tài)-動作對將被存儲在一個數(shù)據(jù)集M*中,用于后續(xù)的探索策略訓練。對于目標導(dǎo)向的任務(wù),這個閾值可以是達到目標狀態(tài)的獎勵。

2. 探索策略的訓練和獎勵機制

在識別了高獎勵的狀態(tài)-動作子空間后,MESA將訓練一組探索策略來有效覆蓋這一子空間。這些探索策略的訓練使用了基于距離高獎勵子空間的距離來誘導(dǎo)的獎勵機制。具體來說,如果一個訪問的狀態(tài)-動作對足夠接近已識別的高獎勵子空間(即,它與子空間中的某個點的距離小于某個閾值ε),它將獲得一個正的派生獎勵。為了鼓勵探索策略覆蓋更廣泛的子空間并避免模式崩潰,MESA采用了一種獎勵分配方案,確保對相似的狀態(tài)-動作對的重復(fù)訪問會得到遞減的獎勵。

通過這種方式,MESA不僅提高了探索的效率,還通過元學習框架使得智能體能夠在面對新任務(wù)時迅速適應(yīng),展現(xiàn)出良好的泛化能力。這一方法已在多種任務(wù)中得到了驗證,包括矩陣攀爬游戲和連續(xù)控制任務(wù),與現(xiàn)有的多智能體學習和探索算法相比,MESA顯示出了優(yōu)越的性能。

元測試階段應(yīng)用

在元測試階段,MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure)利用在元訓練階段學習到的探索策略來輔助多智能體在未見過的任務(wù)中的學習。這些探索策略是從一組訓練任務(wù)中學習得到的,這些任務(wù)在狀態(tài)-動作空間中具有內(nèi)在的結(jié)構(gòu)特征。在元測試階段,MESA通過隨機選擇已學習的探索策略來收集有價值的經(jīng)驗,從而幫助智能體更有效地學習良好的聯(lián)合策略。

1. 探索策略的應(yīng)用:在每個回合中,MESA以一定的概率執(zhí)行一個隨機選取的探索策略。這些探索策略在初始階段提供更多的回合,以幫助智能體快速適應(yīng)新環(huán)境,隨后逐漸減少探索策略的使用,轉(zhuǎn)而讓智能體依賴其自身的學習成果。

2. 策略的效果評估:MESA的探索策略在多個環(huán)境中表現(xiàn)出色,包括矩陣攀登游戲及其多階段變體和連續(xù)控制任務(wù)。這些策略不僅提高了探索效率,還顯示出對未見測試任務(wù)的泛化能力,這些測試任務(wù)比任何訓練任務(wù)都要具有挑戰(zhàn)性。

實驗設(shè)計與評估

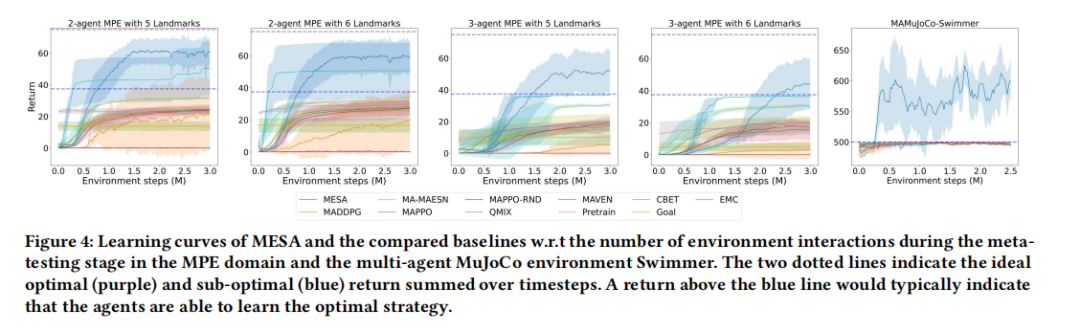

MESA的實驗設(shè)計旨在評估元學習探索策略在新任務(wù)中的表現(xiàn),并與其他多智能體學習和探索算法進行比較。實驗在不同的環(huán)境中進行,包括矩陣攀登游戲的變體、多智能體粒子環(huán)境(MPE)和多智能體MuJoCo基準測試。

1. 實驗設(shè)置:實驗比較了MESA與其他幾種多智能體強化學習算法,如MADDPG、MAPPO和QMIX,以及幾種探索算法,如MAVEN和基于RND的探索。此外,還測試了幾種采用類似元訓練階段的基線方法,包括未條件共享策略和目標條件策略。

2. 評估方法:評估主要關(guān)注探索策略在元測試階段的表現(xiàn),特別是它們在新采樣任務(wù)中的探索效率。通過與基線方法的比較,展示了MESA在攀登游戲變體和高維領(lǐng)域任務(wù)中的優(yōu)勢。此外,還研究了這些探索策略在更具挑戰(zhàn)性的測試任務(wù)分布中的泛化性能。

通過這些詳盡的實驗設(shè)計和評估,MESA證明了其在多智能體學習中應(yīng)用元探索方法的有效性,尤其是在處理結(jié)構(gòu)化探索任務(wù)和高維控制問題時的優(yōu)勢。

結(jié)果分析與討論

1. MESA在Climb Game變體中的表現(xiàn)

MESA在Climb Game的變體中表現(xiàn)出色。在單步Climb Game中,MESA能夠在一些更困難的任務(wù)中找到最優(yōu)解,而其他基線方法則幾乎在所有任務(wù)中停留在次優(yōu)解。在多階段Climb Game中,由于任務(wù)空間指數(shù)級增長,MESA的表現(xiàn)遠超其他算法。通過已學習的探索策略,MESA能夠迅速學習每個階段的最優(yōu)聯(lián)合動作,避免陷入次優(yōu)解。

2. MESA在多智能體MuJoCo環(huán)境中的應(yīng)用

在多智能體MuJoCo環(huán)境中,MESA同樣展現(xiàn)了優(yōu)異的性能。特別是在2-agent Swimmer環(huán)境中,MESA通過學習的探索策略,頻繁地達到目標角度,顯著優(yōu)于其他基線方法。這一環(huán)境極為復(fù)雜,因為智能體很可能收斂到次優(yōu)的獎勵,但MESA通過有效的探索策略,成功地學習到了最終策略,頻繁地達到目標狀態(tài)。

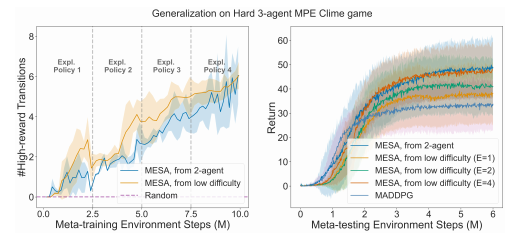

3. MESA的泛化能力評估

MESA在未見測試任務(wù)上的泛化能力表現(xiàn)突出。尤其是在任務(wù)分布更具挑戰(zhàn)性的情況下,MESA展現(xiàn)了良好的零樣本泛化能力。通過在簡單任務(wù)上訓練的探索策略,MESA能夠在更難的測試任務(wù)上加速訓練性能,連續(xù)達到高獎勵區(qū)域,而標準的MADDPG算法則只能學習到次優(yōu)平衡。

MESA方法的優(yōu)勢與局限

優(yōu)勢

- 結(jié)構(gòu)化探索策略:MESA通過在訓練階段識別高獎勵的狀態(tài)-動作子空間,并訓練一組探索策略來覆蓋這一子空間,從而實現(xiàn)高效的結(jié)構(gòu)化探索。

- 優(yōu)異的泛化能力:MESA展現(xiàn)了在從簡單任務(wù)到復(fù)雜任務(wù)的泛化能力,這得益于其能夠利用訓練任務(wù)中學到的結(jié)構(gòu)化探索策略。

- 與現(xiàn)有算法的兼容性:MESA可以與任何離策略的多智能體強化學習算法結(jié)合使用,提高了其適用性。

局限

- 依賴于任務(wù)結(jié)構(gòu)的顯式識別:MESA的性能高度依賴于在訓練階段正確識別出高獎勵的狀態(tài)-動作子空間。如果這一子空間識別不準確,可能會影響探索策略的有效性。

- 計算資源需求:由于需要在多個任務(wù)上訓練探索策略,MESA可能需要較多的計算資源,尤其是在任務(wù)空間較大時。

- 對高獎勵狀態(tài)的依賴:MESA的探索策略訓練依賴于高獎勵狀態(tài)的采集,這在獎勵稀疏的環(huán)境中可能是一個挑戰(zhàn)。

總結(jié)與未來展望

在本文中,我們介紹了一種新的多智能體元探索方法MESA(Cooperative Meta-Exploration in Multi-Agent Learning through Exploiting State-Action Space Structure),該方法通過利用狀態(tài)-動作空間結(jié)構(gòu)來提高多智能體學習的探索效率。MESA框架在元訓練階段通過一系列訓練任務(wù)學習探索策略,并在元測試階段利用這些策略幫助智能體在未見過的任務(wù)中進行學習。我們的實驗結(jié)果顯示,MESA在多種環(huán)境和任務(wù)中均優(yōu)于現(xiàn)有的多智能體學習和探索算法,尤其是在需要協(xié)調(diào)探索的復(fù)雜環(huán)境中。

1. 主要貢獻

MESA的主要貢獻在于其能夠有效地識別和利用訓練任務(wù)中的高獎勵狀態(tài)-動作子空間,從而訓練出一組多樣化的探索策略。這些策略在元測試階段被用來引導(dǎo)智能體探索新任務(wù),顯著提高了學習效率和策略性能。此外,MESA展示了良好的泛化能力,能夠?qū)⒃谙鄬唵蔚娜蝿?wù)中學到的探索策略成功應(yīng)用于更復(fù)雜的測試任務(wù),從而解決了多智能體系統(tǒng)中的探索難題。

2. 實驗驗證

通過在不同的游戲和控制任務(wù)中進行廣泛的實驗,包括Climb Game變體和多智能體MuJoCo環(huán)境,MESA不僅在學習效率上超過了其他基線方法,還在多階段游戲和高維任務(wù)中表現(xiàn)出卓越的性能。這些結(jié)果驗證了MESA探索策略的有效性和適應(yīng)性。

3. 未來工作

盡管MESA已經(jīng)取得了一定的成功,但仍有一些潛在的改進空間和未來的研究方向。例如,如何進一步優(yōu)化探索策略的學習過程,減少所需的訓練任務(wù)數(shù)量,以及如何更好地處理動態(tài)變化的環(huán)境和任務(wù)。此外,探索如何將MESA擴展到非合作或競爭性的多智能體環(huán)境中也是未來研究的一個重要方向。

總之,MESA為解決多智能體系統(tǒng)中的協(xié)同探索問題提供了一個有效的框架,并為未來在更廣泛的應(yīng)用領(lǐng)域中推廣元探索策略奠定了基礎(chǔ)。我們期待看到MESA在更多實際應(yīng)用中的表現(xiàn),并希望它能激發(fā)更多關(guān)于多智能體學習和探索的研究。

本文轉(zhuǎn)載自 ??AI論文解讀??,作者: 柏企