突破個性化圖像生成局限!MagicTailor:組件可控個性化圖像生成創新框架! 精華

文章鏈接:https://arxiv.org/pdf/2410.13370

項目鏈接:https://correr-zhou.github.io/MagicTailor

亮點直擊

- 引入了一項名為組件可控個性化的新任務,使T2I模型在個性化過程中能夠精確控制概念的各個組件。此外,語義污染和語義不平衡被確定為此任務中的關鍵挑戰。

- 提出了MagicTailor,這是一個專門為組件可控個性化設計的新框架。該框架結合了動態掩碼退化(DM-Deg),用于動態擾動不需要的視覺語義,以及雙流平衡(DS-Bal),以確保視覺語義的平衡學習。

- 綜合對比表明,MagicTailor在該任務中取得了優異的性能。此外,消融研究和進一步的應用展示了該方法的有效性和多功能性。

總結速覽

解決的問題

傳統的文本到圖像(T2I)擴散模型在生成高質量圖像方面有了顯著進展,但仍難以精細控制特定的視覺概念。現有方法雖然可以通過學習參考圖像來復制給定的概念,但在個體組件的細粒度自定義方面存在局限性。這種細粒度的控制受限于語義污染(不需要的視覺元素會干擾個性化概念)和語義不平衡(概念與組件之間的學習不均衡)兩個主要挑戰。

提出的方案

為了解決這些問題,提出了“組件可控個性化”的新任務,并設計了創新框架MagicTailor。MagicTailor通過動態掩碼退化(DM-Deg) 動態干擾不需要的視覺語義,同時使用 雙流平衡(DS-Bal) 建立了平衡的學習方式,從而實現對目標視覺語義的精細控制。

應用的技術

- 動態掩碼退化(DM-Deg):動態擾動不需要的視覺語義,減少語義污染。

- 雙流平衡(DS-Bal):建立平衡的學習模式,解決語義不平衡問題。

達到的效果

通過廣泛的對比實驗、消融分析和性能分析,MagicTailor在組件可控的個性化任務上表現優異,展示出顯著的實用潛力,為更細致和富有創造力的圖像生成鋪平了道路。

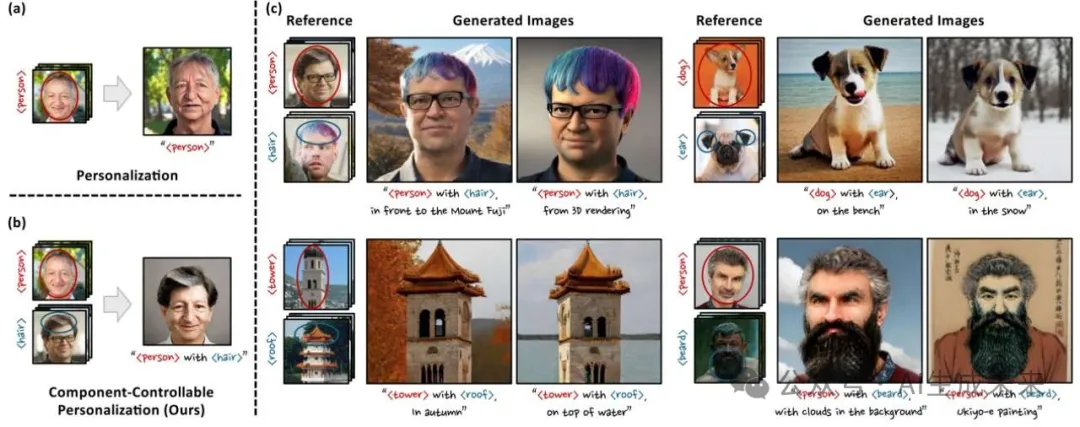

組件可控的個性化

- (a) 個性化插圖,展示文本到圖像 (T2I) 擴散模型如何從給定的參考圖像中學習和再現視覺概念。

- (b) 組件可控個性化的圖示,描繪了一項新制定的任務,旨在在個性化過程中修改視覺概念的特定組件。

- (c) MagicTailor 生成的示例圖像,展示了所提出的 MagicTailor 的有效性,MagicTailor 是一種新穎的框架,采用 T2I 擴散模型來實現組件可控的個性化。

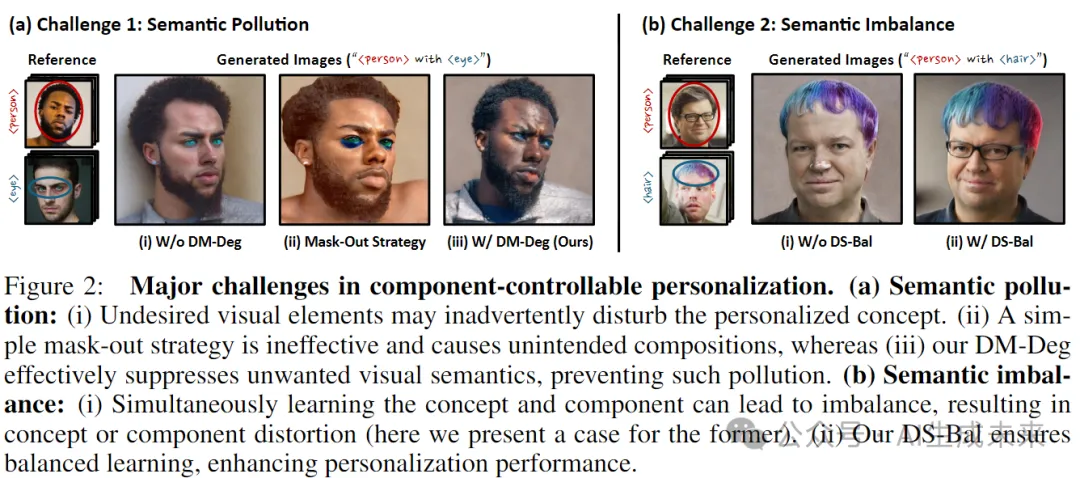

組件可控個性化的挑戰

- (a) 語義污染:

- (i) 不受歡迎的視覺元素可能會無意中擾亂個性化概念。

- (ii) 簡單的屏蔽策略是無效的,會導致意外的合成

- (iii) DM-Deg 有效地抑制了不需要的視覺語義,防止了這種污染。

- (b) 語義不平衡:

- (i) 同時學習概念和組件可能會導致不平衡,導致概念或組件扭曲(這里介紹前者的情況)。

- (ii) DS-Bal 確保平衡學習,提高個性化表現。

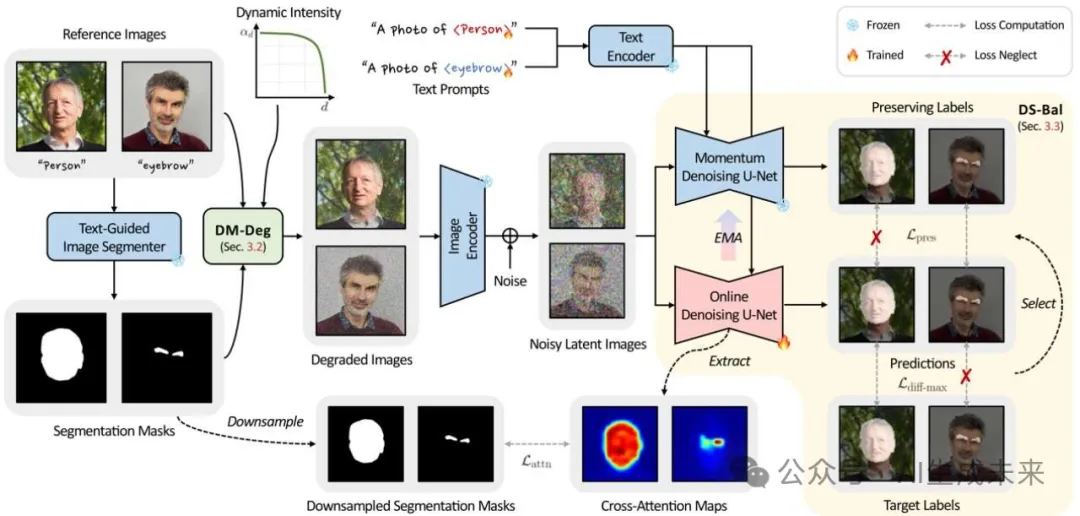

MagicTailor Pipeline

MagicTailor 使用參考圖像作為輸入,通過低秩自適應 (LoRA) 微調 T2I 擴散模型,以學習目標概念和組件,從而能夠生成將組件無縫集成到概念中的圖像。

本文引入了動態掩碼退化(DM-Deg),這是一種動態干擾不需要的視覺語義的新技術。這種方法有助于抑制模型對不相關視覺細節的敏感性,同時保留整體視覺上下文,從而有效減輕語義污染。

此外,采用雙流平衡(DS-Bal),一種旨在平衡視覺語義學習的雙流學習范式,來解決語義不平衡的問題。在線去噪 U-Net 執行樣本最小-最大優化,而動量去噪 U-Net 應用選擇性保留正則化,確保更忠實的個性化。

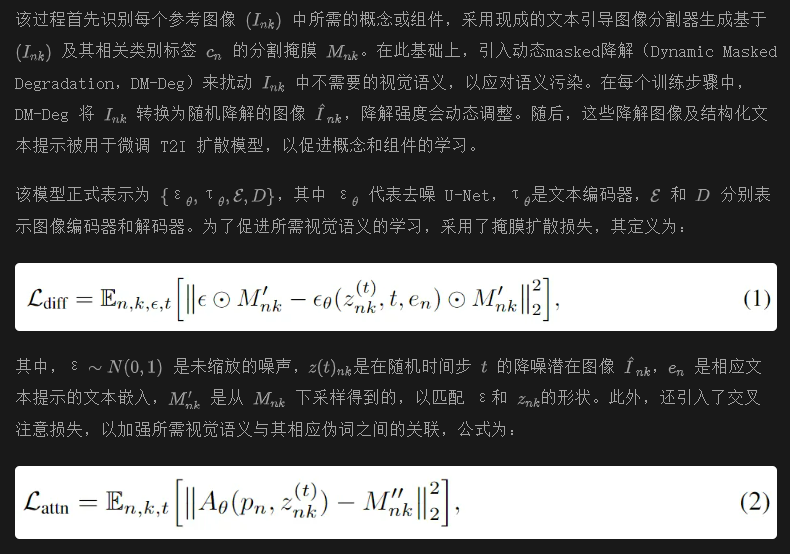

算法總覽

動態mask退化

在此任務中,主要挑戰之一是語義污染,其中不需要的視覺語義可能被 T2I 模型感知,從而“污染”個性化概念。如圖 2(a.i) 所示,目標概念(即人)可能會受到目標組件的所有者(即眼睛)的嚴重干擾,導致生成混合的人物。不幸的是,直接遮蔽目標概念和組件以外的區域會破壞整體視覺上下文,從而導致過擬合和奇怪的組合,如圖 2(a.ii) 所示。因此,參考圖像中不需要的視覺語義應當妥善處理。因此,我們提出了動態掩膜降解(Dynamic Masked Degradation,DM-Deg),旨在動態擾動不需要的視覺語義(見圖 3),以抑制 T2I 模型對這些語義的感知,同時保持整體視覺上下文(見圖 2(a.iii))。

雙流平衡

在此任務中,另一個主要挑戰是語義不平衡,這源于目標概念與組件之間固有的視覺語義差異。一般而言,一個概念的視覺語義通常比組件更為豐富(例如,人物與頭發),而在某些情況下,組件的語義豐富性可能大于概念(例如,簡單的塔與復雜的屋頂)。這種不平衡使得聯合學習過程變得復雜,可能會過度強調概念或組件中的某一方,導致生成的不連貫性(見圖 5(a))。為了解決這一挑戰,設計了雙流平衡(Dual-Stream Balancing,DS-Bal),建立了一種在線和動量去噪 U-Net 的雙流學習范式(見圖 3),以平衡概念和組件的視覺語義學習,從而提高個性化的保真度(見圖 5(b))。

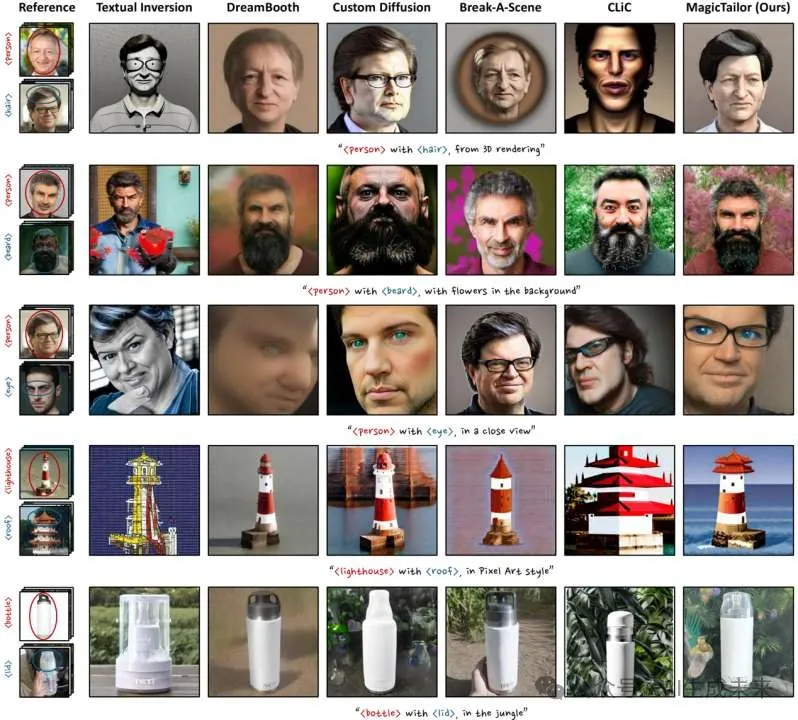

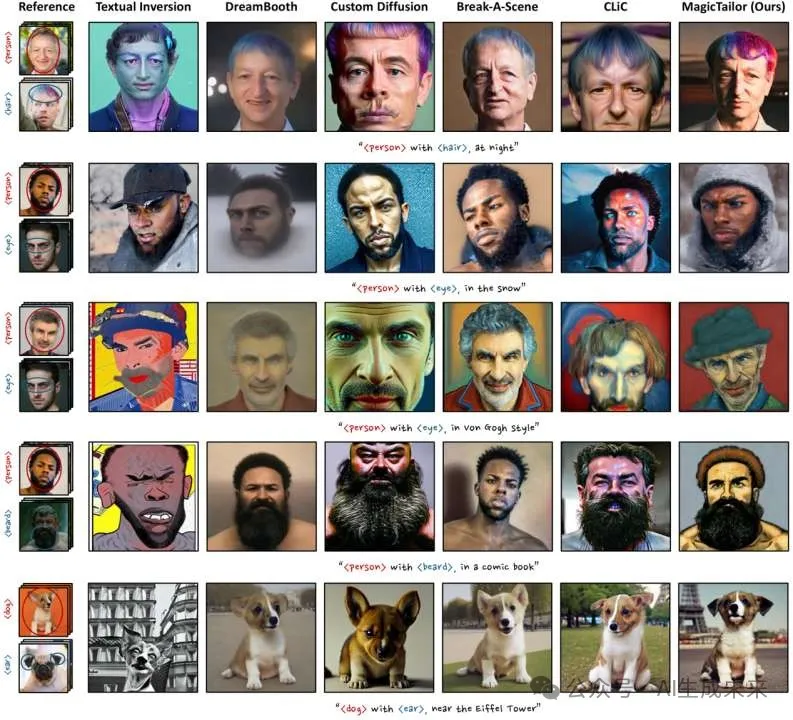

定性結果

展示了由 MagicTailor 生成的圖像以及針對各個領域的個性化的 SOTA 方法。 MagicTailor 總體上實現了良好的文本對齊、強大的身份保真度和高生成質量。

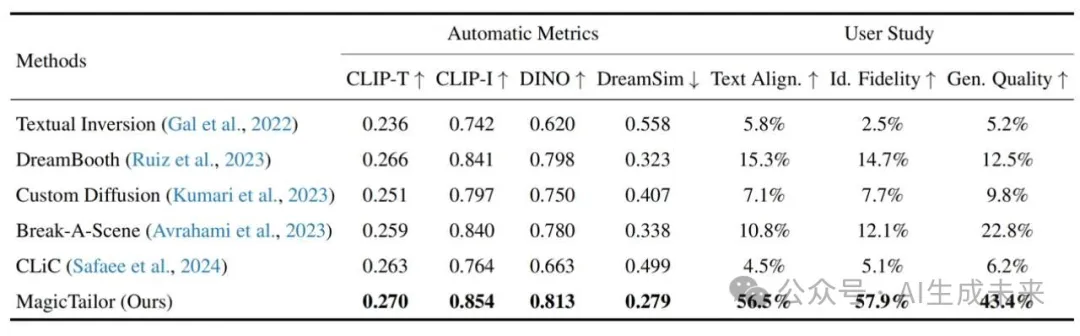

定量結果

將 MagicTailor 與基于自動指標(CLIP-T、CLIP-I、DINO 和 DreamSim)和用戶研究(人類對文本對齊、身份保真度和生成質量的偏好)的 SOTA 個性化方法進行比較。最佳結果以粗體標記。

MagicTailor 可以在這項具有挑戰性的任務中取得卓越的性能。

結論

本文引入了組件可控個性化這一新任務,允許在個性化概念中精確定制各個組件。解決了使該任務特別困難的兩個主要挑戰:語義污染(不需要的視覺元素破壞概念的完整性)和語義不平衡(導致視覺語義學習過程偏差)。為應對這些挑戰,提出了MagicTailor這一創新框架,包含動態掩碼退化(DM-Deg)以緩解不需要的視覺語義影響,以及雙流平衡(DS-Bal)以確保視覺組件的平衡學習。全面實驗表明,MagicTailor不僅在這一具有挑戰性的任務中樹立了新的基準,還為廣泛的創意應用開辟了令人興奮的可能性。展望未來,設想將該方法擴展至圖像和視頻生成的其他領域,探索如何識別、控制和操控多層次視覺語義,以實現更復雜和富有想象力的生成能力。

本文轉自AI生成未來 ,作者:AI生成未來