斯坦福、Salesforce等開源1萬億tokens多模態數據集

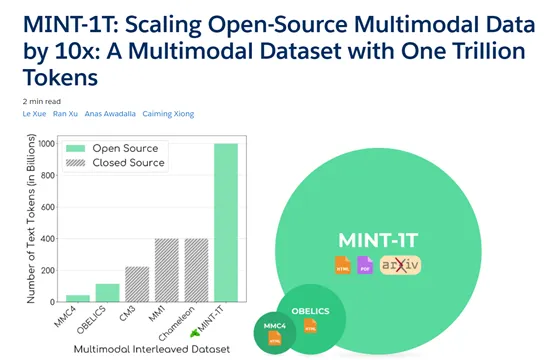

華盛頓大學、斯坦福大學、Salesforce等研究人員聯合開源了多模態數據集MINT-1T。

據悉,MINT-1T共包含了大約1萬億個文本標記和34億張圖像,是現有開源多模態數據集的10倍,同時還首次從ArXiv網站中爬取了專業論文,進一步提升了數據質量。這對于開源領域開發GPT-4o、Gemini等多模態模型,提供了全面、多元化的數據集。

開源地址:https://github.com/mlfoundations/MINT-1T

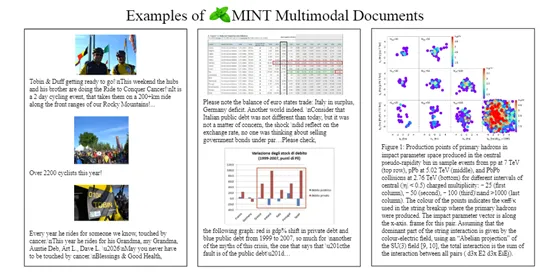

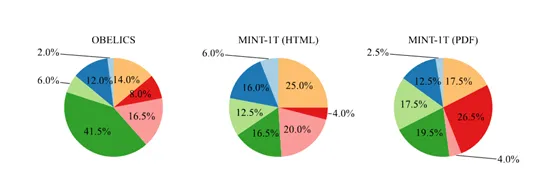

MINT-1T數據集包含了多種來源,其中,HTML文檔的主要來源于CommonCrawl,是一個非盈利性的組織,通過爬取互聯網上的網頁生成了大量的數據集,被廣泛用于各種學術研究和模型訓練。

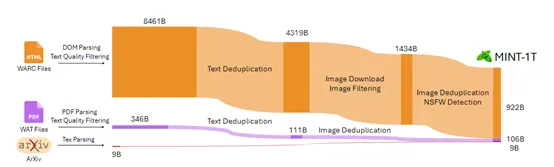

在提取的過程中,為了確保數據集的質量和多樣性,研究人員對文檔進行了數據過濾,排除了那些不包含圖像或包含超過三十張圖像的文檔,同時剔除了那些圖像URL中包含不適當子字符串(例如,logo、avatar、porn、xxx等)的文檔。

在處理HTML文檔時,團隊采用了OBELICS的方法,通過解析WARC條目的DOM樹來提取交錯的多模態文檔。這種方法允許團隊在保持圖像和文本原始順序的同時,提取出有用的數據。

此外,團隊還對HTML文檔進行了去重處理,使用了Bloom Filter技術,通過設置0.01的誤報率,對13-gram段落進行去重。如果一個文檔中超過80%的段落是重復的,那么整個文檔就會被丟棄。這種方法有效地減少了數據集中的冗余內容,提高了數據的質量和可用性。

PDF文檔是MINT-1T數據集中的另一個重要組成部分。這些文檔主要來源于CommonCrawl WAT文件,涵蓋了2023年2月——2024年4月的數據。與HTML文檔的處理方法類似,研究人員首先從這些轉儲中提取所有PDF鏈接,然后嘗試使用PyMuPDF 2下載和讀取PDF文件。

在處理的過程中,研究人員對PDF文件的大小和頁數進行了限制,排除了超過50MB大或超過50頁的PDF文檔。這是因為這些文檔通常包含大量的圖像,可能會影響數據處理的效率和效果。

ArXiv是全球著名提供物理、數學、計算機科學、AI等領域的專業論文網站,研究人員從這里提取了大量基于LaTeX源代碼的文檔,包含了論文的文本內容、圖像、表格、參考文獻等所有元素。

在處理LaTeX源代碼時首先需要識別圖形標簽,這些標簽通常以\includegraphics的形式出現,指示了圖像在文檔中的位置。

通過分析這些標簽,研究人員能夠確定圖像在文本中的相對位置,并據此將圖像與文本內容進行交錯,這對于保持文檔的原始結構和閱讀順序至關重要。

在獲取了經過初步處理的PDF、HTML等數據后,研究人員對這些數據做了進一步處理。首先,使用Fasttext的語言識別模型排除了非英語文檔,以確保數據集的語言一致性。

其次,刪除了URL包含NSFW子字符串的文檔,以排除色情和不良內容。還使用了RefinedWeb的文本過濾方法,移除了包含過多重復n-gram或被識別為低質量的文檔。

在圖像過濾方面,團隊嘗試下載HTML數據集中的所有圖像URL,丟棄了任何無法檢索的鏈接,并移除了沒有有效圖像鏈接的文檔。為了提高圖像質量,移除了小于150像素的圖像,以避免包含諸如徽標和圖標等噪聲圖像。

為了確保數據集的安全性和合規性,研究人員對所有圖像使用了NSFW圖像檢測器。如果發現文檔包含單個NSFW圖像,則丟棄整個文檔。同時對對文本數據中的電子郵件地址和IP地址等個人信息,進行了匿名化處理防止敏感數據泄露。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區