一文搞懂 DeepSeek - 強化學習和蒸餾 原創

這個春節,DeepSeek 實在太火爆了。

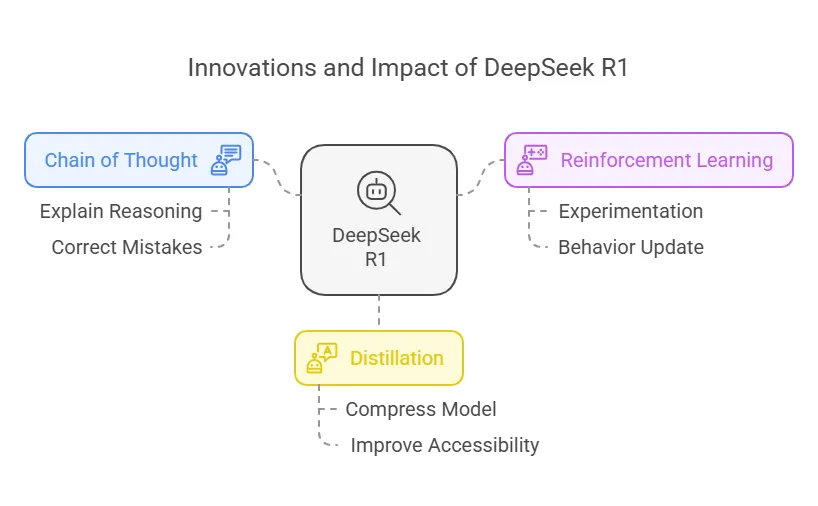

DeepSeek-R1 在其論文(??https://arxiv.org/abs/2501.12948??)引言部分指出,R1 模型通過融合冷啟動數據、多階段訓練流程以及純粹的強化學習策略,顯著增強了大型語言模型的推理能力。這使得 R1 模型在性能上與 OpenAI 的 o1 系列模型持平,并且通過蒸餾技術,成功地將這種推理能力傳遞給了更小型化的模型。

在 DeepSeek-R1 的“貢獻”章節中,著重強調了以下兩點創新:

1.模型訓練完成后:對基礎模型實施了大規模的強化學習訓練。通過這種方式,DeepSeek-R1 在基礎模型的基礎上,成功培育出了自我驗證和長思維鏈等高級推理能力。

2.蒸餾技術:小型模型也能具備強大能力。本研究還證明了,大型模型的推理模式可以有效地通過蒸餾技術轉移到小型模型中,從而顯著提高小型模型的性能。

1、Post-Training:大規模強化學習

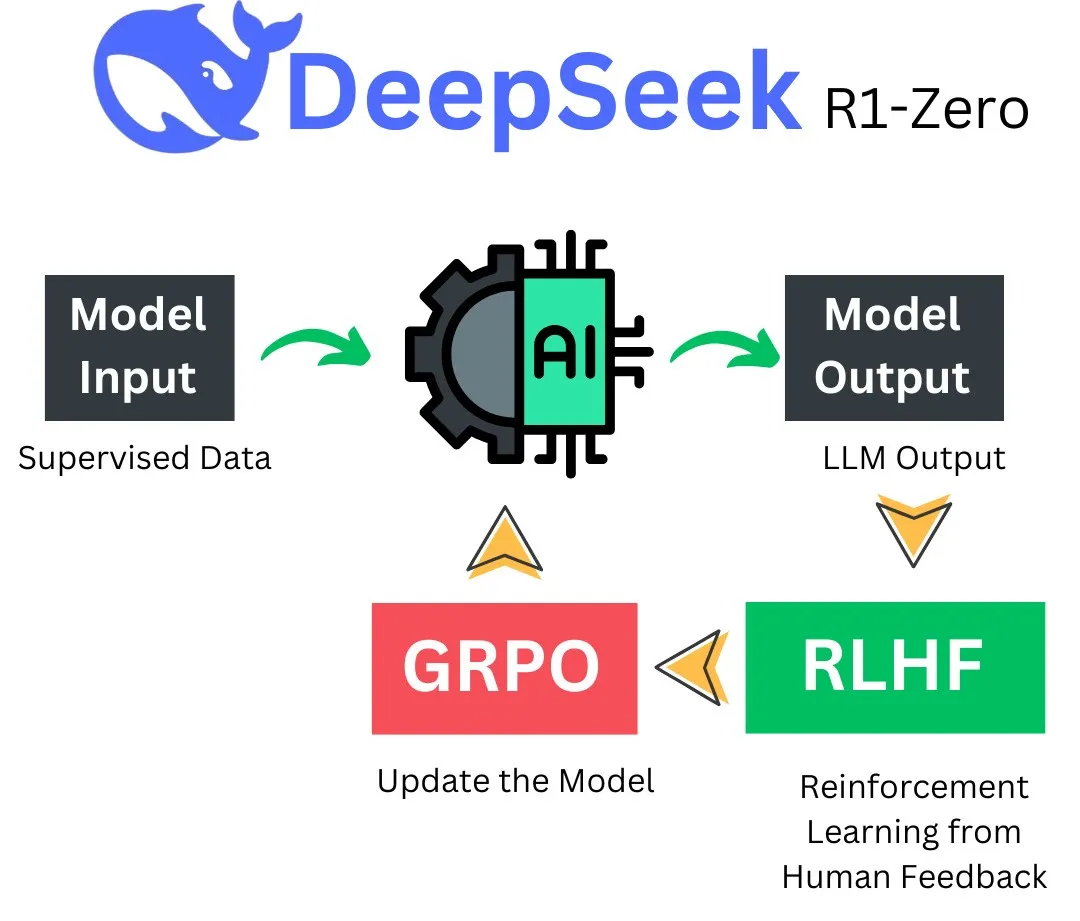

DeepSeek-R1-Zero 揭示了,大語言模型(LLMs)的推理能力能夠僅依靠強化學習得到提升,無需進行監督微調。DeepSeek 采取的策略是在基礎模型上直接實施強化學習,跳過了監督微調這一預備步驟。這種做法使得模型能夠深入探索解決復雜問題的思維鏈,進而孕育出具備自我驗證、反思以及長思維鏈生成能力的 DeepSeek-R1-Zero,為學術研究樹立了一個重要的里程碑。通過純粹的強化學習手段,而非監督微調,DeepSeek 成功激發了 LLMs 的推理潛能,這一技術革新為領域的發展開辟了新路徑。中國的這一 0-1技術創新令硅谷震動,甚至導致英偉達市值大幅波動。

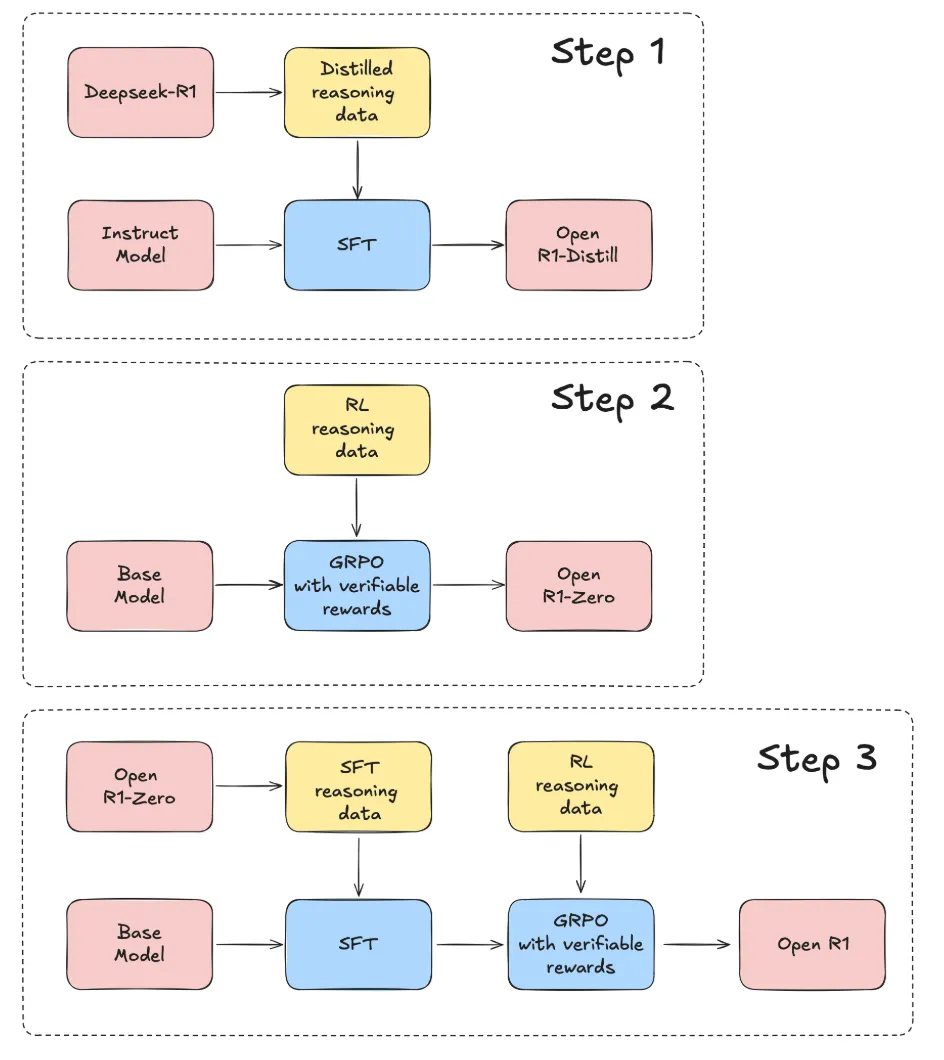

DeepSeek-R1 的開發流程是怎樣的?R1 的開發流程涉及兩個強化學習階段,目的是發掘更優的推理模式,并與人類偏好相契合。此外,流程中還包含兩個監督微調階段,這些階段構成了模型推理和非推理能力的基礎。DeepSeek 堅信,這一流程將有助于構建更出色的模型,從而為整個行業帶來益處。

2、蒸餾:小模型同樣強大

蒸餾技術是否真的能讓小型模型同樣強大?事實證明,大型模型的推理模式可以通過蒸餾技術轉移到小型模型中,這種方法相較于僅在小型模型上應用強化學習發現的推理模式,能夠實現更卓越的性能表現。

開源的 DeepSeek-R1 及其 API 將助力研究界在未來提煉出更優秀的小型模型。DeepSeek-R1 系列通過蒸餾得到的小型模型在多項基準測試中展現出顯著優勢,超越了先前開源的模型。特別是 DeepSeek-R1-Distill-Qwen-32B,其性能足以與 o1-mini 匹敵,而 DeepSeek 已向學術界開源了基于 Qwen2.5 和 Llama3 系列的不同參數規模的模型,包括 150億、70億、80億、140億、320億 和 700億參數的檢查點。這一顛覆性的0-1技術創新,讓硅谷的技術巨頭們感到不安,因為這一創新已在全球技術人員的驗證下,證實了基于 R1 論文方法可以成功蒸餾出與 o1-mini 性能相當的小型模型。再次向梁文峰大神致敬。

那么,如何蒸餾出 DeepSeek-R1-Distill-Qwen-32B 呢?以下是詳細的蒸餾步驟:

第一步、確定模型角色

1、教師模型:選取表現卓越、知識淵博的DeepSeek-R1作為指導。

2、學生模型:選擇參數適中、適合蒸餾的Qwen-32B作為學習對象。

第二步、準備數據集

1、數據收集:整合跨領域的高質量文本數據,為蒸餾打下基礎。

2、數據預處理:對數據集進行嚴格篩選和處理,確保蒸餾效果不受數據質量影響。

第三步、模型訓練與蒸餾

1、教師模型推理:DeepSeek-R1提供軟標簽和中間層特征,作為Qwen-32B的學習標準。

2、學生模型訓練:Qwen-32B模仿DeepSeek-R1的行為,吸收其知識和經驗。

3、損失函數設計:使用KL散度或交叉熵等,衡量學生模型與教師模型之間的差異。

4、優化算法選擇:采用SGD或Adam等算法,優化學生模型參數,降低損失函數值。

第四步、模型評估與調優

1、模型評估:使用獨立的測試數據集,比較學生模型與教師模型的表現,以評估蒸餾效果。

2、模型調優:根據評估結果,調整超參數、優化損失函數等,以提高蒸餾效果。

本文轉載自公眾號玄姐聊AGI 作者:玄姐