DeepSeek-R1:通過強化學習激發大語言模型的推理潛能 精華

在本文中,我們將深入探索DeepSeek-R1背后的前沿進展與創新方法。這一成果作為提升大語言模型(LLMs)推理能力的卓越方案,融合了強化學習(RL)等前沿技術,不僅革新了模型訓練范式,還為行業發展開辟了新方向。接下來,讓我們一同揭開DeepSeek-R1的神秘面紗,探尋其引領AI推理領域變革的核心力量。

來源:DeepSeek AI

隨著強化學習(RL)技術的興起,提升大語言模型(LLM)推理能力的探索取得了重大突破。本文將深入剖析DeepSeek-Zero和DeepSeek-R1這兩種開創性的模型,它們各自具備獨特的架構與訓練策略,為大語言模型的推理能力帶來了質的飛躍。

- DeepSeek-Zero:這是一款純粹基于強化學習的模型,它無需依賴監督微調(SFT),便能展現出令人驚嘆的推理能力,通過自我進化的訓練機制,在各種推理任務中實現高效表現。

- DeepSeek-R1:作為DeepSeek-Zero的進階版本,DeepSeek-R1整合了多階段訓練技術和冷啟動數據,進一步優化了模型的可讀性與推理性能,使其在復雜任務處理中更加精準、高效。

創新點

這些模型的獨特優勢在于:

- 強化學習驅動推理:摒棄傳統監督微調模式,完全依靠強化學習激發模型的推理能力,構建更加自主、高效的學習機制。

- 能力蒸餾優化架構:將大型模型的強大推理能力提煉至更小、更高效的架構中,在降低計算成本的同時,保持甚至提升了模型的性能表現,為資源受限場景提供了更優解決方案。

方法

通過強化學習實現推理能力

這些模型充分挖掘強化學習在提升推理能力方面的巨大潛力,無需監督微調作為冷啟動,直接從基礎模型開始進行優化。訓練流程從專注于通過強化學習實現自我進化的DeepSeek-Zero逐步演進到整合結構化數據以優化結果的DeepSeek-R1,不斷提升模型的適應性和準確性。

DeepSeek-Zero:基礎模型上的強化學習

- 組相對策略優化(GRPO):GRPO是一項具有高效計算性能的強化學習技術,它以基于組分數的估計替代傳統的critic模型,極大地降低了計算負擔,提升了訓練效率,為模型的快速迭代提供了有力支持。

- 獎勵建模

準確性獎勵:在數學、編程等確定性任務中,確保模型輸出的準確性是至關重要的。準確性獎勵機制通過對正確答案的正向激勵,引導模型在這些任務中不斷優化推理過程,提高解題的正確率。

格式獎勵:利用<step>和<answer>標簽,格式獎勵機制強制模型遵循結構化的推理流程,確保推理過程的清晰性和邏輯性,使模型輸出更易于理解和驗證。

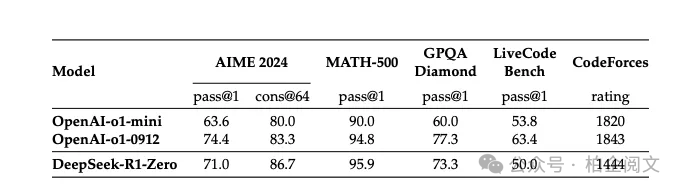

- 績效和自我評估:DeepSeek-Zero在推理基準測試中表現出持續的性能提升,模型能夠在訓練過程中自主優化推理策略,在關鍵節點實現“頓悟”,達到與OpenAI的o1系列模型相媲美的性能水平。

DeepSeek-R1:冷啟動強化學習

- 什么是冷啟動?:冷啟動是指利用精心篩選的長思維鏈(CoT)數據對基礎模型(DeepSeek-V3-Base)進行微調,以此穩定強化學習的訓練過程。這一過程不僅提升了模型輸出的可讀性,還確保了輸出結果具有結構化的總結,為后續的推理任務奠定了堅實基礎。同時,冷啟動有效解決了從原始未調優模型開始訓練時強化學習的不穩定性問題,加速了模型的收斂速度,顯著提升了推理任務的執行效率。

- 面向推理的強化學習:在冷啟動之后,DeepSeek-R1通過大規模強化學習進一步優化模型在編碼、數學、邏輯等推理密集型任務中的表現。為了解決語言混合問題,模型引入了語言一致性獎勵機制,使輸出結果更加符合人類語言習慣,提升了文本的連貫性和可讀性。

數據使用

- 推理數據:該數據集包含專為推理密集型任務設計的提示,如數學問題求解、邏輯推理和結構化問題解決場景。訓練過程中,基于規則的獎勵機制用于評估模型輸出的正確性,確保模型能夠有效處理具有明確解決方案的復雜問題。數據來源涵蓋標準化數學和邏輯競賽(如AIME)以及編程競賽平臺(如Codeforces)的任務,這些數據助力模型生成高度結構化和邏輯性的輸出。

- 非推理數據:非推理數據集涵蓋問答(QA)、創意寫作和語言翻譯等多種任務的提示,旨在拓寬模型的能力邊界,確保其在非推理任務中也能表現出色。數據來源于多個領域,包括事實性問答基準、對話任務和特定語言的翻譯,幫助模型流暢、連貫地處理各類查詢。

蒸餾:賦予小模型推理能力

DeepSeek-R1的強大推理能力可以通過蒸餾技術遷移到如Qwen和Llama系列等較小的模型中,顯著提升它們的性能,且無需進行強化學習訓練。這一創新方法使得先進的推理能力能夠更廣泛地應用于研究和工業領域,推動了AI技術的普及與發展。

DeepSeek-R1評估

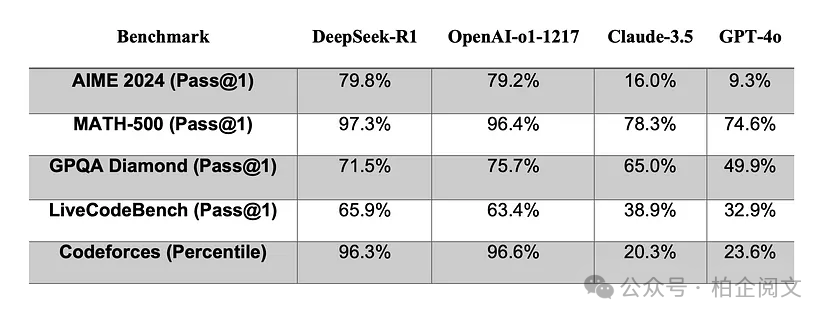

DeepSeek-R1的性能與行業領先模型進行了全面對比,結果顯示:

- 推理任務:在AIME 2024和MATH-500等基準測試中,DeepSeek-R1展現出卓越的準確性,超越了眾多競爭對手,證明了其在復雜推理任務中的強大實力。

- 一般問答:在創意寫作和指令遵循任務中,DeepSeek-R1的表現優于GPT-4o和Claude等知名模型,為用戶提供更加優質、符合需求的回答。

- 長上下文理解:在AlpacaEval和ArenaHard等需要長上下文推理的任務中,DeepSeek-R1表現出色,能夠深入理解復雜語境,提供準確、連貫的答案。

這些結果充分證明了強化學習在提升模型推理能力和泛化能力方面的顯著成效。

蒸餾與強化學習

- 蒸餾的優勢:相較于強化學習,蒸餾技術能夠以更低的計算成本為小模型帶來更好的性能提升。DeepSeek-R1的蒸餾模型在性能上超越了傳統強化學習訓練的緊湊型架構,如QwQ-32B,為小模型的優化提供了更高效的途徑。

- 強化學習的挑戰:對于小模型而言,強化學習的計算成本較高,且難以達到與蒸餾技術相媲美的效果。這一局限性在實際應用中需要謹慎考慮,促使研究人員不斷探索更加優化的解決方案。

未成功的嘗試

在開發過程中,部分實驗未能取得預期成果,揭示了一些技術挑戰和局限性:

- 流程獎勵模型(PRM):PRM旨在通過評估中間步驟來引導模型的推理過程,但在實際應用中,面臨著細粒度步驟定義困難、依賴手動注釋以及易受獎勵黑客攻擊等問題,嚴重限制了其可擴展性。

- 蒙特卡洛樹搜索(MCTS):受AlphaGo和AlphaZero啟發,MCTS試圖將問題分解為更小的部分以系統地探索解決方案。然而,代幣生成的指數級復雜性和訓練細粒度價值模型的困難導致其性能不盡人意。

這些嘗試雖然未獲成功,但為研究人員提供了寶貴的經驗教訓,有助于進一步優化模型設計和訓練策略。

結論、局限性與未來工作

結論

DeepSeek-R1充分展示了強化學習在提升大語言模型推理能力方面的巨大潛力,其性能與OpenAI-o1-1217等頂尖模型相當。通過蒸餾技術,先進的推理能力得以擴展到更小、更高效的模型中,為AI領域的廣泛應用提供了有力支持。

局限性

- 多輪交互與角色扮演挑戰:在處理多輪交互和復雜角色扮演任務時,DeepSeek-R1仍面臨一定困難,需要進一步優化以提升其在這類場景中的表現。

- 語言混合問題:在處理非英語語言查詢時,模型存在語言混合的問題,影響了回答的準確性和流暢性。

- 提示敏感性:模型對提示較為敏感,few-shot提示可能導致性能下降,需要更穩健的提示策略來優化模型響應。

未來工作

- 優化提示工程:通過改進提示工程,提升模型的穩健性和適應性,使其能夠更好地應對各種輸入。

- 擴展訓練數據:擴大訓練數據集,尤其是包含多種語言的語料,以解決語言混合問題,提升模型的跨語言處理能力。

- 引入異步評估:整合異步評估機制,提高軟件工程任務中的效率,進一步優化模型在實際應用中的性能。