帶你一文讀懂爆火的 DeepSeek-R1 新模型技術,為何震動了全球 AI 圈 原創 精華

這個春節,DeepSeek 實在太火爆了。

短短一個月不到,DeepSeek 再次震撼了全球人工智能領域。

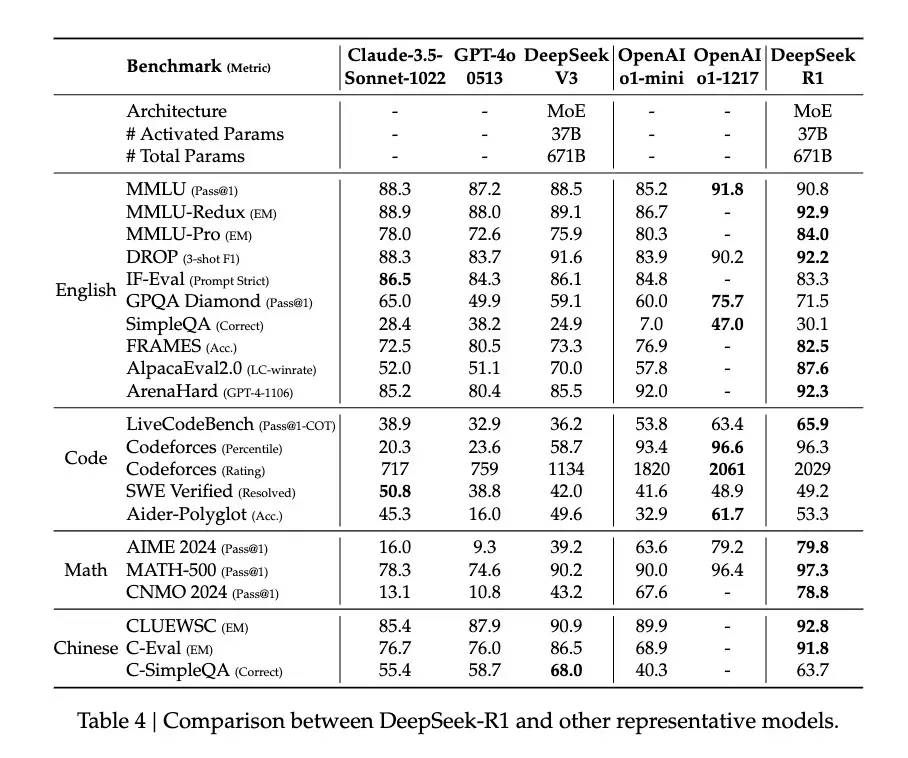

在去年12月,DeepSeek 推出的 DeepSeek-V3 在全球 AI 界引起了軒然大波,它憑借極低的訓練成本,達到了與 GPT-4o、Claude Sonnet 3.5 等頂級模型媲美的性能表現。

與之前不同的是,此次推出的 DeepSeek-R1 模型不僅在成本上更具優勢,而且在技術層面實現了質的飛躍,更重要的是,它是一款開源模型。

新模型 DeepSeek-R1 繼承了高性價比的特點,僅需十分之一的成本就能達到 GPT-o1 級別的性能。因此,許多行業人士紛紛宣稱“ DeepSeek 有望取代 OpenAI”。

舉例來說,前 Meta AI 員工、著名 AI 論文推特博主 Elvis 指出,DeepSeek-R1 的論文堪稱珍寶,因為它深入探討了提升大語言模型推理能力的多種途徑,并揭示了其中的顯著涌現特性。

英偉達 GEAR Lab的項目主管 Jim Fan 在 Twitter 上提及,DeepSeek-R1 利用硬編碼規則計算出的實際獎勵,從而規避了使用易于被 RL 破解的學習獎勵模型。這種方法促成了模型自我反思和探索行為的自然涌現。

Jim Fan 甚至表示,DeepSeek-R1 實現了 OpenAI 本應采取的行動——開源。

那么,他們提及的純粹基于 RL 方法訓練的模型究竟指的是什么?

模型展現的“頓悟時刻”(Aha Moment)又是如何證明 AI 已經具備了涌現能力的?

我們更感興趣的是,DeepSeek-R1 的這一創新對人工智能領域未來的發展方向,究竟蘊含著怎樣的意義?

1、用最簡單的配方,回歸最純粹的強化學習

自 o1 模型發布以來,推理強化成為了行業內的焦點方法。

通常情況下,一個模型在訓練過程中會采用一種固定的訓練方法來增強其推理能力。

然而,DeepSeek 團隊在 R1 模型的訓練中,大膽嘗試了三種截然不同的技術路線:直接強化學習訓練(R1-Zero)、多階段逐步訓練(R1)以及模型蒸餾,并且都取得了成功。這兩種訓練方法和模型蒸餾都蘊含了眾多創新元素,對整個行業產生了深遠的影響。

尤其令人振奮的是直接強化學習這條路徑。DeepSeek-R1 成為了首個驗證這一方法有效性的模型。

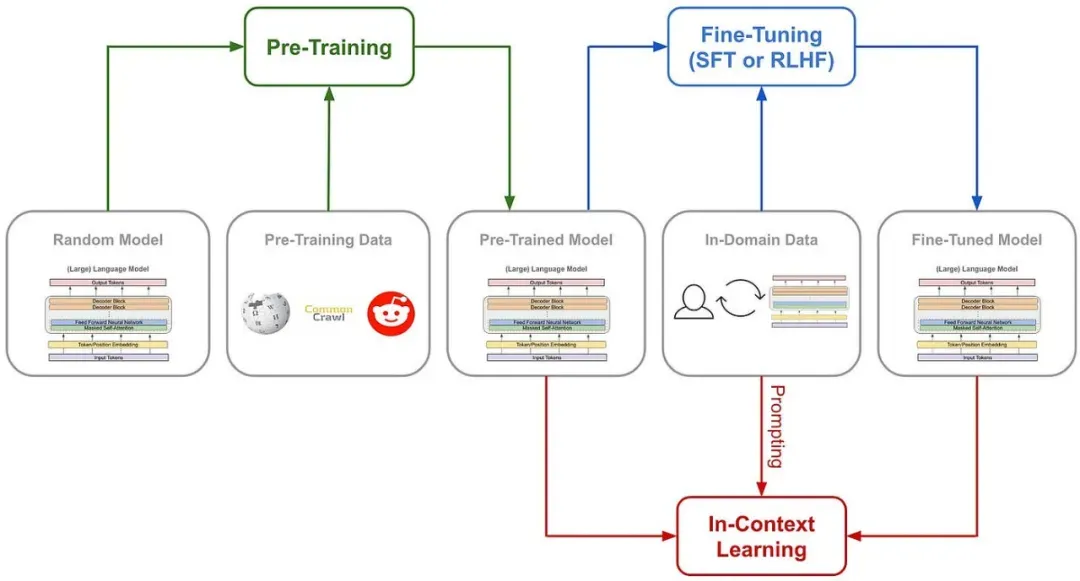

讓我們先來探討一下,傳統訓練 AI 推理能力的常用方法是什么,如下圖所示:通常是在監督式微調(SFT)中引入大量的思維鏈(COT)示例,通過示例和復雜的神經網絡獎勵模型,如過程獎勵模型(PRM),來教會模型如何進行思維鏈式的思考。

有時還會結合蒙特卡洛樹搜索(MCTS),使模型能夠在多種可能性中尋找最佳答案。

DeepSeek-R1-Zero 采用了前所未有的策略,即“純”強化學習路徑,完全摒棄了預先設定的思維鏈模板(Chain of Thought)和監督式微調(SFT),僅通過簡單的獎勵和懲罰信號來優化模型的行為。

這好比是讓一個天才兒童在沒有范例和指導的情況下,僅通過不斷的嘗試和接收反饋來自學解題。

DeepSeek-R1-Zero 僅配備了一套基礎的獎勵系統,旨在激發 AI 的推理能力。

這套系統的規則非常簡單,只有兩條:

準確性獎勵:模型根據其響應的正確與否來獲得獎勵或懲罰。正確回答得到加分,錯誤回答則扣分。評估標準也很直接:例如,在數學問題中,模型需要以特定的格式(如分數和小數)提供最終答案;在編程問題中,則通過編譯器根據預設的測試用例來生成反饋。

格式獎勵:模型必須將其思考過程放在特定的標簽之間,以獲得格式獎勵。未能這樣做會扣分,反之則加分。

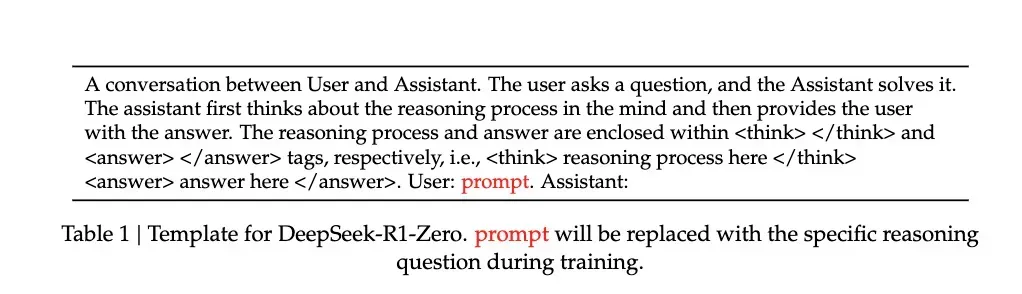

為了更準確地觀察模型在強化學習(RL)過程中的自然發展,DeepSeek 甚至刻意將系統提示詞(如下圖所示)限制在這種結構化的格式上,以避免任何針對特定內容的偏見——比如強制模型進行反思性推理或推廣特定的解題策略。

正是基于這樣一套簡化的規則,A I能夠在 GRPO(Group Relative Policy Optimization)的框架下進行自我采樣和比較,從而實現自我提升。

GRPO 的方法論相當直接,它通過比較組內樣本來計算策略梯度,這樣不僅有效減少了訓練過程中的不穩定性,還提升了學習效率。

換句話說,可以將其類比為老師出題,模型對每個問題給出多個答案,然后根據之前提到的獎勵和懲罰規則對每個答案進行評分,模型根據追求高分、避免低分的邏輯進行自我更新。

整個流程大致如下:

輸入問題 → 模型產生多個答案 → 規則系統進行評分 → GRPO計算相對優勢 → 模型更新

這種直接的訓練方法帶來了幾個明顯的優勢。首先,訓練效率得到了顯著提升,整個流程可以在更短的時間內完成。其次,資源消耗減少,因為省去了SFT和復雜的獎勵模型,計算資源的需求大幅降低。

更為關鍵的是,這種方法確實讓模型學會了如何思考,并且是通過“頓悟”這種方式來學習的。

2、用自己的語言,在“頓悟”中學習

我們是如何判斷模型在這樣一套“原始”方法下真正學會了“思考”的呢?

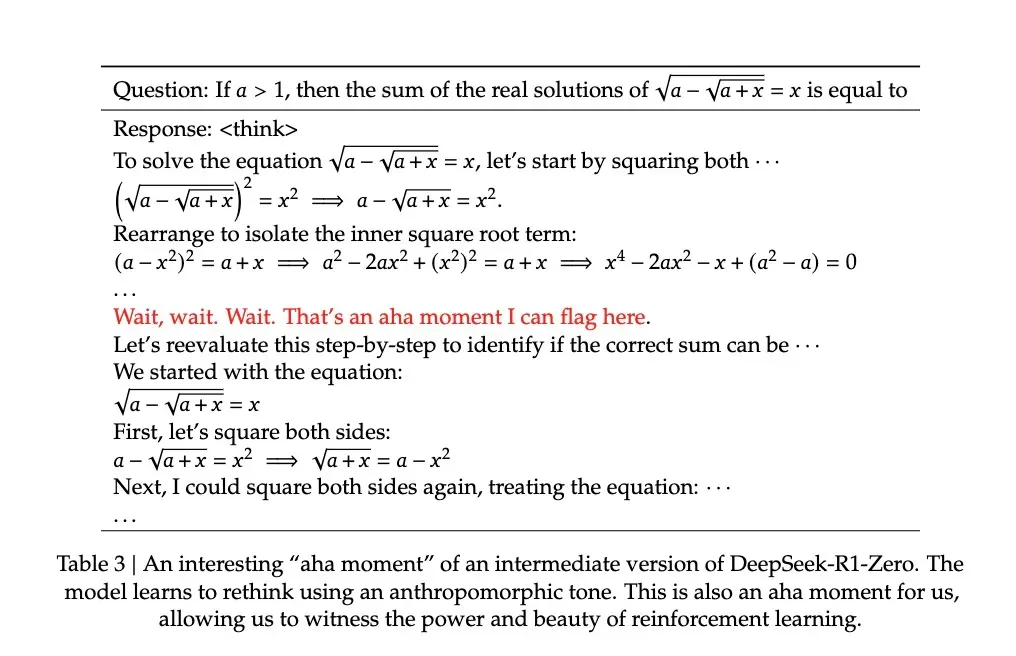

研究論文中記錄了一個令人矚目的例子:在解決一個包含復雜數學表達式 √a - √(a + x) = x 的問題時,模型突然停下來并說道:"Wait, wait. Wait. That's an aha moment I can flag here"(等等、等等,這是一個值得標記的頓悟時刻),然后它重新審視了整個解題過程。這種類似于人類頓悟的行為是自發產生的,而非預先編程的結果。

這種頓悟通常標志著模型思維能力的飛躍。

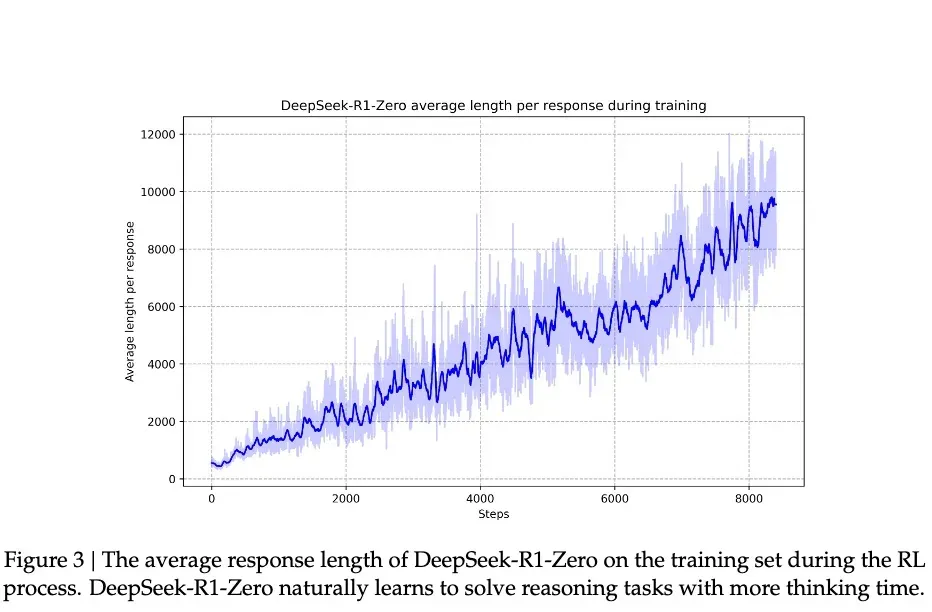

根據 DeepSeek 的研究,模型的進步并非平滑漸進的。在強化學習的過程中,模型的響應長度會突然顯著增加,這些“跳躍點”往往伴隨著解題策略的本質變化。這種模式與人類長時間思考后突然的領悟相似,暗示著某種深層的認知突破。

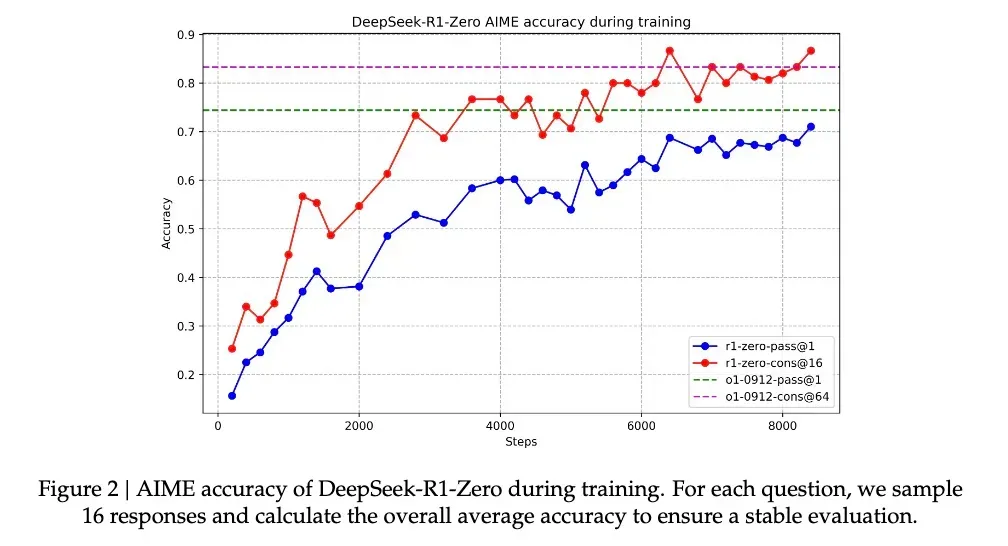

在這種伴隨頓悟的能力提升下,R1-Zero 在備受數學界推崇的 AIME 競賽中的正確率從最初的 15.6% 飆升至 71.0%,而在對同一問題進行多次嘗試后,準確率甚至達到了 86.7%。這不僅僅是看過問題就能解決那么簡單—— AIME 的題目需要深入的數學直覺和創造性思維,而非機械的公式應用。模型的這種提升表明它必須具備推理能力。

另一個證明模型確實通過這種方法學會了推理的核心證據是,模型響應的長度會根據問題的復雜度自然調整。這種自適應行為顯示,模型并非簡單套用模板,而是真正理解了問題的難度,并相應地投入更多的“思考時間”。就像人類在處理簡單加法和復雜積分時會自然調整思考時間一樣,R1-Zero 展現出了類似的智慧。

或許最有說服力的是模型展現出的遷移學習能力。在完全不同的編程競賽平臺 Codeforces 上,R1-Zero 達到了超過 96.3% 的人類選手水平。這種跨領域的表現說明,模型并非只是在記憶特定領域的解題技巧,而是掌握了某種普遍適用的推理能力。

3、一個聰明,但口齒不清的天才

盡管 R1-Zero 展現了令人矚目的推理技能,但研究人員很快便發現了一個重大缺陷:其思維過程對人類來說往往晦澀難懂。

論文中直言不諱地提到了這個完全通過強化學習訓練出來的模型存在“可讀性差”和“語言混雜”的問題。

這一現象不難理解:R1-Zero 完全依賴獎勵和懲罰信號來優化其行為,沒有人類提供的“標準答案”作為參照。這就好比一個天才兒童發明了一種獨特的解題方法,雖然有效,但在向他人解釋時卻顯得語無倫次。它在解題時可能會混用多種語言,或者創造出一種獨特的表達方式,這些都使得其推理過程難以追蹤和理解。

為了解決這個問題,研究團隊開發了改進版的 DeepSeek-R1。通過引入傳統的“冷啟動數據”和多階段訓練流程,R1 不僅保留了強大的推理能力,還學會了以人類容易理解的方式表達其思維過程。這就像為那位天才兒童配備了一位溝通教練,指導他如何清晰表達自己的想法。

經過這樣的訓練之后,DeepSeek-R1 展現出了與 OpenAI o1 相媲美甚至在某些方面更勝一籌的性能。在 MATH 基準測試中,R1 達到了 77.5% 的準確率,與 o1 的 77.3% 不相上下;在更具挑戰性的 AIME 2024上,R1 的準確率達到了 71.3%,超過了 o1 的 71.0%。在編程領域,R1 在 Codeforces 的評測中達到了 2441分,超越了 96.3% 的人類參與者。

然而,DeepSeek-R1 Zero 的潛力似乎更為巨大。在 AIME 2024 測試中,當使用多數投票機制時,其準確率達到了 86.7%,這個成績甚至超越了 OpenAI 的 o1-0912。這種“多次嘗試后準確性提高”的特性暗示 R1-Zero 可能掌握了一種基礎的推理框架,而不僅僅是記憶解題模式。

論文中的數據顯示,從 MATH-500 到 AIME,再到 GSM8K,模型展現了穩定的跨領域性能,特別是在那些需要創造性思維的復雜問題上。這種廣泛的性能表明 R1-Zero 可能確實培養出了一種基礎的推理能力,這與專注于特定任務優化的傳統模型形成了鮮明對比。

因此,盡管表達不夠清晰,但或許 DeepSeek-R1-Zero 才是真正理解推理的“天才”。

4、純粹強化學習,也許才是通向 AGI 的意外捷徑

DeepSeek-R1 的發布之所以令業界矚目,并將焦點轉向純強化學習方法,是因為它實質上為 AI 的進化開辟了一條新道路。

R1-Zero——這個完全依賴強化學習訓練而成的 AI 模型,展現了令人矚目的通用推理能力。它不僅在數學競賽中取得了卓越成績,更重要的是,R1-Zero 并非僅僅在模仿思考,而是真正培育出了一種推理能力。

在傳統的訓練方法中,尤其是在監督式微調中,使用預先訓練好的神經網絡來評估輸出質量時,模型可能會學會觸發獎勵模型的特定模式,生成符合獎勵模型“口味”的內容,而非真正提升推理能力。換言之,AI 系統可能找到了一種獲得高獎勵但同時偏離訓練目標的方法。這就是我們所說的獎勵欺騙(reward hacking)。然而,R1-Zero 通過極其簡單的獎勵規則,幾乎避免了獎勵欺騙的可能性——規則太過簡單,沒有“口味”可以模仿。在這種情況下,模型發展出的推理能力更加可靠,也更加自然。

這一發現可能會顛覆我們對機器學習的傳統認知:傳統的 AI 訓練方法可能一直在犯一個根本性的錯誤,我們過于專注于讓 AI 模仿人類的思維方式,而業界或許需要重新審視監督學習在 AI 發展中的角色。通過純強化學習,AI 系統似乎能夠發展出更加原生的問題解決能力,而不是局限于預設的解決方案框架。

盡管 R1-Zero 在輸出的可讀性上存在顯著不足,但這個“不足”本身可能正反映了其思維方式的獨特性。就像一個天才兒童創造了自己的解題方法,卻難以用常規語言表達一樣。這提示我們:真正的通用人工智能可能需要一種完全不同于人類的認知方式。

這才是強化學習的真正精髓。正如著名教育家皮亞杰所提出的理論:真正的理解來自于主動建構,而非被動接受。

本文轉載自公眾號玄姐聊AGI 作者:玄姐

原文鏈接:??https://mp.weixin.qq.com/s/PzgzuiO3qvb6_n26vte8Yw??