什么是自然語言處理——NLP,其解決了什么問題? 原創

“ 自然語言處理是一門讓機器理解人類語言的技術,是人和機器交流的橋梁 ”

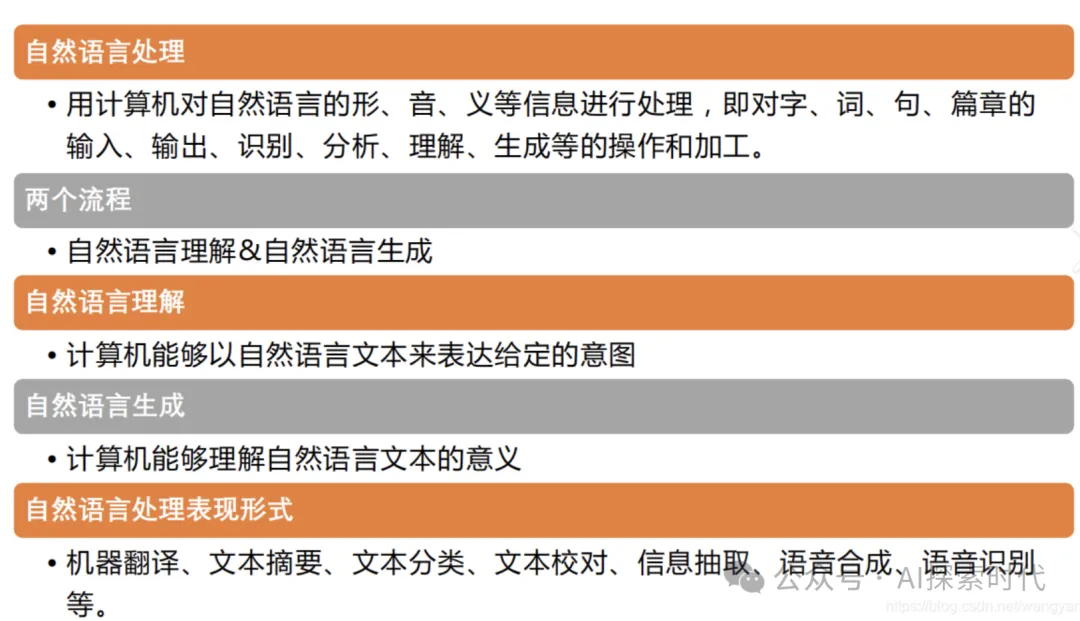

自然語言處理(Natural Language Processing, NLP)是人工智能(AI)的一個分支,旨在讓計算機能夠理解、生成和處理人類的自然語言(如中文、英文)。

NLP 的目標是讓計算機能夠像人類一樣理解和使用語言,從而實現人機自然交互、自動化信息處理等功能。

自然語言處理

自然語言處理的技術實現原理

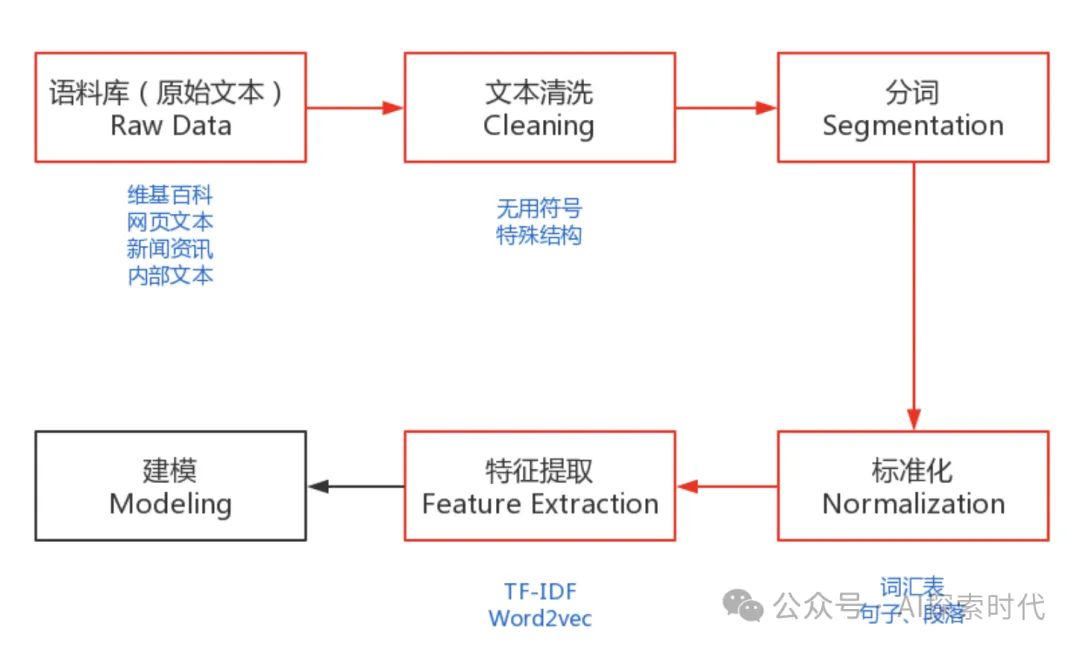

NLP 技術主要依賴于語言學知識、統計方法和深度學習技術,逐漸從基于規則的實現方法發展到依賴神經網絡和大規模預訓練模型的現代實現方法。

1. 傳統 NLP 方法

- 規則驅動:

a.基于手工規則,如上下文無關文法(CFG)、正則表達式。

b.優點:易解釋、邏輯清晰。

c.缺點:靈活性差,難以處理復雜語言現象。

- 統計方法:

a.使用統計模型對語言現象建模。

b.典型模型:隱馬爾可夫模型(HMM)、條件隨機場(CRF)。

c.應用:詞性標注、命名實體識別、機器翻譯等。

2. 深度學習與神經網絡方法

- 詞向量表示:

a.將語言中的詞表示為高維向量,使其包含語義信息。

b.方法:Word2Vec、GloVe、FastText。

c.示例:語義相近的詞,如“國王”和“女王”,其向量表示距離更近。

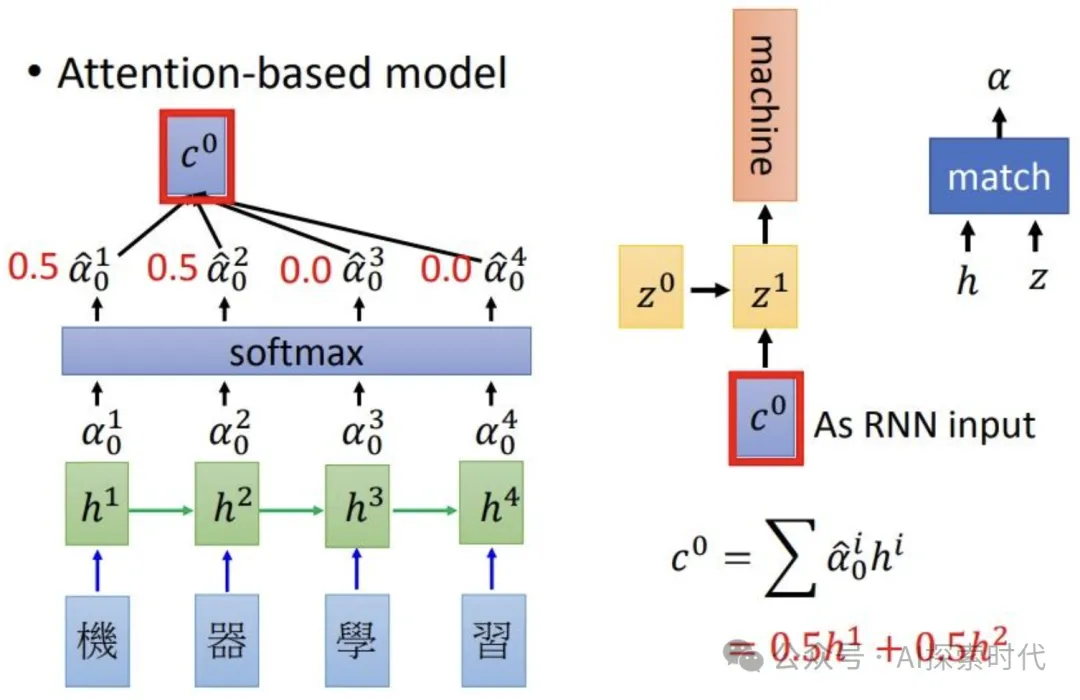

- 序列模型:

a.使用循環神經網絡(RNN)、長短時記憶網絡(LSTM)等捕捉語言序列特性。

b.缺點:難以處理長距離依賴。

- Transformer 及其改進:

a.Transformer 通過自注意力機制捕捉長距離依賴,是現代 NLP 的核心技術。

b.代表模型:BERT、GPT、T5 等。

- 預訓練與微調:

a.使用大規模數據預訓練語言模型(如 GPT、BERT),然后通過少量數據在特定任務上微調。

b.優點:通用性強,適配多種任務。

自然語言處理的困難點

1. 語言的復雜性

- 多義性:

a.一個詞或句子可能有多種解釋。

b.示例:“銀行”可能指金融機構,也可能指河岸。

- 長距離依賴:

a.在長句中,句子的語義可能依賴較遠的上下文。

b.示例:“盡管他生病了,他仍然參加了比賽。”需要理解“盡管”和“仍然”的邏輯關系。

- 隱含語義:

a.有些句子的意義需要結合上下文才能理解。

b.示例:“他是一個很‘棒’的廚師。”需要判斷“棒”是褒義還是諷刺。

2. 數據問題

- 數據稀缺:

a.對于某些語言或領域,標注數據不足。

b.示例:少數民族語言、專業醫學文檔等。

- 數據偏見:

a.訓練數據中的偏見可能導致模型輸出不公平的結果。

b.示例:男女職業刻板印象。

- 數據質量:

a.噪聲、不準確或不一致的數據會影響模型的性能。

3. 技術實現的復雜性

- 模型訓練成本高:

a.現代語言模型需要大規模計算資源。

b.示例:GPT-3 的訓練需要數百 GB 的文本和巨大的算力。

- 多語言處理:

a.不同語言的語法、詞匯、表達方式不同,導致跨語言處理困難。

- 實時性需求:

b.在對話系統、實時翻譯等場景中,模型需要快速響應。

4. 模型解釋性

- 深度學習模型(如 Transformer)通常被視為“黑箱”,難以解釋其決策過程。

總結

自然語言處理通過結合語言學、統計學和深度學習技術,推動了機器對語言的理解和生成能力的發展。然而,NLP 的實現仍面臨多義性、上下文理解、數據稀缺和模型偏見等問題。隨著技術的進步和數據的積累,NLP 將繼續朝著更智能、更自然的方向發展,為人機交互、信息檢索、智能翻譯等領域帶來更多可能性。

本文轉載自公眾號AI探索時代 作者:DFires

原文鏈接:??https://mp.weixin.qq.com/s/RbSHr1y3E2ryysjA9m4uiA??