NATURAL PLAN:LLMs在自然語言規劃上的基準

一、結論寫在前面

論文來自Google DeepMind。

論文標題:NATURAL PLAN: Benchmarking LLMs on Natural Language Planning

論文鏈接:??https://arxiv.org/pdf/2406.04520??

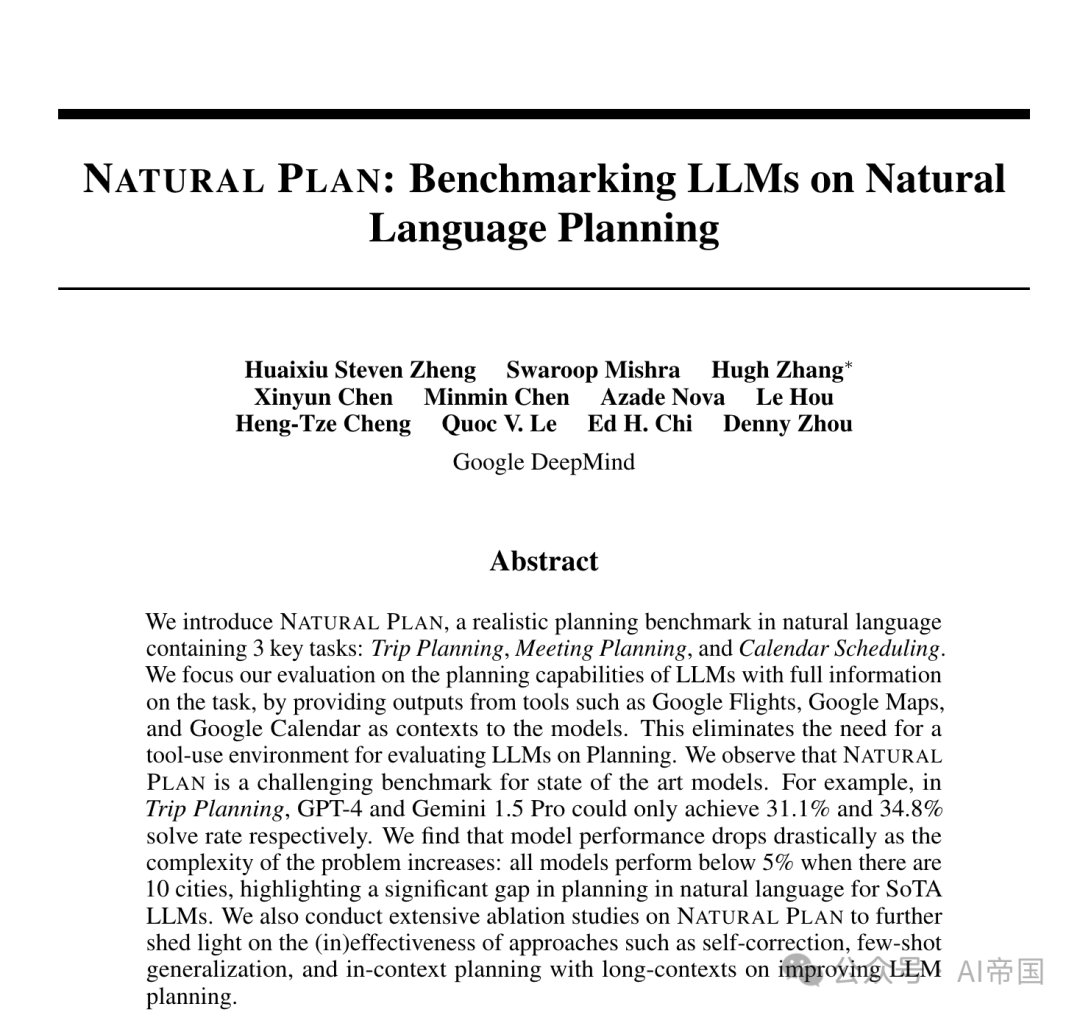

論文提出了NATURAL PLAN,一個包含三個關鍵任務(旅行規劃、會議規劃和日歷調度)的自然語言現實規劃基準。論文的評估重點在于LLMs在完全了解任務情況下的規劃能力,通過提供來自Google Flights、Google Maps和Google Calendar等工具的輸出作為模型的上下文。

這消除了在規劃方面評估LLMs時對工具使用環境的需要。論文觀察到,NATURAL PLAN對當前最先進模型來說是一個挑戰。例如,在旅行規劃任務中,GPT-4和Gemini 1.5 Pro分別僅能達到31.1%和34.8%的解決率。論文發現,隨著問題復雜度的增加,模型性能急劇下降:當涉及10個城市時,所有模型的表現均低于5%,凸顯了當前最先進LLMs在自然語言規劃方面存在顯著差距。

論文還對NATURAL PLAN進行了廣泛的消融研究,進一步揭示了自校正、少樣本泛化以及長上下文情境下的規劃等方法在提升LLM規劃效果上的(不)有效性。

?二、論文的簡單介紹

2.1 論文的背景?

LLM的規劃能力仍遠落后于人類表現。盡管許多近期工作旨在解決這一問題,但沒有反映真實世界應用的現實基準,難以在增強這些模型的規劃能力方面取得有意義的進展。

規劃在機器人學和具身環境中已被廣泛研究。自動化規劃算法已被廣泛應用于此類系統中,以實現規劃功能。在這些場景中,規劃涉及制定一系列行動,當執行這些行動時,可以將代理從一個特定的初始狀態帶到期望的世界狀態。這些系統通常使用規劃域描述語言(PDDL)或答案集編程(ASP)作為規劃器的底層動作語言。盡管最近的工作已經探索了LLM驅動的代理在經典規劃設置中的潛力,但規劃場景并非實際設置,并且它們通常包含模板,而非自然語言。

圖1:旅行規劃任務的示例

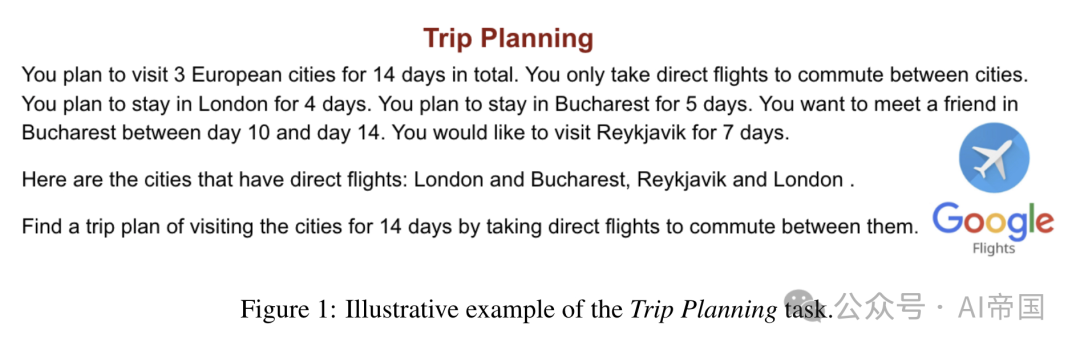

圖2:會議規劃任務的示例

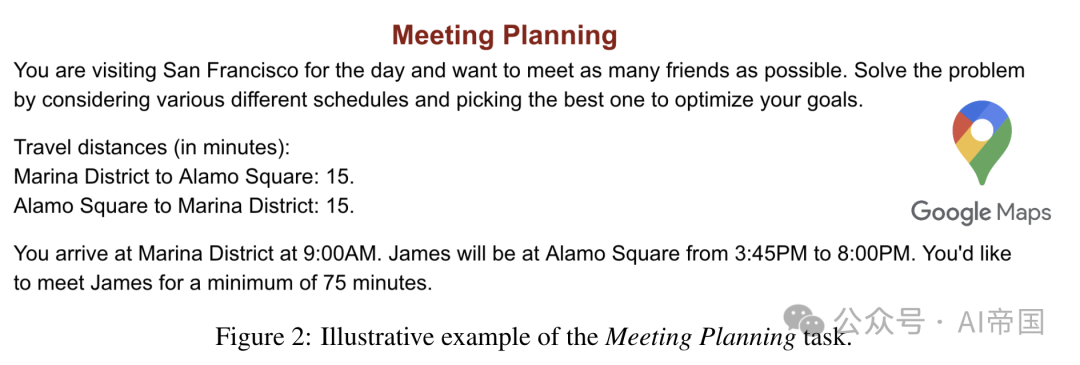

圖3:日歷安排任務的示例

論文引入了NATURAL PLAN,這是一個專為評估大型語言模型(LLMs)處理自然語言描述的規劃任務能力而設計的新基準。NATURAL PLAN包含三種不同的規劃任務,即旅行規劃、會議規劃和日歷調度。對于每項任務,論文從現有工具中收集真實信息。例如,在旅行規劃中,論文查詢Google Flights API,并提供城市間的航班連接信息作為上下文。圖1至圖3展示了這些任務及其相關的谷歌工具,這些工具提供的信息作為上下文。

2.2 論文的方法--NATURAL PLAN

NATURAL PLAN是一個旨在評估LLMs執行自然語言表達的規劃任務能力的基準。

?2.2.1 數據集類別

NATURAL PLAN包含三個規劃類別:旅行規劃、會議規劃和日歷調度。每個類別旨在捕捉涉及某些工具(如Google Flights)的真實世界規劃任務。論文將工具使用與推理任務分離,并在上下文中提供工具輸出,以確保NATURAL PLAN專注于規劃。論文相信這將顯著簡化評估LLMs規劃過程的復雜性。

2.2.1.1 旅行規劃

旅行規劃是一項任務,專注于在給定約束條件下規劃旅行行程。附錄A展示了一個示例提示及其解決方案。該任務是關于確定訪問 個城市的順序。論文添加足夠的約束條件,使得任務只有一個解決方案,從而使得對預測的評估變得直接。

個城市的順序。論文添加足夠的約束條件,使得任務只有一個解決方案,從而使得對預測的評估變得直接。

2.2.1.2 會議安排

本部分基準專注于在各種給定約束下安排會議。給定 個朋友,該任務提供了會議時間和地點。附錄A展示了一個示例問題。目標是在給定的約束條件下,盡可能多地與朋友見面,這些約束包括地點之間的旅行時間。

個朋友,該任務提供了會議時間和地點。附錄A展示了一個示例問題。目標是在給定的約束條件下,盡可能多地與朋友見面,這些約束包括地點之間的旅行時間。

2.2.1.3 日歷調度

日歷調度是一項任務,專注于在多人之間根據現有日程和各種約束條件安排工作會面。論文通過改變參與會議的人數和工作的天數來調整任務難度。附錄A展示了一個示例問題。

2.2.2 數據集構建

論文通過使用相應的工具數據并創建各種約束條件,人工合成了NATURAL PLAN數據集。下面描述了每類任務的具體創建過程。

2.2.2.1 旅行規劃?

論文創建數據集的方式如下:為了創建一個問題,論文從歐洲訪問量最大的48個城市中隨機抽取

個城市。論文還隨機抽取總持續時間和在每個城市停留的天數,設為 。論文在行程中添加約束條件,要求在特定日期訪問某些城市,例如在旅行中的第3天到第5天在巴黎與朋友見面。作為一個全局約束,論文增加了只使用直飛航班在城市間通行的偏好,排除了如果沒有從

。論文在行程中添加約束條件,要求在特定日期訪問某些城市,例如在旅行中的第3天到第5天在巴黎與朋友見面。作為一個全局約束,論文增加了只使用直飛航班在城市間通行的偏好,排除了如果沒有從 到

到 的直飛航班,就不能在訪問

的直飛航班,就不能在訪問 后訪問

后訪問 的可能性。為了幫助LLM理解連通性約束,論文查詢Google Flights API,并在上下文中提供城市之間的航班連通性信息。

的可能性。為了幫助LLM理解連通性約束,論文查詢Google Flights API,并在上下文中提供城市之間的航班連通性信息。

2.2.2.2 會議規劃

對于此數據集類別,論文隨機抽樣人員姓名以安排會議,并相應地抽樣地點。論文還抽樣時間框架,顯示人員的可用性。論文增加了約束條件,例如您將在舊金山訪問一天。在此設置中,目標是要盡可能多地會見朋友。為了使問題更加真實,時間約束/地點遵循現實世界的地點。旅行距離通過查詢Google地圖API的駕駛時間來估算。

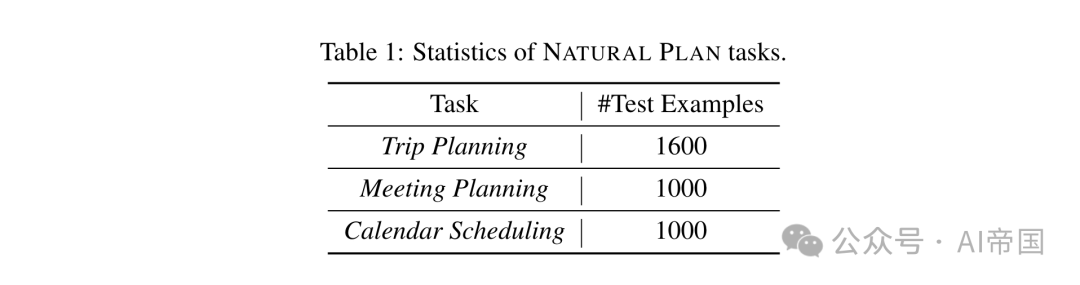

表1:NATURAL PLAN任務的統計數據

2.2.2.3 日歷調度

數據集的這一部分包括在多個工作日中安排30分鐘或1小時會議的任務,涉及不同數量的與會者。論文實例化了兩個子集:第一個子集固定會議在特定的一天,例如星期一,同時變化與會者的數量在[2, 7]之間;第二個子集固定與會者數量為2,同時變化會議可以安排的工作日數量為1, 5。每個參與會議的人都有他們當天的現有會議安排(第一個子集)或一周(第二個子集),這是通過向每天添加隨機的30分鐘會議直到n小時的會議時間被填滿來創建的。

論文隨機為每個與會者分配n,以確保一半的與會者有繁忙的日程,意味著他們超過一半的工作時間用于會議,而另一半有較輕的日程,不到一半的工作時間用于會議。每個與會者的連續會議被合并成一個單獨的塊,如圖3所示。一旦論文有了所有與會者的現有日程,論文添加兩種類型的約束:1) 最早可用性;2) 避免在特定時間段內開會,以確保問題有一個單一的解決方案。

2.2.3 統計數據

表1展示了NATURAL PLAN中涉及的行程規劃、會議規劃和日歷調度等多個任務的統計數據。

?2.3 論文的效果

論文進行了一系列實驗,以評估當前最先進的語言模型(LMs)在NATURAL PLAN中規劃任務的表現。

2.3.1 模型

論文實驗了多個頂尖的LLMs:GPT-4(gpt-4-turbo-2024-04-09),GPT-3.5(gpt-3.5-turbo-0125),GPT-4o(gpt-4o-2024-05-13),以及Gemini 1.5 Flash和Pro 。

2.3.2 設置?

少量示例學習 對于NATURAL PLAN中的每個任務,論文提供5個同一任務內的示例作為少量示例,以使LLM通過上下文學習[Brown et al., 2020]從這些示例中學習。此設置還確保輸出可以輕松解析以進行評分。

約束復雜性理解 為了更好地理解LLMs的規劃能力,論文通過控制變量改變每個任務的難度級別。論文通過改變約束條件(如人數、城市數、天數等)進行分析,以更好地理解模型在規劃任務復雜性變化中的行為。

少量示例泛化 論文通過分別提供簡單和困難示例作為上下文示例,進行由易到難和由難到易的泛化研究。例如,在行程規劃中,對于由易到難(由難到易)的泛化,論文提供5個比評估任務實例少(多)2個城市更簡單(困難)的示例。

自我修正 論文評估模型是否能在NATURAL PLAN中各種任務類別中自我修正其錯誤。論文提示模型識別是否存在任何錯誤,并在必要時進行自我修正。

長上下文中的上下文規劃 論文評估模型如何利用長上下文能力進行規劃中的上下文學習。論文將測試集分為80%和20%,其中80%用作上下文示例,同時論文在20%的測試集上評估模型性能。論文將使用的少量示例數量增加到800個。

評估 論文解析LLM的輸出,并與黃金計劃進行比較。論文計算LLM生成的計劃與黃金計劃完全匹配(EM)的分數。

2.3.3 結果與分析

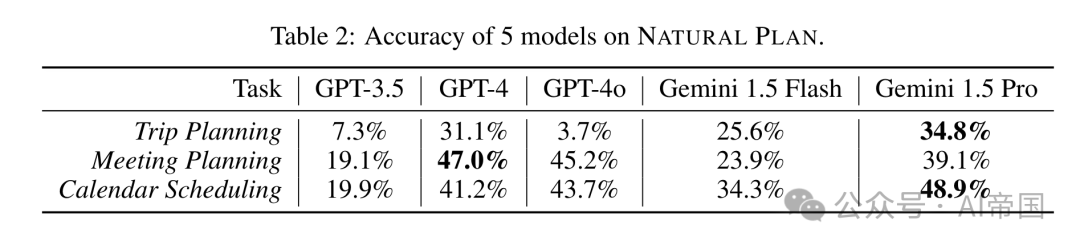

表2:5種模型在NATURAL PLAN上的準確性

2.3.3.1 結果

表2展示了在5次嘗試設置中,各種LLM在NATURAL PLAN任務中的表現。論文從結果中得出以下見解。

所有模型在NATURAL PLAN上的表現都不佳。Gemini 1.5 Pro在旅行規劃和日歷調度上表現最佳,而GPT-4在會議規劃上表現最佳。

在旅行規劃中,Gemini 1.5 Pro達到34.8%的準確性,而GPT-4為31.1%。特別是,論文觀察到GPT-4o僅為3.7%。進一步分析顯示,GPT-4o在理解和遵守航班連接和旅行日期限制方面遇到困難,更多詳細分析見附錄D。在會議規劃上,GPT-4和GPT-4o分別達到47%和45.29%的準確性,而Gemini 1.5 Pro為39.1%。對于日歷調度,Gemini 1.5 Pro以48.9%的準確性超過了GPT-4和GPT-4o。

在NATURAL PLAN的三個任務中,旅行計劃是其中最難的,最佳準確率僅為34.8%。值得注意的是,所有模型在這三個任務上的準確率均未超過50%,這表明即使所有必要的工具使用信息都已在上下文中提供,自然語言規劃對于最先進模型來說仍然是一個極具挑戰性的任務。

2.3.3.2 約束復雜性

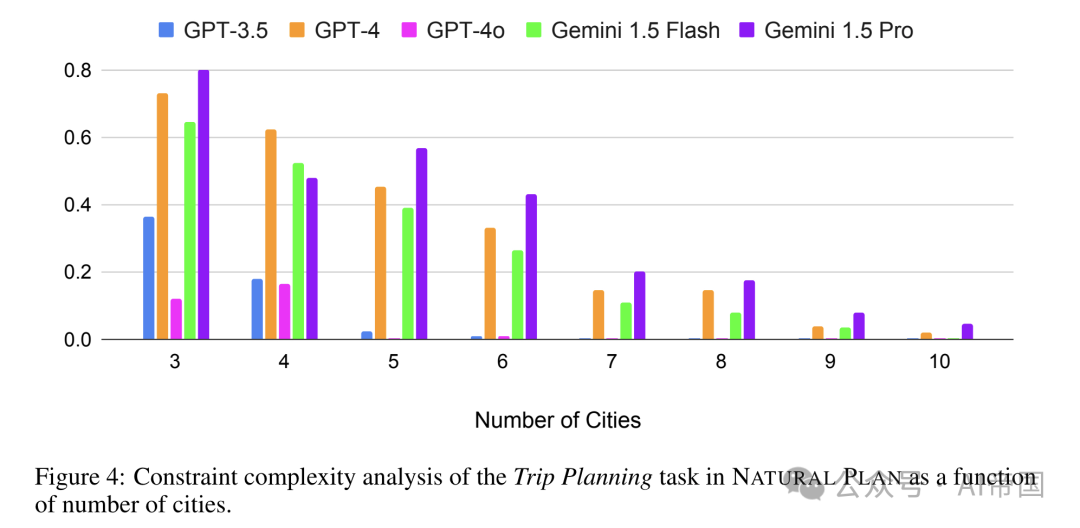

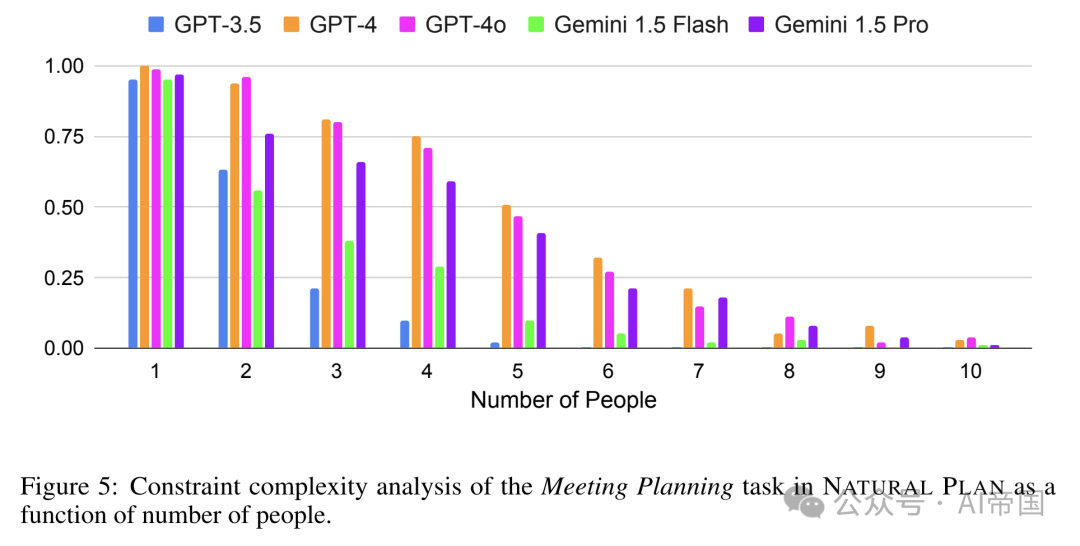

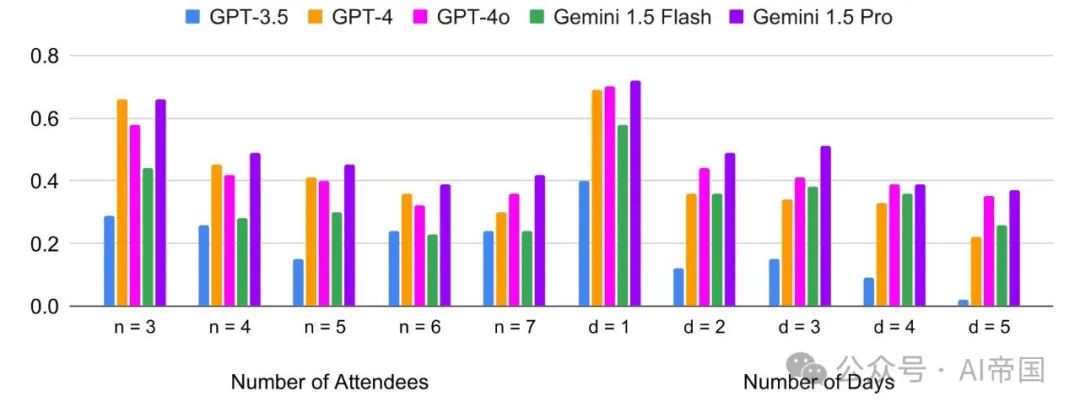

圖4至圖6展示了模型在旅行計劃中城市數量、會議安排中人數、日歷安排中參與者和天數變化下的性能變化。論文觀察到以下關鍵見解:

圖5:NATURAL PLAN中會議規劃任務的約束復雜性分析,作為人數的函數

圖6:日歷調度任務的約束復雜性分析,作為一天內涉及的人數(左)和兩個與會者之間選擇會議時間的工作日數量(右)的函數

隨著城市/人數/與會者/天數的增加,性能下降。對于旅行規劃,圖4顯示,當規劃中涉及更多城市時,模型開始失敗。在旅行規劃中,所有五個模型在涉及10個城市時,性能都低于5%。對于會議規劃,論文評估了從1到10的人數場景。圖S再次顯示,隨著需要會見的人數增加,性能急劇下降。超過8人后,所有模型的得分都低于10%。對于日歷調度,與其他兩個任務相比,增加與會者或天數時,準確性的下降并不顯著。

2.3.3.3 泛化分析

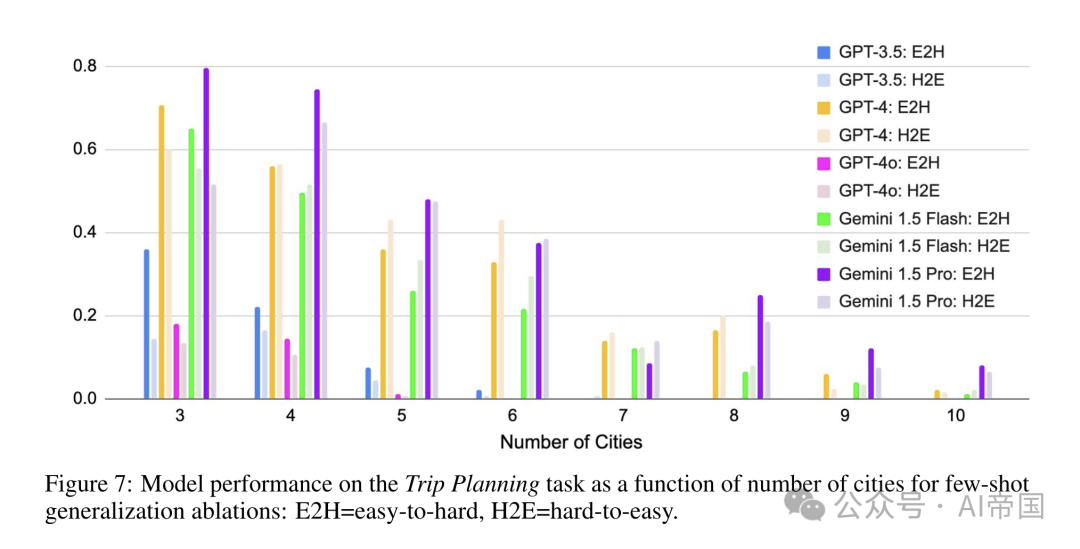

圖7:模型在旅行規劃任務上的性能,作為城市數量對少數鏡頭泛化消融的影響函數:E2H=從易到難,H2E=從難到易

圖7展示了論文對從易到難和從難到易泛化實驗的總結。對于從易到難(從難到易)泛化,論文提供了5個更簡單(更難)的例子,這些例子比任務少2個(多2個)城市,以測試大型語言模型(LLMs)是否能從更簡單(更難)的上下文學習示例中泛化。論文選擇旅行規劃任務來進行消融研究,因為它是自然規劃任務中最困難的任務。

總體而言,論文觀察到從易到難的泛化效果優于從難到易的泛化,跨越了不同的模型家族。第4.2節顯示,當任務復雜度較高時,模型的表現更差。這一結果表明,即使是對于最先進的LLMs,理解和利用上下文學習中的困難示例仍然具有挑戰性。然而,論文確實觀察到,對于GPT-4和Gemini 1.5 Flash,隨著任務復雜度的增加,趨勢發生了逆轉:對于

到8,從難到易的示例比從易到難的示例表現更好。

到8,從難到易的示例比從易到難的示例表現更好。

2.3.3.4 自我修正

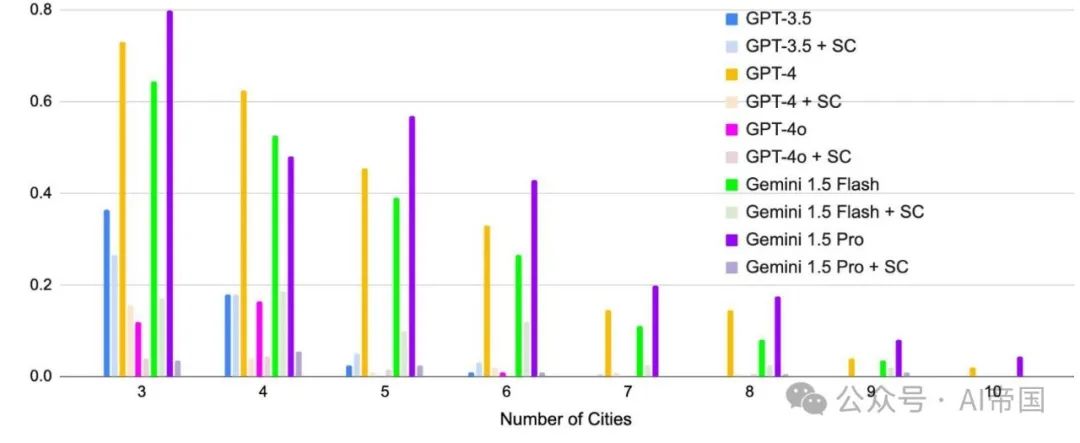

圖8:自我修正消融實驗中,行程規劃準確率隨城市數量的變化。SC=自我修正

圖8展示了在行程規劃任務中對模型預測進行自我修正的結果。論文提示大型語言模型(LLM)檢查生成的計劃是否正確,如果判定為不正確,則修正計劃(見附錄B中的提示)。

自我修正導致所有模型性能顯著下降。有趣的是,如GPT-4和Gemini 1.5 Pro這樣的更強模型相比GPT-3.5遭受了更大的損失。如GPT-4和Gemini 1.5 Pro這樣的更強模型相比GPT-3.5遭受了更大的損失。這與先前發現自我修正可能導致推理任務性能下降的研究結果一致[Huang et al., 2023]。像GPT-4和Gemini 1.5 Pro這樣的經過指令調優的強模型可能在被提示時對自己的解決方案過于自信,自我修正的示例見附錄E。

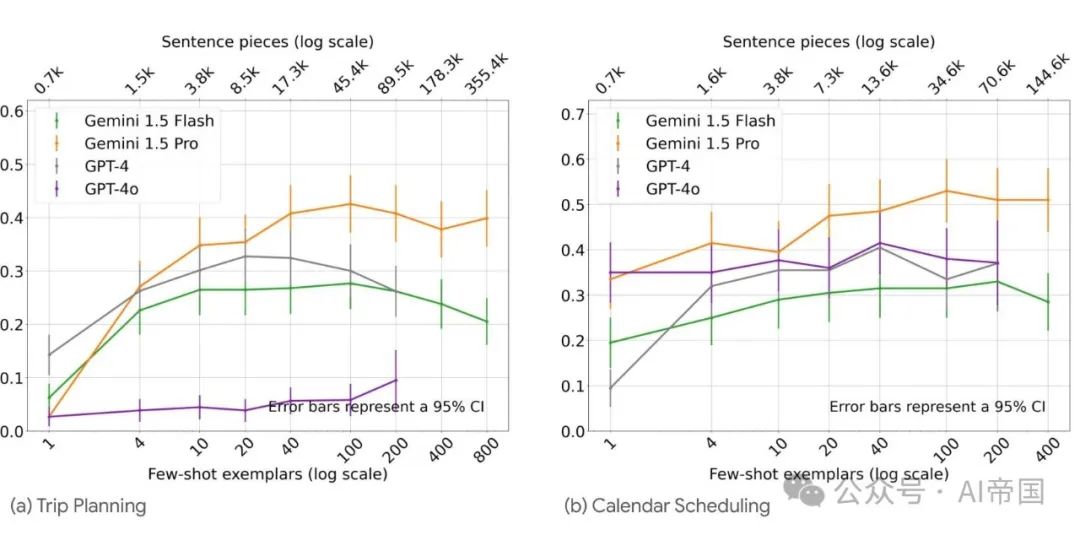

2.3.3.5 長上下文情景下的即時規劃

圖9 展示了在旅行規劃和日歷調度任務中利用長上下文進行情境規劃的情況。Gemini 1.5 Pro在規劃任務上展現出強大的長上下文學習能力,相較于其他模型表現更優

論文研究了通過利用近期模型的長上下文能力進行情境規劃的可能性。圖9展示了四種模型在最多800個示例下的性能。

由于強大的長上下文能力,Gemini Pro 1.5能夠利用多達35.5萬個上下文示例,并持續顯示出穩定的改進。例如,在旅行規劃中,將示例數量從1增加到800,Gemini Pro 1.5的準確率從2.7%提升至39.9%。與此同時,GPT-4和Gemini 1.5 Flash在20個示例時達到性能峰值,并開始出現性能下降。在日歷調度任務中,Gemini 1.5 Pro持續改進至400個示例。這些結果展示了情境規劃的潛力,其中長上下文能力使得大型語言模型能夠利用更廣泛的上下文來提升規劃能力。

本文轉載自 ??AI帝國??,作者: 無影寺