Nature: LLM變得越來越像大腦

?哥倫比亞大學和范斯坦醫學研究所學者最近研究了 LLM 與腦神經反應的相似性。

目的與發現

研究的目的是確定最新的 LLM 是否與人腦表現出相似之處,有可能提高對LLM和大腦的理解,尤其在理解和生成語言方面。

研究結果發表在《自然機器智能》上【文獻1】,表明隨著 LLM 越來越先進,不僅性能更高,也變得更像大腦。

研究方法

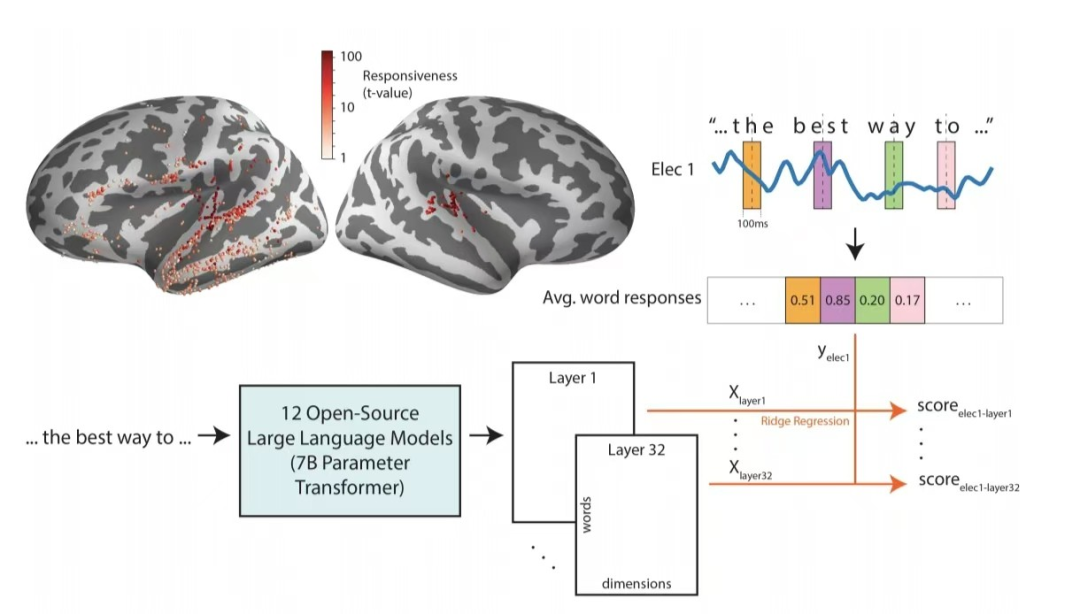

研究人員通過植入神經外科患者大腦的電極記錄了他們在聽語音時的腦神經反應。

并將同一語音的文本提供給 LLM 并提取其嵌入Embedding,嵌入本質上是 LLM 不同層編碼和處理文本的內部表征。

隨后,通過從單詞嵌入來預測腦神經對單詞的反應,這個詞嵌入中預測大腦反應的能力,可用來估計LLM與大腦的相似性。

學者比較了具有幾乎相同的架構和相似參數量的 12 種不同開源模型,探索每個 LLM 的哪些層與語言處理中涉及的大腦區域表現出最大的對應關系。

結論與含義

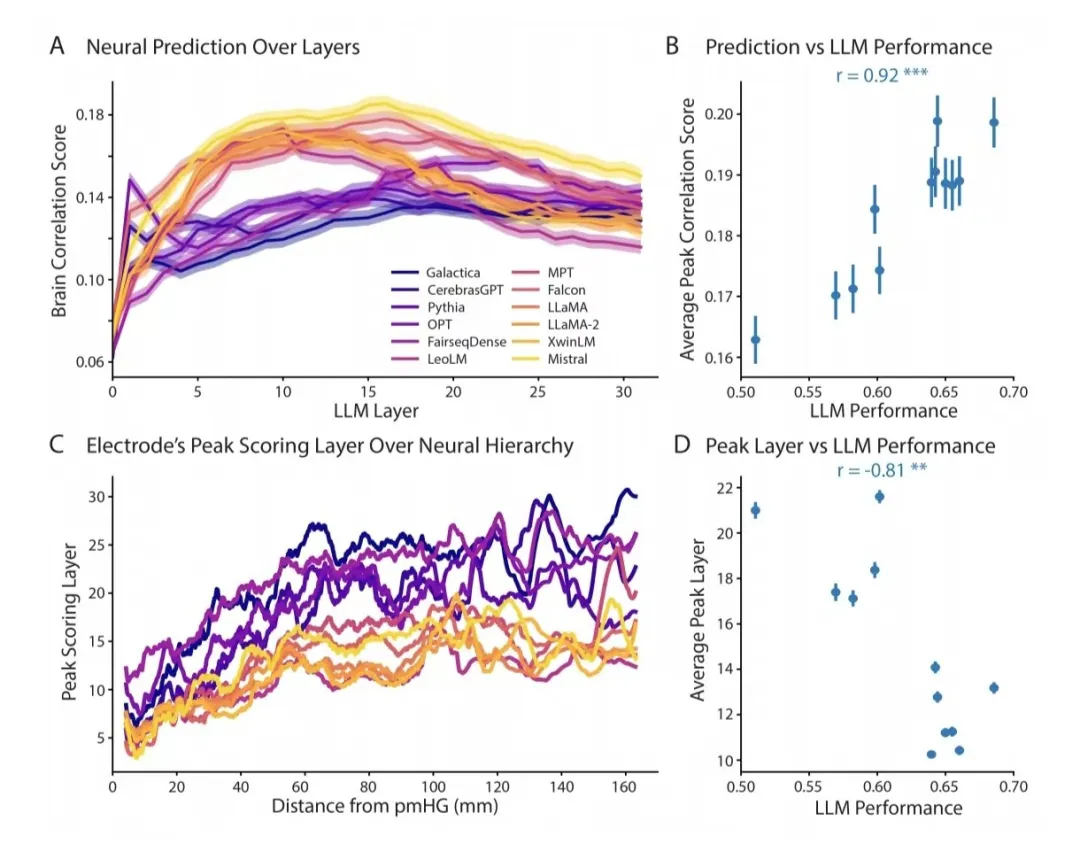

隨著 LLM 變得越來越強大,其嵌入變得更加類似于大腦對語言的神經反應,與大腦層次結構的一致性也在增加。

意味著在語言處理過程中,在連續的大腦區域中提取的信息量和類型,與性能最高的 LLM 的連續層提取的信息比低性能的 LLM 更一致。

該發現具有多種含義,其一是 LLM 架構和訓練的方法正引領LLM朝著與人腦相同的原則發展。

作者闡明“無論是因為一些基本原則是理解語言的最有效方法,還是僅僅出于偶然,似乎自然系統和人工系統在朝著相似的語言處理方法靠攏。”

大腦知覺原理

??GPT4技術原理五:大模型的幻覺,解鈴還須系鈴人 ??筆者整理過 Friston的大腦知覺原理:

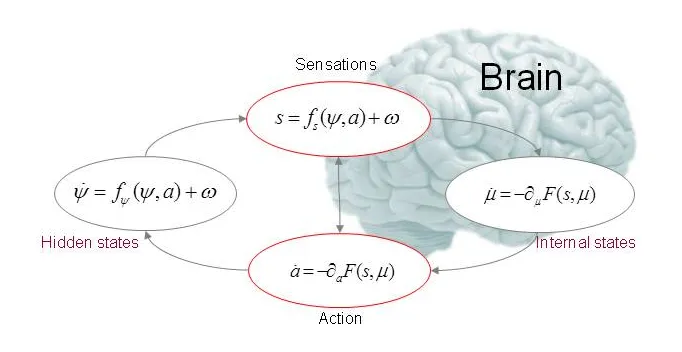

Friston假設大腦構建了一個世界模型,其中先驗的“信念”用以指導概率推理:從大腦接收的感官輸入中,推斷出其外部原因。

將“先驗”與新的感官輸入相結合,產生感知,是大腦對內外部兩個信息源的整合,并按其相對精度進行加權。其數學形式如下:

F(s,u) = - log(p(s|m)) + Dkl [ q(Φ|u) || p(Φ|s,m) ] ,式中,m 代表外部客觀世界,u 是大腦內部建構的世界模型,s 是感官輸入,Φ是m的參數,也是大腦需要推測的導致s 的原因,F 是這一感知過程的自由能。

這就是著名的貝葉斯大腦:

LLM認知框架

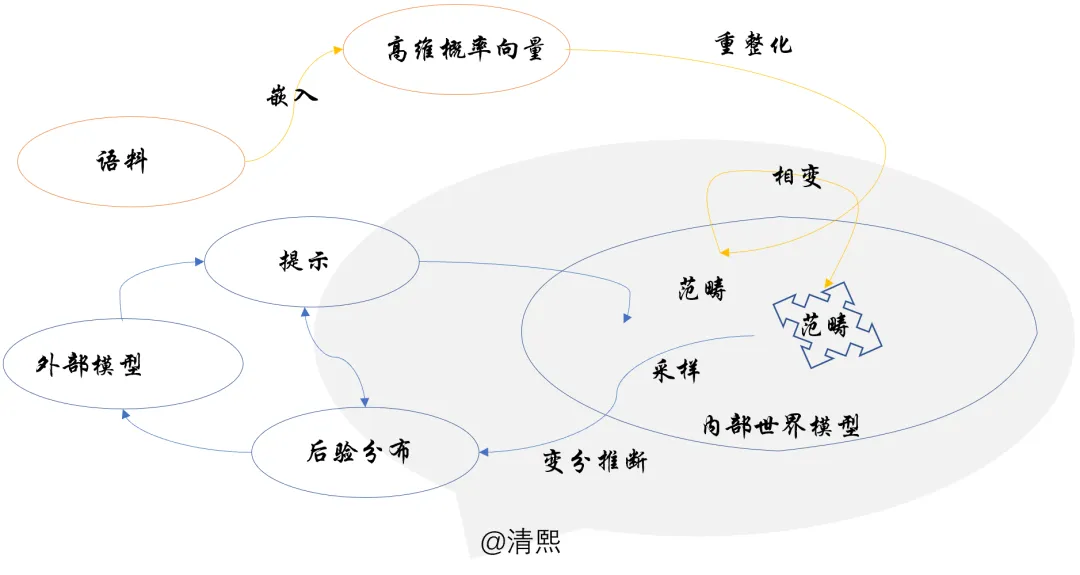

Friston的大腦知覺原理與筆者梳理出來LLM數理認知框架相輔相成:LLM通過重整化感知,范疇構成內部世界模型,變分推斷做推理。

LLM認知框架十分接近Friston 的貝葉斯大腦,與學者們的研究結論“自然系統和人工系統在朝著相似的語言處理方法靠攏”亦吻合。

文獻1:Contextual Feature Extraction Hierarchies Converge in Large Language Models and the Brain https://www.nature.com/articles/s42256-024-00925-4

預印本:https://arxiv.org/abs/2401.17671

代碼:https://doi.org/10.24433/CO.0003780.v1

本文轉載自 ??清熙??,作者: 王慶法