視覺文本語音強強聯合!南大&騰訊優圖發布GPT-4o級別的實時視覺語音交互——VITA1.5

文章鏈接:https://arxiv.org/pdf/2501.01957

git 鏈接:https://github.com/VITA-MLLM/VITA

亮點直擊

- VITA-1.5,一種多模態大語言模型(LLM),通過精心設計的三階段訓練方法整合了視覺、語言和語音。該訓練策略逐步引入視覺和語音數據,緩解了模態沖突,同時保持了強大的多模態性能。

- 對圖像、視頻和語音理解相關的各類基準進行了廣泛評估,并將結果與開源和專有模型進行了比較。VITA-1.5展現了與領先的基于圖像/視頻的多模態大語言模型(MLLMs)相當的感知和推理能力,并在語音能力上表現出顯著提升。

總結速覽

解決的問題

當前多模態大語言模型(MLLMs)主要聚焦于視覺和文本模態的整合,而對語音在增強交互中的作用關注較少。視覺和語音模態的融合存在根本性差異,導致在視覺和語音任務中實現高性能仍是一個顯著挑戰。此外,傳統方法依賴獨立的自動語音識別(ASR)和語音合成(TTS)模塊,增加了系統復雜性和延遲。

提出的方案

提出了一種名為 VITA-1.5 的多模態大語言模型,通過精心設計的三階段訓練方法,逐步整合視覺、語言和語音模態,具體包括:

- 第一階段:訓練視覺適配器,基于視覺-語言數據(如描述性字幕和視覺問答數據)微調模型,建立視覺理解能力。

- 第二階段:引入音頻處理模塊,基于語音與轉錄配對數據訓練音頻編碼器,并通過語音問答數據微調模型,使其具備語音理解能力。

- 第三階段:訓練音頻解碼器,實現端到端語音輸出,避免使用獨立的TTS模塊,從而提升語音交互的流暢性和效率。

應用的技術

- 多模態融合:通過多階段訓練策略,逐步引入視覺和語音數據,緩解模態沖突問題。

- 視覺適配器:提升模型對圖像和視頻的感知與推理能力。

- 音頻編碼器與解碼器:實現語音輸入的高效理解及端到端語音輸出,避免依賴外部ASR和TTS模塊。

- 端到端優化:減少模塊化設計帶來的延遲,實現實時多模態交互。

達到的效果

- 在圖像、視頻和語音任務的基準測試中,VITA-1.5展現了與領先的基于圖像/視頻的多模態大語言模型相當的視覺感知和推理能力。

- 在語音任務上表現出顯著提升,支持近乎實時的視覺和語音交互。

- 實現了無需獨立ASR和TTS模塊的高效語音到語音對話功能,大幅加速了多模態響應速度,并提升了交互自然性和用戶體驗。

VITA-1.5

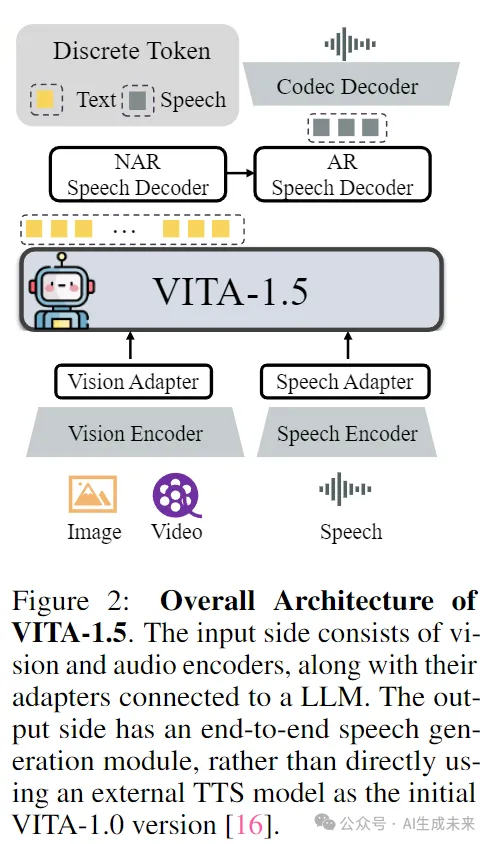

模型架構

VITA-1.5 的整體架構如圖 2 所示。

輸入端與 VITA-1.0 版本相同,即采用“多模態編碼器-適配器-LLM”的配置。它結合了視覺/音頻 Transformer 和多層連接器,與 LLM 一起進行聯合訓練,旨在增強對視覺、語言和音頻的統一理解。

在輸出端,VITA-1.5 擁有自己的端到端語音模塊,而不是像原始 VITA-1.0 版本那樣使用外部 TTS 模型。

視覺模態

視覺編碼器

VITA-1.5 采用 InternViT-300M 作為視覺編碼器,輸入圖像大小為448X448像素,每張圖像生成 256 個視覺標記(visual tokens)。對于高分辨率圖像,VITA-1.5 使用動態分塊(dynamic patching)策略來捕捉局部細節,從而提升圖像理解的準確性。

視頻處理

視頻被視為一種特殊的多圖像輸入。如果視頻長度小于 4 秒,則均勻采樣 4 幀;對于 4 到 16 秒的視頻,每秒采樣 1 幀;對于長度超過 16 秒的視頻,均勻采樣 16 幀。為了避免生成過多視覺標記而影響處理效率,視頻幀不適用動態分塊。

視覺適配器

使用兩層 MLP(多層感知機)將視覺特征映射為適合后續 LLM 理解的視覺標記。

音頻模態

語音編碼器(Speech Encoder)

類似于[56],本文的音頻編碼模塊由多個下采樣卷積層(4倍下采樣)和24個Transformer塊(隱藏層大小為1024)組成。下采樣層有助于降低音頻特征的幀率,從而提高LLM的處理速度。音頻編碼器包含約3.5億參數,輸出幀率為12.5Hz。音頻編碼器的輸入為梅爾濾波器組特征(Mel-filter bank features),其窗口大小為25ms,幀移為10ms。

語音適配器(Speech Adapter)

?語音適配器由多個帶有2倍下采樣的卷積層組成。

語音解碼器(Speech Decoder)

使用TiCodec 作為編解碼模型,定制了一個大小為1024的單碼本(single codebook)。這種單碼本設計簡化了推理階段的解碼過程。編解碼模型負責將連續的語音信號編碼為頻率為40Hz的離散語音標記(speech tokens),并同時具備將其解碼回采樣率為24,000Hz的語音信號的能力。

當前的LLM只能輸出文本標記(text tokens),而語音生成能力要求LLM能夠輸出語音標記。為此,在文本標記之后添加了兩個語音解碼器(參考[56]):

- 非自回歸(Non-Autoregressive, NAR)語音解碼器:全局處理文本token并建模語義特征,旨在生成語音token的初始分布。

- 自回歸(Autoregressive, AR)語音解碼器:基于NAR解碼器生成的語音信息,逐步生成更高質量的語音標記。

最終的語音標記序列通過Codec模型的語音解碼器被解碼為連續的語音信號流(波形)。為NAR和AR語音解碼器分別采用了4層LLaMA解碼器,其隱藏層大小為896,參數規模約為1.2億。

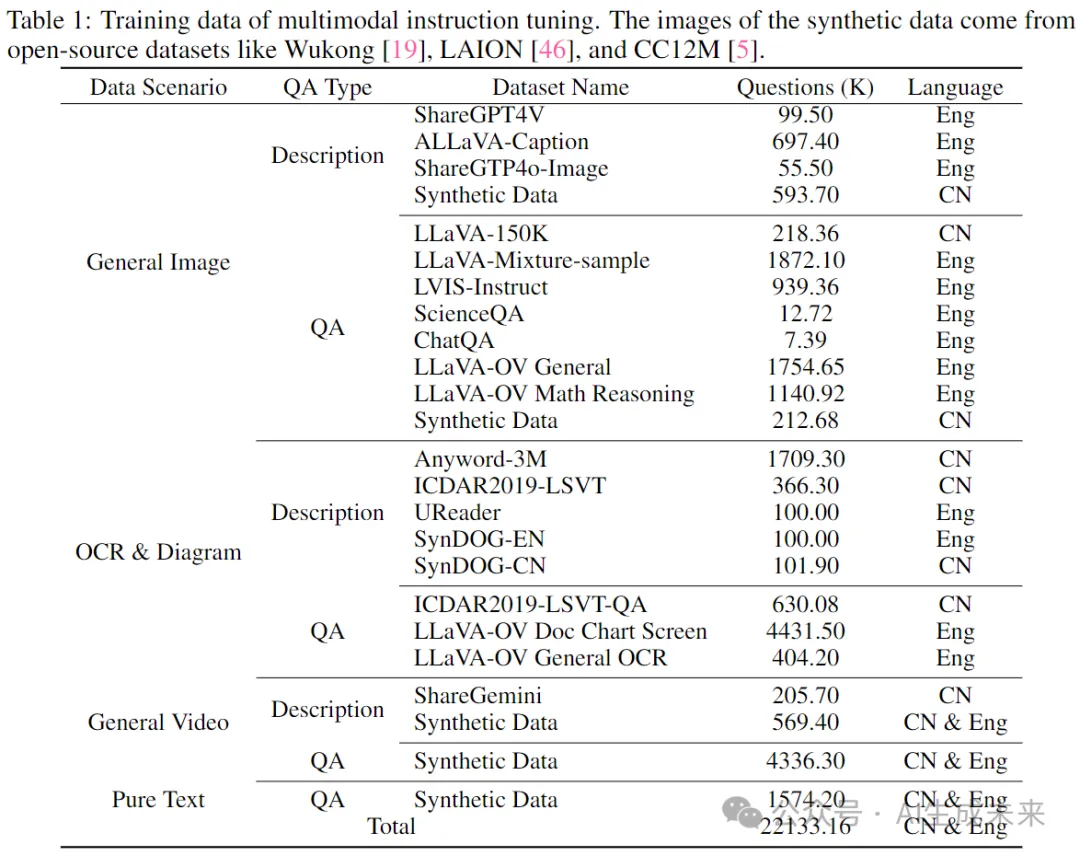

訓練數據

如表1所示,多模態指令微調的訓練數據涵蓋了廣泛的類別,例如圖像描述數據和問答(QA)數據,涉及中文和英文。在不同的訓練階段,會有選擇性地從整個數據集中抽取子集以實現不同的訓練目標。

具體來說,這些數據集被分類如下:

- 圖像描述數據:使用的數據集包括 ShareGPT4V、ALLaVA-Caption、SharedGPT4o-Image,以及合成數據,用于訓練模型生成圖像的描述性語言。

- 圖像問答數據:使用的數據集包括 LLaVA-150K、LLaVA-Mixture-sample、LVISInstruct、ScienceQA、ChatQA ,以及從 LLaVA-OV 中抽取的子集(如通用圖像問答和數學推理數據集),用于訓練模型回答基于圖像的問題并執行視覺推理任務。

- OCR和圖表數據:此類別支持模型理解OCR和圖表內容,使用的數據集包括 Anyword-3M 、ICDAR2019-LSVT 、UReader、SynDOG、ICDAR2019-LSVT-QA,以及從 LLaVA-OV 中抽取的相關數據。

- 視頻數據:使用的數據集包括 ShareGemini和合成數據,用于訓練模型處理視頻輸入并執行視頻描述和基于視頻的問答任務。

- 純文本數據:此類別增強了模型理解和生成語言的能力,以支持基于文本的問答任務。

除了表1中列出的圖像和視頻數據外,還包含了11萬小時的內部語音轉錄配對的ASR數據(涵蓋中文和英文),用于訓練音頻編碼器并將其與大語言模型(LLM)對齊。此外,還使用了3000小時由TTS系統生成的文本-語音配對數據,用于訓練語音解碼器。

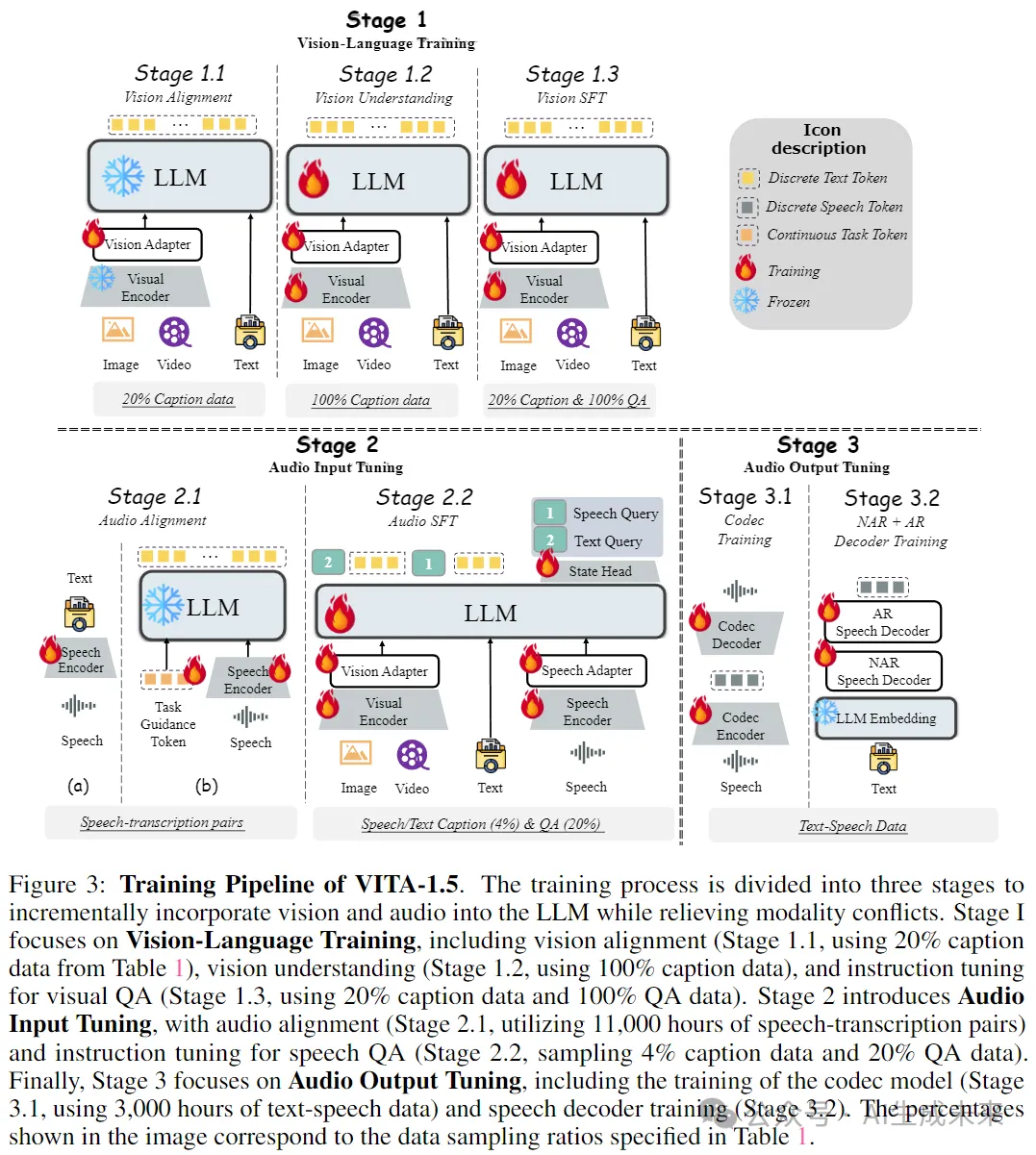

三階段訓練策略

為了確保 VITA-1.5 在視覺、語言和音頻相關任務中表現良好,必須面對一個關鍵挑戰,即不同模態之間的訓練沖突。例如,加入語音數據可能會對視覺數據的理解產生負面影響,因為語音的特征與視覺的特征存在顯著差異,這會在學習過程中引發干擾。為了解決這一挑戰,設計了一個如圖 3 所示的三階段訓練策略。核心思想是逐步將不同的模態引入模型,使其在增強新模態能力的同時,保持現有模態的能力。

Stage 1: 視覺-語言訓練

階段 1.1:視覺對齊(Vision Alignment)

階段 1.2:視覺理解(Vision Understanding)

階段 1.3:視覺微調(Vision SFT)

Stage 2: 音頻輸入微調

階段 2.1 音頻對齊 在完成階段 1 的訓練后,模型已在圖像和視頻理解方面建立了堅實的基礎。在此階段,目標是基于階段 1 的成果,減少音頻和語言之間的差異,從而使大語言模型(LLM)能夠理解音頻輸入。訓練數據包含 11,000 小時的語音-轉錄對。我們采用兩步方法:

(a) 語音編碼器訓練

采用常見語音識別系統中使用的訓練框架,利用連接時序分類(Connectionist Temporal Classification, CTC)損失函數來訓練語音編碼器。目標是讓編碼器從語音輸入中預測出轉錄文本。此步驟確保語音編碼器能夠提取語音特征并將其映射到文本表示空間。

(b) 語音適配器訓練

在完成語音編碼器的訓練后,將其與 LLM 集成,使用音頻適配器將音頻特征引入 LLM 的輸入層。在此階段的訓練目標是使 LLM 能夠輸出語音數據的轉錄文本。此外,在步驟 (b) 中,引入了特殊的可訓練輸入標記(tokens)來引導語音理解過程。這些token提供額外的上下文信息,用于指導 LLM 在問答(QA)任務中執行自動語音識別(ASR)任務。

在本階段,視覺編碼器與適配器、音頻編碼器與適配器,以及 LLM 均可訓練,旨在提升模型對多模態輸入的適應能力。此外,在 LLM 的輸出端添加了一個分類頭(classification head),用于區分輸入是來自語音還是文本。通過這一改進,模型能夠更準確地解釋語音輸入,并高效、靈活地處理不同模態的數據。

Stage 3: 音頻輸出微調

在訓練的前兩個階段,VITA-1.5模型已經有效地發展了其多模態理解能力。然而,一個關鍵能力,即語音輸出,仍然缺失,而這對于其作為交互助手的角色至關重要。為了在不影響模型基本能力的情況下引入語音輸出功能,借鑒了策略[56],使用了3,000小時的文本-語音數據,并采用了兩步訓練方法(見圖3)。

階段3.1 編解碼器訓練。 此步驟的目標是使用語音數據訓練一個具有單個碼本的編解碼器模型。編解碼器模型的編碼器能夠將語音映射為離散的標記,而解碼器可以將離散的標記映射回語音流。在VITA-1.5的推理階段,僅使用解碼器。

階段3.2 非自回歸(NAR)+自回歸(AR)解碼器訓練。 本階段的訓練使用文本-語音配對數據,其中文本被輸入到分詞器和LLM的嵌入層以獲得其嵌入向量,而語音被輸入到編解碼器模型的編碼器以獲得其語音標記。文本嵌入向量被發送到NAR語音解碼器以獲取全局語義特征,然后這些特征被發送到AR語音解碼器,后者預測相應的語音標記。注意,在此階段LLM是凍結的,因此多模態性能不會受到影響。

評估

視覺-語言評估

基準模型 比較了一系列開源的多模態大語言模型(MLLM),包括VILA-1.5、LLaVA-Next、CogVLM2、InternLM-XComposer2.5、Cambrian-1、MiniCPM-V-2.6、Ovis1.5、InternVL-Chat-1.5、InternVL-2、LLaVA-OV、Video-LLaVA、SliME和LongVA,以及5個閉源的MLLM,包括GPT-4V7、GPT-4o8、GPT-4o-mini、Gemini 1.5 Pro和Claude 3.5 Sonnet9。

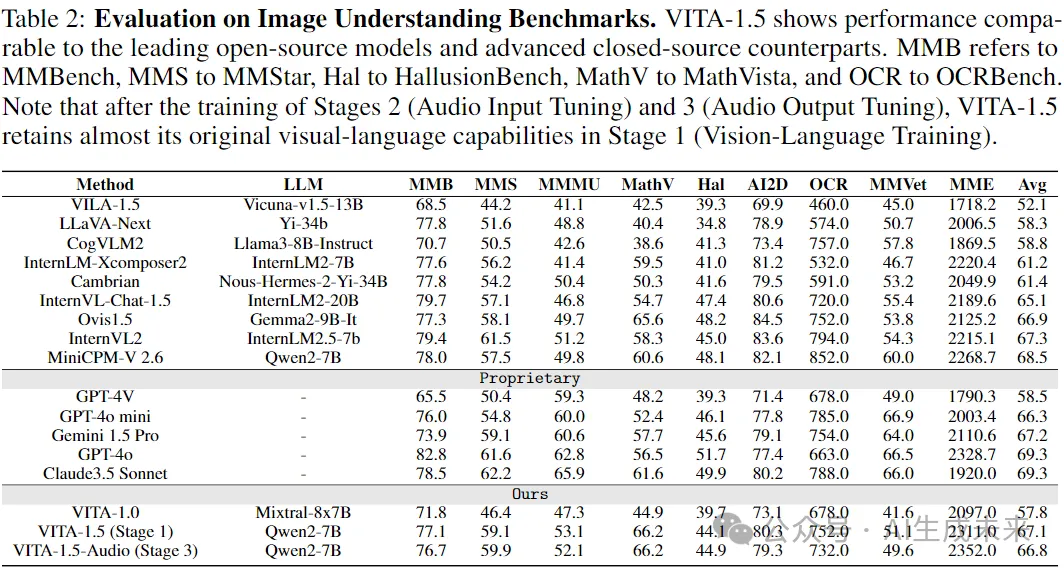

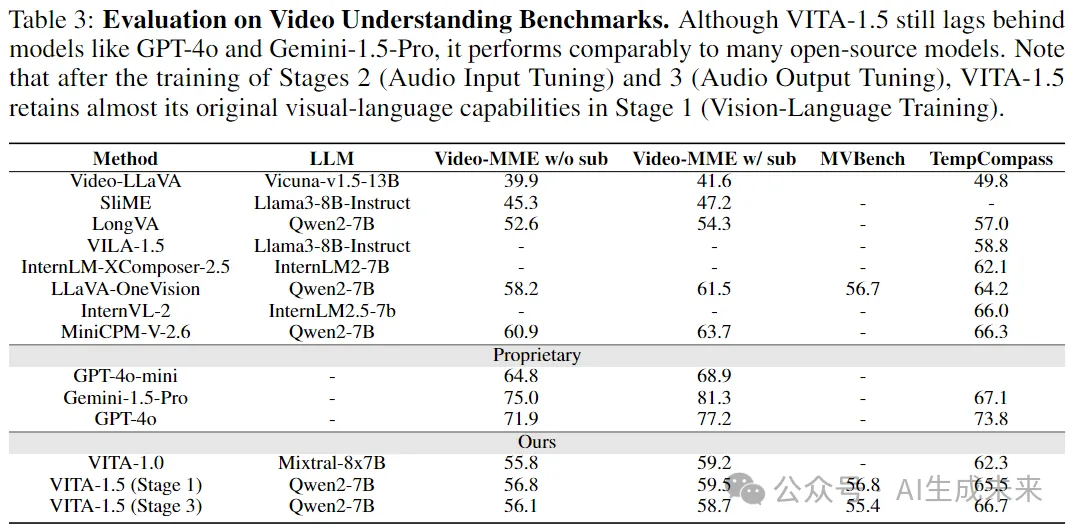

評估基準 為了評估VITA-1.5的圖像感知和理解能力,使用了多個評估基準,包括MME、MMBench、MMStar、MMMU、MathVista、HallusionBench、AI2D、OCRBench和MMVet。這些基準涵蓋了廣泛的方面,包括一般的多模態能力(例如,MME、MMBench和MMMU)、數學推理(MathVista)、幻覺檢測(HallusionBench)、圖表(AI2D)和OCR(OCRBench)理解,提供了全面的評估結果。對于視頻理解,使用了具有代表性的評估基準,包括Video-MME、MVBench和TempCompass。

視覺-語言能力 表2展示了VITA-1.5在圖像理解性能方面的比較。經過三個階段的訓練后,VITA-1.5的表現與最先進的開源模型相當,甚至超過了一些閉源模型,如GPT-4V和GPT-4o-mini。這個結果突顯了VITA-1.5在圖像-語言任務中的強大能力。如表3所示,VITA-1.5在視頻理解的評估中表現出與頂級開源模型相當的性能。與專有模型相比的顯著差距表明,VITA-1.5在視頻理解方面仍有顯著的改進空間和進一步增強的潛力。請注意,在階段2(音頻輸入調優)和階段3(音頻輸出調優)訓練后,VITA-1.5幾乎保留了其在階段1(視覺-語言訓練)中的原始視覺-語言能力。

語音評估

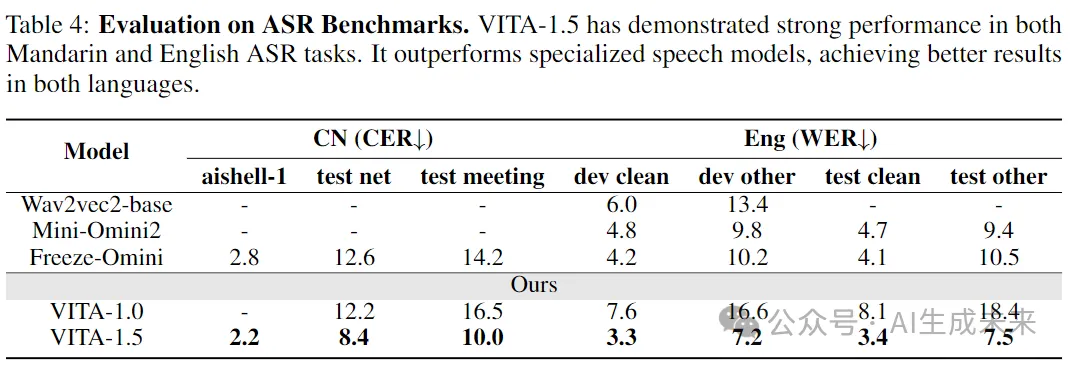

基線模型。使用以下三個基線模型進行比較:Wav2vec2-base、Mini-Omini2、Freeze-Omini和 VITA-1.0。

評估基準。 普通話評估集包括三個數據集:aishell-1、test net和 test meeting。這些數據集用于評估模型在普通話語音上的表現。評估指標是字符錯誤率(CER)。英語評估集包括四個數據集:dev-clean、dev-other、test-clean 和 test-other,用于評估模型在英語語音上的表現。評估指標是單詞錯誤率(WER)。

語音識別性能。 表 4 中的評估結果表明,VITA-1.5 在普通話和英語語音識別任務中均實現了領先的準確性。這表明 VITA-1.5 成功整合了先進的語音能力,以支持多模態交互。

結論

VITA-1.5,這是一種多模態大語言模型(LLM),通過精心設計的三階段訓練策略來整合視覺和語音。通過緩解模態間的固有沖突,VITA-1.5在視覺和語音理解方面實現了強大的能力,使得語音到語音的高效交互成為可能,而無需依賴單獨的自動語音識別(ASR)或文本到語音(TTS)模塊。廣泛的評估表明,VITA-1.5在多模態基準測試中表現出色。希望VITA-1.5能夠接過VITA-1.0的旗幟,繼續推動開源模型在實時多模態交互領域的進步。

本文轉自AI生成未來 ,作者:AI生成未來