多模型協作增強模型推理能力 原創

01、Corex Pushing the boundaries of complex reasoning through multi-model collaboration

Corex:通過多模型協作推動復雜推理的邊界

摘要:大型語言模型(LLMs)正以前所未有的速度發展,并在擁有世界知識的自然語言處理(NLP)領域展現了相當的能力。受益于超大規模的訓練語料庫,單一的LLM能夠勝任典型的NLP任務。然而,其在執行復雜任務時的表現仍受到其內部表示的局限性約束。為進一步突破這一邊界,我們引入了Corex,這是一套將LLM轉變為自主代理的新型通用策略,率先進行多代理協作以解決任務。受人類行為啟發,Corex由包括討論、審查和檢索模式在內的多種協作范式組成,共同致力于增強推理過程。這些范式促進了任務無關的方法,使基于LLM的代理能夠“跳出框框思考”,從而克服常見錯誤并提供更好的解決方案。通過對四種不同類型推理任務的大量實驗,我們證明了協調多個代理協同工作比現有的強方法能夠產生更好的結果。進一步的分析揭示了Corex的成本效益,同時探索了不同規模模型之間的協同作用,并促進了注釋效率的提高。

圖片

圖片

圖1:在使用鏈式思維提示(CoT)和程序輔助語言模型(PAL)進行推理任務時,LLMs中常見的三種錯誤。

Corex 是一種通過多模型協作來推動復雜推理能力的框架。其主要原理是將大型語言模型(LLMs)轉變為自主代理,并通過多模型協作來解決任務。Corex 的設計靈感來源于人類行為,尤其是多種認知過程的交互和合作。通過引入“討論”(Discuss)、“審查”(Review)和“檢索”(Retrieve)三種主要模式,Corex 提供了一個多模型協作的通用方法,以提升推理過程的準確性和可靠性。

Corex 的核心原理:

- 討論模式(Discuss Mode):在討論模式中,LLM 代理被隨機分為兩組,每組進行多輪討論,以細化推理鏈和預測結果。通過這種動態交互,代理可以不斷修改他們的觀點并達成共識,最終由一個裁判(Judge)評估并決定最優的答案。

- 審查模式(Review Mode):審查模式通過多輪審查和反饋來改進初始推理鏈和代碼。一個主要代理生成初步的推理鏈和預測結果,其他代理逐輪審查并提供改進意見,最終得出更為可靠的答案。

- 檢索模式(Retrieve Mode):檢索模式旨在從多個推理鏈和預測結果中選擇最符合事實的組合。檢索代理通過對比推理鏈與預測結果的一致性,評分并選擇最可靠的答案。

Corex 在多個推理任務中表現優異,尤其是在數學推理、符號推理、常識推理和半結構化推理任務中,展示了較強的性能提升。此外,Corex 還在成本效益和注釋效率方面具有顯著優勢。

這種協作方法旨在超越單一模型推理的局限,通過多模型的相互協作,解決復雜的推理任務。

圖片

圖片

圖2:Corex的直觀示意圖,展示了利用基于LLM的代理協作解決問題的過程。策略包括討論、審查和檢索模式,利用推理過程和代碼生成。該框架促進了模型之間的互動,營造出一個協作環境,以得出一個經過充分推理的答案。

使用 Corex 框架的具體例子:

任務:假設我們有一個數學推理問題:

“Vincent 買了 10 本關于動物的書,1 本關于外太空的書,3 本關于火車的書。每本書的價格是 16 美元。Vincent 總共花了多少錢?”

我們可以使用 Corex 的三個模式來處理這個問題。

- 討論模式(Discuss Mode)

在討論模式下,多個 LLM 代理被分為兩組,每組進行討論以推導出答案。

- 第一輪討論:

- 代理1:Vincent 總共買了 14 本書(10 + 1 + 3),所以他花了 14 16 = 224 美元。

- 代理2:Vincent 買了 10 + 1 + 3 = 14 本書,花費了 224 美元。

兩個代理都同意答案是 224 美元。

- 第二輪討論:

- 代理3:Vincent 買了 14 本書,所以花了 14 16 = 224 美元。

- 代理4:Vincent 買了 14 本書,花費了 224 美元。

兩組的答案一致,討論結束,裁判代理確認最終答案為 224 美元。

- 審查模式(Review Mode)

在審查模式下,一個代理生成初始答案,其他代理對其進行審查和改進。

- 初始代理生成答案:

- 代理1:計算總價為 14 16 = 224 美元。

- 審查代理檢查答案:

- 代理2:檢查發現計算是正確的,沒有錯誤。

- 代理3:再次檢查并確認 224 美元是正確的答案。

最終,經過審查的答案仍然是 224 美元。

- 檢索模式(Retrieve Mode)

在檢索模式下,多個代理獨立生成答案,然后由檢索代理選擇最可靠的答案。

- 代理們獨立生成答案:

- 代理1:14 16 = 224 美元。

- 代理2:計算錯誤,給出了 160 美元的錯誤答案。

- 代理3:正確計算出 224 美元。

- 代理4:再次計算出正確的 224 美元。

- 檢索代理選擇最可靠的答案:

- 檢索代理分析所有答案,發現代理1和代理3的答案一致且正確,因此選擇 224 美元作為最終答案。

通過這些模式的協同工作,Corex 框架能夠有效地減少錯誤并提升答案的可靠性。即使某個代理給出了錯誤的答案,其他代理通過討論、審查和檢索可以糾正這些錯誤,確保最終的答案是正確的。

Sun Q, Yin Z, Li X, et al. Corex: Pushing the boundaries of complex reasoning through multi-model collaboration[J]. arXiv preprint arXiv:2310.00280, 2023.

Shark-NLP, Shanghai AI Laboratory

Fudan University

National University of Singapore

East China Normal University

The University of Hong Kong

————————————————————————————————————

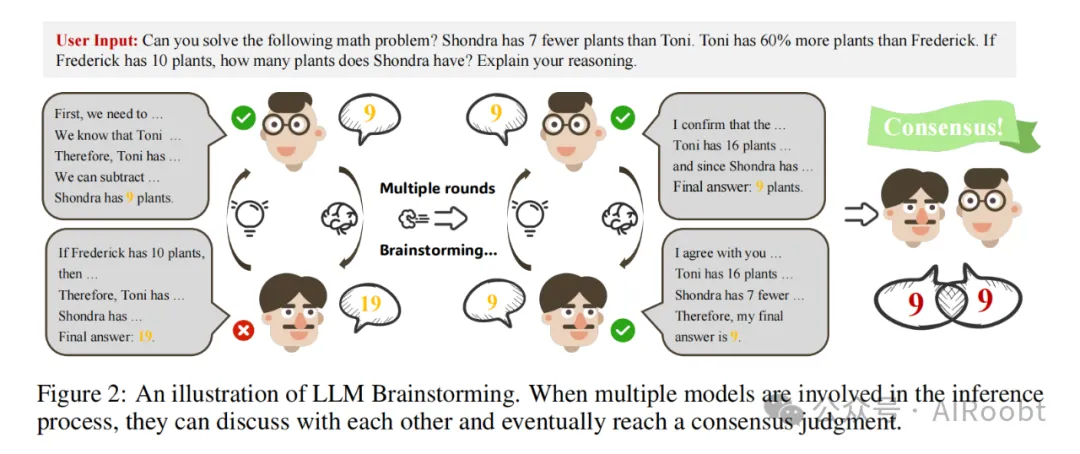

02、Brainstorming Brings Power to Large Language Models of Knowledge Reasoning

頭腦風暴為大型語言模型的知識推理賦能

摘要:大型語言模型(LLMs)在語言生成、文本理解和知識推理方面展現了驚人的能力。雖然單一強大的模型已經能夠處理多種任務,但依賴單一視角可能導致結果的偏差和不穩定。最近的研究通過引入多模型協作進一步提升了模型在廣泛任務上的推理能力。然而,不同能力的模型可能會在同一問題上產生沖突的答案,如何合理地從多個候選模型中獲得正確答案成為一個具有挑戰性的問題。本文提出了一種基于提示的多模型頭腦風暴方法。它將不同模型納入一個團隊進行頭腦風暴,通過多輪推理闡述和重新推理,最終在團隊內達成共識答案。我們在三種不同類型的數據集上進行了實驗,結果表明頭腦風暴顯著提升了邏輯推理和事實提取的有效性。此外,我們發現兩個小參數模型通過頭腦風暴可以達到接近大參數模型的準確性,這為大型語言模型的分布式部署提供了一種新的解決方案。

圖片

圖片

原理:

- 多模型頭腦風暴

- 核心思想:方法論的核心是利用多種異構的大型語言模型(LLMs)進行頭腦風暴。通過結合不同模型在不同語料庫上訓練所展現的多樣化優勢,提升推理表現。

- 過程:

- 首先,將問題呈現給多個模型,而不提供額外的上下文信息。

- 如果模型給出不同的答案,將其他模型的推理過程整合到下一輪的提示中。

- 這個迭代過程會持續進行,模型之間共享各自的推理,最終目標是達成共識。

- 頭腦風暴中的共識

- 達成共識:這個過程會持續進行,直到所有模型給出相同的答案,或者達到最大頭腦風暴輪數(由?

?max_brainstorming_round?? 參數定義)。 - 最終答案:如果在最大輪數后仍未達成共識,則選擇模型中最常見的答案作為最終結果。這確保了最終答案能夠反映所有模型的集體推理。

- 對話截斷策略

- 效率管理:為了管理對話長度并確保處理效率,方法論中包括了對話截斷策略。僅保留最新的幾輪對話用于進一步的頭腦風暴。

- 影響:這一策略有助于減少輸入的詞元長度,加快頭腦風暴過程,同時不影響推理的準確性。

- 整體方法

- 自動提示:與傳統的手動提示方法(如思維鏈CoT)不同,頭腦風暴方法通過利用不同模型的輸出作為其他模型的提示,減少了手動標注的需求。

- 知識交換:該方法促進了模型之間的知識交換,從而帶來更健壯和準確的推理過程。

這種方法旨在利用多個LLM的集體智慧,提升復雜推理任務中的準確性和可靠性。

圖片

圖片

例子:

假設我們有一個數學問題:"如果弗雷德里克有10株植物,托尼的植物比弗雷德里克多60%,而香卓拉比托尼少7株,香卓拉有多少株植物?"

- 第一輪頭腦風暴

- 模型A 經過推理后回答:香卓拉有 9株植物。

- 模型B 經過推理后回答:香卓拉有 19株植物。

- 模型C 經過推理后回答:香卓拉有 9株植物。

在這輪中,模型A和模型C給出的答案是相同的,但與模型B不同。

- 第二輪頭腦風暴

- 現在,模型A、B和C相互分享了它們的推理過程。例如,模型B可能得知其他兩個模型的推理步驟,并發現自己的計算有誤。

- 模型B 經過再次推理后更新答案:香卓拉有 9株植物。

- 達成共識

- 在第二輪中,所有模型都達成了一致的答案:香卓拉有 9株植物。

- 對話截斷策略

- 由于不需要保留所有輪次的對話,只保留最后一輪的推理過程,從而減少計算開銷。

- 最終答案

- 經過兩輪頭腦風暴,最終所有模型達成共識,得出一致答案:香卓拉有9株植物。

這個例子說明了如何通過多個模型的頭腦風暴,從一開始的不同答案,通過相互分享和修正推理,最終達成共識并得出正確答案。這種方法尤其在面對復雜的邏輯推理或需要精確知識的場景中,顯著提高了推理的準確性。

Qin Z, Wang C, Qin H, et al. Brainstorming Brings Power to Large Language Models of Knowledge Reasoning[J]. arXiv preprint arXiv:2406.06561, 2024.

Beijing Nomal University

————————————————————————————————————

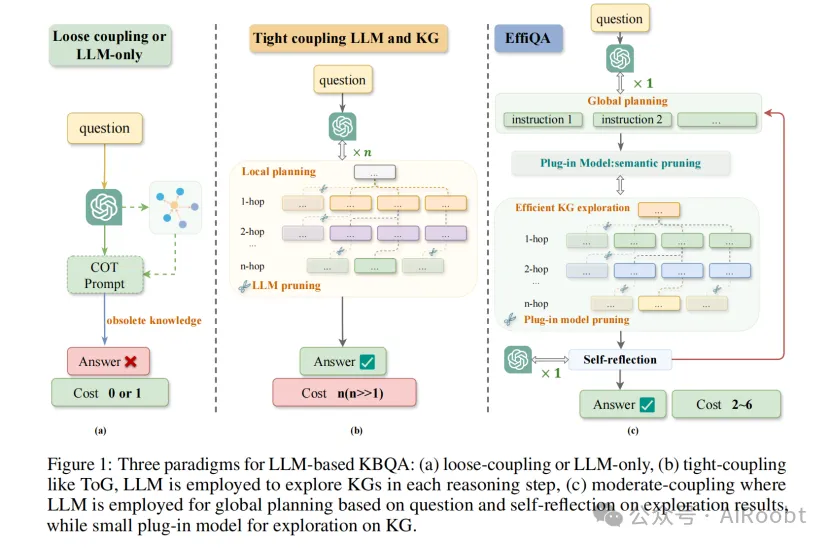

03、EffiQA Efficient Question-Answering with Strategic Multi-Model Collaboration on Knowledge Graphs

EffiQA:基于知識圖譜的多模型協作高效問答框架

摘要:盡管大型語言模型(LLM)在自然語言處理方面表現出顯著的能力,但它們在涉及知識圖譜(KG)的復雜多步推理任務中仍然表現不佳。現有的將LLM與KG結合的方法要么未能充分利用LLM的推理能力,要么由于緊密耦合導致了高昂的計算成本。為了解決這些問題,我們提出了一種名為EffiQA的新型協作框架,它通過迭代的方式在性能和效率之間取得平衡。EffiQA包括三個階段:全局規劃、有效的KG探索和自我反思。具體來說,EffiQA利用LLM的常識能力,通過全局規劃來探索潛在的推理路徑。然后,它將語義剪枝任務卸載給一個小型插件模型,以實現高效的KG探索。最后,探索結果會被反饋給LLM進行自我反思,從而進一步改進全局規劃和KG探索。多項KBQA基準測試的實驗證據表明,EffiQA在推理精度和計算成本之間實現了最佳平衡。我們希望所提出的新框架能夠通過重新定義LLM與KG的整合方式,為高效的知識密集型查詢開辟道路,并促進未來在基于知識的問答領域的研究。

圖片

圖片

原理:

EffiQA是一種新型的協作框架,旨在通過戰略性的多模型協作來提高在知識圖譜上的問答效率。該框架主要包括三個階段:全局規劃、有效的知識圖譜(KG)探索和自我反思。下面是每個階段的詳細原理:

- 全局規劃:在這個階段,大型語言模型(LLM)利用其常識能力來對問題進行分解,將其轉化為若干語義上連貫的路徑,并生成探索指令,以便在知識圖譜的結構限制之外,探索潛在的推理路徑。這一階段的目的是擴展搜索空間并識別可能的推理路徑。

- 有效的知識圖譜探索:在這一階段,通過一個小型插件模型來進行語義剪枝,從而在知識圖譜搜索過程中去除不相關的節點和路徑。該插件模型根據全局規劃階段生成的探索指令,執行廣度優先搜索和語義匹配。這個過程可以理解為在一個智能代理中使用了增強的查詢策略,該策略能夠在語義上有效剪枝并僅擴展最有希望的圖譜區域,從而顯著減少搜索空間。

- 自我反思:在完成探索之后,LLM會對探索結果進行自我反思,從而優化全局規劃和知識圖譜探索。這一階段的目標是通過反復迭代的方式,進一步改進全局規劃和探索策略,確保最終的答案既準確又有效。

通過這種迭代的方式,EffiQA能夠在提高推理準確性的同時,降低計算成本。它通過將LLM的全局指導與知識圖譜的受限語義剪枝緊密結合,實現了較為平衡的整合,從而在KBQA(基于知識庫的問答)任務中重新定義了高效知識密集型查詢的標準。

實驗結果表明,EffiQA能夠在多個基準數據集上取得較好的平衡,既提高了推理精度,也降低了計算成本。這種方法不同于以往的緊密耦合或松散耦合的方法,通過結合LLM和KG的優勢,既提升了推理性能,又改善了操作效率。

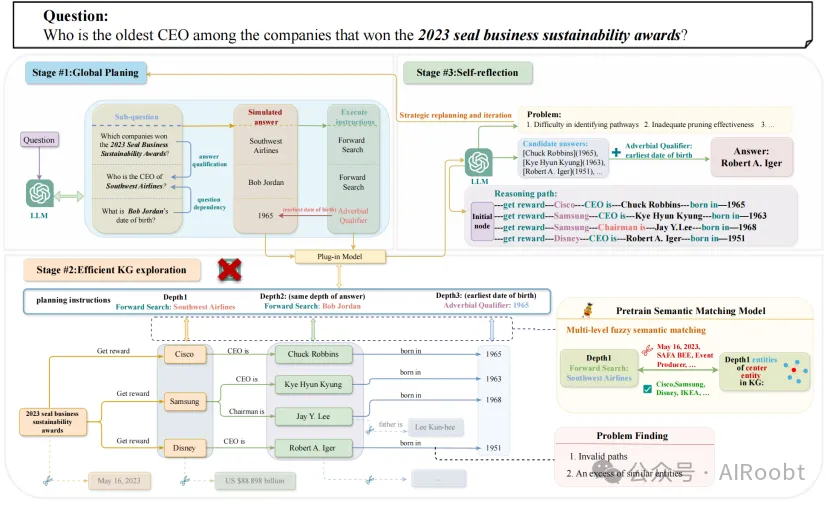

圖片

圖片

圖2:EffiQA的示例工作流程包括三個階段。在第一階段,LLM將問題分解,并根據問題的邏輯生成包含模擬答案和操作的指令。在第二階段,EffiQA使用插件模型來執行這些指令,進行高效的知識圖譜(KG)探索,并通過策略發現探索中的問題。在第三階段,LLM對探索過程中的問題進行反思,執行自我迭代的重新規劃,并在提供足夠信息后輸出答案。

一個具體的例子來說明其運作過程:

例子:假設我們想要回答一個復雜的問題:“2023年獲得Seal商業可持續性獎的公司中,哪位CEO最年長?”

- 全局規劃:

- 首先,EffiQA會使用LLM對這個問題進行分解。例如,LLM可能會將問題分解為幾個子問題:“2023年獲得Seal商業可持續性獎的公司有哪些?”、“這些公司的CEO分別是誰?”、“這些CEO的出生年份是多少?”

- LLM會生成一系列探索指令來指導后續的知識圖譜搜索,比如:“在知識圖譜中搜索與Seal獎相關的公司”,“查找這些公司的CEO信息”,“找到這些CEO的出生年份”。

- 知識圖譜探索:

- 使用插件模型(一個小型的語義剪枝模型)來在知識圖譜中執行搜索。該模型會根據LLM生成的指令,進行廣度優先搜索并進行語義剪枝。

- 插件模型可能首先找到與Seal商業可持續性獎相關的公司節點,然后繼續搜索這些公司的CEO,并進一步探索這些CEO的出生日期。

- 例如,插件模型可能發現三個CEO分別是Bob、Alice和Charlie,他們的出生年份分別是1965年、1970年和1958年。

- 自我反思:

- EffiQA會回顧探索的結果并進行反思,以優化回答流程。LLM將會檢查每一個推理路徑,以確保其與初始問題一致,并對結果進行綜合分析。

- 在這個例子中,LLM會比較發現的出生年份,最終得出結論:1965年出生的Bob Jordan是最年長的CEO。

- 如果在這一過程中出現了路徑剪枝不當或信息不足的問題,LLM會重新規劃和迭代探索,直到找到最優解。

最終答案:通過上述步驟,EffiQA最終得出答案:“在2023年獲得Seal商業可持續性獎的公司中,最年長的CEO是Bob Jordan。”

這個例子展示了EffiQA如何通過全局規劃、有效的知識圖譜探索和自我反思,逐步縮小搜索空間,并最終高效地找到準確答案的過程。

Dong Z, Peng B, Wang Y, et al. EffiQA: Efficient Question-Answering with Strategic Multi-Model Collaboration on Knowledge Graphs[J]. arXiv preprint arXiv:2406.01238, 2024.

National Key Laboratory of Parallel and Distributed Computing, College of Computer Science and Technology

National University of Denfense Technology

?

本文轉載自公眾號AIRoobt ,作者:AIRoobt

原文鏈接:????https://mp.weixin.qq.com/s/uxB7DOuCGMimQoQlZ_Pz8g???