Take a Step Back:通過(guò)抽象激發(fā)大模型推理能力(ICLR2024) 原創(chuàng)

??摘要: 我們提出了一種簡(jiǎn)單的提示技術(shù)——“退一步”提示(STEP-BACK PROMPTING),該技術(shù)能夠使大語(yǔ)言模型(LLMs)進(jìn)行抽象,從包含特定細(xì)節(jié)的實(shí)例中推導(dǎo)出高層次概念和基本原理。通過(guò)使用這些概念和原理來(lái)指導(dǎo)推理,LLMs顯著提高了沿著正確推理路徑找到解決方案的能力。我們?cè)?nbsp;PaLM-2L、GPT-4 和 Llama2-70B 模型上進(jìn)行了“退一步”提示的實(shí)驗(yàn),并在包括 STEM、知識(shí)問(wèn)答(Knowledge QA)和多跳推理(Multi-Hop Reasoning)等各種具有挑戰(zhàn)性的推理密集型任務(wù)中觀察到顯著的性能提升。例如,“退一步”提示使 PaLM-2L 在 MMLU(物理和化學(xué))上的性能分別提高了 7% 和 11%,在 TimeQA 上提高了 27%,在 MuSiQue 上提高了 7%。

1、引言

自然語(yǔ)言處理(NLP)領(lǐng)域正在經(jīng)歷一場(chǎng)由基于Transformer模型(Vaswani等,2017)的大語(yǔ)言模型(LLMs)(Devlin等,2018;Raffel等,2020;Brown等,2020;Anil等,2023)引發(fā)的革命。通過(guò)擴(kuò)大模型的規(guī)模和預(yù)訓(xùn)練語(yǔ)料庫(kù)(Hoffmann等,2022;Chowdhery等,2022),模型的能力和樣本效率得到了顯著提升,這得益于縮放定律(Kaplan等,2020;Hoffmann等,2022)的見(jiàn)解以及諸如多步推理(Wei等,2022b;Zhou等,2022)和指令跟隨(Mishra等,2022b;Wei等,2021)等新興能力。

盡管取得了這些進(jìn)展,復(fù)雜的多步推理仍然對(duì)最先進(jìn)的大語(yǔ)言模型構(gòu)成挑戰(zhàn)。Lightman等人(2023)的研究表明,通過(guò)逐步驗(yàn)證的過(guò)程監(jiān)督是一種有前景的解決方法,可以提高中間推理步驟的正確性。類(lèi)似于“思維鏈”(Chain-of-Thought, CoT)(Wei等,2022b)的方法被引入,用于生成一系列連貫的中間推理步驟,從而提高沿著正確解碼路徑的成功率。受到人類(lèi)在面對(duì)復(fù)雜任務(wù)時(shí)往往會(huì)退一步,通過(guò)抽象得出高層次原則來(lái)指導(dǎo)解決過(guò)程的啟發(fā),我們提出了“退一步”提示方法(STEP-BACK PROMPTING),通過(guò)在推理中引入抽象以減少中間步驟中的錯(cuò)誤概率。

在許多認(rèn)知技能中,抽象能力(Lachmy等,2022)是人類(lèi)處理大量信息并推導(dǎo)出一般性原則的普遍能力。例如,開(kāi)普勒將數(shù)千個(gè)觀測(cè)數(shù)據(jù)歸納為開(kāi)普勒的三大行星運(yùn)動(dòng)定律,這些定律精確描述了行星圍繞太陽(yáng)的軌道(Russell,1964)。在關(guān)鍵決策中,抽象有助于人類(lèi)獲得更廣闊的環(huán)境視角。本文研究了大語(yǔ)言模型(LLMs)如何通過(guò)抽象與推理的兩步過(guò)程來(lái)處理涉及大量低層次細(xì)節(jié)的復(fù)雜任務(wù)。第一步是通過(guò)上下文學(xué)習(xí)來(lái)引導(dǎo)LLMs“退一步”——提示它們?yōu)樘囟ㄊ纠茖?dǎo)出高層次的抽象概念和原則。第二步是利用推理能力,在這些高層次概念和原則的基礎(chǔ)上進(jìn)行推理。我們使用少樣本示例演示來(lái)在LLMs上執(zhí)行“退一步”提示方法。

我們?cè)谏婕邦I(lǐng)域特定推理的各種任務(wù)上進(jìn)行了實(shí)驗(yàn),如物理和化學(xué)、需要事實(shí)知識(shí)的知識(shí)密集型問(wèn)答、多跳常識(shí)推理。我們觀察到PaLM-2L(Anil等,2023)在這些任務(wù)上的顯著性能提升(最高達(dá)27%),這證明了“退一步”提示方法在處理復(fù)雜任務(wù)時(shí)的有效性,這些任務(wù)由于需要推理的大量細(xì)節(jié)而具有挑戰(zhàn)性。圖1總結(jié)了本文中展示的所有關(guān)鍵結(jié)果。有些任務(wù)非常具有挑戰(zhàn)性:在TimeQA和MuSiQue上,PaLM-2L和GPT-4的準(zhǔn)確率僅約為40%。鏈?zhǔn)剿季S提示在少數(shù)任務(wù)上帶來(lái)了輕微的改進(jìn),而“退一步”提示方法則在所有任務(wù)上提升了PaLM-2L的性能:在MMLU物理和化學(xué)上分別提升了7%和11%,在TimeQA上提升了27%,在MuSiQue上提升了7%。

圖 1:STEP-BACK PROMPTING 的強(qiáng)大表現(xiàn):我們提出的“抽象與推理”方案在各種具有挑戰(zhàn)性的任務(wù)中顯著提升了性能,這些任務(wù)涉及STEM、知識(shí)問(wèn)答(Knowledge QA)和多跳推理(Multi-Hop Reasoning),并且通常需要復(fù)雜(往往是多跳)的推理。

我們進(jìn)行了多種分析,發(fā)現(xiàn)“退一步”提示方法相比鏈?zhǔn)剿季S(CoT)提示(Wei等,2022b)和“深呼吸”(TDB)提示(Yang等,2023)顯著提升了性能(最高達(dá)36%)。我們進(jìn)行了定性評(píng)估,發(fā)現(xiàn)“退一步”方法修正了基礎(chǔ)模型的大部分錯(cuò)誤(最高約40%),同時(shí)只引入了少量新的錯(cuò)誤(最高約12%)。我們還進(jìn)行了錯(cuò)誤分析,發(fā)現(xiàn)“退一步”提示方法的大多數(shù)錯(cuò)誤源于LLMs推理能力的內(nèi)在限制,而抽象技能相對(duì)容易在LLMs中展現(xiàn),這為類(lèi)似“退一步”提示方法的未來(lái)改進(jìn)指明了方向。

2、退一步 PROMPTING

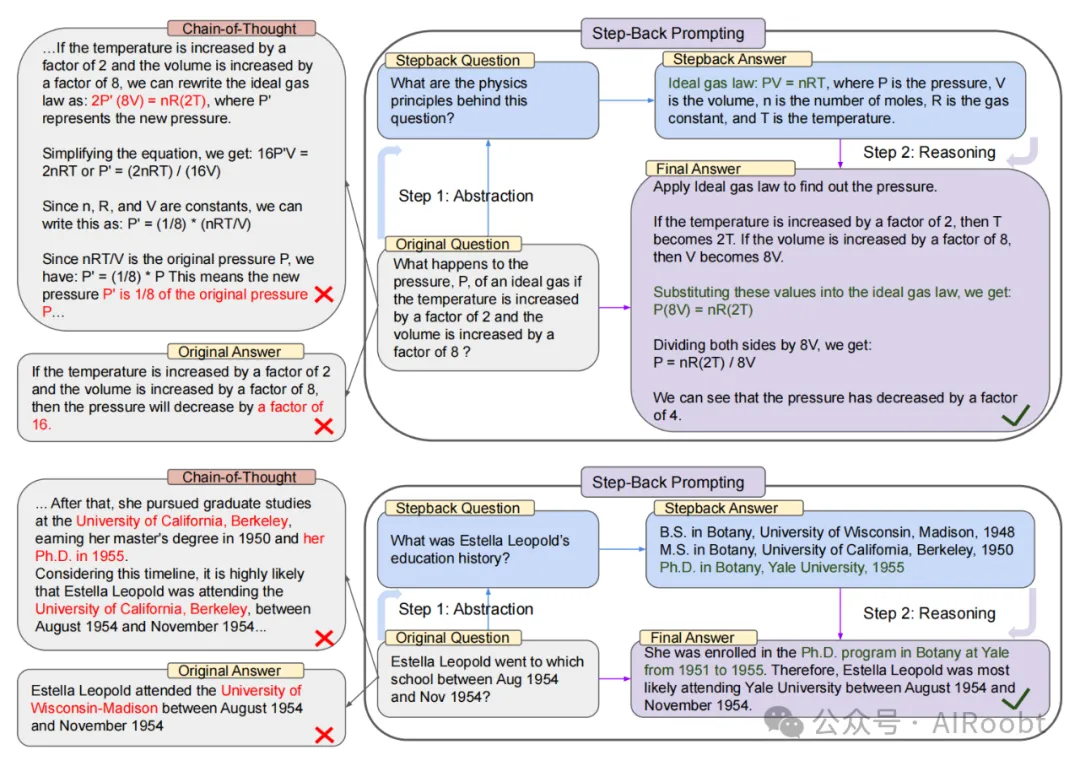

“退一步”提示方法的動(dòng)機(jī)源于這樣一個(gè)觀察:許多任務(wù)包含大量的細(xì)節(jié),而這讓大語(yǔ)言模型很難提取出相關(guān)信息來(lái)解決這些任務(wù)。如圖2頂部所示,對(duì)于一個(gè)物理問(wèn)題“如果溫度增加2倍,體積增加8倍,理想氣體的壓力P會(huì)發(fā)生什么變化?”,在直接對(duì)問(wèn)題進(jìn)行推理時(shí),大語(yǔ)言模型可能會(huì)偏離理想氣體定律的基本原理。同樣,對(duì)于“埃斯特拉·萊奧波德在1954年8月至1954年11月期間就讀于哪所學(xué)校?”這樣的問(wèn)題,由于時(shí)間范圍的具體限制,直接回答也非常困難。在這兩種情況下,提出一個(gè)“退一步”的問(wèn)題可以幫助模型更有效地解決問(wèn)題。

圖 2:展示了通過(guò)概念和原理指導(dǎo)的“退一步”提示法(STEP-BACK PROMPTING)中的抽象和推理兩個(gè)步驟。**

頂部:一個(gè)MMLU高中物理的示例(Hendrycks等,2020),通過(guò)抽象檢索到理想氣體定律的基本原理。

底部:來(lái)自TimeQA的一個(gè)示例(Chen等,2021),其中高層次的“教育背景”概念是抽象的結(jié)果。

左側(cè):PaLM-2L(Anil等,2023)未能回答原始問(wèn)題。鏈?zhǔn)剿季S提示(Chain-of-Thought Prompting,Wei等,2022b;Kojima等,2022)在中間推理步驟中出現(xiàn)錯(cuò)誤(紅色部分突出顯示)。

右側(cè):通過(guò)“退一步”提示法(STEP-BACK PROMPTING),PaLM-2L(Anil等,2023)成功回答了問(wèn)題。

我們將“退一步”問(wèn)題定義為從原始問(wèn)題中提取的、更高抽象層次上的問(wèn)題。例如,與其直接詢(xún)問(wèn)“埃斯特拉·萊奧波德在特定時(shí)間段內(nèi)就讀于哪所學(xué)校”,不如提出一個(gè)“退一步”問(wèn)題(圖2底部),例如詢(xún)問(wèn)她的“教育背景”,這是一個(gè)包含原始問(wèn)題的高層次概念。在這種情況下,回答“埃斯特拉·萊奧波德的教育背景”這一“退一步”問(wèn)題,將提供所有必要的信息來(lái)推理“她在特定時(shí)期就讀于哪所學(xué)校”。前提是“退一步”問(wèn)題通常更簡(jiǎn)單。在這種抽象基礎(chǔ)上進(jìn)行推理,有助于避免中間步驟中的推理錯(cuò)誤,例如圖2左側(cè)思維鏈(Chain-of-Thought)中的例子。簡(jiǎn)而言之,“退一步”提示方法包括兩個(gè)簡(jiǎn)單的步驟:

- 抽象:與直接回答問(wèn)題不同,我們首先提示大語(yǔ)言模型提出一個(gè)關(guān)于更高層次概念或原理的泛化的“退一步”問(wèn)題,并檢索與該高層次概念或原理相關(guān)的事實(shí)。“退一步”問(wèn)題對(duì)于每個(gè)任務(wù)都是獨(dú)特的,以便檢索最相關(guān)的事實(shí)。

- 推理:基于有關(guān)高層次概念或原理的事實(shí),大語(yǔ)言模型可以推理出原始問(wèn)題的解決方案。我們將這稱(chēng)為“基于抽象的推理”。

在接下來(lái)的章節(jié)中,我們將對(duì)一系列具有挑戰(zhàn)性的任務(wù)進(jìn)行“退一步”提示方法的實(shí)證研究,這些任務(wù)涉及復(fù)雜推理的領(lǐng)域,如STEM、知識(shí)問(wèn)答和多跳推理。

3、實(shí)驗(yàn)設(shè)置

在本節(jié)中,我們定義了實(shí)驗(yàn)中使用的任務(wù)和模型。同時(shí),我們還描述了我們的評(píng)估指標(biāo)和所考慮的基線方法。

3.1 任務(wù)

我們?cè)谝韵虏煌?lèi)型的任務(wù)上進(jìn)行實(shí)驗(yàn):(a)STEM,(b)知識(shí)問(wèn)答(Knowledge QA),以及(c)多跳推理(Multi-Hop Reasoning)。以下是我們所使用的數(shù)據(jù)集(詳細(xì)信息請(qǐng)參見(jiàn)附錄B)。

- STEM: 我們?cè)赟TEM任務(wù)中評(píng)估MMLU和GSM8K。MMLU(Hendrycks等,2020)包含一系列跨多領(lǐng)域的基準(zhǔn)測(cè)試,用于評(píng)估模型的語(yǔ)言理解能力。我們選擇了MMLU中的高中物理和化學(xué)部分,因?yàn)檫@些部分涉及深層次的推理。

(注釋?zhuān)篠TEM任務(wù)指的是涉及科學(xué)、技術(shù)、工程和數(shù)學(xué)(Science, Technology, Engineering, and Mathematics)領(lǐng)域的問(wèn)題。在自然語(yǔ)言處理和大語(yǔ)言模型的研究中,STEM任務(wù)通常用于測(cè)試模型在這些特定領(lǐng)域中的理解和推理能力。)

- 知識(shí)問(wèn)答(Knowledge QA): 我們選擇了TimeQA(Chen等,2021),因?yàn)樗枰獜?fù)雜時(shí)間敏感知識(shí)的查詢(xún)。我們還實(shí)驗(yàn)了SituatedQA(Zhang & Choi,2021),這是另一個(gè)需要模型在給定時(shí)間或地理背景下回答問(wèn)題的挑戰(zhàn)性開(kāi)放檢索問(wèn)答數(shù)據(jù)集。

- 多跳推理(Multi-Hop Reasoning): 我們使用MuSiQue(Trivedi等,2022)進(jìn)行實(shí)驗(yàn),這是一種通過(guò)組合單跳問(wèn)題對(duì)創(chuàng)建的難度較大的多跳推理數(shù)據(jù)集,還使用了包含需要策略解決的開(kāi)放域問(wèn)題的StrategyQA(Geva等,2021)。

(注釋?zhuān)憾嗵评恚∕ulti-Hop Reasoning)是一種需要模型進(jìn)行多步推理才能到達(dá)正確答案的任務(wù)類(lèi)型。在這種任務(wù)中,問(wèn)題的解答不可能通過(guò)單一的事實(shí)或信息直接獲得。相反,模型必須將多個(gè)中間步驟的推理結(jié)果綜合起來(lái),才能找到正確的答案。這通常涉及從多個(gè)信息來(lái)源或段落中收集、連接和整合相關(guān)信息,以完成一個(gè)復(fù)雜的推理過(guò)程。

問(wèn)題:"愛(ài)因斯坦在1921年獲得諾貝爾獎(jiǎng)的那一年,哪個(gè)國(guó)家是歐洲人口最多的國(guó)家?"

推理步驟:

愛(ài)因斯坦在1921年獲得諾貝爾獎(jiǎng)。

找到1921年時(shí)歐洲人口最多的國(guó)家。

確定答案為當(dāng)時(shí)的俄羅斯。

答案:"俄羅斯")

3.2 模型

我們使用了以下最先進(jìn)的大語(yǔ)言模型:經(jīng)過(guò)指令微調(diào)的PaLM-2L(Anil等,2023)、GPT-4(OpenAI,2023)和Llama2-70B(Touvron等,2023)。

3.3 評(píng)估

傳統(tǒng)的評(píng)估指標(biāo),如準(zhǔn)確率和F1分?jǐn)?shù),在評(píng)估最先進(jìn)的大語(yǔ)言模型的生成時(shí)有其局限性,因?yàn)檫@些模型通常會(huì)生成難以量化的長(zhǎng)篇回答。因此,我們采用了PaLM-2L模型進(jìn)行的評(píng)估,其中我們使用少樣本示例來(lái)提示模型識(shí)別目標(biāo)答案和模型預(yù)測(cè)之間的等價(jià)性。用于此評(píng)估的少樣本示例、提示和其他詳細(xì)信息見(jiàn)附錄C。

3.4 基線方法

- PaLM-2L, PaLM-2L 1-shot: PaLM-2L模型直接使用問(wèn)題進(jìn)行查詢(xún),或在提示中包含一個(gè)問(wèn)題-答案示例的單個(gè)演示樣例。

- PaLM-2L + CoT, PaLM-2L + CoT 1-shot: 使用零樣本思維鏈(Chain-of-Thought, CoT)提示(Kojima等,2022)來(lái)查詢(xún)PaLM-2L模型:“讓我們一步一步思考”被添加到問(wèn)題中。對(duì)于1-shot,提示中提供了一個(gè)問(wèn)題和答案對(duì)的示例,其中答案采用CoT風(fēng)格(Wei等,2022b)。

- PaLM-2L + TDB: 使用零樣本提示“深呼吸并一步一步解決這個(gè)問(wèn)題。”(Yang等,2023)添加到問(wèn)題之前。

- PaLM-2L + RAG: 在第5和第6節(jié)中,我們使用檢索增強(qiáng)生成(RAG),其中檢索到的段落作為上下文被大語(yǔ)言模型使用。

- GPT-4 和 Llama2-70B: 我們?cè)贛MLU任務(wù)上對(duì)所有方法運(yùn)行了GPT-4和Llama2-70B。此外,我們還在所有基線上對(duì)所有任務(wù)運(yùn)行了GPT-4。

由于STEM任務(wù)的內(nèi)在推理性質(zhì),我們沒(méi)有對(duì)這些任務(wù)使用RAG。所有推斷都是使用貪婪解碼進(jìn)行的。

4、STEM

我們?cè)赟TEM任務(wù)上評(píng)估“退一步”提示法(STEP-BACK PROMPTING),以衡量我們的方法在高度專(zhuān)業(yè)領(lǐng)域中的推理能力。以下是我們?cè)贛MLU高中物理和化學(xué)以及GSM8K基準(zhǔn)測(cè)試上應(yīng)用“退一步”提示法的實(shí)驗(yàn)設(shè)置、結(jié)果和分析。

4.1 “退一步”提示法

MMLU基準(zhǔn)測(cè)試中的問(wèn)題需要更深層次的推理。此外,它們還需要理解和應(yīng)用通常為物理和化學(xué)原理和概念的公式。在這種情況下,我們首先向模型展示抽象技能,這些技能表現(xiàn)為概念和基本原理,如牛頓第一運(yùn)動(dòng)定律、多普勒效應(yīng)和吉布斯自由能等。

在這里,隱含的“退一步”問(wèn)題是“解決此任務(wù)涉及哪些物理或化學(xué)原理和概念?”我們提供了一些示例來(lái)引導(dǎo)模型從自身的知識(shí)中背誦解決任務(wù)所需的相關(guān)原理(參見(jiàn)附錄D.1了解少樣本示例)。

4.2 結(jié)果

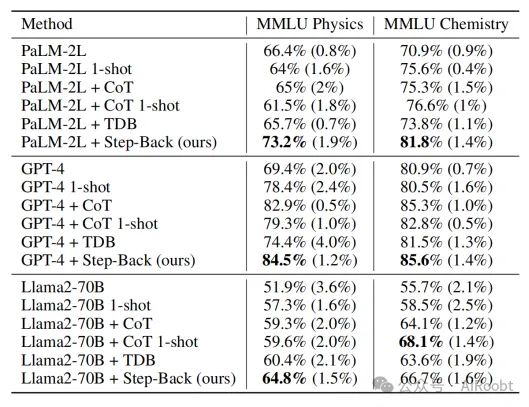

表1展示了不同模型族的各種設(shè)置下的模型性能:PaLM-2L、GPT-4和Llama2-70B。表中報(bào)告的是5次評(píng)估運(yùn)行的平均準(zhǔn)確率,并附上標(biāo)準(zhǔn)差(括號(hào)內(nèi)的數(shù)值)。PaLM-2L的基線性能在物理和化學(xué)上的準(zhǔn)確率分別為66.4%和70.9%。我們發(fā)現(xiàn),CoT和TDB零樣本提示并未顯著提升模型性能,這可能是由于這些任務(wù)固有的難度和深層次的推理要求。PaLM-2L的1-shot和PaLM-2L + CoT的1-shot方法也未對(duì)基線有太多提升,這突顯了向模型展示推理步驟的挑戰(zhàn)。相比之下,“退一步”提示法顯著提高了模型性能:相比于PaLM-2L,物理和化學(xué)分別提高了7%和11%。同樣,對(duì)于GPT-4和Llama2-70B模型,“退一步”提示法在我們測(cè)試的所有基線方法中表現(xiàn)非常有競(jìng)爭(zhēng)力,這表明“退一步”提示法是模型無(wú)關(guān)的。我們?cè)诟戒汚.1中展示了GSM8K的結(jié)果。

表 1:在 MMLU 任務(wù)中,"退一步"提示法(STEP-BACK PROMPTING)在三個(gè)模型系列上表現(xiàn)出色。** CoT:零樣本鏈?zhǔn)剿季S提示(Chain of Thought prompting,Kojima等,2022),TDB:“深呼吸”提示(Take a Deep Breath prompting,Yang等,2023)。

4.3 消融實(shí)驗(yàn)和分析

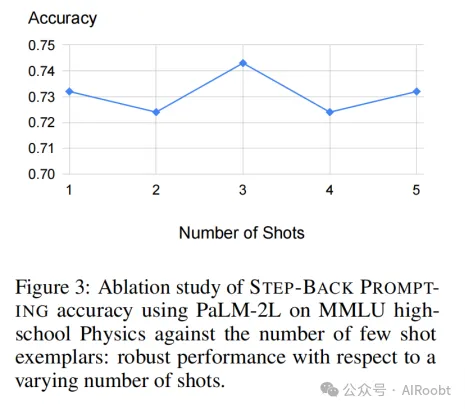

少樣本消融實(shí)驗(yàn): 首先,在圖3中,我們觀察到“退一步”提示法對(duì)用作示例的少樣本(問(wèn)題和原理對(duì))的數(shù)量具有魯棒性。增加超過(guò)一個(gè)示例的演示并不會(huì)帶來(lái)進(jìn)一步的改進(jìn)。這表明,通過(guò)上下文學(xué)習(xí),檢索相關(guān)原理和概念的任務(wù)對(duì)模型來(lái)說(shuō)相對(duì)容易,一個(gè)示例就足夠了。因此,除非是消融實(shí)驗(yàn),否則本文中使用的少樣本提示都是單個(gè)示例。

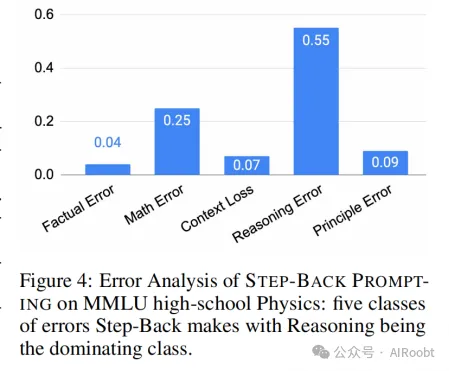

錯(cuò)誤分析: 比較“退一步”提示法對(duì)MMLU高中物理的預(yù)測(cè)結(jié)果和PaLM-2L基線模型的預(yù)測(cè)結(jié)果,我們發(fā)現(xiàn)“退一步”提示法修正了20.5%的基線錯(cuò)誤,同時(shí)引入了11.9%的新錯(cuò)誤。

為了進(jìn)一步了解“退一步”提示法的錯(cuò)誤來(lái)源,我們對(duì)測(cè)試集中所有的錯(cuò)誤預(yù)測(cè)進(jìn)行了標(biāo)注,并將其分為5類(lèi)(參見(jiàn)附錄E.1了解每類(lèi)中的示例):

- 原理錯(cuò)誤: 在抽象步驟中發(fā)生的錯(cuò)誤,模型生成的基本原理是錯(cuò)誤的或不完整的。

- 事實(shí)錯(cuò)誤: 當(dāng)模型背誦自身的事實(shí)知識(shí)時(shí),至少有一個(gè)事實(shí)錯(cuò)誤。

- 數(shù)學(xué)錯(cuò)誤: 在涉及數(shù)學(xué)計(jì)算的中間步驟中存在至少一個(gè)數(shù)學(xué)錯(cuò)誤。

- 上下文丟失: 模型響應(yīng)丟失了問(wèn)題的上下文,從而偏離了對(duì)原始問(wèn)題的回答。

- 推理錯(cuò)誤: 我們將推理錯(cuò)誤定義為在到達(dá)最終答案之前的中間推理步驟中至少出現(xiàn)一個(gè)錯(cuò)誤。

圖4顯示,除原理錯(cuò)誤外,所有五種類(lèi)型的錯(cuò)誤都發(fā)生在推理步驟中,原理錯(cuò)誤指向抽象步驟的失敗。推理錯(cuò)誤和數(shù)學(xué)錯(cuò)誤是主要的錯(cuò)誤類(lèi)別。這與上述消融研究中的發(fā)現(xiàn)相吻合,即僅需少量示例就可以向大語(yǔ)言模型展示抽象技能。推理步驟仍然是“退一步”提示法執(zhí)行需要復(fù)雜推理的任務(wù)(如MMLU)的瓶頸。具體到MMLU物理,推理和數(shù)學(xué)技能對(duì)于成功解決這些問(wèn)題至關(guān)重要:即使正確地檢索了基本原理,也需要通過(guò)典型的多步推理過(guò)程進(jìn)行深入推理和數(shù)學(xué)運(yùn)算,以得出正確的最終答案。

5、知識(shí)問(wèn)答(Knowledge QA)

我們?cè)谛枰芗聦?shí)知識(shí)的問(wèn)答基準(zhǔn)上評(píng)估了“退一步”提示法(STEP-BACK PROMPTING)。知識(shí)問(wèn)答對(duì)大語(yǔ)言模型(LLMs)來(lái)說(shuō)是一個(gè)挑戰(zhàn)。在本節(jié)中,我們首先描述實(shí)驗(yàn)設(shè)置,然后是對(duì)“退一步”提示法的結(jié)果和分析。

5.1 “退一步”提示法

我們?cè)谥R(shí)問(wèn)答類(lèi)別中評(píng)估了“退一步”提示法,使用了TimeQA(Chen等,2021)和SituatedQA(Zhang & Choi,2021)數(shù)據(jù)集。我們首先通過(guò)上下文中的演示向LLMs展示如何進(jìn)行抽象。圖2中的“退一步”問(wèn)題“埃斯特拉·萊奧波德的教育背景是什么?”就是通過(guò)少樣本演示生成的(詳細(xì)信息見(jiàn)附錄D.2)。鑒于這些查詢(xún)的知識(shí)密集性質(zhì),我們結(jié)合“退一步”提示法使用了檢索增強(qiáng)(RAG)。“退一步”問(wèn)題用于檢索相關(guān)事實(shí),這些事實(shí)作為額外的上下文(提示見(jiàn)表14)以支持最終的推理步驟。

5.2 結(jié)果

我們?cè)赥imeQA的測(cè)試集上對(duì)模型進(jìn)行了評(píng)估。如表2所示,GPT-4和PaLM-2L的基線模型分別達(dá)到了45.6%和41.5%的準(zhǔn)確率,這突顯了任務(wù)的難度。將CoT或TDB零樣本(以及單樣本)提示應(yīng)用于基線模型并未顯示出改進(jìn)。相反,通過(guò)常規(guī)檢索增強(qiáng)(RAG)增強(qiáng)基線模型,將準(zhǔn)確率提升至57.4%,這突顯了任務(wù)的事實(shí)密集性質(zhì)。“退一步”+ RAG的結(jié)果顯示了回到高層次概念的有效性,這使得檢索增強(qiáng)更加可靠:TimeQA的準(zhǔn)確率達(dá)到了顯著的68.7%。

接下來(lái),我們將TimeQA按原始數(shù)據(jù)集中提供的難度等級(jí)分為易和難兩個(gè)級(jí)別。正如預(yù)期的那樣,所有方法在困難子集上的表現(xiàn)都較差。雖然RAG可以將易級(jí)別的準(zhǔn)確率從42.6%提升到67.8%,但在難級(jí)別上的提升要小得多:從40.4%提升到46.8%。這正是“退一步”提示法的優(yōu)勢(shì)所在,它通過(guò)檢索高層次概念的事實(shí)來(lái)支持最終推理:“退一步”+ RAG進(jìn)一步將難級(jí)別的準(zhǔn)確率提升到62.3%,超越了GPT-4的42.6%。我們假設(shè)關(guān)于高層次概念(如教育背景)的事實(shí)比低層次細(xì)節(jié)更容易獲取。

在SituatedQA基準(zhǔn)測(cè)試中,我們觀察到從54.3%到我們最佳方法“退一步”+ RAG(61%)的適度質(zhì)量提升,與GPT-4的63.2%有小的差距。與TimeQA類(lèi)似,諸如CoT和TDB之類(lèi)的提示對(duì)于SituatedQA并沒(méi)有顯著幫助。

5.3 消融實(shí)驗(yàn)和分析

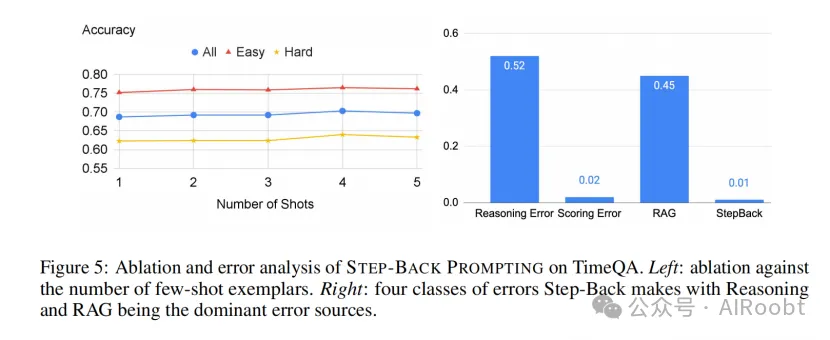

少樣本消融實(shí)驗(yàn): 我們?cè)趫D5(左)中觀察到,“退一步”提示法在TimeQA上的表現(xiàn)對(duì)演示中使用的示例數(shù)量具有魯棒性,這再次顯示了PaLM-2L模型在上下文中學(xué)習(xí)抽象技能的樣本效率。

錯(cuò)誤分析: 圖5(右)顯示了“退一步”提示法在TimeQA上的所有剩余錯(cuò)誤的分類(lèi)。類(lèi)似于第4.3節(jié),我們將錯(cuò)誤分類(lèi)為:

- StepBack: 生成的“退一步”問(wèn)題對(duì)解決任務(wù)沒(méi)有幫助。

- RAG: 盡管“退一步”問(wèn)題是準(zhǔn)確的,但RAG未能檢索到相關(guān)信息。

- 評(píng)分錯(cuò)誤: 評(píng)估模型的判斷錯(cuò)誤。

- 推理錯(cuò)誤: 檢索到的上下文是相關(guān)的,但模型仍未能通過(guò)上下文得出正確答案。

圖5TimeQA上“退一步”提示法的消融和錯(cuò)誤分析。左圖:與少樣本示例數(shù)目相關(guān)的消融研究。右圖:錯(cuò)誤類(lèi)別分布,推理和RAG是主要的錯(cuò)誤來(lái)源。

我們發(fā)現(xiàn)“StepBack”很少失敗。相反,我們發(fā)現(xiàn)超過(guò)一半的錯(cuò)誤是由于推理錯(cuò)誤。此外,45%的錯(cuò)誤是由于未能檢索到正確信息,盡管抽象提供的“退一步”問(wèn)題使其成為一個(gè)更容易的任務(wù)。這反映了TimeQA任務(wù)的難度。TimeQA的更多錯(cuò)誤分析見(jiàn)附錄A。

6、多跳推理(MULTI-HOP REASONING)

我們?cè)诰哂刑魬?zhàn)性的多跳推理基準(zhǔn)數(shù)據(jù)集MuSiQue(Trivedi等,2022)和StrategyQA(Geva等,2021)上評(píng)估了“退一步”提示法(STEP-BACK PROMPTING)。我們遵循第5節(jié)中的相同協(xié)議來(lái)實(shí)施“退一步”提示法。

表3顯示了在MuSiQue和StrategyQA的開(kāi)發(fā)集上的各種基線的性能。由于MuSiQue是一個(gè)難度較大的多跳推理基準(zhǔn)數(shù)據(jù)集,PaLM-2L和GPT-4的基線性能較低(分別為35.5%和38.5%)。相比之下,StrategyQA的基線性能較強(qiáng)(PaLM-2L為82.8%,GPT-4為78.3%),這可能是因?yàn)樗且粋€(gè)二元分類(lèi)任務(wù)。在MuSiQue的情況下,CoT和TDB提示略微提高了模型性能(分別約為3%和3.5%),這可能歸因于該任務(wù)固有的推理性質(zhì),而這些方法已被證明是有幫助的。在StrategyQA的情況下,由于該任務(wù)基線性能較高,這些提示方法并沒(méi)有顯著的性能提升,這限制了它們改進(jìn)性能的空間。通常情況下,1-shot性能顯著低于零樣本方法,這可能是由于潛在的示例偏差(Zhao等,2021;Parmar等,2023)。RAG提升了模型性能(MuSiQue約4%,StrategyQA約2%)。憑借抽象的優(yōu)勢(shì),“退一步”提示法產(chǎn)生了所有方法中最好的性能:MuSiQue為42.8%,StrategyQA為86.4%,在這兩個(gè)任務(wù)上顯著超過(guò)了GPT-4。我們?cè)诟戒汚.3中提供了StrategyQA的詳細(xì)錯(cuò)誤分析。

7、 討論(DISCUSSION)

抽象幫助人類(lèi)通過(guò)去除無(wú)關(guān)細(xì)節(jié)并提煉高層次概念和原則來(lái)解決復(fù)雜任務(wù)。“退一步”提示法將復(fù)雜任務(wù)(如知識(shí)密集型問(wèn)答、多跳推理和科學(xué)問(wèn)題)分為抽象和推理兩個(gè)獨(dú)立步驟。我們通過(guò)實(shí)證實(shí)驗(yàn)表明,對(duì)于諸如PaLM-2L之類(lèi)的大語(yǔ)言模型來(lái)說(shuō),抽象是一項(xiàng)通過(guò)樣本高效的上下文學(xué)習(xí)容易掌握的技能。基于高層次概念和原則,大語(yǔ)言模型可以利用其內(nèi)在的推理能力來(lái)推導(dǎo)解決方案。這減少了中間步驟中推理失敗的機(jī)會(huì),并被證明在廣泛的復(fù)雜推理任務(wù)中提高了性能。盡管取得了成功,但通過(guò)錯(cuò)誤分析,我們發(fā)現(xiàn)推理仍然是大語(yǔ)言模型最難掌握的技能之一:即使在“退一步”提示法大幅降低了任務(wù)復(fù)雜性之后,它仍然是主要的失敗模式。

然而,抽象并非在所有情況下都是必要或可行的。例如,任務(wù)可能簡(jiǎn)單到只需要回答“2000年美國(guó)的總統(tǒng)是誰(shuí)?”這種情況下沒(méi)有必要退一步并提出一個(gè)高層次的問(wèn)題,因?yàn)榇祟?lèi)問(wèn)題的答案顯而易見(jiàn)。諸如“光速是多少?”之類(lèi)的問(wèn)題本身就指向了基本原理。在這種情況下,進(jìn)行抽象并不會(huì)產(chǎn)生差異。

8、相關(guān)工作(RELATED WORK)

提示(Prompting)

少樣本提示(Brown等,2020;Liu等,2023;Mishra等,2022a;Wei等,2022b)在不需要更新模型參數(shù)的情況下顯著提高了模型在各種任務(wù)上的表現(xiàn)。我們的工作“退一步”提示法(STEP-BACK PROMPTING)與鏈?zhǔn)剿季S提示法(Chain-of-Thought Prompting,Wei等,2022b)和草稿紙方法(Scratchpad,Nye等,2021)屬于同一類(lèi)別,因?yàn)樗鼈兌季哂泻?jiǎn)單性和通用性。但是,我們的方法專(zhuān)注于抽象這一核心理念,這一靈感來(lái)源于人類(lèi)在執(zhí)行復(fù)雜任務(wù)時(shí)經(jīng)常退一步的做法。我們的工作也與背誦增強(qiáng)語(yǔ)言模型(Recitation-Augmented Language Models,Sun等,2022)相關(guān);然而,與他們的工作相比,我們明確執(zhí)行退一步和抽象,并根據(jù)任務(wù)的性質(zhì)選擇性地使用檢索增強(qiáng)。

分解(Decomposition)

將一個(gè)任務(wù)分解為更簡(jiǎn)單的子任務(wù)并通過(guò)解決這些子任務(wù)來(lái)完成原始任務(wù),一直是提高模型在復(fù)雜任務(wù)上表現(xiàn)的有效方法(Zhou等,2022;Patel等,2022;Khot等,2022;Press等,2022)。幾種提示方法在這方面取得了成功。我們的“退一步”提示法與此不同,它旨在將問(wèn)題變得更抽象和高層次,而分解往往是對(duì)原始問(wèn)題的低層次細(xì)分。例如,一個(gè)關(guān)于“1990年史蒂夫·喬布斯為哪個(gè)雇主工作?”的通用問(wèn)題可以被改寫(xiě)為“史蒂夫·喬布斯的就業(yè)歷史是什么?”。而分解會(huì)導(dǎo)致生成多個(gè)子問(wèn)題,如“史蒂夫·喬布斯在1990年做了什么?”,“1990年史蒂夫·喬布斯是否受雇?”以及“如果史蒂夫·喬布斯受雇,他的雇主是誰(shuí)?”。此外,諸如“史蒂夫·喬布斯的就業(yè)歷史是什么?”的抽象問(wèn)題往往具有多對(duì)一的映射關(guān)系,因?yàn)槎鄠€(gè)問(wèn)題(如“1990年史蒂夫·喬布斯為哪個(gè)雇主工作?”和“2000年史蒂夫·喬布斯為哪個(gè)雇主工作?”)可以具有相同的抽象問(wèn)題。這與分解通常具有一對(duì)多映射的特性不同,因?yàn)橥ǔP枰鄠€(gè)分解的子問(wèn)題來(lái)解決一個(gè)問(wèn)題。

9、結(jié)論(CONCLUSION)

我們提出了“退一步”提示法,這是一種簡(jiǎn)單而通用的方法,可以通過(guò)抽象在大語(yǔ)言模型中引發(fā)深層次的推理。我們?cè)谑聦?shí)查詢(xún)、常識(shí)推理和領(lǐng)域特定推理基準(zhǔn)測(cè)試上對(duì)大語(yǔ)言模型進(jìn)行了實(shí)驗(yàn),結(jié)果表明“退一步”提示法顯著提高了模型的表現(xiàn)。我們假設(shè),抽象幫助模型減少幻覺(jué),并更好地進(jìn)行推理,這可能反映了模型的真實(shí)能力,而這些能力通常在模型回答原始問(wèn)題時(shí)隱藏起來(lái)。我們希望我們的工作能夠激發(fā)更多靈感來(lái)自人類(lèi)的方式,以開(kāi)發(fā)大語(yǔ)言模型的潛力。

?

本文轉(zhuǎn)載自公眾號(hào)AIRoobt ,作者:AIRoobt

原文鏈接:??https://mp.weixin.qq.com/s/B2qO3gAeOpL1A1wD77X4og??