開源創新框架MoA,可極大增強大模型的能力

知名大模型平臺Together AI開源了一個創新框架Mixture-of-Agents(簡稱,MoA)。

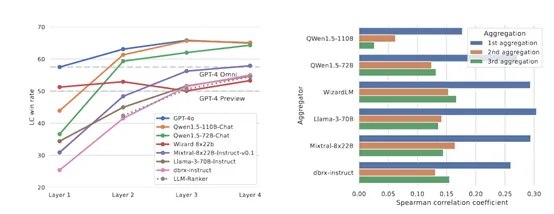

MoA可以顯著提升大模型的生成內容的能力和安全性,同時降低對AI算力的需求。研究人員在AlpacaEval 2.0、MT-Bench和FLASK等多個基準上進行了全面評測,涵蓋了從無害性、魯棒性、效率、可讀性、事實性等多個維度。

結果顯示,MoA在AlpacaEval 2.0上以65.1%的得分,擊敗了OpenAI的GPT-4o (57.5%),并且在使用開源大模型的條件下,仍然保持了明顯的優勢。也就是說,開發人員在有限的算力預算下,MoA也能最大化開源大模型的能力。

開源地址:https://github.com/togethercomputer/moa?tab=readme-ov-file

論文地址:https://arxiv.org/abs/2406.04692

傳統的單一大模型在特定任務上表現卓越,例如,金融、醫療、營銷等,但它們受限于訓練數據和參數的限制,無法達到更好的效果。

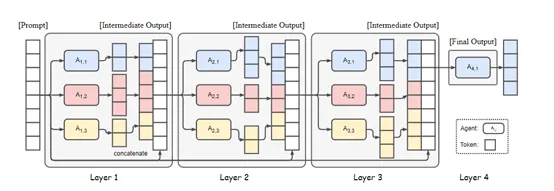

MoA則使用了一種創新架構,構建了一個由多個代理層組成的模型,每一層都包含若干個大模型代理。這些代理在模型的每一層中獨立地工作,但它們之間的協作卻非常緊密。

在MoA的每一層中,這些代理不僅僅是簡單地接收輸入并生成輸出,它們還會對前一層的輸出進行深入分析和綜合,以生成更加精準和全面的回答。簡單來說,有點像是一個交響樂團,每個代理都扮演著演奏者的角色,共同演奏一首美妙的歌曲。

此外,這些代理會被統一劃分為提議者(Proposers)和聚合器(Aggregators)兩種角色。提議者擅長生成有用的參考響應,即使這些響應本身可能并不完美,但它們提供了豐富的上下文和多樣化的視角。

而聚合器則精于將這些來自不同提議者的響應整合成一個高質量的單一輸出。這種角色分配使得MoA能夠充分發揮每個模型的長處,同時彌補個別模型的不足。

為了確保模型之間的有效協作并提高整體響應質量,MoA在選擇每一層的大模型時非常謹慎。選擇過程主要基于兩個標準:性能指標和多樣性考慮。

性能指標確保所選模型在歷史上的表現是出色的,多樣性確保了不同模型的輸出能夠相互補充,從而豐富了最終的響應內容。

在大模型魯棒性方面,在面對復雜或模糊的輸入內容時,單一的大模型可能會產生不確定或錯誤的響應。而MoA通過多模型代理協作,可以減少這種不確定性,提供更加穩定和可靠的輸出。

這種魯棒性對于需要高可靠性的領域,如醫療咨詢、法律服務、以及客戶支持等,尤為重要,同時能增強多任務的學習能力,在執行語言翻譯、摘要生成、情感分析等多個子任務的復雜查詢時,能夠提供更加全面和深入的解答。

在資源優化方面,MoA通過智能地選擇和組合不同代理模型的輸出,能夠在保持高性能的同時,減少對計算資源的需求。使得MoA在資源受限的環境中,例如,手機、平板、筆記本等,也能發揮出大模型的能力。

本文轉自 AIGC開放社區 ,作者:AIGC開放社區