OpenAI o1引發的思維鏈思考:思維鏈提示啟發大模型推理

摘要:

我們探索了生成一個思維鏈(一系列中間推理步驟)可以怎樣顯著提高大型語言模型執行復雜推理的能力。特別是,我們展示了這種推理能力是如何通過一種稱為思維鏈提示的簡單方法,在足夠大的語言模型中自然出現的,其中提供了一些思維鏈演示作為提示的示例。

在三個大型語言模型上的實驗表明,思維鏈提示可以提高一系列算術、常識和符號推理任務的性能。經驗收益可能是驚人的。例如,用只有八個思維鏈示例來提示PaLM 540B在數學應用題集GSM8K基準測試上達到了非常先進的精度,甚至超過了帶有驗證器微調過的GPT-3。

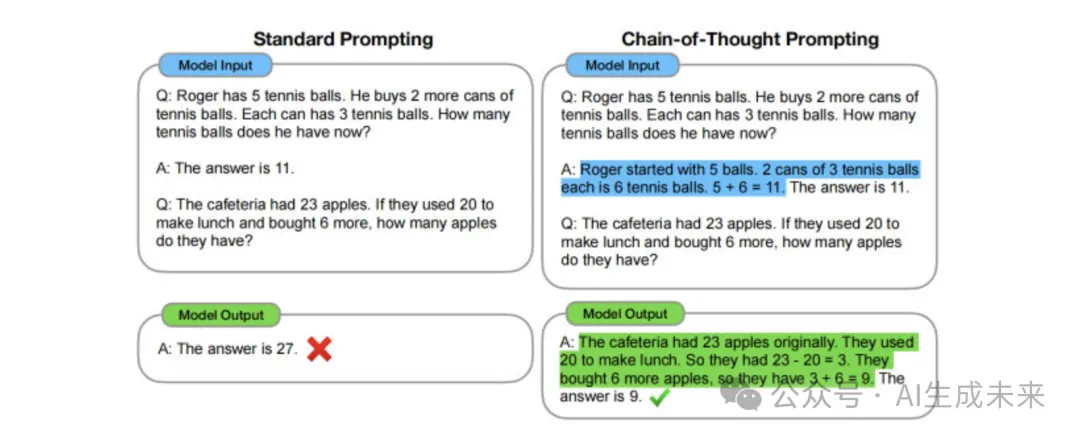

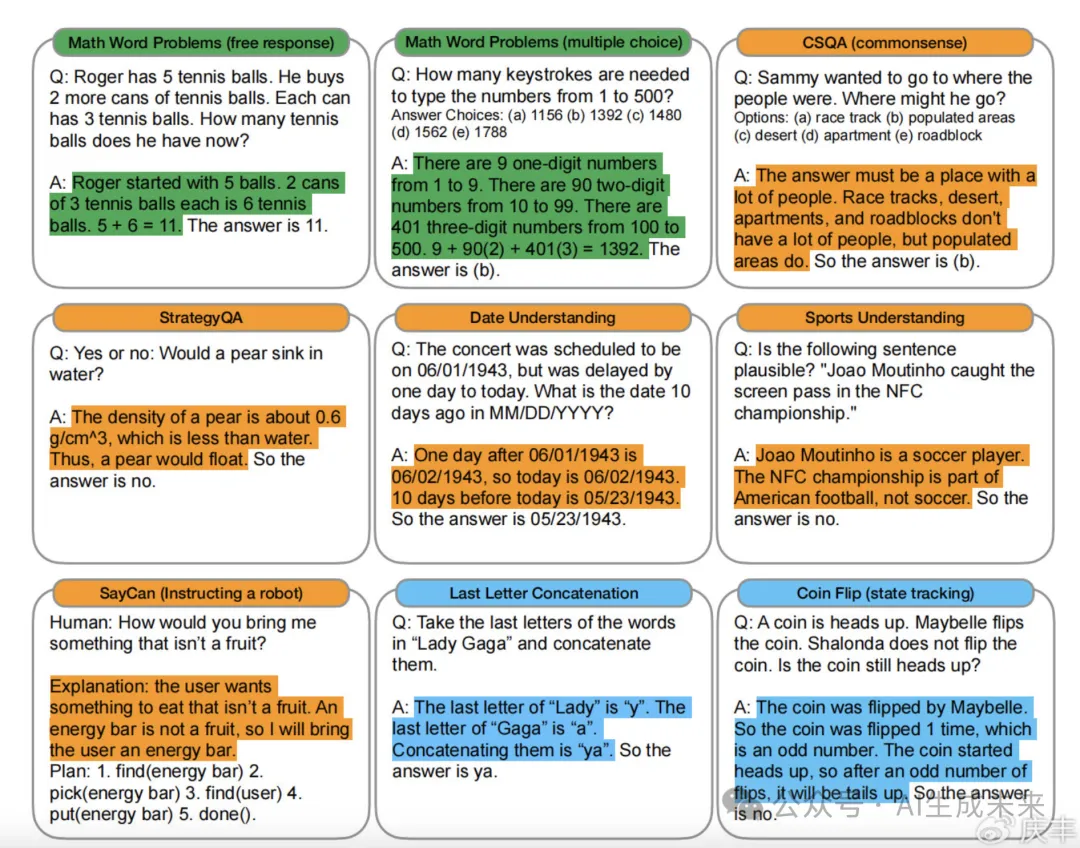

圖1:思維鏈提示使大型語言模型能夠處理復雜的算法、常識和符號推理任務。思維鏈推理過程已被高亮顯示。

1、簡介

NLP領域最近被語言模型徹底改變了。擴大語言模型的規模已被證明可以帶來一系列好處,例如提升的性能和樣本效率。然而,僅擴大模型尺寸還不足以在具有挑戰性的任務中取得更好的表現,例如算術、常識和符號推理方面。

這項工作探討了如何通過一種由兩個想法驅動的簡單方法來解鎖大型語言模型的推理能力。首先,算術推理技術可以從生成自然語言基本原理(產生最終答案)中受益。先前的工作使模型能夠具有通過從頭開始訓練或微調預訓練模型來生成自然語言的中間步驟的能力,此外還有使用形式語言而不是自然語言的神經符號方法。其次,大型語言模型提供了令人興奮的可能性,可以通過提示進行上下文少樣本學習。也就是說,可以簡單地用幾個演示任務的輸入-輸出示例“提示”模型,替代掉為每個新任務微調單獨的語言模型檢查點。值得注意的是,這在一系列簡單的問答任務中取得了成功。

然而,上述兩種想法都有嚴重的局限性。對于基本原理,增強訓練和微調方法,創建大量高質量的基本原理成本很高,這比普通機器學習中使用的簡單輸入輸出對更復雜。對于Brown等人使用的傳統少量樣本提示方法,它在需要推理能力的任務上效果不佳,并且通常不會隨著語言模型規模的增加而顯著提高. 在本文中,我們結合了這兩種觀點的優點,避免了它們的局限性。

具體來說,我們探索了語言模型在給定由三元組組成的提示(輸入、思維鏈、輸出)的情況下,對推理任務執行少量樣本提示的能力。思維鏈是一系列導致最終輸出的中間自然語言推理步驟,我們將這種方法稱為思維鏈提示。示例提示如圖1所示。

我們對算術、常識和符號推理基準進行了實證評估,表明思維鏈提示優于標準提示,有時甚至達到了驚人的程度。

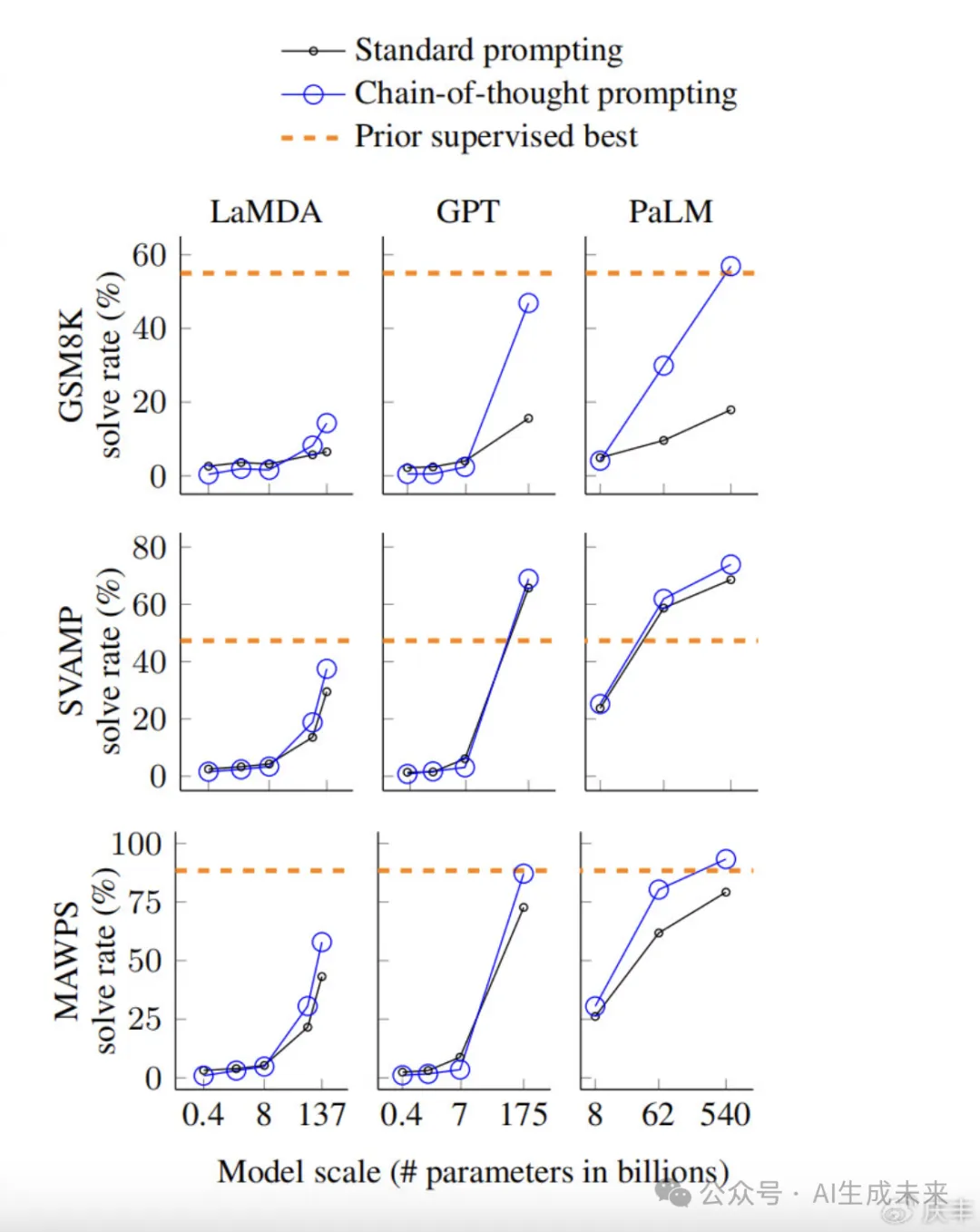

圖2:PaLM 540B使用思維鏈提示在GSM8K數學應用題題基準上實現了最先進的性能。Cobbe等人(2021)對GPT-3進行了微調,并得出了之前的最佳結果。

圖2展示了一個這樣的結果——在數學應用題GSM8K基準測試中,使用PaLM 540B的思維鏈提示優于標準提示,并達到了新的最先進的性能。僅僅提示的方法就很重要,因為它不需要大型訓練數據集,也因為單個模型檢查點可以執行許多任務而不失一般性。這項工作重點說明大型語言模型可以通過幾個例子學習關于任務的自然語言數據(通過大型訓練數據集作為輸入和輸出基礎的自動學習模式)。

2、思維鏈提示

在解決復雜的推理任務時(如多步驟數學應用題),考慮一下自己的思考過程。通常會將問題分解為多個中間步驟并在給出最終答案之前解決每個步驟的問題:“簡給媽媽2朵花后,她有10朵花……然后給爸爸3朵花后,他會有7朵花……所以答案是7。”

本文的目標是賦予語言模型生成類似思維鏈的能力——一系列連貫的產生問題最終答案的中間環節推理步驟。我們將證明,如果在示例中為少樣本提示提供了思維鏈推理的演示,那么足夠大的語言模型可以生成思維鏈。

圖1顯示了一個模型的示例,該模型產生了一個思維鏈來解決一個數學應用題,否則它會出錯。在這種情況下,思維鏈類似于解決方案,可以被解釋為一個解決方案,但我們仍然選擇稱之為思維鏈,以更好地捕捉到它模仿了一個循序漸進的思維過程來得出答案的想法(而且,解決方案/解釋通常在最終答案之后出現)。

思維鏈提示作為一種促進語言模型推理的方法具有幾個吸引人的特性:

1.首先,原則上,思維鏈允許模型將多步問題分解為多個中間步驟,這意味著可以將額外的計算分配給需要更多推理步驟的問題。

2.其次,思維鏈為模型的行為提供了一個可解釋的窗口,表明它是如何得出特定答案的,并提供了調試出錯的推理路徑的機會(盡管充分描述模型的支持答案的計算仍然是一個懸而未決的問題)。

3.第三,思維鏈推理可用于數學應用題、常識推理和符號操縱等任務,并且潛在的適用于(至少在原則上)人類可以通過語言解決的任何任務。

4.最后,在足夠大的現成語言模型中,只需將思維鏈序列的示例包含在少樣本提示的示例中,就可以很容易地引出思維鏈推理。

在實證實驗中,我們將觀察思維鏈提示對算術推理(第3節)、常識推理(第4節)和符號推理(第5節)的效用。

3、算術推理

我們首先考慮圖1中形式的數學應用題,它衡量了語言模型的算術推理能力。雖然對人類來說很簡單,但算術推理是一項語言模型經常遇到困難的任務。引人注目的是,當與540B參數語言模型一起使用時,思維鏈提示在多個任務上的表現與特定任務的微調模型相當,甚至在具有挑戰性的GSM8K基準測試上達到了新的技術水平。

3.1 實驗設置

我們在多個基準上探索了各種語言模型的思維鏈提示。

基準:

我們考慮以下五個數學單詞問題基準:

(1)GSM8K數學應用題的基準測試,

(2)具有不同結構的數學題的SVAMP數據集,

(3)各種數學題的ASDiv數據集,

(4)代數題的AQuA數據集,

以及(5)MAWPS基準測試。附錄表12中給出了示例問題。

標準提示:

對于基線,我們考慮Brown等人推廣的標準少樣本提示,其中在輸出測試時間示例的預測之前,給大語言模型輸入-輸出對的上下文示例。示例的格式為問題和答案。該模型直接給出了答案,如圖1(左)所示。

思維鏈提示:

我們提出的方法是用一個思維鏈來增強提示中每個示例,以獲得相關答案,如圖1(右)所示。由于大多數數據集只有一個評估分割,我們手動組合了一組八個帶有思維鏈的示例用于提示——圖1(右)顯示了一個思維鏈示例,附錄表20給出了全套示例。(這些特定的示例沒有經過及時的工程設計;穩健性在第3.4節和附錄A.2中進行了研究。)為了調查這種形式的思維鏈提示是否可以成功地引發一系列數學應用題的成功推理,我們將這八個思維鏈示例用于所有基準測試,除了AQuA(它是多項選擇而不是自由反應)。對于AQuA,我們使用了訓練集中的四個示例和解決方案,如附錄表21所示。

圖3:算術、常識和符號推理基準的輸入、思維鏈、輸出三元組示例。思維鏈被高亮顯示。附錄G中的完整提示。

語言模型:

我們評估了五種大型語言模型。

第一個是GPT-3,我們使用text-ada-001、text-babbage-001、text-curie-001和text-davinci-002,它們可能對應于350M、1.3B、6.7B和175B參數的InstructGPT模型。第二個是LaMDA,它有422M、2B、8B、68B和137B參數的模型。第三個是PaLM,它有8B、62B和540B參數的模型。第四個是UL2 20B,第五個是Codex。

我們通過貪婪解碼從模型中采樣(盡管后續工作表明,通過在許多采樣代中獲得多數最終答案,可以改善思維鏈提示)。對于LaMDA,我們報告了五個隨機種子的平均結果,其中每個種子具有不同的隨機混洗的示例順序。由于LaMDA實驗在不同種子之間沒有顯示出很大的差異,為了節省計算,我們報告了所有其他模型的單個樣本順序的結果。

3.2、結果

圖4總結了思維鏈提示的最強結果,每個模型集合、模型大小和基準的所有實驗輸出如附錄表2所示。

有三個關鍵要點。

圖4:思維鏈提示使大型語言模型能夠解決具有挑戰性的數學問題。值得注意的是,思維鏈推理是一種增加模型規模的新興能力。之前的最佳數字來自Cobbe等人(2021年)的GSM8K、Jie等人(2022年)的SVAMP和Lan等人(2021)的MAWPS。

首先,圖4顯示,思維鏈提示是一種模型尺度的涌現能力。也就是說,思維鏈提示對小型模型的性能沒有積極影響,只有在與參數為100B及以上的模型一起使用時才能提高性能。我們確定的發現,較小規模的模型產生了流暢但不合邏輯的思維鏈,導致其表現低于標準提示。

其次,對于更復雜的問題,思維鏈提示具有更大的性能提升。例如,對于GSM8K(基線性能最低的數據集),最大的GPT和PaLM模型的性能翻了一番多。另一方面,對于MAWPS中最簡單的子集SingleOp(只需要一步即可解決),性能改進要么是負面的,要么是非常小的(見附錄表3)。

第三,通過GPT-3 175B和PaLM 540B的思維鏈提示與現有技術相比具有優勢,現有技術通常在標記的訓練數據集上微調特定任務的模型。

圖4顯示了PaLM 540B如何使用思維鏈提示在GSM8K、SVAMP和MAWPS上實現新的技術水平(盡管請注意,標準提示已經通過了SVAMP的先前最佳水平)。在另外兩個數據集上,AQuA和ASDiv、PaLM的思維鏈提示超過了最先進水平的2%以內(附錄表2)。

為了更好地理解為什么思維鏈提示有效,我們手動檢查了LaMDA 137B為GSM8K生成的模型思維鏈。在模型返回正確最終答案的50個隨機例子中,除了兩個巧合地得出正確答案的例子外,所有生成的思維鏈在邏輯和數學上都是正確的(正確模型生成的思考鏈的例子見附錄D.1和表8)。我們還隨機檢查了50個模型給出錯誤答案的隨機樣本。這項分析的總結是,除了小錯誤(計算器錯誤、符號映射ping錯誤或缺少一個推理步驟)外,46%的思維鏈幾乎是正確的,另外54%的思維鏈在語義理解或連貫性方面存在重大錯誤(見附錄D.2)。為了深入了解為什么縮放可以提高思維鏈推理能力,我們對PaLM 62B的錯誤進行了類似的分析,并分析了這些錯誤是否通過縮放到PaLM 540B而得到修復。總結來看,將PaLM擴展到540B可以修復62B模型中很大一部分步驟缺失和語義理解錯誤(見附錄a.1)。

3.3、消融研究

使用思維鏈提示的觀察到的好處提出了一個自然的問題,即是否可以通過其他類型的提示來提高同樣的績效。

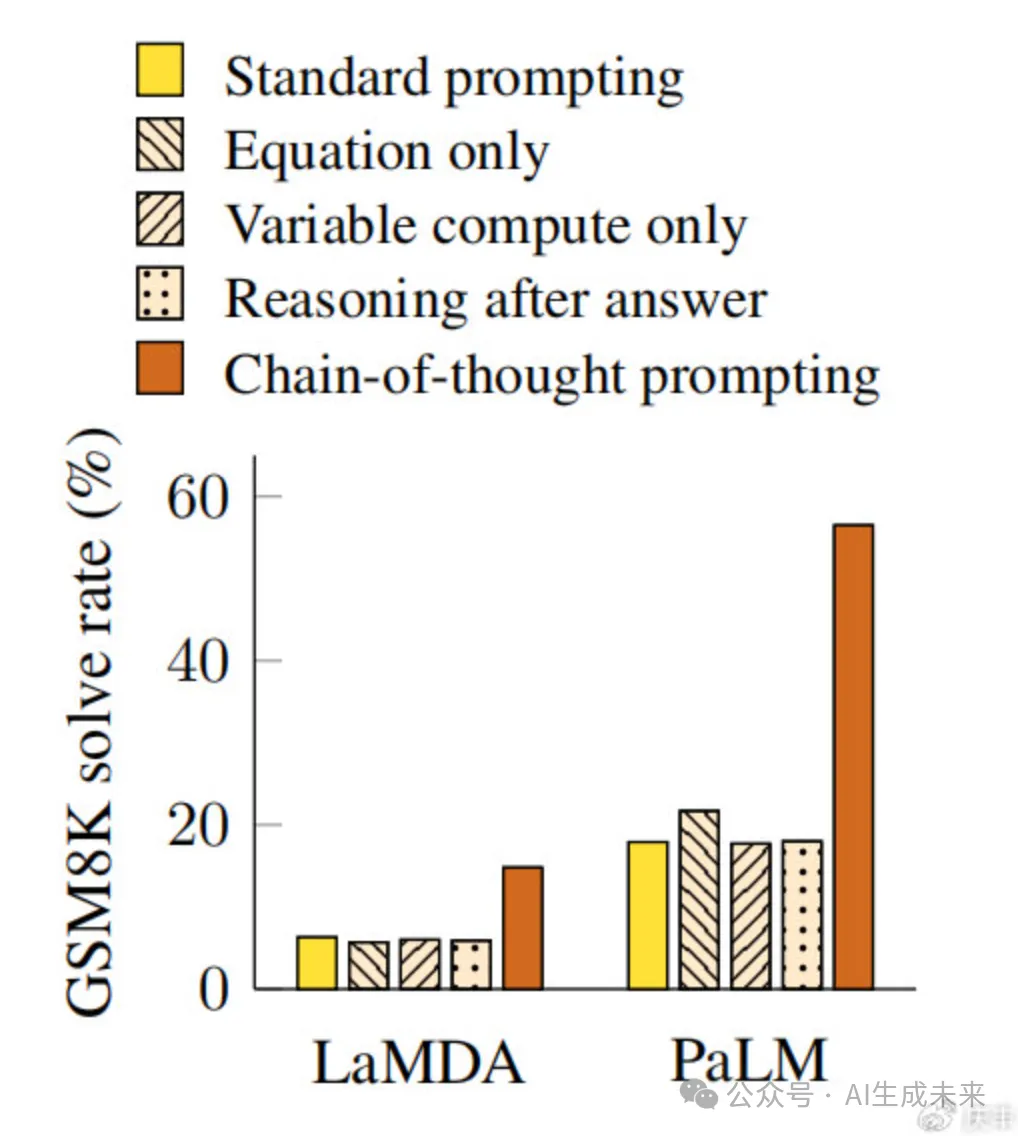

圖5:LaMDA 137B和PaLM 540B不同刺激變化的消融研究。其他數據集的結果見附錄表6和表7

圖5顯示了一項消融研究,其中有三種不同的思路,如下所述。

僅方程式:

思維鏈提示可能有所幫助的一個原因是,它產生了要評估的數學方程,因此我們測試了一種變體,在這種變體中,模型在給出答案之前只被提示輸出一個數學方程。圖5顯示,僅提示方程式對GSM8K沒有多大幫助,這意味著問題的語義在GSM8K中,如果沒有思維鏈中的自然語言推理步驟,直接翻譯成方程式太具有挑戰性了。然而,對于一步或兩步問題的數據集,我們發現僅提示方程式確實可以提高性能,因為方程式可以很容易地從問題中推導出來(見附錄表6)。

僅變量計算:

另一種直覺是,思維鏈允許模型在更難的問題上花費更多的計算(即中間令牌)。為了將變量計算的影響與思維鏈推理隔離開來,我們測試了一種配置,在這種配置中,模型被提示輸出一個點序列(…),該點序列等于解決問題所需的方程中的字符數。這種變體的表現與基線大致相同,這表明變量計算本身并不是思維鏈提示成功的原因,而且通過自然語言表達中間步驟似乎是有用的。

答案后的思考鏈:

思維鏈提示的另一個潛在好處可能是,這種提示使模型能夠更好地獲取預訓練期間獲得的相關知識。因此,我們測試了一種替代配置,在這種配置中,思維鏈提示僅在答案之后給出,從而隔離模型是否真正依賴于產生的思維鏈來給出最終答案。這種變體的表現與基線大致相同,這表明思維鏈中體現的順序推理不僅有助于激活知識。

3.4、思維鏈的穩健性

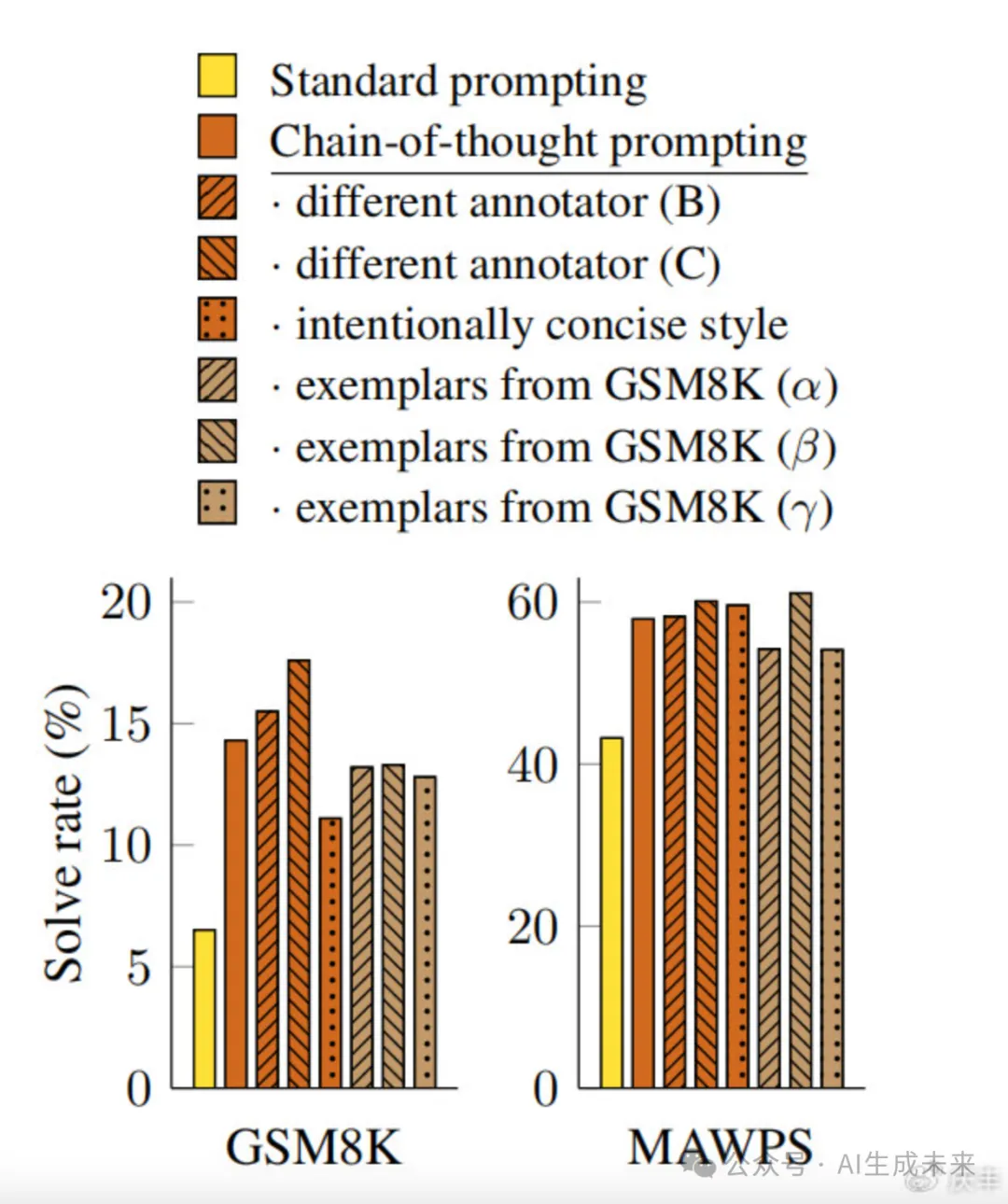

對樣本的敏感性是提示方法的關鍵考慮因素。例如,改變少數樣本的排列可能會導致GPT-3在SST-2上的準確度從接近機會(54.3%)到接近現有技術(93.4%)(趙等人,2021)。在最后一小節中,我們評估了對不同注釋者編寫的思維鏈的魯棒性。除了上述使用注釋者A編寫的思維鏈的結果外,本文的另外兩位合著者(注釋者B和C)還獨立地為相同的少數鏡頭示例編寫了思維鏈(如附錄H所示)。注釋者A還按照Cobbe等人(2021)給出的解決方案風格,寫了另一條比原文更簡潔的思路。

圖6顯示了GSM8K和MAWPS上LaMDA 137B的這些結果(其他數據集的消融結果見附錄表6/表7)。盡管不同的思維鏈注釋之間存在差異,正如使用基于范例的提示時所預期的那樣(Le Scao和Rush,2021;Reynolds和McDonnell,2021;趙等人,2021),但所有的思維鏈提示都大大超出了標準基線。這一結果表明,思維鏈的成功使用并不取決于特定的語言風格。

圖6:思維鏈提示對于不同的提示檢查樣本(如預期的那樣)有差異,但對于各種注釋者和不同的示例,其表現優于標準提示。

為了確認成功的思維鏈提示對其他樣本集也有效,我們還對從獨立來源GSM8K訓練集中隨機抽取的三組八個樣本進行了實驗(該數據集中的樣本已經包括了像思維鏈這樣的推理步驟)。圖6顯示,這些提示的表現與我們手動編寫的示例相當,也大大優于標準提示。

除了對注釋器、獨立編寫的思維鏈、不同的示例和各種語言模型的魯棒性外,我們還發現,算術推理的思維鏈提示對不同的示例順序和不同數量的示例具有魯棒性(見附錄A.2)。

4、常識推理

雖然思維鏈特別適合數學應用題,但思維鏈基于語言的本質,實際上使其適用于廣泛的常識推理問題,這些問題涉及在一般背景知識的假設下對物理和人類交互的推理。常識推理是與世界互動的關鍵,仍然超出了當前自然語言理解系統的能力范圍。

基準:

我們考慮了五個數據集,涵蓋了各種常識推理類型。流行的CSQA(Talmor等人,2019)提出了關于世界的常識性問題,涉及復雜的語義,通常需要先驗知識。StrategyQA(Geva等人,2021)要求模型推斷出多跳策略來回答問題。我們從BIG bench合作中選擇了兩個專門的評估集(2021年):日期理解,涉及從給定的上下文中推斷日期,以及運動理解,涉及確定與運動相關的句子是合理的還是不合理的。最后,SayCan數據集(Ahn等人,2022)涉及將自然語言指令映射到離散集合中的機器人動作序列。圖3顯示了所有數據集的思維鏈注釋示例。

提示:

我們遵循與前一節相同的實驗設置。對于CSQA和StrategyQA,我們從訓練集中隨機選擇示例,并手動構建思維鏈,讓他們使用盡可能少的樣本示例。這兩個大型工作臺任務沒有訓練集,因此我們選擇了前十個示例作為評估集中的示例,作為評估集中其余部分的少量樣本示例和報告編號。對于SayCan,我們使用了Ahn等人(2022)使用的訓練集中的六個例子,以及手動組成的思維鏈。

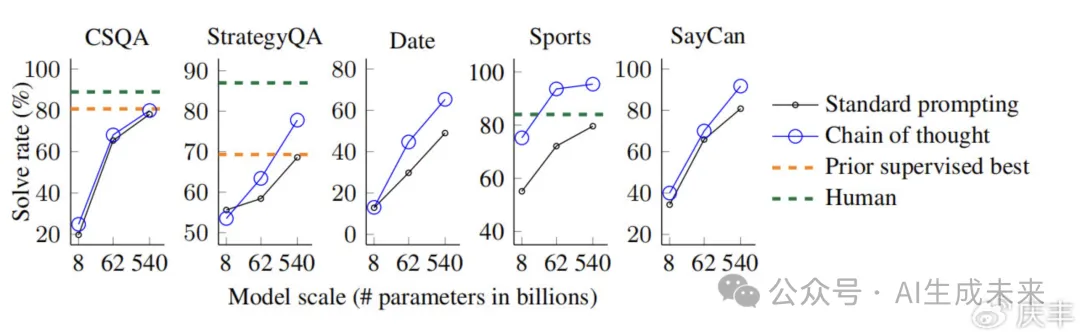

結果:

圖7突出顯示了PaLM的這些結果(LaMDA、GPT-3和不同模型量表的完整結果如表4所示)。對于所有任務,擴大模型大小可以提高標準提示的性能;思維鏈提示帶來了進一步的收益,其中PaLM 540B的改進似乎是最大的。在思維鏈的推動下,PaLM 540B相對于基線取得了強勁的表現,在StrategyQA上超越了先前的技術水平(75.6%對69.4%),在運動理解方面超越了獨立的體育愛好者(95.4%對84%)。

圖7:思維鏈提示也提高了語言模型的常識推理能力。這里顯示的語言模型是PaLM。之前的最佳數字來自CSQA(Talmor等人,2019)和StrategyQA(Geva等人,2021)的排行榜(截至2022年5月5日,僅限單一型號)。使用不同大小的LaMDA、GPT-3和PaLM的其他結果如表4所示。

這些結果表明,思維鏈提示也可以提高需要一系列常識推理能力的任務的性能(盡管請注意,CSQA的收益很小)。

5、符號推理

我們的最終實驗評估考慮了符號推理,這對人類來說很簡單,但對語言模型來說可能具有挑戰性。我們表明,思維鏈提示不僅使語言模型能夠執行符號推理任務(這在標準提示設置中具有挑戰性),而且有助于對推理時間輸入進行長度泛化,比少數示例中看到的更長。

任務:

我們使用以下兩個玩具任務:

?最后一個字母連接。

此任務要求模型連接名稱中單詞的最后一個字母(例如,“Amy Brown”→“yn”)。這是一個更具挑戰性的首字母連接版本,語言模型已經可以在沒有思維鏈的情況下執行。

我們通過隨機連接姓名普查數據中前一千個名字和姓氏中的名字來生成全名。

?硬幣翻轉。

這項任務要求模型回答,在人們拋硬幣或不拋硬幣后,硬幣是否仍然朝上(例如,“硬幣朝上。菲比拋硬幣。奧斯瓦爾多沒有拋硬幣。硬幣還在漲嗎?”→ “否”)。

由于這些符號推理任務的構造是明確的,對于每項任務,我們考慮一個域內測試集和一個域外(OOD)測試集,域內測試集中的示例的步驟數與訓練/少鏡頭示例相同,域外測試集的評估示例的步數比示例中的多。對于最后一個字母連接,該模型只看到包含兩個單詞的名稱示例,然后對包含3個和4個單詞的姓名執行最后一個字符連接。我們對拋硬幣任務中的潛在翻轉次數也做了同樣的操作。我們的實驗裝置使用與前兩節相同的方法和模型。我們再次手動為每個任務的幾個鏡頭示例構建思維鏈,如圖3所示。

結果:

PaLM的域內和OOD評估結果如圖8所示,LaMDA的結果如附錄表5所示。使用PaLM 540B,思維鏈提示導致幾乎100%的解決率(請注意,標準提示已經解決了PaLM 540的拋硬幣問題,但不適用于LaMDA 137B)。請注意,這些領域內評估是“玩具任務”,因為在少數示例中,思維鏈已經提供了完美的解決方案結構;模型所要做的就是對測試時間示例中的新符號重復相同的步驟。然而,小模型仍然失敗了——對這三個任務中看不見的符號進行抽象操作的能力只出現在100B模型參數的規模上。

對于OOD評估,標準提示對這兩個任務都失敗了。在思維鏈提示下,語言模型實現了向上縮放曲線(盡管性能低于域內設置)。因此,思維鏈提示有助于對足夠規模的語言模型進行超越可見思維鏈的長度泛化。

6、討論

我們探索了思維鏈提示作為一種在大型語言模型中引發多步推理行為的簡單機制。我們首先看到,思維鏈提示在算術推理方面大大提高了性能,產生的改進比消融強得多,對不同的注釋器、示例和語言模型也很穩健(第3節)。

接下來,常識推理實驗強調了思維鏈推理的語言性質如何使其普遍適用(第4節)。最后,我們表明,對于符號推理,思維鏈提示有助于OOD泛化到更長的序列長度(第5節)。在所有實驗中,思維鏈推理都是通過提示現成的語言模型來引發的。在撰寫本文的過程中,沒有對語言模型進行微調。

由于模型規模而出現的思維鏈推理一直是一個流行的主題(Wei等人,2022b)。對于許多標準提示具有平坦縮放曲線的推理任務,思維鏈提示會導致縮放曲線急劇增加。思維鏈提示似乎擴展了大型語言模型可以成功執行的任務集——換句話說,我們的工作強調了標準提示只提供了大型語言模塊能力的下限。這一觀察結果可能提出的問題比它回答的問題更多——例如,隨著模型規模的進一步擴大,我們還能期望推理能力提高多少?還有哪些提示方法可以擴展語言模型可以解決的任務范圍?

至于局限性,我們首先要證明,盡管思維鏈模仿了人類推理者的思維過程,但這并不能回答神經網絡是否真的是“推理”,這是一個懸而未決的問題。第二,盡管在少數搜索設置中,用思想鏈手動擴充樣本的成本是最小的,但這種注釋成本可能會阻礙微調(盡管這可能會通過合成數據生成或零樣本泛化來克服)。第三,不能保證正確的推理路徑,這可能會導致正確和錯誤的答案;改進語言模型的事實世代是未來工作的一個開放方向。最后,只有在大模型尺度上才出現思維鏈推理,這使得在現實世界的應用中服務成本很高;進一步的研究可以探索如何在較小的模型中誘導推理。

7、相關工作

這項工作受到了許多研究領域的啟發,我們在擴展的相關工作部分詳細介紹了這些領域。在這里,我們描述了兩個可能最相關的方向和相關論文。第一個相關方向是使用中間步驟來解決推理問題。Ling等人(2017)率先提出了通過一系列中間步驟使用自然語言推理來解決數學應用題的想法。他們的作品與使用正式語言進行推理的文學形成了鮮明的對比。Cobbe等人(2021)通過創建更大的數據集并使用它來微調預訓練的語言模型,而不是從頭開始訓練模型,對Ling等人(2017)進行了擴展。在程序綜合領域,Nye等人(2021)利用語言模型通過第一行到第行預測中間計算結果來預測Python程序的最終輸出,并表明他們的逐步預測方法比直接預測最終輸出表現更好。

當然,本文也與最近關于提示的大量工作密切相關。自從Brown等人(2020)提出的少鏡頭提示普及以來,有幾種通用的方法 提高了模型的提示能力,例如自動學習提示(Lester等人,2021)或為模型提供描述任務的指令(Wei等人,2022a;Sanh等人,2022;Ouyang等人,2022)。盡管這些方法改進或增強了提示的輸入部分(例如,添加到輸入前的指令),但我們的工作采用了用思維鏈增強語言模型輸出的正交方向。

8、結論

我們探索了思維鏈提示作為一種簡單且廣泛適用的方法來增強語言模型中的推理。通過對算術、符號和常識推理的實驗,我們發現思維鏈推理是模型尺度的一種涌現特性,它允許足夠大的語言模型執行原本具有平坦尺度曲線的推理任務。

拓寬語言模型可以執行的推理任務的范圍,將有望激發基于語言的推理方法的進一步研究。

本文轉自 AI生成未來 ,作者:慶豐