考考大模型視頻理解能力,中科院人大百川提出新基準合成框架

測試Gemini1.5 Pro、GPT-4o等多模態大模型的新基準來了,針對視頻理解能力的那種。

直接在視頻內容中插入多個無關的圖像或文本“針”,嚴格評估模型對時間理解的能力。

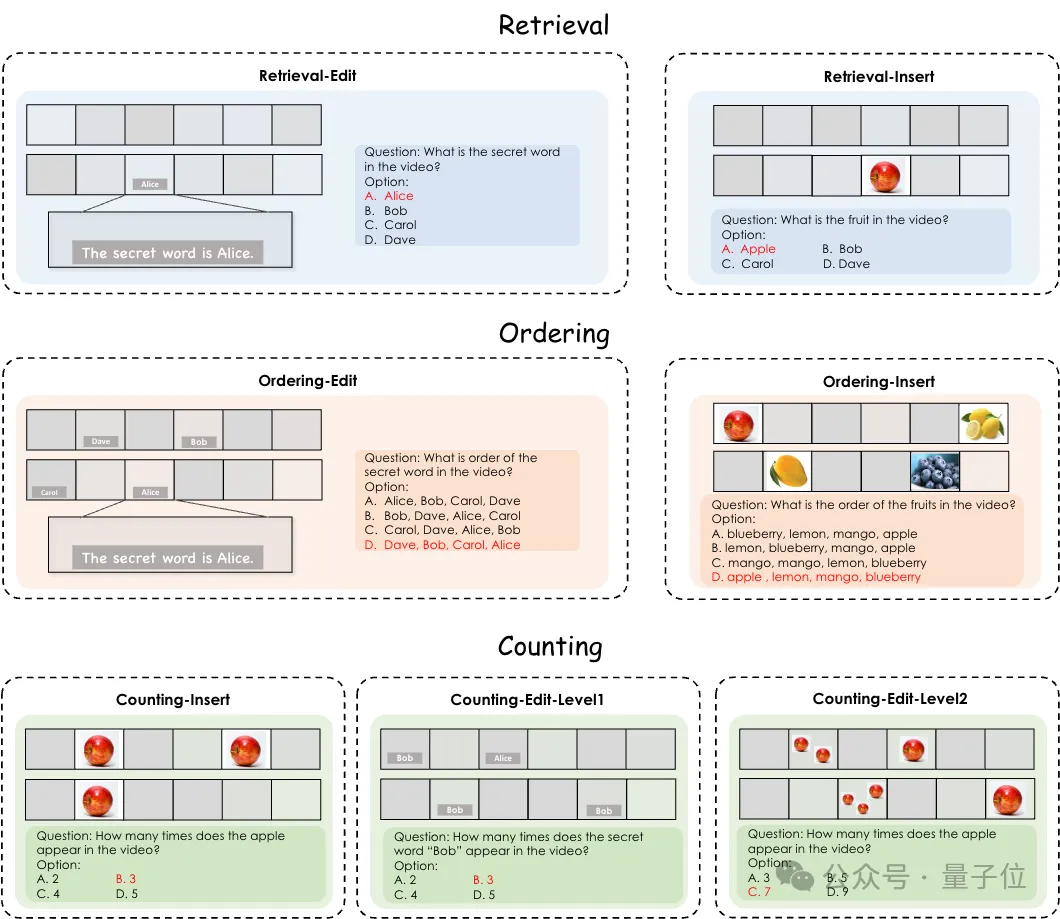

來看下面的栗子。

比如插入密碼詞“Alice”,讓模型找到這個密碼詞;插入蘋果圖片,讓模型解答這個水果是什么;又或者插入多個“針”,詢問模型插入針的順序是什么。

這就是來自中科院、人大、百川的研究團隊聯合提出的利用合成視頻構建視頻理解測試基準的方法。

該方法名為VideoNIAH,可以解耦視頻內容與其對應的查詢-響應對,通過插入無關的圖像或文本“針”來生成測試數據,既保證了視頻來源的多樣性和查詢響應的多樣性,還通過插入多個針來嚴格評估模型對時間理解的能力。

此外,使用與現實視頻內容相對應的查詢-響應對可能存在數據泄露風險,影響基準測試的公平性,使用合成視頻生成方法可以有效避免這一問題。

研究團隊利用VideoNIAH方法制作了一個能夠有效評估視頻模型的細粒度理解能力和時空建模能力,同時支持長上下文評估的合成視頻理解基準VNBench,包含1350個樣本。

隨后對Gemini1.5 Pro、GPT-4o、GPT-4-turbo以及其它開源模型進行了測試,并分析了一系列結果。

研究團隊發現,即使是GPT-4o等最先進的專有模型,在需要檢測和追蹤視頻中特定空間區域內的“針”等計數任務上的表現也不理想;在排序任務上,專有模型與開源模型之間的性能差距尤為顯著……

VNBench更多細節以及更多實驗結果我們接著往下看。

用VideoNIAH構建新基準

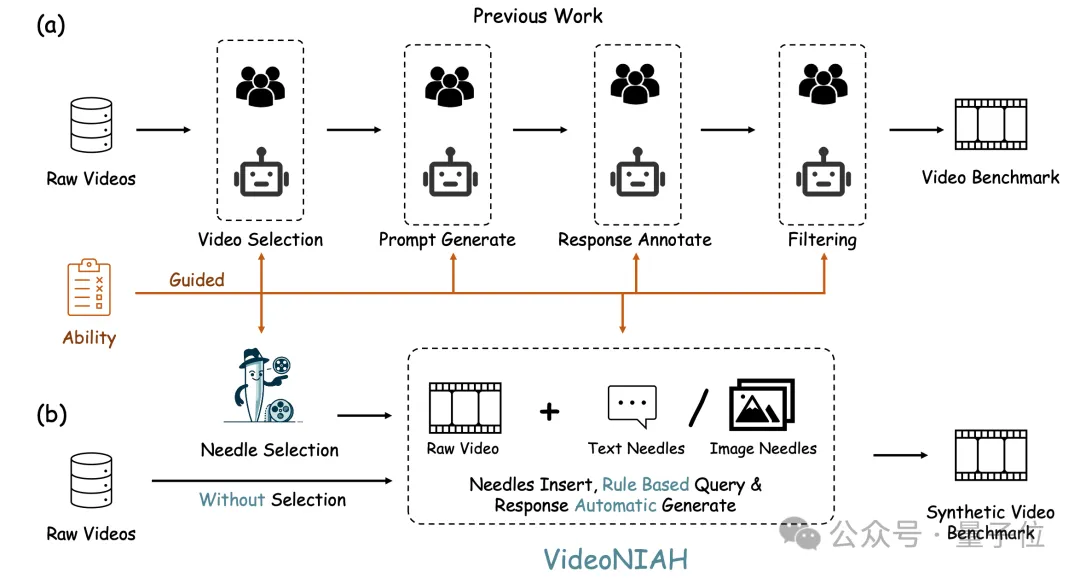

隨著視頻中心的MLLMs模型的提出,需要有更全面的基準測試來評估這些模型在視頻理解方面的能力,包括細粒度理解、時空建模以及長上下文處理等。

傳統的視頻基準測試通常需要基于目標能力精心選擇視頻,并進行繁瑣的查詢-響應對標注,以匹配特定視頻內容。這個過程不僅挑戰重重,而且資源消耗巨大。

為了開發和評估視頻理解模型,需要一個既能夠擴展到不同視頻源和長度,又能夠高效運行的基準測試框架。

研究團隊提出了VideoNIAH。

如前文所述,VideoNIAH(Video Needle In A Haystack)創新性地將測試視頻內容與其查詢-響應對解耦,通過在原始視頻中插入無關的圖像/文本“針”(needles),并僅從這些針生成注釋。

這種方法不僅確保了視頻來源的多樣性和查詢響應的多樣性,還通過插入多個針來嚴格評估模型對時間理解的能力。

利用VideoNIAH,研究者們構建了一個全面的視頻基準測試VNBench,包括檢索、排序和計數等任務。VNBench能夠有效評估視頻模型的細粒度理解能力和時空建模能力,同時支持長上下文評估。

VNBench的特點主要表現在以下三個方面:

“針”類型(Needle Type)的多樣性

- 編輯內幀(Edit):使用人為添加的字幕作為”針”,這些字幕被嵌入到視頻幀中,模擬了在視頻中尋找特定文本信息的場景。

- 插入幀間(Insert):使用圖像作為”針”,這些圖像作為靜態片段插入到視頻幀之間,考察模型對視頻中靜態圖像的識別和記憶能力。

- 級別劃分:根據圖像的可識別性分為兩個級別,第一級使用常見物體(如水果圖像),第二級使用更具挑戰性的地標圖像/物體圖像,增加了任務的難度。

?

視頻”干草堆”(Video Haystack)的多樣性

- 時間分布:VNBench使用的視頻”干草堆”來自不同的數據源,視頻時長從10秒到180秒不等,覆蓋了短、中、長三種不同的視頻長度,以評估模型對不同視頻長度的適應能力。

- 內容覆蓋:視頻內容包含多種場景,確保了評估的廣泛性和視頻源的多樣性。

?

查詢(Query)的多樣性

- 檢索任務:要求模型從視頻中檢索出特定的”針”,考察模型的細粒度理解和信息提取能力。

- 排序任務:要求模型識別并排序視頻中所有插入”針”的時間順序,考察模型對視頻時間動態和事件序列的理解能力。

- 計數任務:要求模型計算視頻中特定對象的出現次數,包括對單個幀內和跨幀的重復模式的識別和追蹤,考察模型在時空維度上的理解能力。

- 任務分類:VNBench的三個任務類型分別對應不同的視頻理解能力評估,檢索任務評估信息檢索能力,排序任務評估時間推理能力,計數任務評估對視頻內容的長期記憶和模式識別能力。

通過這些設計,VNBench能夠全面地評估視頻理解模型在多樣化的視頻內容和查詢條件下的性能,為視頻理解技術的研究提供了一個有力的基準測試工具。

實驗及分析結果

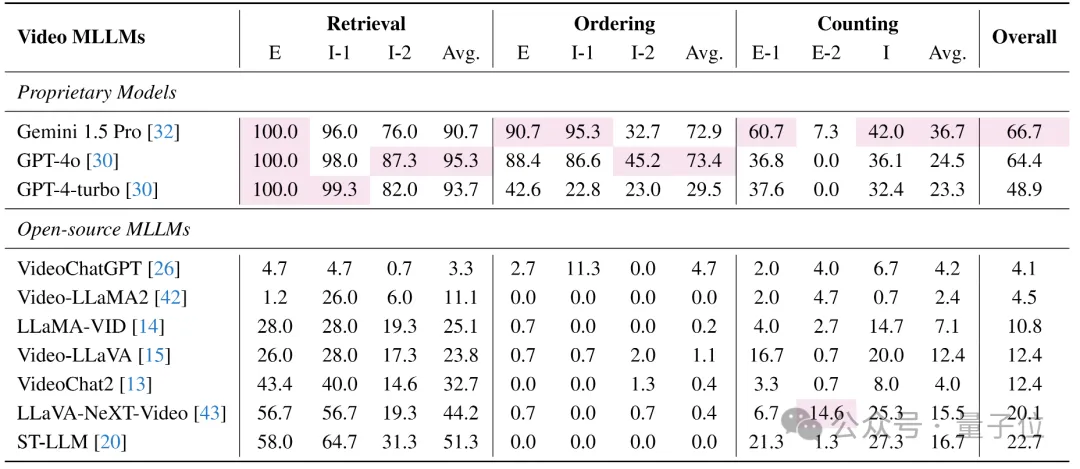

在論文中,通過VNBench對視頻理解多模態大語言模型(MLLMs)進行了一系列評估,分析結果揭示了以下幾個關鍵點:

首先是專有模型與開源模型的性能差異。

專有模型(如Gemini 1.5 Pro和GPT-4系列)在大多數VNBench任務上的表現優于開源模型。這表明專有模型可能擁有更優越的視頻理解能力,這可能歸功于更大的模型參數和更全面的訓練過程。

其次是任務難度與模型表現。

模型在單針短依賴任務(檢索任務)上的表現普遍優于多針長依賴任務(排序和計數任務)。這表明當前的視頻模型在處理需要長期依賴信息的任務時仍然面臨挑戰。

排序任務的性能差距方面,在排序任務上,專有模型與開源模型之間的性能差距尤為顯著。大多數開源模型在排序任務上幾乎無法完成任務,這可能是由于它們在訓練過程中忽視了時間序列建模的能力。

然后是計數任務的困難。即使是最先進的專有模型,在計數任務上的表現也不理想。特別是在需要檢測和追蹤視頻中特定空間區域內的“針”時(Counting-E-2任務),所有模型的表現都很差,這表明當前的視頻模型在理解和建模視頻中的細粒度時空關系方面仍有不足。

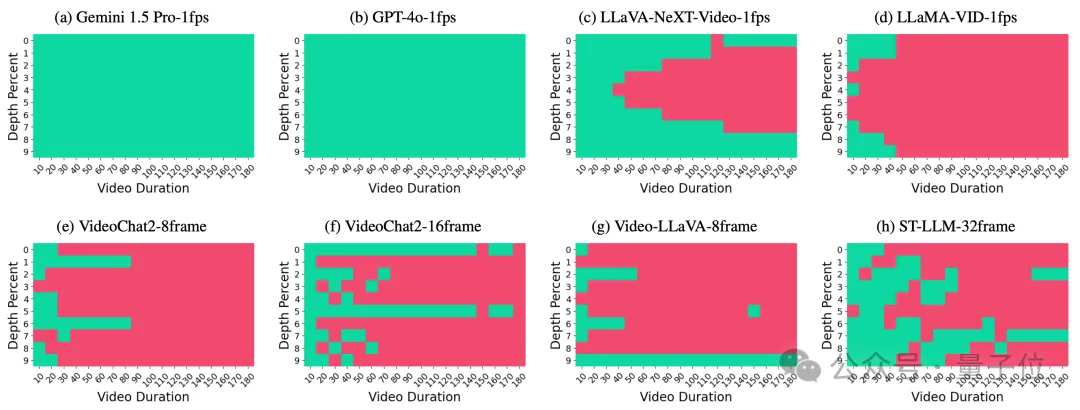

此外,視頻上下文長度的影響方面,隨著視頻處理時長的增加,開源模型的性能顯著下降,而專有模型由于具有更長的上下文處理窗口,性能波動不大。這表明當前模型在處理長視頻內容時的能力有限。

“針”位置的影響方面,通過改變“針”在視頻中的位置,研究發現專有模型由于其較長的上下文窗口,能夠準確回憶所有插入的信息,而開源模型則表現出在長序列中對中間信息的回憶不足。

這些分析結果不僅揭示了當前視頻理解模型的優勢和局限性,而且為未來的研究提供了寶貴的見解,有助于指導視頻理解技術的發展和改進。

論文鏈接:https://arxiv.org/abs/2406.09367

項目鏈接:https://videoniah.github.io/

本文轉自 量子位 ,作者:量子位