NVIDIA 聯合團隊提出長視頻理解的前沿技術BREASE,新框架連接情節和語義

隨著互聯網和社交媒體平臺上視頻內容的爆炸性增長,視頻理解技術的重要性日益凸顯。視頻理解不僅僅是對視頻內容的簡單分類或標簽化,而是深入分析視頻中的動作、場景、情節和語義信息。這項技術在多個領域具有廣泛的應用前景,包括視頻摘要、內容檢索、內容審核、版權保護和智能推薦等。

在信息時代,視頻理解技術扮演著越來越重要的角色。隨著視頻內容的激增,如何有效地理解和處理這些內容成為了一個關鍵問題。視頻理解不僅僅是對視頻進行分類或標注,而是需要深入分析視頻中的動作、場景、情節和語義信息,這項技術在多個領域具有廣泛的應用前景。

視頻摘要方面,通過自動生成視頻摘要,用戶可以快速獲取視頻的核心內容,節省時間和精力。這在新聞、教育和娛樂等領域尤為重要。內容檢索方面,視頻理解技術可以幫助用戶通過視頻內容進行搜索和檢索,提高信息獲取的效率。例如,在大型視頻庫中快速找到相關視頻片段。內容審核方面,自動檢測和過濾不良內容,保障平臺內容的安全性。這對于社交媒體平臺和視頻分享網站尤為重要,可以有效防止不良信息的傳播。版權保護方面,通過識別和管理視頻內容的版權信息,防止侵權行為的發生。這對于保護創作者的權益和維護市場秩序具有重要意義。智能推薦方面,根據用戶的觀看歷史和偏好,推薦相關視頻內容,提升用戶體驗。這在流媒體平臺和視頻分享網站中得到了廣泛應用。

目前,大多數視頻理解研究主要集中在短視頻的處理上,這些方法通常依賴于卷積神經網絡(CNN)和Transformer等模型。然而長視頻理解面臨著更大的挑戰,主要包括時間復雜性、語義理解和內存計算限制等問題。

長視頻包含大量幀,處理這些幀需要高效的時間序列分析方法。現有的方法在處理長視頻時,往往無法有效應對時間復雜性的問題。長視頻通常包含復雜的敘事結構和高層次的語義信息,需要對視頻中的高層次概念和敘事結構進行深刻理解。然而,現有的方法在語義理解方面表現不足。處理長視頻需要大量的計算資源和內存,現有方法在這方面往往表現不足,難以在實際應用中推廣。

盡管一些研究嘗試將短視頻理解的方法擴展到長視頻,但這些方法通常未能充分考慮長視頻的獨特特性,導致性能提升有限。例如,傳統的方法往往將長視頻視為多個短視頻的簡單拼接,忽略了長視頻中情節和語義的連續性和復雜性。

為了填補現有方法在長視頻理解中的空白,NVIDIA、國立臺灣大學和國立清華大學(中國臺灣)的聯合團隊提出了一個新的框架——BREASE(BRidging Episodes And SEmantics)。該框架的設計靈感來自于人類的認知過程,旨在通過模擬情節記憶積累和語義知識的結合,更準確地理解長視頻內容。

BREASE框架的主要目標是開發一個高效的情節壓縮器(Episodic COmpressor,ECO),能夠從微觀到半宏觀層面聚合關鍵表示,捕捉視頻中的動作序列。ECO通過模擬人類的情節記憶積累過程,有效地將視頻內容分解為多個情節單元,從而提高模型的理解能力。此外,BREASE還提出了一個語義檢索器(Semantics reTRiever,SeTR),通過關注更廣泛的上下文,增強模型對視頻內容的理解,顯著減少特征維度,同時保留相關的宏觀信息。SeTR通過提取視頻中的高層次語義信息,幫助模型更好地理解視頻的整體結構和內容。

通過這兩個關鍵組件,BREASE框架在多個長視頻理解基準上實現了最先進的性能,顯著超越了現有方法。論文的研究目標是通過BREASE框架,解決長視頻理解中的時間復雜性、語義理解和內存計算限制等問題,為視頻理解技術的發展提供新的思路和方法。大量實驗表明,BREASE 在零樣本和全監督設置的多個長視頻理解基準中均實現了最佳性能。項目頁面和代碼位于:https://joslefaure.github.io/assets/html/hermes.html。

這項研究由來自不同機構的專家團隊合作完成,成員有來自國立臺灣大學的Gueter Josmy Faure、Jia-Fong Yeh、Hung-Ting Su和Winston H. Hsu,他們在視頻理解和計算機視覺領域有著豐富的研究經驗。Winston H. Hsu不僅是國立臺灣大學的教授,還在Mobile Drive Technology擔任重要職務,負責項目的整體協調和技術指導。來自NVIDIA的Min-Hung Chen,專注于深度學習和視頻理解技術的研究,為團隊帶來了工業界的先進技術和實踐經驗。國立清華大學的Shang-Hong Lai,專注于計算機視覺和圖像處理領域的研究,為團隊提供了堅實的學術支持。

這個多機構合作團隊結合了學術界和工業界的力量,致力于推進長視頻理解的研究。通過他們的共同努力,BREASE框架在長視頻理解領域取得了顯著的進展,為視頻理解技術的發展提供了新的思路和方法。

相關工作

在視頻理解領域,研究者們已經在多個方向上取得了顯著進展。

動作識別是視頻理解中的一個核心任務,主要關注在短視頻片段中識別特定的動作。早期的研究主要依賴于卷積神經網絡(CNN),例如使用3D卷積來捕捉視頻中的時空特征。隨著技術的發展,研究者們逐漸引入了時間卷積和其他更復雜的模型來提高識別精度。

近年來,基于Transformer的模型在動作識別中表現出色。例如,研究者們通過引入自注意力機制,使模型能夠更好地捕捉視頻中的長距離依賴關系。這些模型在多個動作識別基準上取得了最先進的性能,展示了其在處理復雜視頻數據方面的潛力。

視頻問答(VQA)是視頻理解中的另一個重要任務,旨在回答與視頻內容相關的問題。這需要模型對視頻中的視覺信息和文本信息有深刻的理解。為此,研究者們開發了多個數據集,如ActivityNet-QA和MovieChat-1k,這些數據集為評估模型在視頻問答任務中的表現提供了基準。

在VQA任務中,模型不僅需要識別視頻中的物體和動作,還需要理解視頻的上下文和敘事結構。這通常涉及到多模態學習,即結合視覺和文本信息進行聯合建模。近年來,隨著大規模預訓練模型的出現,VQA任務的性能得到了顯著提升。

與短視頻相比,長視頻理解面臨著更多的挑戰。長視頻通常包含復雜的敘事結構和大量的幀,這使得處理和理解這些視頻變得更加困難。為了應對這些挑戰,研究者們開發了多個專門用于長視頻理解的數據集,如LVU、COIN、Breakfast和MovieChat。

傳統的方法往往將長視頻視為多個短視頻的簡單拼接,忽略了長視頻中情節和語義的連續性和復雜性。為了更好地理解長視頻,研究者們提出了多種方法,包括記憶技術和狀態空間模型(SSM),這些方法能夠更有效地處理長時間跨度的視頻數據。

最近,大語言模型(LLM)在視頻理解中的應用引起了廣泛關注。這些模型通過將視頻內容轉化為文字,能夠更好地理解視頻的語義信息。例如,在視頻字幕生成、視頻問答和動作分類等任務中,LLM展示了其強大的能力。

一些研究提出了使用記憶技術處理大量視頻內容的框架,這些框架能夠有效地管理視頻中的時間依賴信息。此外,研究者們還探索了如何利用LLM進行長視頻理解,通過結合視覺和文本信息,進一步提升模型的性能。

視頻理解領域的研究正在不斷發展,新的方法和技術不斷涌現。通過結合情節記憶和語義知識,BREASE框架為長視頻理解提供了一個新的思路,展示了其在處理復雜視頻數據方面的潛力。

方法

BREASE的設計理念

BREASE(BRidging Episodes And SEmantics)框架的設計靈感來自于人類的認知過程,旨在通過模擬情節記憶積累和語義知識的結合,更準確地理解長視頻內容。該框架的核心理念是將視頻內容分解為多個情節單元,并通過語義信息進行強化,從而提高模型的理解能力。BREASE框架由多個模塊組成,每個模塊在視頻處理的不同階段發揮關鍵作用。

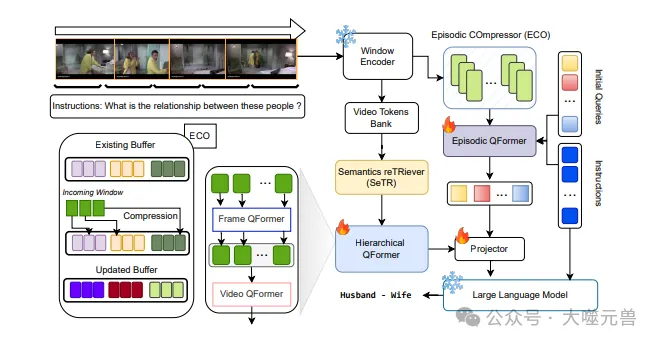

圖1:框架概述。逐窗口流式傳輸視頻,并使用凍結的ViT提取特征。每個窗口特征都由ECO(如圖左下所示)以在線方式處理,在此過程中丟棄冗余,并保留傳遞給情節Q-Former的視頻片段。視頻令牌庫包含每個窗口的特征,SeTR僅選擇高級信息傳遞到分層幀以對Q-Former進行排序。然后將情節和高級表示連接起來,然后饋送到凍結的LLM,LLM按照指令輸出文本。

視頻編碼的初步處理

BREASE框架的第一步是對視頻進行編碼處理。為了處理任意長度的視頻,首先需要指定要提取的幀數,將視頻分割成若干不重疊的窗口。每個窗口的特征由ViT-G/14模型逐步編碼,提取出視頻數據的特征表示。這些特征表示將作為后續處理的輸入,為情節壓縮器(ECO)提供基礎數據。

情節壓縮器的工作機制

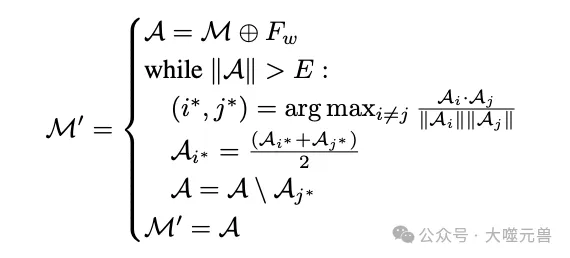

ECO(Episodic COmpressor)是BREASE框架中的關鍵組件之一,負責將視頻內容分解為多個情節單元。ECO通過維護一個最大容量為E的記憶緩沖區,接收窗口特征后,檢查緩沖區是否有足夠帶寬。如果有,則直接連接;否則進行壓縮。ECO的核心是通過計算幀特征的余弦相似度,合并最相似的幀,直到滿足大小約束。這樣可以有效地減少冗余信息,保留視頻中的關鍵情節。

其中M是現有緩沖區,Fw表示w幀特征的傳入窗口,A是連接的緩沖區和新窗口,∥A?A的大小。總結方程式(2),Ai·Aj Ai Aj計算幀特征Ai和Aj之間的余弦相似度,arg-maxi?=j找到余弦相似度最高的幀對,(Ai?+Aj?)2組合最相似的幀,A\Aj*刪除幀Aj*合并后的A。重復該過程,直到A的大小在允許的最大事件E范圍內,并且A成為新的緩沖區M′。

情節查詢變換器的作用

Episodic Q-Former使用與原始Q-Former相同的架構,通過自注意力和交叉注意力機制處理初始查詢和視覺表示。具體來說,Episodic Q-Former首先對初始查詢進行自注意力處理,然后與ECO提供的視覺表示進行交叉注意力處理。經過這一過程,查詢被增強,并通過類似ECO的過程合并相似查詢,形成高信息密度的情節。這有助于在整個視頻中保持查詢的數量恒定,提高模型的處理效率。

語義檢索器的功能

SeTR(Semantics reTRiever)是BREASE框架中的另一個關鍵組件,負責從視頻特征中提取高層次的語義信息。SeTR通過歸一化特征、分組、計算相似度分數并合并最相似的幀,減少幀數,保留最相關的特征。具體來說,SeTR首先對視頻特征進行歸一化處理,然后將幀分為兩組,計算兩組幀之間的相似度分數,并合并最相似的幀。這樣可以有效地減少特征維度,同時保留視頻中的關鍵語義信息。

將視頻表示轉化為自然語言輸出

在BREASE框架中,SeTR提取的語義表示通過層次化Q-Former處理后,與Episodic Q-Former的輸出連接,投射到大語言模型(如Vicuna-7B)的輸入空間。大語言模型根據提供的指令,生成所需的自然語言輸出。這一過程將視頻的視覺表示轉化為自然語言描述,使得模型能夠回答與視頻內容相關的問題,生成視頻字幕,或進行其他形式的文本生成任務。

通過這些模塊的協同工作,BREASE框架能夠高效地處理和理解長視頻內容,顯著提高了視頻理解的性能和準確性。

實驗與結果

LVU和MovieChat數據集

在本研究中,BREASE框架的性能在兩個主要數據集上進行了評估:LVU和MovieChat。LVU數據集專注于電影內容和元數據,提供了豐富的長視頻分類任務。MovieChat數據集則是一個新引入的數據集,專門用于長視頻問答任務,涵蓋了電影中的對話和情節信息。這兩個數據集的選擇,旨在全面評估BREASE框架在不同長視頻理解任務中的表現。

在不同數據集上的表現

在實驗中,BREASE框架展示了其在長視頻理解任務中的卓越性能。通過對LVU和MovieChat數據集的測試,BREASE框架在多個基準上實現了最先進的結果,顯著超越了現有方法。

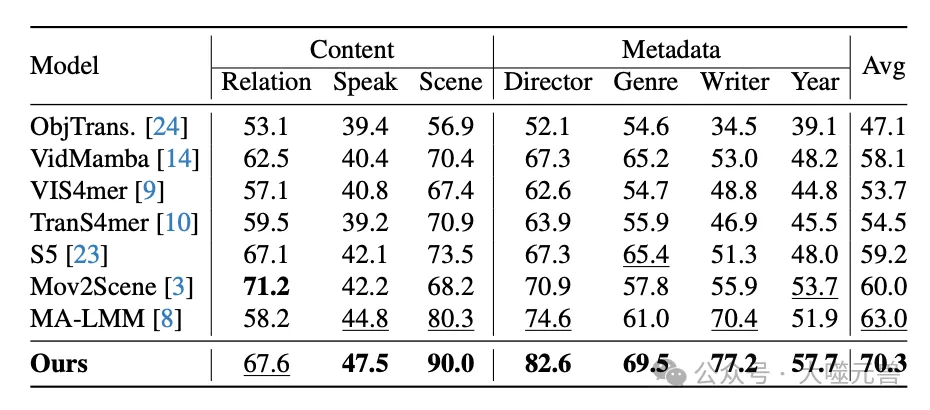

表1:LVU數據集的SOTA比較:該表顯示了各種模型的前1精度。最高分以粗體突出顯示,次高分以下劃線突出顯示。與其他方法中觀察到的微小增量改進不同,我們的模型表現出了顯著的性能飛躍,平均比其最接近的競爭對手高出7.3%。

分類準確率的提升

在LVU數據集上,BREASE框架的表現尤為突出。實驗結果顯示,BREASE在長視頻分類任務中的top-1分類準確率顯著提高了7.3%。這一顯著提升表明,BREASE框架在處理復雜電影內容和元數據時,能夠更好地捕捉和理解視頻中的關鍵情節和語義信息。

零樣本和完全監督場景下的表現

在MovieChat數據集上,BREASE框架同樣表現出色。在零樣本模式下,BREASE的準確率提高了14.9%,顯著超過了之前的最先進方法。此外,在完全監督場景下,BREASE框架通過對MovieChat訓練集進行一次訓練,進一步提升了模型的性能。這些結果表明,BREASE框架在處理長視頻問答任務時,能夠有效地理解和回答與視頻內容相關的問題。

ECO和SeTR的重要性分析

為了進一步驗證BREASE框架中各個組件的重要性,研究團隊進行了多次消融實驗,重點分析了ECO和SeTR的作用。

在ECO的重要性實驗中,結果表明,缺少ECO會導致模型性能顯著下降。具體來說,ECO通過有效地壓縮和聚合視頻中的情節信息,顯著提高了模型的理解能力。相比之下,使用隨機選擇特征或FIFO流式方法的替代策略,均未能達到ECO的效果。

在SeTR的重要性實驗中,結果顯示,移除SeTR會導致準確率下降5%。SeTR通過提取視頻中的高層次語義信息,幫助模型更好地理解視頻的整體結構和內容。相比之下,簡單的方法如最大池化和平均池化效果不如SeTR。

通過這些消融實驗,研究團隊驗證了ECO和SeTR在BREASE框架中的關鍵作用,進一步證明了BREASE框架在長視頻理解任務中的卓越性能。

BREASE框架在LVU和MovieChat數據集上的實驗結果,展示了其在長視頻理解任務中的強大能力。通過有效地結合情節記憶和語義信息,BREASE框架為長視頻理解提供了一個新的思路,顯著提升了視頻理解的性能和準確性。

討論

BREASE框架的創新點

BREASE框架在長視頻理解領域引入了多項創新,顯著提升了模型的性能和理解能力。首先,BREASE通過模擬人類的認知過程,將視頻內容分解為多個情節單元,并通過語義信息進行強化。這種方法不僅提高了模型對視頻內容的理解深度,還有效地減少了冗余信息。

Episodic COmpressor (ECO) 是BREASE框架中的關鍵組件之一。ECO通過維護一個記憶緩沖區,動態地壓縮和聚合視頻中的情節信息,保留了視頻中的關鍵情節。這種方法模擬了人類的情節記憶積累過程,使得模型能夠更好地捕捉視頻中的動作序列和情節變化。

Semantics reTRiever (SeTR) 則通過提取視頻中的高層次語義信息,增強了模型對視頻內容的理解。SeTR通過歸一化特征、分組、計算相似度分數并合并最相似的幀,減少了特征維度,同時保留了視頻中的關鍵語義信息。這種方法不僅提高了模型的處理效率,還增強了模型對視頻整體結構和內容的理解。

與現有方法的對比

在多個長視頻理解基準上,BREASE框架展示了其卓越的性能。與現有方法相比,BREASE在LVU和MovieChat數據集上的表現尤為突出。在LVU數據集上,BREASE的top-1分類準確率顯著提高了7.3%,展示了其在處理復雜電影內容和元數據時的強大能力。在MovieChat數據集上,BREASE在零樣本模式下的準確率提高了14.9%,顯著超過了之前的最先進方法。這些結果表明,BREASE框架在處理長視頻問答任務時,能夠有效地理解和回答與視頻內容相關的問題。

通過消融實驗,研究團隊進一步驗證了ECO和SeTR在BREASE框架中的關鍵作用。結果顯示,缺少ECO會導致模型性能顯著下降,而移除SeTR則會導致準確率下降5%。這些實驗結果進一步證明了BREASE框架在長視頻理解任務中的卓越性能。

在實際應用中的潛力

BREASE框架在實際應用中具有廣泛的潛力。首先,在視頻摘要方面,BREASE可以自動生成視頻摘要,幫助用戶快速獲取視頻的核心內容,節省時間和精力。這在新聞、教育和娛樂等領域尤為重要。其次,在內容檢索方面,BREASE可以通過視頻內容進行搜索和檢索,提高信息獲取的效率。例如,在大型視頻庫中快速找到相關視頻片段。

在內容審核方面,BREASE可以自動檢測和過濾不良內容,保障平臺內容的安全性。這對于社交媒體平臺和視頻分享網站尤為重要,可以有效防止不良信息的傳播。在版權保護方面,BREASE可以識別和管理視頻內容的版權信息,防止侵權行為的發生。這對于保護創作者的權益和維護市場秩序具有重要意義。

此外,BREASE還可以用于智能推薦,根據用戶的觀看歷史和偏好,推薦相關視頻內容,提升用戶體驗。這在流媒體平臺和視頻分享網站中得到了廣泛應用。總的來說,BREASE框架為長視頻理解提供了一個新的思路,展示了其在處理復雜視頻數據方面的強大能力和廣泛應用前景。

參考資料:https://arxiv.org/pdf/2408.17443