支持合成一分鐘高清視頻,華科等提出人類跳舞視頻生成新框架UniAnimate 精華

人類跳舞視頻生成是一項(xiàng)引人注目且具有挑戰(zhàn)性的可控視頻合成任務(wù),旨在根據(jù)輸入的參考圖像和目標(biāo)姿勢(shì)序列生成高質(zhì)量逼真的連續(xù)視頻。隨著視頻生成技術(shù)的快速發(fā)展,特別是生成模型的迭代演化,跳舞視頻生成任務(wù)取得了前所未有的進(jìn)展,并展示了廣泛的應(yīng)用潛力。

現(xiàn)有的方法可以大致分為兩組。第一組通常基于生成對(duì)抗網(wǎng)絡(luò)(GAN),其利用中間的姿勢(shì)引導(dǎo)表示來(lái)扭曲參考外觀,并通過(guò)之前扭曲的目標(biāo)生成合理的視頻幀。然而,基于生成對(duì)抗網(wǎng)絡(luò)的方法通常存在訓(xùn)練不穩(wěn)定和泛化能力差的問題,導(dǎo)致明顯的偽影和幀間抖動(dòng)。

第二組則使用擴(kuò)散模型(Diffusion model)來(lái)合成逼真的視頻。這些方法兼具穩(wěn)定訓(xùn)練和強(qiáng)大遷移能力的優(yōu)勢(shì),相較于基于 GAN 的方法表現(xiàn)更好,典型方法如 Disco、MagicAnimate、Animate Anyone、Champ 等。

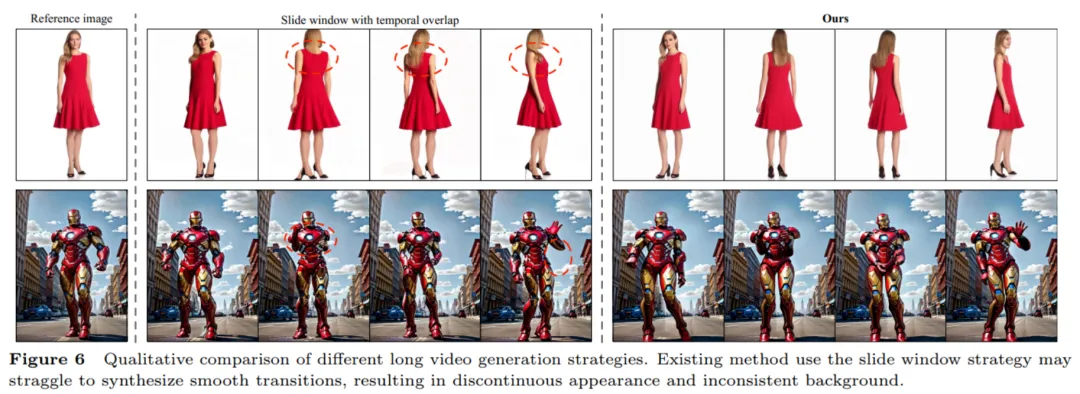

盡管基于擴(kuò)散模型的方法取得了顯著進(jìn)展,但現(xiàn)有的方法仍存在兩個(gè)限制:一是需要額外的參考網(wǎng)絡(luò)(ReferenceNet)來(lái)編碼參考圖像特征并將其與 3D-UNet 的主干分支進(jìn)行表觀對(duì)齊,導(dǎo)致增加了訓(xùn)練難度和模型參數(shù);二是它們通常采用時(shí)序 Transformer 來(lái)建模視頻幀之間時(shí)序依賴關(guān)系,但 Transformer 的復(fù)雜度隨生成的時(shí)間長(zhǎng)度成二次方的計(jì)算關(guān)系,限制了生成視頻的時(shí)序長(zhǎng)度。典型方法只能生成 24 幀視頻,限制了實(shí)際部署的可能性。盡管采用了時(shí)序重合的滑動(dòng)窗口策略可以生成更長(zhǎng)的視頻,但團(tuán)隊(duì)作者發(fā)現(xiàn)這種方式容易導(dǎo)致片段重合連接處通常存在不流暢的轉(zhuǎn)換和外貌不一致性的問題。

為了解決這些問題,來(lái)自華中科技大學(xué)、阿里巴巴、中國(guó)科學(xué)技術(shù)大學(xué)的研究團(tuán)隊(duì)提出了 UniAnimate 框架,以實(shí)現(xiàn)高效且長(zhǎng)時(shí)間的人類視頻生成。

- 論文地址:https://arxiv.org/abs/2406.01188

- 項(xiàng)目主頁(yè):https://unianimate.github.io/

方法簡(jiǎn)介

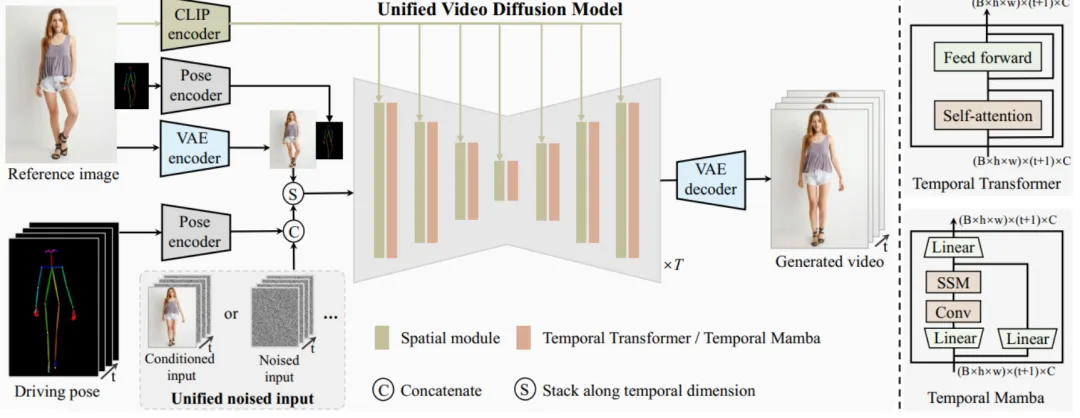

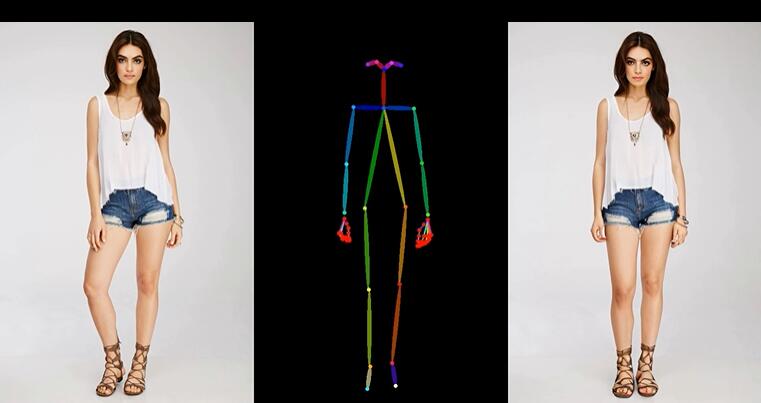

UniAnimate 框架首先將參考圖像、姿勢(shì)指導(dǎo)和噪聲視頻映射到特征空間中,然后利用統(tǒng)一的視頻擴(kuò)散模型(Unified Video Diffusion Model)同時(shí)處理參考圖像與視頻主干分支表觀對(duì)齊和視頻去噪任務(wù),實(shí)現(xiàn)高效特征對(duì)齊和連貫的視頻生成。

其次,研究團(tuán)隊(duì)還提出了一種統(tǒng)一的噪聲輸入,其支持隨機(jī)噪聲輸入和基于第一幀的條件噪聲輸入,隨機(jī)噪聲輸入可以配合參考圖像和姿態(tài)序列生成一段視頻,而基于第一幀的條件噪聲輸入(First Frame Conditioning)則以視頻第一幀作為條件輸入延續(xù)生成后續(xù)的視頻。通過(guò)這種方式,推理時(shí)可以通過(guò)把前一個(gè)視頻片段(segment)的最后一幀當(dāng)作后一個(gè)片段的第一幀來(lái)進(jìn)行生成,并以此類推在一個(gè)框架中實(shí)現(xiàn)長(zhǎng)視頻生成。

最后,為了進(jìn)一步高效處理長(zhǎng)序列,研究團(tuán)隊(duì)探索了基于狀態(tài)空間模型(Mamba)的時(shí)間建模架構(gòu),作為原始的計(jì)算密集型時(shí)序 Transformer 的一種替代。實(shí)驗(yàn)發(fā)現(xiàn)基于時(shí)序 Mamba 的架構(gòu)可以取得和時(shí)序 Transformer 類似的效果,但是需要的顯存開銷更小。

通過(guò) UniAnimate 框架,用戶可以生成高質(zhì)量的時(shí)序連續(xù)人類跳舞視頻。值得一提的是,通過(guò)多次使用 First Frame Conditioning 策略,可以生成持續(xù)一分鐘的高清視頻。與傳統(tǒng)方法相比,UniAnimate 具有以下優(yōu)勢(shì):

- 無(wú)需額外的參考網(wǎng)絡(luò):UniAnimate 框架通過(guò)統(tǒng)一的視頻擴(kuò)散模型,消除了對(duì)額外參考網(wǎng)絡(luò)的依賴,降低了訓(xùn)練難度和模型參數(shù)的數(shù)量。

- 引入了參考圖像的姿態(tài)圖作為額外的參考條件,促進(jìn)網(wǎng)絡(luò)學(xué)習(xí)參考姿態(tài)和目標(biāo)姿態(tài)之間的對(duì)應(yīng)關(guān)系,實(shí)現(xiàn)良好的表觀對(duì)齊。

- 統(tǒng)一框架內(nèi)生成長(zhǎng)序列視頻:通過(guò)增加統(tǒng)一的噪聲輸入,UniAnimate 能夠在一個(gè)框架內(nèi)生成長(zhǎng)時(shí)間的視頻,不再受到傳統(tǒng)方法的時(shí)間限制。

- 具備高度一致性:UniAnimate 框架通過(guò)迭代利用第一幀作為條件生成后續(xù)幀的策略,保證了生成視頻的平滑過(guò)渡效果,使得視頻在外觀上更加一致和連貫。這一策略也使得用戶可以生成多個(gè)視頻片段,并選取生成結(jié)果好的片段的最后一幀作為下一個(gè)生成片段的第一幀,方便了用戶與模型交互和按需調(diào)整生成結(jié)果。而利用之前時(shí)序重合的滑動(dòng)窗口策略生成長(zhǎng)視頻,則無(wú)法進(jìn)行分段選擇,因?yàn)槊恳欢我曨l在每一步擴(kuò)散過(guò)程中都相互耦合。

以上這些特點(diǎn)使得 UniAnimate 框架在合成高質(zhì)量、長(zhǎng)時(shí)間的人類跳舞視頻方面表現(xiàn)出色,為實(shí)現(xiàn)更廣泛的應(yīng)用提供了新的可能性。

生成結(jié)果示例

1. 基于合成圖片進(jìn)行跳舞視頻生成。

2. 基于真實(shí)圖片進(jìn)行跳舞視頻生成。

3. 基于粘土風(fēng)格圖片進(jìn)行跳舞視頻生成。

4. 馬斯克跳舞。

5. Yann LeCun 跳舞。

6. 基于其他跨域圖片進(jìn)行跳舞視頻生成。

7. 一分鐘跳舞視頻生成。

獲取原始 MP4 視頻和更多高清視頻示例請(qǐng)參考論文的項(xiàng)目主頁(yè) ???https://unianimate.github.io/??。

實(shí)驗(yàn)對(duì)比分析

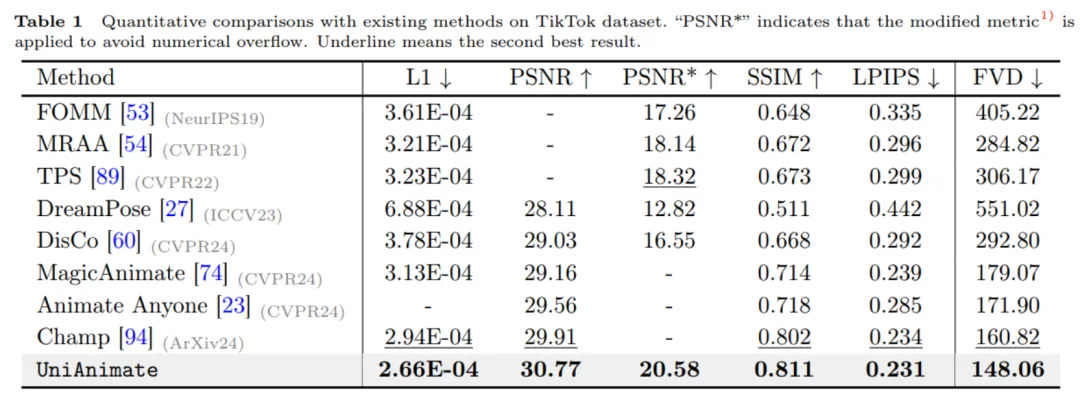

1. 和現(xiàn)有方法在 TikTok 數(shù)據(jù)集上的定量對(duì)比實(shí)驗(yàn)。

如上表所示,UniAnimate 方法在圖片指標(biāo)如 L1、PSNR、SSIM、LPIPS 上和視頻指標(biāo) FVD 上都取得了最好的結(jié)果,說(shuō)明了 UniAnimate 可以生成高保真的結(jié)果。

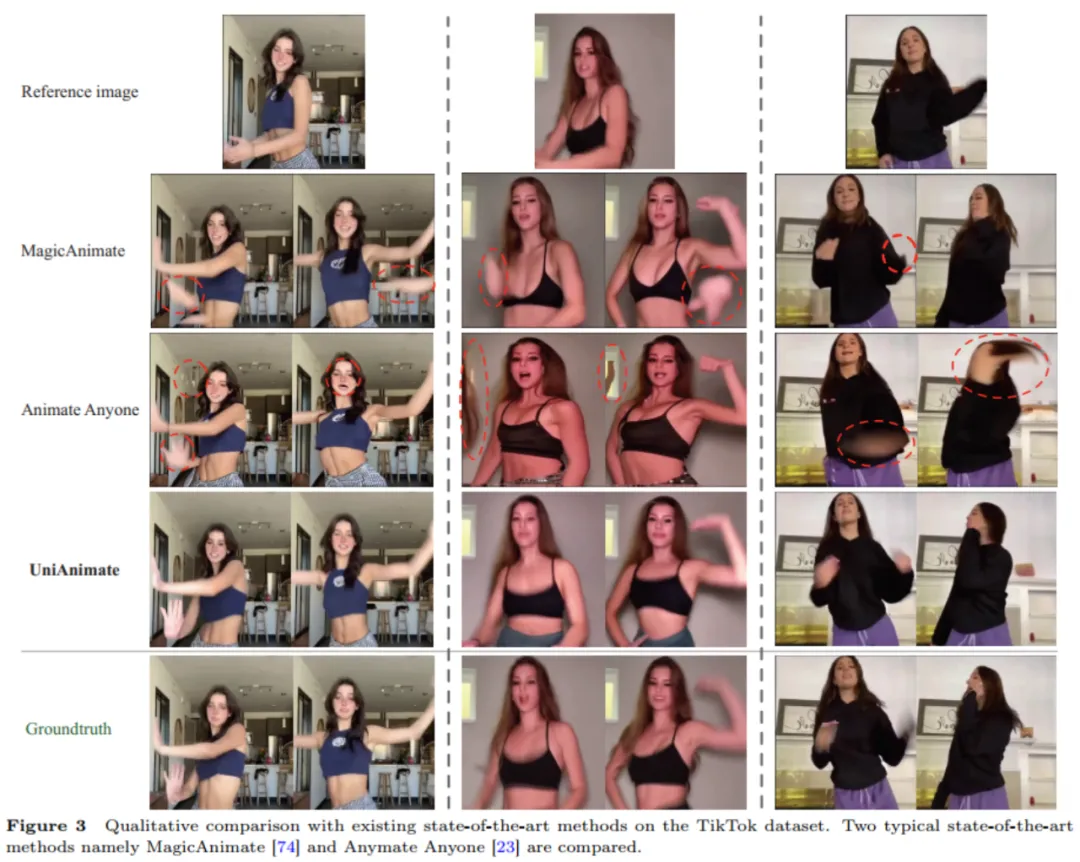

2. 和現(xiàn)有方法的定性對(duì)比實(shí)驗(yàn)。

從上述定性對(duì)比實(shí)驗(yàn)也可以看出,相比于 MagicAnimate、Animate Anyone, UniAnimate 方法可以生成更好的連續(xù)結(jié)果,沒有出現(xiàn)明顯的 artifacts,表明了 UniAnimate 的有效性。

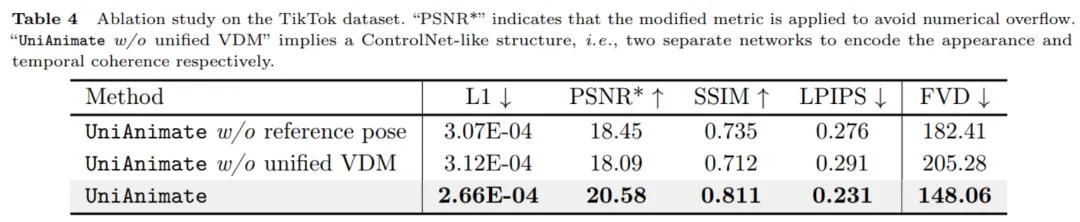

3. 剝離實(shí)驗(yàn)。

從上表的數(shù)值結(jié)果可以看出,UniAnimate 中用到的參考姿態(tài)和統(tǒng)一視頻擴(kuò)散模型對(duì)性能提升起到了很關(guān)鍵的作用。

4. 長(zhǎng)視頻生成策略對(duì)比。

從上圖可以看出之前常用的時(shí)序重合滑動(dòng)窗口策略生成長(zhǎng)視頻容易導(dǎo)致不連續(xù)的過(guò)渡,研究團(tuán)隊(duì)認(rèn)為這是因?yàn)椴煌翱谠跁r(shí)序重合部分去噪難度不一致,使得生成結(jié)果不同,而直接平均會(huì)導(dǎo)致有明顯的變形或者扭曲等情況發(fā)生,并且這種不一致會(huì)進(jìn)行錯(cuò)誤傳播。而本文利用的首幀視頻延續(xù)生成方法則可以生成平滑的過(guò)渡。

更多的實(shí)驗(yàn)對(duì)比結(jié)果和分析可以參考原論文。

總而言之,UniAnimate 的示例結(jié)果表現(xiàn)和定量對(duì)比結(jié)果很不錯(cuò),期待 UniAnimate 在各個(gè)領(lǐng)域的應(yīng)用,如影視制作、虛擬現(xiàn)實(shí)和游戲產(chǎn)業(yè)等,為用戶帶來(lái)更為逼真、精彩的人類形象動(dòng)畫體驗(yàn)。

本文轉(zhuǎn)自 機(jī)器之心 ,作者:機(jī)器之心