Tiktok多模態大模型最新研究:顯示序列建模提升視頻理解能力

今天給大家介紹一篇視頻多模態大模型工作,這篇文章的核心是探索了在現有的SOTA視頻多模態大模型中,引入顯示的視頻時序建模提升模型的視頻理解能力。

論文標題:Exploring the Role of Explicit Temporal Modeling in Multimodal Large Language Models for Video Understanding

下載地址:??https://arxiv.org/pdf/2501.16786??

1.研究背景

傳統的時間序列預測方法,都是最基礎的時間序列形式數據進行建模的。然而,最近一些工作將文本信息、圖像信息等模態引入時間序列建模中。例如,將時間序列轉換成文本形式輸入到LLM,或者將時間序列轉換成圖像數據輸入圖像模型。

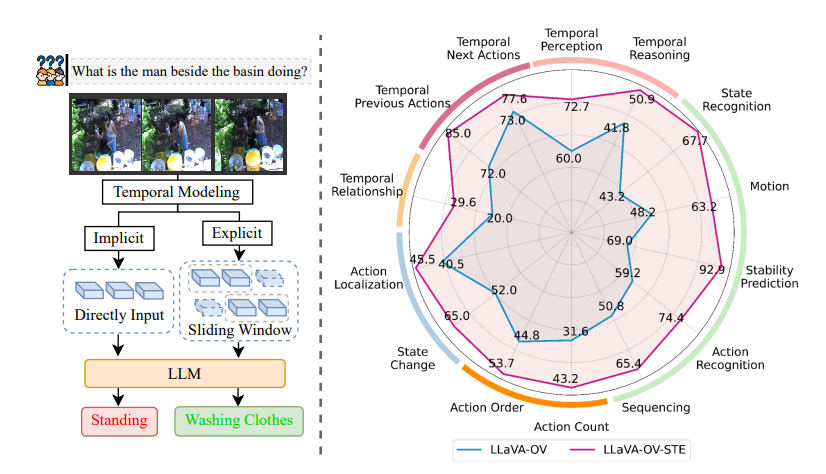

視頻多模態大模型一般都基于訓練好的Large Language Model進行擴展,實現對視頻、圖像等數據的處理。現有的兼容視頻模態的多模態大模型中,對于是否顯示考慮視頻各個幀的時序關系,有兩種處理方法。一種是隱式的建模,即將不同幀的圖片按順序拼接到一起,直接輸入到LLM中,希望利用LLM的時序建模能力隱式建模視頻時序關系。另一種方法是引入直接的時序建模模塊,將時序建模表征輸入LLM。

隱式時序建模無法充分建模視頻時序關系,因此本文研究了顯示建模視頻時序關系的方法,并提出了再視頻幀表征基礎上使用引入 Stackable Temporal Encoder建模視頻時序關系,在以LLaVA為基礎的SOTA視頻多模態大模型上取得顯著效果提升。

2.研究背景

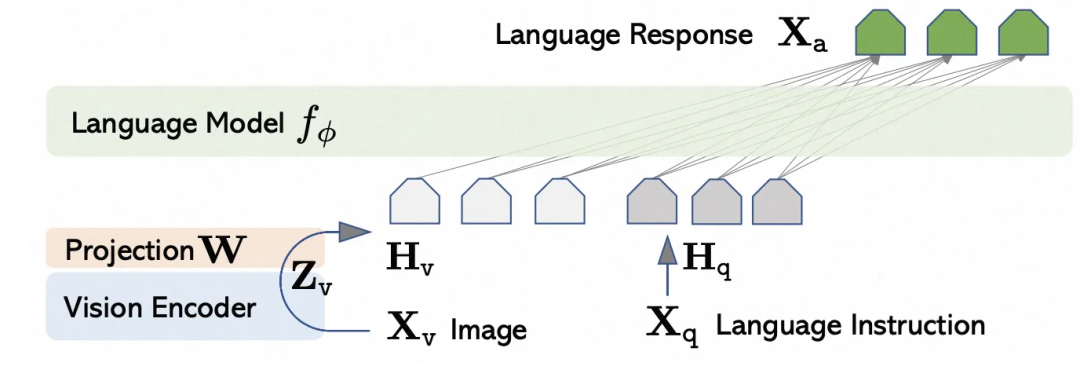

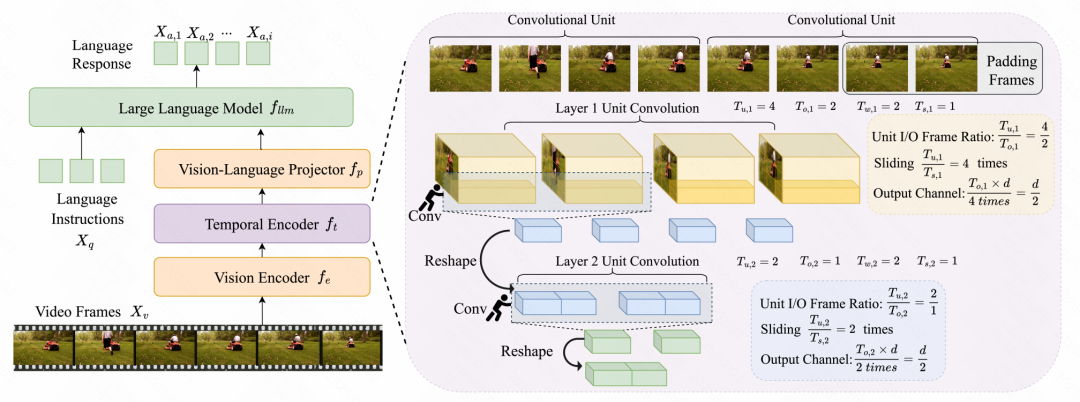

首先介紹一下基礎的視頻多模態大模型結構。以LLaVA為例,其基本結構由一個LLM和一個視覺編碼器(如ViT)組成,視覺編碼器的表征通過MLP(Vision-Language Projector)映射后和文本token表征拼接到一起輸入到大模型。在訓練方式上,采用Instruction Tuning進行圖文的訓練,同時也可以引入視頻-文本數據進行訓練,對視頻采用采樣幀的方式轉換成圖片的方式輸入到LLM。

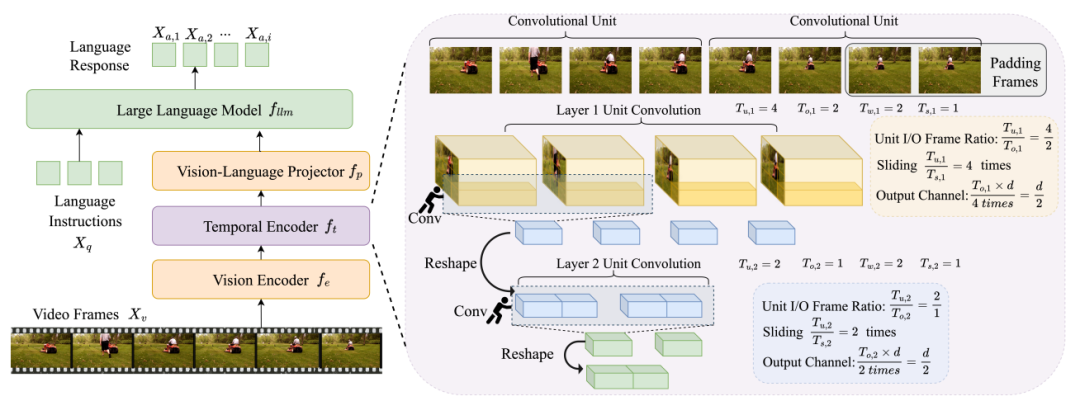

本文的核心則是在上述架構的基礎上,在視覺編碼器和MLP映射層之間加了一個對視頻進行時序表征提取的模塊(Temporal Encoder),顯示的讓視頻表征能夠考慮到前后幀的時序關系。

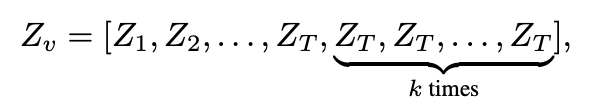

Temporal Encoder模塊具體的結構如下圖,是由多層卷積神經網絡組成。每一層卷積神經網絡設定了input幀數和output幀數的比例,根據這一比例通過滑動窗口進行單元的劃分,每個單元內使用卷積建模單元內連續幀之間的關系,生成考慮時序信息的視頻表征。每個卷積輸出多個channel,每個channel對應一個維度的視頻表征。

具體的卷積計算邏輯如下。每一幀都對應多個patch(共p個patch),每個patch對應一個patch embedding(維度為d),形式如下:

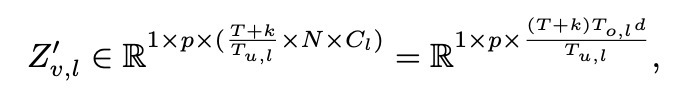

其中需要定義好輸入的幀數(Tu)、輸出的幀數(To),根據輸出幀數、滑動步數等來確定每層卷積輸出的channel數量,最后將每個卷積channel結果拼接到一起,還原對應的目標幀數。最終每一層輸出的維度如下:

3.實驗效果

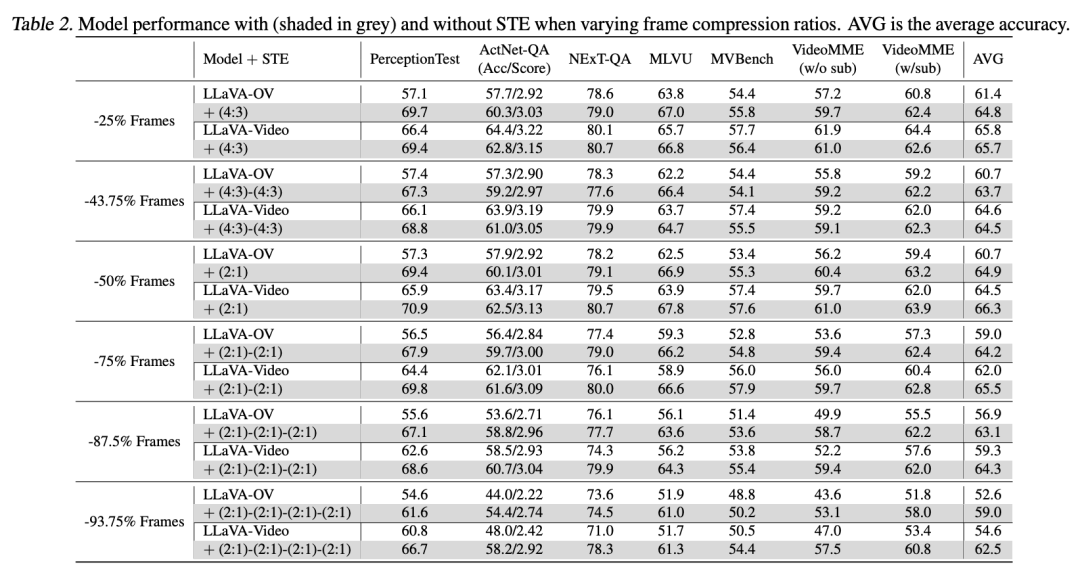

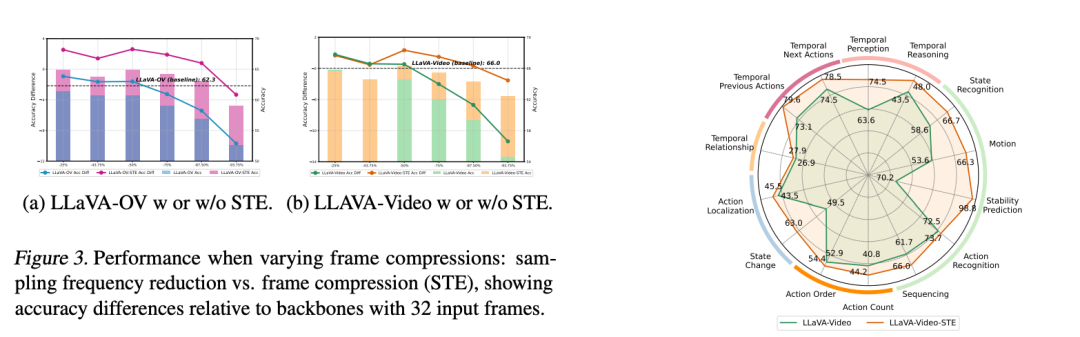

通過在現有的SOTA視頻多模態大模型LLaVA-OV和LLaVA-Video上的實驗可以看出,引入了Temporal Encoder可以顯著的提升視頻理解任務上的效果。

本文轉載自??圓圓的算法筆記??