庫里杜蘭特“合舞”科目三,騰訊混元團隊全新圖生視頻模型來了

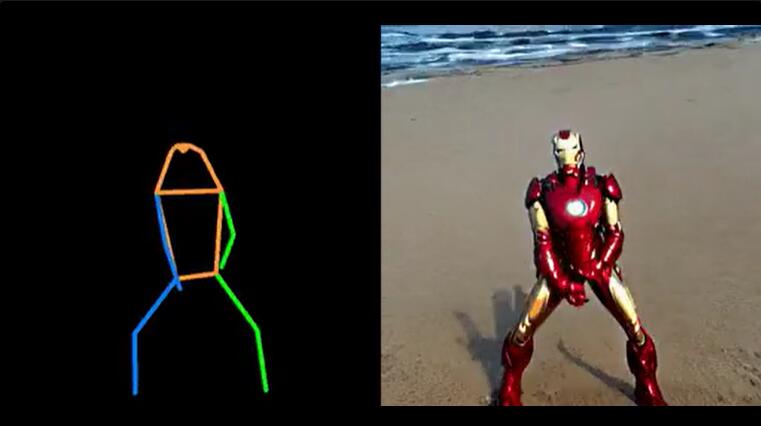

當前大家常見的視頻生成是醬嬸兒的:

多數情況下只能讓一個人動起來。

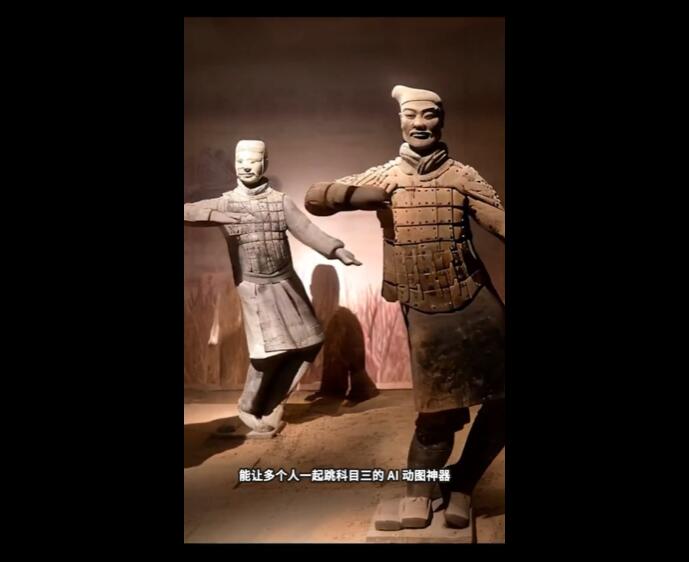

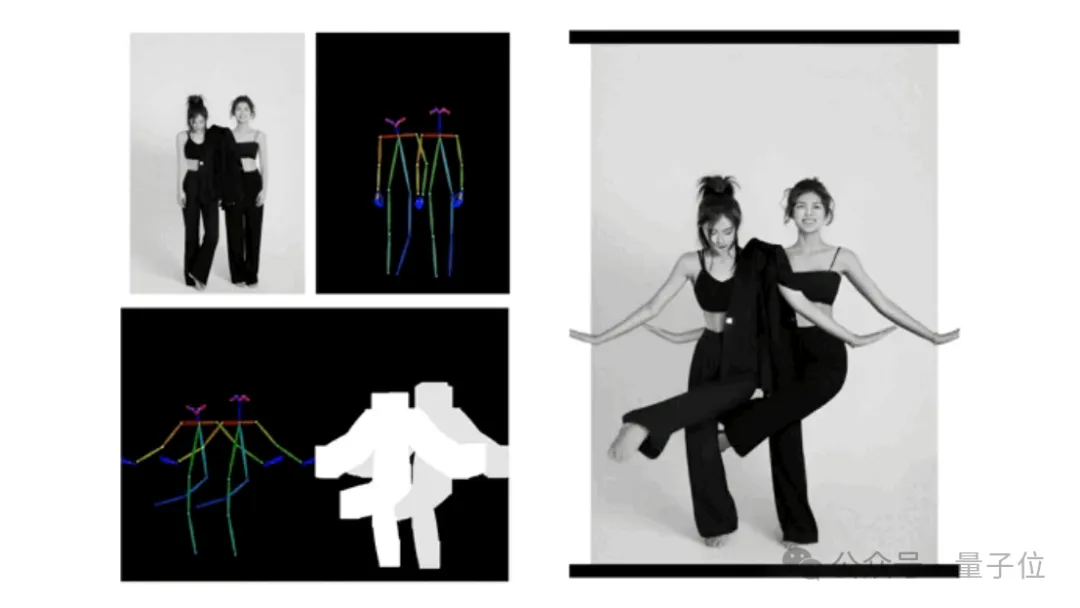

而現在,如果提供了一張人物合照,所有人都能同時“舞起來了”。

如此看來,從單人到多人,視頻生成已經進入了Next Neval ~

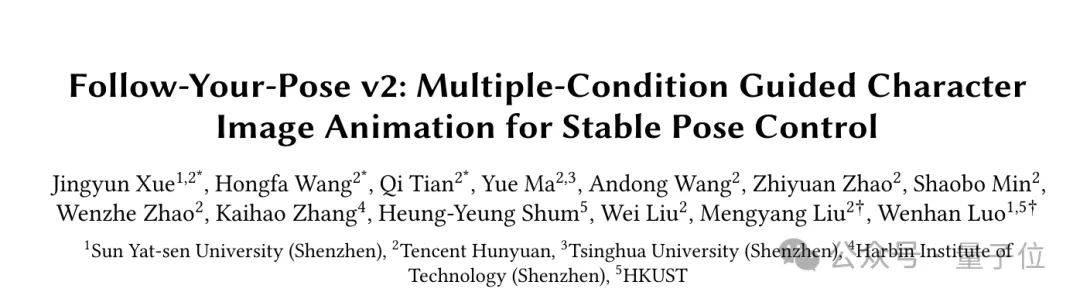

如上成果出自騰訊混元團隊聯合中山大學、香港科技大學推出的全新圖生視頻模型:Follow-Your-Pose-v2。

與之前的模型相比,“Follow-Your-Pose-v2”主要有4大新亮點:

- 在推理耗時更少的情況下,支持多人視頻動作生成

- 模型具備較強的泛化能力,不論年齡、服裝、人種、背景雜亂程度、動作復雜程度如何,都能生成高質量視頻

- 日常生活照(含抓拍)/視頻均可用于模型訓練及生成,無需費力尋找高質量圖片/視頻

- 面對單張圖片上多個人物的軀體相互遮擋問題,能生成具有正確前后關系的遮擋畫面,保證多人“合舞”順利完成

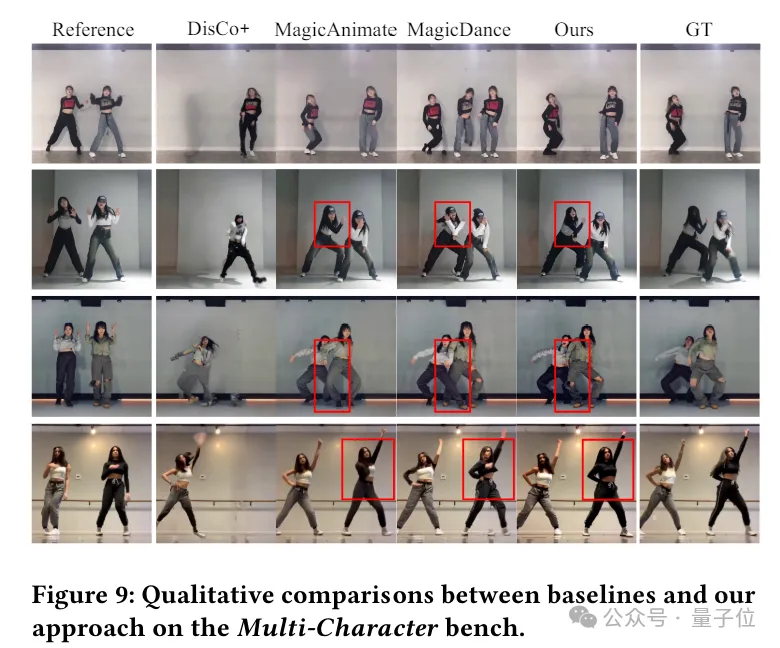

為了評估多角色生成效果,團隊提出了一個包含約4000幀(約20個多角色視頻)的新基準——Multi-Character。

實驗結果顯示,模型在2個公共數據集(TikTok和TED演講)和7個指標上的性能均優于最新技術35%以上。

下面,一起來看看它具體是如何做到的吧。

怎么做到的?

目前,Follow-Your-Pose-v2已經能很好地完成“單人動起來”這項任務(生成視頻長度可達10秒)。

它的出現主要用來解決“更復雜場景”可能遇到的視頻生成問題:

- 多個角色動畫

- 多角色身體遮擋、背景畸變等一致性問題

- 傳統方法下的訓練數據集要求高(不易獲取且成本高)

首先,在動作驅動圖片生成視頻的任務中,一般的方法往往需要精心篩選高質量(具有穩定背景和時間一致性)訓練數據,成本高的同時還限制了訓練集的規模,從而導致模型在泛化能力的提升上有瓶頸。

對此,團隊提出了一個可以在互聯網上容易獲得的嘈雜開源視頻上進行訓練的框架Follow-Your-Pose v2。

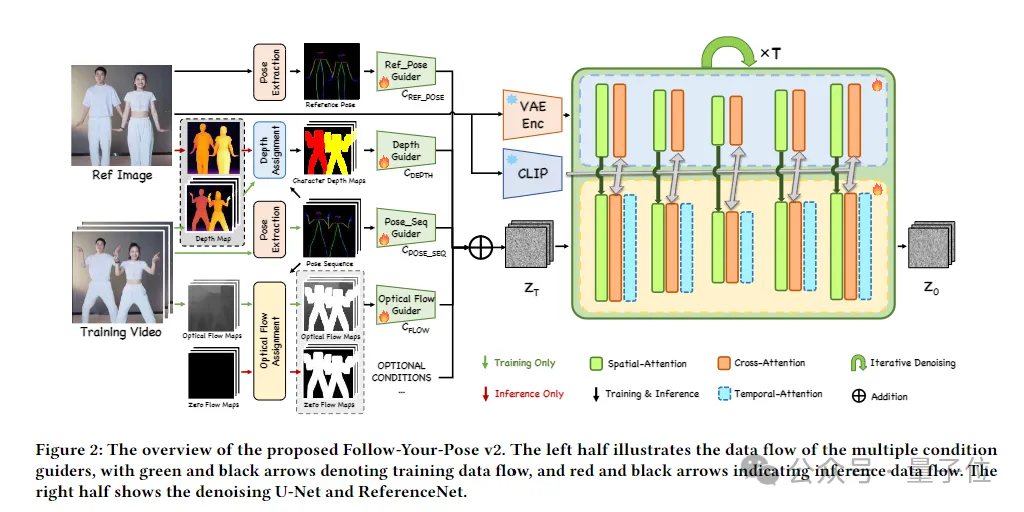

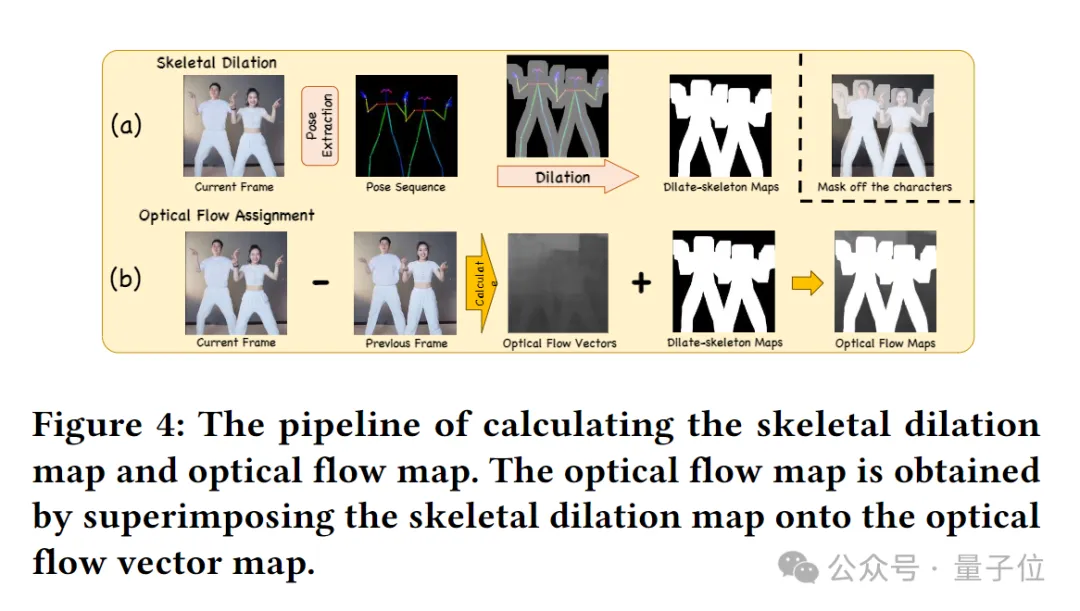

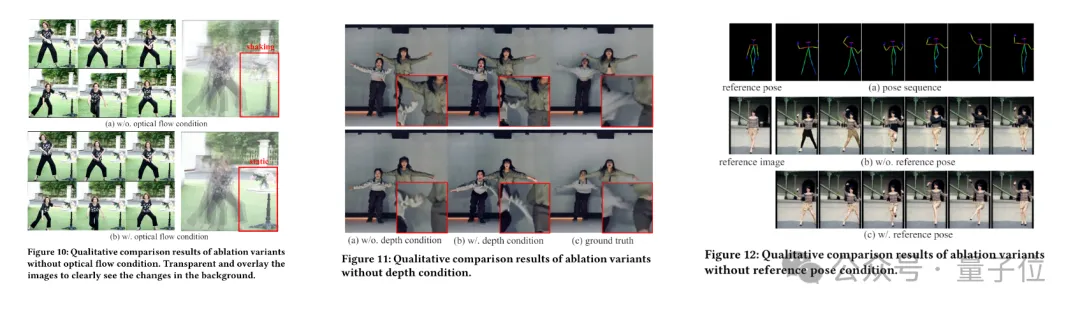

該框架中特有的“光流指導器”(Optical Flow Guider)引入了背景光流信息,賦予了模型在大量有噪聲的低質量數據上訓練收斂的能力。

具體而言,光流指導器負責分析并預測幀間的像素級運動,為模型提供背景穩定性。通過這種方式,即使在存在相機抖動或不穩定背景的情況下,也能生成穩定的背景動畫。

這也意味著,“Follow-Your-Pose-v2”能夠讓使用者基于任意一張人物圖片和一段動作視頻生成高質量視頻,不再需要費力尋找滿足高要求的圖片和視頻,這些照片可以是自己和家人朋友的生活照,也可以是偶像的一張簡單抓拍。

其次,模型對于圖片上蘊含的空間信息的理解能力有限,具體表現在前景和后景的區分不清晰,導致生成視頻背景的畸變和人物動作的不準確。

對此,Follow-Your-Pose-v2框架通過整合多條件引導器(Multi-condition Guiders),有效解決了現有方法在復雜場景下的不足,如多角色動畫和身體遮擋問題。

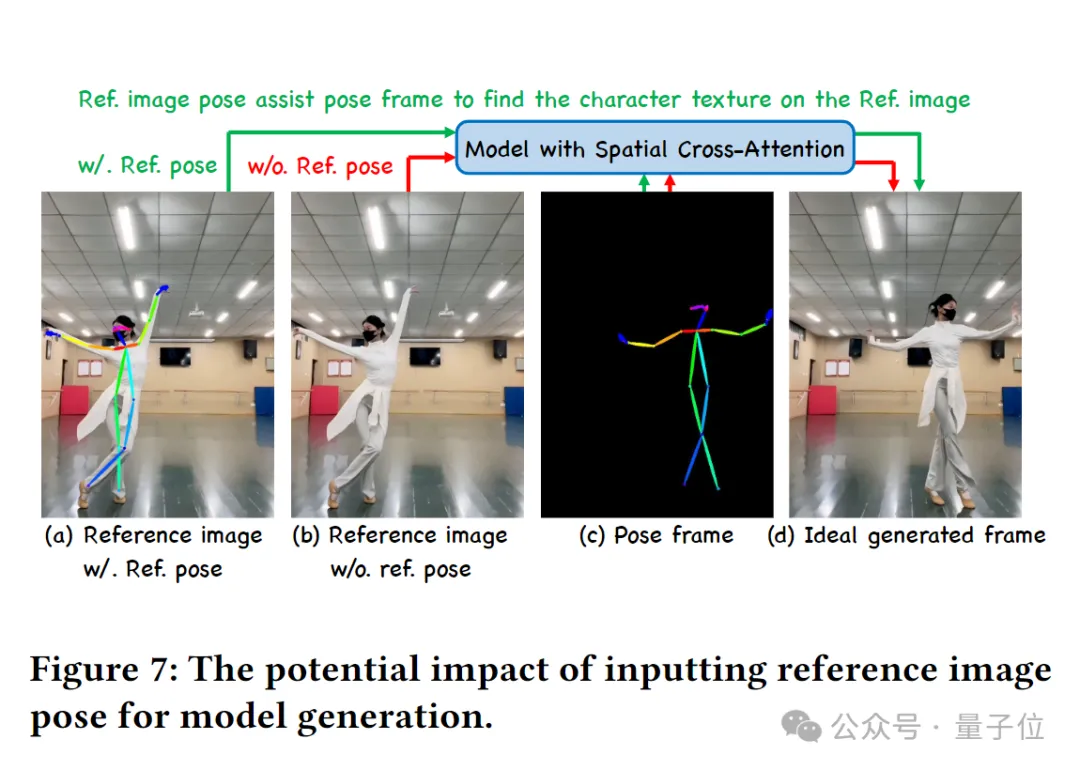

該框架中特有的“推理圖指導器”(Reference Pose Guider)引入了圖片中的人物空間信息,賦予模型更強的動作跟隨能力。

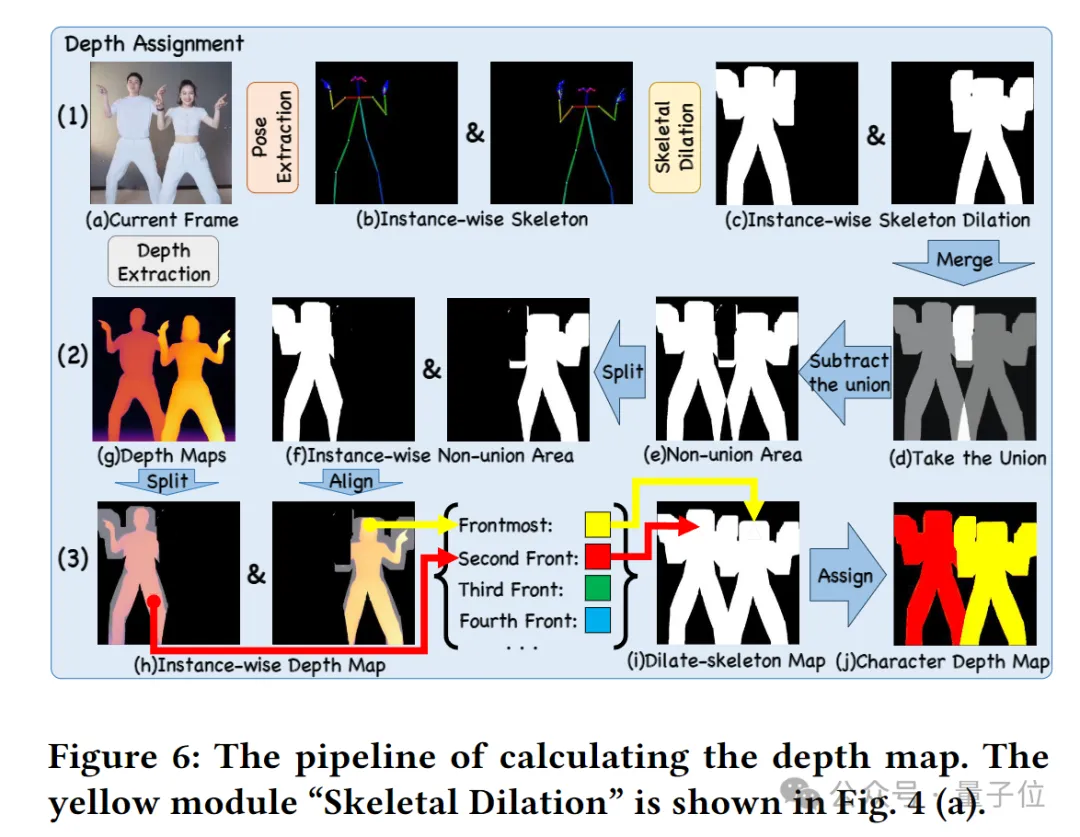

另外,模型特有的“深度圖指導器”(Depth Guider)引入了多人物的深度圖信息,增強了模型對于多角色的空間位置關系的理解和生成能力。在面對單張圖片上多個人物的軀體相互遮擋問題時,“Follow-Your-Pose-v2”能生成出具有正確的前后關系的遮擋畫面,保證多人“合舞”順利完成。

總之,新框架通過整合多種條件引導器,提高了模型對嘈雜數據的魯棒性,使其能夠直接在未經篩選的大量視頻上進行訓練。

在訓練過程中,團隊收集了4000個來自TikTok、YouTube和其他網站的公共視頻,總計200萬幀。

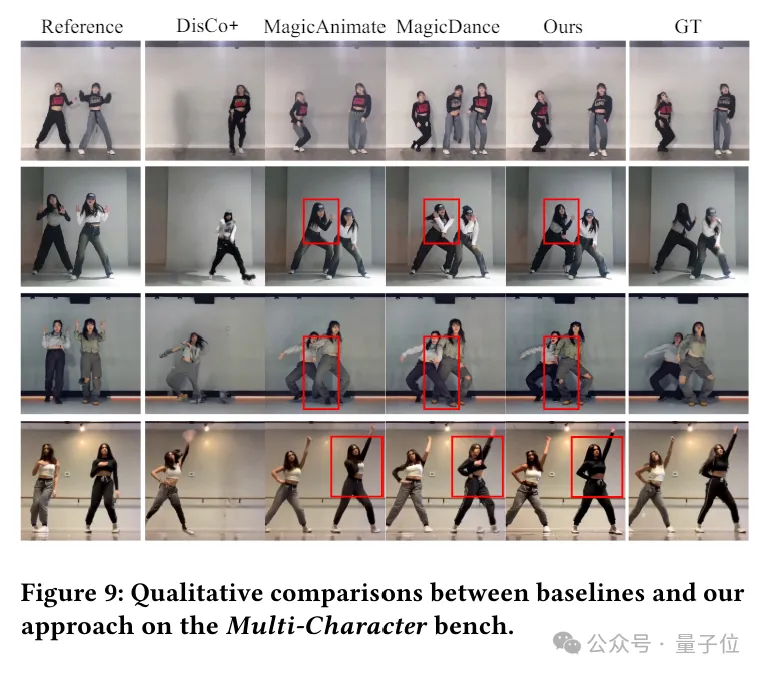

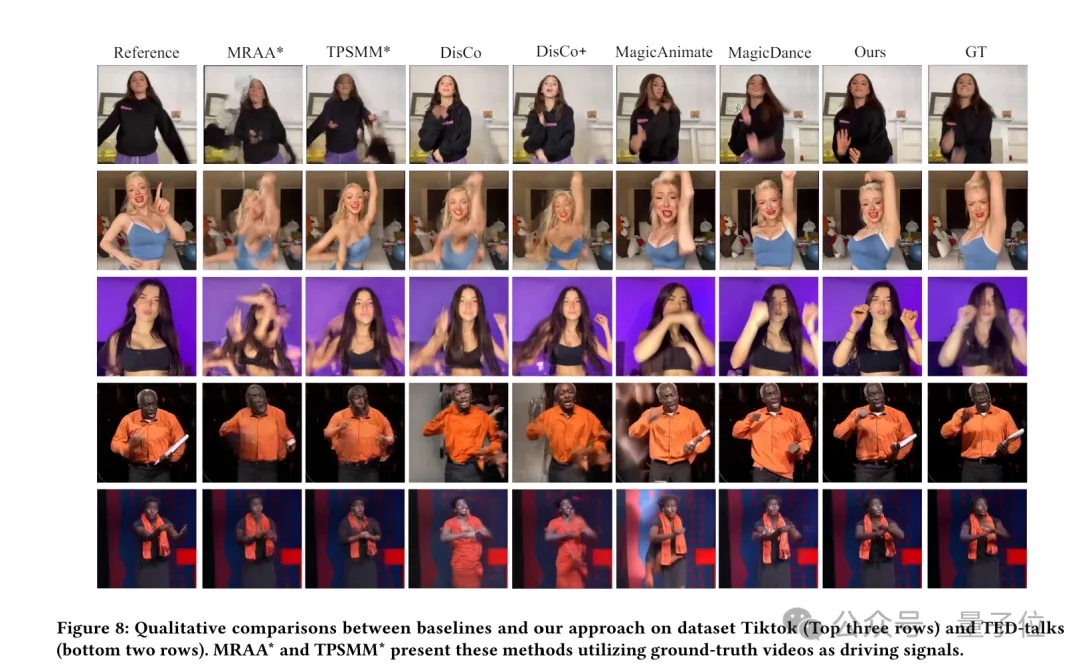

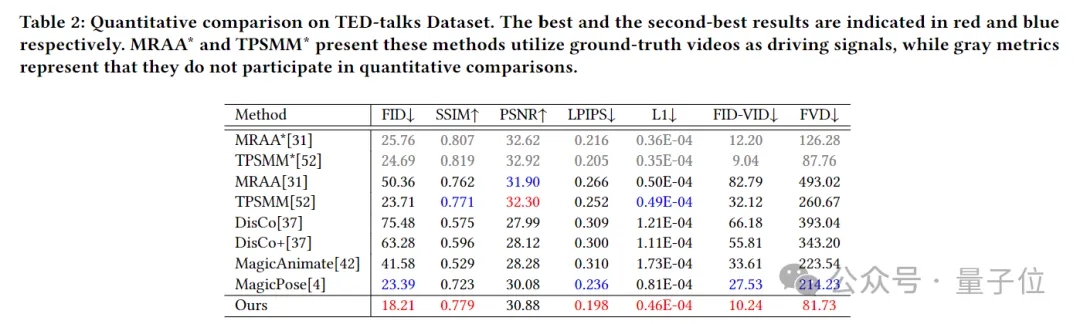

為了評估效果,團隊將“Follow-Your-Pose-v2”與多個現有的最先進方法進行了比較,包括基于GAN的方法(如MRAA和TPSMM)和基于VLDM的方法(如DreamPose、DisCo、MagicAnimate和AnimateAnyone)。

并且團隊先在TikTok和TED演講這2個公共數據集上進行了測試。

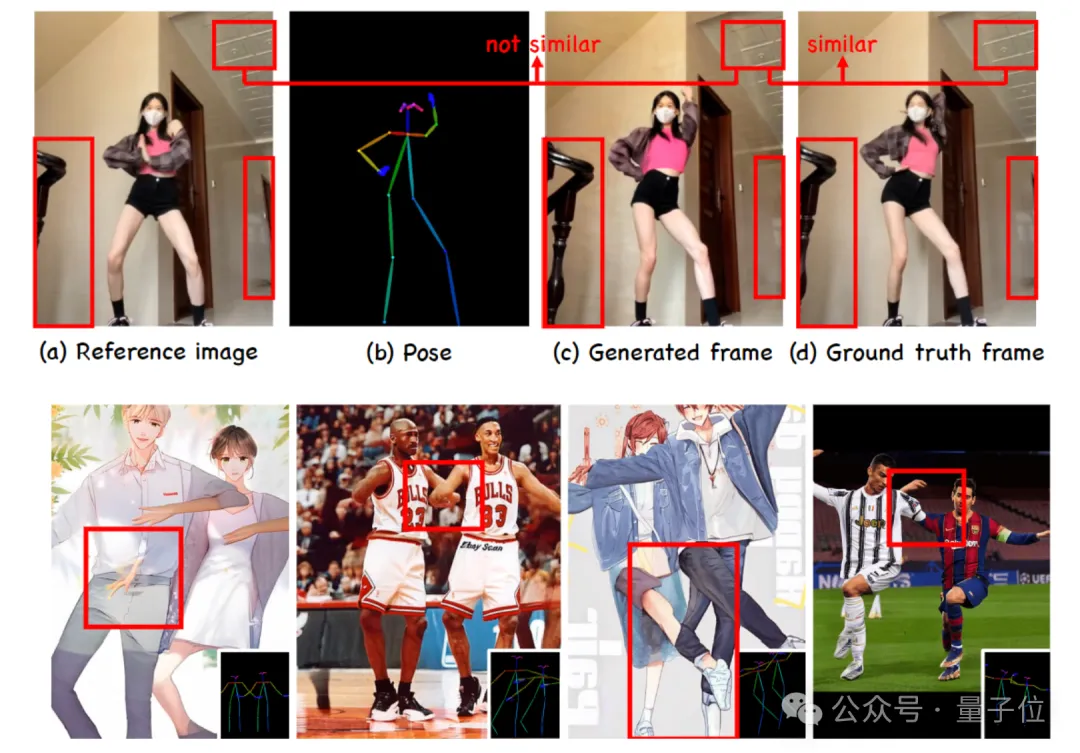

在TikTok數據集中,模型在姿勢跟蹤和視覺質量方面獲得了更好的性能。比如它能夠生成真實情況中不存在的手部細節,以及它是能夠準確生成反向舉起手臂的姿勢的唯一方法。

在TED演講數據集中,模型在除PSNR(衡量圖像的峰值信噪比)之外的六個評估指標上都實現了SOTA性能。

此外,由于缺乏多角色視頻生成的基準,團隊從社交媒體收集了20個多角色舞蹈視頻,總計3917幀,命名為Multi-Character。該數據集作為評估模型生成多角色姿態可控視頻能力的基準。

可以看到,在Multi-Character Bench數據集上,“Follow-Your-Pose-v2”在所有評估指標上都顯著優于其他方法,證明了其在處理多角色動畫方面的優勢。

最后,為了評估各個組件對整體性能的貢獻,團隊進行了消融研究,移除了光流、深度圖和推理圖指導器,分別評估它們對模型性能的影響。

研究表明,光流指導器對模型性能的提升最為顯著,其次是深度圖引導器和推理圖引導器。這些組件的移除都會導致性能下降,證明了它們在生成穩定和高質量動畫中的重要性。

One More Thing

當下,圖像到視頻生成的技術在電影內容制作、增強現實、游戲制作以及廣告等多個行業的AIGC應用上有著廣泛前景,是2024年最熱門的AI技術之一。

參與了“Follow-Your-Pose-v2”研究的騰訊混元團隊,也在6月6日公布了其文生圖開源大模型(混元DiT)的加速庫,號稱大幅提升推理效率,生圖時間縮短75%。

官方表示,混元DiT模型的使用門檻也大幅降低,用戶可以基于ComfyUI的圖形化界面使用騰訊混元文生圖模型能力,并在Hugging Face的官方模型庫中用三行代碼調用模型(無需下載原始代碼庫)。

目前本文介紹的相關技術論文已上傳公共社區,感興趣的家人們可以進一步了解。

論文:??https://arxiv.org/abs/2406.03035???

抱抱臉混元DiT:???https://huggingface.co/Tencent-Hunyuan/HunyuanDiT?cnotallow=7b93f8f875055859b0712c994d253b9f??

本文轉自 量子位 ,作者:量子位