五分鐘讀懂 LLM:DeepSeek、ChatGPT 背后的核心技術

LLM(Large Language Model)是大型語言模型的簡稱,像DeepSeek、ChatGPT等都屬于不同公司開發的LLM。你可以把它想象成一個超級聰明的聊天機器人和寫作助手,它通過學習了海量文字資料,變得非常擅長理解和生成人類語言。簡單來說,它能聽懂你說什么,也能像模像樣地跟你聊天、寫文章等等。

一、LLM到底是什么?

1. 咱們先拆開看看

- 語言模型 (Language Model):你可以把它想象成一個學習了海量文字資料的“學霸”。它讀了很多很多書、新聞、網頁等等,所以它對我們平時說話、寫文章的規律非常熟悉。它知道哪些詞語經常一起出現,一句話說完之后接下來可能會說什么。

- 大型 (Large):這個“大型”就厲害了!它意味著這個“學霸”讀過的書實在是太多太多了,比你我讀過的書加起來還要多得多!正是因為讀得多,它才能更好地理解和運用語言。

所以,LLM合起來就是:一個超級超級厲害的語言“學霸”,它通過學習大量的文字,掌握了人類語言的規律,然后就能做很多事情:

- 跟你聊天:你可以像跟朋友一樣跟它說話,問它問題,它會盡力理解你的意思并給出回答。

- 幫你寫東西:你可以讓它幫你寫郵件、寫文章、寫詩,甚至寫代碼!當然,它寫出來的東西可能還需要你稍微修改一下。

- 總結信息:你給它一篇很長的文章,它可以幫你提煉出最重要的信息。

- 翻譯語言:它可以幫你把一種語言翻譯成另一種語言。

- 生成各種文本:比如,你給它一些關鍵詞,它可以幫你生成一段相關的文字。

你可以把LLM想象成一個非常聰明的鸚鵡,但它不僅僅是簡單地模仿你說話,它還能理解你說話的意思,并且能根據它學到的知識來生成新的、有意義的語言。

2. 舉個例子

就像你用手機上的輸入法打字,它會根據你已經輸入的內容,預測你接下來想輸入什么詞語,這就是一個簡單的語言模型在工作。而LLM就像一個超級升級版的輸入法,它能理解更復雜的語境,生成更長的、更連貫的文本。

總而言之,LLM就是一個非常強大的、能夠理解和生成人類語言的計算機程序,它通過學習大量的文本數據,變得非常“聰明”,能夠幫助我們處理各種與語言相關的任務。

希望這個解釋能讓你明白什么是LLM!是不是沒有想象中那么復雜?

二、LLM工作原理

咱們來詳細介紹一下LLM(大型語言模型)的原理,我會盡量用通俗易懂的方式來解釋。你可以把LLM想象成一個非常非常聰明的語言學習機器,它的“聰明”來自于學習了海量的文本數據。

1. 核心原理:預測下一個詞語

LLM最核心的原理其實非常簡單:預測序列中的下一個詞語。

想象一下,你正在輸入一句話:“今天天氣真...”。你大腦里可能會自動浮現出很多可能的下一個詞,比如“好”、“不錯”、“糟糕”等等。LLM的工作方式跟這個很像,只不過它比你的大腦要厲害得多,因為它學習了海量的文本數據,知道在什么語境下哪個詞語出現的可能性更高。

2. 關鍵技術:Transformer架構

現在主流的LLM,比如GPT系列、BERT系列等等,都基于一種叫做 Transformer 的神經網絡架構。這個架構是讓LLM變得如此強大的關鍵。Transformer架構主要包含以下幾個核心組件:

(1) 嵌入層 (Embedding Layer):

當你輸入一段文字時,首先每個詞語都會被轉換成一個叫做“詞向量”的東西。你可以把詞向量想象成一個包含了這個詞語各種信息的數字列表。比如,“貓”這個詞的詞向量可能會包含“動物”、“可愛”、“有胡須”等信息。

這樣做的好處是,計算機可以更好地理解詞語之間的關系。比如,“貓”和“狗”的詞向量在某種程度上會比較接近,因為它們都是動物。

(2) 自注意力機制 (Self-Attention Mechanism):

這是Transformer架構中最核心、最關鍵的部分。它的作用是讓模型在處理一個句子中的某個詞語時,能夠同時關注到句子中的其他詞語,從而更好地理解這個詞語的含義。

舉個例子,在句子“小明喜歡踢足球,他踢得很好”中,當模型處理“他”這個詞的時候,自注意力機制會幫助模型注意到“他”指的是“小明”,而不是“足球”。

你可以把它想象成,當你在閱讀一篇文章的時候,你會根據上下文來理解每個詞語的意思。自注意力機制就是讓模型也具備這種能力。

模型會對句子中的每個詞語都計算出一個“注意力權重”,權重高的詞語表示模型認為它與當前正在處理的詞語更相關。

(3) 多頭注意力 (Multi-Head Attention):

為了讓模型能夠從不同的角度去理解詞語之間的關系,Transformer使用了多個“注意力頭”。每個注意力頭都進行一次自注意力計算,然后將結果合并起來。

這就像你從不同的角度觀察一個事物,可以獲得更全面的認識。

(4) 前饋神經網絡 (Feed-Forward Neural Network):

在自注意力機制之后,每個詞語的表示會通過一個前饋神經網絡進行進一步的處理,提取更復雜的特征。

(5) 位置編碼 (Positional Encoding):

由于Transformer架構本身并沒有像循環神經網絡(RNN)那樣天然的時序性(即知道詞語的先后順序),因此需要通過位置編碼來告訴模型句子中每個詞語的位置信息。

(6) 層歸一化和殘差連接(Layer Normalization and Residual Connections):

這些是訓練深度神經網絡常用的技術,可以幫助模型更好地訓練,避免梯度消失等問題。

3. 訓練過程:海量數據和預測任務

LLM之所以能夠如此強大,很大程度上歸功于其龐大的訓練數據和訓練方式:

(1) 海量文本數據:LLM通常會在非常龐大的文本數據集上進行訓練,這些數據可能包括互聯網上的網頁、書籍、新聞文章、代碼等等。數據量越大,模型學到的語言規律就越多,能力也就越強。

(2) 無監督學習 (Self-Supervised Learning):LLM的訓練通常采用一種叫做“無監督學習”的方式。這意味著我們不需要人工標注大量的數據來告訴模型什么是對的,什么是錯的。

- 掩碼語言模型:隨機遮蓋輸入文本中的一些詞語,然后讓模型預測被遮蓋的詞語是什么。這迫使模型理解上下文信息。

- 下一個句子預測:給模型兩個句子,讓它判斷第二個句子是不是第一個句子的下一個句子。這幫助模型理解句子之間的邏輯關系。

- 最常見的訓練任務就是“掩碼語言模型(Masked Language Model)”和“下一個句子預測 (Next Sentence Prediction)”(在早期的模型中,比如BERT)。

- 對于像GPT這樣的生成式模型,主要的訓練任務是“語言模型 (Language Modeling)”,也就是給定一段文本,讓模型預測下一個最有可能出現的詞語。模型會不斷地預測下一個詞,直到生成完整的文本。

(3) 反向傳播和梯度下降:在訓練過程中,模型會不斷地預測下一個詞語,并將其與實際的下一個詞語進行比較,計算出“損失”。然后,模型會通過反向傳播和梯度下降等優化算法來調整自身的參數,使得預測結果越來越接近真實答案。

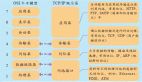

4. 預訓練和微調 (Pre-training and Fine-tuning)

LLM的訓練通常分為兩個階段:

- 預訓練 (Pre-training):在海量的通用文本數據上進行訓練,讓模型學習到通用的語言知識和模式。這個階段通常需要消耗大量的計算資源和時間。

- 微調 (Fine-tuning):在特定的任務數據集上進行訓練,讓模型更好地適應特定的任務。比如,如果你想讓LLM做情感分析,你可以在一個標注了情感的文本數據集上對預訓練好的模型進行微調。

5. 總結一下LLM的原理

- 核心是預測下一個詞語。

- 主要基于Transformer架構,核心組件是自注意力機制,讓模型能夠理解上下文。

- 通過在海量文本數據上進行無監督學習來訓練,學習語言的規律。

- 通常分為預訓練和微調兩個階段。

希望這個詳細的介紹能夠幫助你更好地理解LLM的原理!雖然其中涉及到一些技術細節,但核心思想就是讓計算機通過學習大量的語言數據,學會像人類一樣理解和生成語言。

三、具體案例

我們來用一個詳細的案例來理解LLM是如何工作的。這次我們以一個常見的應用場景為例:生成一個在線商店的產品描述。

場景:假設你是一家銷售手工制作陶瓷杯子的商店,你想為你的一個新款杯子生成一個吸引人的產品描述。你可能會給LLM提供一些關鍵信息作為輸入。

輸入 (Prompt):

請為一款手工制作的陶瓷杯子寫一段產品描述。這款杯子是淡藍色的,上面有手繪的白色小花圖案。杯子的容量大約是350毫升,非常適合喝咖啡或茶。它是由高質量的陶瓷制成的,手感舒適,并且可以放入微波爐和洗碗機。強調其獨特性和手工制作的溫暖感。1. LLM內部處理過程 (簡化版):

(1) 理解輸入 (Tokenization and Embedding):

LLM首先會將你輸入的這段文字切分成一個個小的單元,叫做“token”(可以理解為詞語或標點符號)。比如,“請”、“為”、“一”、“款”、“手工”、“制作”等等。

然后,每個token會被轉換成一個叫做“詞向量”的數字表示。這個詞向量包含了這個詞的語義信息,以及它與其他詞語的潛在關系。

(2) 利用Transformer架構進行理解 (Self-Attention):

接下來,LLM會利用Transformer架構中的自注意力機制來分析這些詞向量之間的關系。

當模型處理到“淡藍色”這個詞的時候,自注意力機制會幫助它注意到“杯子”這個詞,從而理解“淡藍色”是用來描述杯子的顏色。

同樣地,當處理到“手繪”的時候,模型會注意到“白色小花圖案”,理解這是杯子上的裝飾方式。

自注意力機制會為每個詞語都計算出一個“注意力權重”,告訴模型哪些詞語在理解當前詞語時更重要。比如,在理解“適合喝咖啡或茶”時,“咖啡”和“茶”的權重可能會比較高。

(3) 預測下一個詞語 (Iterative Generation):

LLM的目標是生成一段連貫的產品描述。它會從一個起始標記(通常是表示開始的特殊符號)開始,然后根據它對輸入信息的理解,以及它之前學習到的海量文本數據中的語言模式,來預測下一個最有可能出現的詞語。

例如,在理解了這是一個淡藍色、有白色小花圖案的手工陶瓷杯子之后,模型可能會預測下一個詞是“這款”。

(4) 重復預測,逐步生成:

預測出“這款”之后,LLM會將“這款”作為新的輸入,再次進行預測,預測下一個最有可能出現的詞語。可能是“精致”或者“獨特”。

這個過程會不斷重復,直到模型生成一個完整的句子或者段落,或者遇到一個表示結束的特殊標記。

在生成每個詞語的時候,LLM會考慮之前已經生成的詞語,以及輸入的提示信息,確保生成的內容是連貫和有意義的。

(5) 考慮提示中的強調:

LLM也會注意到你在提示中強調了“獨特性”和“手工制作的溫暖感”。這會影響它在生成描述時選擇的詞語和表達方式。它可能會使用一些更具情感色彩的詞語,比如“匠心獨運”、“溫潤”、“細膩”等等。

輸出 (Generated Product Description - 可能的例子):

**感受手工的溫暖,品味生活的精致。** 這款淡藍色的手工陶瓷杯,以其手繪的白色小花圖案,為您帶來一份寧靜與雅致。杯身線條流暢,容量約為350毫升,是您享用早晨咖啡或午后茶歇的理想伴侶。

這款杯子由高品質的陶瓷精心制作而成,不僅手感溫潤舒適,更兼具實用性,可安全放入微波爐和洗碗機。每一朵小花都由匠人手工繪制,賦予了這款杯子獨一無二的藝術魅力,也傳遞著手工制作的溫暖與用心。無論是自用還是作為禮物,這款手工陶瓷杯都能為您和您的親友帶來一份美好的體驗。關鍵原理回顧:

- 預測下一個詞語:LLM在生成描述時,本質上就是在不斷預測下一個最合適的詞語。

- Transformer架構和自注意力機制:模型通過自注意力機制理解了輸入提示中的關鍵信息,比如顏色、圖案、材質、用途等,并建立了它們之間的聯系。

- 海量數據學習:LLM之所以能生成如此流暢和自然的文本,是因為它在海量的文本數據中學習了各種表達方式和語言模式。

- 提示引導:你提供的提示信息有效地引導了LLM生成符合你要求的描述,包括強調獨特性和手工感。

2. 為什么LLM能做到這一點?

LLM通過學習海量的文本數據,已經掌握了非常豐富的語言知識,包括詞語的含義、語法規則、不同語境下的表達方式等等。當它接收到你的提示時,它會利用這些知識,結合你提供的具體信息,來預測最有可能出現的下一個詞語,從而逐步生成一段符合你要求的文本。

這個案例展示了LLM是如何理解輸入,利用其內部的機制進行處理,并最終生成符合要求的輸出的。當然,實際的LLM的內部運作要比這個簡化描述復雜得多,但核心原理是相通的。像DeepSeek 和 ChatGPT 等都是不同公司開發的LLM模型。