AI預(yù)判了你的預(yù)判!人大高瓴團(tuán)隊(duì)發(fā)布TTR,教會(huì)AI一眼看穿你的下一步

本文作者均來(lái)自中國(guó)人民大學(xué)高瓴人工智能學(xué)院。其中,第一作者譚文輝是人大高瓴博士生(導(dǎo)師:宋睿華長(zhǎng)聘副教授),他的研究興趣主要在多模態(tài)與具身智能。本文通訊作者為宋睿華長(zhǎng)聘副教授,她的團(tuán)隊(duì) AIMind 主要研究方向?yàn)槎嗄B(tài)感知、生成與交互。

對(duì)面有個(gè)人向你緩緩抬起手,你會(huì)怎么回應(yīng)呢?握手,還是揮手致意?

在生活中,我們每天都在和別人互動(dòng),但這些互動(dòng)很多時(shí)候都不太確定,很難直接猜到對(duì)方動(dòng)作意圖,以及應(yīng)該作何反應(yīng)。

為此,來(lái)自人大高瓴的研究團(tuán)隊(duì)提出了一種新的框架 ——Think-Then-React (TTR),采用預(yù)訓(xùn)練大語(yǔ)言模型(LLM)+ 運(yùn)動(dòng)編碼器的策略,使模型能夠先「思考」輸入動(dòng)作的意義,再推理出適合的反應(yīng),最后生成連貫的反應(yīng)動(dòng)作。該論文已被 ICLR 2025 接收。

- 論文標(biāo)題:Think-Then-React: Towards Unconstrained Human Action-to-Reaction Generation

- 論文鏈接:https://openreview.net/pdf?id=UxzKcIZedp

- 項(xiàng)目鏈接:Think-Then-React.github.io

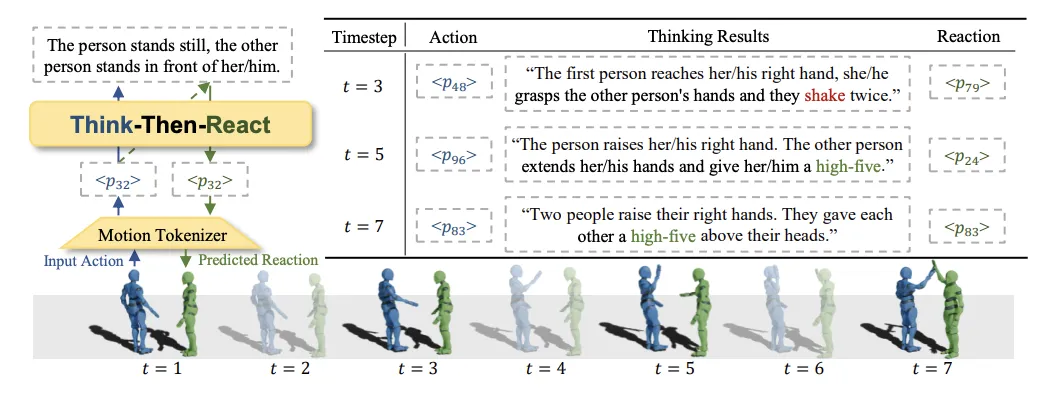

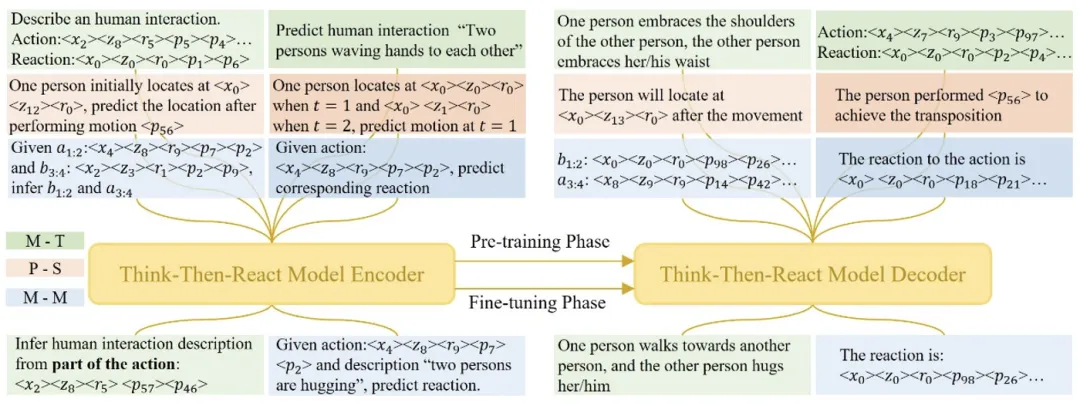

圖1 :Think-Then-React (TTR) 模型總覽圖。TTR 通過(guò)動(dòng)作編碼器將人類(lèi)動(dòng)作編碼為大語(yǔ)言模型可讀的標(biāo)記,進(jìn)而在預(yù)測(cè)人類(lèi)反應(yīng)過(guò)程中使用大語(yǔ)言模型識(shí)別動(dòng)作,推理出合適的反應(yīng)動(dòng)作。推理過(guò)程中,模型不間斷地進(jìn)行重新思考,以避免動(dòng)作的錯(cuò)誤識(shí)別以及累計(jì)誤差。

圖1 :Think-Then-React (TTR) 模型總覽圖。TTR 通過(guò)動(dòng)作編碼器將人類(lèi)動(dòng)作編碼為大語(yǔ)言模型可讀的標(biāo)記,進(jìn)而在預(yù)測(cè)人類(lèi)反應(yīng)過(guò)程中使用大語(yǔ)言模型識(shí)別動(dòng)作,推理出合適的反應(yīng)動(dòng)作。推理過(guò)程中,模型不間斷地進(jìn)行重新思考,以避免動(dòng)作的錯(cuò)誤識(shí)別以及累計(jì)誤差。

方法

統(tǒng)一運(yùn)動(dòng)編碼器

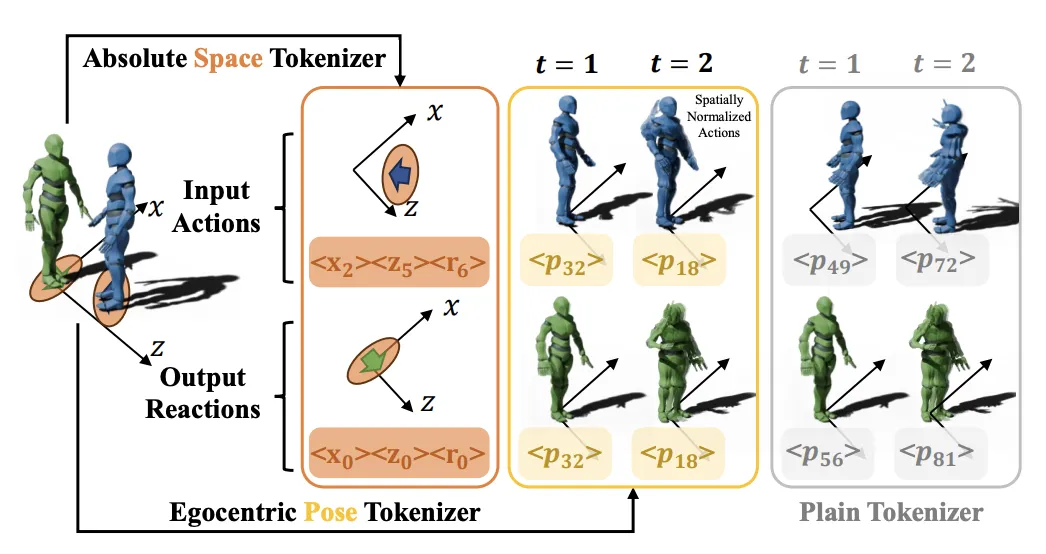

TTR 方法的第一步是通過(guò)統(tǒng)一運(yùn)動(dòng)編碼器處理輸入的動(dòng)作數(shù)據(jù)。過(guò)去的工作通常將人類(lèi)動(dòng)作起始姿態(tài)在空間上規(guī)范化至坐標(biāo)軸原點(diǎn),以保證編碼器的高效利用。然而這種方式忽略了人類(lèi)交互場(chǎng)景中的相對(duì)位置關(guān)系。

為此,作者團(tuán)隊(duì)提出解耦空間 - 位姿編碼,將人類(lèi)動(dòng)作的全局信息(空間中的位置與身體朝向)與局部信息(運(yùn)動(dòng)位姿)分別編碼并組合使用,同時(shí)保證了編碼系統(tǒng)的高效利用與交互過(guò)程中兩人相對(duì)位置信息保留。

圖2 :空間 - 位姿解耦編碼器與傳統(tǒng)編碼器架構(gòu)對(duì)比。

運(yùn)動(dòng) - 文本聯(lián)合預(yù)訓(xùn)練

為了提升模型對(duì)運(yùn)動(dòng)數(shù)據(jù)和語(yǔ)言的理解能力,作者設(shè)計(jì)了一系列運(yùn)動(dòng)與文本相關(guān)的預(yù)訓(xùn)練任務(wù)。這些任務(wù)的目標(biāo)是讓大語(yǔ)言模型能夠同時(shí)處理文本和運(yùn)動(dòng)數(shù)據(jù),從而在多模態(tài)的環(huán)境中進(jìn)行知識(shí)遷移和任務(wù)執(zhí)行。

在這個(gè)階段,模型通過(guò)將運(yùn)動(dòng)數(shù)據(jù)與文本數(shù)據(jù)結(jié)合,學(xué)習(xí)到兩者之間的對(duì)應(yīng)關(guān)系,以便在后續(xù)的反應(yīng)生成過(guò)程中能夠更好地理解和生成與動(dòng)作相關(guān)的反應(yīng)。

圖3 :TTR 預(yù)訓(xùn)練與微調(diào)階段任務(wù)示意圖。

思考 - 反應(yīng)生成(Thinking-Reacting)

TTR 方法的核心是分階段生成反應(yīng)動(dòng)作。具體來(lái)說(shuō),模型首先進(jìn)入「思考」階段(Think),在此階段中,模型理解輸入動(dòng)作的含義,并判斷出什么樣的反應(yīng)是合適的。

接下來(lái),進(jìn)入「反應(yīng)」階段(React),模型根據(jù)思考結(jié)果生成與輸入動(dòng)作相關(guān)的反應(yīng)動(dòng)作。這一過(guò)程類(lèi)似于人類(lèi)的決策和行動(dòng)流程,在某種程度上模擬了人類(lèi)對(duì)外界刺激的反應(yīng)機(jī)制。

實(shí)驗(yàn)

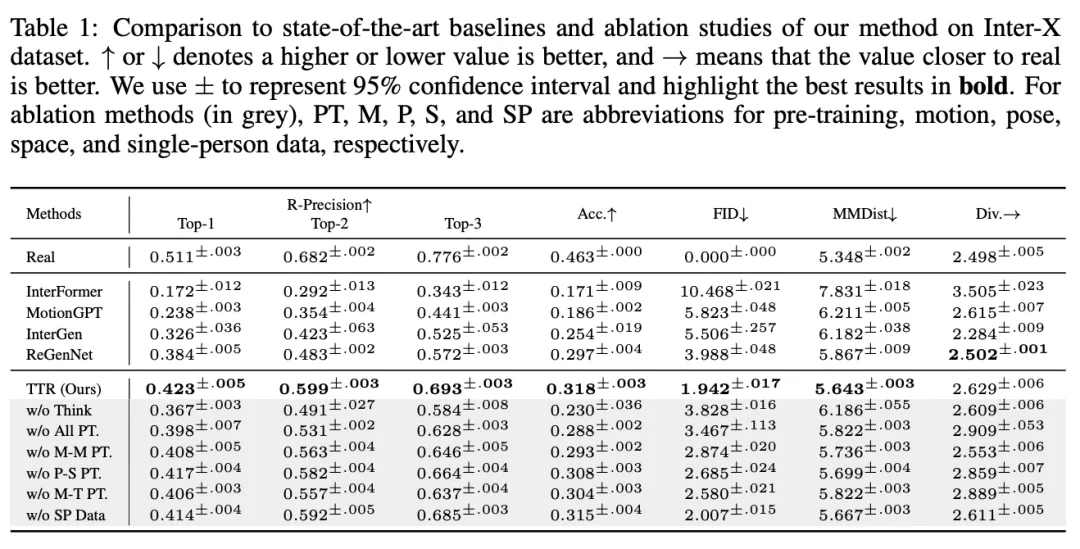

反應(yīng)動(dòng)作生成質(zhì)量測(cè)評(píng)

TTR 在不同的任務(wù)上,包括 R-Precision、分類(lèi)準(zhǔn)確率(Acc.)、Frechet Inception Distance (FID)、多模態(tài)距離(MMDist.)等方面,均取得了優(yōu)異的性能。

TTR 的 FID 僅為 1.942,相較于次優(yōu)方法 ReGenNet (3.988) 顯著降低。此外,在 R-Precision 和分類(lèi)準(zhǔn)確率方面,TTR 也取得了更高的分?jǐn)?shù),表明其生成的反應(yīng)動(dòng)作更加符合輸入動(dòng)作的語(yǔ)義。

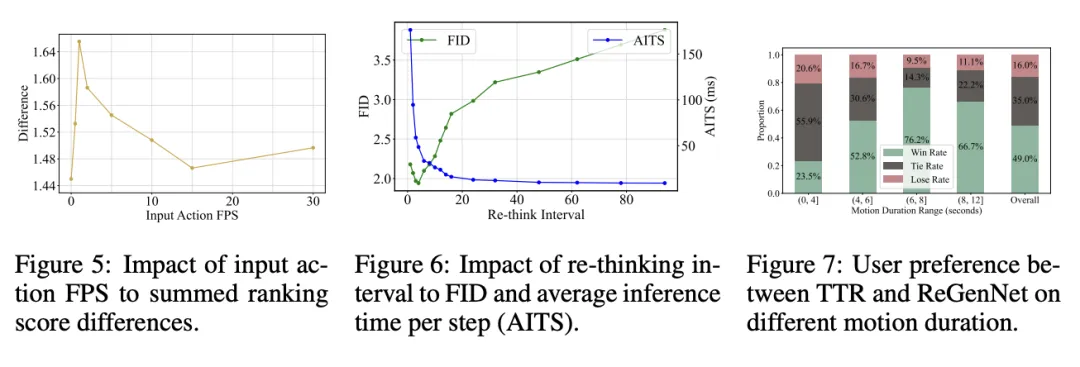

同樣,在對(duì)比 TTR 與 ReGenNet 的用戶研究中,受試者更偏好 TTR 生成的動(dòng)作,特別是在較長(zhǎng)時(shí)間序列的場(chǎng)景中,TTR 以 76.2% 的勝率勝出。

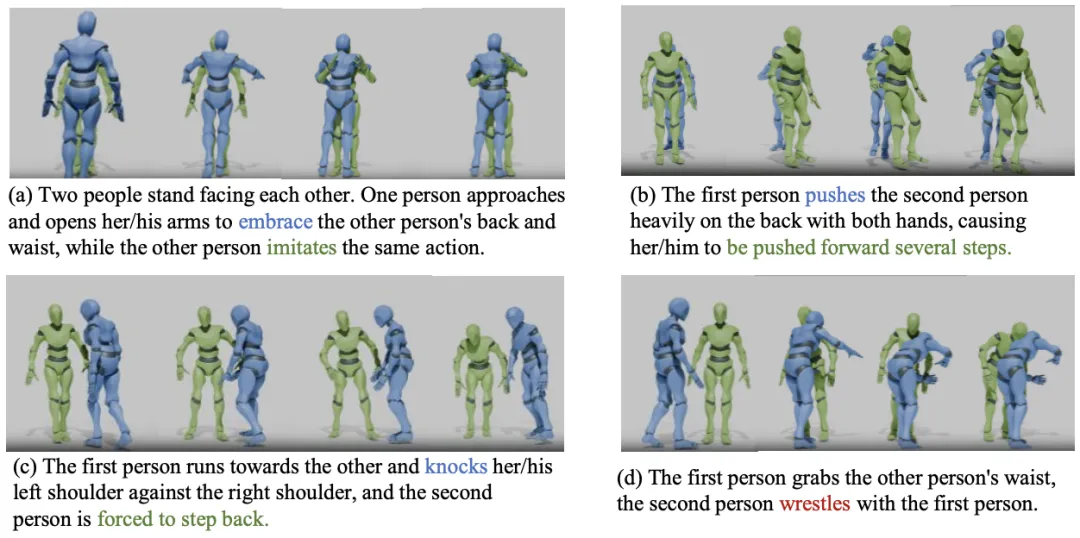

圖4 :TTR 思考與預(yù)測(cè)反應(yīng)(綠色)可視化樣例。在樣例 (a) 至 (c) 中,TTR 思考過(guò)程正確識(shí)別并推理出了相應(yīng)動(dòng)作,進(jìn)而預(yù)測(cè)了正確的反應(yīng)。在樣例 (d) 中,TTR 錯(cuò)誤地將對(duì)方動(dòng)作(藍(lán)色)識(shí)別為「摔跤」(正確動(dòng)作為「擁抱」),預(yù)測(cè)了錯(cuò)誤的反應(yīng)。

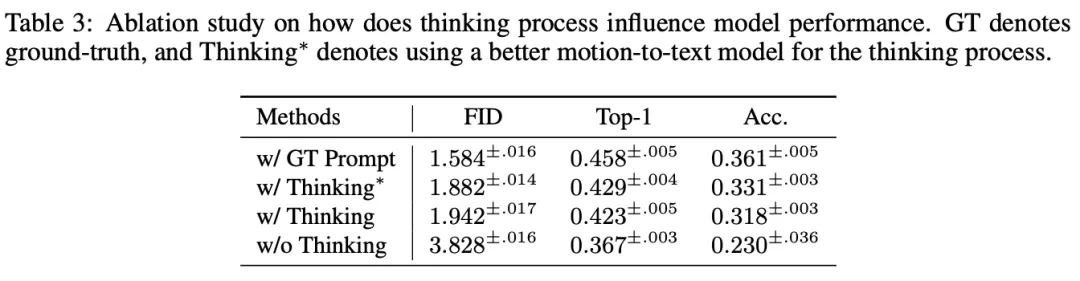

消融實(shí)驗(yàn)

為了更進(jìn)一步驗(yàn)證文中所提方法的有效性,作者團(tuán)隊(duì)進(jìn)行了多項(xiàng)消融實(shí)驗(yàn):

- 去除思考(w/o Think):FID 從 1.942 上升到 3.828,證明了思考階段對(duì)反應(yīng)生成的重要性。

- 去除預(yù)訓(xùn)練(w/o All PT.):模型性能大幅下降,表明預(yù)訓(xùn)練對(duì)于適應(yīng)運(yùn)動(dòng) - 語(yǔ)言模態(tài)至關(guān)重要。

- 去除不同預(yù)訓(xùn)練任務(wù):三種預(yù)訓(xùn)練任務(wù)(動(dòng)作 - 動(dòng)作、空間 - 位姿、動(dòng)作 - 文本)均有正向貢獻(xiàn),互為補(bǔ)充。

- 去除單人數(shù)據(jù)(w/o SP Data):僅依賴多人的數(shù)據(jù)仍可取得較好結(jié)果,單人數(shù)據(jù)的補(bǔ)充對(duì)模型表現(xiàn)提升不顯著。

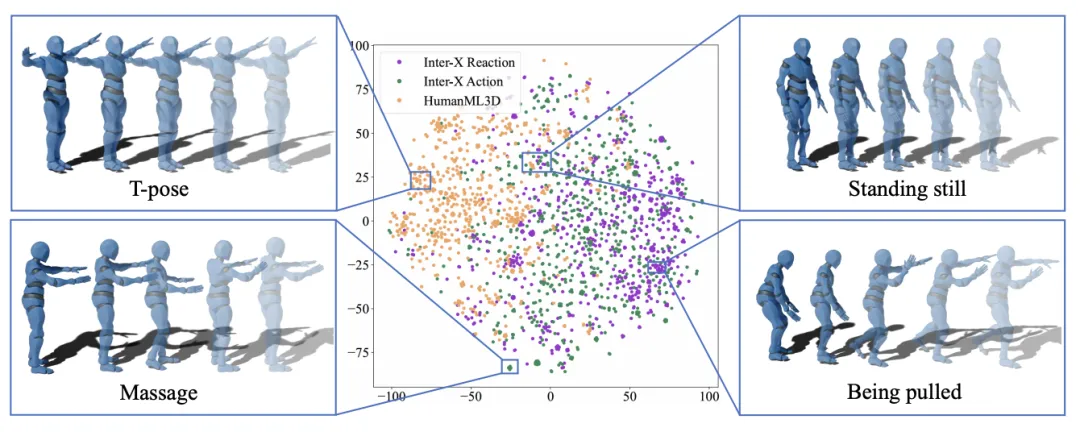

圖五:多人交互數(shù)據(jù)集 Inter-X Action/Reaction 以及單人動(dòng)作數(shù)據(jù)集 HumanML3D 動(dòng)作特征示意圖。

系統(tǒng)分析

- 單人動(dòng)作數(shù)據(jù)有效性

為了進(jìn)一步分析單人數(shù)據(jù)貢獻(xiàn)較小的原因,作者在同一空間中可視化了單人運(yùn)動(dòng)(HumanML3D)、交互動(dòng)作(Inter-X Action)和交互反應(yīng)(Inter-X Reaction)的運(yùn)動(dòng)序列,如上圖所示。

具體而言,該團(tuán)隊(duì)使用 t-SNE 工具將運(yùn)動(dòng)分詞序列的特征投影到二維空間。從上圖可以看出,單人運(yùn)動(dòng)與兩人運(yùn)動(dòng)序列幾乎沒(méi)有重疊。

在案例分析中,作者發(fā)現(xiàn)大多數(shù)交互運(yùn)動(dòng)是獨(dú)特的,例如按摩、被拉拽等,而這些動(dòng)作不會(huì)出現(xiàn)在單人運(yùn)動(dòng)數(shù)據(jù)中。同樣,大多數(shù)單人運(yùn)動(dòng)也是獨(dú)特的,例如 T 字姿勢(shì),很少出現(xiàn)在多人交互中。兩者只有少量重疊的運(yùn)動(dòng),如靜止站立。

- 重新思考時(shí)間間隔

TTR 的重新思考(re-thinking)機(jī)制可以動(dòng)態(tài)調(diào)整生成的反應(yīng)描述,從而減少累積誤差,同時(shí)在計(jì)算成本上保持高效。

實(shí)驗(yàn)表明,過(guò)高與過(guò)低的重新思考頻率均會(huì)導(dǎo)致性能下降。在保證高性能的情況下,TTR 的平均推理時(shí)間可以在單張 Tesla V100 上實(shí)現(xiàn)實(shí)時(shí)推理(延遲低于 50 毫秒)。

- 動(dòng)作描述質(zhì)量

作者還在運(yùn)動(dòng)描述任務(wù)上對(duì) TTR 模型進(jìn)行了評(píng)估,結(jié)果下表所示。基線方法的結(jié)果來(lái)源于 Inter-X 論文的附錄 A.1。由于基線方法均使用動(dòng)作和反應(yīng)作為輸入,而 TTR 的思考過(guò)程僅能訪問(wèn)真實(shí)的動(dòng)作,因此作者首先調(diào)整 TTR 的設(shè)置,使其與基線方法一致,記作 TTR?。

從結(jié)果可以看出,得益于作者的細(xì)粒度訓(xùn)練和高效的運(yùn)動(dòng)表示,TTR? 在所有指標(biāo)上都取得了最佳的運(yùn)動(dòng)描述性能。

隨后在真實(shí)場(chǎng)景下評(píng)估 TTR,即僅能看到部分輸入動(dòng)作。作者分別使用 25%、50% 和完整的輸入動(dòng)作,讓 TTR 進(jìn)行動(dòng)作到文本的生成。

結(jié)果表明,即使僅提供四分之一的輸入動(dòng)作,TTR 仍然能夠準(zhǔn)確預(yù)測(cè)對(duì)應(yīng)的動(dòng)作和反應(yīng)描述,展現(xiàn)出較強(qiáng)的泛化能力。

- 思考 / 動(dòng)作描述

為了探究思考過(guò)程的必要性,作者比較了不同的提示對(duì)反應(yīng)生成的影響。

首先,將真實(shí)提示 (w/ GT Prompt) 輸入到思考過(guò)程中,結(jié)果表明,預(yù)測(cè)的反應(yīng)質(zhì)量顯著提升。

然后,作者采用了一個(gè)增強(qiáng)版的思考模型 (w/ Thinking*),結(jié)果 FID 從 1.94 降至 1.88,這證明了更好的思考過(guò)程能夠有效提升后續(xù)的反應(yīng)生成能力。

此外,當(dāng)完全去除思考過(guò)程時(shí),模型的反應(yīng)生成質(zhì)量大幅下降,這表明思考與重新思考(re-thinking)過(guò)程在指導(dǎo)反應(yīng)生成和減少累積誤差方面至關(guān)重要。

總結(jié)

綜上所述,該團(tuán)隊(duì)借用大語(yǔ)言模型的推理能力,設(shè)計(jì)了「先思考,后反應(yīng)」的人類(lèi)反應(yīng)動(dòng)作預(yù)測(cè)框架 Think-Then-React (TTR),并且通過(guò)解耦空間 - 位姿編碼系統(tǒng)實(shí)現(xiàn)了人類(lèi)動(dòng)作高效編碼,提升了預(yù)測(cè)反應(yīng)動(dòng)作質(zhì)量。

與過(guò)往工作相比,TTR 模型在 Inter-X 數(shù)據(jù)集多個(gè)指標(biāo)上均有明顯提升,同時(shí)作者通過(guò)大量消融實(shí)驗(yàn)與分析實(shí)驗(yàn)驗(yàn)證了方法的有效性。

在未來(lái),作者團(tuán)隊(duì)計(jì)劃探索更高效的跨類(lèi)別數(shù)據(jù)集利用,包括單人與多人動(dòng)作數(shù)據(jù),以實(shí)現(xiàn)更高的泛化性能。