ECCV 2024 | 一眼臨摹:瞥一眼就能模仿筆跡的AI

來(lái)自華南理工大學(xué)、新加坡國(guó)立大學(xué)、昆侖萬(wàn)維以及琶洲實(shí)驗(yàn)室的研究者們提出一種新的風(fēng)格化手寫(xiě)文字生成方法,僅需提供單張參考樣本即可臨摹用戶(hù)的書(shū)寫(xiě)風(fēng)格,支持英文,中文和日文三種文字的臨摹。

一眼臨摹 AI 的研究背景

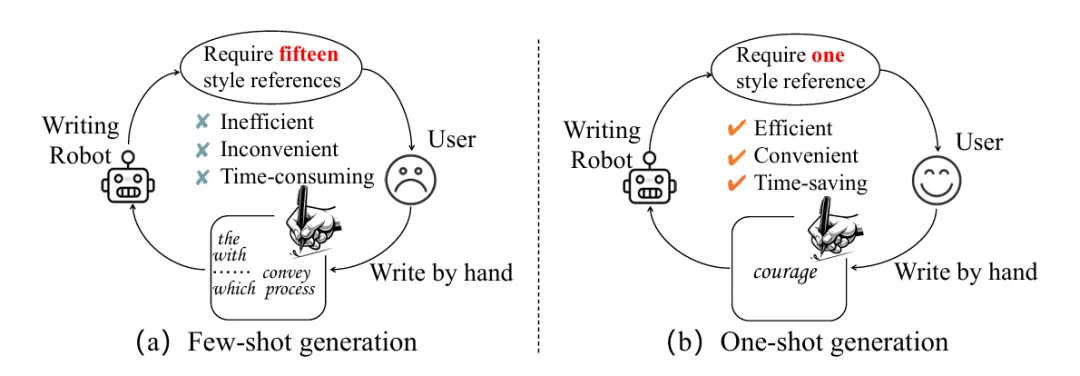

手寫(xiě)體自動(dòng)臨摹是一項(xiàng)有趣的 AI 生成式任務(wù),用戶(hù)只需將少量書(shū)寫(xiě)樣本輸入到筆跡模仿 AI 中,就能獲得一套符合自己書(shū)寫(xiě)風(fēng)格的電子字體。該字體可以用于社交和辦公軟件中,幫助用戶(hù)更好的表達(dá)個(gè)性和傳遞情感,兼顧了傳統(tǒng)手寫(xiě)的人情味和數(shù)字化時(shí)代的高效表達(dá)。

在去年早些時(shí)候,機(jī)器之心也報(bào)道過(guò)一個(gè)CVPR’23筆跡模仿的工作,名為Disentangling Writer and Character Styles for Handwriting Generation。彼時(shí)的筆跡模仿 AI 還需要提供 15 張樣本作為風(fēng)格參考,用戶(hù)使用起來(lái)覺(jué)得略顯繁瑣。在實(shí)際應(yīng)用中,用戶(hù)更傾向于只需單張樣本作為輸入的筆跡模仿 AI,因?yàn)槠涓痈咝В憬菀约肮?jié)約時(shí)間。

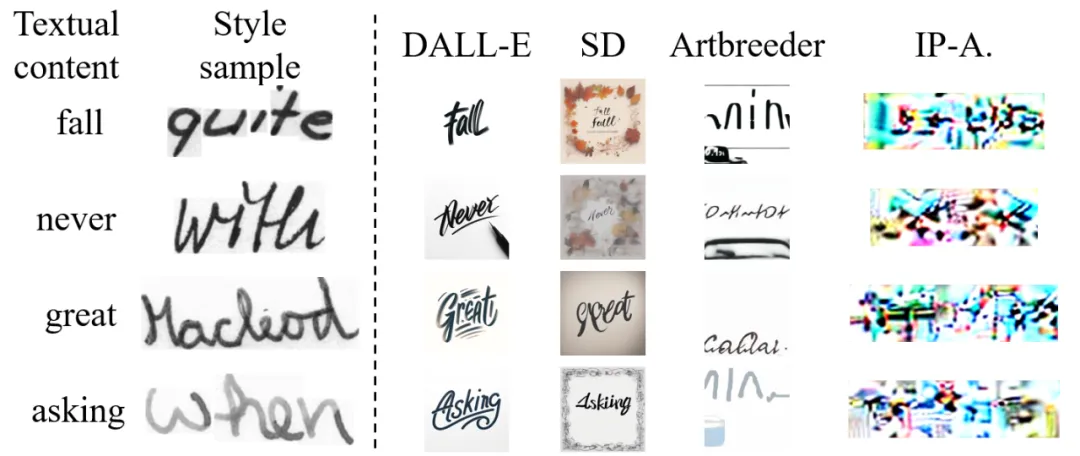

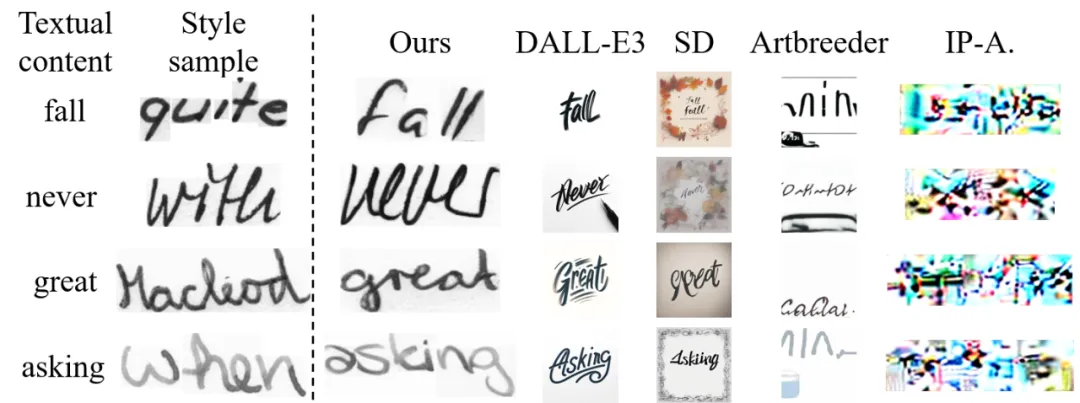

在這篇發(fā)表在 ECCV 2024 上的新工作中,研究者們?cè)O(shè)計(jì)了一種能夠一眼臨摹的手寫(xiě)文字生成方法。該方法僅需單張樣本作為風(fēng)格輸入,為用戶(hù)帶來(lái)更好的使用體驗(yàn)。在具體介紹該工作之前,我們可以思考一個(gè)問(wèn)題:目前大火的文生圖方法和風(fēng)格遷移方法是在海量的數(shù)據(jù)上進(jìn)行訓(xùn)練的,擁有強(qiáng)大的泛化能力,能否可以直接實(shí)現(xiàn)一眼臨摹?答案是否定的。研究者們挑選了 DALL-E3, Stable Diffusion , Artbreeder , IP-Adapter 等工業(yè)方法進(jìn)行測(cè)試,實(shí)驗(yàn)顯示現(xiàn)有工業(yè)方法在手寫(xiě)文字的風(fēng)格臨摹 (墨跡顏色,傾斜程度,字母間的連筆和間隔等) 上離目標(biāo)還有較大距離,暫時(shí)還無(wú)法做到一眼臨摹。

為了實(shí)現(xiàn)一眼臨摹,研究者們提出一個(gè)風(fēng)格化的手寫(xiě)文字生成模型 (stylized handwritten text generation method),該模型能夠從單張手寫(xiě)樣本中臨摹出用戶(hù)的書(shū)寫(xiě)風(fēng)格,進(jìn)而合成任意書(shū)寫(xiě)內(nèi)容的手寫(xiě)筆跡。目前論文的代碼和數(shù)據(jù)已經(jīng)開(kāi)源,歡迎感興趣的小伙伴們上手試玩!

- 論文地址:https://arxiv.org/abs/2409.04004

- 代碼開(kāi)源:https://github.com/dailenson/One-DM

關(guān)鍵問(wèn)題

圍繞上述目標(biāo),研究者們分析了兩個(gè)關(guān)鍵問(wèn)題:1. 用戶(hù)只能提供單張書(shū)寫(xiě)樣本,如何從單張參考樣本中準(zhǔn)確學(xué)習(xí)用戶(hù)獨(dú)特的書(shū)寫(xiě)風(fēng)格呢?換句話(huà)說(shuō),一眼臨摹的要求過(guò)于苛刻,僅僅使用單張樣本能否臨摹出令人滿(mǎn)意的用戶(hù)筆跡?2. 實(shí)際應(yīng)用中,用戶(hù)書(shū)寫(xiě)的紙張可能沒(méi)那么干凈,提供的樣本中存在多樣的噪聲背景,如何在臨摹風(fēng)格的過(guò)程中避免這些噪聲的干擾?接下來(lái)讓我們看看這篇 ECCV2024 提出的 One-DM(One-Shot Diffusion Mimicker)是如何解決上述問(wèn)題的吧。

技術(shù)方案

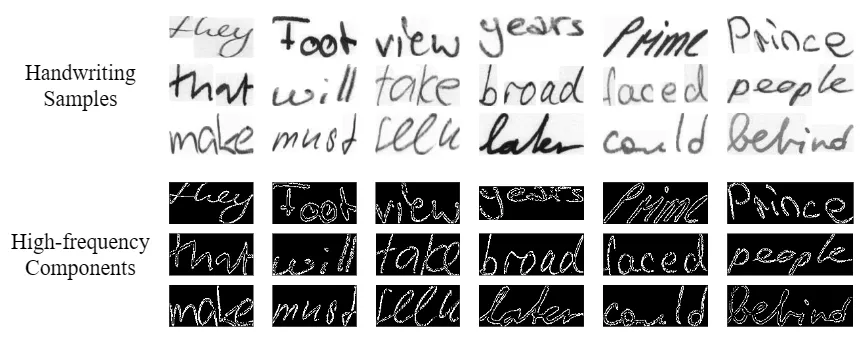

研究動(dòng)機(jī) 研究者發(fā)現(xiàn),由于單張樣本圖像中存在背景干擾,書(shū)寫(xiě)風(fēng)格模式并不清晰,很難直接從原始的樣本圖像中提取出準(zhǔn)確的書(shū)寫(xiě)風(fēng)格。為了解決上述問(wèn)題,研究者對(duì)樣本進(jìn)行高低頻分離,發(fā)現(xiàn)書(shū)寫(xiě)樣本的高頻成分中具有清晰的文字輪廓,蘊(yùn)含著顯著的書(shū)寫(xiě)風(fēng)格模式,包含文字的傾斜,字母間距和連筆模式等。受啟發(fā)于上述觀察,One-DM 旨在引入個(gè)人筆跡的高頻成分來(lái)增強(qiáng)用戶(hù)書(shū)寫(xiě)風(fēng)格的提取。

然而,這聽(tīng)起來(lái)簡(jiǎn)單,實(shí)際操作卻不容易。這里有兩個(gè)尚未解決的難題:(1) 盡管高頻成分中存在更清晰的風(fēng)格模式,如何準(zhǔn)確引導(dǎo) One-DM 從高頻圖像中提取出風(fēng)格特征而不是其他的特征呢?(2) 由于高頻成分中缺乏筆跡顏色,仍然需要從原始樣本中提取風(fēng)格模式作為補(bǔ)充,這導(dǎo)致最終提取出的風(fēng)格特征依然保留了樣本的背景噪聲,從而對(duì)后續(xù)的文字合成過(guò)程產(chǎn)生不利影響。為了解決這些難題,One-DM 提出了兩個(gè)解決策略:(a)拉普拉斯風(fēng)格增強(qiáng)模塊,(b)自適應(yīng)過(guò)濾噪聲的門(mén)控機(jī)制。

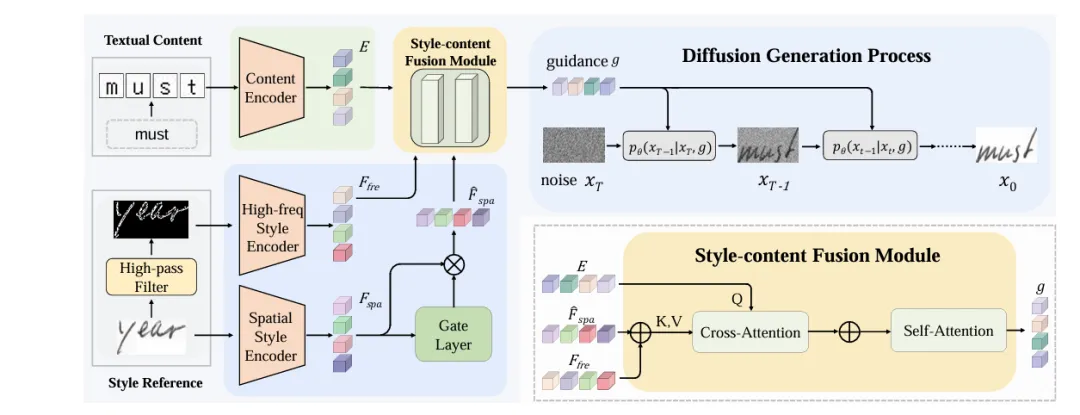

方法框架 One-DM 的整體框架如下圖所示,包含高頻風(fēng)格編碼器、空域風(fēng)格編碼器、內(nèi)容編碼器、風(fēng)格 - 內(nèi)容融合模塊和擴(kuò)散生成模塊。首先,One-DM 利用高通濾波器從原始風(fēng)格參考圖像中提取高頻成分,其次將高頻和原始圖像并行輸入到高頻和空域風(fēng)格編碼器中,分別獲得高頻和空域風(fēng)格特征。然后,利用門(mén)控機(jī)制來(lái)自適應(yīng)過(guò)濾空域風(fēng)格特征中的背景噪聲。接著將內(nèi)容編碼器提取的內(nèi)容特征,高頻風(fēng)格特征和過(guò)濾后的空域風(fēng)格特征送入風(fēng)格 - 內(nèi)容融合模塊中獲得合并后的條件輸入。最后,利用該條件輸入引導(dǎo)擴(kuò)散模型合成滿(mǎn)足期望風(fēng)格和目標(biāo)內(nèi)容的手寫(xiě)文字。

(a) 拉普拉斯風(fēng)格增強(qiáng)模塊 One-DM 提出拉普拉斯風(fēng)格增強(qiáng)模塊來(lái)從單張書(shū)寫(xiě)樣本中高效提取用戶(hù)的書(shū)寫(xiě)風(fēng)格。首先利用拉普拉斯算子獲取原始樣本的高頻成分。相比其他算子,例如:傅里葉算子,索貝爾算子和小波算子,拉普拉斯算子的優(yōu)勢(shì)在于能夠提取更加清晰的字符風(fēng)格模式。隨后,在拉普拉斯對(duì)比學(xué)習(xí)損失函數(shù)(LapNCE)的引導(dǎo)下,高頻風(fēng)格編碼器從高頻成分中提取出判別性強(qiáng)的風(fēng)格模式,用于促進(jìn)手寫(xiě)文本合成的真實(shí)性和多樣性。LapNCE 和高頻成分是不可分割的整體,與其他直接作用于圖像上的對(duì)比學(xué)習(xí)損失函數(shù)不同,LapNCE 只有作用在高頻成分上才能準(zhǔn)確引導(dǎo)風(fēng)格的提取。

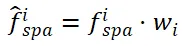

(b) 自適應(yīng)門(mén)控機(jī)制 為了過(guò)濾空域風(fēng)格特征中存在的噪聲信息,One-DM 提出自適應(yīng)門(mén)控機(jī)制。門(mén)控機(jī)制中存在多個(gè)可學(xué)習(xí)的門(mén)控單元 ,其數(shù)量與空域風(fēng)格特征

,其數(shù)量與空域風(fēng)格特征 的長(zhǎng)度相同。門(mén)控單元W的值會(huì)隨著

的長(zhǎng)度相同。門(mén)控單元W的值會(huì)隨著 的改變而自適應(yīng)變化,每個(gè)門(mén)控單元

的改變而自適應(yīng)變化,每個(gè)門(mén)控單元 決定了對(duì)應(yīng)位置

決定了對(duì)應(yīng)位置 的通過(guò)率,使得

的通過(guò)率,使得 較大的位置通過(guò)率越高。該機(jī)制能夠從

較大的位置通過(guò)率越高。該機(jī)制能夠從 獲取有意義的風(fēng)格信息

獲取有意義的風(fēng)格信息 ,同時(shí)抑制多余的背景噪聲,其中

,同時(shí)抑制多余的背景噪聲,其中 。

。

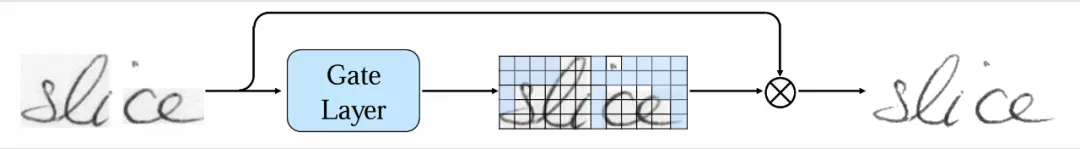

(c) 風(fēng)格 - 內(nèi)容的融合摸塊 獲取了高頻和空域風(fēng)格特征后,如何將風(fēng)格信息和內(nèi)容編碼器提取出的內(nèi)容信息注入到擴(kuò)散模型中,引導(dǎo)后續(xù)的文字生成過(guò)程呢?One-DM 提出先將內(nèi)容信息和風(fēng)格信息融合后再進(jìn)行注入擴(kuò)散模型,而不是分開(kāi)注入。具體來(lái)說(shuō),所提出的風(fēng)格 - 內(nèi)容融合模塊包含兩個(gè) attention 機(jī)制。首先,內(nèi)容信息E作為 query 向量,合并后的風(fēng)格信息作為 key & value 向量,在交叉注意力機(jī)制中,E動(dòng)態(tài)查詢(xún)風(fēng)格信息中與自身最相關(guān)的風(fēng)格特征。然后,將查詢(xún)出的風(fēng)格特征和內(nèi)容信息合并,送入自注意力機(jī)制中完成進(jìn)一步的信息融合。

實(shí)驗(yàn)評(píng)估

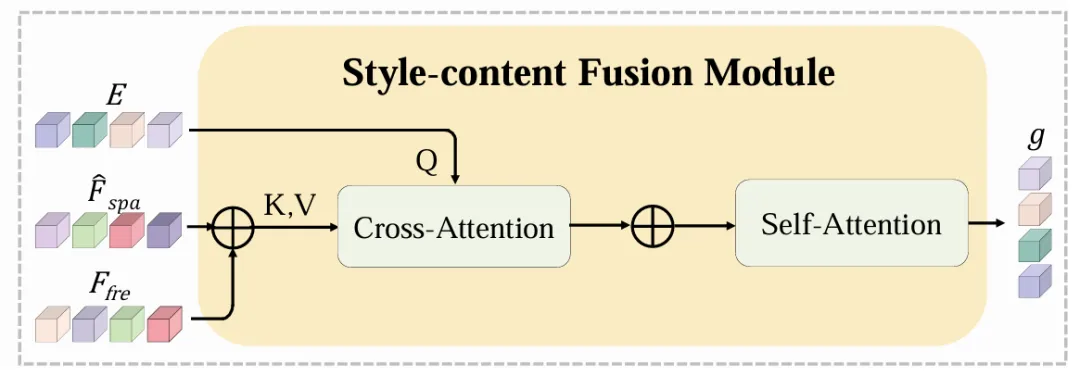

定量評(píng)價(jià) One-DM 在多個(gè)英文、中文和日文數(shù)據(jù)集上都取得了最優(yōu)異的臨摹性能。尤其強(qiáng)調(diào)的是,僅需一張參考樣本的 One-DM 超過(guò)了之前依賴(lài)十幾張參考樣本的 SOTA 方法 (HWT 和 VATr)。

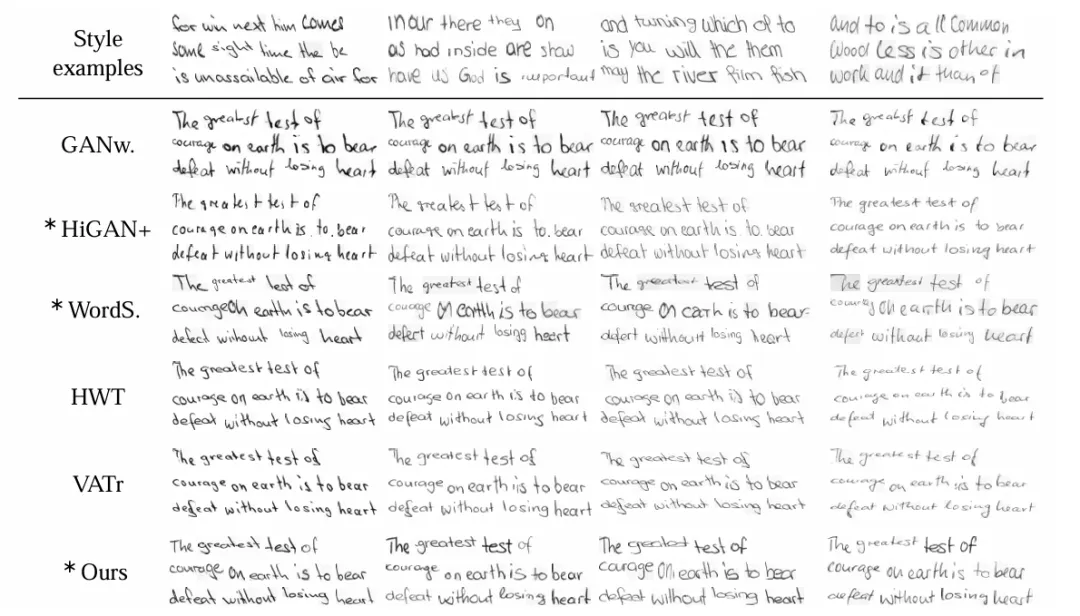

定性評(píng)價(jià) 在英文文本生成任務(wù)上,相比以前的 SOTA 方法,One-DM 生成的結(jié)果可以更好的臨摹出參考樣本的墨跡、字符間隔和筆畫(huà)粗細(xì)等風(fēng)格特征。

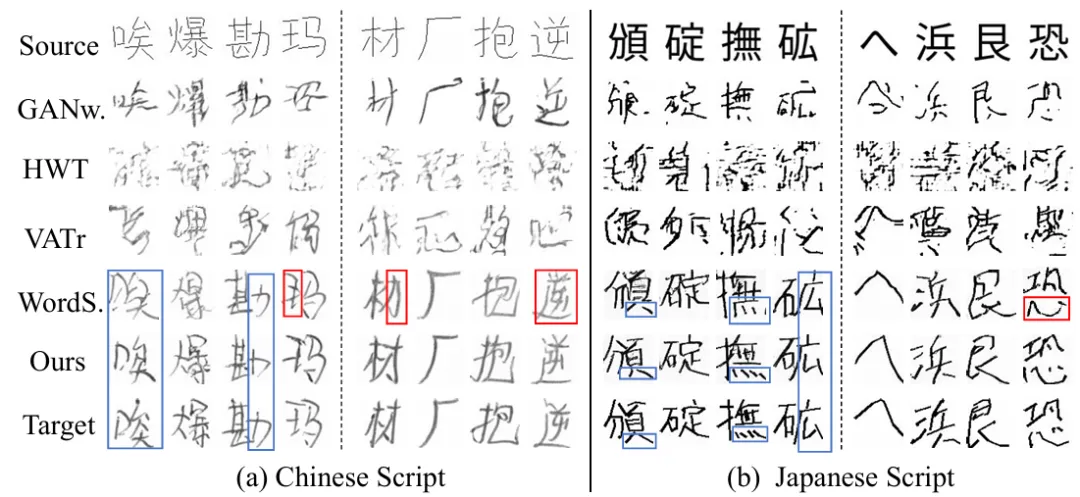

在其他語(yǔ)言上 One-DM 也表現(xiàn)良好。從下圖中可以看出,Diffusion-based (One-DM 和 WordStylist) 的方法在生成中文和日文等字符結(jié)構(gòu)復(fù)雜的文本時(shí),顯著優(yōu)于 GAN-based (GANwriting,HWT 和 VATr) 方法。而相比同為 Diffusion-based 的 WordStylist,One-DM 在字符細(xì)節(jié)上更勝一籌。

與工業(yè)方法對(duì)比,One-DM 也有較大優(yōu)勢(shì)。在英文文本合成任務(wù)上,One-DM 的文本內(nèi)容準(zhǔn)確度和風(fēng)格臨摹上都顯著優(yōu)于現(xiàn)有的主流工業(yè)方法。其中,DALL-E3 跟 Stable Diffusion 表現(xiàn)稍好,可以合成正確的文本內(nèi)容,但是在風(fēng)格臨摹上效果不佳,并且 Stable Diffusion 容易生成多余的背景。而中文文本合成任務(wù)上,One-DM 在字符的墨跡和字符細(xì)節(jié)上與目標(biāo)風(fēng)格更接近。

消融實(shí)驗(yàn)

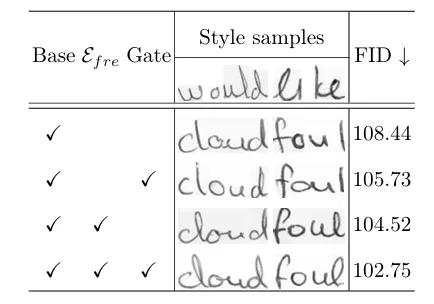

核心模塊對(duì)算法性能的影響 如下表所示,本文提出的拉普拉斯風(fēng)格增強(qiáng)模塊和門(mén)控機(jī)制具有協(xié)同作用,有效提升了對(duì)用戶(hù)筆跡的臨摹性能。此外,實(shí)驗(yàn)也證明了拉普拉斯算子比其他算子提取的風(fēng)格模式更加清晰,有助于提升文字合成性能。

拉普拉斯風(fēng)格增強(qiáng)模塊的分析 實(shí)驗(yàn)驗(yàn)證了高頻成分和拉普拉斯對(duì)比學(xué)習(xí) (LapNCE) 是不可分割的整體:?jiǎn)为?dú)使用會(huì)導(dǎo)致 One-DM 性能顯著下降,聯(lián)合使用二者才能最大程度上提升性能。原因在于,沒(méi)有 LapNCE 的引導(dǎo),One-DM 很難從高頻成分中準(zhǔn)確提取風(fēng)格模式。另一方面,由于原圖中的風(fēng)格模式并不清晰,直接將 LapNCE 應(yīng)用在原圖上也很難提取到理想的風(fēng)格模式。

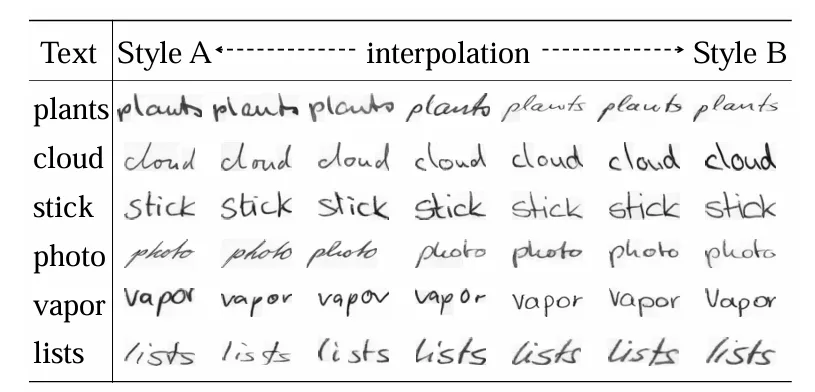

一眼臨摹的深入分析 為什么僅需單張樣本的 One-DM 可以超越需要 10 幾張樣本的 SOTA 方法呢?本文給出了潛在的分析:首先,One-DM 學(xué)習(xí)到了有意義的風(fēng)格特征空間,可以根據(jù)訓(xùn)練過(guò)程中見(jiàn)過(guò)的風(fēng)格靈活創(chuàng)造新的書(shū)寫(xiě)風(fēng)格而不是機(jī)械的記憶訓(xùn)練集中的已有風(fēng)格,如下圖所示。然后,借助拉普拉斯風(fēng)格增強(qiáng)模塊,One-DM 可以從用戶(hù)提供的參考樣本中準(zhǔn)確提取出書(shū)寫(xiě)風(fēng)格特征,并將其映射到特征空間中與用戶(hù)相近的位置,從而產(chǎn)生高質(zhì)量的風(fēng)格化手寫(xiě)文本圖像。

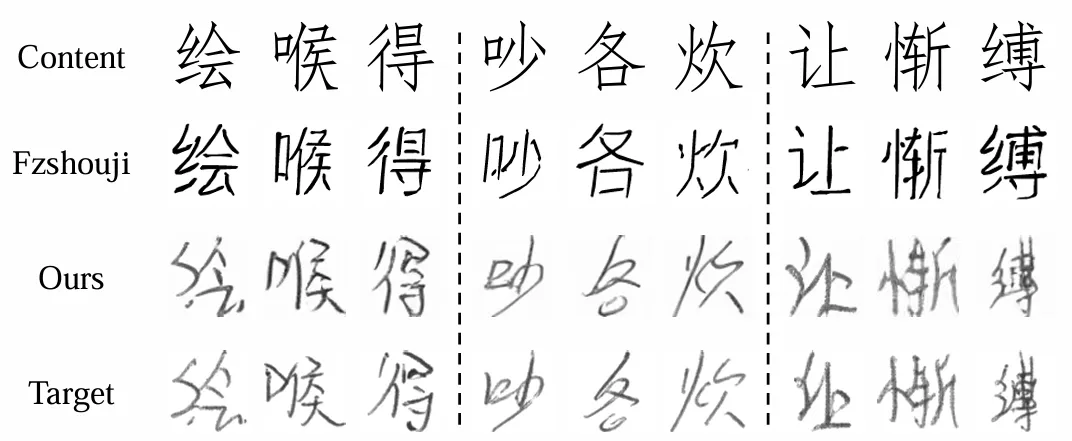

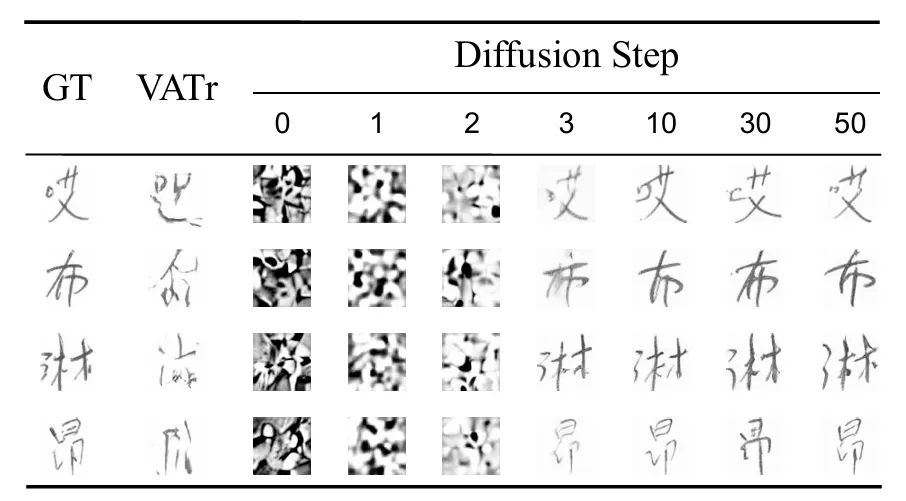

One-DM 在中文和日文實(shí)驗(yàn)上的深入分析 為什么 One-DM 在中文和日文實(shí)驗(yàn)上遠(yuǎn)超 GAN-based 的方法?本文對(duì)此做了進(jìn)一步探究。作者認(rèn)為,GAN-based 方法在較低性能可能源于其基礎(chǔ)卷積架構(gòu)難以處理這些字符的復(fù)雜幾何結(jié)構(gòu)。相比之下,One-DM 作為 Diffusion-based 方法,將中文和日文等復(fù)雜字符的生成過(guò)程分解為更簡(jiǎn)單的步驟。如上圖所示,在擴(kuò)散生成過(guò)程的早期階段,One-DM 首先嘗試生成一個(gè)粗略的中文手寫(xiě)字符。然后,在條件輸入的引導(dǎo)下,模型繼續(xù)細(xì)化書(shū)寫(xiě)風(fēng)格(例如字符形狀和筆畫(huà)顏色),直到合成出令人滿(mǎn)意的手寫(xiě)體。

總結(jié)與展望

One-DM 從用戶(hù)的實(shí)際體驗(yàn)出發(fā),提出了一眼臨摹的筆跡臨摹 AI。相比之前的類(lèi)似工作,One-DM 僅需單張樣本作為風(fēng)格輸入,使用起來(lái)更加高效、便捷和節(jié)約時(shí)間,并且在性能上也優(yōu)于以往依賴(lài) 10 幾張風(fēng)格樣本的 SOTA 工作。希望在未來(lái),人人都可以在互聯(lián)網(wǎng)上使用自己的專(zhuān)屬字體,能夠同時(shí)享受傳統(tǒng)手寫(xiě)體帶來(lái)的人情味與 AI 時(shí)代帶來(lái)的高效便捷。