圖靈獎頒給強化學習師徒,一個造船改行寫代碼,一個痛批AI投身AGI

計算機最高獎圖靈獎揭曉!

強化學習先驅Andrew Barto與Richard Sutton共同獲獎,他們被評價為“引領基礎AI技術開發的研究人員”。

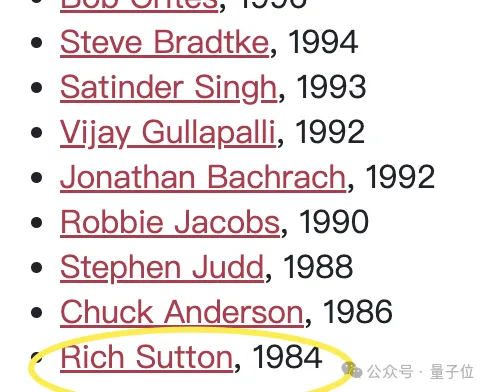

值得一提的是,兩位是師徒關系,Richard Sutton是Andrew Barto他第一位博士生。

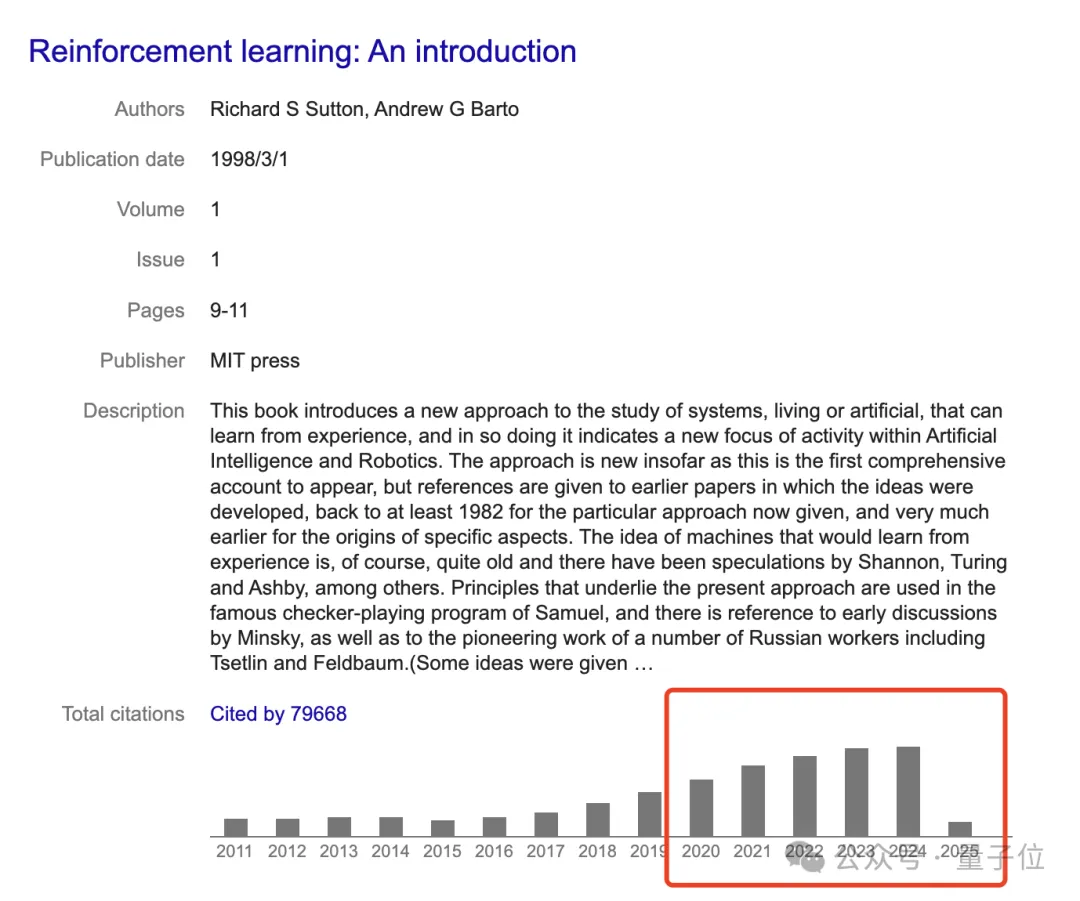

兩人1998年合著的《強化學習:導論》,時至今日也是強化學習的標準教材,引用數接近8萬,尤其在最近五年也仍在持續攀升。

最近幾年來AI的重大進展,從AlphaGo到ChatGPT,都與他們開創的強化學習技術密切相關。

師徒拉開了強化學習大門

先來看Andrew Barto,是馬薩諸塞大學阿默斯特分校信息與計算機科學系榮譽教授,年紀在76歲左右。

他是IEEE Fellow,曾獲馬薩諸塞大學神經科學終身成就獎、IJCAI 研究卓越獎(Research Excellence Award)和 IEEE 神經網絡學會先驅獎。

Barto本科畢業于密歇根大學數學專業,此前他主修的是船舶建筑與工程專業。在閱讀了邁克爾·阿比布、麥卡洛克和皮茨的著作后,他開始對使用計算機和數學來模擬大腦產生了興趣。

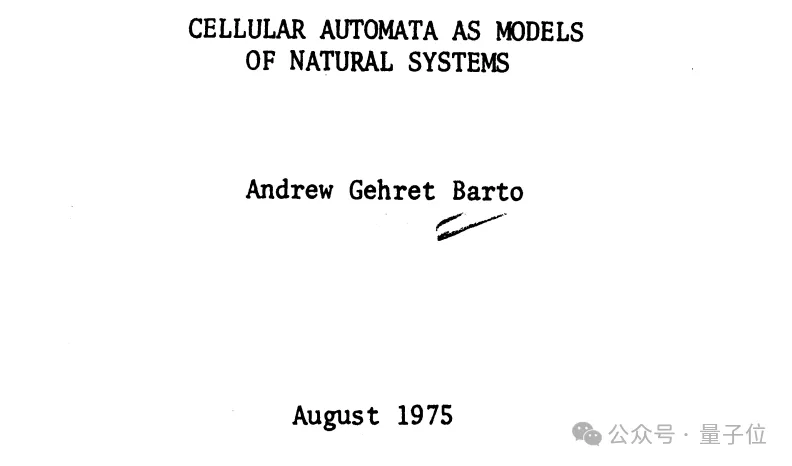

五年后,他以一篇關于細胞自動機的論文獲得了計算機的博士學位。

《細胞自動機作為自然系統的模型》

1977 年,他作為博士后研究助理在馬薩諸塞大學阿默斯特分校開始職業生涯,此后擔任過多個職位,包括副教授、教授和系主任。

任職期間,Barto 共同領導了自主學習實驗室(最初為自適應網絡實驗室),該實驗室提出了強化學習的幾個關鍵思想。

直到Richard Sutton來到他的實驗室,他們正式拉開了強化學習的大門。

2012年他官宣退休,再也不再招收學生。

再來看看他的學生Richard Sutton,時至今日仍然AGI探索積極分子。

目前,他是是阿爾伯塔大學計算機科學教授、Keen Technologies(一家總部位于德克薩斯州達拉斯的通用人工智能公司)的研究科學家,以及阿爾伯塔機器智能研究所(Amii)的首席科學顧問。

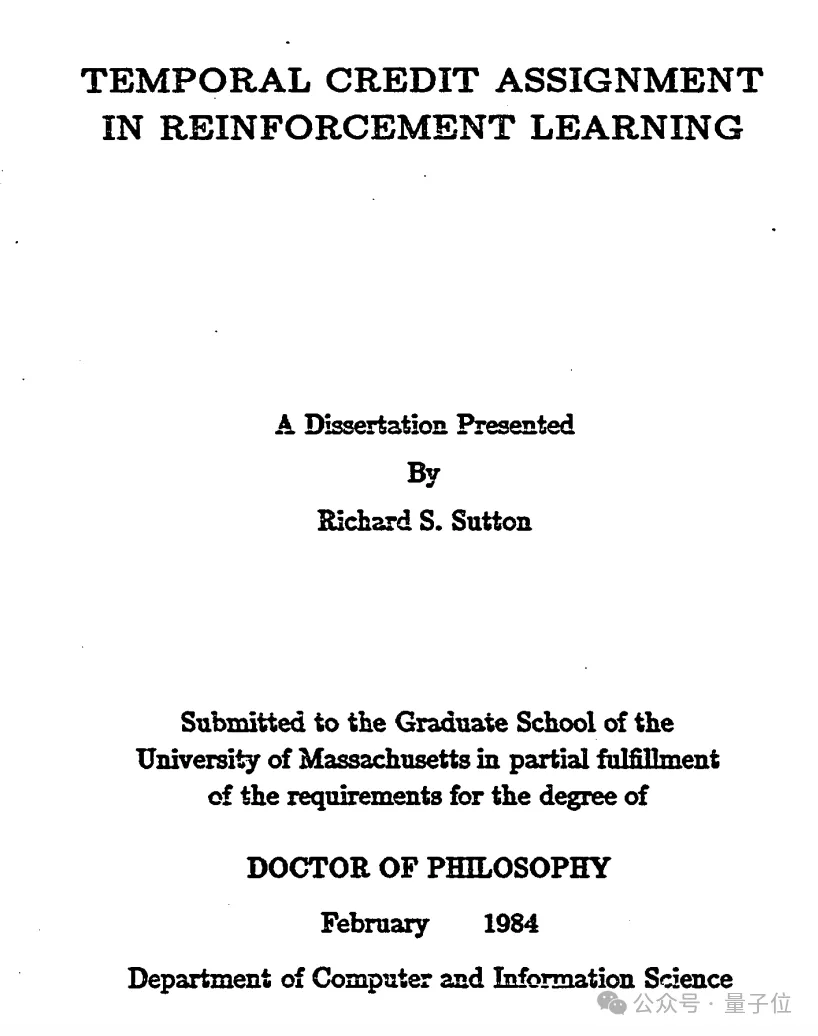

1978年,他從斯坦福大學心理學專業畢業,隨后在Andrew Barto的指導下,先后獲得了碩博學位。

他的博士論文《Temporal Credit Assignment in Reinforcement Learning》(強化學習中的時間學分分配),介紹了行為批判架構和時間學分分配,足足有210頁。

而要說興趣轉向強化學習的緣由,他是受到Harry Klopf在 20 世紀 70 年代的研究成果的影響,該成果提出監督學習不足以用于人工智能或解釋智能行為,而由“行為的享樂方面”驅動的試錯學習才是必要的。

而要說興趣轉向強化學習的緣由,他是受到Harry Klopf在 20 世紀 70 年代的研究成果的影響,該成果提出監督學習不足以用于人工智能或解釋智能行為,而由“行為的享樂方面”驅動的試錯學習才是必要的。

Sutton 從 2017 年到 2023 年是 DeepMind 的杰出研究科學家。在加入阿爾伯塔大學之前,他曾于 1998 年至 2002 年在新澤西州 Florham Park 的 AT&T 香農實驗室人工智能部門擔任首席技術人員。

2019年,他曾撰文《痛苦的教訓》痛批當前AI的發展,表示“未能吸取慘痛教訓,即從長遠來看,建立我們的思維方式是行不通的”。

他認為“70 年的人工智能研究表明,利用計算的通用方法最終是最有效的,而且領先優勢很大”,打敗了在計算機視覺、語音識別、國際象棋或圍棋等特定領域基于人類知識的努力。

2023年,他官宣與John Carmack合作,共同開發AGI,也就是Keen Technologies。

圖靈獎官方科普強化學習

強化學習的起源

強化學習是怎么來的?圖靈獎官網在頒獎公告中介紹到:

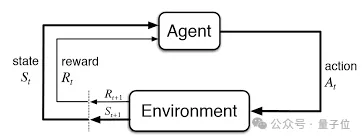

人工智能(AI)領域通常涉及構建智能體——即感知和行動的實體。

更強的智能體選擇更好行動方案。因此,人工智能的核心是某些行動方案比其他方案更好的觀念。獎勵——一個從心理學和神經科學借用的術語——表示提供給智能體與其實際行為質量相關的信號。強化學習(RL)是在此信號下學習如何更成功行為的進程。

獎勵學習的理念對動物培訓師來說已經存在了數千年。

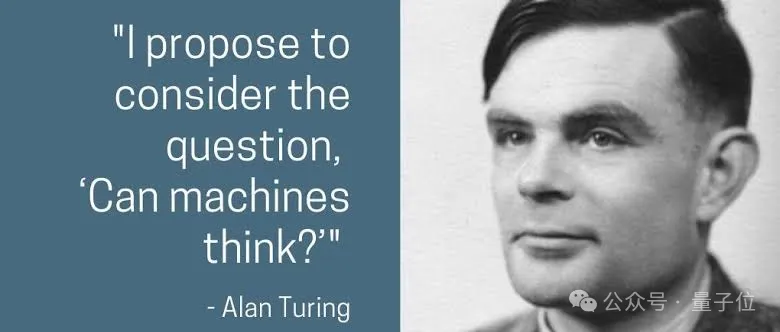

后來,艾倫·圖靈在1950年的論文《Computing Machinery and Intelligence》中提出了“機器能思考嗎?”的問題,并提出了基于獎勵和懲罰的機器學習方法。

雖然圖靈報告稱已經使用這種方法進行了一些初步實驗, 且Arthur Samuel在20世紀50年代末開發了一個通過自我對弈學習的國際象棋程序,但在接下來的幾十年里,人們在這條道路上進步甚微。

直到20世紀80年代初,Barto和他的博士研究生Sutton受到心理學觀察的啟發,開始將強化學習構想為一個通用的問題框架。

他們借鑒了馬爾可夫決策過程(MDPs)提供的數學基礎。在馬爾可夫決策過程中,智能體在隨機環境中做出決策,每次狀態轉移后都會收到一個獎勵信號,并旨在最大化其長期累積獎勵。標準的馬爾可夫決策過程理論假設智能體知曉關于馬爾可夫決策過程的一切信息,而強化學習框架則允許環境和獎勵未知。強化學習所需的最少信息,再加上馬爾可夫決策過程框架的通用性,使得強化學習算法能夠應用于廣泛的問題,如下文將進一步解釋。

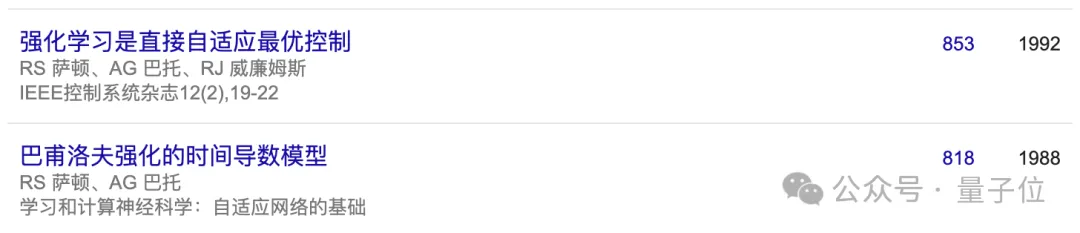

Barto和Sutton共同以及與其他人一起,開發了許多強化學習的基本算法方法。其中包括他們最重要的貢獻——時序差分學習(在解決獎勵預測問題上取得了重大進展),還有策略梯度方法以及將神經網絡用作表示學習函數的工具。

他們還提出了將學習與規劃相結合的智能體設計,展示了獲取環境知識作為規劃基礎的價值。

或許同樣具有影響力的是他們的教科書《Reinforcement Learning: An Introduction》(1998),這本書至今仍是該領域的標準參考文獻,被引用次數超過7.5萬次。它讓數千名研究人員得以理解這一新興領域并為之做出貢獻,直至今日仍激勵著計算機科學領域許多重要的研究活動。

深度強化學習的應用

盡管Barto和Sutton的算法是幾十年前開發的,但強化學習在實際應用中的重大進展卻是在過去十五年中通過將強化學習與深度學習算法(由2018年圖靈獎得主Bengio、Hinton和LeCun 創)相結合而實現的,這催生了深度強化學習技術。

強化學習最著名的例子是AlphaGo在2016年和2017年戰勝了最頂尖的人類圍棋選手。近期的另一項重大成就是ChatGPT。

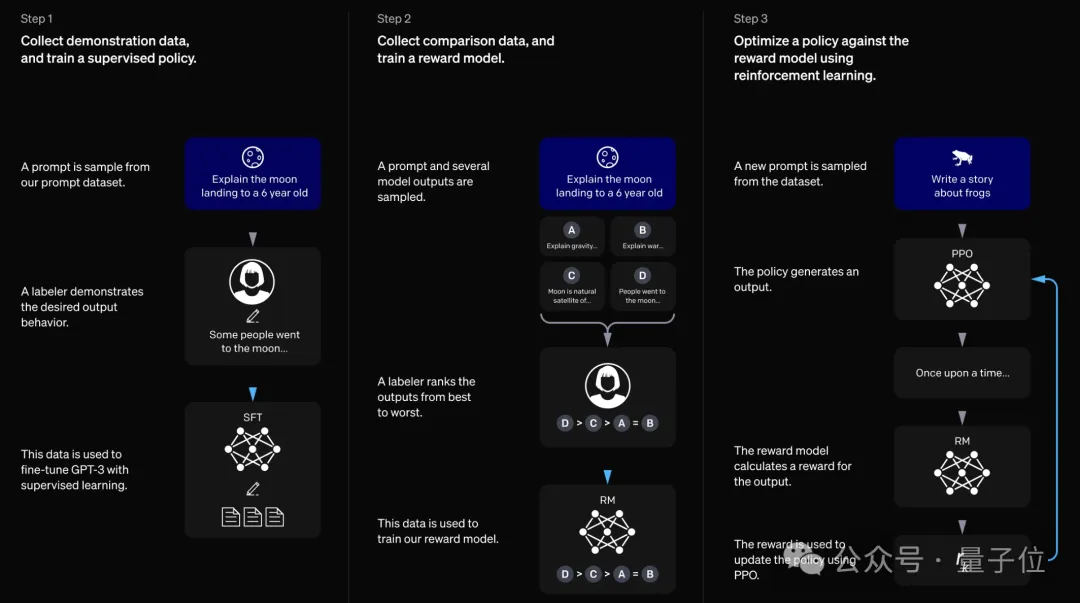

ChatGPT是一個分兩個階段訓練的大語言模型,其中第二階段采用了一種名為基于人類反饋的強化學習(RLHF)的技術,以捕捉人類的期望。

強化學習在許多其他領域也取得了成功。一個備受矚目的研究實例是機器人在手中操作技能學習以及解決實體魔方問題,這表明在模擬環境中進行所有強化學習,最終在差異顯著的現實世界中也能取得成功。

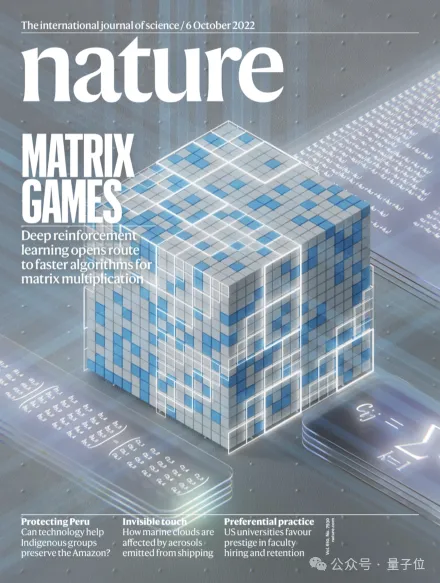

其他領域包括網絡擁塞控制、芯片設計、互聯網廣告、優化、全球供應鏈優化、提升聊天機器人的行為和推理能力,甚至改進計算機科學中最古老問題之一——矩陣乘法的算法。

最后,一項部分受神經科學啟發的技術也反過來帶來了啟發。近期的研究(包括Barto的工作)表明,人工智能領域的特定強化學習算法能夠很好地解釋關于人類大腦中多巴胺系統的一系列研究發現。

美國計算機協會(ACM)主席Yannis Ioannidis稱“Barto和Sutton的工作展示了運用多學科方法應對我們領域長期存在的挑戰所蘊含的巨大潛力”。

從認知科學、心理學到神經科學等研究領域都啟發了強化學習的發展,強化學習為人工智能領域一些最重要的進展奠定了基礎,也讓我們對大腦的工作方式有了更深入的了解。

Barto和Sutton的工作并非我們可以拋在身后的墊腳石。強化學習仍在不斷發展,為計算機科學和許多其他學科的進一步發展提供了巨大潛力。我們用本領域最負盛名的獎項來表彰他們是恰如其分的。”

谷歌高級副總裁Jeff Dean(谷歌為圖靈獎提供資金支持)指出,“Barto和Sutton開創的強化學習直接回應了圖靈的挑戰”。

在過去幾十年里,他們的工作一直是人工智能發展的關鍵。他們開發的工具仍然是人工智能熱潮的核心支柱,帶來了重大進展,吸引了大批年輕研究人員,并推動了數十億美元的投資。強化學習的影響在未來仍將持續。”