ICLR2025|小紅書等提出AI圖像檢測新基準新方法

在數字化浪潮洶涌澎湃的今天,AI生成內容已深度滲透至我們生活的方方面面,從藝術創作到設計領域,再到信息傳播與版權保護,其影響力無處不在。然而,隨著生成模型技術的飛速發展,如何精準甄別AI生成圖像成為業界與學界共同聚焦的難題。

近日,小紅書生態算法團隊、中科大、上海交通大學聯合在ICLR 2025上提出行業稀缺的全人工標注Chameleon基準和行業領先的AIDE檢測方法,為AI生成圖像檢測領域帶來了新的挑戰和曙光。

論文:

https://arxiv.org/pdf/2406.19435

主頁:

https://shilinyan99.github.io/AIDE/

代碼:

https://github.com/shilinyan99/AIDE

01 背景

隨著生成模型的飛速發展,AI生成的圖像在質量上已經達到了前所未有的高度,甚至能夠以假亂真,這在藝術創作、設計等領域帶來了新的機遇,但同時也引發了對圖像真實性的擔憂。如何有效地區分 AI 生成的圖像與真實世界的圖像,成為了圖像取證、打擊虛假信息以及保護版權等領域的關鍵問題。然而現有的 AI 生成圖像檢測方法雖然眾多,但大多在特定的生成模型上訓練和測試,缺乏對真實世界中復雜多樣的 AI 生成圖像的檢測能力,這促使我們重新審視這一任務的解決情況。

因此,研究團隊提出了Chameleon數據集和AIDE檢測器。

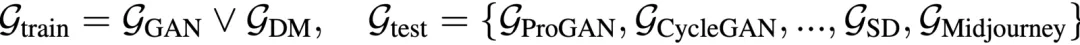

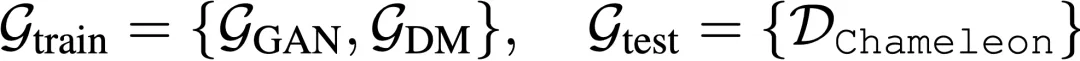

02 問題設定:重新定義 AI生成圖像檢測任務

Train-Test Setting-I:在現有研究中,AI 生成圖像檢測任務通常被設定為在一個特定的生成模型(如 GAN 或擴散模型)上訓練模型,然后在其他生成模型上進行測試。

然而,通常來說,這種設定存在兩個主要問題:

- 評估Benchmark過于簡單:現有Benchmark中的圖像通常會有一些artifacts。

- 訓練數據的局限性:將模型限制在特定類型的生成模型上 (GAN or 擴散模型) 訓練,限制了模型從更先進的生成模型中學習多樣化特征的能力。

為了解決這些問題,我們提出了一個新的問題設定:

Train-Test Setting-II:鑒別器可以將多種生成模型的圖像混合一起訓練,然后在更具挑戰性的、真實世界場景中的圖像上進行測試。這種設定更符合實際應用中的需求,能夠更好地評估模型的泛化能力和魯棒性。

03 ”幻像熔爐“ — Chameleon 數據集:挑戰人類感知的基準

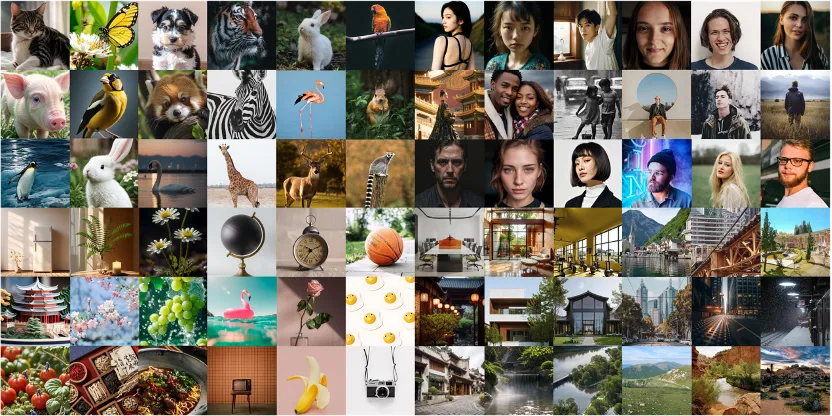

為了更真實地評估 AI 生成圖像檢測方法的性能,我們精心構建了Chameleon 數據集,如下圖展示了我們的Chameleon數據集。

3.1 數據集特點

Chameleon數據集具有以下顯著特點:

- 高度逼真性:所有AI生成圖像均通過了人類感知“圖靈測試”,即人類標注者無法將其與真實圖像區分開來。這些圖像在視覺上與真實圖像高度相似,能夠有效挑戰現有檢測模型的極限。

- 多樣化類別:數據集涵蓋了人類、動物、物體和場景等多類圖像,全面模擬現實世界中的各類場景。這種多樣性確保了模型在不同類別上的泛化能力。

- 高分辨率:圖像分辨率普遍超過720P,最高可達4K。高分辨率圖像不僅提供了更豐富的細節信息,也增加了檢測模型對細微差異的捕捉能力。

3.2 數據集構建

為構建一個能夠真實反映 AI 生成圖像檢測挑戰的高質量數據集,我們在數據收集、清洗和標注環節均采取了創新且嚴謹的方法,確保數據集的高質量和高逼真度。

3.2.1 數據收集:多渠道、高逼真度圖像獲取

與之前的基準數據集不同,我們從多個流行的 AI 繪畫社區(如 ArtStation、Civitai 和 Liblib)收集了超過 150K 的 AI 生成圖像,這些圖像均由廣泛的用戶創作,使用了多種先進的生成模型(如 Midjourney、DALL·E 3 和 Stable Diffusion 等)。這些圖像不僅在視覺上逼真,而且涵蓋了豐富多樣的主題和風格,包括人物、動物、物體和場景等。此外,我們還從 Unsplash 等平臺收集了超過 20K 的真實圖像,這些圖像均由專業攝影師拍攝,具有高分辨率和高質量。所有圖像均獲得了合法授權,確保了數據的合法性和可用性。

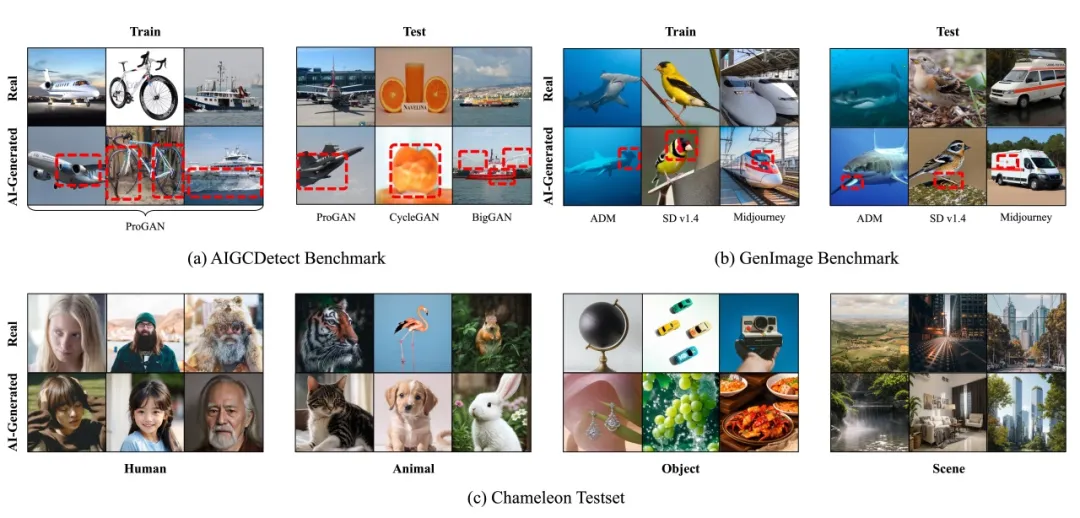

相比之下,之前的基準數據集通常使用生成效果較差的模型生成圖像,缺乏多樣性和真實感,如下圖所示。

3.2.2 數據清洗:多維度、精細化過濾

為確保數據集的高質量,我們對收集的圖像進行了多維度、精細化的清洗過程:

- 分辨率過濾:我們過濾掉了分辨率低于 448×448 的圖像,確保所有圖像具有足夠的細節和清晰度,以反映 AI 生成圖像的真實特性。

- 內容過濾:利用先進的安全檢查模型(如 Stable Diffusion 的安全檢查模型),我們過濾掉了包含暴力、色情和其他不適宜內容的圖像,確保數據集的合規性和適用性。

- 去重處理:通過比較圖像的哈希值,我們去除了重復的圖像,確保數據集的多樣性和獨立性。

- 文本-圖像一致性過濾:利用 CLIP 模型,我們計算了圖像與對應文本描述的相似度,過濾掉了與文本描述不匹配的圖像,確保圖像與文本的一致性和相關性。

之前的基準數據集往往缺乏嚴格的過濾步驟,導致數據集中包含大量低質量的圖像,影響了數據集的整體質量。

3.2.3 數據標注:專業標注平臺與多輪評估

為確保數據集的準確性和可靠性,我們建立了專門的標注平臺,并招募了 20 名具有豐富經驗的人類標注者對圖像進行分類和真實性評估:

- 分類標注:標注者將圖像分為人類、動物、物體和場景四類,確保數據集覆蓋了多種現實世界中的場景和對象。

- 真實性評估:標注者根據“是否可以用相機拍攝”這一標準對圖像的真實性進行評估。每個圖像獨立評估兩次,只有當兩名標注者均誤判為真實時,圖像才被標記為“高逼真”。

- 多輪評估:為確保標注的準確性,我們對標注結果進行了多輪審核和校對,確保每個圖像的分類和真實性評估結果準確無誤。

與之前的基準數據集不同,我們的數據集經過了嚴格的人工標注,確保了數據集的高質量和高逼真度。之前的基準數據集往往缺乏嚴格的人工標注,導致數據集中的圖像質量和標注準確性參差不齊。

通過上述多維度、精細化的數據收集、清洗和標注過程,我們構建了一個高質量、高逼真度的 AI 生成圖像檢測基準數據集,為后續的研究和模型評估提供了堅實的基礎。我們的數據集不僅在規模上更大,而且在圖像質量和標注精度上也有了顯著提升,能夠更好地反映 AI 生成圖像檢測的實際挑戰。

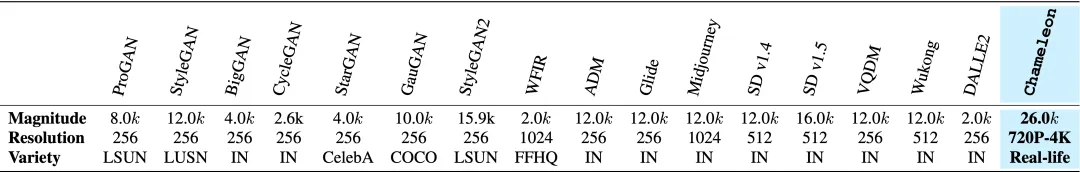

3.3 數據集對比

Chameleon數據集可以作為現有評測數據集的擴展,Chameleon數據集在規模、多樣性和圖像質量等方面均展現出顯著優勢:

- 規模:Chameleon數據集包含約26,000張測試圖像,是目前最大的AI生成圖像檢測數據集之一。

- 多樣性:數據集涵蓋了多種生成模型和圖像類別,遠超其他數據集的單一類別。

- 圖像質量:圖像分辨率從720P到4K不等,提供了更高質量的圖像數據,增加了檢測模型的挑戰性。

04 ”超級偵探“ — AIDE模型:多專家融合的檢測框架

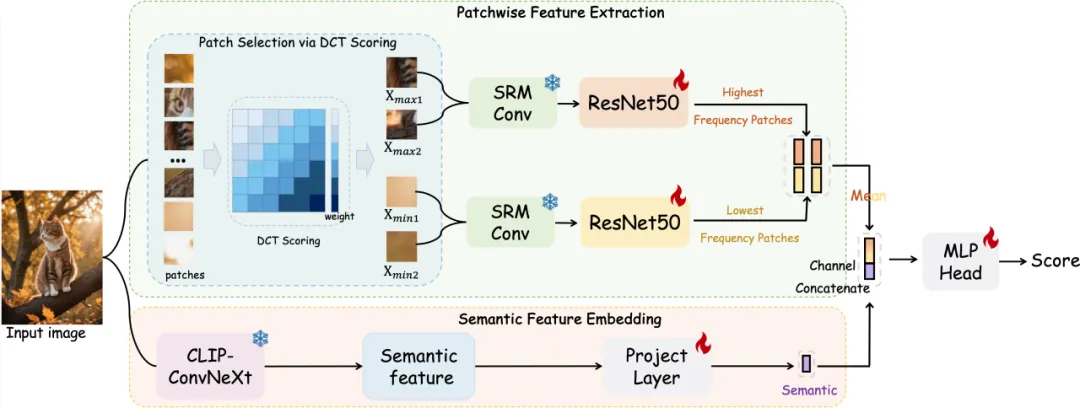

在AI生成圖像檢測領域,現有的檢測方法往往只能從單一角度進行分析,難以全面捕捉AI生成圖像與真實圖像之間的細微差異。為了解決這一問題,研究者們提出了簡單且有效的AIDE(AI-generated Image DEtector with Hybrid Features)模型,該模型通過融合多種專家模塊,從低級像素統計和高級語義兩個層面全面捕捉圖像特征,實現了對AI生成圖像的精準檢測。

4.1 模型整體架構

AIDE模型主要由兩個核心模塊組成:Patchwise Feature Extraction(PFE)模塊和Semantic Feature Embedding(SFE)模塊。這兩個模塊通過多專家融合的方式,共同為最終的分類決策提供豐富的特征信息。

4.2 Patchwise Feature Extraction(PFE)模塊

PFE模塊旨在捕捉圖像中的低級像素統計特征,特別是AI生成圖像中常見的噪聲模式和紋理異常。具體而言,該模塊通過以下步驟實現:

- Patch Selection via DCT Scoring:首先,將輸入圖像劃分為多個固定大小的圖像塊(如32×32像素)。然后,對每個圖像塊應用離散余弦變換(DCT),將其轉換到頻域。通過設計不同的帶通濾波器,計算每個圖像塊的頻率復雜度得分,從而識別出最高頻率和最低頻率的圖像塊。

- Patchwise Feature Encoder:將篩選出的高頻和低頻圖像塊調整為統一大小(如256×256像素),并輸入到SRM(Spatial Rich Model)濾波器中提取噪聲模式特征。這些特征隨后通過兩個ResNet-50網絡進行進一步處理,得到最終的特征圖。

4.3 Semantic Feature Embedding(SFE)模塊

SFE模塊旨在捕捉圖像中的高級語義特征,特別是物體共現和上下文關系等。具體而言,該模塊通過以下步驟實現:

- Semantic Feature Embedding:利用預訓練的OpenCLIP模型對輸入圖像進行全局語義編碼,得到圖像的視覺嵌入特征。通過添加線性投影層和平均空間池化操作,進一步提取圖像的全局上下文信息。

4.4 Discriminator模塊

將PFE和SFE模塊提取的特征在通道維度上進行融合,通過多層感知機(MLP)進行最終的分類預測。具體而言,首先對高頻和低頻特征圖進行平均池化,得到低級特征表示;然后將其與高級語義特征進行通道級拼接,形成最終的特征向量;最后通過MLP網絡輸出分類結果。

05 實驗

5.1 實驗設置

1. 數據集:實驗在AIGCDetectBenchmark、GenImage和Chameleon三個數據集上進行。AIGCDetectBenchmark和GenImage是現有的基準測試數據集,而Chameleon是研究者們新構建的更具挑戰性的數據集。

2. 模型對比:研究者選擇了9種現成的AI生成圖像檢測器進行對比,包括CNNSpot、FreDect、Fusing、LNP、LGrad、UnivFD、DIRE、PatchCraft和NPR。

3. 評價指標:實驗采用分類準確率(Accuracy)和平均精度(Average Precision, AP)作為評價指標。

5.2 實驗結果

5.2.1 AIGCDetectBenchmark & GenImage

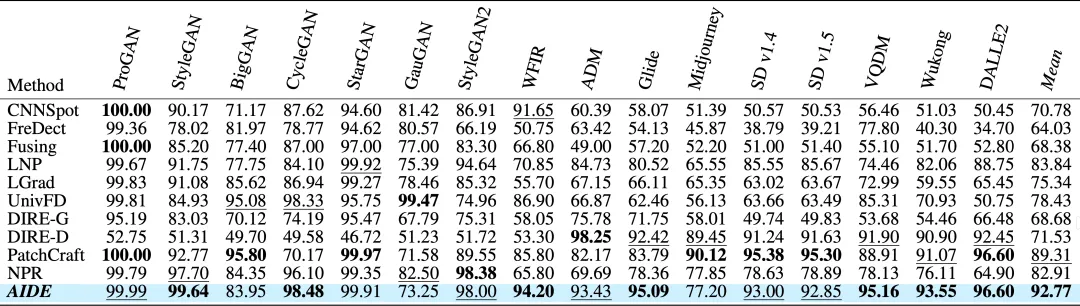

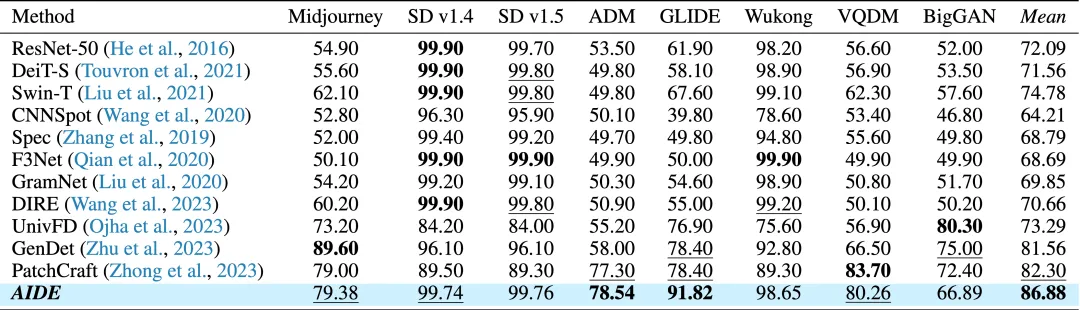

我們評測了AIDE在AIGCDetectBenchmark和GenImage上的結果,如下表所示:

AIDE模型在這兩個數據集上的優異表現表明,融合低級像素統計和高級語義特征的方法能夠有效捕捉AI生成圖像與真實圖像之間的差異,從而提高檢測準確率。

5.2.2 Chameleon數據集

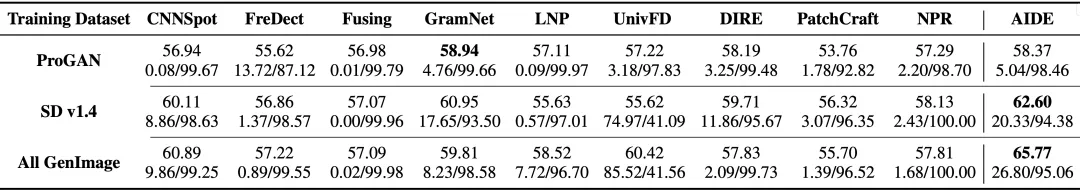

我們在Chameleon benchmark上測評了9個現有的detectors,如下表所示。

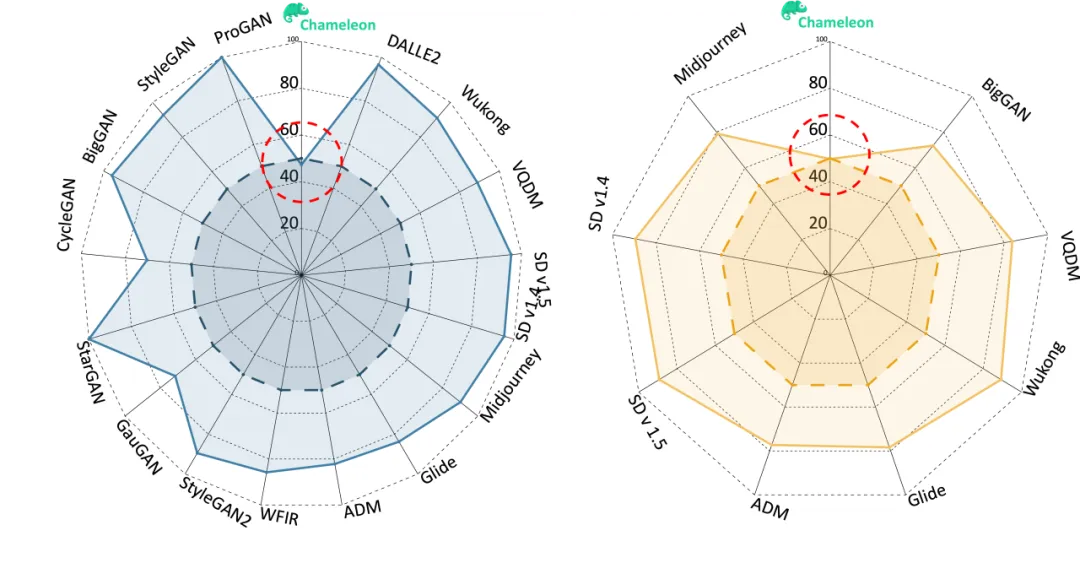

同時我們可視化了,之前的SOTA方法PatchCraft在AIGCDetectBenchmark & GenImage 以及Chameleon上的表現,如下圖所示:

結果表明,之前在AIGCDetectBenchmark &GenImage上表現優異的模型,在我們Chameleon benchmark上均表現很差,這表明Chameleon數據集中的圖像確實具有高度的逼真性,對現有檢測模型提出了更大的挑戰。

06 結論與展望

本論文通過對現有 AI 生成圖像檢測方法的重新審視,提出了一個新的問題設定,構建了更具挑戰性的 Chameleon 數據集,并設計了一個融合多專家特征的檢測器 AIDE。實驗結果表明,AIDE 在現有的兩個流行基準(AIGCDetectBenchmark 和GenImage)上取得了顯著的性能提升,分別比現有的最先進方法提高了 3.5% 和 4.6% 的準確率。然而,在我們提出的 Chameleon 基準上,盡管 AIDE 取得了最好的性能,但與現有基準相比,仍存在較大的差距。這表明,檢測 AI 生成圖像的任務仍然具有很大的挑戰性,需要未來進一步的研究和改進。我們希望我們的工作能夠為這一領域的研究提供新的思路和方向,推動 AI 生成圖像檢測技術的發展。

盡管AIDE模型在AI生成圖像檢測領域取得了顯著進展,但研究者們仍計劃在未來的工作中進一步優化模型架構,此外,研究者們還計劃擴大Chameleon數據集的規模,涵蓋更多類別、更多場景、更多生成模型的圖像,以推動AI生成圖像檢測技術的進一步發展,敬請期待!

同時團隊還有一篇輕量高效的AI圖像檢測的工作「Improving Synthetic Image Detection Towards Generalization: An Image Transformation Perspective」*, 發表于KDD2025, 僅用1.44M參數超越SOTA4.5個點。

*上述論文鏈接:https://arxiv.org/abs/2408.06741

07 作者介紹

大少

小紅書多模態算法工程師,碩士畢業于復旦大學計算機系,曾在 ICLR、NeurIPS、CVPR、ECCV、AAAI等機器學習與計算機視覺領域頂級會議上發表 10 余篇論文,曾獲2024全球DeepFake攻防挑戰賽 Global Multimedia Deepfake Detection Challenge 2024 Video Detection 任務全球亞軍、YouTube-VOS 視頻分割競賽全球亞軍等。主要研究方向:多模態大模型、多模態理解 & 生成、多模態表征、AIGC生成&鑒別等。

嘉音

小紅書多模態算法工程師,碩士畢業于清華大學計算機系,負責小紅書社區生態場景下大模型算法研究與應用。曾在ICLR、 CVPR、ACM MM、 KDD 等機器學習、計算機視覺、數據挖掘領域頂會發表數篇論文,曾獲2024全球DeepFake攻防挑戰賽 Global Multimedia Deepfake Detection Challenge 2024 Video Detection 任務全球亞軍。主要研究方向:多模態大模型、AIGC生成&鑒別、視頻理解、視頻編輯等。

萊戈

小紅書生態算法團隊負責人。曾在 CVPR、ICCV、ICLR、ECCV、IJCV 等會刊發表 10 余篇論文,曾獲 YouTube-VOS 視頻分割競賽 Top-3 排名,曾獲天池視覺分割大獎賽復賽第 1 名。主要研究方向:目標跟蹤、視頻分割、多模態分類/檢索、多模態大模型等。