全新模型RoboVLMs解鎖VLA無限可能,真實機器人實驗交出滿分答卷

本文作者來自清華大學、字節跳動、中科院自動化所、上海交通大學和新加坡國立大學。作者列表:李興航、李沛言、劉明桓、王棟、劉濟榕、康炳易、馬驍、孔濤、張翰博和劉華平。第一作者李興航是清華大學計算機系博士生。通訊作者是字節跳動機器人研究員孔濤,新加坡國立大學博士后張翰博和清華大學計算機系教授劉華平。

近年來,視覺語言基礎模型(Vision Language Models, VLMs)大放異彩,在多模態理解和推理上展現出了超強能力。現在,更加酷炫的視覺語言動作模型(Vision-Language-Action Models, VLAs)來了!通過為 VLMs 加上動作預測模塊,VLAs 不僅能 “看” 懂和 “說” 清,還能 “動” 起來,為機器人領域開啟了新玩法!

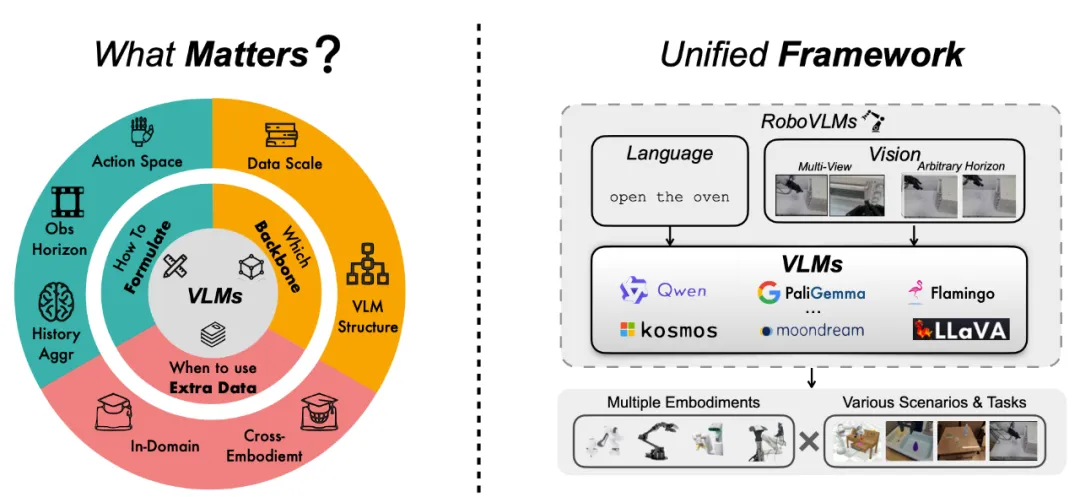

雖然 VLAs 在各種任務和場景中表現搶眼,但大家在模型設計上卻走了很多不同的路,比如用什么架構、怎么選數據、怎么調訓練策略等等,這導致領域內對 “怎么做好一個 VLA” 還沒有統一的答案。為了理清這些問題,我們通過一系列的實驗,提出了一個全新模型 ——RoboVLMs。

- 論文標題:Towards Generalist Robot Policies: What Matters in Building Vision-Language-Action Models

- 論文地址:https://arxiv.org/pdf/2412.14058

這個模型超級簡單,但性能卻相當硬核!它不僅在三個模擬任務中取得了高分,還在真實機器人實驗中交出了滿分答卷。這篇文章就是要帶你一起看看,我們是如何用 RoboVLMs 解鎖 VLA 的無限可能!

四大靈魂拷問:RoboVLMs 是怎么煉成的?

我們圍繞四個關鍵問題,對 VLA 的設計展開了深度探索,下面就帶你看看答案!

1. 為什么要用 VLA 模型?

簡單說,通過實驗,我們發現設計合理的 VLA 不僅能輕松搞定常見的操作任務,還能在陌生場景中穩穩發揮。

仿真任務中拿下頂尖成績

在 CALVIN 和 SimplerEnv 環境里,RoboVLMs 取得了壓倒性的勝利:

- 任務成功率:表現穩定且超越主流模型。

- 泛化能力:即使在陌生場景中,表現依然抗打!

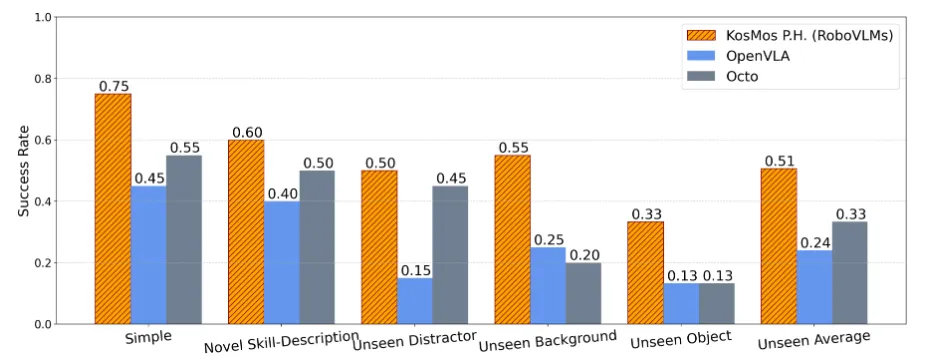

圖 1 SimplerEnv 仿真環境中的評測結果

圖 2 針對視覺語言預訓練的消融實驗結果

真實機器人實驗也不輸

在真實環境中,RoboVLMs 面對更復雜的挑戰,仍然比其他模型表現更好。比如,在果蔬分類任務中,它不僅能精準識別,還能應對干擾環境,穩穩完成分類操作。無論是已知場景還是新任務,它都能輕松拿下。

圖 3 真實環境下的評測結果

對于未見過的技能描述、背景、干擾物體和目標物體,RoboVLMs 均能很好的完成任務。

2. 怎么設計一個靠譜的 VLA 架構?

這里面講究可不少!比如:

- 動作空間:用連續動作空間比離散的好很多。

- 歷史信息:加多步歷史信息后,模型的操作更穩準狠。

- 歷史信息組織模塊:一個專門的模塊可以讓模型更懂 “上下文”。

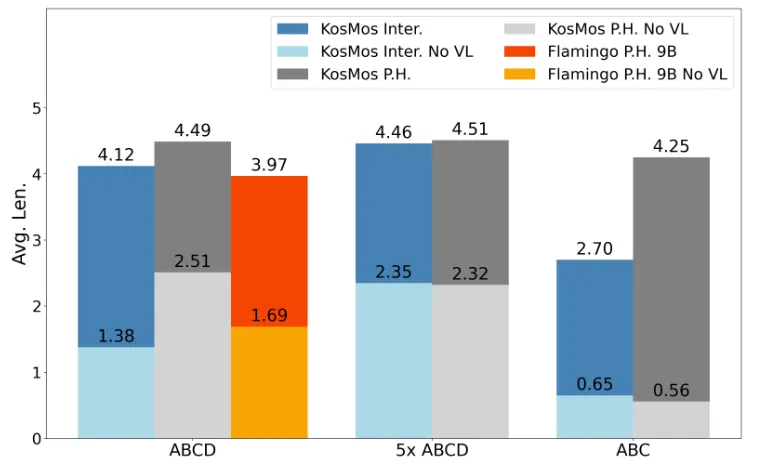

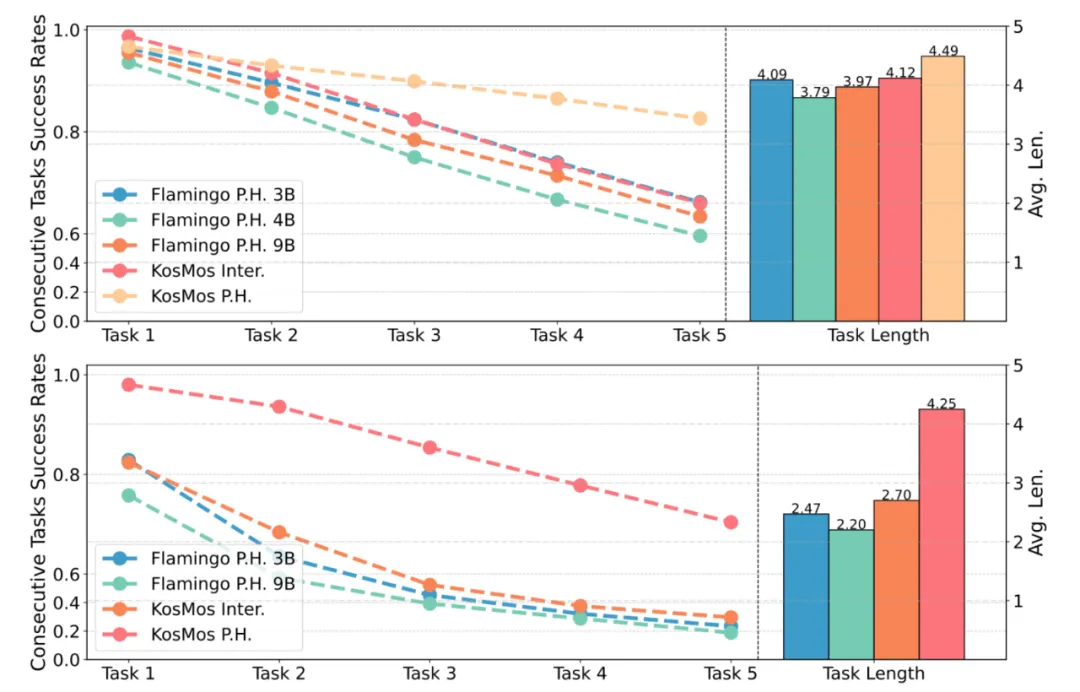

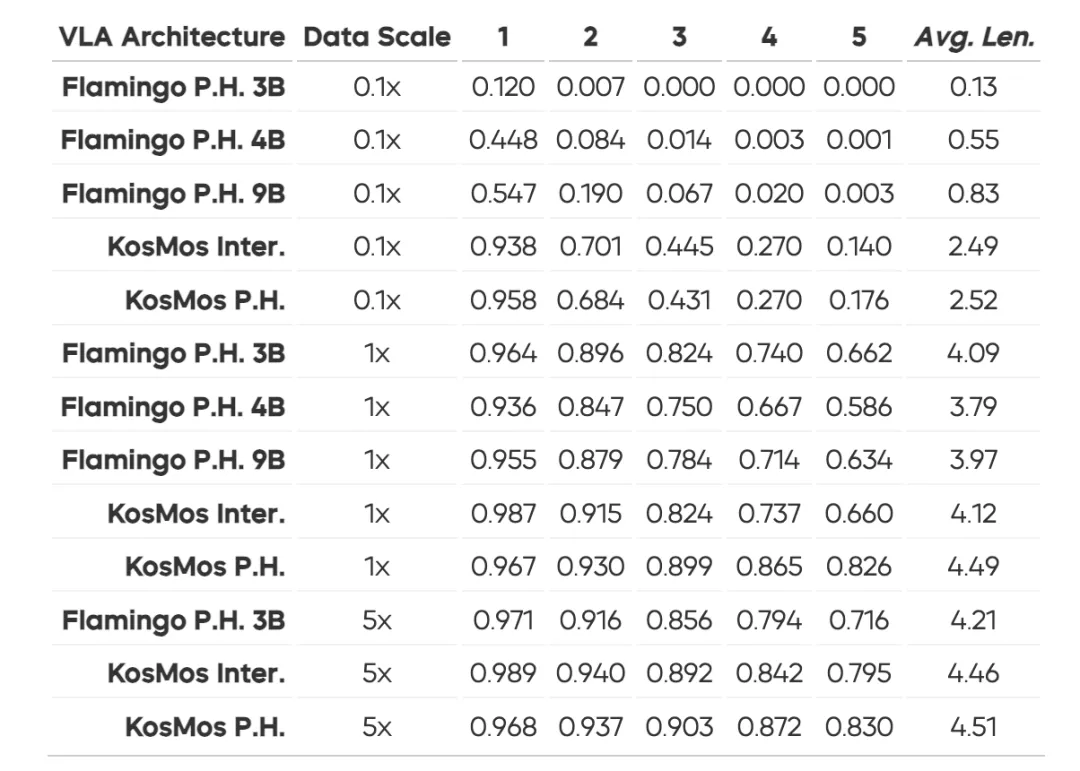

經過一系列實驗,我們確認了這些設計選擇是提升模型性能和泛化能力的關鍵。進一步的實驗也表明,最優的設計來自于基于 KosMos 基座模型的架構,并且結合了專門的歷史信息組織模塊。這樣的設計在 CALVIN 中實現了出色的泛化能力,在 zero-shot 設置下僅有輕微的性能下降,而其他設計形式的模型則出現了顯著掉分。這一結論直接說明,架構設計的好壞對模型的泛化能力和效率至關重要。

3. 選什么基座模型最合適?

我們對比了當前主流的 8 種視覺語言模型(VLM),結果發現 KosMos 和 Paligemma 的表現遙遙領先,輕松碾壓其他模型。無論是任務完成的精確度還是泛化能力,它們都展現出了壓倒性的優勢。究其原因,主要得益于它們經過了扎實且全面的視覺語言預訓練,從而為模型提供了強大的先驗知識和理解能力。

這一發現讓我們更加確信:選對基座模型,就是讓 VLA 模型起飛的關鍵一步!想要讓模型在多模態任務中表現驚艷,一個經過深度預訓練、具備強大視覺語言表征能力的 VLM 基座顯然能提供無與倫比的助力。而一旦打好了這個基礎,后續的設計和訓練才能真正發揮最大潛力。

4. 跨本體數據什么時候加入最合適?

實驗告訴我們一個黃金法則:在預訓練階段引入跨本體數據(如 Open-X Embodiment 數據集)可以顯著提升模型的魯棒性和少樣本場景下的表現。反之,直接將跨本體數據和微調數據混合訓練,效果就沒那么顯著了。這些結論為未來 VLA 模型的訓練策略指明了方向。

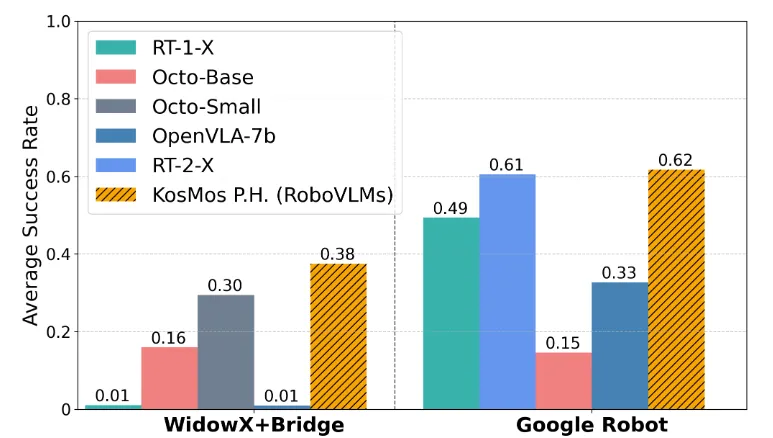

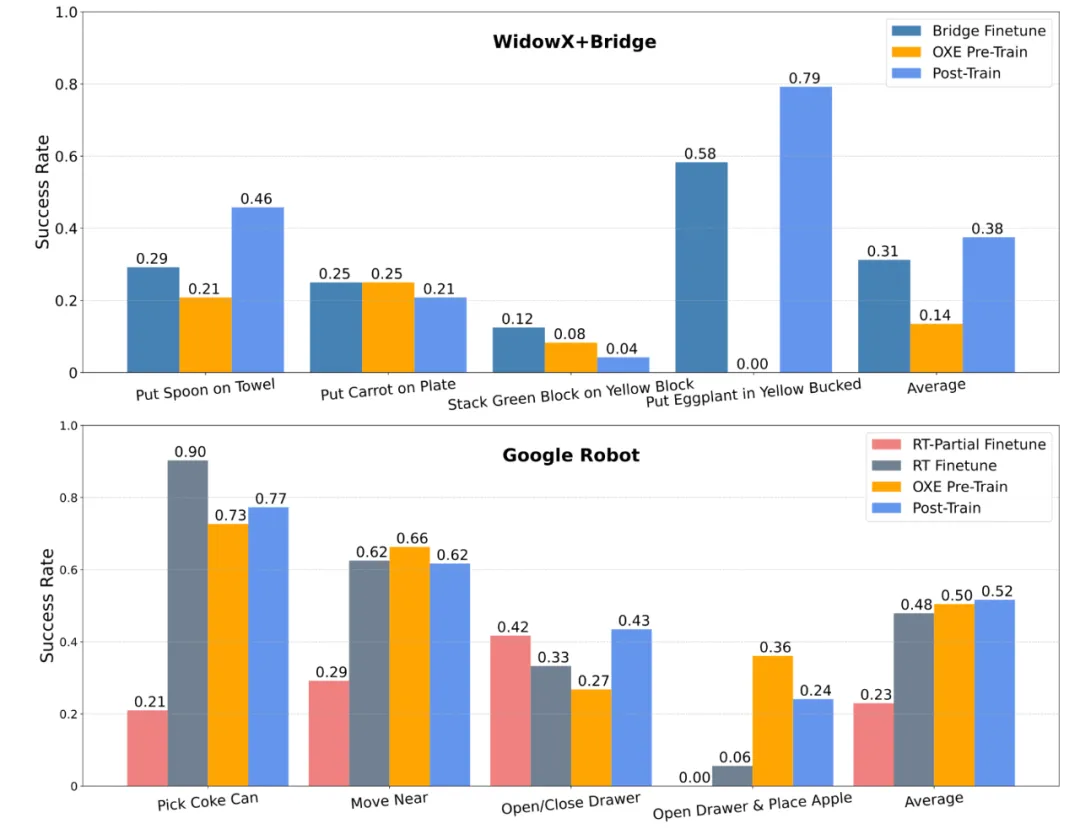

具體實驗中,我們在 WidowX+Bridge 和 Google Robot 兩大環境下分別進行了不同訓練策略的測試:

WidowX+Bridge 環境:

- Bridge Finetune:直接在完整的 Bridge 數據集上微調(測試任務不包括在內)。

- OXE Pre-Train:先用 OXE 數據集預訓練模型。

- Post-Train:用經過 OXE 預訓練的模型再在 Bridge 數據集上微調。

Google Robot 環境:

- RT-Partial Finetune:僅在特定的 RT 任務上微調。

- RT Finetune:在完整的 RT 數據集上微調(包括測試任務)。

- OXE Pre-Train:先用 OXE 數據集預訓練模型。

- Post-Train:在 OXE 預訓練基礎上用 RT 數據集進一步訓練。

實驗結果進一步驗證了:在預訓練階段引入跨本體數據不僅能提升泛化能力,還能讓模型在少樣本和高復雜任務下表現更佳。

展望未來:VLA 的進階之路

雖然 RoboVLMs 已經很能打了,但接下來的發展空間更讓人期待!未來可以探索:

- 更細化的設計優化:比如再打磨 VLM 內部結構、信息融合模塊和訓練目標,讓它更高效。

- 挑戰復雜任務:像 “做早餐” 這種長鏈條任務,也許是下一個突破點!

- 多模態協作能力:進一步讓機器人 “看懂”、“聽清”、“動得更聰明”。

RoboVLMs 的出現,驗證了視覺語言動作模型的可能性,也讓機器人更接近成為我們的全能助手。未來,它們或許不僅能理解語言和視覺,還能真正幫我們完成那些繁瑣又復雜的任務。接下來會有更多驚喜等著我們!