北大推出全新機器人多模態大模型!面向通用和機器人場景的高效推理和操作

本文由 HMI Lab 完成。HMI Lab依托北京大學視頻與視覺技術國家工程研究中心和多媒體信息處理全國重點實驗室兩大平臺,長期從事機器學習、多模態學習和具身智能方向的研究。本工作第一作者為劉家銘博士,研究方向為面向開放世界的多模態具身大模型與持續性學習技術。本工作第二作者為劉夢真,研究方向為視覺基礎模型與機器人操縱。指導老師為仉尚航,北京大學計算機學院研究員、博士生導師、博雅青年學者。從事多模態大模型與具身智能研究,取得了一系列重要研究成果,在人工智能頂級期刊和會議上發表論文 80 余篇,谷歌引用 9700 余次。榮獲世界人工智能頂會 AAAI 最佳論文獎,位列世界最大學術源代碼倉庫 Trending Research 第一位。

為了賦予機器人端到端的推理和操縱能力,本文創新性地將視覺編碼器與高效的狀態空間語言模型集成,構建了全新的 RoboMamba 多模態大模型,使其具備視覺常識任務和機器人相關任務的推理能力,并都取得了先進的性能表現。同時,本文發現當 RoboMamba 具備強大的推理能力后,我們可以通過極低的訓練成本使得 RoboMamba 掌握多種操縱位姿預測能力。

- 論文:RoboMamba: Multimodal State Space Model for Efficient Robot Reasoning and Manipulation

- 論文鏈接:https://arxiv.org/abs/2406.04339

- 項目主頁:https://sites.google.com/view/robomamba-web

- Github:https://github.com/lmzpai/roboMamba

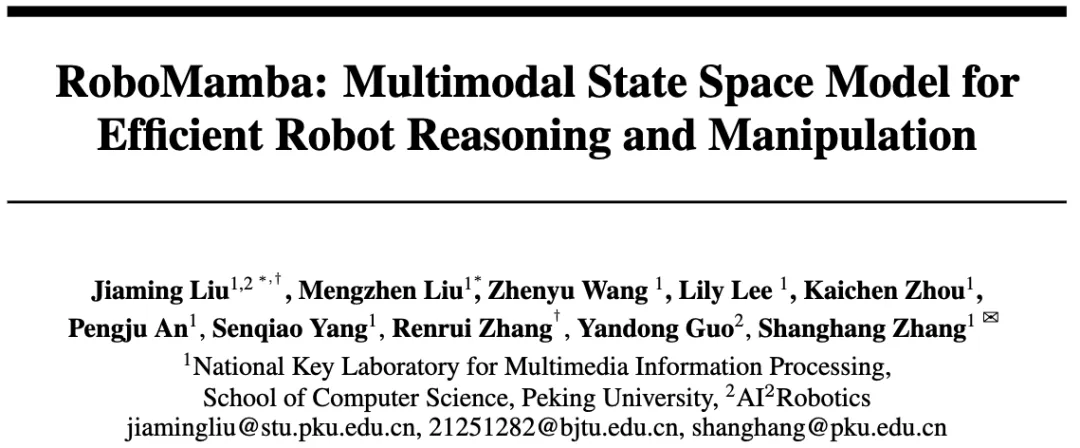

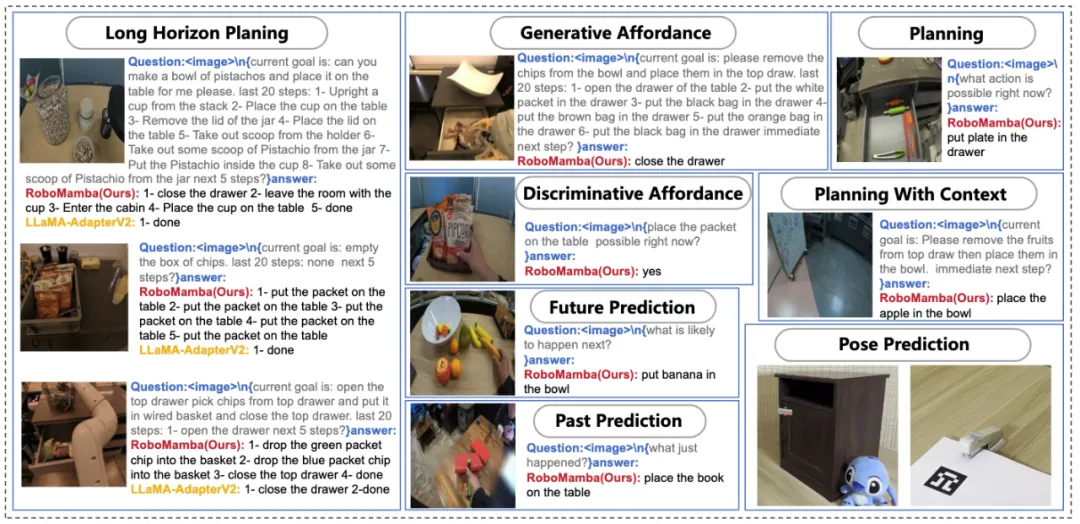

圖 1. RoboMamba 具備的機器人相關能力,其中包括任務規劃、提示性任務規劃、長程任務規劃、可操縱性判斷、可操縱性生成、未來與過去預測、末端執行器位姿預測等。

摘要

機器人操縱的一個基本目標是使模型能夠理解視覺場景并執行動作。盡管現有的機器人多模態大模型(MLLM)可以處理一系列基本任務,但它們仍然面臨兩個方面的挑戰:1) 處理復雜任務的推理能力不足;2) MLLM 微調和推理的計算成本較高。最近提出的狀態空間模型(SSM),即 Mamba,其具備線性推理復雜度同時在序列建模中展示了令人期待的能力。受此啟發,我們推出了端到端機器人 MLLM—RoboMamba,它利用 Mamba 模型提供機器人推理和行動能力,同時保持高效的微調和推理能力。

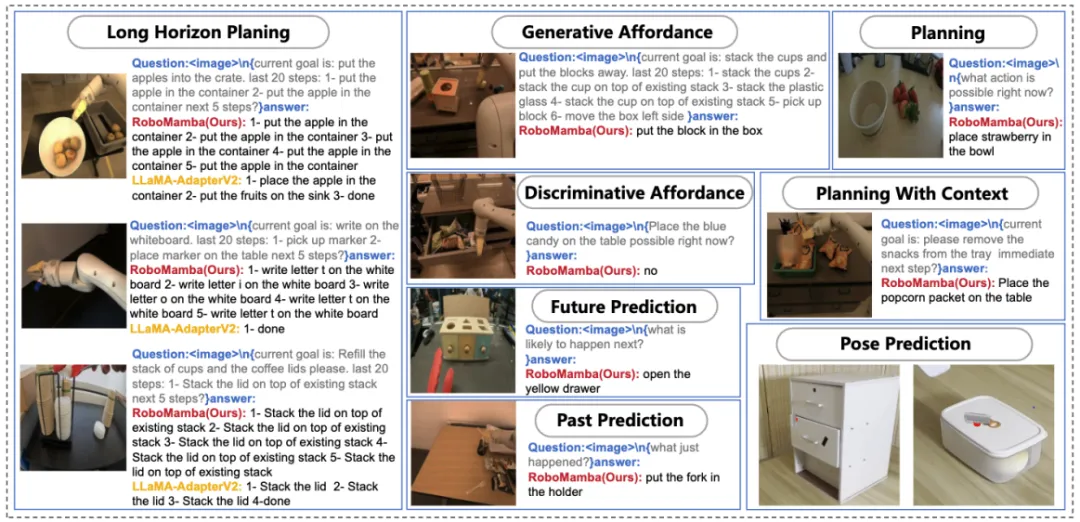

具體來說,我們首先將視覺編碼器與 Mamba 集成在一起,通過共同訓練將視覺數據與語言嵌入對齊,使我們的模型具有視覺常識和與機器人相關的推理能力。為了進一步增強 RoboMamba 的操縱位姿預測能力,我們探索了一種僅使用簡單 Policy Head 的高效微調策略。我們發現,一旦 RoboMamba 擁有足夠的推理能力,它可以通過極少的微調參數(模型的 0.1%)和微調時間(20 分鐘)來掌握多種操作技能。在實驗中,RoboMamba 在通用和機器人評估基準上展示了出色的推理能力,如圖 2 所示。同時,我們的模型在模擬和現實世界實驗中展示了令人印象深刻的操縱位姿預測能力,其推理速度比現有的機器人 MLLMs 快 7 倍。

圖 2. 概述:Robomamba 是一種高效的機器人多模態大模型,同時具備強大的推理和操作能力。RoboMamba-2.8B 在通用 MLLM 基準上實現了與其他 7B MLLM 可競爭的推理性能,同時在機器人任務中展示了長程推理能力。隨后,我們引入了一種極其高效的微調策略,使 RoboMamba 具備操縱位姿預測能力,只需 20 分鐘即可微調一個簡單的策略頭。

本文主要貢獻總結如下:

- 我們創新地將視覺編碼器與高效的 Mamba 語言模型集成,構建了全新的端到端機器人多模態大模型,RoboMamba,其具備視覺常識和機器人相關的全面推理能力。

- 為了使 RoboMamba 具備末端執行器操縱位姿預測能力,我們探索了一種使用簡單 Policy Head 的高效微調策略。我們發現,一旦 RoboMamba 達到足夠的推理能力,它可以以極低的成本掌握操縱位姿預測技能。

- 在我們的大量實驗中,RoboMamba 在通用和機器人推理評估基準上表現出色,并在模擬器和真實世界實驗中展示了令人印象深刻的位姿預測結果。

研究背景

數據的 scaling up 顯著推動了大語言模型(LLMs)研究的發展,展示了在自然語言處理(NLP)中推理和泛化能力的顯著進步。為了理解多模態信息,多模態大語言模型(MLLMs)應運而生,賦予 LLMs 視覺指令跟隨和場景理解的能力。受 MLLMs 在通用環境中強大能力的啟發,近期研究旨在將 MLLMs 應用于機器人操作領域。一些研究工作使機器人能夠理解自然語言和視覺場景,自動生成任務計劃。另一些研究工作則是利用 MLLMs 的固有能力,使其具備預測操作位姿的能力。

機器人操作涉及在動態環境中與物體交互,需要類人推理能力以理解場景的語義信息,以及強大的操縱位姿預測能力。雖然現有基于機器人 MLLM 可以處理一系列基礎任務,但它們在兩個方面仍然面臨挑戰。

1)首先,預訓練的 MLLMs 在機器人場景中的推理能力被發現是不足的。正如圖 2

所示,當微調后的機器人 MLLMs 遇到復雜推理任務時,這種缺陷會帶來挑戰。

2)其次,由于現有 MLLM 注意力機制的計算復雜度較高,微調 MLLMs 并使用它們生成機器人操作動作會產生更高的計算成本。

為了平衡推理能力和效率,NLP 領域出現了幾項研究。尤其是,Mamba 引入了創新的選擇性狀態空間模型(SSM),在保持線性復雜度的同時,促進了上下文感知的推理。

受此啟發,我們提出一個問題:“我們能否開發出一種高效的機器人 MLLM,既具備強大的推理能力,又能以非常經濟的方式獲得機器人操作技能?”

RoboMamba 方法

1. 背景知識

- 問題陳述

對于機器人視覺推理,我們的 RoboMamba 基于圖像 和語言問題

和語言問題 生成語言答案

生成語言答案 ,表示為

,表示為 。推理答案通常包含單獨的子任務

。推理答案通常包含單獨的子任務 對于一個問題

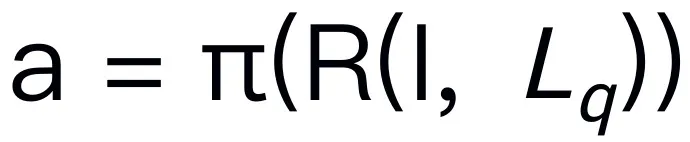

對于一個問題 。例如,當面對一個計劃問題,如 “如何收拾桌子?”,反應通常包括 “第一步:撿起物體” 和 “第二步:把物體放入盒子” 等步驟。對于動作預測,我們利用一個高效簡單的策略頭 π 來預測動作

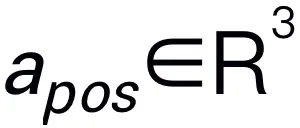

。例如,當面對一個計劃問題,如 “如何收拾桌子?”,反應通常包括 “第一步:撿起物體” 和 “第二步:把物體放入盒子” 等步驟。對于動作預測,我們利用一個高效簡單的策略頭 π 來預測動作 。根據之前的工作,我們使用 6-DoF 來表達 Franka Emika Panda 機械臂的末端執行器位姿。6 自由度包括末端執行器位置

。根據之前的工作,我們使用 6-DoF 來表達 Franka Emika Panda 機械臂的末端執行器位姿。6 自由度包括末端執行器位置 表示三維坐標,方向

表示三維坐標,方向 表示旋轉矩陣。如果訓練抓取任務,我們將抓夾狀態添加到位姿預測中,從而實現 7-DoF 控制。

表示旋轉矩陣。如果訓練抓取任務,我們將抓夾狀態添加到位姿預測中,從而實現 7-DoF 控制。

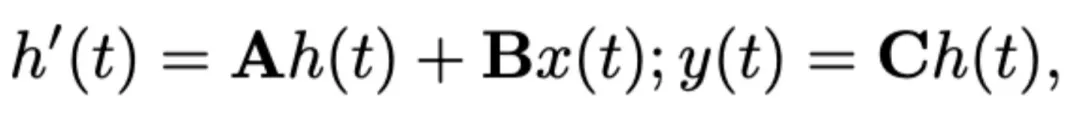

- 狀態空間模型 (SSM)

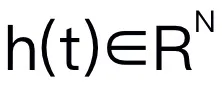

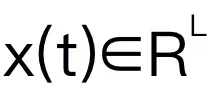

本文選擇 Mamba 作為大語言模型。Mamba 由許多 Mamba block 組成,最關鍵的組成部分是 SSM。SSM 是基于連續系統設計的,通過隱藏狀態 ,將 1D 輸入序列

,將 1D 輸入序列 投影到 1D 輸出序列

投影到 1D 輸出序列 。SSM 由三個關鍵參數組成:狀態矩陣

。SSM 由三個關鍵參數組成:狀態矩陣 ,輸入矩陣

,輸入矩陣 ,輸出矩陣

,輸出矩陣 。SSM 可以表示為:

。SSM 可以表示為:

最近的 SSM (例如,Mamba) 被構造為使用時間尺度參數?的離散連續系統。該參數將連續參數 A 和 B 轉換為離散參數 和

和 。離散化采用零階保持方法,定義如下:

。離散化采用零階保持方法,定義如下:

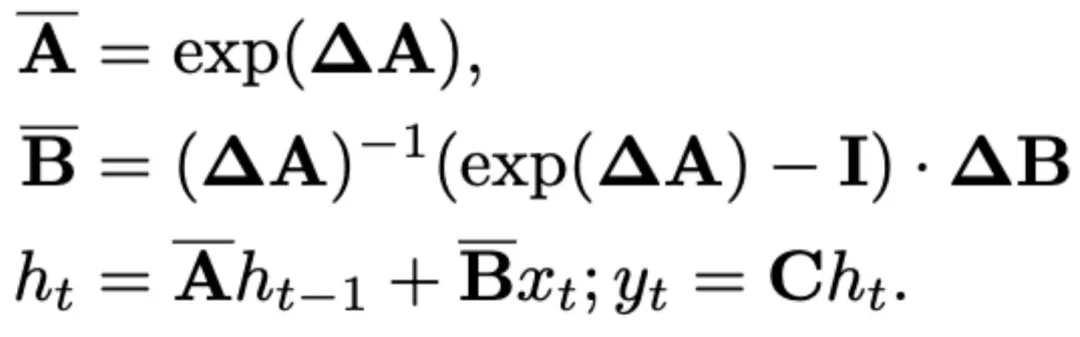

Mamba 引入了選擇性掃描機制 (S6),在每個 Mamba block 中形成其 SSM 操作。SSM 參數更新為 ,實現更好的內容感知推理。下圖 3 中展示了 Mamba block 的詳細信息。

,實現更好的內容感知推理。下圖 3 中展示了 Mamba block 的詳細信息。

2. RoboMamba 模型結構

圖 3. Robomamba 整體框架。RoboMamba 通過視覺編碼器和投影層將圖像投影到 Mamba 的語言嵌入空間,然后與文本 tokens 連接,并輸入到 Mamba 模型中。為了預測末端執行器的位置和方向,我們引入簡單的 MLP 策略頭,并使用池化操作從語言輸出 tokens 生成的全局 token 作為輸入。RoboMamba 的訓練策略。為了進行模型訓練,我們將訓練流程分為兩個階段。在 Stage 1,我們引入對齊預訓練(Stage 1.1)和指令共同訓練(Stage 1.2),以使 RoboMamba 具備常識推理和機器人相關的推理能力。在 Stage 2,我們提出機器人操作微調,以高效地賦予 RoboMamba Low-Level 操作技能。

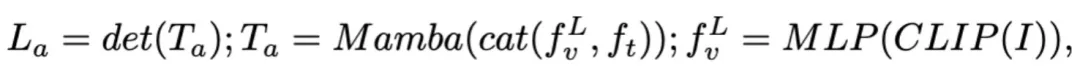

為了使 RoboMamba 具備視覺推理和操作能力,我們從預訓練的大語言模型(LLMs)和視覺模型開始,構建了一個高效的 MLLM 架構。如上圖 3 所示,我們利用 CLIP 視覺編碼器從輸入圖像 I 中提取視覺特征 ,其中 B 和 N 分別表示 batch size 和 token 數。與最近的 MLLMs 不同,我們不采用視覺編碼器集成技術,這種技術使用了多種骨干網絡(即 DINOv2、CLIP-ConvNeXt、CLIP-ViT)進行圖像特征提取。集成引入了額外的計算成本,嚴重影響了機器人 MLLM 在現實世界中的實用性。因此,我們證明了,當高質量數據和適當的訓練策略結合時,簡單且直接的模型設計也能實現強大的推理能力。為了使 LLM 理解視覺特征,我們使用多層感知器(MLP)將視覺編碼器連接到 LLM。通過這個簡單的跨模態連接器,RoboMamba 可以將視覺信息轉換為語言嵌入空間

,其中 B 和 N 分別表示 batch size 和 token 數。與最近的 MLLMs 不同,我們不采用視覺編碼器集成技術,這種技術使用了多種骨干網絡(即 DINOv2、CLIP-ConvNeXt、CLIP-ViT)進行圖像特征提取。集成引入了額外的計算成本,嚴重影響了機器人 MLLM 在現實世界中的實用性。因此,我們證明了,當高質量數據和適當的訓練策略結合時,簡單且直接的模型設計也能實現強大的推理能力。為了使 LLM 理解視覺特征,我們使用多層感知器(MLP)將視覺編碼器連接到 LLM。通過這個簡單的跨模態連接器,RoboMamba 可以將視覺信息轉換為語言嵌入空間 。

。

請注意,模型效率在機器人領域至關重要,因為機器人需要根據人類指令快速響應。因此,我們選擇 Mamba 作為我們的大語言模型,因為它具有上下文感知推理能力和線性計算復雜度。文本提示使用預訓練的分詞器編碼為嵌入空間 ,然后與視覺 token 連接(cat)并輸入 Mamba。我們利用 Mamba 強大的序列建模來理解多模態信息,并使用有效的訓練策略來開發視覺推理能力(如下一節所述)。輸出 token (

,然后與視覺 token 連接(cat)并輸入 Mamba。我們利用 Mamba 強大的序列建模來理解多模態信息,并使用有效的訓練策略來開發視覺推理能力(如下一節所述)。輸出 token ( ) 然后被解碼(det),生成自然語言響應

) 然后被解碼(det),生成自然語言響應 。模型的前向過程可以表示如下:

。模型的前向過程可以表示如下:

3.RoboMamba 通用視覺和機器人推理能力訓練

在構建了 RoboMamba 架構后,接下來的目標是訓練我們的模型學習通用視覺推理和機器人相關的推理能力。如圖 3 所示,我們將 Stage 1 的訓練分為兩個子步驟:對齊預訓練(Stage 1.1)和指令共同訓練(Stage 1.2)。具體而言,與以往的 MLLM 訓練方法不同,我們的目標是使 RoboMamba 能夠理解通用視覺和機器人場景。鑒于機器人領域涉及許多復雜且新穎的任務,RoboMamba 需要更強的泛化能力。因此,我們在 Stage 1.2 階段采用了共同訓練策略,將高層次的機器人數據(例如任務規劃)與通用指令數據結合起來。我們發現,共同訓練不僅可以獲得更具泛化能力的機器人策略,還由于機器人數據中的復雜推理任務而帶來的通用場景推理能力增強。訓練細節如下:

- Stage 1.1:對齊預訓練。

我們采用 LLaVA 過濾的 558k 圖像 - 文本配對數據集進行跨模態對齊。如圖 3 所示,我們凍結 CLIP 編碼器和 Mamba 語言模型的參數,僅更新投影層。通過這種方式,我們可以將圖像特征與預訓練的 Mamba 詞嵌入對齊。

- Stage 1.2:指令共同訓練。

在這一階段,我們首先遵循先前 MLLM 的工作進行通用視覺指令數據收集。我們采用了 655K LLaVA 混合指令數據集和 400K LRV-Instruct 數據集,分別用于學習視覺指令跟隨和減輕幻覺。需要注意的是,減輕幻覺在機器人場景中起著重要作用,因為機器人 MLLM 需要基于真實場景生成任務規劃,而不是想象中的場景。例如,現有的 MLLMs 可能公式化地回答 “打開微波爐” 時說 “步驟 1:找到把手”,但許多微波爐沒有把手。接下來,我們結合了 800K RoboVQA 數據集,以學習高層次的機器人技能,如長程任務規劃、可操縱性判斷、可操縱性生成、未來與過去預測等。在共同訓練期間,如圖 3 所示,我們凍結 CLIP 編碼器的參數,并在 1.8m 合并數據集上微調投影層和 Mamba。所有來自 Mamba 語言模型的輸出都使用交叉熵損失進行監督。

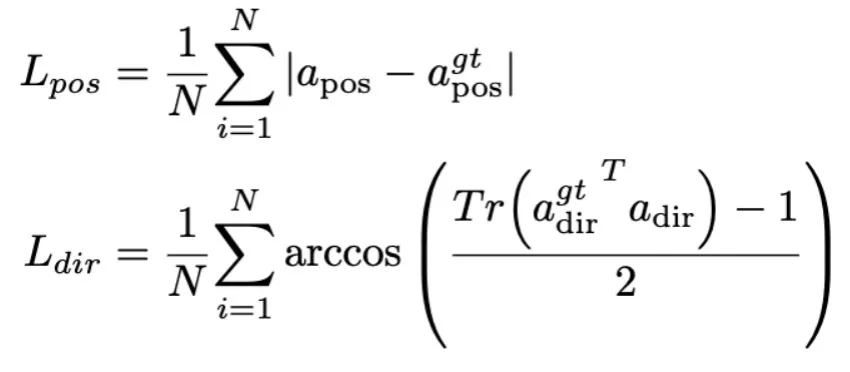

4.RoboMamba 操縱能力微調訓練

在 RoboMamba 強大的推理能力基礎上,我們在本節介紹了我們的機器人操作微調策略,在圖 3 中稱為訓練 Stage 2。現有的基于 MLLM 的機器人操作方法在操作微調階段需要更新投影層和整個 LLM。雖然這種范式可以賦予模型動作位姿預測能力,但它也破壞了 MLLM 的固有能力,并且需要大量的訓練資源。為了解決這些挑戰,我們提出了一種高效的微調策略,如圖 3 所示。我們凍結 RoboMamba 的所有參數,并引入一個簡單的 Policy head 來建模 Mamba 的輸出 token。Policy head 包含兩個 MLP 分別學習末端執行器位置和方向,總共占用整個模型參數的 0.1%。根據前期工作 where2act,位置和方向的損失公式如下:

其中,N 表示訓練樣本的數量,Tr (A) 表示矩陣 A 的跡。RoboMamba 只預測圖像中接觸像素的二維位置(x, y),然后使用深度信息將其轉換為三維空間。為了評估這一微調策略,我們使用 SAPIEN 模擬生成了一個包含 1 萬條末端執行器位姿預測的數據集。

在操作微調之后,我們發現一旦 RoboMamba 具備了足夠的推理能力,它可以通過極高效的微調來獲取位姿預測技能。由于微調參數(7MB)極少且模型設計高效,我們只需 20 分鐘即可實現新的操作技能學習。這一發現突出了推理能力對于學習操作技能的重要性,并提出了一個新的視角:我們可以在不影響 MLLM 固有推理能力的情況下,高效地賦予其操作能力。最后,RoboMamba 可以使用語言響應進行常識和與機器人相關的推理,并使用 Policy head 進行動作位姿預測。

定量實驗

1. 通用推理能力評估(MLLM Benchmarks)

為了評估推理能力,我們使用了幾個流行的基準,包括 VQAv2、OKVQA、GQA、OCRVQA、VizWiz、POPE、MME、MMBench 和 MM-Vet。除此之外,我們還在 RoboVQA 的 18k 驗證數據集上直接評估了 RoboMamba 的機器人相關推理能力,涵蓋了機器人任務,如任務規劃、提示性任務規劃、長程任務規劃、可操縱性判斷、可操縱性生成、過去描述和未來預測等。

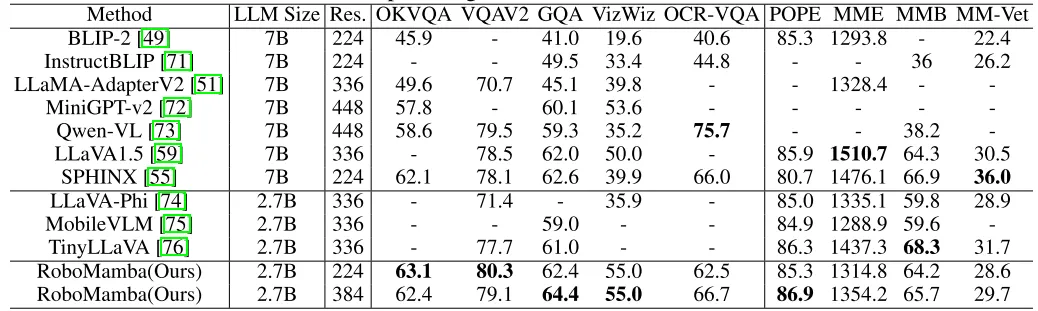

表 1. Robomamba 與現有 MLLMs 在多個基準上的通用推理能力比較。

如表 1 所示,我們將 RoboMamba 與以前最先進的 (SOTA) MLLM 在通用的 VQA 和最近的 MLLM 基準測試上進行比較。首先,我們發現 RoboMamba 僅使用 2.7B 語言模型,就在所有 VQA 基準測試中取得了令人滿意的結果。結果表明,簡單的結構設計是有效的。對齊預訓練和指令協同訓練顯著提高了 MLLM 的推理能力。例如,由于在協同訓練階段引入了大量的機器人數據,RoboMamba 在 GQA 基準上的空間識別性能得到了提高。同時,我們還在最近提出的 MLLM 基準上測試了我們的 RoboMamba。與以前的 MLLMs 相比,我們觀察到我們的模型在所有基準測試中都取得了具有競爭力的結果。雖然 RoboMamba 的一些性能仍然低于最先進的 7B MLLM (e.g., LLaVA1.5 和 SPHINX),但我們優先使用更小更快的 Mamba-2.7B 來平衡機器人模型的效率。在未來,我們計劃為資源不受限制的場景開發 RoboMamba-7B。

2. 機器人推理能力評估(RoboVQA Benchmark)

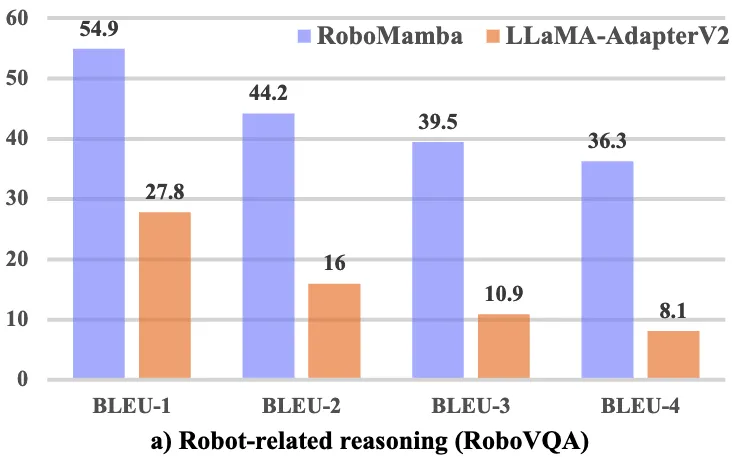

另外,為了全面比較 RoboMamba 與機器人相關的推理能力,我們在 RoboVQA 驗證集上與 LLaMA-AdapterV2 進行基準測試。我們選擇 LLaMA-AdapterV2 作為基準,因為它是當前 SOTA 機器人 MLLM (ManipLLM) 的基礎模型。為了進行公平的比較,我們加載了 LLaMA-AdapterV2 預訓練參數,并使用其官方指令微調方法在 RoboVQA 訓練集上對其進行了兩個 epoch 的微調。如圖 4 a)所示,RoboMamba 在 BLEU-1 到 BLEU-4 之間實現了卓越的性能。結果表明,我們的模型具有先進的機器人相關推理能力,并證實了我們的訓練策略的有效性。除了更高的準確率外,我們的模型實現的推理速度比 LLaMA-AdapterV2 和 ManipLLM 快 7 倍,這可以歸因于 Mamba 語言模型的內容感知推理能力和效率。

圖 4. RoboVQA 上與機器人相關的推理對比。

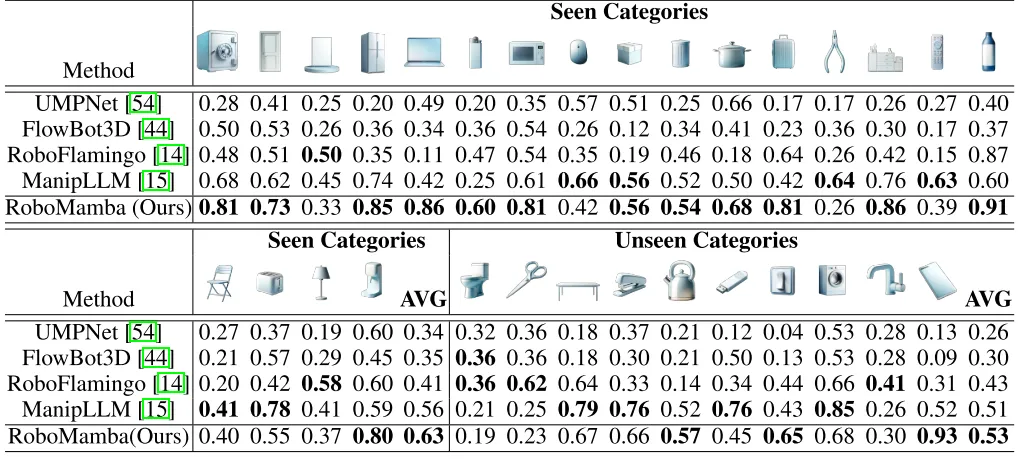

3. 機器人操縱能力評估(SAPIEN)

為了評估 RoboMamba 的操作能力,我們將我們的模型與四個基線進行了比較:UMPNet, Flowbot3D, RoboFlamingo 和 ManipLLM。在比較之前,我們復現所有基線并在我們收集的數據集上訓練它們。對于 UMPNet,我們在預測的接觸點上執行操作,方向垂直于物體表面。Flowbot3D 在點云上預測運動方向,選擇最大的流作為交互點,并使用流方向表示末端執行器的方向。RoboFlamingo 和 ManipLLM 分別加載 OpenFlamingo 和 LLaMA-AdapterV2 預訓練參數,并遵循各自的微調和模型更新策略。如表 2 所示,與之前的 SOTA ManipLLM 相比,我們的 RoboMamba 在可見類別上實現了 7.0% 的改進,在不可見類別上實現了 2.0% 的改進。在效率方面,RoboFlamingo 更新了 35.5% (1.8B) 的模型參數,ManipLLM 更新了 LLM 中的適配器 (41.3M),包含 0.5% 的模型參數,而我們的微調 Policy head (3.7M) 僅占模型參數的 0.1%。RoboMamba 比以前基于 MLLM 的方法更新的參數少了 10 倍,而推理速度提高了 7 倍。結果表明,我們的 RoboMamba 不僅具有強大的推理能力,而且能夠以低成本的方式獲得操縱能力。

表 2. Robomamba 與其他 baseline 的成功率比較

定性結果

圖 4. RoboMamba 面對現實世界中各種機器人下游任務的可視化。

如圖 4 所示,我們可視化了 RoboMamba 在各種機器人下游任務中的推理結果。在任務規劃方面,相較于 LLaMA-AdapterV2, RoboMamba 憑借其強大的推理能力,展現出了更準確、更長遠的規劃能力。為了進行公平的比較,我們還對 RoboVQA 數據集上的基準 LLaMA-AdapterV2 進行了微調。對于操縱位姿預測,我們使用了 Franka Emika 機械臂來與各種家庭物品進行交互。我們將 RoboMamba 預測的 3D 位姿投影到 2D 圖像上,使用紅點表示接觸點,末端執行器表示方向,如圖右下角所示。