把RLHF帶給VLA模型!通過偏好對齊來優化機器人策略,代碼已開源

論文一作為北卡羅來納大學教堂山分校張子健,指導老師為北卡羅來納大學教堂山分校助理教授 Huaxiu Yao。共同第一作者為華盛頓大學 Kaiyuan Zheng,其余作者包括來自北卡教堂山的 Mingyu Ding、來自華盛頓大學的 Joel Jang、Yi Li 和Dieter Fox,以及來自芝加哥大學的 Zhaorun Chen、Chaoqi Wang。

- 論文標題:GRAPE: Generalizing Robot Policy via Preference Alignment

- 論文鏈接:https://arxiv.org/abs/2411.19309

- 項目地址:https://grape-vla.github.io

- 代碼地址:https://github.com/aiming-lab/GRAPE

研究背景

近年來,視覺-語言-動作模型(Vision-Language-Action, VLA)在諸多機器人任務上取得了顯著的進展,但它們仍面臨一些關鍵問題,例如由于僅依賴從成功的執行軌跡中進行行為克隆,導致對新任務的泛化能力較差。

此外,這些模型通常通過微調來復制在不同環境下由專家收集的演示數據,這導致了分布偏差,并限制了它們對多樣化操作目標(如效率、安全性和任務完成)的適應能力。

方法部分

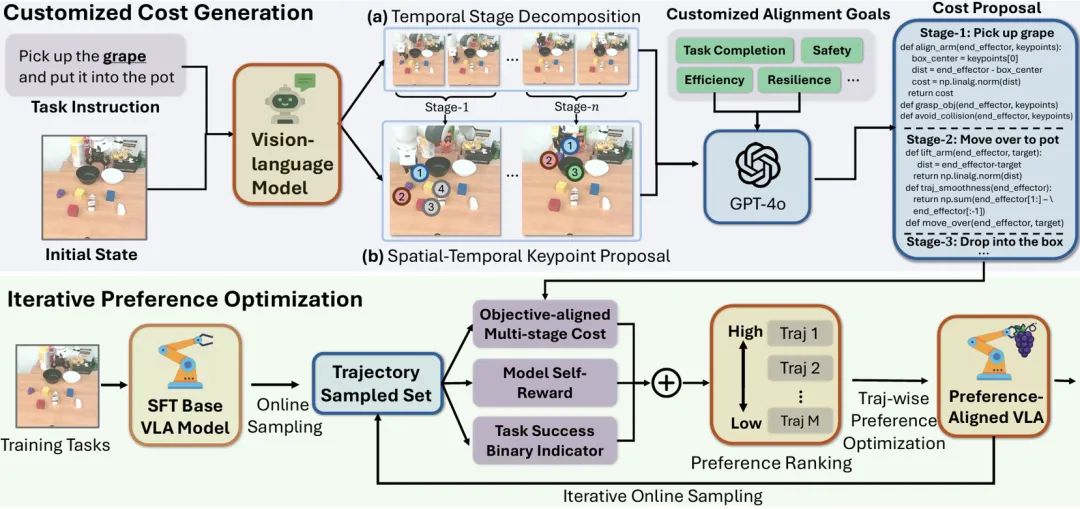

為了解決這一問題,我們提出了 GRAPE,一種即插即用的算法,通過偏好對齊提升機器人策略的泛化能力,并支持將 VLA 模型對齊到任意設定的目標。GRAPE 的框架如下圖所示:

圖 1:GRAPE 的框架

GRAPE 帶來了以下三大優勢,顯著增強了 VLA 模型的泛化性:

- GRAPE 在軌跡層面通過強化學習(RL)目標對 VLA 進行對齊,賦予模型全局決策能力,而不僅僅是簡單的行為克隆;

- GRAPE 隱式建模了成功和失敗嘗試中的獎勵,從而提升對多樣化任務的泛化能力;

- GRAPE 采用可擴展的偏好合成算法。GRAPE 通過與任意目標對齊的偏好對軌跡進行排序,進而使得 VLA 模型能被對齊到設定的目標上。

具體而言,GRAPE 的框架可以被拆成三個部分:Trajectory-wise Preference Optimization、Customized Preference Synthesis 和 Iterative Online Alignment。以下是這三個部分的詳細介紹:

Trajectory-wise Preference Optimization(軌跡級偏好優化):

GRAPE 將逐步訓練的 VLA 模型擴展到軌跡級別,并通過強化學習(RL)目標進行訓練,確保對齊后的策略能夠優先選擇被接受的軌跡,而非被拒絕的軌跡。

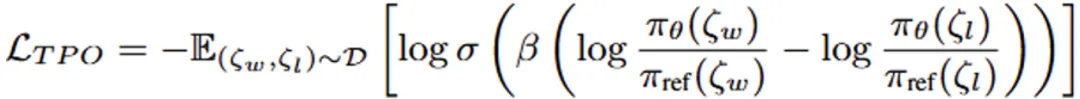

具體而言,我們基于 DPO 的 Loss 函數進行了改進,引入了一種全新的 TPO_Loss,使得模型能夠學習軌跡級別的偏好。我們利用模型在任務中采集的較優與較劣的嘗試(分別計為 ζ_w,ζ_l),建立了 TPO 偏好數據集,最終使得模型在 TPO 訓練后在全局層面獲得了對齊,并增強了其魯棒性。

圖 2 TPO-Loss 公式

圖 2 TPO-Loss 公式

Customized Preference Synthesis(定制化偏好合成):

基于 TPO-Loss 的設計,我們需要對于軌跡的優劣進行建模,從而構建對應的偏好數據集。然而,對于一些復雜的機器人任務,并沒有能夠用于軌跡排序的獎勵模型。

針對這個問題,GRAPE 引入了一種可擴展算法,將復雜操作任務分解為獨立階段,并通過一個大型視覺-語言模型提出的關鍵點,自動引導偏好建模過程中的時空約束。這些約束具有靈活性,可根據需求進行定制,使模型與不同目標(如安全性、效率或任務完成)保持一致。

Iterative Online Alignment(迭代式在線對齊):

GRAPE 通過以下迭代循環不斷優化對齊過程:1)在線樣本采集,2)合成偏好排序,3)軌跡級偏好優化。這種方法逐步提升了 VLA 策略的泛化能力,并使其與任意目標更好地對齊。

實驗結果

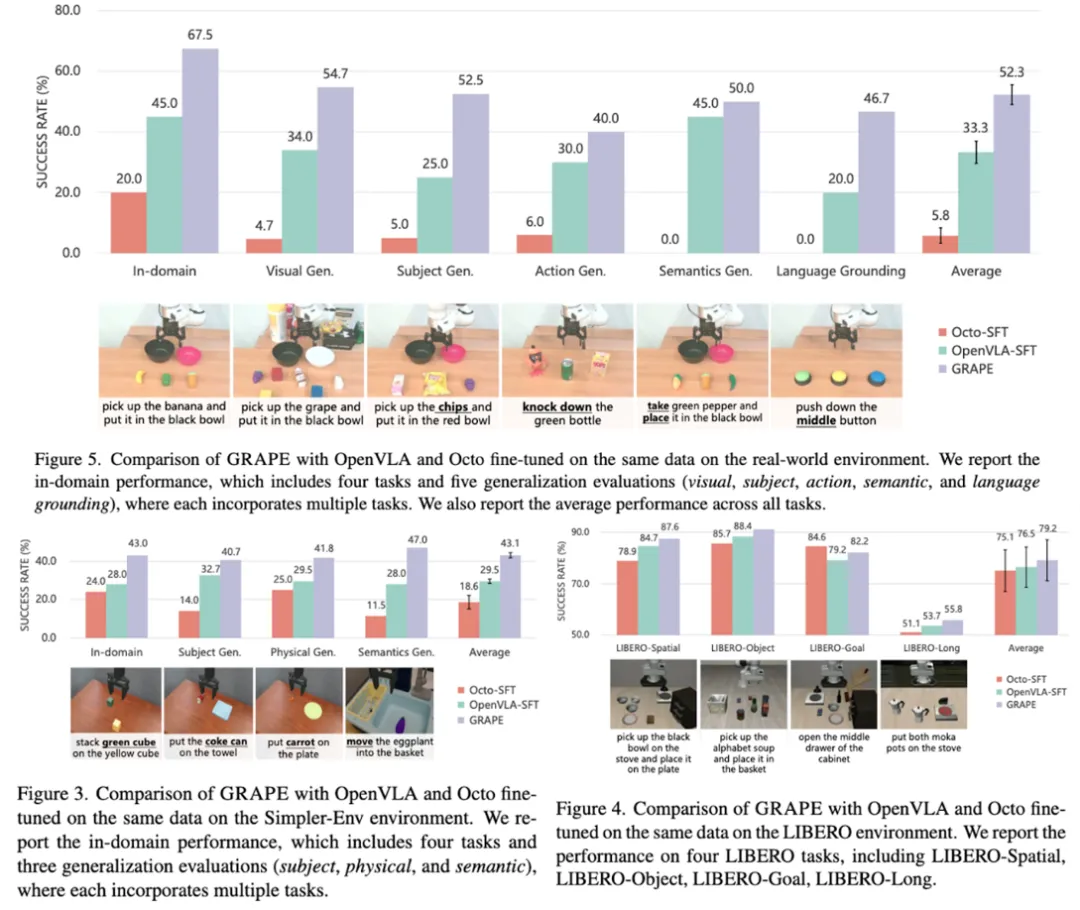

真機泛化實驗

我們在域內任務以及五種分布外泛化(OOD)任務上評估了 GRAPE 的性能,這些 OOD 任務包括:視覺(新的視覺環境)、主體(未見過的物體)、動作(未見過的操作)、語義(未見過的提示)和語言落地泛化(物體處于未見過的空間位置)。

結果顯示,GRAPE 在這些 OOD 任務上的表現分別比最先進的 OpenVLA-SFT 模型提升了 20.7%、27.5%、10.0%、5.0% 和 26.7%。這充分體現了通過偏好對齊過程所實現的卓越泛化能力。

仿真泛化實驗

我們進一步在 Simpler-Env 和 LIBERO 環境中評估了 GRAPE 的性能,重點考察三種 OOD 任務的泛化能力:主體(未見過的物體)、物理屬性(未見過的物體尺寸 / 形狀)和語義(未見過的提示)。

結果顯示,GRAPE 在這些 OOD 任務上相較 OpenVLA-SFT 模型分別提升了 8.0%、12.3% 和 19.0% 的表現。

圖 3:真機與仿真實驗統計結果

特定對齊目標分析

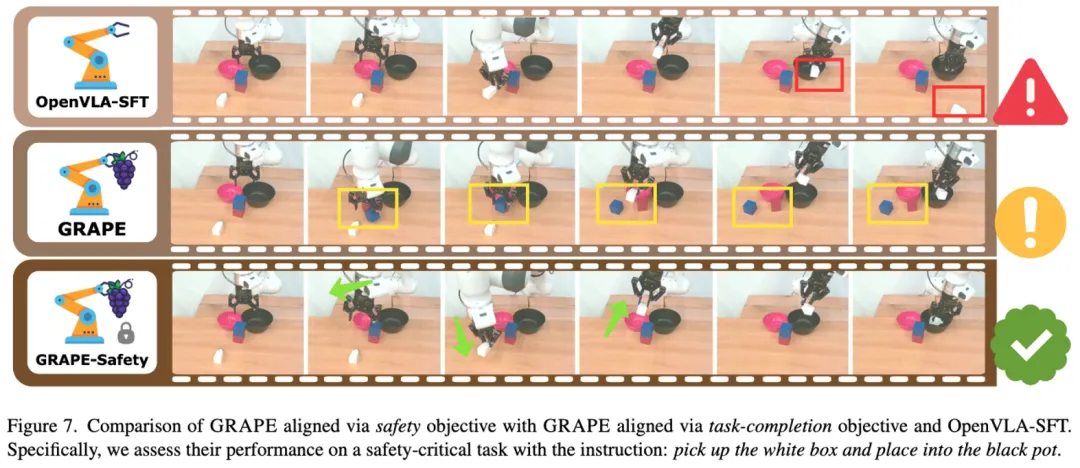

GRAPE 能夠高效地將機器人策略與通過自然語言指定的多種目標對齊,例如任務完成、安全性和效率。這些目標被融入多階段的成本函數中,進而影響采樣軌跡的排序。

實驗表明,當對齊目標為更安全或更高效的操作策略時,GRAPE 可將碰撞率降低 44.31%,或將執行軌跡的長度縮短 11.15%。

圖4:指定的對齊目標(安全),訓練后的模型學會了安全地執行操作

結論

本文提出了 GRAPE,一種即插即用的 VLA 模型對齊框架,在多種機器人任務場景下均能使用,能夠基于軌跡偏好提升機器人策略的泛化能力,并支持將模型對齊到指定目標。