Tokenization不存在了?Meta最新研究,無需Tokenizer的架構(gòu)來了

最近幾天,來自 Meta 、芝加哥大學(xué)等機(jī)構(gòu)的合著論文《 Byte Latent Transformer: Patches Scale Better Than Tokens 》火了,在 Hacker News 上受到廣泛討論。

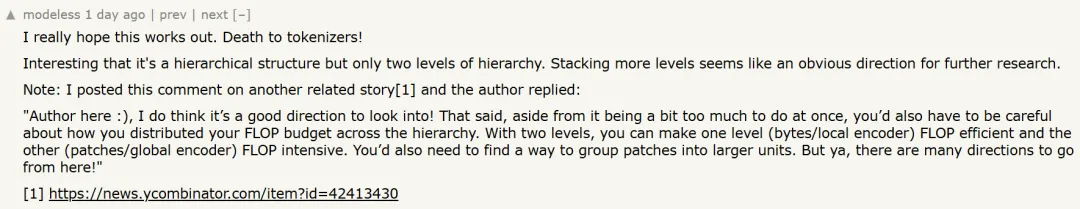

有人表示,非常期待這項研究取得成功,這樣就可以和 tokenizer 拜拜了!

還有人擔(dān)心的表示,「現(xiàn)在 tokenization 是大多數(shù)模型的基礎(chǔ),這項研究被采用的可能性究竟有多大?」

總結(jié)而言,該研究提出了一種新的 LLM 思想。傳統(tǒng)的語言模型依賴于 tokenizer 來預(yù)處理數(shù)據(jù),但 tokenization 有其固有的局限性,包括固定的詞匯表、處理多語言或噪聲數(shù)據(jù)的效率低下,以及由壓縮啟發(fā)式方法引入的偏見。

該研究提出字節(jié)潛在 Transformer(Byte Latent Transformer,簡稱 BLT)挑戰(zhàn)了這種常規(guī)做法。BLT 通過直接建模原始字節(jié)流,將它們根據(jù)熵動態(tài)分組為 patch 以實現(xiàn)高效計算。

具體而言,BLT 不需要 tokenizer 架構(gòu),可以直接從原始字節(jié)數(shù)據(jù)中學(xué)習(xí),避免了靜態(tài)詞匯表的限制,并能更好地處理多樣化和帶噪聲的輸入。

基于熵的 Patch:根據(jù)信息復(fù)雜度動態(tài)地將字節(jié)分組為 Patch,對高熵區(qū)域(復(fù)雜輸入)分配更多的計算資源,在低熵區(qū)域節(jié)省資源。

高效擴(kuò)展:通過優(yōu)化 patch 大小并利用輕量級局部模型,BLT 實現(xiàn)了與基于 token 模型(如 LLaMA)相當(dāng)或更好的性能,并在推理過程中節(jié)省高達(dá) 50% 的計算資源。

魯棒性與靈活性:BLT 在需要字符級理解、噪聲輸入或長尾泛化的任務(wù)中表現(xiàn)出色,在許多基準(zhǔn)測試中超越了基于 token 的架構(gòu)。

圖源:https://x.com/theraggedflesh/status/1867911485428482131

此外,該研究首次提出了對字節(jié)級模型進(jìn)行 flop 控制的擴(kuò)展研究,參數(shù)規(guī)模高達(dá) 8B,訓(xùn)練字節(jié)高達(dá) 4T,從而展示了在沒有固定詞匯表 tokenization 的情況下,從字節(jié)級別端到端地大規(guī)模訓(xùn)練模型。

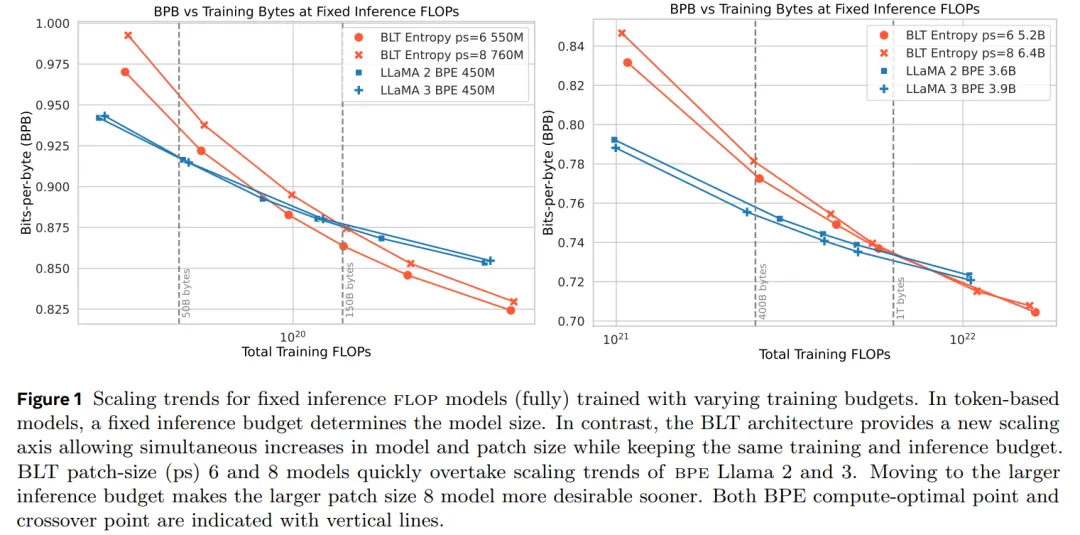

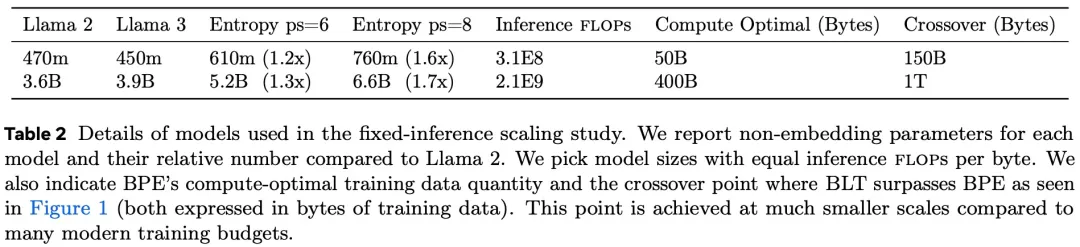

總體而言,BLT 在訓(xùn)練時的 flop 控制性能與 Llama 3 相當(dāng),同時在推理時使用的 flop 減少了高達(dá) 50%。該研究還進(jìn)行了 inference-flop 控制的擴(kuò)展實驗(圖 1),并觀察到與基于 tokenization 架構(gòu)相比,BLT 擴(kuò)展趨勢明顯更好。

這篇論文貢獻(xiàn)如下:

- 提出了 BLT,這是一種字節(jié)潛在 LLM 架構(gòu),動態(tài)分配計算資源以提高 flop 效率;

- 展示了在 8B(即 80 億)參數(shù)規(guī)模下,能夠?qū)崿F(xiàn)與 Llama 3 模型相當(dāng)?shù)挠?xùn)練 flop 控制,同時可以通過犧牲一小部分評估指標(biāo)來換取高達(dá) 50% 的 flop 效率提升;

- BLT 模型為擴(kuò)展大型語言模型開啟了一個新的維度,現(xiàn)在可以在保持固定推理預(yù)算的同時擴(kuò)展模型大小。

- 論文標(biāo)題:Byte Latent Transformer: Patches Scale Better Than Tokens

- 論文地址:https://arxiv.org/pdf/2412.09871

- 項目地址:https://github.com/facebookresearch/blt

這種無需 tokenizer 的方法代表了語言建模的重大轉(zhuǎn)變,為更高效、可擴(kuò)展和魯棒的人工智能系統(tǒng)鋪平了道路。

對此,有研究者表示:「Meta 剛剛殺死了 TOKENIZATION,他們發(fā)布的 BLT 是一種無 tokenizer 的架構(gòu),可以動態(tài)地將字節(jié)編碼為 patch,并實現(xiàn)更好的推理效率和穩(wěn)健性!」

「2025 年可能是我們告別 tokenization 的一年。」

BLT 架構(gòu)

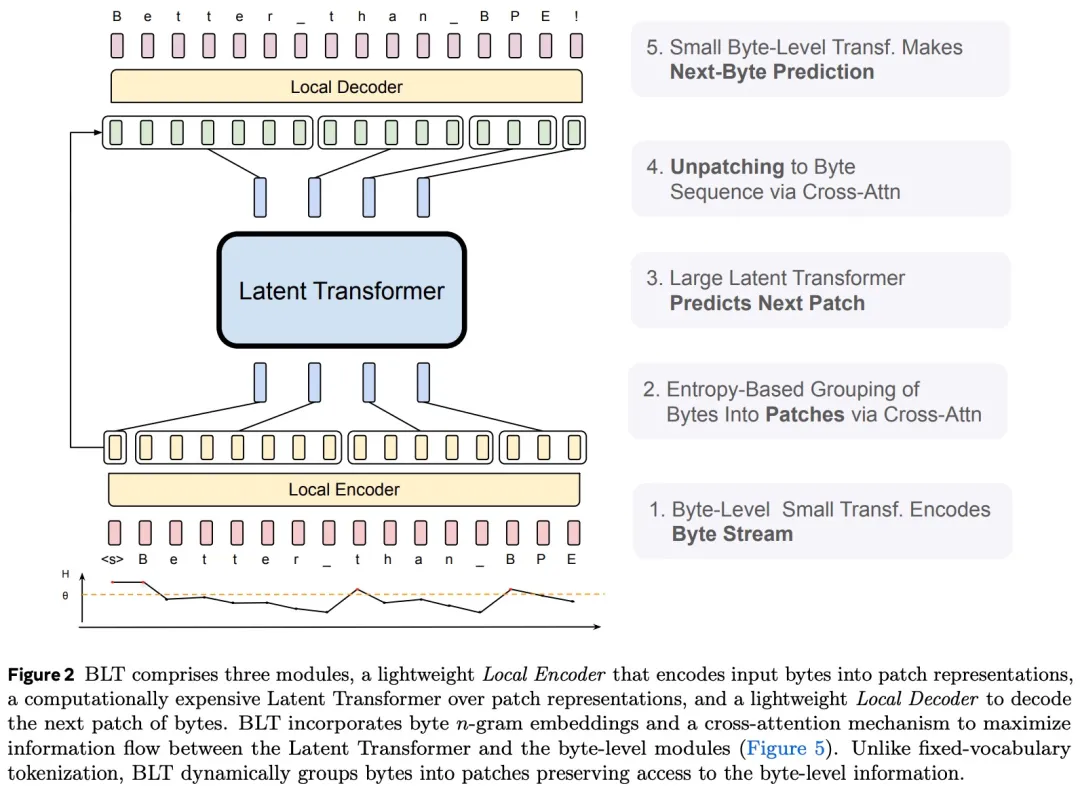

BLT 由一個對 patch 表征進(jìn)行操作的大型全局自回歸語言模型以及兩個較小的局部模型組成,兩個較小的局部模型將字節(jié)序列編碼為 patch 并將 patch 表征解碼回字節(jié)(圖 2)。

潛在全局 Transformer 模型

潛在全局 Transformer 是一個具有 l_G 層的自回歸 transformer 模型 G,它將一系列潛在輸入 patch 表征 p_j 映射到一系列輸出 patch 表征 o_j。

論文使用下標(biāo) j 表示 patch,使用下標(biāo) i 表示字節(jié)。全局模型使用塊因果注意力掩碼(Dubey et al., 2024)。

局部編碼器

局部編碼器模型(用 ε 表示)是一種基于 transformer 的輕量級模型,具有 層,其主要作用是有效地將輸入字節(jié)序列 b_i 映射為表達(dá)性 patch 表征 p_j。與 Transformer 架構(gòu)的主要區(qū)別是在每個 Transformer 層之后添加了一個交叉注意力層,其功能是將字節(jié)表征池化為 patch 表征(圖 5)。

層,其主要作用是有效地將輸入字節(jié)序列 b_i 映射為表達(dá)性 patch 表征 p_j。與 Transformer 架構(gòu)的主要區(qū)別是在每個 Transformer 層之后添加了一個交叉注意力層,其功能是將字節(jié)表征池化為 patch 表征(圖 5)。

首先,使用 矩陣嵌入輸入字節(jié)序列 b_i ,表示為 x_i 。然后,這些嵌入可以選擇以散列嵌入的形式添加附加信息。然后,一系列交替的 transformer 和交叉注意力層將這些表征轉(zhuǎn)換為由全局 transformer G 處理的 patch 表征 p_i。transformer 層使用局部塊因果注意力掩碼;每個字節(jié)都關(guān)注前面字節(jié)的固定窗口,該窗口通常可以跨越動態(tài) patch 邊界,但不能跨越文檔邊界。

矩陣嵌入輸入字節(jié)序列 b_i ,表示為 x_i 。然后,這些嵌入可以選擇以散列嵌入的形式添加附加信息。然后,一系列交替的 transformer 和交叉注意力層將這些表征轉(zhuǎn)換為由全局 transformer G 處理的 patch 表征 p_i。transformer 層使用局部塊因果注意力掩碼;每個字節(jié)都關(guān)注前面字節(jié)的固定窗口,該窗口通常可以跨越動態(tài) patch 邊界,但不能跨越文檔邊界。

局部解碼器

與局部編碼器類似,局部解碼器 D 是一個基于 transformer 的輕量級模型,具有 層,它將全局 patch 表征序列 o_j 解碼為原始字節(jié) y_i 。局部解碼器根據(jù)先前解碼的字節(jié)來預(yù)測原始字節(jié)序列,因此將局部編碼器為字節(jié)序列生成的隱藏表征作為輸入。它應(yīng)用了一系列交叉注意力層和 transformer 層的 lD 交替層。解碼器中的交叉注意力層在 transformer 層之前應(yīng)用,以首先從 patch 表征創(chuàng)建字節(jié)表征,并且局部解碼器 transformer 層對生成的字節(jié)序列進(jìn)行操作。

層,它將全局 patch 表征序列 o_j 解碼為原始字節(jié) y_i 。局部解碼器根據(jù)先前解碼的字節(jié)來預(yù)測原始字節(jié)序列,因此將局部編碼器為字節(jié)序列生成的隱藏表征作為輸入。它應(yīng)用了一系列交叉注意力層和 transformer 層的 lD 交替層。解碼器中的交叉注意力層在 transformer 層之前應(yīng)用,以首先從 patch 表征創(chuàng)建字節(jié)表征,并且局部解碼器 transformer 層對生成的字節(jié)序列進(jìn)行操作。

擴(kuò)展趨勢

該研究展示了字節(jié)級模型擴(kuò)展趨勢的整體圖景,可以為 BLT 模型的進(jìn)一步擴(kuò)展提供信息,旨在通過以下方式解決先前字節(jié)級模型研究的局限性:

- 比較計算最優(yōu)訓(xùn)練方案的趨勢;

- 在大量訓(xùn)練上訓(xùn)練匹配的 8B 模型數(shù)據(jù)并評估下游任務(wù);

- 測量推理成本控制設(shè)置中的擴(kuò)展趨勢。

參數(shù)匹配計算最優(yōu)擴(kuò)展趨勢

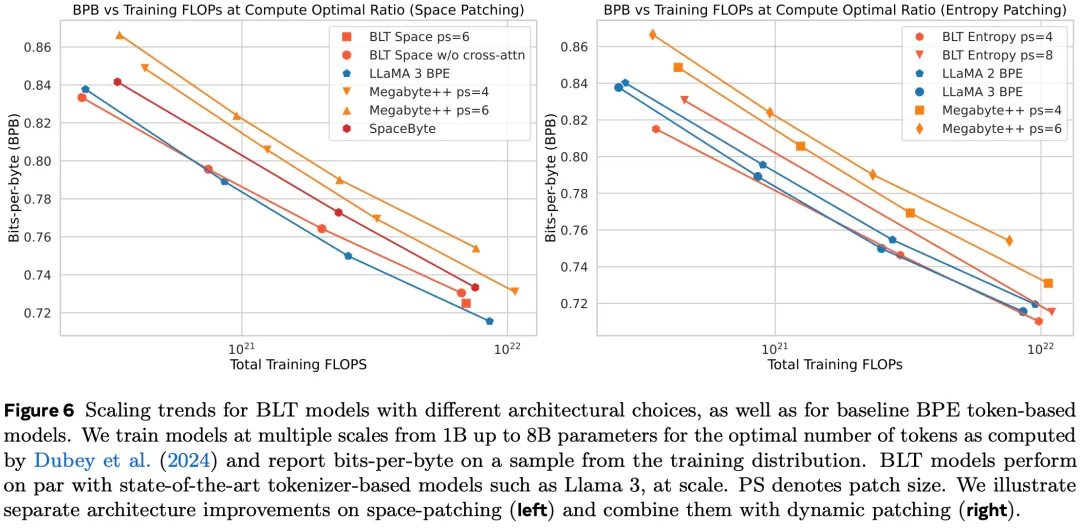

使用 Llama 2 數(shù)據(jù)集,該研究訓(xùn)練了四種不同大小(參數(shù)范圍從 1B 到 8B)的各種計算最優(yōu) bpe 和 BLT 模型。然后在訓(xùn)練數(shù)據(jù)混合物的代表性子集上根據(jù)語言建模性能繪制訓(xùn)練 flops 圖。BPE 模型使用 Llama 3 確定的模型參數(shù)與訓(xùn)練數(shù)據(jù)的最佳比率進(jìn)行訓(xùn)練(Dubey et al., 2024)。這種計算最優(yōu)設(shè)置理論上旨在在給定的訓(xùn)練預(yù)算內(nèi)實現(xiàn)訓(xùn)練數(shù)據(jù)集的最佳性能(Hoffmann et al., 2022),為模型提供魯棒的基線。對于每個 bpe 模型,該研究還使用與相應(yīng) bpe Transformer 的大小和架構(gòu)相匹配的潛在 Transformer 在相同數(shù)據(jù)上訓(xùn)練相應(yīng)的 BLT 模型。

如圖 6(右)所示,BLT 模型要么相當(dāng),要么優(yōu)于 BPE 模型,并且隨著擴(kuò)展模型大小和 flops,這種趨勢仍然存在。

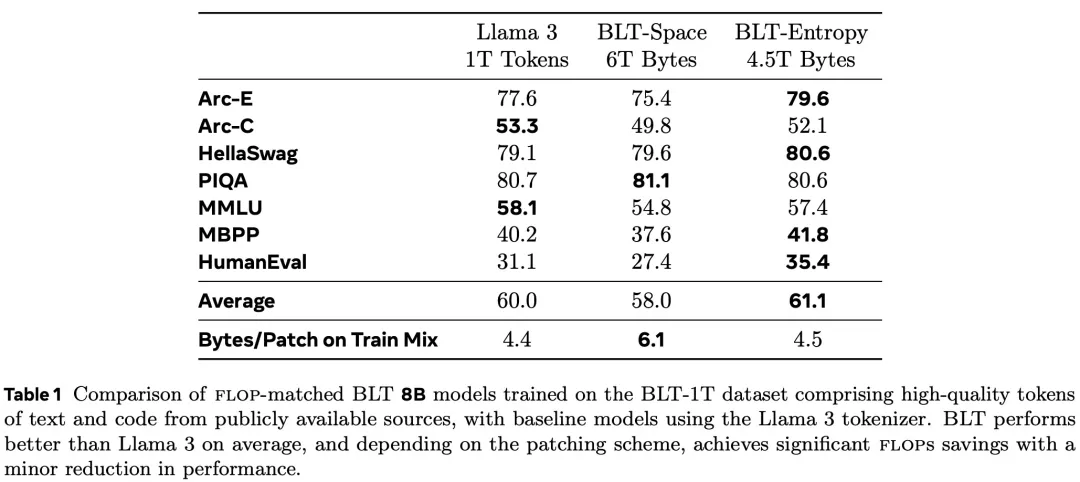

為了進(jìn)一步評估擴(kuò)展特性,該研究在更大的高質(zhì)量數(shù)據(jù)集 BLT-1T 上訓(xùn)練了一個 8B 參數(shù)規(guī)模的 BLT 模型。表 1 比較了在 BLT-1T 數(shù)據(jù)集上訓(xùn)練的三個模型,基于 tokenizer 的 BPE Llama 3 模型和 BLT 模型的兩個變體(一個采用空間 - patch 方案 (BLT-Space),另一個采用基于熵的 patch 方案 (BLT-Entropy))。

結(jié)果顯示,BLT-Entropy 模型在 7 項任務(wù)中的 4 項上的表現(xiàn)優(yōu)于 Llama 3 模型。這種改進(jìn)是由于 (1) 通過動態(tài) patch 更好地利用了訓(xùn)練計算,以及 (2) 直接對字節(jié)級信息進(jìn)行建模,而不是對 token 進(jìn)行建模。

此外,論文還介紹了 Patch 比 Token 更容易擴(kuò)展。

總結(jié)來說,對 patch 長度擴(kuò)展研究表明,BLT 這種基于 patch 的架構(gòu)可以通過同時增加 patch 和模型的大小來實現(xiàn)更好的擴(kuò)展趨勢。這樣的趨勢似乎在更大規(guī)模的模型中持續(xù)存在,甚至有所改善。

字節(jié)建模提高魯棒性

字符級任務(wù)

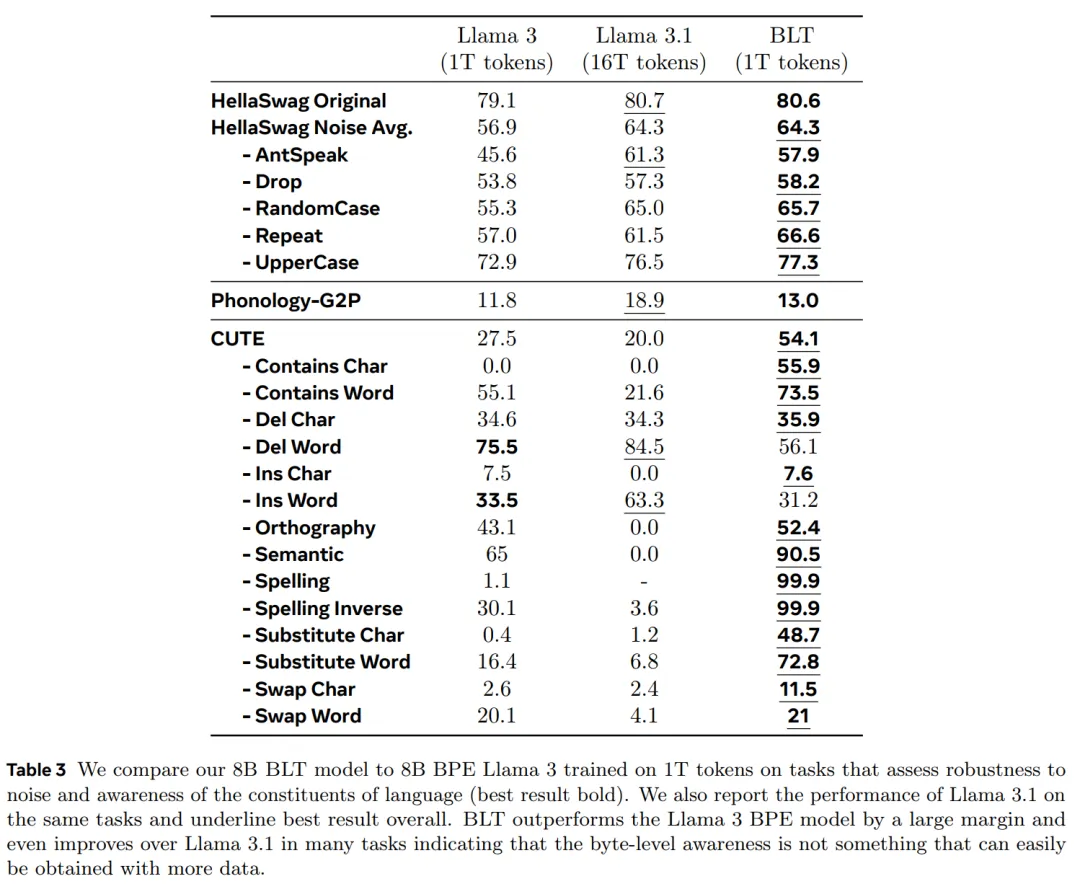

在對帶噪聲的 HellaSwag 測試結(jié)果發(fā)現(xiàn),BLT 確實在魯棒性方面全面超越了基于 tokenizer 的模型,平均優(yōu)勢達(dá)到 8 個百分點,甚至超過了在更大數(shù)據(jù)集上訓(xùn)練的 Llama 3.1 模型。

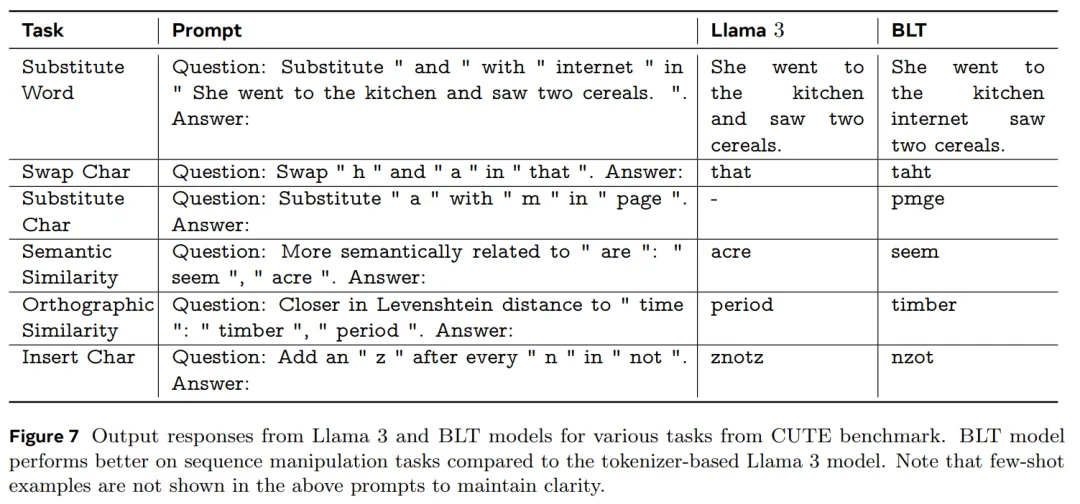

圖 7 展示了 Llama 3 tokenizer 模型表現(xiàn)不佳,但 BLT 模型表現(xiàn)良好的幾個場景。

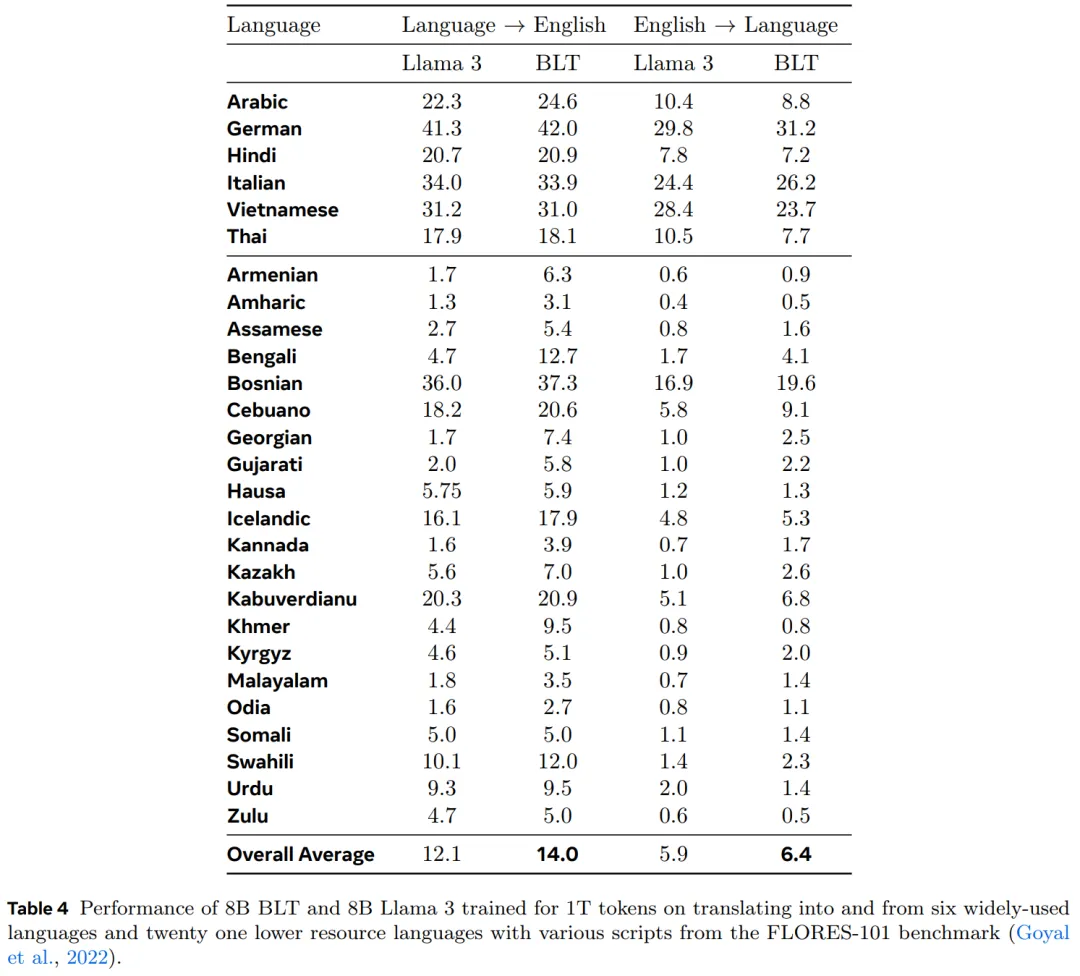

表 4 表明,BLT 的表現(xiàn)超過了使用 Llama 3 tokenizer 訓(xùn)練的模型。在流行的語言對中,BLT 的表現(xiàn)與 Llama 3 相當(dāng)或略好。然而,在資源較少的語言對上,BLT 的表現(xiàn)超過了 Llama 3,這強(qiáng)調(diào)了字節(jié)建模在泛化到長尾字節(jié)序列上的有效性。

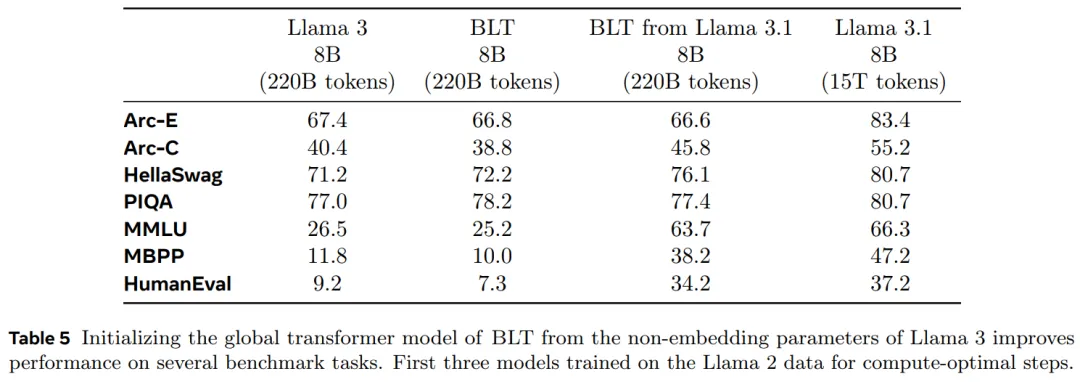

從 Llama 3 到 BLT

最后,作者還探討了一種工作流,其中 BLT 模型可以利用經(jīng)過預(yù)訓(xùn)練的基于 tokenizer 的模型,通過使用經(jīng)過預(yù)訓(xùn)練的 Llama 3.1 初始化 BLT 的全局 tokenizer 參數(shù)來實現(xiàn)更好更快的訓(xùn)練收斂。表 5 為結(jié)果。

很明顯,經(jīng)過 Llama 3.1 初始化的 BLT 顯著優(yōu)于 Llama 3 和 BLT 基線,這些基線是用相同數(shù)量的 flop 訓(xùn)練的。