10 月 11 日 - 10 月 17 日,原定于加拿大蒙特利爾舉辦的計算機視覺領(lǐng)域三大頂會之一——ICCV 2021,正在線上舉行。今天,大會全部獎項已經(jīng)公布。

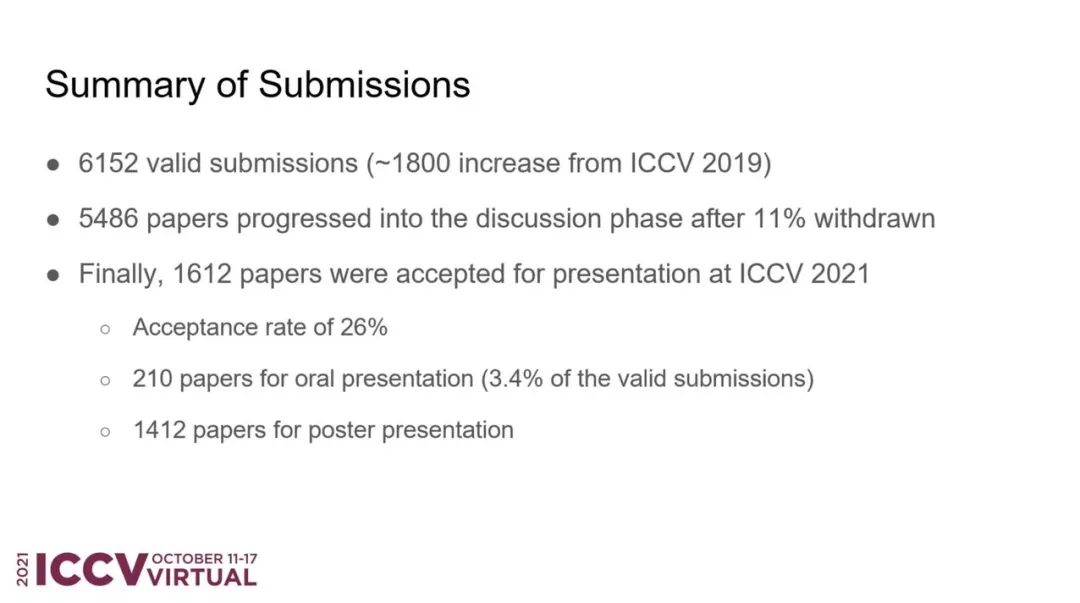

6 月中旬,ICCV 2021 官方公布了論文評審結(jié)果。據(jù)統(tǒng)計,大會共接收了 6236 篇有效論文投稿,在首輪 desk reject 之后還有 6152 篇。

7 月下旬,大會放出了接收論文列表,共有 1617 篇被接收,其中包括 210 篇 Oral 和 1412 篇 Poster 論文,接收率約為 25.9%。相較于 2019 年的 25%,ICCV 2021 的接收率略有上升。

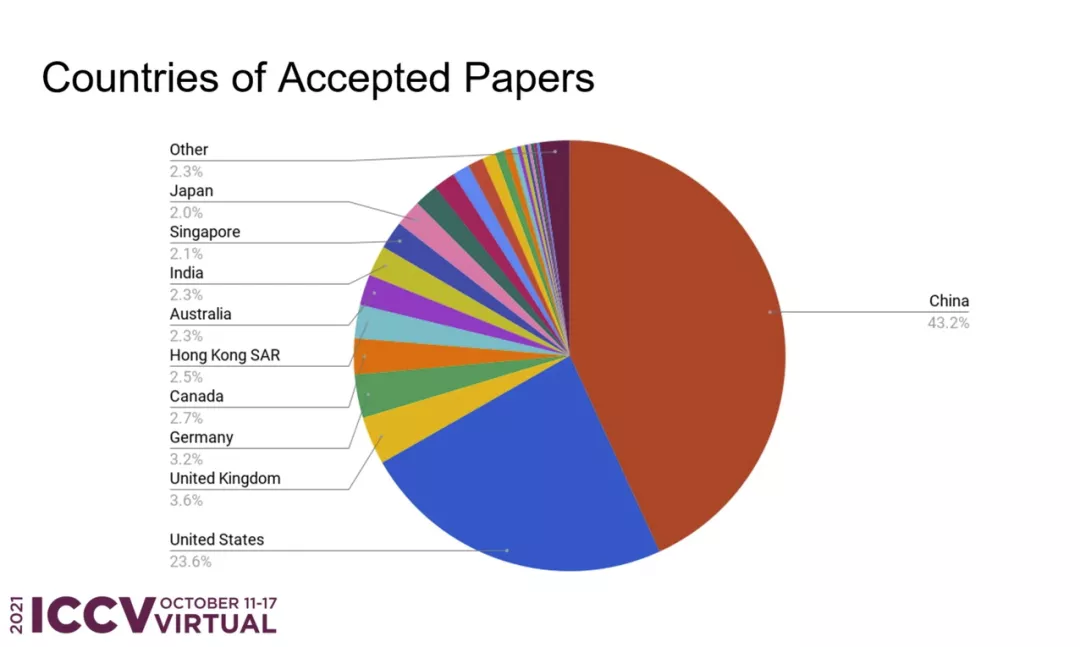

在所有被接收的論文中,來自中國的論文數(shù)量占比最高,達(dá)到了 43.2%,約為第二位美國(23.6%)的兩倍。

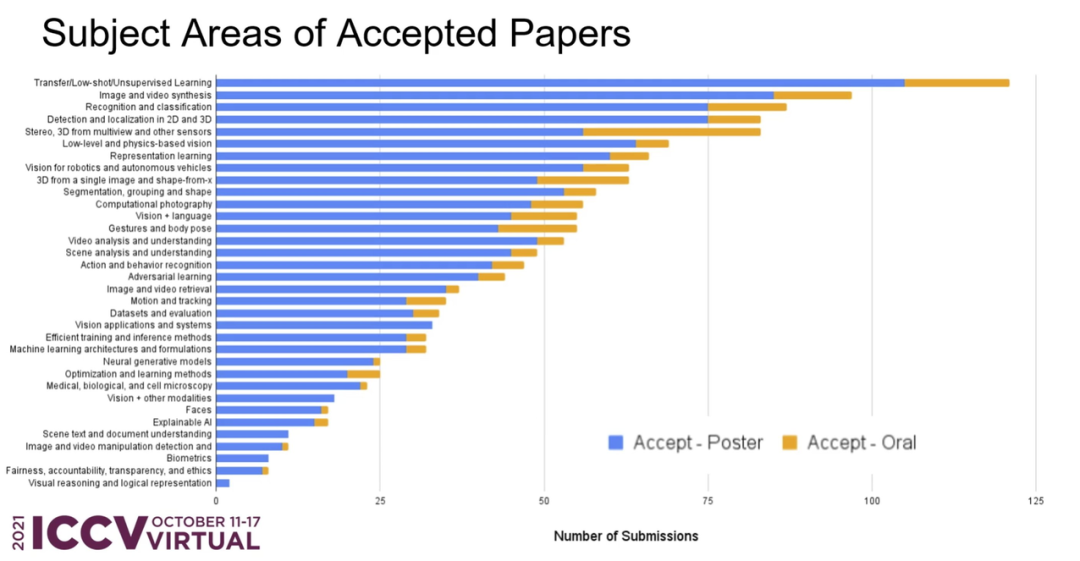

從接收論文的主題領(lǐng)域分布來看,前三位分別是:遷移 / 小樣本 / 無監(jiān)督學(xué)習(xí)、圖像與視頻合成、識別與分類。

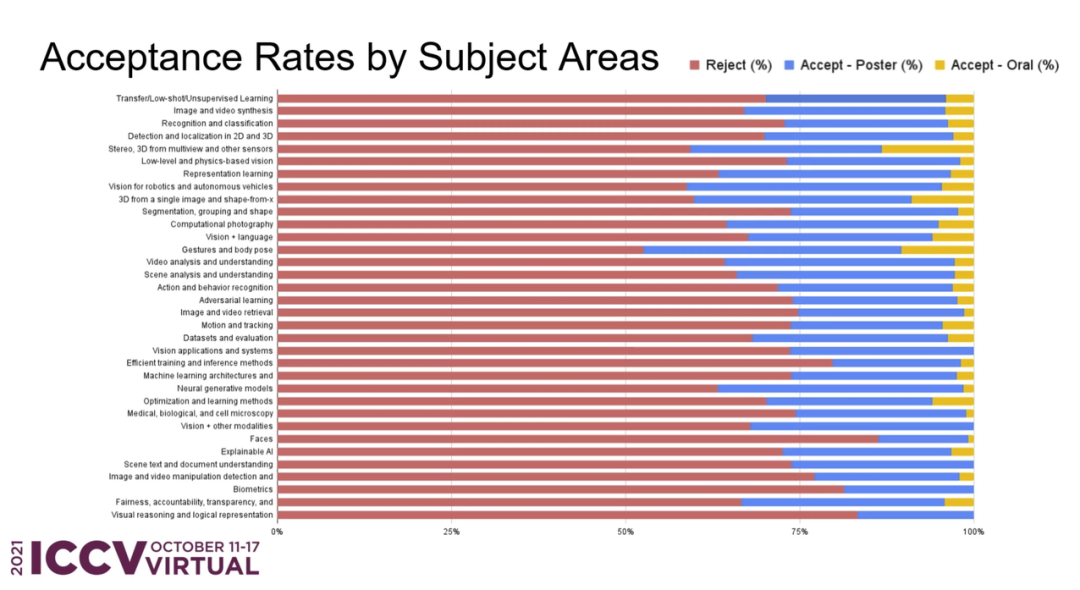

在所有投稿中,各個主題領(lǐng)域的接收率如何?ICCV 官方也進(jìn)行了詳細(xì)的統(tǒng)計:

接下來,介紹一下本屆大會的獲獎信息。

最佳論文 - 馬爾獎

來自微軟亞洲研究院的研究者獲得 ICCV 2021 馬爾獎(最佳論文)。論文作者主要包括來自中國科學(xué)技術(shù)大學(xué)的劉澤、西安交通大學(xué)的林宇桐、微軟的曹越等人。

在 Swin Transformer 論文公開沒多久之后,微軟官方就在 GitHub 上開源了代碼和預(yù)訓(xùn)練模型,涵蓋圖像分類、目標(biāo)檢測以及語義分割任務(wù)。目前,該項目已收獲 4600 星。

- 獲獎?wù)撐模篠win Transformer: Hierarchical Vision Transformer using Shifted Windows

- 作者機構(gòu):微軟亞洲研究院

- 論文地址:https://arxiv.org/pdf/2103.14030.pdf

- 項目地址:https://github.com/microsoft/Swin-Transformer

本文提出了一種新的 vision Transformer,即 Swin Transformer,它可以作為計算機視覺的通用骨干。相比之前的 ViT 模型,Swin Transformer 做出了以下兩點改進(jìn):

其一,引入 CNN 中常用的層次化構(gòu)建方式構(gòu)建分層 Transformer;

其二,引入局部性(locality)思想,對無重合的窗口區(qū)域內(nèi)進(jìn)行自注意力計算。

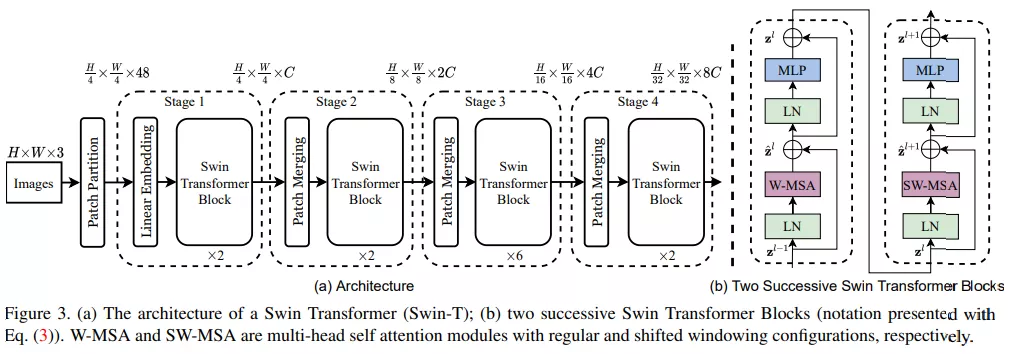

首先來看 Swin Transformer 的整體工作流,下圖 3a 為 Swin Transformer 的整體架構(gòu),圖 3b 為兩個連續(xù)的 Swin Transformer 塊。

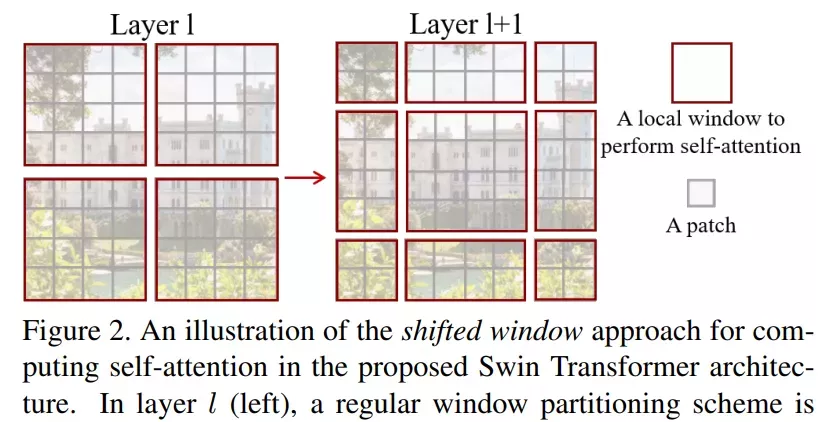

該研究的亮點在于利用移動窗口對分層 Transformer 的表征進(jìn)行計算。通過將自注意力計算限制在不重疊的局部串口,同時允許跨窗口連接。這種分層結(jié)構(gòu)可以靈活地在不同尺度上建模,并具有圖像大小的線性計算復(fù)雜度。下圖 2 為在 Swin Transformer 架構(gòu)中利用移動窗口計算自注意力的工作流:

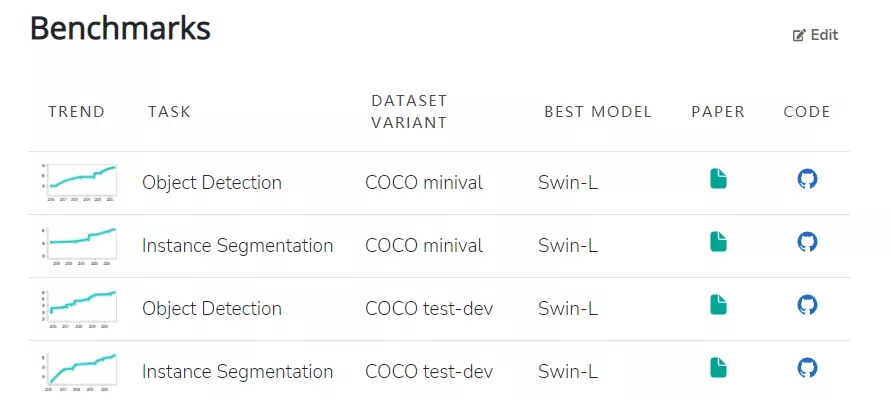

模型本身具有的特性使其在一系列視覺任務(wù)上都實現(xiàn)了頗具競爭力的性能表現(xiàn)。其中,在 ImageNet-1K 數(shù)據(jù)集上實現(xiàn)了 86.4% 的圖像分類準(zhǔn)確率、在 COCO test-dev 數(shù)據(jù)集上實現(xiàn)了 58.7% 的目標(biāo)檢測 box AP 和 51.1% 的 mask AP。目前在 COCO minival 和 COCO test-dev 兩個數(shù)據(jù)集上,Swin-L(Swin Transformer 的變體)在目標(biāo)檢測和實例分割任務(wù)中均實現(xiàn)了 SOTA。

此外,在 ADE20K val 和 ADE20K 數(shù)據(jù)集上,Swin-L 也在語義分割任務(wù)中實現(xiàn)了 SOTA。

最佳學(xué)生論文獎

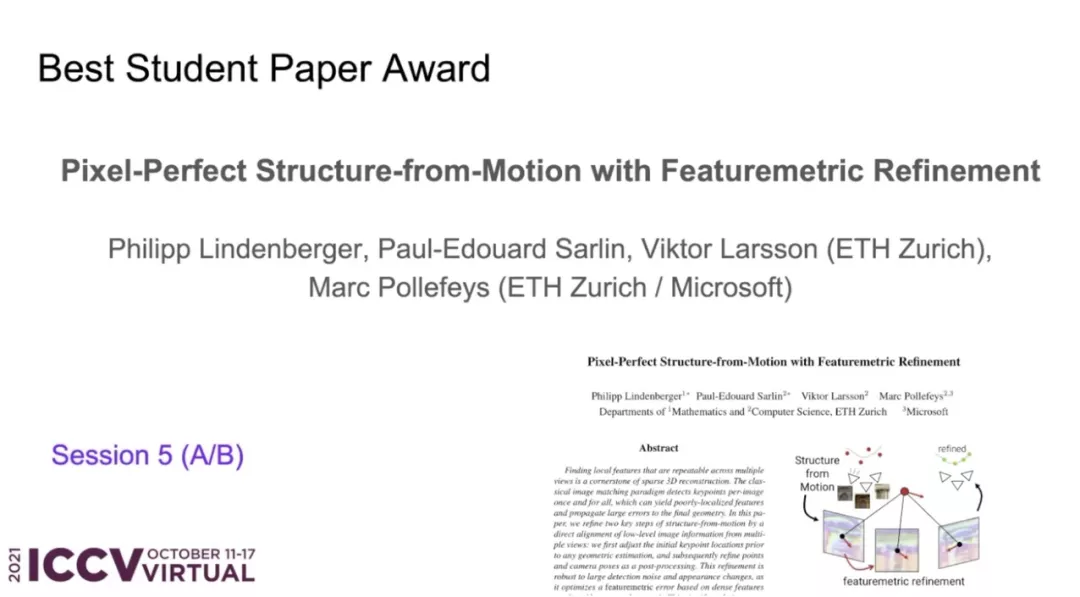

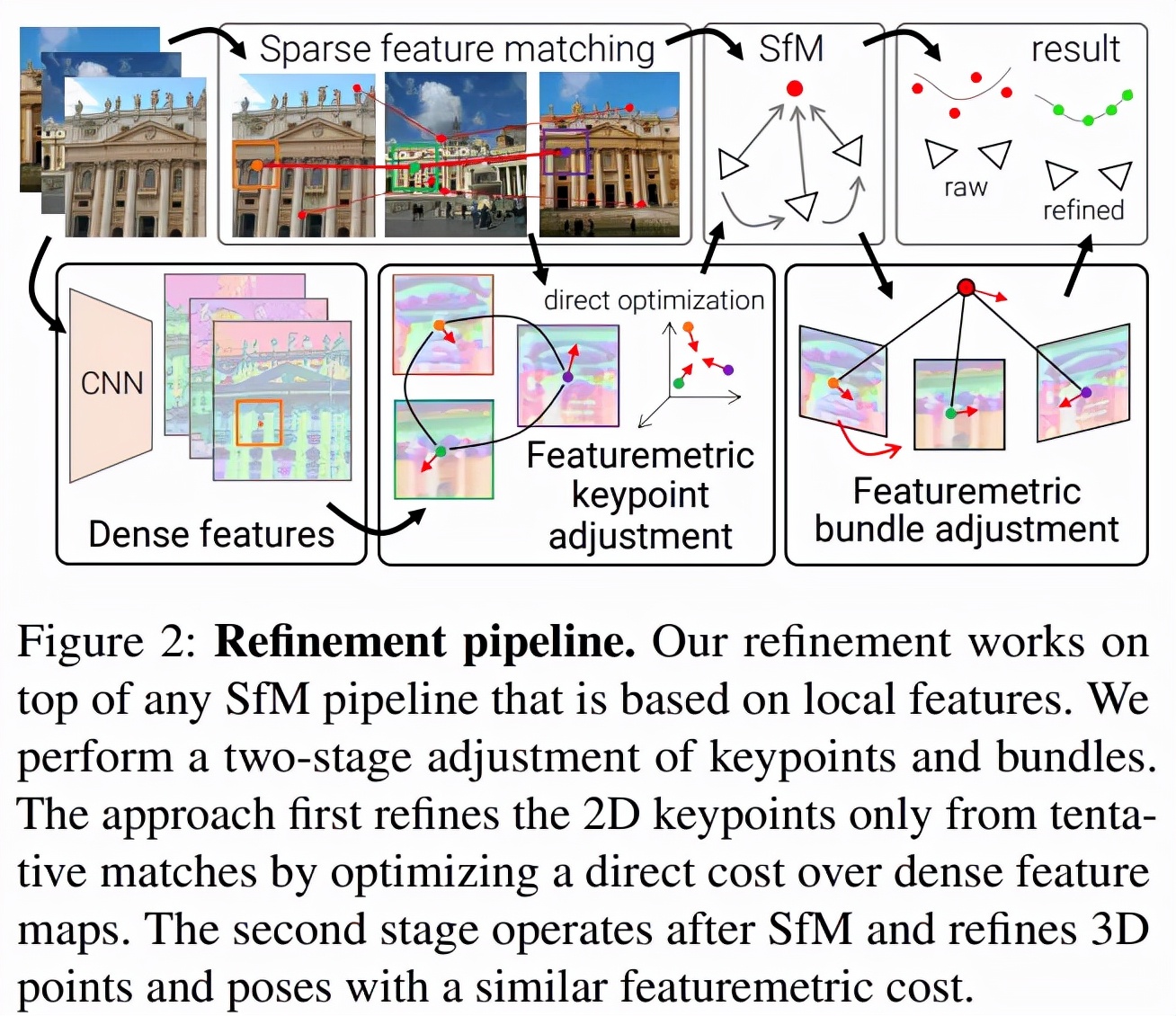

- 獲獎?wù)撐模篜ixel-Perfect Structure-from-Motion with Featuremetric Refinement

- 作者機構(gòu):蘇黎世聯(lián)邦理工學(xué)院、微軟

- 論文地址:https://arxiv.org/pdf/2108.08291.pdf

- 項目地址:github.com/cvg/pixel-perfect-sfm (http://github.com/cvg/pixel-perfect-sfm)

論文摘要:在多個視圖中尋找可重復(fù)的局部特征是稀疏 3D 重建的基礎(chǔ)。經(jīng)典的圖像匹配范式一次性檢測每個圖像的全部關(guān)鍵點(keypoint),這可能會產(chǎn)生定位不佳的特征,使得最終生成的幾何形狀出現(xiàn)較大錯誤。研究者通過直接對齊來自多個視圖的低級圖像信息來細(xì)化運動恢復(fù)結(jié)構(gòu)(structure-from-motion,SFM)的兩個關(guān)鍵步驟:首先在任何幾何估計之前調(diào)整初始關(guān)鍵點位置,然后細(xì)化點和相機姿態(tài)作為一個后處理。這種改進(jìn)對大的檢測噪聲和外觀變化具有穩(wěn)健性,因為它基于神經(jīng)網(wǎng)絡(luò)預(yù)測的密集特征優(yōu)化了特征度量誤差。這顯著提高了相機姿態(tài)和場景幾何的準(zhǔn)確性,并適用于各種關(guān)鍵點檢測器、具有挑戰(zhàn)性的觀看條件和現(xiàn)成的(off-the-shelf)深度特征。該系統(tǒng)可以輕松擴展到大型圖像集合,從而實現(xiàn)像素完美的大規(guī)模眾包定位。該方法現(xiàn)已封裝為 SfM 軟件 COLMAP 的附加組件。

細(xì)化幾何原本是一種局部操作,但該研究表明局部密集像素可以起到較大的作用。SfM 通常盡可能早地丟棄圖像信息,該研究借助直接對齊用幾個步驟替代了 SfM。下圖 2 是該方法的概覽:

最佳論文榮譽提名獎

今年有四篇論文獲得 ICCV 2021 最佳論文榮譽提名獎。

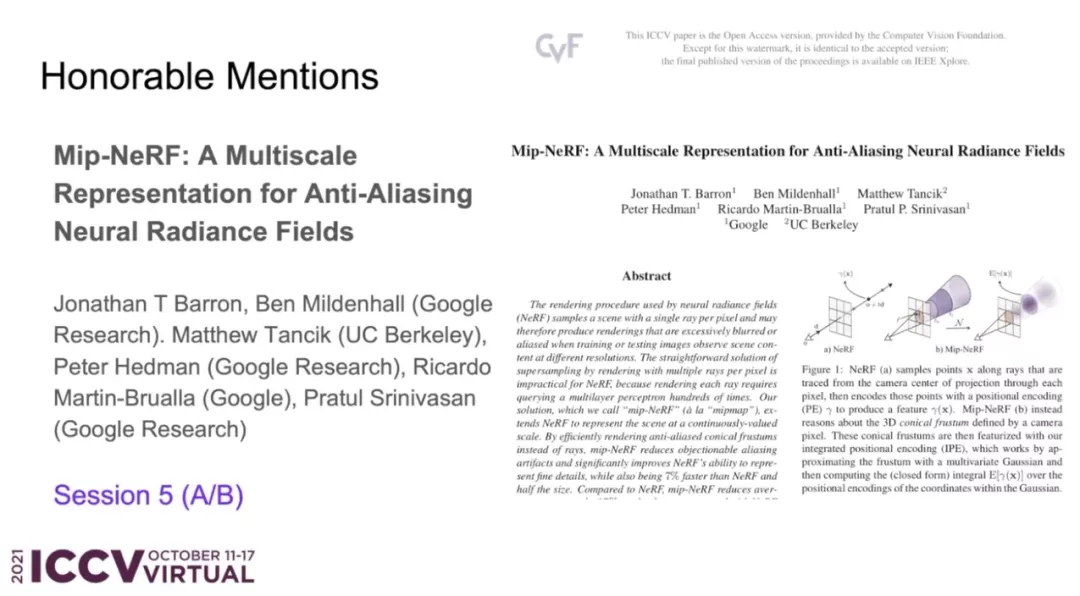

- 論文 1:Mip-NeRF: A Multiscale Representation for Anti-Aliasing Neural Radiance Fields

- 作者機構(gòu):谷歌、加州大學(xué)伯克利分校

- 論文地址:https://arxiv.org/pdf/2103.13415.pdf

論文摘要:NeRF(neural radiance fields)使用的渲染過程以每像素單個光線對場景進(jìn)行采樣,因此當(dāng)訓(xùn)練或測試圖像以不同分辨率觀察場景內(nèi)容時,可能會產(chǎn)生過度模糊的渲染。該研究提出了 mip-NeRF,它以連續(xù)值的比例表示場景。他們通過高效地渲染消除反鋸齒圓錐錐體( anti-aliased conical frustums)取代光線,mip NeRF 減少了混疊瑕疵(aliasing artifacts),并顯著提高了其表示精細(xì)細(xì)節(jié)的能力,同時比 NeRF 快 7%,而大小僅為 NeRF 的一半。

與 NeRF 相比,mip NeRF 在數(shù)據(jù)集上降低了 17% 的平均錯誤率,在具有挑戰(zhàn)性的多尺度變體上降低了 60% 的平均錯誤率。此外,Mip NeRF 還能夠在多尺度數(shù)據(jù)集上與超采樣 NeRF 的精度相匹配,同時速度快 22 倍。

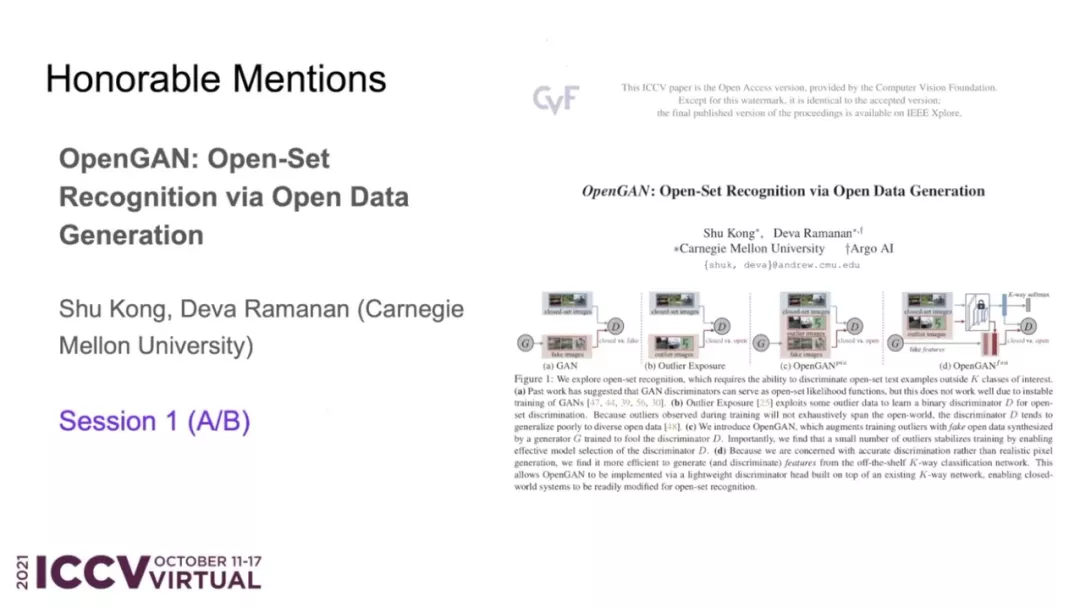

- 論文 2:OpenGAN: Open-Set Recognition via Open Data Generation

- 作者機構(gòu):卡內(nèi)基梅隆大學(xué)

- 論文地址:https://arxiv.org/pdf/2104.02939.pdf

論文摘要:真實世界的機器學(xué)習(xí)系統(tǒng)需要分析新的測試數(shù)據(jù),而這些測試數(shù)據(jù)與訓(xùn)練數(shù)據(jù)不同。在 K-way 分類中,這被清晰地表述為開集識別,其核心是區(qū)分 K 個閉集類之外的開集數(shù)據(jù)的能力。關(guān)于開集的鑒別,有兩種思想:1) 利用離群(outlier)數(shù)據(jù)作為開集,對開 - 閉(open-vs-closed)二進(jìn)制鑒別器分別進(jìn)行鑒別學(xué)習(xí);2) 使用 GAN 對閉集數(shù)據(jù)分布進(jìn)行無監(jiān)督學(xué)習(xí),并將其鑒別器作為開集似然函數(shù)。然而,前者不能很好地泛化到不同的開放測試數(shù)據(jù),而后者由于 GAN 的訓(xùn)練不穩(wěn)定效果不佳。

該研究提出了 OpenGAN,它通過將每種方法與幾種技術(shù)見解相結(jié)合來解決每種方法的局限性。首先,他們展示了在一些真實的離群數(shù)據(jù)上,精心選擇的 GAN 鑒別器已經(jīng)達(dá)到了 SOTA 水平。其次,該研究用對抗性合成的假數(shù)據(jù)擴充可用的真實開集示例集。第三,也是最重要的,該研究在 K-way 網(wǎng)絡(luò)計算的特征上可以構(gòu)建鑒別器。大量實驗表明,OpenGAN 顯著優(yōu)于先前的開集方法。

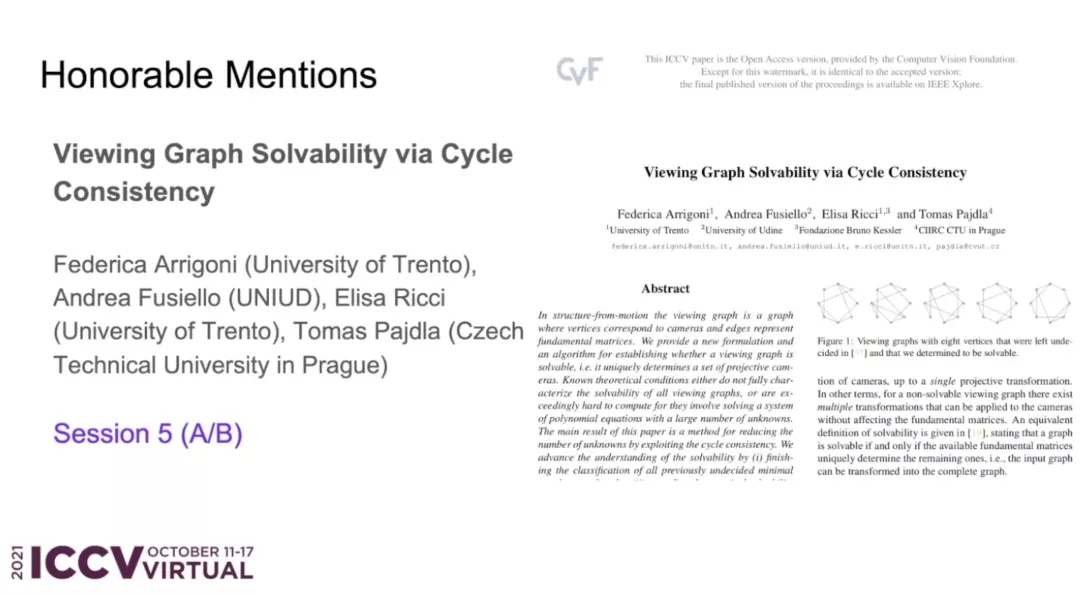

- 論文 3:Viewing Graph Solvability via Cycle Consistency

- 作者機構(gòu):特倫托大學(xué)等

- 論文地址:https://openaccess.thecvf.com/content/ICCV2021/papers/Arrigoni_Viewing_Graph_Solvability_via_Cycle_Consistency_ICCV_2021_paper.pdf

論文摘要:在運動恢復(fù)結(jié)構(gòu)(structure-from-motion,SFM)中,視圖圖(viewing graph)是一種頂點與相機對應(yīng)、邊代表基本矩陣的圖。該研究提供了一種新的公式和算法,用于確定視圖圖是否可解(即它唯一地確定一組投影相機)。已知的理論條件要么不能完全描述所有視圖圖的可解性,要么涉及求解含大量未知數(shù)的多項式方程組而非常難以計算。該論文的主要成果是提出一種利用循環(huán)一致性來減少未知數(shù)的方法。該研究通過以下 3 種方法來進(jìn)一步理解可解性:(i) 完成對最多 9 個節(jié)點的所有先前未定最小圖的分類;(ii) 將實際可解性測試擴展到具有最多 90 個節(jié)點的最小圖;(iii) 通過證明有限可解性不等于可解性明確回答了一個開放型研究問題。最后,該研究以一個真實數(shù)據(jù)的實驗表明在實際情況中出現(xiàn)了無解的圖。

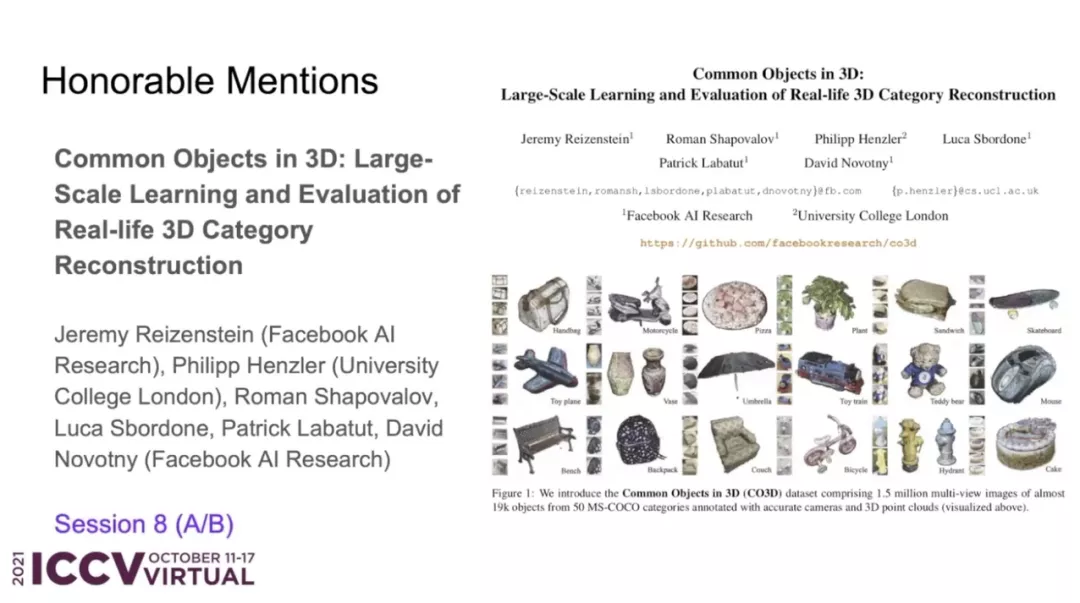

- 論文 4:Common Objects in 3D: Large-Scale Learning and Evaluation of Real-life 3D Category Reconstruction

- 作者機構(gòu):Facebook AI 研究院、倫敦大學(xué)學(xué)院

- 論文地址:https://arxiv.org/pdf/2109.00512.pdf

論文摘要:由于缺乏真實的以類別為中心的 3D 標(biāo)注數(shù)據(jù),傳統(tǒng)的 3D 物體類別學(xué)習(xí)方法,主要是在合成數(shù)據(jù)集上進(jìn)行訓(xùn)練和評估。該研究的主要目標(biāo)是通過收集與現(xiàn)有合成數(shù)據(jù)類似的真實世界數(shù)據(jù)來促進(jìn)該領(lǐng)域的進(jìn)展。因此,這項工作的主要貢獻(xiàn)是一個名為「Common Objects in 3D」的大規(guī)模數(shù)據(jù)集,,其中含有真實的多視角物體類別圖像,并附有相機姿態(tài)和 3D 點云標(biāo)注真值。該數(shù)據(jù)集包含來自近 19,000 個視頻的 150 萬幀捕獲了 50 個 MS-COCO 類別的物體,因此它在類別和物體的數(shù)量方面都比其他數(shù)據(jù)集具有明顯優(yōu)勢。研究者利用這個新數(shù)據(jù)集對幾種新視圖合成和以類別為中心的 3D 重建方法進(jìn)行了大規(guī)模評估。此外,該研究還貢獻(xiàn)了 NerFormer——一種新穎的神經(jīng)渲染方法,利用強大的 Transformer 來重建僅給定少量視圖的物體。

PAMI TC 獎

今年 ICCV 上的 PAMI 獎依舊包括四大獎項,分別是 Helmholtz 獎、Everingham 獎、Azriel Rosenfeld 終身成就獎和杰出研究者獎。

PAMI 是 IEEE 旗下的期刊,是模式識別和機器學(xué)習(xí)領(lǐng)域最重要的學(xué)術(shù)性匯刊之一,有著很高的影響因子和排名。

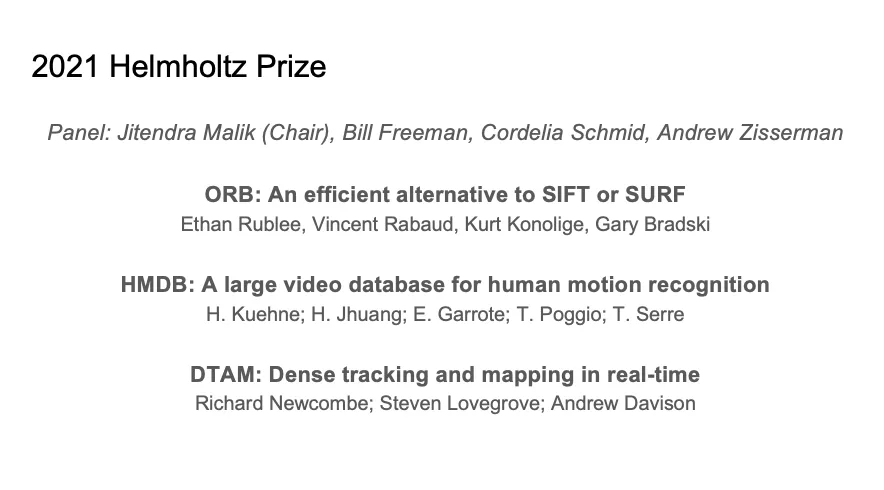

Helmholtz 獎

Helmholtz 獎項名稱來源于 19 世紀(jì)的物理、生理學(xué)家 Hermann von Helmholtz,旨在獎勵對計算機視覺領(lǐng)域做出重要貢獻(xiàn)的工作,頒發(fā)對象是十年前對計算機視覺領(lǐng)域產(chǎn)生重大影響的論文。

今年共有 3 篇論文獲得了 Helmholtz 獎,分別是:

- 論文 1:《ORB: An efficient alternative to SIFT or SURF》

- 論文鏈接:https://ieeexplore.ieee.org/document/6126544

- 論文 2:《HMDB: A large video database for human motion recognition》

- 論文鏈接:https://ieeexplore.ieee.org/document/6126543

- 論文 3:《DTAM: Dense tracking and mapping in real-time》

- 論文鏈接:https://ieeexplore.ieee.org/document/6126513

Everingham 獎

Everingham 獎的設(shè)立初衷是紀(jì)念計算機視覺領(lǐng)域?qū)<?Mark Everingham 并激勵后來者在計算機視覺領(lǐng)域做出更多貢獻(xiàn)。頒獎對象包括為計算機視覺社區(qū)其他成員做出巨大貢獻(xiàn)的無私研究者或研究團隊。

本次獲得 Everingham 獎項的分別是 Detectron 目標(biāo)檢測和分割軟件團隊和 KITTI 視覺基準(zhǔn)團隊。

Detectron 目標(biāo)檢測和分割軟件團隊成員包括 Ross Girshick, Yuxin Wu, llija Radosavovic, Alexander Kirillov, Georgia Gkioxari,Francisco Massa,Wan-Yen Lo,Piotr Dollar, 何愷明和其他開源貢獻(xiàn)者。

KITTI 視覺基準(zhǔn)團隊成員包括 Andreas Geiger, Philip Lenz, Christoph Stiller, Raquel Urtasun 等。

Azriel Rosenfeld 終身成就獎

Azriel Rosenfeld 終身成就獎是為了紀(jì)念已故的計算機科學(xué)家和數(shù)學(xué)家 Azriel Rosenfeld 教授,旨在表彰在長期職業(yè)生涯中為計算機視覺領(lǐng)域作出突出貢獻(xiàn)的杰出研究者。

今年的 Azriel Rosenfeld 終身成就獎頒給了 UC 伯克利電氣工程與計算機科學(xué)系 NEC 特聘教授 Ruzena Bajcsy。

Ruzena Bajcsy 在斯坦福大學(xué)獲得了計算機科學(xué)博士學(xué)位。從 1972 年到 2001 年,Ruzena Bajcsy 是賓夕法尼亞大學(xué)計算機與信息科學(xué)系的教授,并于 1978 年建立了通用機器人、自動化、傳感和感知 (GRASP) 實驗室。28 年間,她一直從事機器人研究,包括計算機視覺、觸覺感知以及一般的系統(tǒng)識別問題。

在加入 UC 伯克利之前,她是美國國家科學(xué)基金會計算機與信息科學(xué)與工程理事會的負(fù)責(zé)人(1999-2001 年)。

Ruzena Bajcsy 美國國家工程院 (1997) 和美國國家醫(yī)學(xué)科學(xué)院 (1995) 的成員,以及 ACM Fellow 和 AAAI Fellow。2002 年 11 月,她被《探索》雜志評為 50 位最重要的女性之一。由于在機器人和自動化領(lǐng)域的貢獻(xiàn),Ruzena Bajcsy 獲得了本杰明富蘭克林計算機和認(rèn)知科學(xué)獎?wù)拢?009 年)和 IEEE 機器人與自動化獎(2013 年)。

杰出研究者獎

基于主要研究貢獻(xiàn)及對其他研究的激發(fā)影響等考量原則,杰出研究者獎旨在獎勵對計算機視覺發(fā)展作出重大貢獻(xiàn)的研究者。

今年的杰出研究者獎獲得者為 Pietro Perona 和 Cordelia Schmid。

Pietro Perona 是加州理工學(xué)院教授,他以計算機視覺領(lǐng)域的研究成果著名,同時也是加州理工學(xué)院計算機視覺小組的負(fù)責(zé)人。

Cordelia Schmid 是法國國家信息與自動化研究所(INRIA)的 THOTH 項目組負(fù)責(zé)人。她在 2012 年入選 IEEE Fellow,以表彰其在大規(guī)模圖像檢索、分類和目標(biāo)檢測方面的貢獻(xiàn)。2020 年,Cordelia Schmid 獲得了 Milner 獎。