開源版SearchGPT來了,兩張3090就可復(fù)現(xiàn),超越Perplexity付費版

OpenAI推出SearchGPT沒幾天,開源版本也來了。

港中文MMLab、上海AI Lab、騰訊團(tuán)隊簡易實現(xiàn)了Vision Search Assistant,模型設(shè)計簡單,只要兩張RTX3090就可復(fù)現(xiàn)。

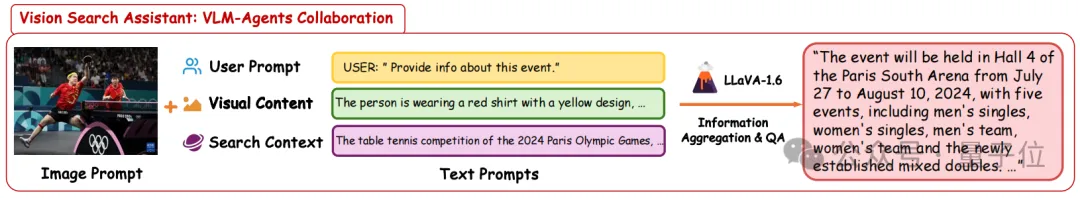

Vision Search Assistant(VSA)以視覺語言模型(VLM)為基礎(chǔ),巧妙地將Web搜索能力融入其中,讓VLM內(nèi)部的知識得到實時更新,使其更加靈活和智能。

目前,VSA已經(jīng)針對通用圖像進(jìn)行了實驗,可視化和量化結(jié)果良好。但不同類別的圖像各具特色,還可以針對不同種類的圖像(比如表格、醫(yī)學(xué)等)構(gòu)建出更為特定的VSA應(yīng)用。

更令人振奮的是,VSA的潛力并不僅限于圖像處理。還有更廣闊的可探索空間,比如視頻、3D模型和聲音等領(lǐng)域,期待能將多模態(tài)研究推向新的高度。

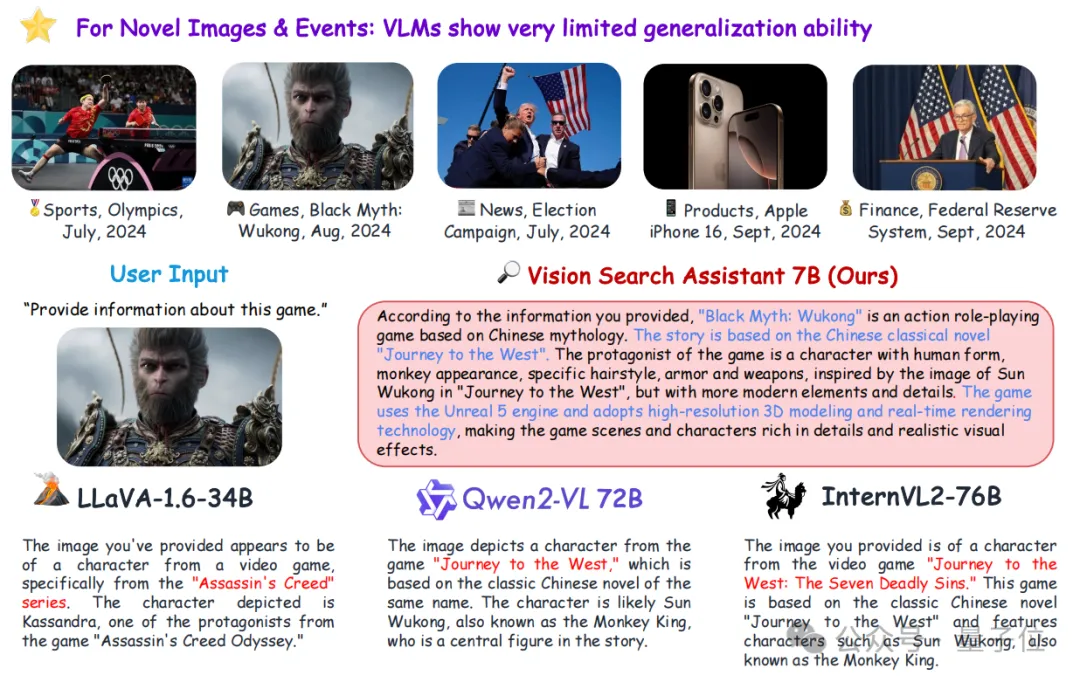

讓VLM處理未見過的圖像和新概念

大型語言模型(LLM)的出現(xiàn)讓人類可以利用模型的強大零樣本問答能力來獲取陌生知識。

在此基礎(chǔ)上,檢索增強生成(RAG)等技術(shù)進(jìn)一步提高了LLM在知識密集型、開放域問答任務(wù)中的表現(xiàn)。然而,VLM在面對未見過的圖像和新概念時,它們往往不能利用好來自互聯(lián)網(wǎng)的最新多模態(tài)知識。

現(xiàn)有的 Web Agent主要依賴于對用戶問題的檢索,并總結(jié)檢索返回的HTML文本內(nèi)容,因此它們在處理涉及圖像或其他視覺內(nèi)容的任務(wù)時存在明顯的局限性,即視覺信息被忽視或處理不充分。

為了解決這一問題,團(tuán)隊提出了Vision Search Assistant。Vision Search Assistant以VLM模型為基礎(chǔ),能夠回答有關(guān)未見過的圖像或新概念的問題,其行為類似人類在互聯(lián)網(wǎng)上進(jìn)行搜索并解決問題的過程,包括:

- 理解查詢

- 決定應(yīng)該關(guān)注圖像中的哪些對象并推斷對象之間的相關(guān)性

- 逐對象生成查詢文本

- 根據(jù)查詢文本和推斷出的相關(guān)性分析搜索引擎返回的內(nèi)容

- 判斷獲得的視覺和文本信息是否足以生成答案,或者它應(yīng)該迭代和改進(jìn)上述過程

- 結(jié)合檢索結(jié)果,回答用戶的問題

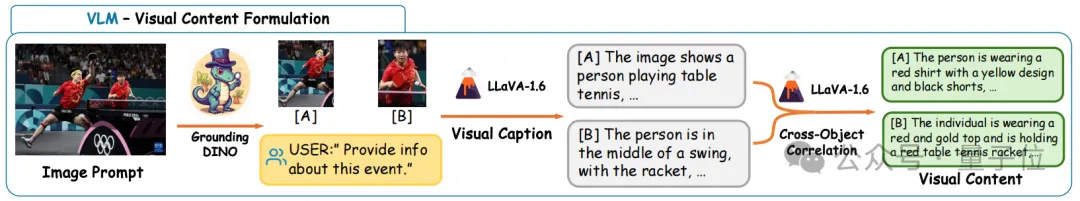

視覺內(nèi)容描述

視覺內(nèi)容描述模塊被用來提取圖像中對象級的描述和對象之間的相關(guān)性,其流程如下圖所示。

首先利用開放域的檢測模型來獲取值得關(guān)注的圖像區(qū)域。緊接著對每一個檢測到的區(qū)域,使用VLM獲取對象級的文本描述。

最后,為了更全面地表達(dá)視覺內(nèi)容,利用VLM進(jìn)一步關(guān)聯(lián)不同的視覺區(qū)域以獲得不同對象的更精確描述。

具體地,令用戶輸入圖片為,用戶的問題為。可通過一個開放域的檢測模型獲取個感興趣的區(qū)域:

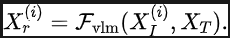

然后利用預(yù)訓(xùn)練的VLM模型分別描述這個區(qū)域的視覺內(nèi)容:

為了讓不同區(qū)域的信息關(guān)聯(lián)起來,提高描述的精度,可將區(qū)域與其它區(qū)域的描述拼接,讓VLM對區(qū)域的描述進(jìn)行矯正:

至此,從用戶輸入獲得了與之高度相關(guān)的個視覺區(qū)域的精確描述。

Web知識搜索:“搜索鏈”

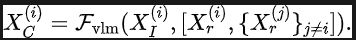

Web知識搜索的核心是名為“搜索鏈”的迭代算法,旨在獲取相關(guān)視覺描述的綜合性的Web知識,其流程如下圖所示。

在Vision Search Assistant中利用LLM來生成與答案相關(guān)的子問題,這一LLM被稱為“Planing Agent”。搜索引擎返回的頁面會被同樣的LLM分析、選擇和總結(jié),被稱為“Searching Agent”。通過這種方式,可以獲得與視覺內(nèi)容相關(guān)的Web知識。

具體地,由于搜索是對每個區(qū)域的視覺內(nèi)容描述分別進(jìn)行的,因此以區(qū)域為例,并省略這個上標(biāo),即。該模塊中使用同一個LLM模型構(gòu)建決策智能體(Planning Agent)和搜索智能體(Searching Agent)。決策智能體控制整個搜索鏈的流程,搜索智能體與搜索引擎交互,篩選、總結(jié)網(wǎng)頁信息。

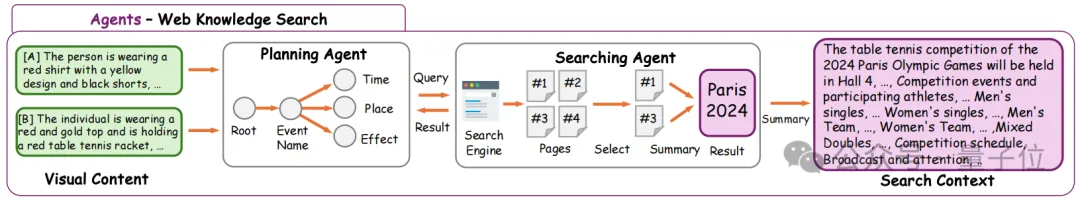

以第一輪迭代為例,決策智能體將問題拆分成個搜索子問題并交由搜索智能體處理。搜索智能體會將每一個交付搜索引擎,得到頁面集合。搜索引擎會閱讀頁面摘要并選擇與問題最相關(guān)的頁面集合(下標(biāo)集為),具體方法如下:

協(xié)同生成

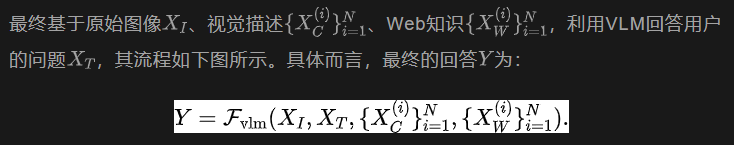

最終基于原始圖像、視覺描述、Web知識,利用VLM回答用戶的問題,其流程如下圖所示。具體而言,最終的回答為:

實驗結(jié)果

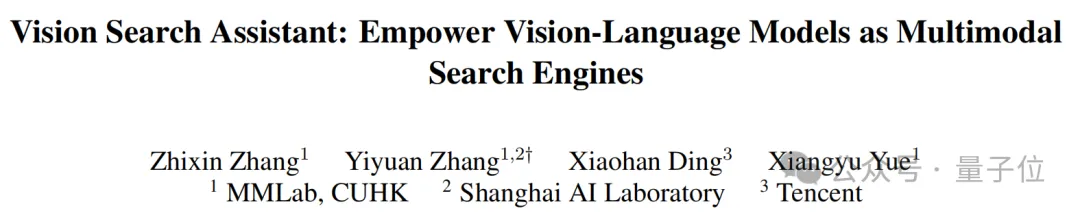

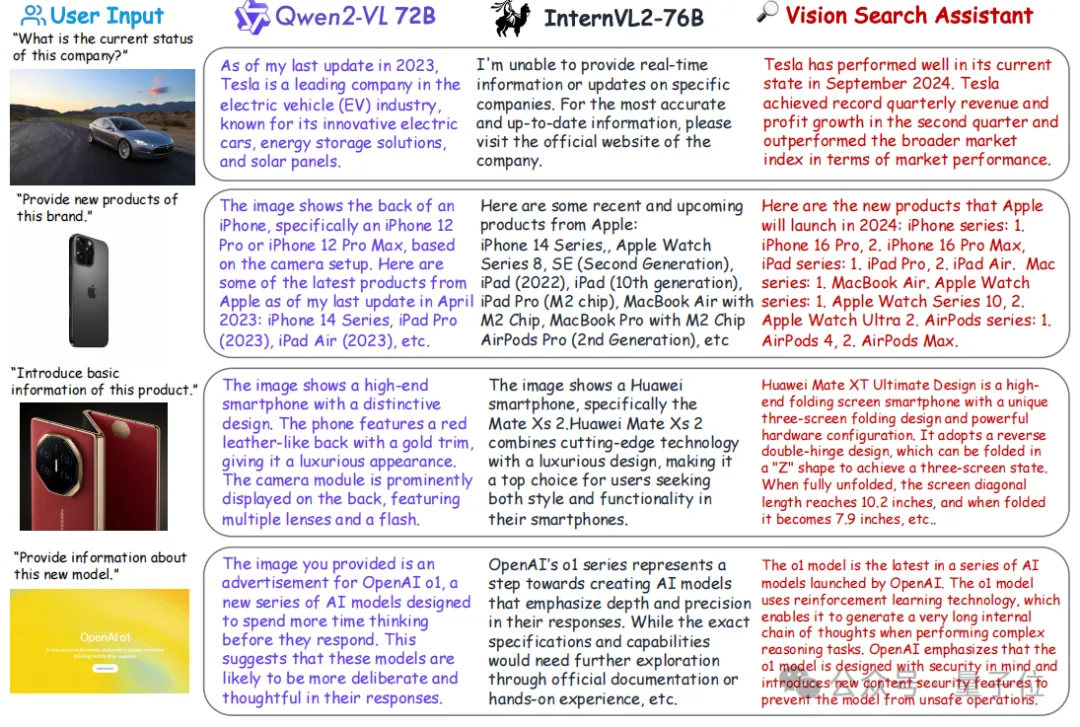

開放集問答可視化對比

下圖中比較了新事件(前兩行)和新圖像(后兩行)的開放集問答結(jié)果。

將Vision Search Assistant和Qwen2-VL-72B以及InternVL2-76B進(jìn)行了比較,不難發(fā)現(xiàn),Vision Search Assistant 擅長生成更新、更準(zhǔn)確、更詳細(xì)的結(jié)果。

例如,在第一個樣例中,Vision Search Assistant對2024年Tesla公司的情況進(jìn)行了總結(jié),而Qwen2-VL局限于2023年的信息,InternVL2明確表示無法提供該公司的實時情況。

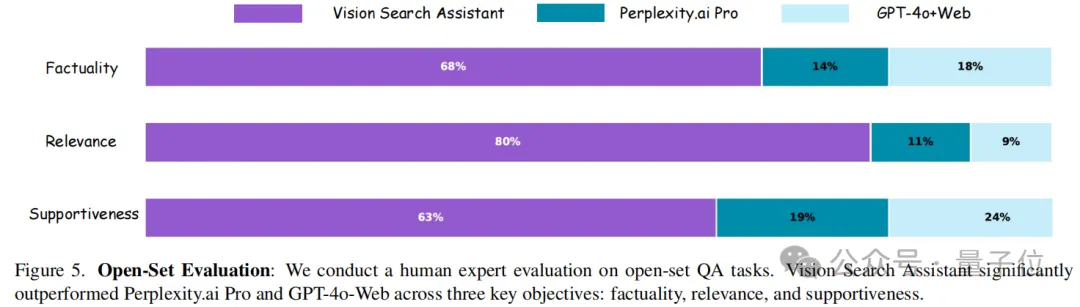

開放集問答評估

在開放集問答評估中,總共通過10位人類專家進(jìn)行了比較評估,評估內(nèi)容涉及7月15日至9月25日期間從新聞中收集的100個圖文對,涵蓋新穎圖像和事件的所有領(lǐng)域。

人類專家從真實性、相關(guān)性和支持性三個關(guān)鍵維度進(jìn)行了評估。

如下圖所示,與Perplexity.ai Pro和GPT-4-Web相比,Vision Search Assistant在所有三個維度上都表現(xiàn)出色。

- 事實性:Vision Search Assistant得分為68%,優(yōu)于Perplexity.ai Pro(14%)和 GPT-4-Web(18%)。這一顯著領(lǐng)先表明,Vision Search Assistant 始終提供更準(zhǔn)確、更基于事實的答案。

- 相關(guān)性:Vision Search Assistant 的相關(guān)性得分為80%,在提供高度相關(guān)的答案方面表現(xiàn)出顯著優(yōu)勢。相比之下,Perplexity.ai Pro和GPT-4-Web分別達(dá)到11%和9%,顯示出在保持網(wǎng)絡(luò)搜索時效性方面存在顯著差距。

- 支持性:Vision Search Assistant在為其響應(yīng)提供充分證據(jù)和理由方面也優(yōu)于其他模型,支持性得分為63%。Perplexity.ai Pro和GPT-4-Web分別以19%和24%的得分落后。這些結(jié)果凸顯了Vision Search Assistant 在開放集任務(wù)中的卓越表現(xiàn),特別是在提供全面、相關(guān)且得到良好支持的答案方面,使其成為處理新圖像和事件的有效方法。

封閉集問答評估

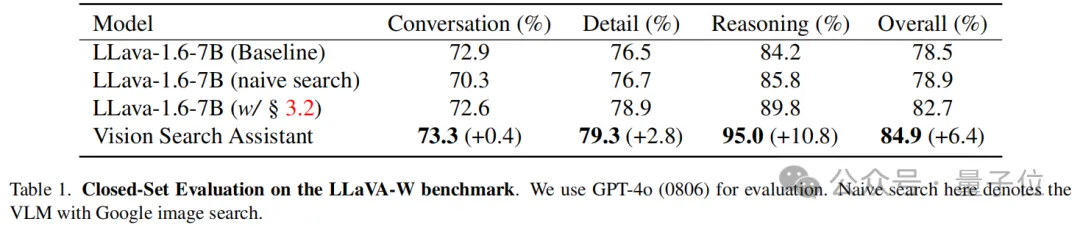

在LLaVA W基準(zhǔn)進(jìn)行閉集評估,其中包含60個問題,涉及VLM在野外的對話、細(xì)節(jié)和推理能力。

使用GPT-4o(0806)模型進(jìn)行評估,使用LLaVA-1.6-7B作為基線模型,該模型在兩種模式下進(jìn)行了評估:標(biāo)準(zhǔn)模式和使用簡單Google圖片搜索組件的“樸素搜索”模式。

此外還評估了LLaVA-1.6-7B的增強版本,該版本配備搜索鏈模塊。

如下表所示,Vision Search Assistant在所有類別中均表現(xiàn)出最強的性能。具體而言,它在對話類別中獲得了73.3%的得分,與LLaVA模型相比略有提升,提升幅度為+0.4%。在細(xì)節(jié)類別中,Vision Search Assistant以79.3%的得分脫穎而出,比表現(xiàn)最好的LLaVA變體高出 +2.8%。

在推理方面,VSA方法比表現(xiàn)最佳的LLaVA模型高出+10.8%。這表明Vision Search Assistant對視覺和文本搜索的高級集成極大地增強了其推理能力。

Vision Search Assistant的整體性能為84.9%,比基線模型提高+6.4%。這表明Vision Search Assistant在對話和推理任務(wù)中都表現(xiàn)出色,使其在野外問答能力方面具有明顯優(yōu)勢。

論文:https://arxiv.org/abs/2410.21220

主頁:https://cnzzx.github.io/VSA/

代碼:https://github.com/cnzzx/VSA