60億AI獨角獸Mistral祭出磁力鏈,首個多模態Pixtral 12B登場!但被大佬曝出評測造假

法國AI初創Mistral AI,又扔出一條磁力鏈炸場了。

圖片

圖片

這次,與以往不同的是,他們發布了首個多模態模型Pixtral 12B,集語言、視覺能力于一身。

圖片

圖片

這意味著,Mistral AI正式跨界MMML,開啟多模態AI新時代,同時向OpenAI、Anthropic等勁敵發起挑戰。

多模態Pixtral 12B,是基于文本模型Nemo 12B完成訓練。

與GPT-4o、Claude類似,只需上傳一張圖、提供一個鏈接,模型就能根據提示回答問題。

它不僅能夠識別復雜手寫筆記,還能看懂數學公式、圖表等等。

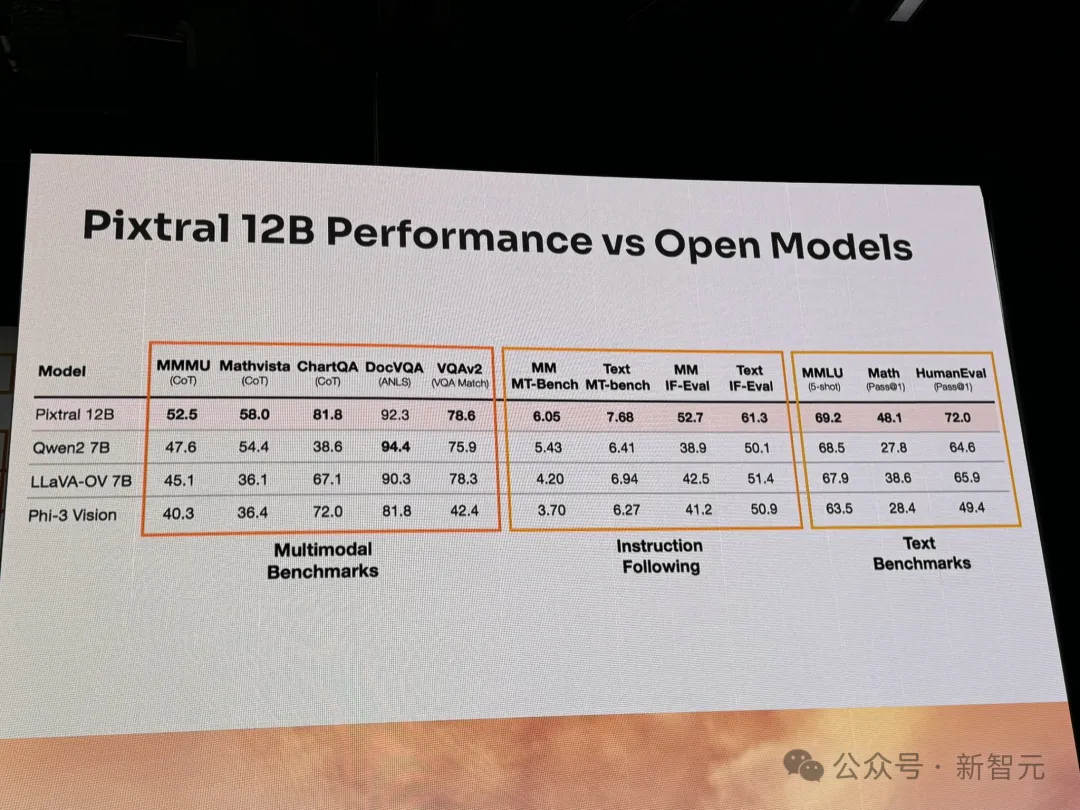

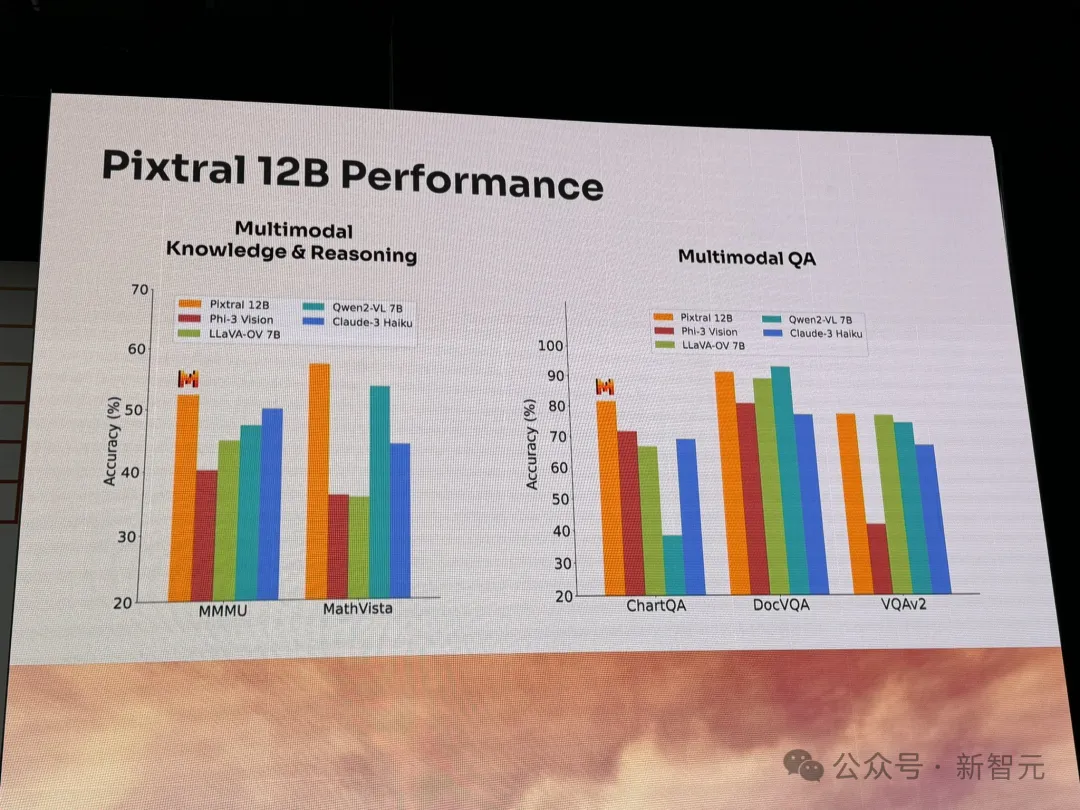

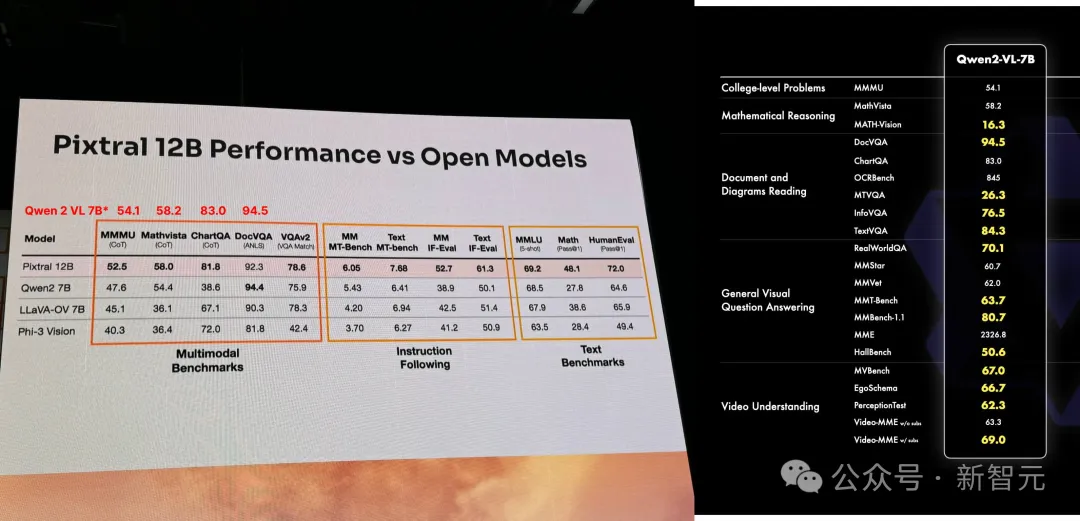

在多項基準測試(文本、指令跟隨、多模態)中,新模型性能大幅超越Qwen2 7B、Phi-3 Vision開源模型。

圖片

圖片

Hugging Face技術負責人發現此處列舉的Qwen的數據問題很大

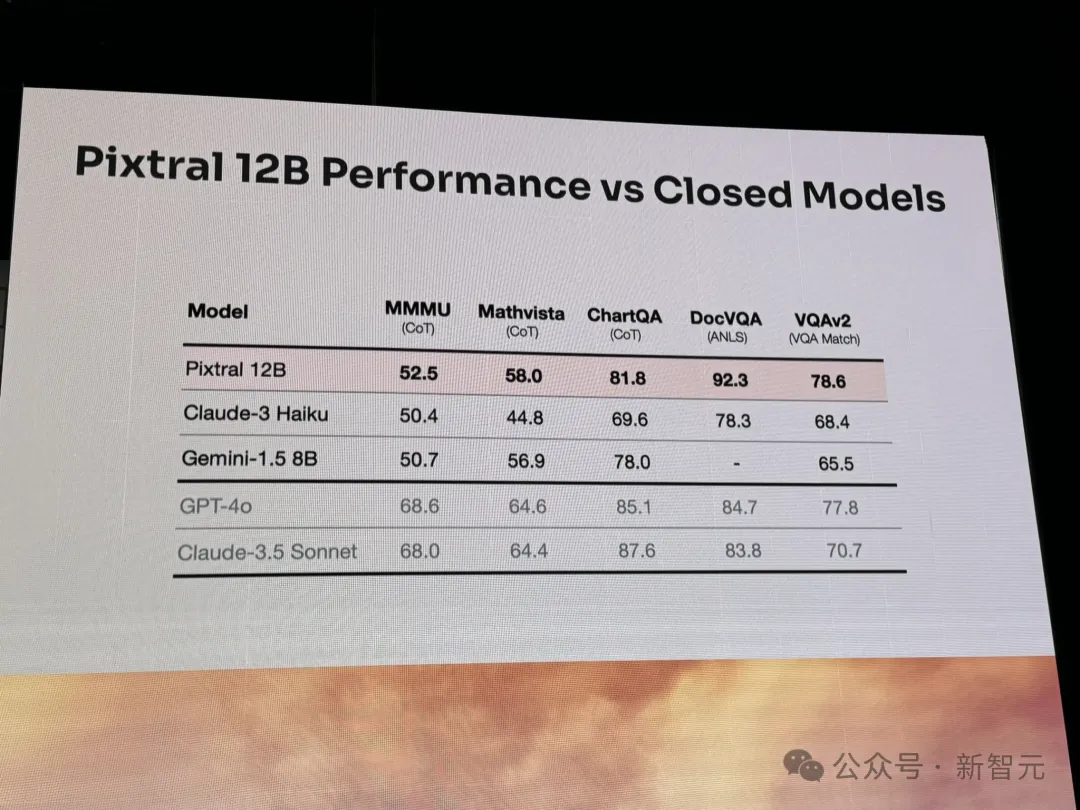

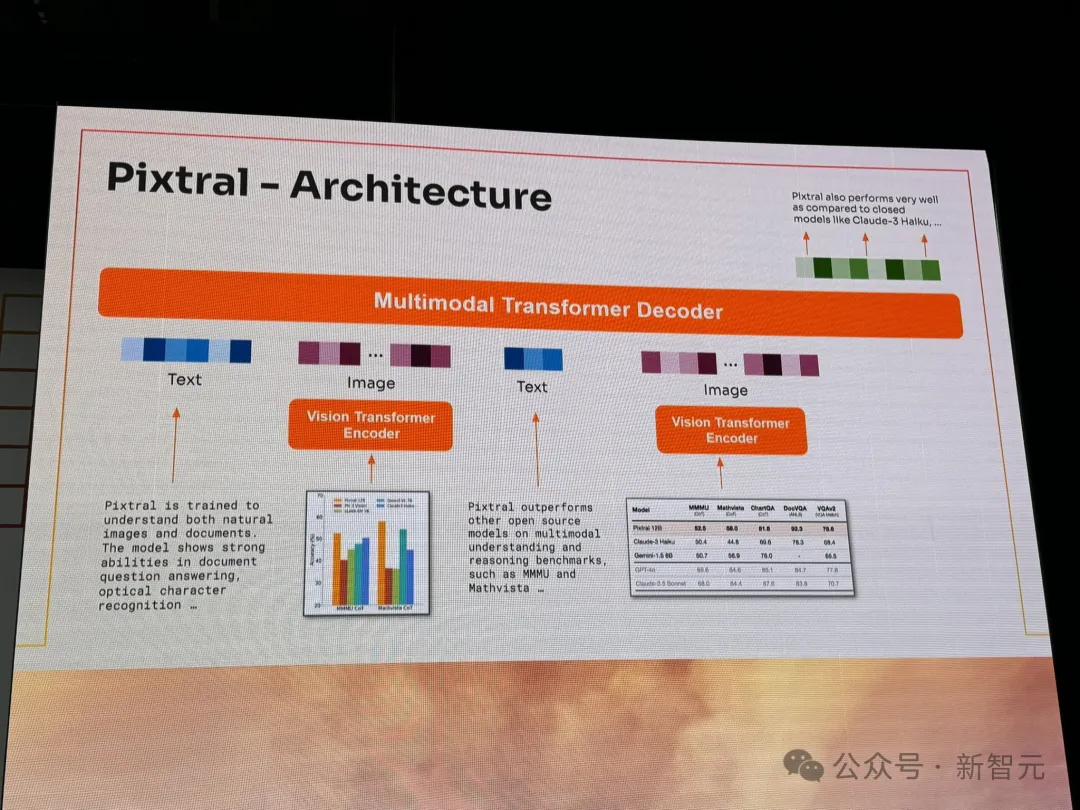

相較于閉源模型,Pixtral 12B在圖表問答、文檔問答、視覺數學推理、大學水平多學科等基準中,性能碾壓Claude3 Haiku、Gemini 1.5 8B。

圖片

圖片

除了大約24GB的磁力鏈,模型代碼還可在HuggingFace、GitHub下載。(由社區開發者上傳)

圖片

圖片

地址:https://huggingface.co/mistral-community/pixtral-12b-240910

值得一提的是,Mistral AI現場還請來了老黃坐鎮。

圖片

圖片

手繪稿直出代碼,現場Demo驚艷

Mistral AI在舊金山舉辦的首屆AI峰會上,初次展示了Pixtral 12B的多模態能力。

圖片

圖片

現場,足以用震撼形容。

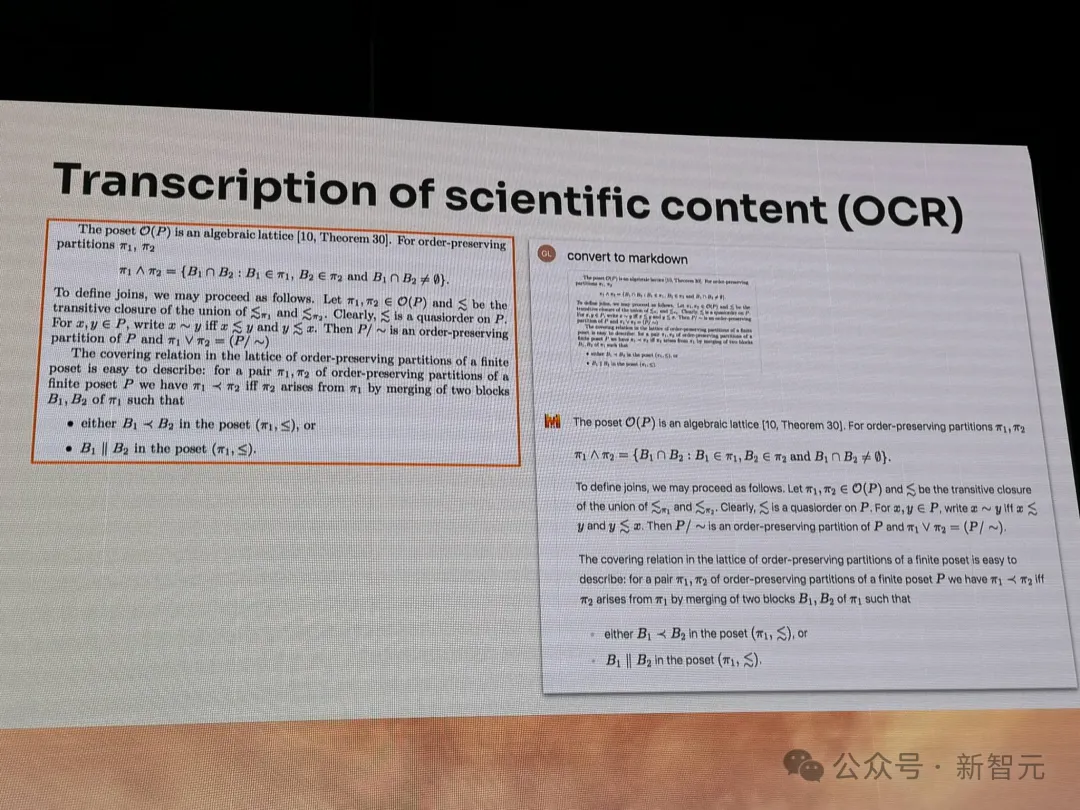

讓它將一份科學報告轉錄為Markdown格式,可以看到圖片中,包含了許多復雜的數學符號,還有公式。

Pixtral 12B通過OCR能力,精準地識別出所有的內容。

圖片

圖片

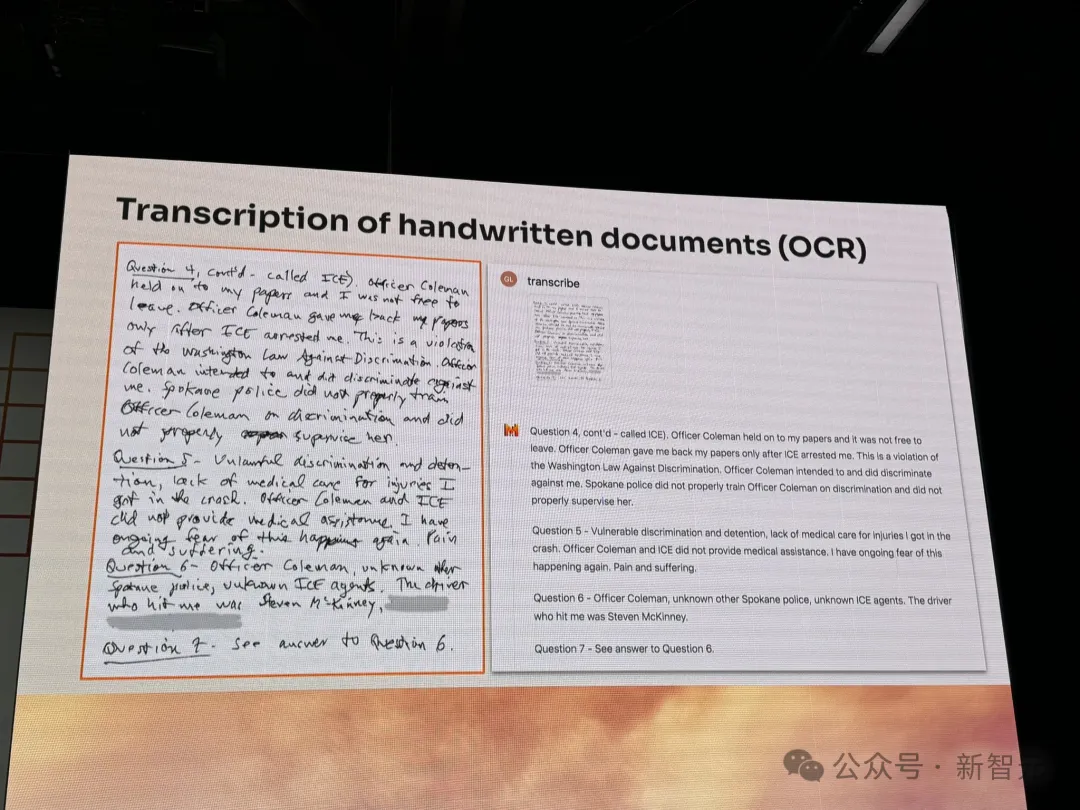

再來一個更復雜的手寫稿,別說AI了,小編也有些看不清寫的什么字。

沒想到,這也難不倒它。

圖片

圖片

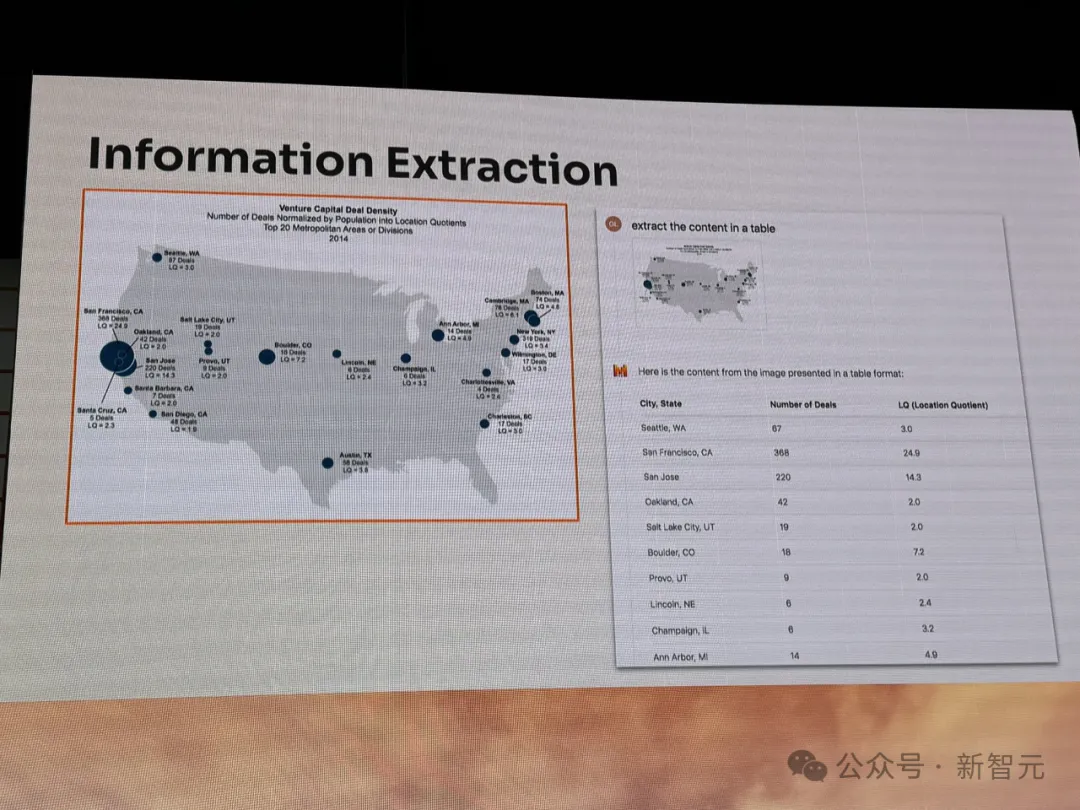

給它扔一張關于美國「風險投資交易密度分布」的圖表,并將其總結成一份表。

模型以不同州/城市,以及交易數量、區位商(LQ),列出了非常清晰的表格。

圖片

圖片

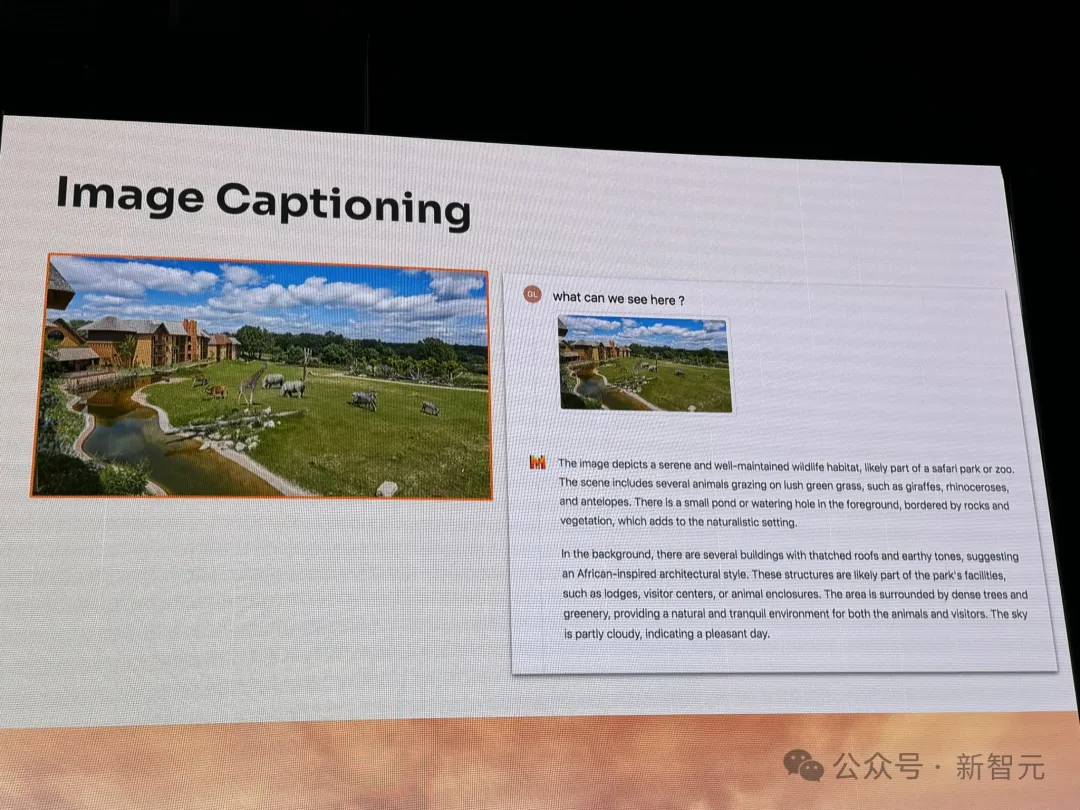

再來看看,它如何去描述一張圖像的。

上傳一張風景圖,然后詢問「我們可以從中看到什么」?

Pixtral 12B先從各種動物近景描述,再延伸到背后建筑、基礎設施,以及大樹、天空云彩等。

整個講述的過程,非常有邏輯。

圖片

圖片

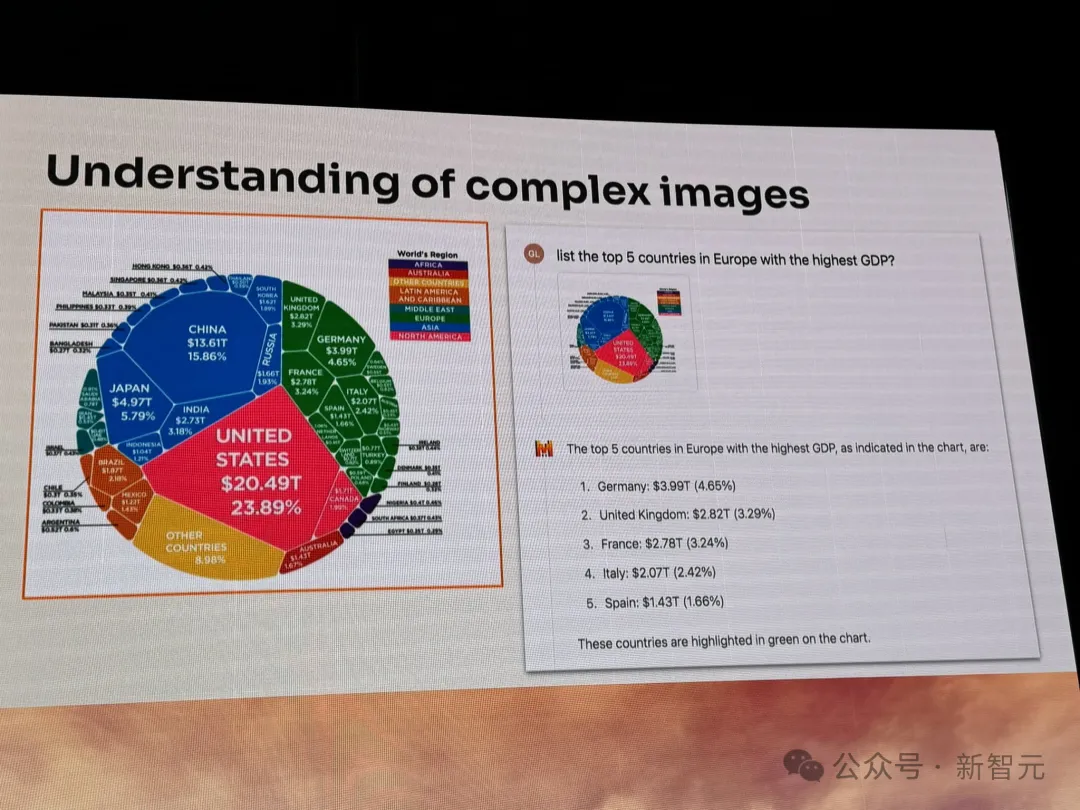

在復雜圖表方面,Pixtral 12B理解力也是一絕。

上傳一張全球不同國家GDP圖片,讓它給出歐洲中GDP最高的5個國家。

模型根據綠色歐洲區域,總結給出了相應的答案。

圖片

圖片

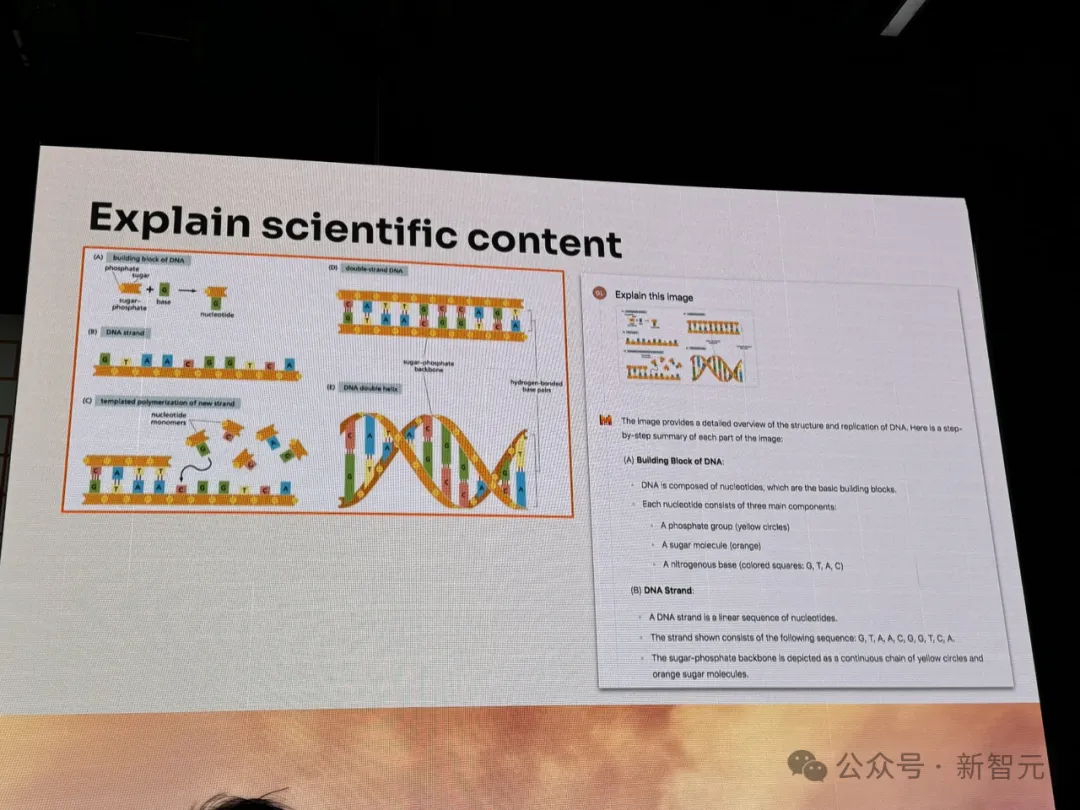

不僅如此,它還可以解釋科學報告中,圖表中DNA結構的具體含義。

圖片

圖片

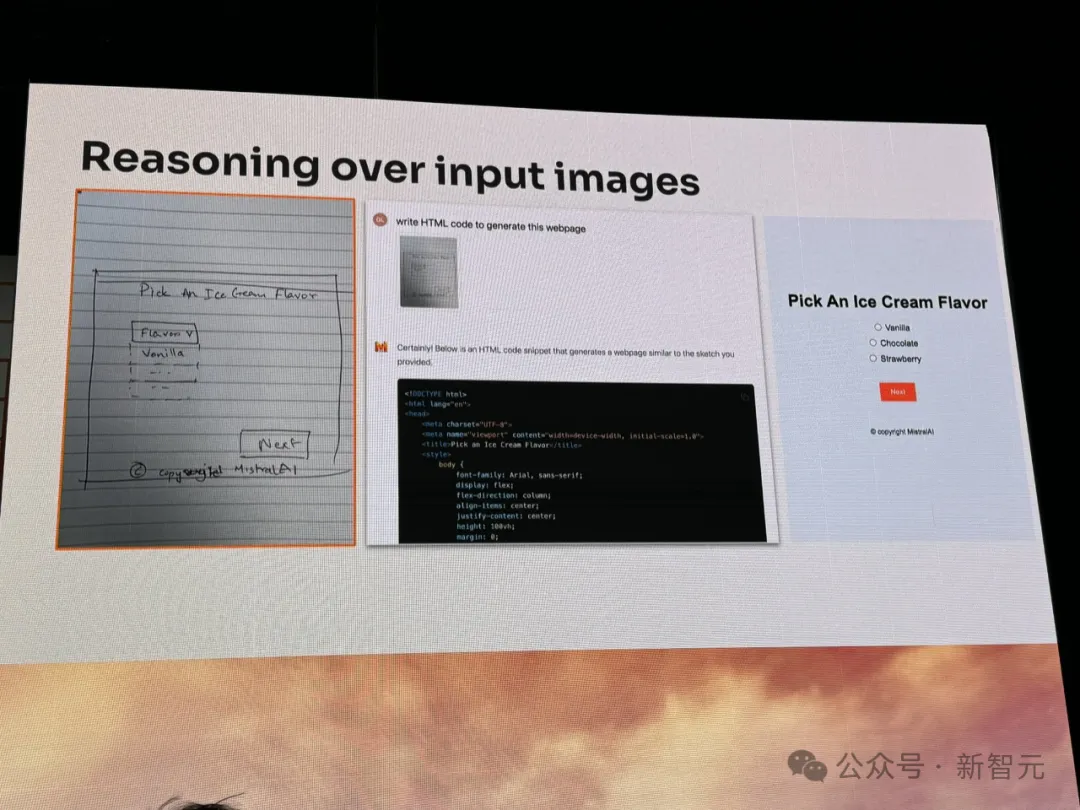

想要搭建一個網頁,手繪一張草稿,傳給模型。

它能看著圖直出代碼,一個網頁HTML的設計分分鐘就搞定了。

圖片

圖片

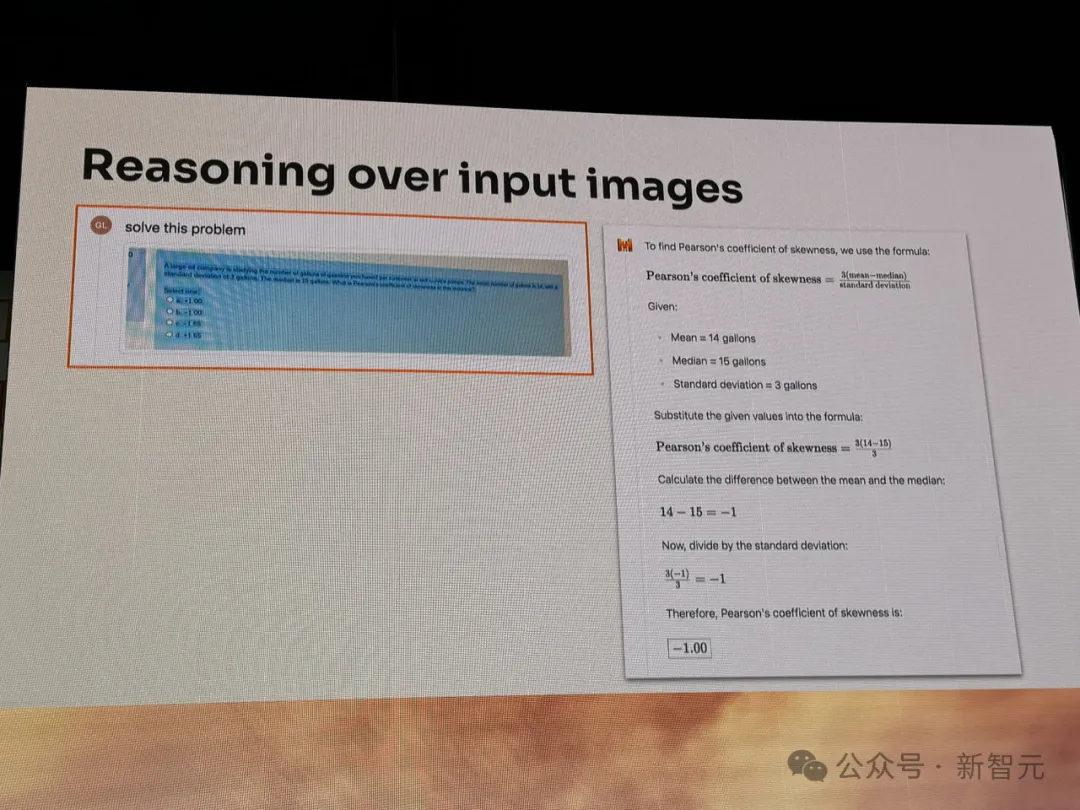

又或是,當你遇到一道數學推理難題,拍好照片上傳給Pixtral 12B,便會得到解題步驟和答案。

圖片

圖片

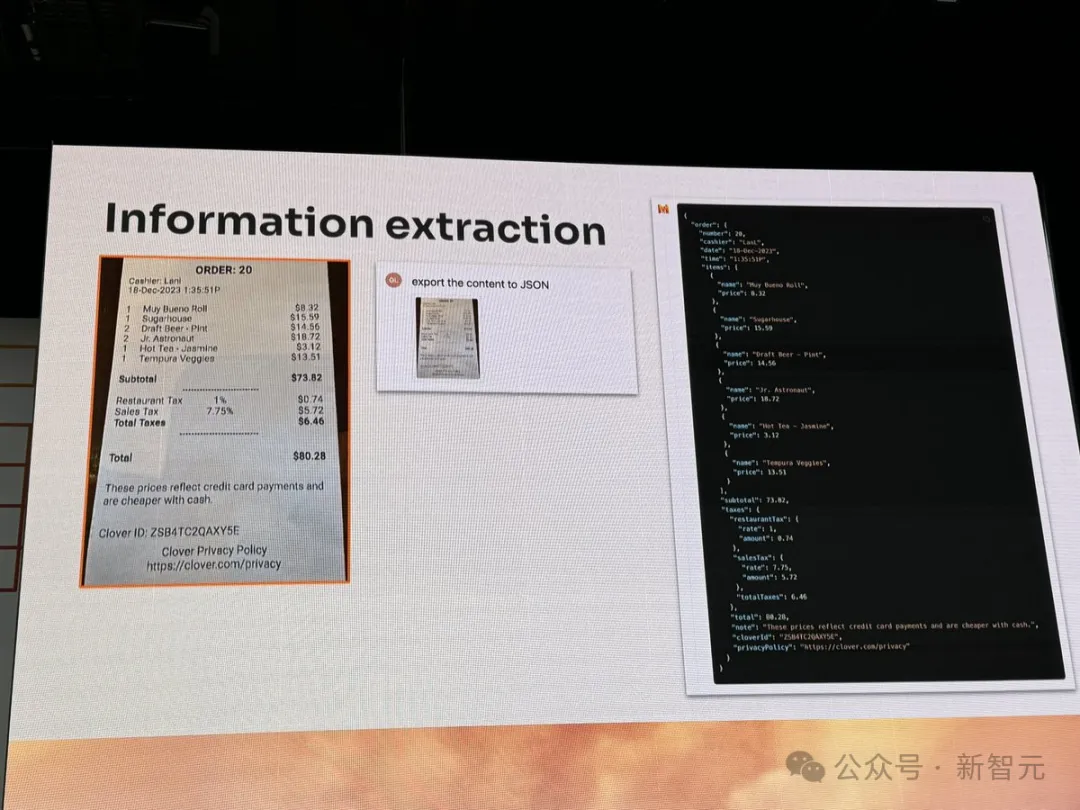

外出餐飲小票,它也可以將其中信息提取成JSON格式。

圖片

圖片

這樣一通看下來,一個120億參數的小模型,竟具備了如此強大的圖像識別、文本理解能力。

那么,它是如何訓練而來?背后架構是什么?

模型架構

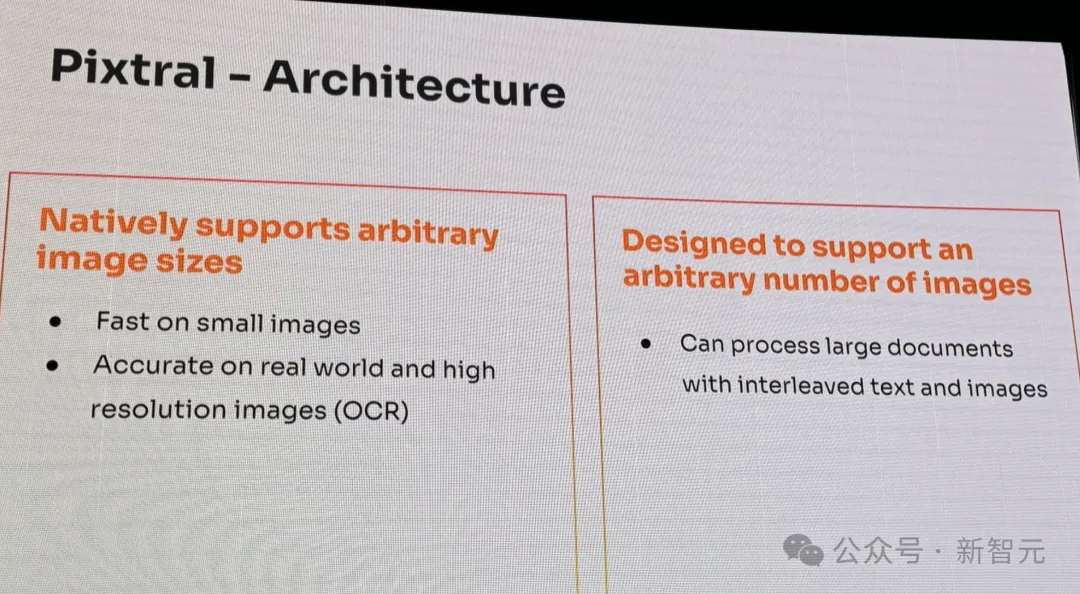

現場的介紹中,Pixtral 12B的架構如下圖所示。

它包含了一個多模態Transformer解碼器,還有視覺Transformer編碼器,能夠理解原生的圖像和文檔。

圖片

圖片

正如開頭所述,新模型是基于Nemo 12B完成搭建,關于訓練數據目前仍在保密中。

開發者關系主管Sophia Yang表示,「Pixtral 12B獨特之處在于,能夠原生支持任意數量、大小的圖像」。

圖片

圖片

它能夠快速處理小圖像,還可以精準處理真實世界和高分辨率的圖像。而且,扔出一個圖文混雜的大型文檔,也能信手拈來。

圖片

圖片

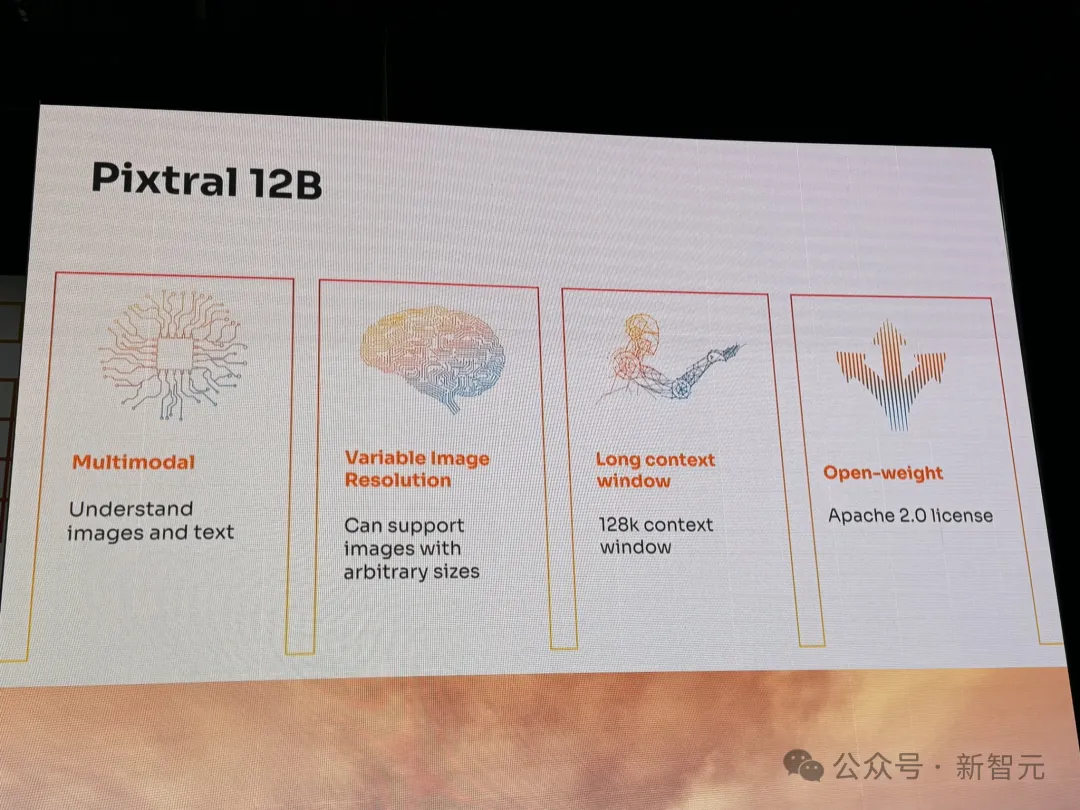

Pixtral 12B的上下文長度為128k。

圖片

圖片

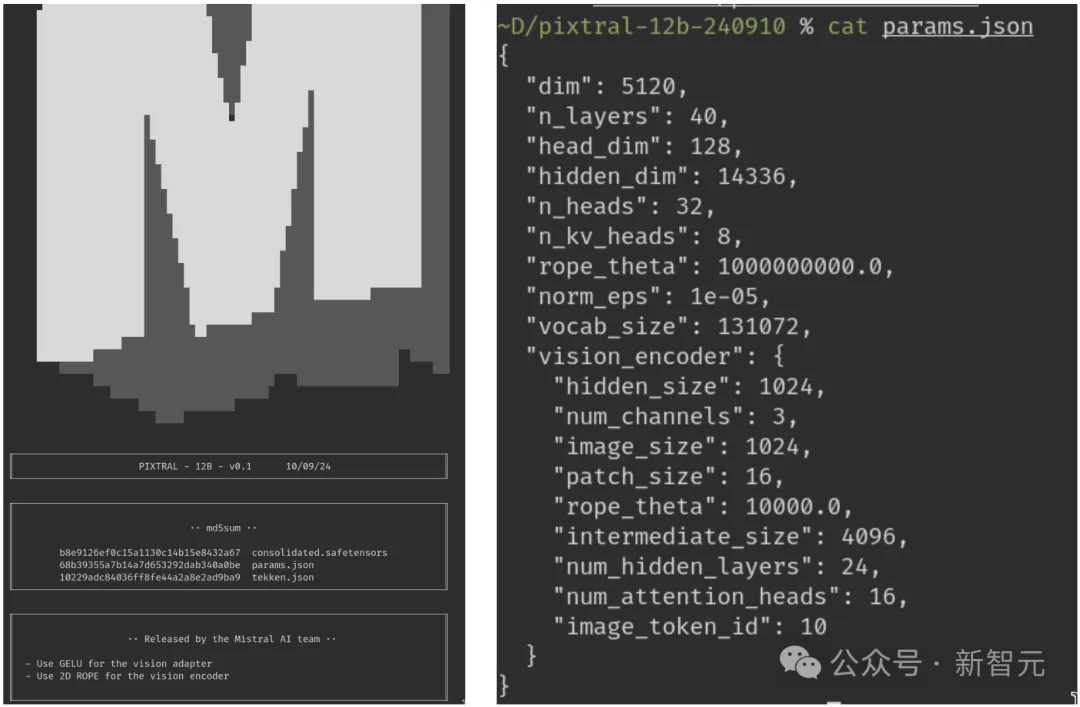

根據初始測試者的分享,這個24GB模型架構共有40層,14336個隱藏維度,32個注意力頭,用于廣泛的計算處理。

圖片

圖片

在視覺方面,它還有一個專用的視覺編碼器,可支持1024×1024圖像分辨率,以及24個隱藏層用于高級圖像處理。

圖片

圖片

然而,當Mistral最終通過API提供該模型時,可能會有所改變。

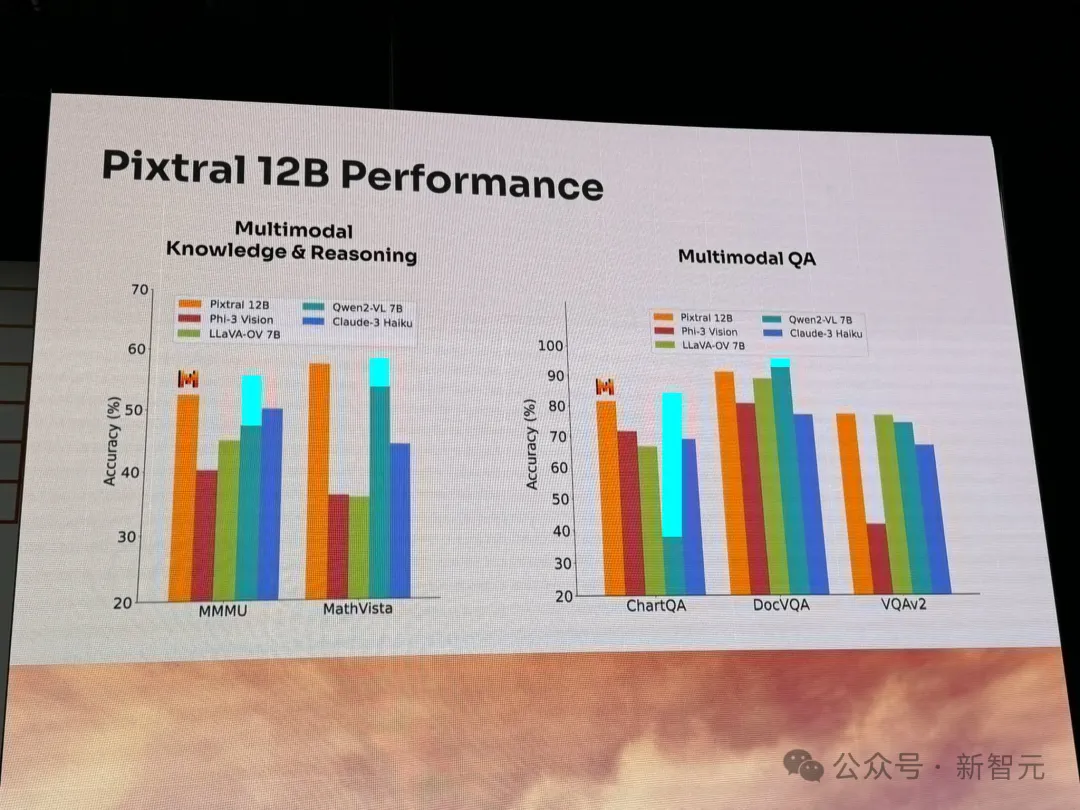

就性能來說,Pixtral 12B在多模態知識和推理基準(MMMU、MathVista)、多模態問答基準(ChatQA、DocVQA、VQAv2)上,完全碾壓當前領先的同等參數的模型。

比如,Qwen2-VL、LLaVA-OV、Phi-3 Vision等。

圖片

圖片

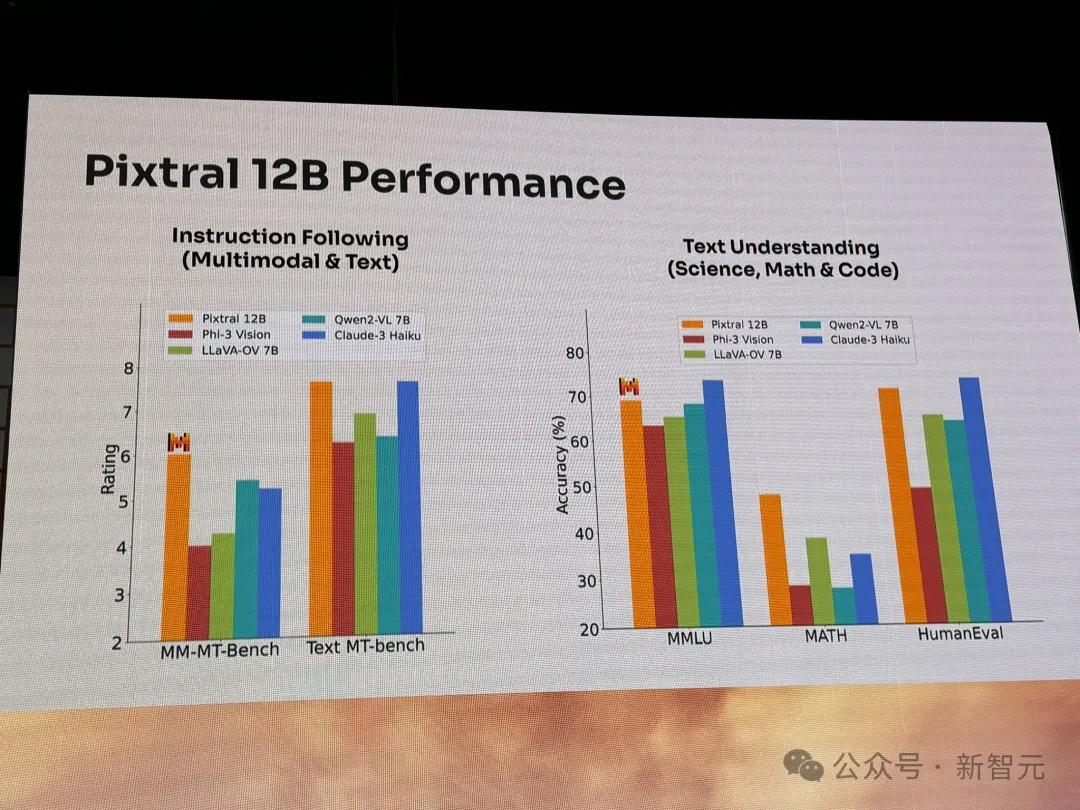

而在指令跟隨(多模態、文本)、文本理解(科學、數學、代碼)基準上,Pixtral 12B表現也非常出色。

圖片

圖片

或許多模態模型對于我們來說,屢見不鮮,但Pixtral 12B對于Mistral來說是開創歷史。

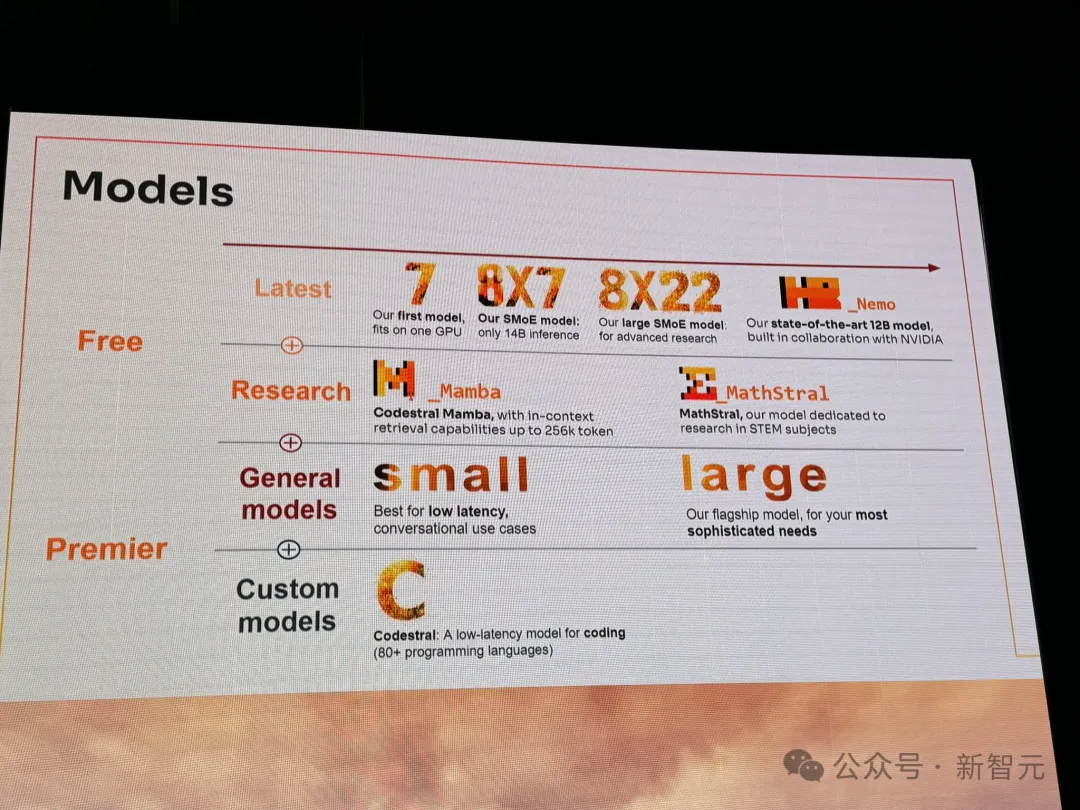

自去年成立以來,Mistral憑借開源媲美OpenAI等領先實驗室大模型,一路走紅得到AI社區的認可。

圖片

圖片

幾個月前,它以60億美金估值,完成6.4億美元新一輪融資,并隨之推出了一款GPT-4級別的模型——Mistral Large 2。

此外,他們在今年,還推出了一個專家混合模型Mixtral 8x22B,包含了一個編碼模型Codestral,以及一個數學推理和科學發現的模型。

圖片

圖片

Mistral或許有實力,成為下一個OpenAI。

穿上皮夾克,和老黃爐邊談話

更讓人驚喜的是,大會現場,還上演了經典「皮夾克幫」集結的一幕。

創始人Arthur Mensch穿上皮夾克和老黃坐在臺前,開啟了爐邊談話,一起探討了未來AI和算力問題。

圖片

圖片

老黃表示,在英偉達,GPU的設計、性能、耗能等方面問題,仍將持續優化。

他們希望利用AI先去探索巨大設計空間的可能性,然后再進行收縮,最終專注于有前景的解決方案。

老黃還認為:推理在今天是一次性的,但在未來不會是這樣。為了實現這一點,還需把推理速度提高到一個數量級。

因為,利用GPU做推理面臨著顯著的困難,英偉達90%的工程師都投在了推理,而非訓練中。

當然,英偉達對推理技術架構的探索,仍在繼續。老黃希望NVLink能夠實現低延遲高吞吐量的推理設計。

對于AI未來的探索,老黃表示自己最喜歡的AI應用,便是創建數字人。

他希望,未來公司會有數百萬個智能體數字員工,可以自主相互交流,運營業務。

此外,他還討論了英偉達在「類人機器人」領域的大量工作。

而它的發展,受到了老黃所言的「3臺計算機問題」的瓶頸制約——

第一臺用于訓練多模態模型,第二臺用于精確物理模擬和生成合成數據(NVIDIA Omniverse),第三臺是機器人體內的計算機(即將推出的NVIDIA Thor)。

最后,老黃還回顧了英偉達歷史,「在1993年成立之時,我們在GPU領域還沒有競爭對手,到1994年有10個,1995年有50個,然后有100個,競爭對手迅速增加」。

在競爭這么激烈領域中,英偉達能夠有所成,一定程度上,可以歸咎于你所做的事情與做這些事情的原因不同。

英偉達是PC游戲行業的最大推動者,他們通過創建計算平臺、生態系統來創造一個新市場,使之成為「家庭的一部分」。

他們最先在游戲領域做到了這一點,然后是科學計算,現在是AI。

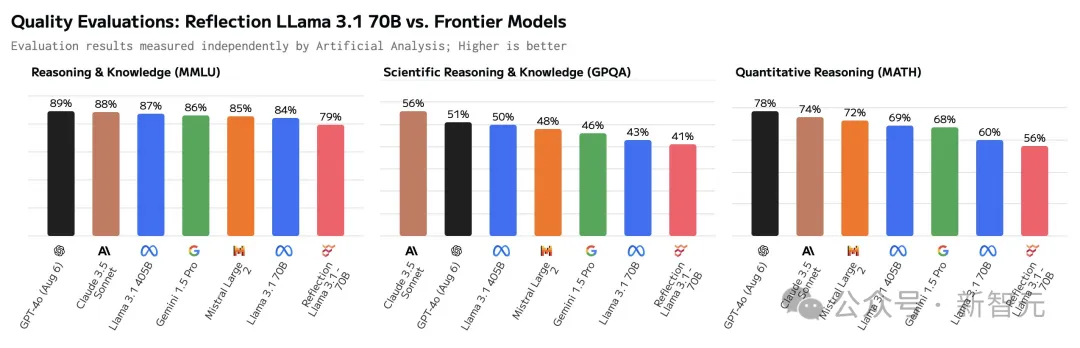

大佬發現「華點」:又來一個評測造假的?

前兩天,所謂的「開源新王」Reflection 70B才剛剛深陷Benchmark造假爭議。

如今,相似的劇情再次上演。

圖片

圖片

隨著峰會現場的照片大范圍流出,Hugging Face技術負責人Philipp Schmid也在第一時間發現,Mistral AI放出的跑分和Qwen 2 VL 7B的官方數據大相徑庭。

圖片

圖片

把數據補全到柱狀圖中后可以看道,Pixtral 12B在多項評測中的成績都明顯不如Qwen 2 VL 7B。

圖片

圖片

也就是說,Mistral AI的首個多模態模型,被一個參數量小了近42%的模型,吊打了!

圖片

圖片

此外,還有網友指出,別說數據有問題,他們連模型的名字好像都沒寫對……

圖片

圖片

參考資料:

https://venturebeat.com/ai/pixtral-12b-is-here-mistral-releases-its-first-ever-multimodal-ai-model/