多模態(tài)競(jìng)技場(chǎng)對(duì)標(biāo)90B Llama 3.2!Pixtral 12B技術(shù)報(bào)告全公開

作為歐洲的OpenAI,Mistral最近壓力不小。

端側(cè)小模型端不出來(lái),對(duì)比評(píng)測(cè)的結(jié)果又遭到質(zhì)疑。

上個(gè)月震撼登場(chǎng)的自家首款多模態(tài)大模型Pixtral 12B,也疑似遇到了成績(jī)不如人的窘境。

不過(guò)世間紛擾,留待時(shí)間之中去見分曉。

畢竟Mistral AI當(dāng)年也是以開源極客之姿殺入江湖的,以后的以后,圈內(nèi)人總會(huì)想起有個(gè)一言不合就甩出磁力鏈的公司吧。

按照慣例,在9月份甩出多模態(tài)Pixtral 12B的開源鏈接之后,Mistral會(huì)在一段時(shí)間后放出技術(shù)報(bào)告。

我們來(lái)看一下Mistral家的第一個(gè)MMLM有什么新花樣。

論文地址:https://arxiv.org/abs/2410.07073

開源代碼:https://github.com/mistralai

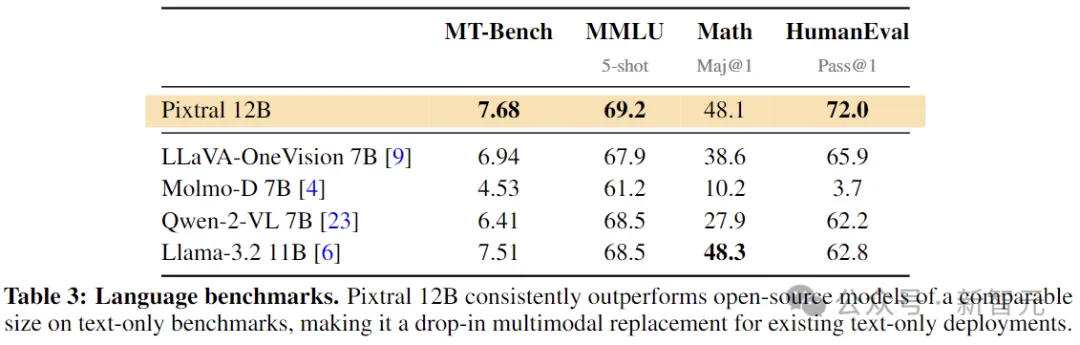

首先,許多開源模型一般有個(gè)問(wèn)題,就是為了多模態(tài)的性能而犧牲了本身的自然語(yǔ)言性能,之前英偉達(dá)的NVLM 1.0也談到了這點(diǎn)。

Pixtral本次也是成功避開了這個(gè)缺陷,單單比較文本模型的性能,也在同等尺寸的模型中居于前列。

另一點(diǎn)與大多數(shù)模型不同的是,Pixtral選擇從頭開始訓(xùn)練了一個(gè)全新的視覺編碼器。

基于此,Pixtral 12B輸入圖片的分辨率和長(zhǎng)寬比不受任何限制,并且在128K的上下文窗口范圍內(nèi),想放多少?gòu)垐D片都行!

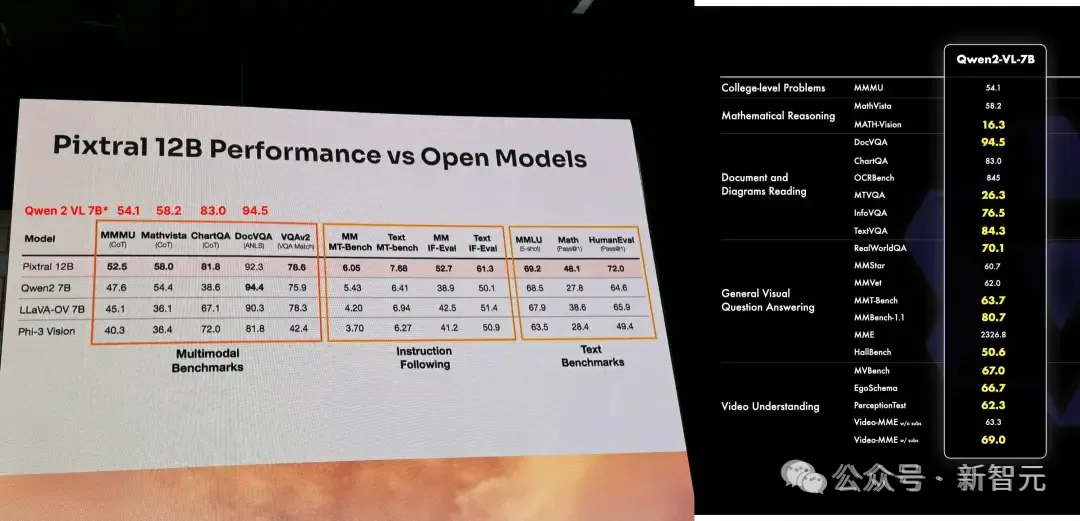

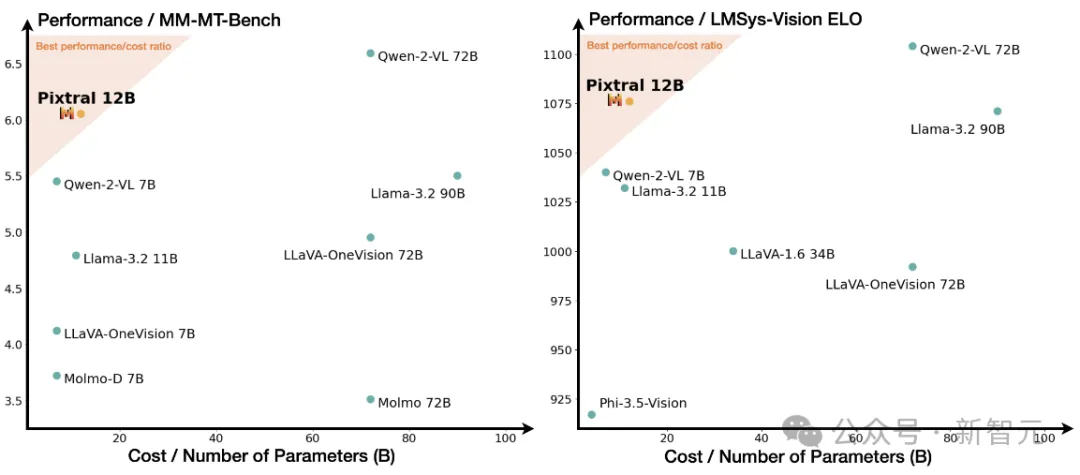

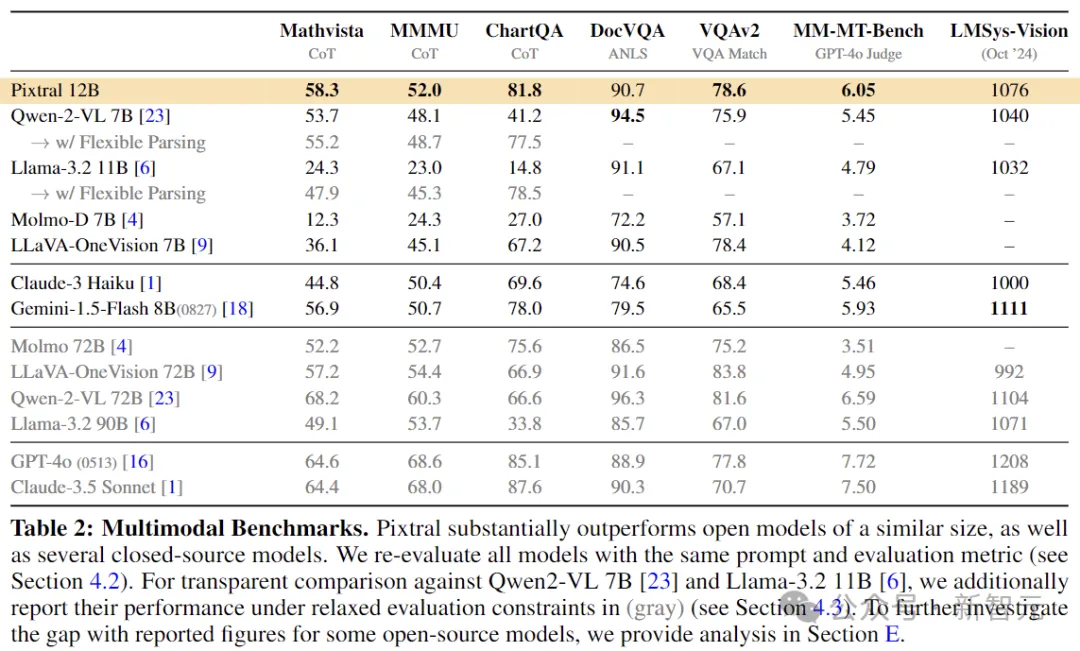

從論文的測(cè)試結(jié)果來(lái)看,Pixtral 12B明顯優(yōu)于其他類似大小的開源模型(比如Llama-3.2 11B和Qwen-2-VL 7B),

甚至在一些評(píng)測(cè)中,表現(xiàn)比Meta家的多模態(tài)老大哥Llama-3.2 90B還要好。

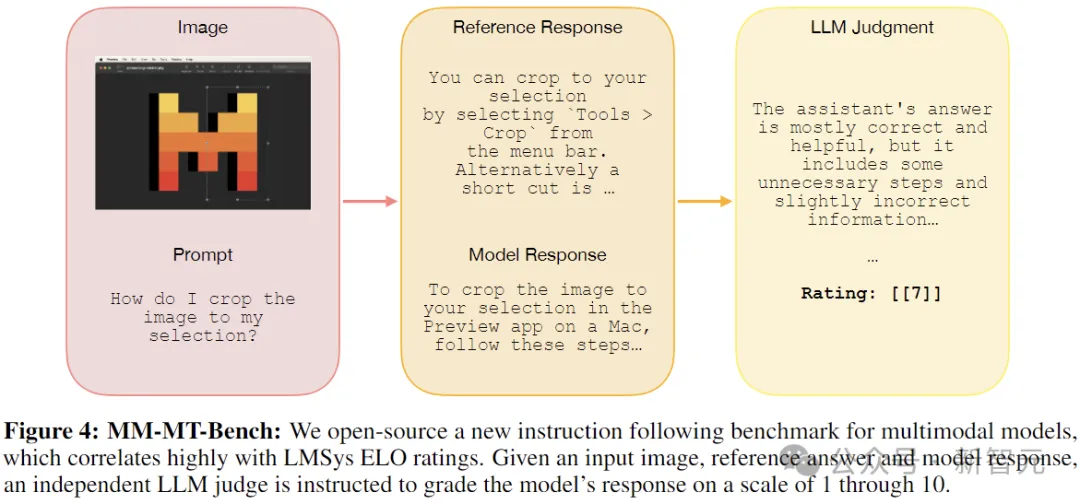

最后,與開源模型一起,Mistral還貢獻(xiàn)了一個(gè)開源基準(zhǔn)測(cè)試MM-MT-Bench,用于在實(shí)際場(chǎng)景中評(píng)估視覺語(yǔ)言模型。

技術(shù)細(xì)節(jié)

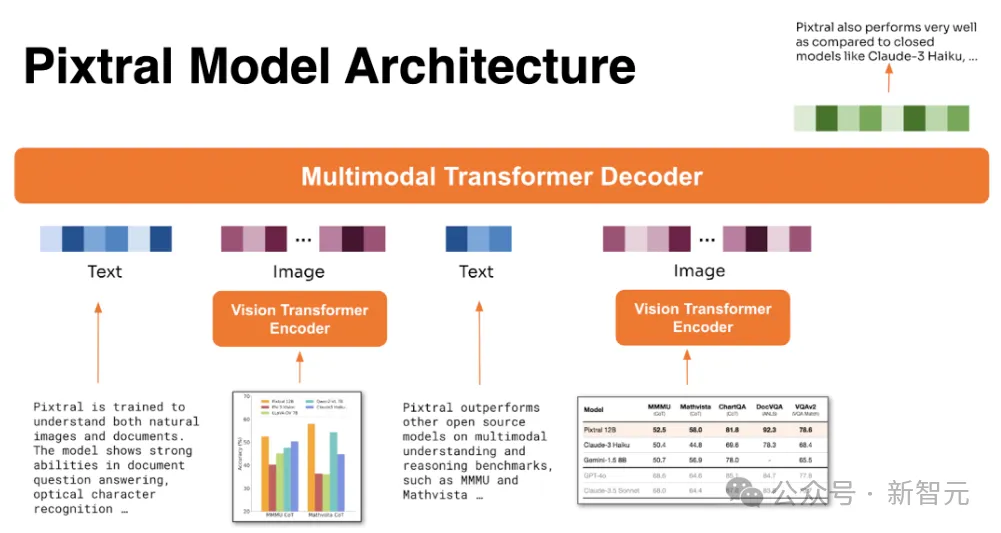

當(dāng)前的多模態(tài)大模型基本上都是:模態(tài)編碼器 + 投影模塊 + 大語(yǔ)言模型主干。

如果需要多模態(tài)輸出,后面還會(huì)對(duì)稱地拼接投影層和各種解碼器。

所以,在模型結(jié)構(gòu)方面,我們可以分部分來(lái)看Pixtral都做了哪些工作。

模型結(jié)構(gòu)

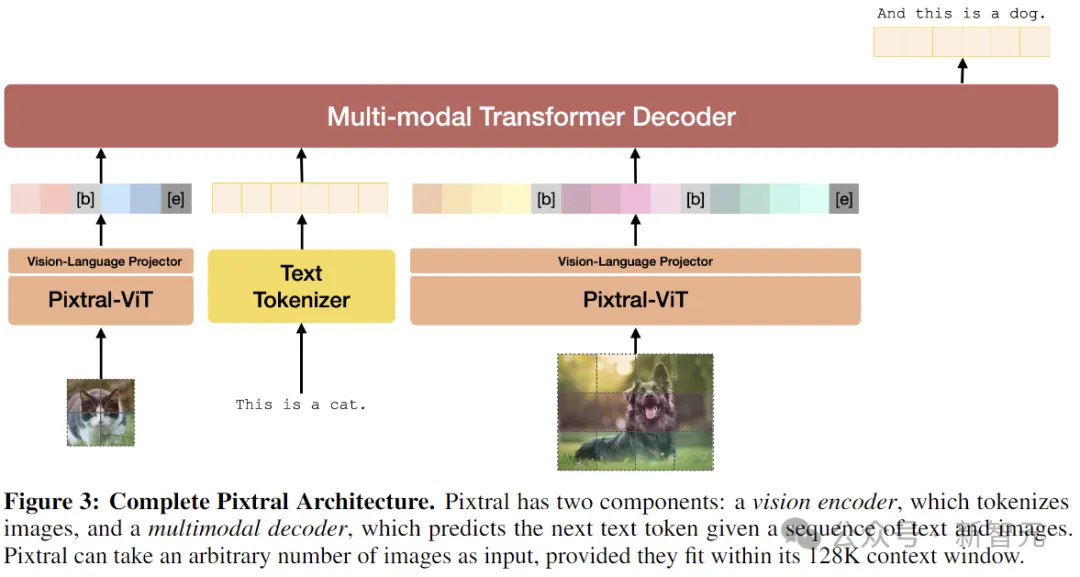

Pixtral 12B整體為Transformer架構(gòu),在大規(guī)模交錯(cuò)圖像和文本文檔上進(jìn)行了預(yù)訓(xùn)練,具備多輪、多圖像對(duì)話的能力。

多模態(tài)解碼器

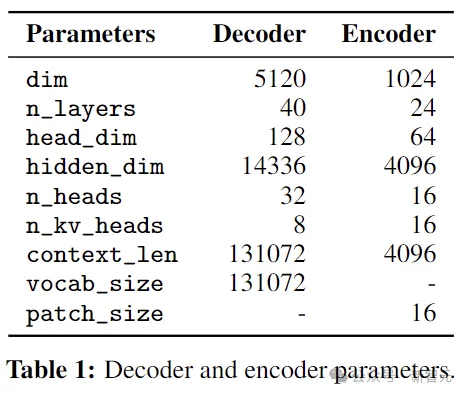

Pixtral的大語(yǔ)言模型主干選擇了自家的Mistral Nemo 12B,decoder-only架構(gòu)。

內(nèi)部維度14336,層數(shù)40,32個(gè)頭分為4組(GQA),詞表大小131072。

視覺編碼器

視覺編碼器部分是隨Pixtral 12B一起新鮮出爐的PixtralViT。

顧名思義,采用ViT架構(gòu)打底,4億參數(shù)量。同時(shí)為了能夠處理各種分辨率和縱橫比的圖像,作者對(duì)標(biāo)準(zhǔn)架構(gòu)進(jìn)行了四項(xiàng)關(guān)鍵更改:

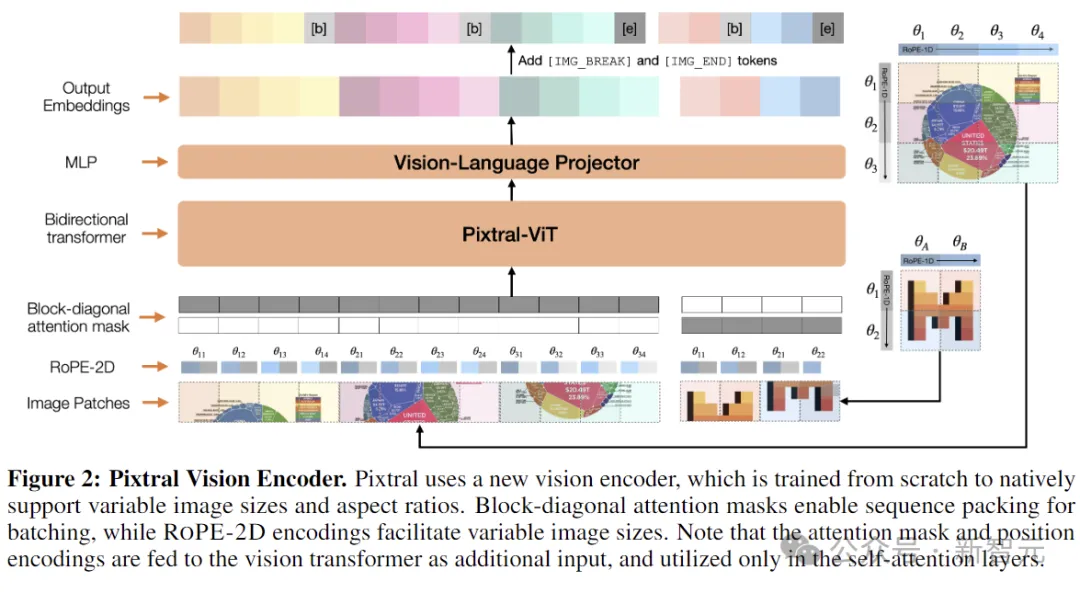

Break tokens:為了幫助模型區(qū)分具有相同patch數(shù)量(相同區(qū)域)但縱橫比不同的圖像,需要在圖像行之間加入[IMAGE BREAK],在圖像序列的末尾加上[IMAGE END]。

FFN中的門控:在隱藏層中使用門控,而非注意力塊中的標(biāo)準(zhǔn)前饋層。

序列打包:為了在單個(gè)批次中有效地處理圖像,作者沿序列維度將圖像展平并連接起來(lái),并構(gòu)建了一個(gè)塊對(duì)角掩碼,以確保來(lái)自不同圖像的patch之間沒有注意力泄漏。

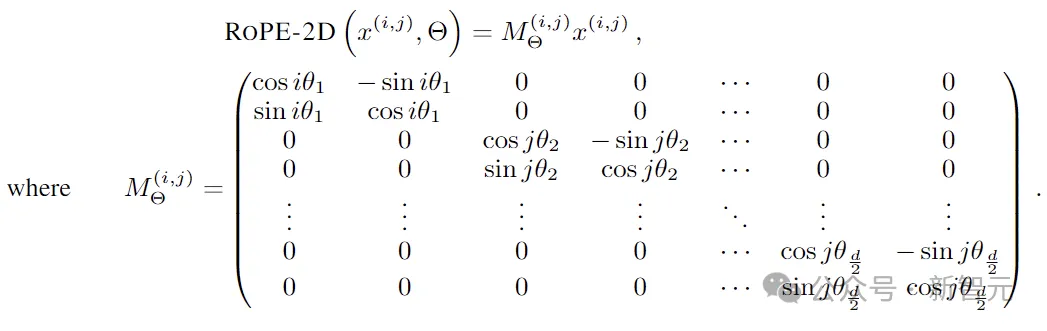

RoPE-2D:在自注意層中用相對(duì)旋轉(zhuǎn)位置編碼代替?zhèn)鹘y(tǒng)的絕對(duì)位置嵌入。雖然必須對(duì)學(xué)習(xí)到的位置嵌入進(jìn)行插值以處理新的圖像大小(通常以犧牲性能為代價(jià)),但相對(duì)位置編碼自然而然地適合可變的圖像大小。

RoPE-2D的變換可以表示為:

這樣的設(shè)計(jì)可以自然地以原始縱橫比適應(yīng)高分辨率和低分辨率圖像,從而顯著提高多模態(tài)任務(wù)的性能。

相比之下,傳統(tǒng)的編碼器一般就是針對(duì)ImageNet訓(xùn)練的,分辨率為224 × 224或336 × 336。

當(dāng)應(yīng)用到多模態(tài)語(yǔ)言模型(需要靈活執(zhí)行標(biāo)準(zhǔn)分類任務(wù),或者光學(xué)字符識(shí)別等任務(wù))時(shí),通常會(huì)將圖像分解成更小的方塊,然后再獨(dú)立地將圖塊饋送到視覺編碼器。

完整架構(gòu)

Pixtral的視覺編碼器通過(guò)兩層全連接網(wǎng)絡(luò)連接到多模態(tài)解碼器(LLM)。MLP層維度不變,用于將視覺編碼器的輸出轉(zhuǎn)換為解碼器所需的輸入嵌入大小,激活函數(shù)為GeLU。

多模態(tài)解碼器對(duì)圖像token的處理方式與文本token相同,包括所有token的RoPE-1D位置編碼。解碼器使用了因果自注意力機(jī)制,能夠平滑地促進(jìn)多圖像對(duì)話等能力。

MM-MT-Bench

大多數(shù)現(xiàn)有的多模態(tài)基準(zhǔn)測(cè)試,衡量的是模型在給定輸入圖像的情況下執(zhí)行某種形式的多項(xiàng)選擇問(wèn)答的能力。

這種能力有用,但還不夠。

大模型說(shuō)到底是給人用的,比如有多模態(tài)能力的小助手或者聊天機(jī)器人。

在純文本領(lǐng)域,MT-Bench可以很好衡量這種性能,它采用獨(dú)立LLM裁判根據(jù)參考答案對(duì)模型的輸出進(jìn)行評(píng)分。

本文中,研究人員構(gòu)建并發(fā)布了一個(gè)名為多模態(tài)MT-Bench(MM-MT-Bench)的新基準(zhǔn)測(cè)試,風(fēng)格與純文本的MT-Bench類似,以評(píng)估指令調(diào)整的多模態(tài)模型的性能。

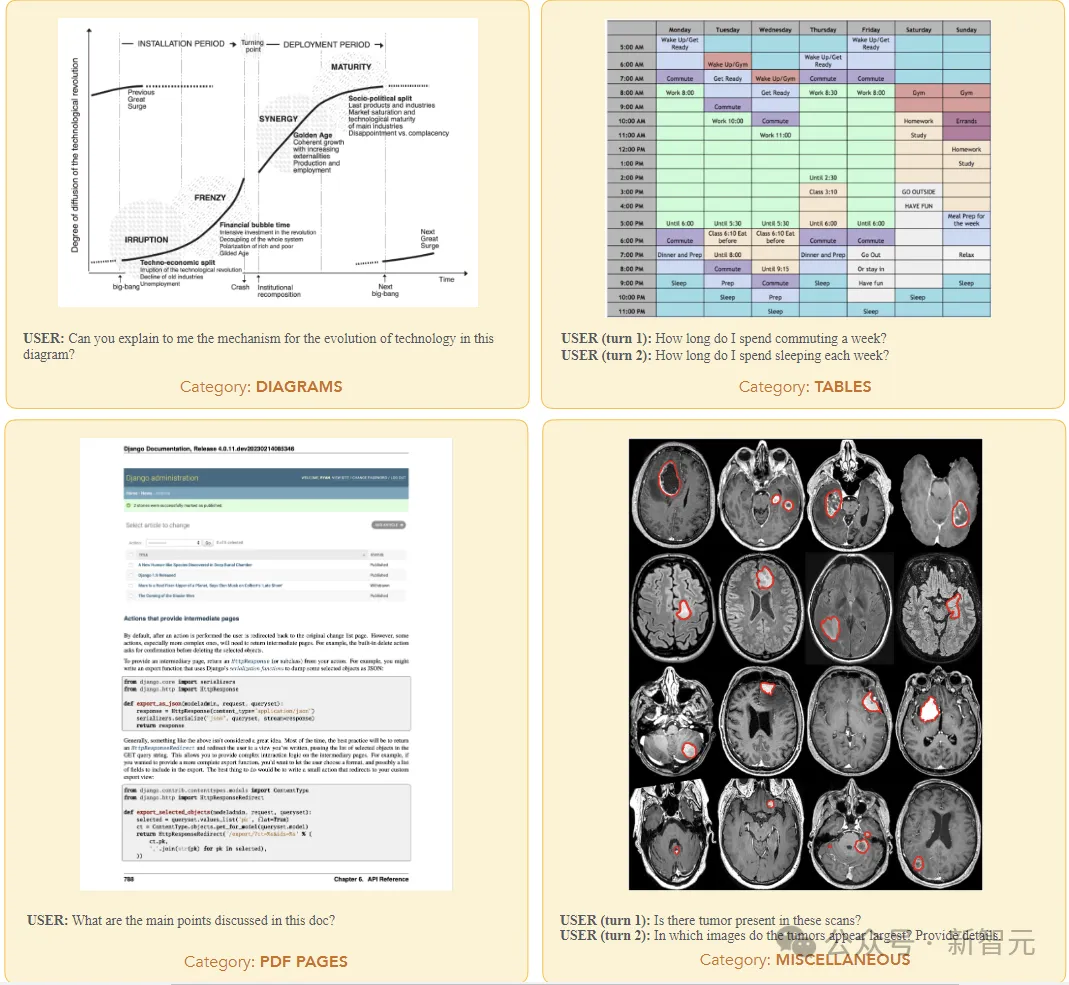

MM-MT-Bench總共包含92個(gè)對(duì)話(單回合對(duì)話69個(gè),2回合對(duì)話18個(gè),3回合對(duì)話4個(gè),4回合對(duì)話1個(gè)),涵蓋了廣泛的實(shí)際使用案例,包括五類圖像:圖表、表格、PDF頁(yè)面 、示意圖和雜項(xiàng)。

為了評(píng)估模型,研究人員在對(duì)話的所有輪次中并行查詢模型,為過(guò)去的輪次提供參考答案作為歷史記錄。裁判會(huì)獨(dú)立對(duì)每個(gè)回合進(jìn)行評(píng)分,并提供整個(gè)對(duì)話歷史記錄。

評(píng)分依據(jù)正確性(提取的信息是否正確)和完整性(標(biāo)準(zhǔn)答案是否涵蓋了參考文獻(xiàn)中提出的所有要點(diǎn))以1到10的等級(jí)為對(duì)話進(jìn)行評(píng)分。

MM-MT-Bench旨在模擬視覺語(yǔ)言模型的實(shí)際使用,用于提取、總結(jié)和推理圖像內(nèi)容。

作者手動(dòng)整理了圖像、提示和答案,并驗(yàn)證了標(biāo)簽編寫者的答案,確保所有提示都需要參考圖像輸入才能正確回答。

實(shí)驗(yàn)測(cè)試結(jié)果表明,MM-MT-Bench的性能與LMSys Vision排行榜上的ELO排名高度相關(guān)。

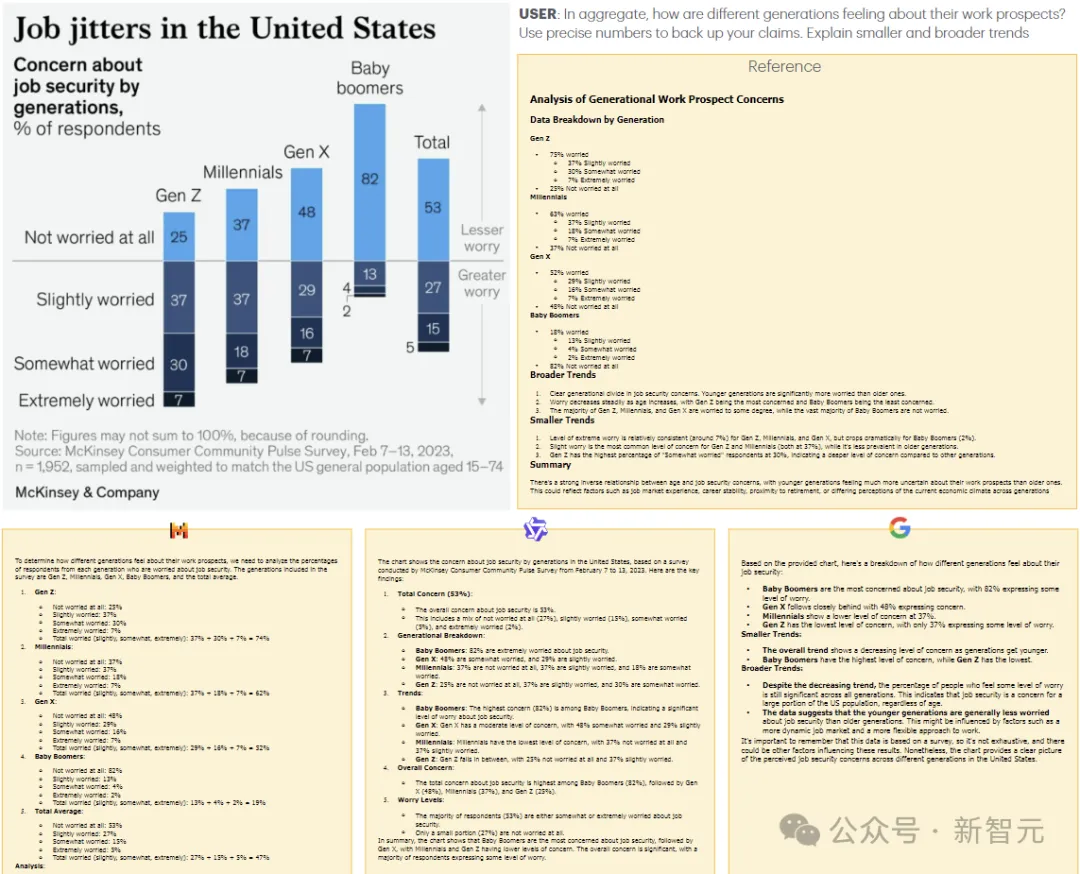

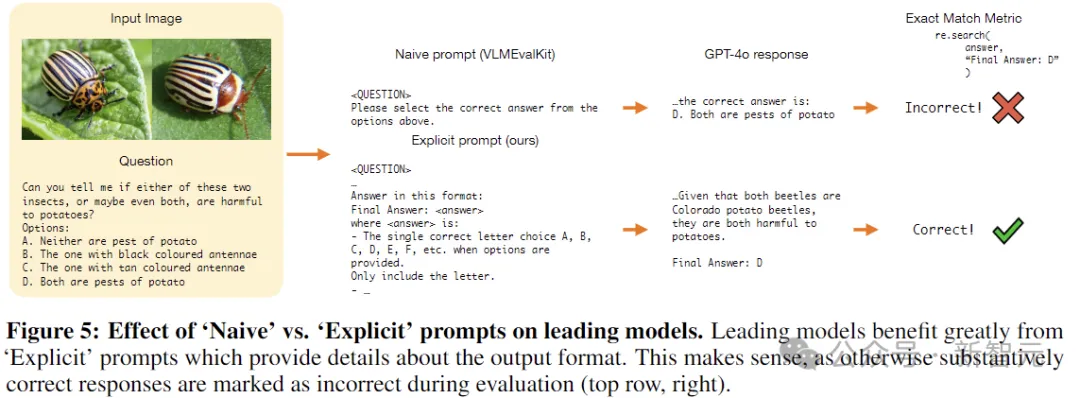

實(shí)驗(yàn)結(jié)果

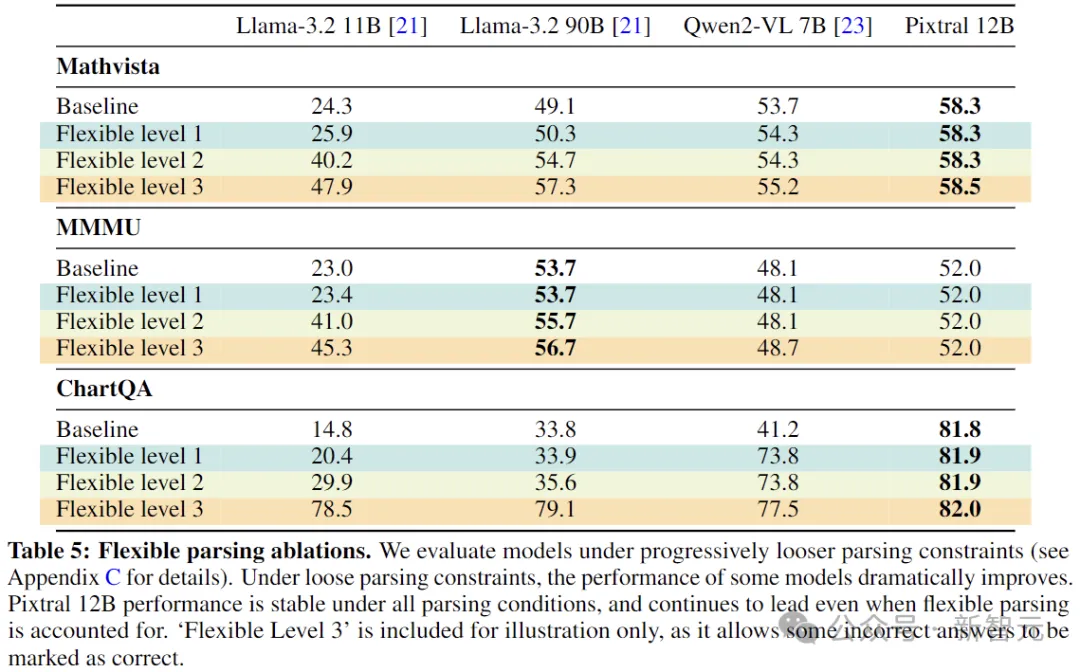

在評(píng)估Pixtral和基線的過(guò)程中,作者發(fā)現(xiàn)多模態(tài)模型的評(píng)估協(xié)議沒有標(biāo)準(zhǔn)化,設(shè)置中的微小變化可能會(huì)極大地改變某些模型的性能(比如要求模型生成與參考答案完全匹配時(shí),6.0和6就可能是不同的)。

為了緩解這個(gè)問(wèn)題,作者建議使用「Explicit」提示來(lái)明確指定參考答案所需的格式。

多模態(tài)性能

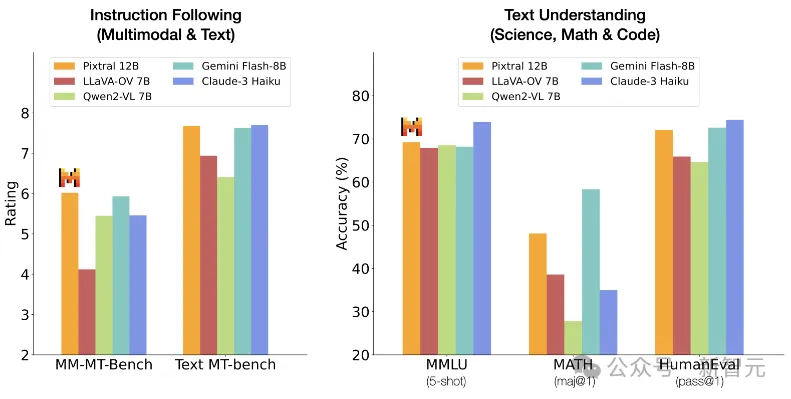

上表顯示,在多模態(tài)基準(zhǔn)測(cè)試中,Pixtral的性能大大優(yōu)于所有同尺寸的開源模型,以及Claude-3 Haiku和Gemini-1.5 Flash 8B等閉源模型。

值得注意的是,Pixtral在針對(duì)實(shí)際用例的MM-MT-Bench上的表現(xiàn)優(yōu)于所有同等尺寸的模型,而在LMSys Vision排行榜上,Pixtral 12B的性能接近最大的開源模型,Qwen2-VL 72B和Llama-3.2 90B。

不過(guò),由于「Explicit」提示的原因,一些開源模型的性能遠(yuǎn)低于其報(bào)告的數(shù)字,這主要是由于模型沒有遵循答案格式說(shuō)明(例如,生成「The answer is 6.」而不是「Final answer:6」)。

為了與這些模型進(jìn)行透明的比較,下面使用更寬松的指標(biāo)進(jìn)一步評(píng)估。

語(yǔ)言性能

上表展示了在常見的純文本基準(zhǔn)測(cè)試(使用常見的提示和評(píng)估協(xié)議)中,Pixtral 12B與同等大小開源模型的比較結(jié)果。Pixtral沒有為了追求多模態(tài)功能而犧牲文本理解,可以作為文本和視覺任務(wù)的通用模型。