無一大模型及格! 北大/通研院提出超難基準,專門評估長文本理解生成

在長文本理解能力這塊,竟然沒有一個大模型及格!

北大聯合北京通用人工智能研究院提出了一個新基準數據集:LooGLE,專門用于測試和評估大語言模型(LLMs)長上下文理解能力。

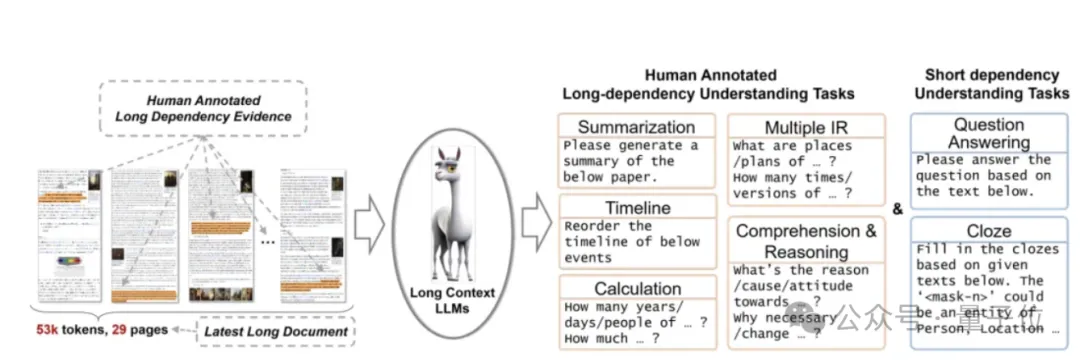

該數據集既能夠評估LLMs對長文本的處理和檢索能力,又可以評估其對文本長程依賴的建模和理解能力。

結果不評不知道,一評估發現這些模型在復雜的長依賴任務中的多信息檢索、時間重排序、計算、理解推理能力表現均不樂觀。

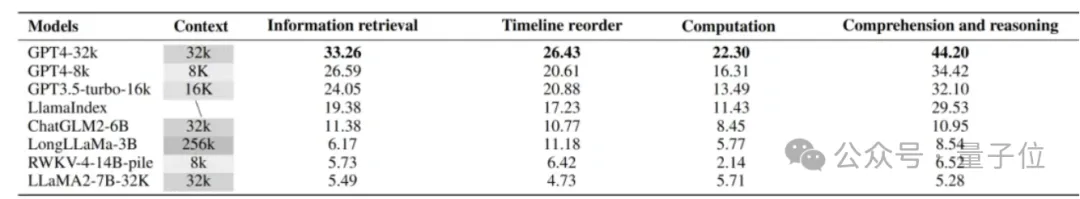

比如像Claude3-200k,GPT4-32k、GPT4-8k、GPT3.5-turbo-6k、LlamaIndex這種商業模型,平均只有40%的準確率。

而像開源模型表現就更不理想了…

ChatGLM2-6B、LongLLaMa-3B、RWKV-4-14B-pile、LLaMA-7B-32K平均只有10%的準確率。

目前該論文已被ACL 2024接收。

論文共同一作為通研院的李佳琪、王萌萌,通訊作者為通研院研究員鄭子隆和北京大學人工智能研究院助理教授張牧涵。

LooGLE基準測試

LooGLE基準測試主要有這樣幾個特點:

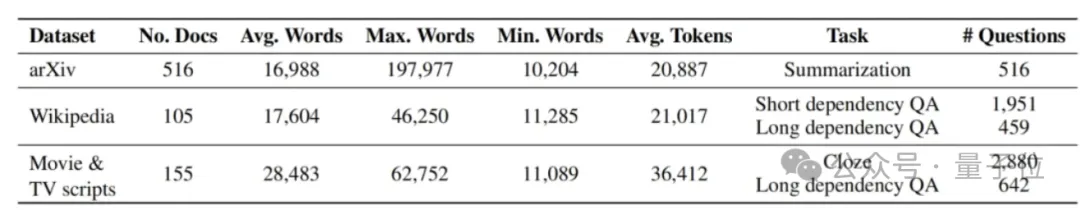

首先,它包含包含近 800 個最新收集的超長文檔。平均近2萬字(是現有相似數據集長度的2倍),并從這些文檔中重新生成了6千個不同領域和類別的任務/問題用于構建LooGLE。

目前目前沒有既評估LLMs對長文本的處理和記憶,又評估其對文本長程依賴的建模和理解能力的數據集。

LooGLE的數據集由7個主要的任務類別組成,旨在評估LLMs理解短程和長程依賴內容的能力。

團隊設計了5種類型的長期依賴任務,包括理解與推理、計算、時間線重新排序、多重信息檢索和摘要。

通過人工標注精心生成了超過1100對高質量的長依賴問答對,以滿足長依賴性要求。這些問答對經過了嚴格的交叉驗證,從而得到了對大型語言模型(LLMs)長依賴能力的精確評估。

LooGLE基準數據集僅包含2022年之后發布的文本,盡可能地避免了預訓練階段的數據泄露,考驗大模型利用其上下文學習能力來完成任務,而不是依靠記憶事實和知識儲備。

該基準的文本源自廣泛認可的開源文檔,包括了arxiv論文、維基百科文章以及電影和電視劇本,涉及學術、歷史、體育、政治、藝術、賽事、娛樂等領域。

長文理解中長程問答任務生成

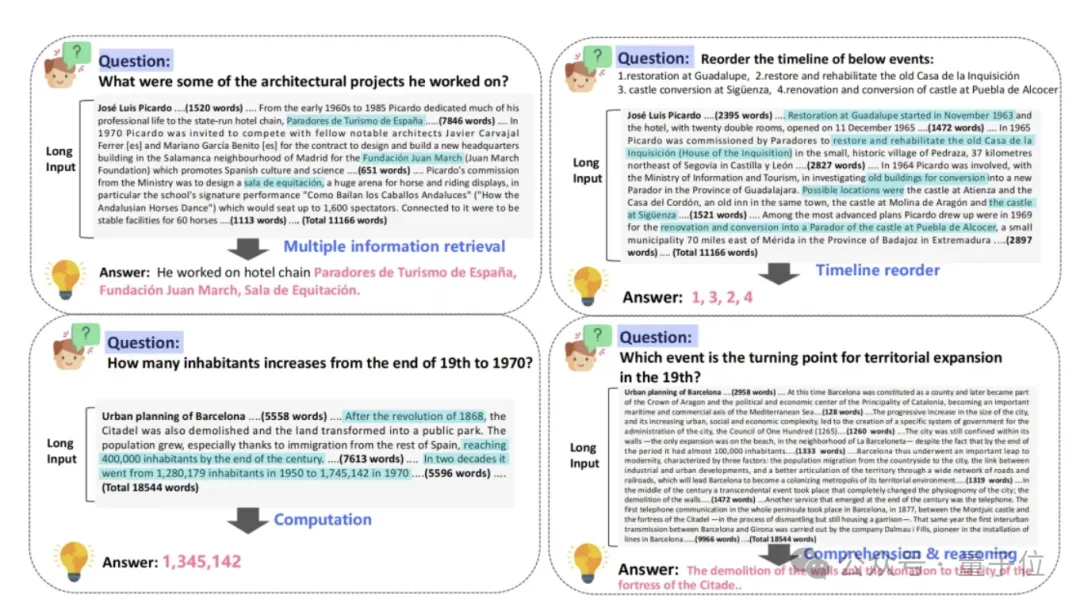

在本研究中,團隊組織了近百名標注者手工編制了約1100個真實的長依賴問答對,分為4類長依賴任務:多信息檢索、時間重排序、計算、理解推理。

多信息檢索:與傳統的短期檢索任務顯著不同,該任務下回答一個特定答案通常需要在整個文本中搜集多個線索或證據。任務要求從長文本中廣泛分布的相關證據或線索中進行檢索和提取,然后對這些證據進行匯總,才能得出最終答案。

計算:與前一個任務類似,首先需要從廣泛的文本中進行多次信息檢索提取相關數字,例如關于數量、頻率、持續時間、特定年份等。要得出準確的答案,還需要對這些數字進行計算。這個過程既依賴于強大的長上下文信息提取能力,并且涉及一定程度的數學推理能力。

時間重排序:這個任務給大模型輸入指令“請重新排列以下事件的時間軸”,以及一組按順序排列的事件描述。任務目標是根據這些事件在長文本中出現的時間先后順序將這些事件排列起來。成功完成這個任務需要對文檔的主要故事情節進行抽取和理解,且要求模型具有時間意識。

理解推理:這個任務要求模型利用散落在長上下文中的證據,深入理解問題并推理出答案。最常見的問題模式涉及到因果關系、影響、貢獻、態度以及與各種事件相關的基本屬性。此外,當問題圍繞著證據的重要程度、顯著程度、最高或最關鍵方面時,則需要進行更廣泛的比較和評估。此任務的答案通常在源文本中不明顯。它們通常需要多步推理來模擬內在的聯系和依賴關系,通過復雜的分析過程獲取答案。

實驗分析

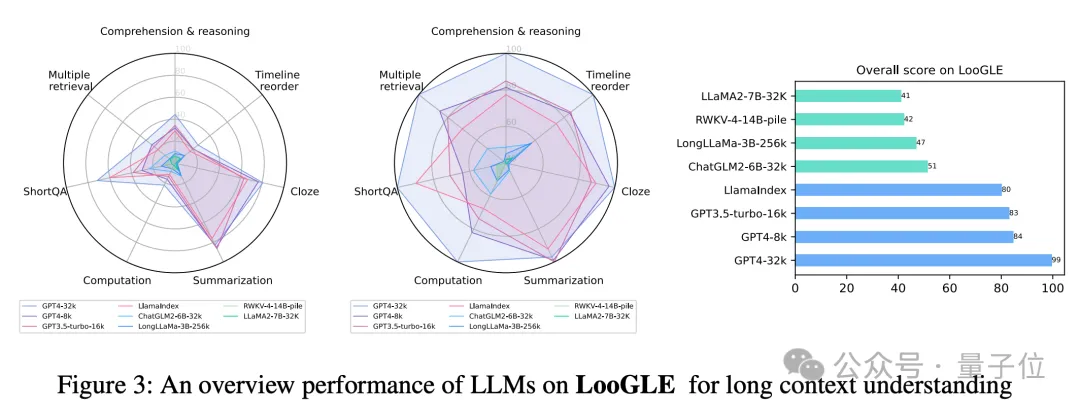

為了提供更全面和通用的性能評估,LooGLE 使用基于語義相似性的度量、GPT4 作為判斷的度量,以及人類評估作為度量。在LooGLE上對9種最先進的長文本LLMs進行評估(其中包括OpenAI和Anthropic的商用模型,以及幾個主流開源基座模型微調得到的長文本模型,和帶有外部記憶模塊的檢索增強模型),得出了以下關鍵發現:

- 商業模型顯著優于開源模型;

- LLMs在短依賴任務(如短問答和填空任務)方面表現出色,但在更復雜的長依賴任務中均表現不佳;

- CoT(思維鏈)只在長上下文理解方面帶來了微小的改進;

- 基于檢索的技術在短問答方面表現出明顯的優勢,而通過優化的Transformer架構或位置編碼來擴展上下文窗口長度的策略對長上下文理解的提升有限。

△不同LLM在LooGLE上展現的長文本理解能力

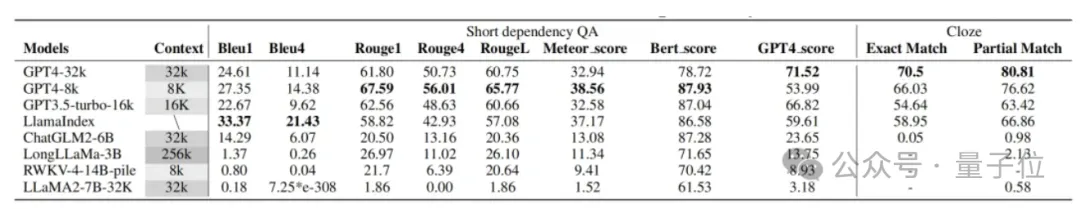

△不同模型在LooGLE短程問答上的性能

△不同模型在LooGLE短程問答上的性能

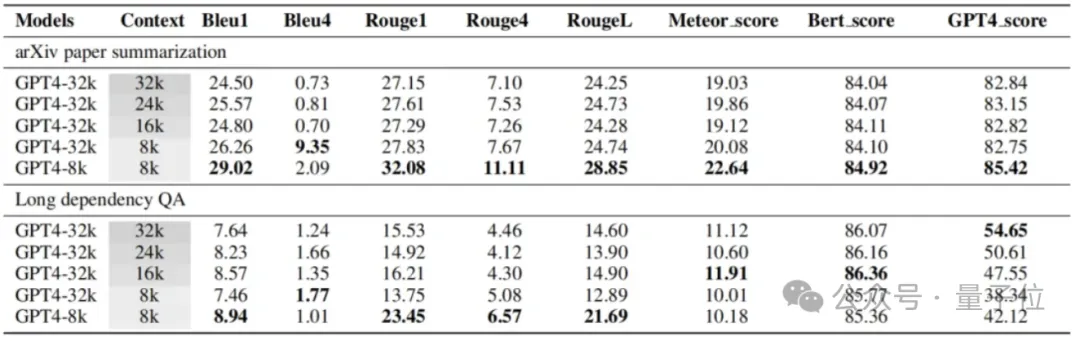

△不同上下文窗口對長程問答性能的影響

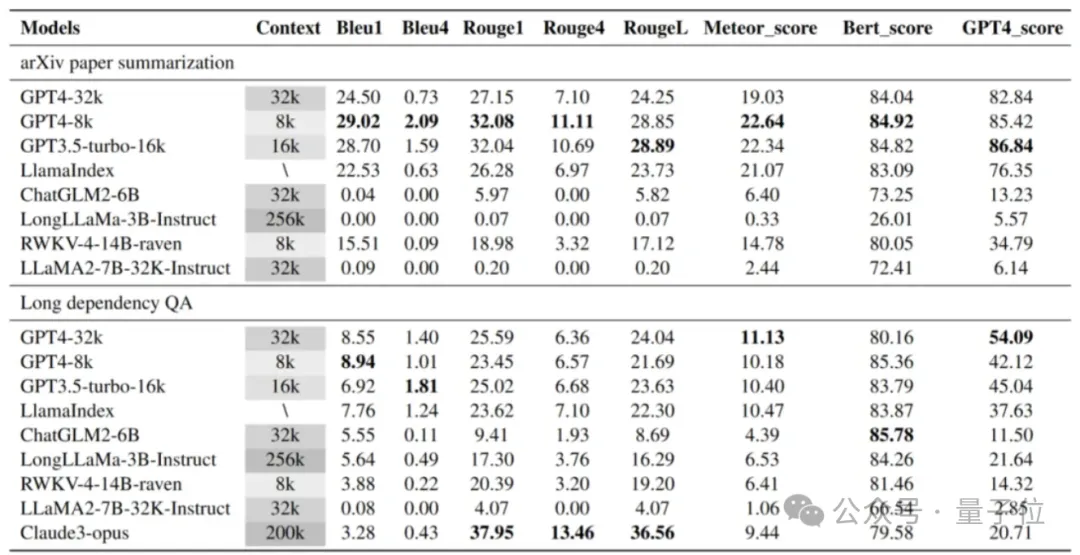

△不同模型在4種不同類型長程問答上的性能

因此,LooGLE不僅提供了關于長上下文LLMs的系統和全面的評估方案,而且為未來開發增強型模型以實現“真正的長上下文理解”提供了啟示。

論文地址:

https://arxiv.org/abs/2311.04939

數據地址:

https://huggingface.co/datasets/bigainlco/LooGLE

代碼地址:

https://github.com/bigai-nlco/LooGLE