一文詳看大模型長(zhǎng)文本如何評(píng)估:四大主流評(píng)測(cè)數(shù)據(jù)集的任務(wù)設(shè)計(jì)、數(shù)據(jù)集構(gòu)建方案

大語(yǔ)言模型(LLM)盡管在各種語(yǔ)言任務(wù)中表現(xiàn)搶眼,但通常僅限于處理上下文窗口大小范圍內(nèi)的文本。

有越來(lái)越多的基準(zhǔn)被提出來(lái)測(cè)試LLM的長(zhǎng)文本理解能力。

當(dāng)前具有代表性的長(zhǎng)文本評(píng)測(cè)主要包括Zero-SCROLLS、L-Eval、LongBench以及l(fā)oogle四個(gè)基準(zhǔn)。

本文對(duì)這個(gè)幾個(gè)數(shù)據(jù)集進(jìn)行梳理,供大家一起參考,包括任務(wù)的設(shè)計(jì)、任務(wù)數(shù)據(jù)集的構(gòu)造方案,這些都很有借鑒性。

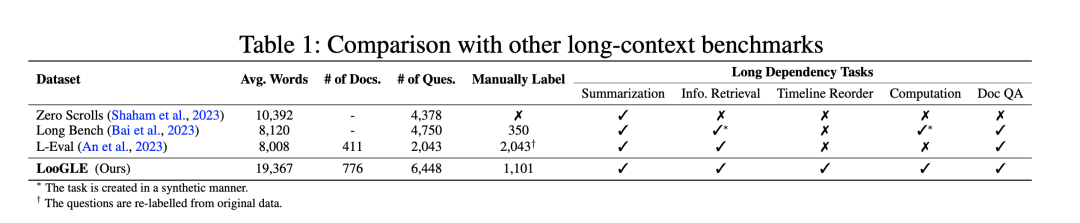

一、ZeroSCROLLS評(píng)測(cè)數(shù)據(jù)集

ZeroSCROLLS將不同來(lái)源的數(shù)據(jù)集自動(dòng)處理成平均10k詞的統(tǒng)一輸入格式。

地址:https://arxiv.org/pdf/2305.14196.pdf

ZeroSCROLLS作為一個(gè)零測(cè)試基準(zhǔn),包含十個(gè)自然語(yǔ)言任務(wù)的測(cè)試集,每個(gè)任務(wù)都要求對(duì)不同類型的長(zhǎng)文本進(jìn)行推理,每個(gè)任務(wù)最多只能使用500個(gè)示例。

其中:

六個(gè)數(shù)據(jù)集是該工作根據(jù)Shaham等人的研究成果改編的,另外四個(gè)是新任務(wù)。

圖片

圖片

1、Summarization摘要任務(wù)

該工作采用了SCROLLS中的三個(gè)摘要數(shù)據(jù)集(GovReport、SummScreenFD和QM-Sum),并增加了第四個(gè)數(shù)據(jù)集(SQuALITY)。

GovReport和SummScreenFD是全文檔摘要任務(wù),而QMSum和SQuALITY則以查詢?yōu)橹攸c(diǎn)。

其中:

GovReport:包含國(guó)會(huì)研究服務(wù)處和美國(guó)政府問(wèn)責(zé)辦公室的長(zhǎng)篇報(bào)告及其專家書(shū)面摘要。

SummScreenFD:包含從維基百科和TVMaze收集的電視節(jié)目集腳本及其摘要。

QMSum:一個(gè)基于查詢的會(huì)議記錄摘要數(shù)據(jù)集。該數(shù)據(jù)集包含學(xué)術(shù)會(huì)議、工業(yè)產(chǎn)品會(huì)議以及威爾士和加拿大議會(huì)的會(huì)議記錄。除了會(huì)議筆錄,每個(gè)實(shí)例還包含一個(gè)查詢,目的是將摘要集中在特定主題上。

SQuALITY:一個(gè)以問(wèn)題為中心的摘要數(shù)據(jù)集,給定古騰堡計(jì)劃中的一個(gè)故事,任務(wù)是根據(jù)一個(gè)指導(dǎo)性問(wèn)題生成該故事或其某些方面的摘要。

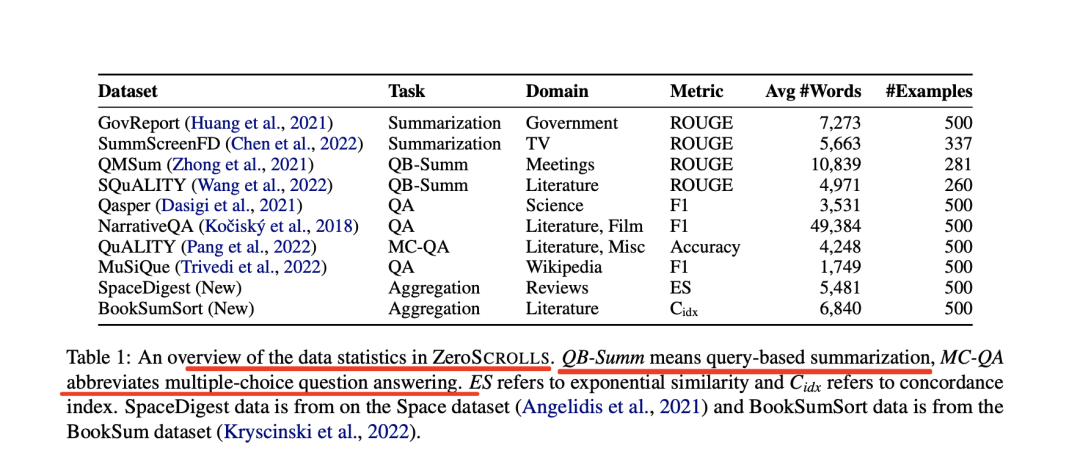

摘要任務(wù)對(duì)應(yīng)的prompt如下:

圖片

圖片

2、Question Answering

該工作采用了SCROLLS的三個(gè)問(wèn)題解答數(shù)據(jù)集(Qasper、NarrativeQA和QuAL-ITY),并增加了MuSiQue,該數(shù)據(jù)集側(cè)重于多跳問(wèn)答。

其中:

Qasper:包含來(lái)自語(yǔ)義學(xué)者開(kāi)放研究語(yǔ)料庫(kù)(S2ORC)的NLP論文。NLP從業(yè)人員根據(jù)摘要提出問(wèn)題,另一組從業(yè)人員根據(jù)文章內(nèi)容進(jìn)行回答。

NarrativeQA:包含對(duì)古騰堡計(jì)劃(ProjectGutenberg)中的書(shū)籍和各種網(wǎng)站中的電影劇本的提問(wèn)和回答。為了創(chuàng)建問(wèn)題和答案,標(biāo)注人員者從維基百科中獲得了書(shū)籍和電影的摘要。 每個(gè)問(wèn)題由一個(gè)或多個(gè)標(biāo)注人員回答。

QuALITY:包含來(lái)自古騰堡計(jì)劃、開(kāi)放美國(guó)國(guó)家語(yǔ)料庫(kù)等的故事和文章。每篇文章都包含一個(gè)故事和一個(gè)選擇題;問(wèn)題編寫者在指導(dǎo)下編寫需要閱讀故事的大部分內(nèi)容才能正確作答的問(wèn)題。

MuSiQue:一個(gè)多跳問(wèn)題解答數(shù)據(jù)集,輸入是20個(gè)維基百科段落和一個(gè)需要在不同段落之間進(jìn)行多次跳轉(zhuǎn)的問(wèn)題。在原始數(shù)據(jù)集中,每個(gè)問(wèn)題都有一個(gè)無(wú)法回答的孿生問(wèn)題,即正確答案不存在于段落中。該工作為ZeroSCROLLS隨機(jī)抽取了100個(gè)無(wú)法回答的問(wèn)題和400個(gè)可以回答的問(wèn)題。

3、Aggregation

該工作創(chuàng)建了兩個(gè)新任務(wù),從結(jié)構(gòu)上看,這兩個(gè)任務(wù)要求對(duì)輸入信息的不同部分進(jìn)行上下文關(guān)聯(lián)和信息聚合。其中:

SpaceDigest:一項(xiàng)新的情感聚合任務(wù)。給定Space數(shù)據(jù)集中的50條酒店評(píng)論(不含評(píng)分),任務(wù)是確定正面評(píng)論的百分比。

該工作從原始數(shù)據(jù)集中評(píng)分最高的500家酒店中為每家酒店創(chuàng)建一個(gè)示例(50條評(píng)論),只保留嚴(yán)格意義上的正面評(píng)論(評(píng)分為5分或4分)或負(fù)面評(píng)論(評(píng)分為2分或1分),剔除評(píng)分為3分的矛盾評(píng)論。

為了驗(yàn)證人類是否能很好地完成這項(xiàng)任務(wù),該工作給5名標(biāo)注人員提供了一個(gè)縮略版的示例(每個(gè)示例包含10條評(píng)論),并要求他們寫出正面評(píng)論的百分比。

每位標(biāo)注人員需要分配到10個(gè)示例(每位注釋者100條評(píng)論,總計(jì)500條)。

BookSumSort:一項(xiàng)基于Book-Sum數(shù)據(jù)集的新任務(wù),該數(shù)據(jù)集包含各種來(lái)源的小說(shuō)、戲劇和長(zhǎng)詩(shī)的章節(jié)(或部分)摘要。

給定一個(gè)章節(jié)摘要的列表,任務(wù)是根據(jù)BookSum中摘要的原始順序?qū)ζ渲匦屡判颉T摴ぷ魍ㄟ^(guò)人工從BookSum中選擇125本書(shū)的摘要來(lái)創(chuàng)建任務(wù),只保留高質(zhì)量的實(shí)例。該工作對(duì)每篇摘要進(jìn)行人工編輯,刪除引言、序言、概述等內(nèi)容,以及任何其他可能表明摘要確切位置的信息;

例如,"第8章以簡(jiǎn)描述......開(kāi)始"被替換為"本章以簡(jiǎn)描述......開(kāi)始","隨著戲劇的開(kāi)場(chǎng),希波呂托斯宣布......"被替換為"希波呂托斯宣布......"。每個(gè)摘要列表包含3至86個(gè)章節(jié)的摘要,中位數(shù)為15個(gè),平均每個(gè)實(shí)例包含18.8個(gè)章節(jié)。

該工作從每個(gè)列表中隨機(jī)選擇4種排列方式,創(chuàng)建500個(gè)實(shí)例。

對(duì)應(yīng)的prompt如下:

圖片

圖片

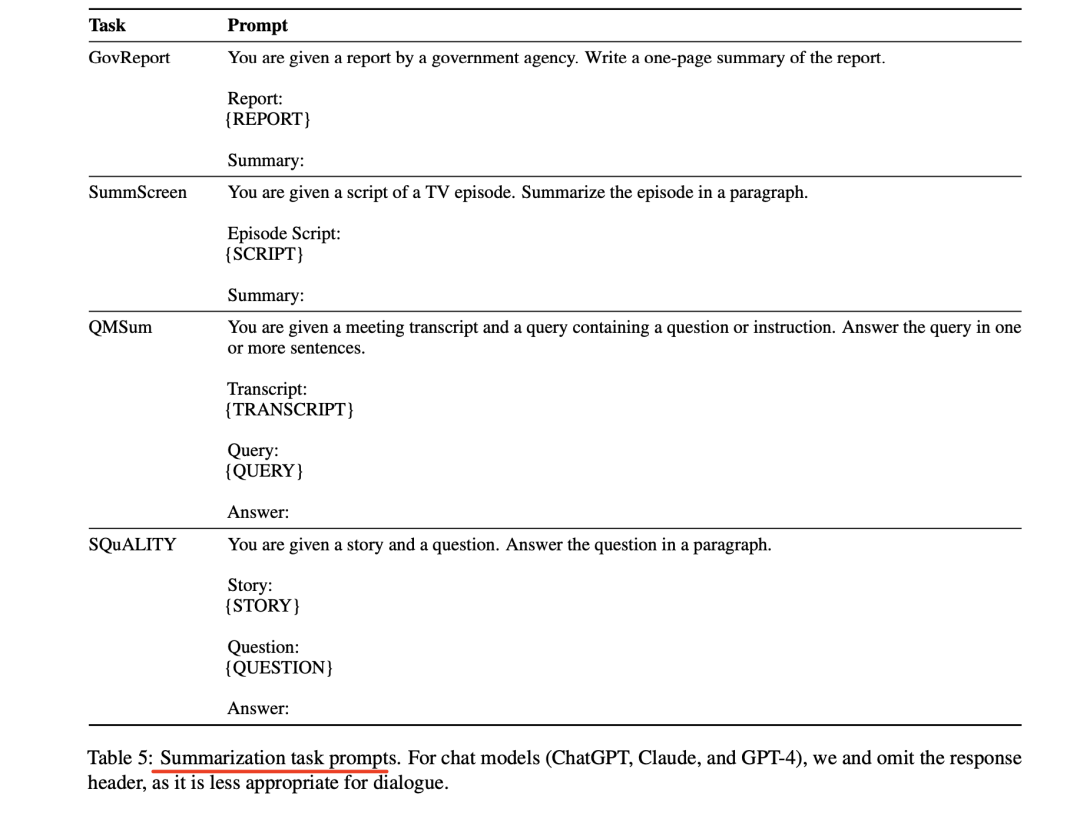

二、L-Eval評(píng)測(cè)數(shù)據(jù)集

L-Eval(L-EVAL: INSTITUTING STANDARDIZED EVALUATION FOR LONG CONTEXT LANGUAGE MODELS)從規(guī)模較小的類似公共數(shù)據(jù)集中重新標(biāo)注數(shù)據(jù)和指令,以確保質(zhì)量。此外,它還優(yōu)化了評(píng)估程序和基線,以獲得更準(zhǔn)確的結(jié)論。

地址:https://arxiv.org/pdf/2307.11088.pdf

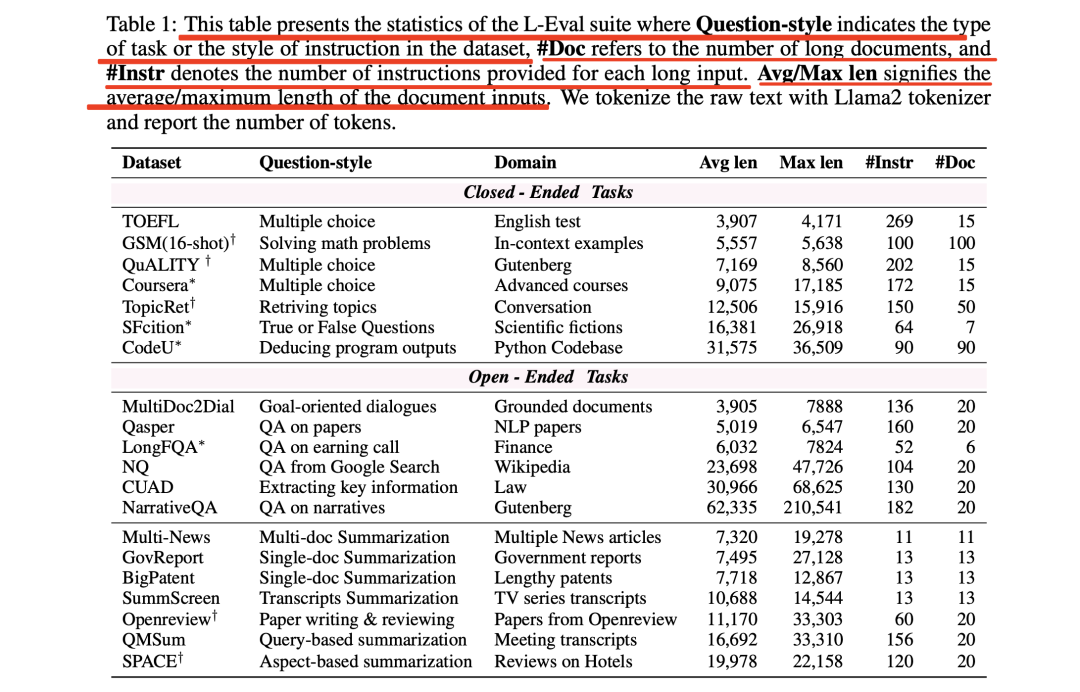

表1列出了L-Eval的統(tǒng)計(jì)數(shù)據(jù)

圖片

圖片

L-Eval包含多種題型,如:

選擇題(TOFEL、QuALITY、Coursera)

真假題(SFiction)

數(shù)學(xué)題(GSM)

代碼理解(CodeU)

目標(biāo)導(dǎo)向?qū)υ挘∕ulti-Doc2Dial)

提取式QA(CUAD、NQ)

摘要性QA(LongFQA、NarrativeQA、Qasper)

單篇文檔摘要(GovReport、BigPatent、SummScreen、SummScreen、QMSum)

多文檔摘要(Multi-News、SPACE)

研究寫作(Openre-view)

在數(shù)據(jù)分布方面,L-Eval中的長(zhǎng)文檔涉及法律、金融、學(xué)術(shù)論文、講座、長(zhǎng)篇對(duì)話、新聞、著名Python代碼庫(kù)、長(zhǎng)篇小說(shuō)和會(huì)議等多個(gè)領(lǐng)域。

在長(zhǎng)度方面,L-Eval的平均輸入長(zhǎng)度從4k到60k不等,最大樣本包含近20萬(wàn)個(gè)token。這種多樣性代表了現(xiàn)實(shí)世界中不同任務(wù)可能需要不同長(zhǎng)度的上下文和指令的情況,不同任務(wù)的引用長(zhǎng)度也有很大差異。

1、從零開(kāi)始的數(shù)據(jù)標(biāo)注

L-Eval共有4個(gè)從頭標(biāo)注的數(shù)據(jù)集:Coursera、SFcition、CodeU和LongFQA。

原始資源分別是來(lái)自Coursera的視頻、以前的開(kāi)源數(shù)據(jù)集、著名Python庫(kù)的源代碼以及公開(kāi)的通話記錄。

為了降低標(biāo)注的難度,該工作選擇了四門與大數(shù)據(jù)和機(jī)器學(xué)習(xí)相關(guān)的公開(kāi)課程。輸入的長(zhǎng)文檔是視頻的字幕。問(wèn)題和真實(shí)答案由作者標(biāo)注。Coursera的教學(xué)方式是選擇題。為了增加任務(wù)的難度,該工作設(shè)置了多個(gè)正確選項(xiàng)。

CodeU是代碼理解數(shù)據(jù)集,要求LLM推斷冗長(zhǎng)Python程序的輸出。該工作主要使用Numpy的源代碼,并構(gòu)建了一個(gè)字符串處理代碼庫(kù)。

為了防止LLM根據(jù)其參數(shù)知識(shí)回答問(wèn)題,該工作替換了原始函數(shù)名。LLM應(yīng)首先找到函數(shù)被調(diào)用的位置,并確定調(diào)用了哪些函數(shù)。

LongFQA該工作還注意到,金融領(lǐng)域缺乏長(zhǎng)語(yǔ)境問(wèn)題解答數(shù)據(jù)集,因此該工作根據(jù)6家公司網(wǎng)站投資者關(guān)系部分的公開(kāi)盈利電話記錄來(lái)標(biāo)注QA對(duì)。

2、從公共數(shù)據(jù)集重新標(biāo)注數(shù)據(jù)

該工作在L-Eval中對(duì)5個(gè)公開(kāi)數(shù)據(jù)集進(jìn)行了重新標(biāo)注。

其中:

GSM(16-shot)源自GSM8k數(shù)據(jù)集。考慮到如果LCLM在較長(zhǎng)的語(yǔ)境中仍能保持其推理能力,那么使用更多高質(zhì)量的示例將對(duì)數(shù)學(xué)問(wèn)題的解決產(chǎn)生積極影響。該工作用較長(zhǎng)的"思維鏈"(Chain-of-Thought)構(gòu)建了16個(gè)上下文示例,其中8個(gè)示例來(lái)自"思維鏈"集線器(Chain-of-Thought-hub),8個(gè)示例由該工作自己構(gòu)建。

在QuALITY中注入了新的合成指令來(lái)測(cè)試全局上下文建模,例如"該工作能從這個(gè)故事中最長(zhǎng)的句子中推斷出什么?"和"故事中有多少個(gè)單詞?

Openreview數(shù)據(jù)集包含從openreview.net收集的論文。該工作要求模型撰寫摘要部分,總結(jié)相關(guān)工作,最后給出反饋,包括給作者的寶貴建議和一些問(wèn)題。

3、數(shù)據(jù)過(guò)濾與校正

剩下的12個(gè)任務(wù)來(lái)源于現(xiàn)有數(shù)據(jù)集。然而,L-Eval在數(shù)據(jù)收集后需要更多的人力,因?yàn)樵摴ぷ靼l(fā)現(xiàn)以前的長(zhǎng)序列數(shù)據(jù)集的標(biāo)注質(zhì)量波動(dòng)很大,有很多無(wú)法回答的問(wèn)題與上下文無(wú)關(guān)。這些錯(cuò)誤很難通過(guò)以往工作中的自動(dòng)預(yù)處理腳本來(lái)糾正。

在L-Eval中,所有樣本都是在數(shù)據(jù)收集后手動(dòng)過(guò)濾和校正。具體地,該工作使用Claude-100k作為助手來(lái)過(guò)濾錯(cuò)誤的QA和無(wú)法回答的問(wèn)題。

首先,該工作將冗長(zhǎng)的文檔輸入Claude,并要求它提供答案和解釋。如果clsude給出的答案與基本事實(shí)嚴(yán)重不符,或者說(shuō)該工作無(wú)法從上下文中推斷出答案,就會(huì)對(duì)其進(jìn)行重新標(biāo)注或直接刪除。

三、LongBench評(píng)測(cè)數(shù)據(jù)集

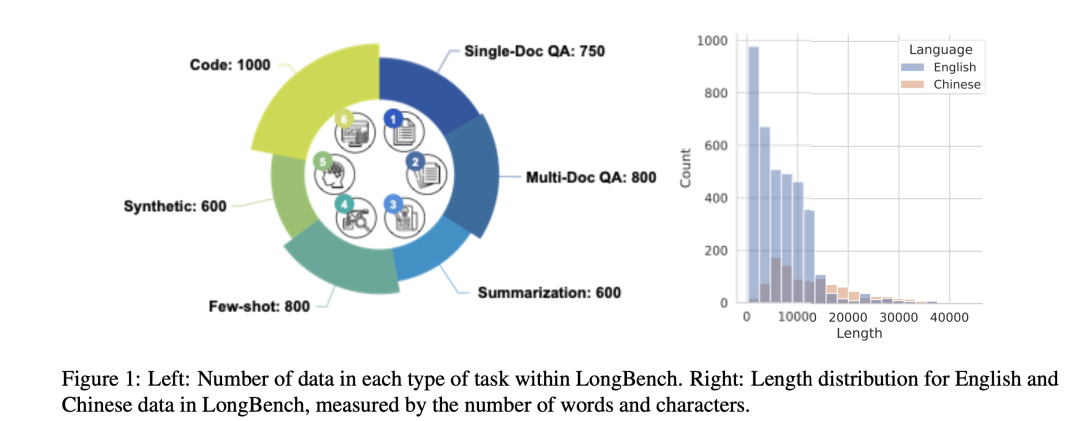

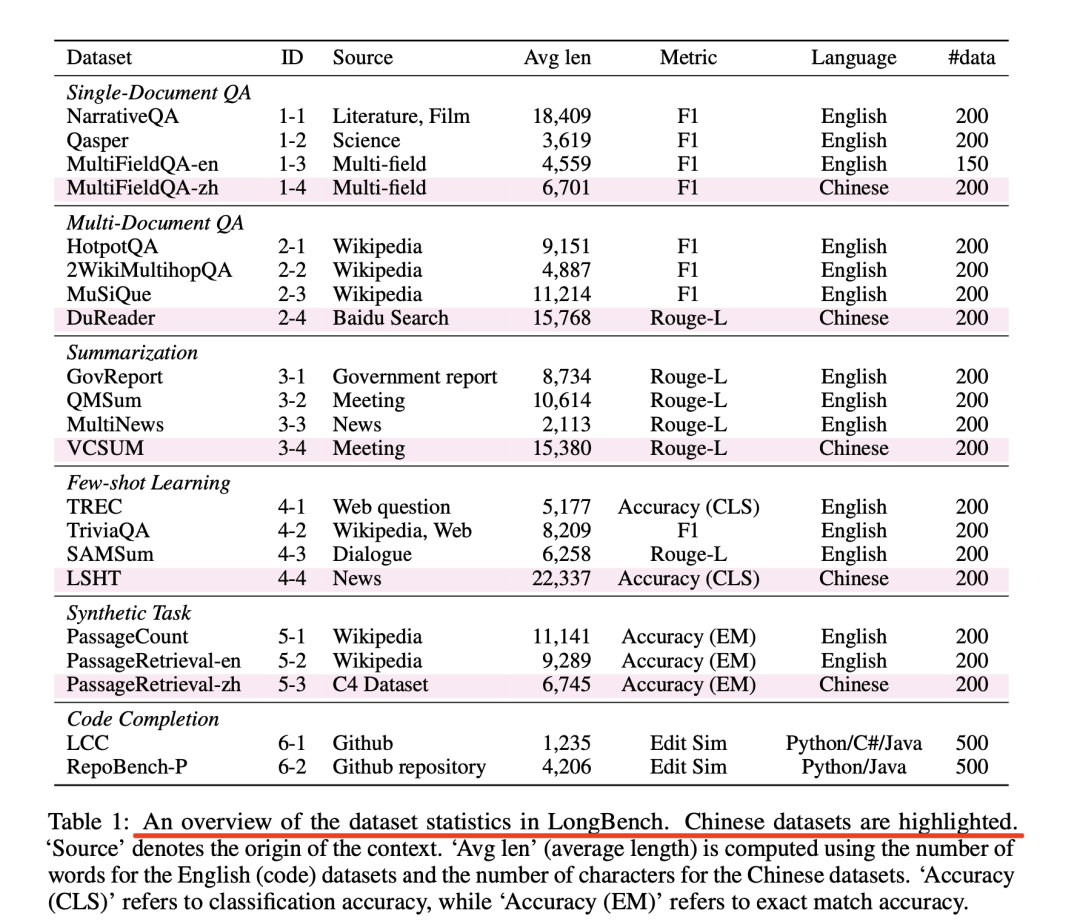

LongBench《LongBench: A Bilingual, Multitask Benchmark for Long Context Understanding》提供了一個(gè)雙語(yǔ)和多任務(wù)數(shù)據(jù)集,具有不同長(zhǎng)度、分布、模式、語(yǔ)言和領(lǐng)域的各種序列,用于全面評(píng)估長(zhǎng)語(yǔ)境理解能力。

圖片

圖片

地址:https://arxiv.org/abs/2308.14508

1、Single-Doc QA單文檔問(wèn)答

對(duì)于單文檔QA,該工作主要關(guān)注具有較長(zhǎng)文檔的實(shí)例。包括:NarrativeQA,該數(shù)據(jù)集由長(zhǎng)故事和測(cè)試閱讀理解能力的問(wèn)題組成。該工作還從Qasper中采樣,該數(shù)據(jù)集的特點(diǎn)是對(duì)NLP論文進(jìn)行QA,并由NLP從業(yè)人員進(jìn)行標(biāo)注。

為了更好地測(cè)試模型在不同領(lǐng)域的長(zhǎng)語(yǔ)境理解能力,該工作手工整理了中英文的MultiFieldQA數(shù)據(jù)集。

具體地,首先從多個(gè)來(lái)源收集文件和文章,包括法律文件、政府報(bào)告、百科全書(shū)、學(xué)術(shù)論文等。該工作邀請(qǐng)了三位博士生為每篇文章的問(wèn)題和答案進(jìn)行標(biāo)注,為了便于自動(dòng)評(píng)估,標(biāo)注時(shí)盡量給出明確的答案。

在注釋過(guò)程中,該工作確保答案可以從文件中推斷出來(lái),而且證據(jù)的位置是相當(dāng)隨機(jī)的,以避免出現(xiàn)偏差,例如,如果與答案相關(guān)的語(yǔ)句經(jīng)常出現(xiàn)在開(kāi)頭或結(jié)尾。

2、Multi-Doc QA多文檔問(wèn)答

多文檔問(wèn)答要求模型從多個(gè)文檔中提取和組合信息以獲得答案,這通常比單文檔問(wèn)答更具挑戰(zhàn)性。

英語(yǔ)測(cè)試樣本來(lái)自三個(gè)基于維基百科的多跳QA數(shù)據(jù)集:HotpotQA、2WikiMultihopQA和MuSiQue。

HotpotQA涉及一些由母語(yǔ)人士直接撰寫的2-hop問(wèn)題,給出兩個(gè)相關(guān)的段落。

2WikiMultihopQA包含多達(dá)5跳的問(wèn)題,這些問(wèn)題是通過(guò)人工設(shè)計(jì)的模板合成的,以確保這些問(wèn)題無(wú)法通過(guò)捷徑解決。

MuSiQue中的問(wèn)題由涉及最多4跳推理的簡(jiǎn)單問(wèn)題精心組成,然后由標(biāo)注人員進(jìn)行解析,以避免走捷徑并確保語(yǔ)言的自然性。原始數(shù)據(jù)集中的每個(gè)問(wèn)題都有2-4個(gè)提供一步推理證據(jù)的輔助段落和幾個(gè)分散注意力的段落作為補(bǔ)充。

為了調(diào)整數(shù)據(jù)以進(jìn)行長(zhǎng)文本評(píng)估,該工作利用維基百科中包含支持段落或干擾段落的完整段落作為語(yǔ)境。首先,在上下文中包含支持性段落,然后添加盡可能多的干擾性段落,直到總長(zhǎng)度達(dá)到最大長(zhǎng)度。最后,這些段落被隨機(jī)排序,形成多文檔上下文。

除了這三個(gè)英文數(shù)據(jù)集之外,該工作還構(gòu)建了一個(gè)基于DuReader的中文數(shù)據(jù)集。為了使其適用于評(píng)估長(zhǎng)語(yǔ)境能力,該工作不僅為每個(gè)問(wèn)題提供若干與該問(wèn)題相關(guān)的文檔,還從全部文檔集中任意選擇若干文檔作為干擾項(xiàng),直到每個(gè)問(wèn)題與20個(gè)文檔相關(guān)聯(lián)。

3、Summarization摘要

與通常可以利用上下文中的局部信息來(lái)解決的質(zhì)量保證任務(wù)相比,摘要要求對(duì)整個(gè)上下文有更全面的了解。

原始GovReport數(shù)據(jù)集是美國(guó)政府問(wèn)責(zé)局和國(guó)會(huì)研究服務(wù)部的詳細(xì)報(bào)告的大規(guī)模集合,每份報(bào)告都附有人工撰寫的摘要,內(nèi)容涵蓋各種國(guó)家政策問(wèn)題。

QMSum數(shù)據(jù)集包含了232個(gè)會(huì)議的查詢-摘要對(duì)標(biāo)注,涉及多個(gè)領(lǐng)域,包括產(chǎn)品會(huì)議、學(xué)術(shù)會(huì)議和委員會(huì)會(huì)議。該工作將查詢視為輸入I,將會(huì)議內(nèi)容視為上下文C,將摘要視為答案A。

MultiNews是多文檔摘要數(shù)據(jù)集,由2-10篇討論同一事件或話題的新聞文章組成,每篇文章都配有人工撰寫的摘要,總結(jié)了多篇源文章中的關(guān)鍵信息。在LongBench中,該工作在第i篇新聞文章前加入"Documenti",并將其串聯(lián)到上下文C中。

VCSUM是一個(gè)大規(guī)模的中文會(huì)議摘要數(shù)據(jù)集,由239個(gè)真實(shí)會(huì)議組成,持續(xù)時(shí)間超過(guò)230小時(shí),可支持多種摘要任務(wù)。在LongBench中,選擇VCSUM中的長(zhǎng)片段作為評(píng)估樣本。

4、Few-shot Learning

為了確保任務(wù)的多樣性,該工作將分類、總結(jié)和閱讀理解任務(wù)納入了few shot學(xué)習(xí)場(chǎng)景中。該工作納入了兩個(gè)具有細(xì)粒度類標(biāo)簽的分類數(shù)據(jù)集,包括TREC和LSHT,前者是涉及50個(gè)細(xì)粒度類的問(wèn)題分類任務(wù),后者是涉及24個(gè)類的中文新聞分類任務(wù)。

在摘要任務(wù)方面,使用SAMSum數(shù)據(jù)集,該數(shù)據(jù)集包含有標(biāo)注摘要的信使式對(duì)話。TriviaQA包含標(biāo)有證據(jù)段落的問(wèn)答對(duì),該工作將其用作閱讀理解任務(wù)。該工作將TriviaQA中字?jǐn)?shù)少于1,000字的段落過(guò)濾為潛在示例。

對(duì)于TREC、LSHT、SAMSum和TriviaQA,范圍分別為[100,600]、[10,40]、[10,100]、[2,24]。

5、Synthetic Task合成任務(wù)

合成任務(wù)通過(guò)精心設(shè)計(jì)來(lái)測(cè)試模型在特定場(chǎng)景和模式下的能力。在LongBench中,該工作設(shè)計(jì)了三個(gè)合成任務(wù)。

PassageRetrieval-en和PassageRetrieval-zh基于英文維基百科和C4數(shù)據(jù)集構(gòu)造,對(duì)于每個(gè)數(shù)據(jù)條目,該工作隨機(jī)抽取30個(gè)段落,并選擇其中一個(gè)使用GPT-3.5-Turbo進(jìn)行總結(jié)。該任務(wù)要求模型識(shí)別精心制作的摘要所對(duì)應(yīng)的原始段落。

PassageCount試要求模型利用完整的上下文來(lái)完成任務(wù)。對(duì)于每項(xiàng)數(shù)據(jù),從英文維基百科中隨機(jī)選取幾個(gè)段落,將每個(gè)段落隨機(jī)重復(fù)若干次,最后將段落打亂,要求模型確定給定集合中唯一段落的數(shù)量。具體地,該工作隨機(jī)選擇M作為段落數(shù)的上限。然后,從[2,M]范圍內(nèi)隨機(jī)抽取唯一段落數(shù)N,從N個(gè)唯一段落中進(jìn)行隨機(jī)抽樣(替換),得到最終的M個(gè)段落。

6、Code Completion代碼補(bǔ)全任務(wù)

代碼自動(dòng)補(bǔ)全是自動(dòng)補(bǔ)全系統(tǒng)的一項(xiàng)重要任務(wù),它可以根據(jù)先前的代碼輸入和上下文幫助用戶補(bǔ)全代碼。

這項(xiàng)任務(wù)會(huì)對(duì)模型構(gòu)成巨大挑戰(zhàn),尤其是在處理冗長(zhǎng)的代碼輸入或甚至是資源庫(kù)級(jí)數(shù)據(jù)時(shí)。這主要是因?yàn)槟P托枰鶕?jù)代碼元素內(nèi)部的關(guān)系(如類和函數(shù)定義之間的關(guān)系)在長(zhǎng)距離序列中建立注意力。因此,該工作認(rèn)為這是一項(xiàng)適合評(píng)估模型長(zhǎng)語(yǔ)境建模能力的任務(wù)。

其中:

LCC數(shù)據(jù)集取自原始的長(zhǎng)代碼完成數(shù)據(jù)集。原始數(shù)據(jù)集是根據(jù)長(zhǎng)度過(guò)濾GitHub上一個(gè)文件中的代碼而構(gòu)建的。該數(shù)據(jù)包括作為上下文的前幾行長(zhǎng)代碼和作為答案的下一行代碼。

考慮到版本庫(kù)級(jí)別的代碼補(bǔ)全設(shè)置,這就需要匯總跨文件的代碼信息。為此,該工作采用了RepoBench-P數(shù)據(jù)集。

RepoBench-P數(shù)據(jù)集收集自Github代碼庫(kù),首先根據(jù)模塊導(dǎo)入語(yǔ)句從其他文件中檢索相關(guān)代碼片段。然后將這些代碼片段與當(dāng)前文件中的前幾行代碼串聯(lián)起來(lái)作為上下文,并用于預(yù)測(cè)下一行代碼。

該工作從原始數(shù)據(jù)集中選擇了最具挑戰(zhàn)性的XF-F(跨文件優(yōu)先)設(shè)置,在這種設(shè)置中,文件內(nèi)上下文沒(méi)有提供模塊的先前使用情況來(lái)幫助預(yù)測(cè)。

對(duì)于每份原始數(shù)據(jù),該工作會(huì)對(duì)包含真實(shí)跨文件代碼片段(人工標(biāo)注為最佳預(yù)測(cè)上下文)的跨文件代碼片段進(jìn)行打亂,并將其合并為上下文C。

圖片

圖片

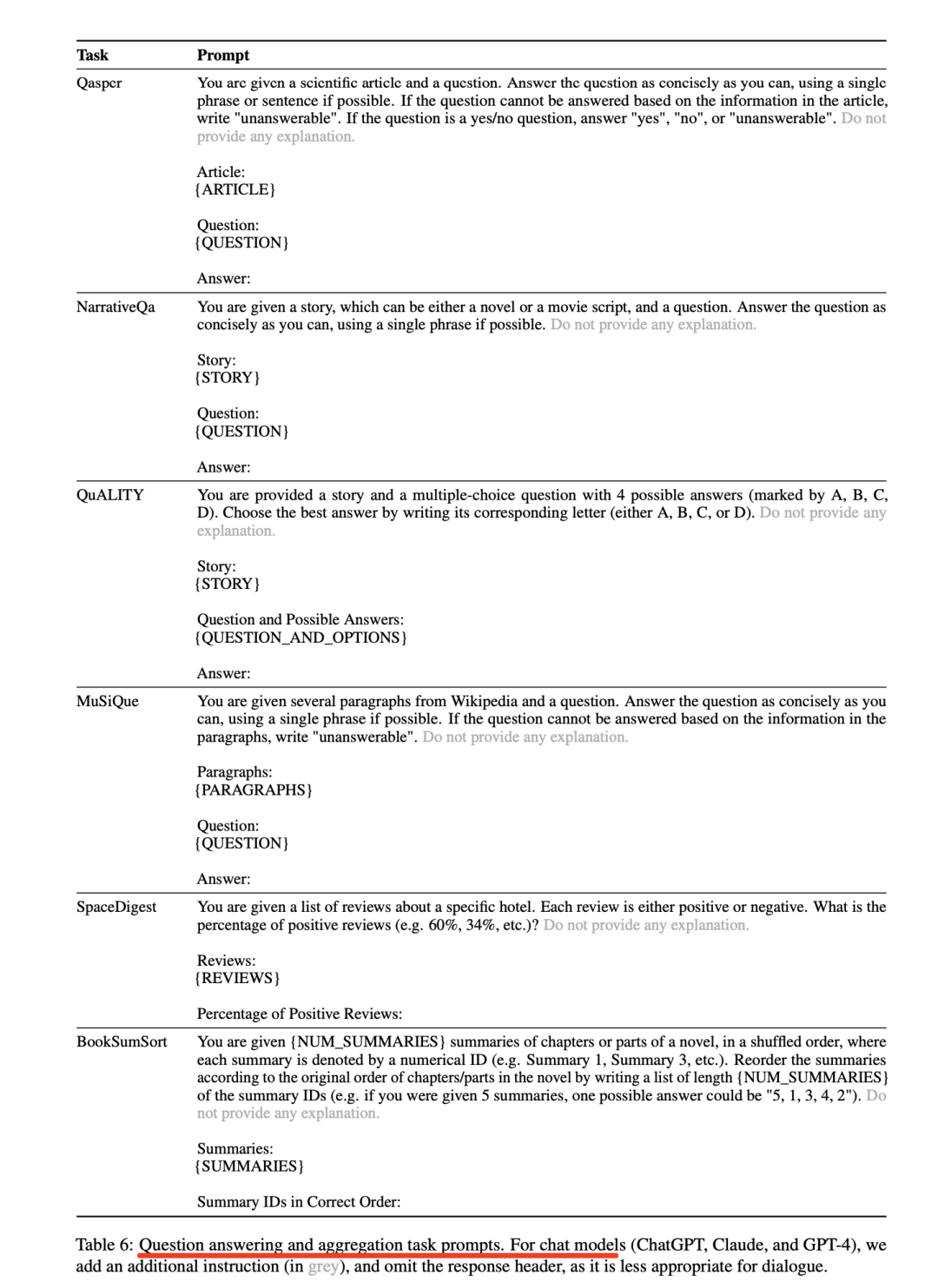

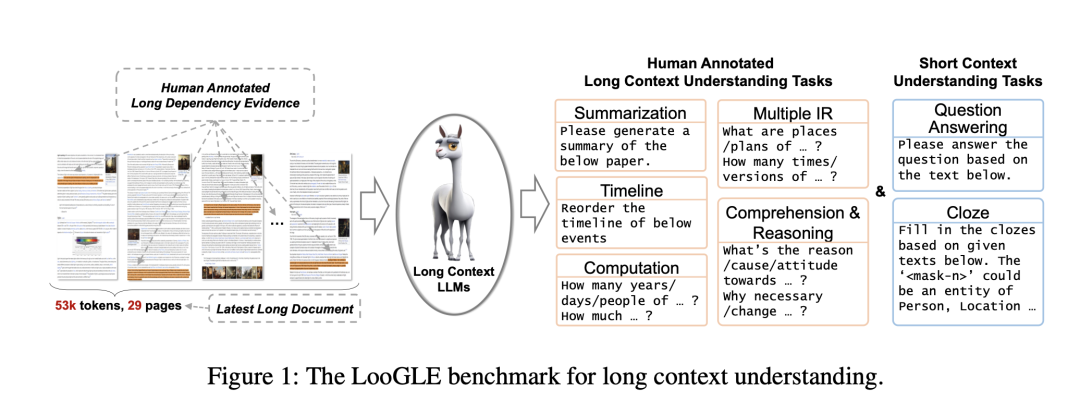

四、LooGLE評(píng)測(cè)數(shù)據(jù)集

LooGLE包含更具挑戰(zhàn)性的長(zhǎng)依賴任務(wù),如事件時(shí)間線重排、理解/推理和計(jì)算。這些任務(wù)不僅需要信息檢索,還需要對(duì)整個(gè)文本進(jìn)行理解/推理。

圖片

圖片

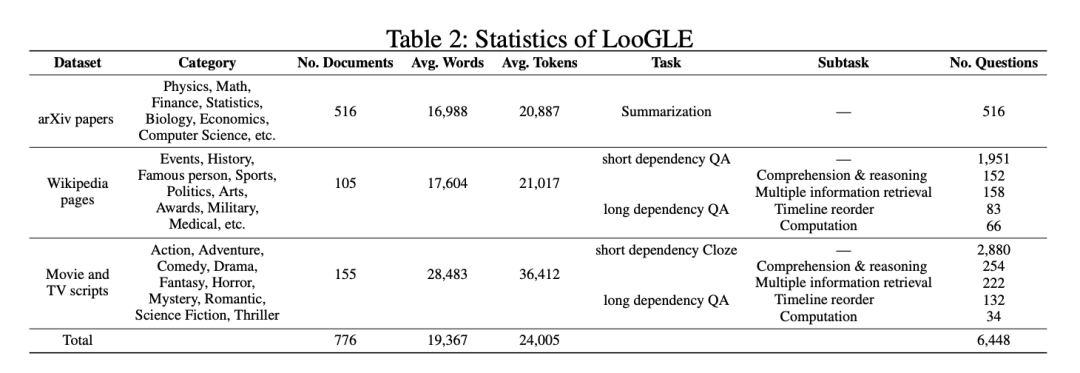

如表2所示,有三類數(shù)據(jù)源。

圖片

圖片

LooGLE中生成了兩類主要任務(wù):短依賴任務(wù)和長(zhǎng)依賴任務(wù)。

對(duì)于短依賴性任務(wù),從維基百科文章和腳本中生成短QA。

對(duì)于長(zhǎng)依賴性任務(wù),包括針對(duì)arXiv論文的摘要和針對(duì)長(zhǎng)文檔理解的人工設(shè)計(jì)QA任務(wù)。

QA有四個(gè)主要子任務(wù):多重信息檢索、時(shí)間軸重排、計(jì)算、理解和推理。該工作精細(xì)地生成任務(wù)/問(wèn)題,以定制每個(gè)數(shù)據(jù)源的內(nèi)在特征,從而更好地進(jìn)行長(zhǎng)文理解評(píng)估。

論文地址:https://arxiv.org/pdf/2311.04939.pdf

項(xiàng)目地址:https://github.com/bigai-nlco/LooGLE.

1、數(shù)據(jù)集的選擇和構(gòu)建

該LooGLE基準(zhǔn)由3個(gè)數(shù)據(jù)源組成:科學(xué)論文、維基百科文章、電影和電視腳本,它們都涵蓋了不同的主題和類別,用所有文檔都是2022年后的文檔,長(zhǎng)度超過(guò)10k。

其中,

針對(duì)arXiv論文。采用隨機(jī)抽取的方法,從arXiv網(wǎng)站(https://arxiv.org/)上的10,000個(gè)大量條目中抽取數(shù)據(jù)。這些條目從2022年1月到2023年4月不等。然后提取它們的摘要,使其成為該工作總結(jié)任務(wù)的主要來(lái)源。該工作在保證數(shù)據(jù)質(zhì)量方面相當(dāng)嚴(yán)格,所以刪去參考文獻(xiàn)部分,清理數(shù)學(xué)公式中的亂碼,并剔除字?jǐn)?shù)少于10,000字的文檔。經(jīng)過(guò)全面檢查,該工作最終收集到了516篇可靠的研究論文。

對(duì)于維基百科文章,首先從官方網(wǎng)站(https://dumps.wikimedia.org/)下載并解析了以.bz文件格式存在的最新頁(yè)面文章。然后,利用來(lái)自HuggingFace(https://huggingface.co/datasets/wikipedia)的開(kāi)源維基百科數(shù)據(jù)集(202203.en)子集,保留了2022年之后字?jǐn)?shù)超過(guò)10k的文章。由于轉(zhuǎn)儲(chǔ)文件中的某些頁(yè)面可能已不存在,并被重定向到相關(guān)頁(yè)面,因此只保留重定向后的頁(yè)面(免責(zé)摘要、引文和參考文獻(xiàn))。

對(duì)于電影和電視腳本,所有劇本均來(lái)自三個(gè)網(wǎng)站(https://www.scriptslug.com,https://thescriptlab.com/,https://8flix.com),包括2022年之后上映的電影和電視劇

2、長(zhǎng)依賴任務(wù)

摘要Summarization:直接使用每篇論文的摘要作為生成摘要的參考。摘要有效地捕捉了每篇論文的主要內(nèi)容和關(guān)鍵信息。

每個(gè)文檔的平均字?jǐn)?shù)在10,000到20,000之間,需要生成5到10個(gè)問(wèn)題。此外,參與者不得使用大型語(yǔ)言模型和ChatGPT等工具進(jìn)行文章閱讀、數(shù)據(jù)生成和標(biāo)注。

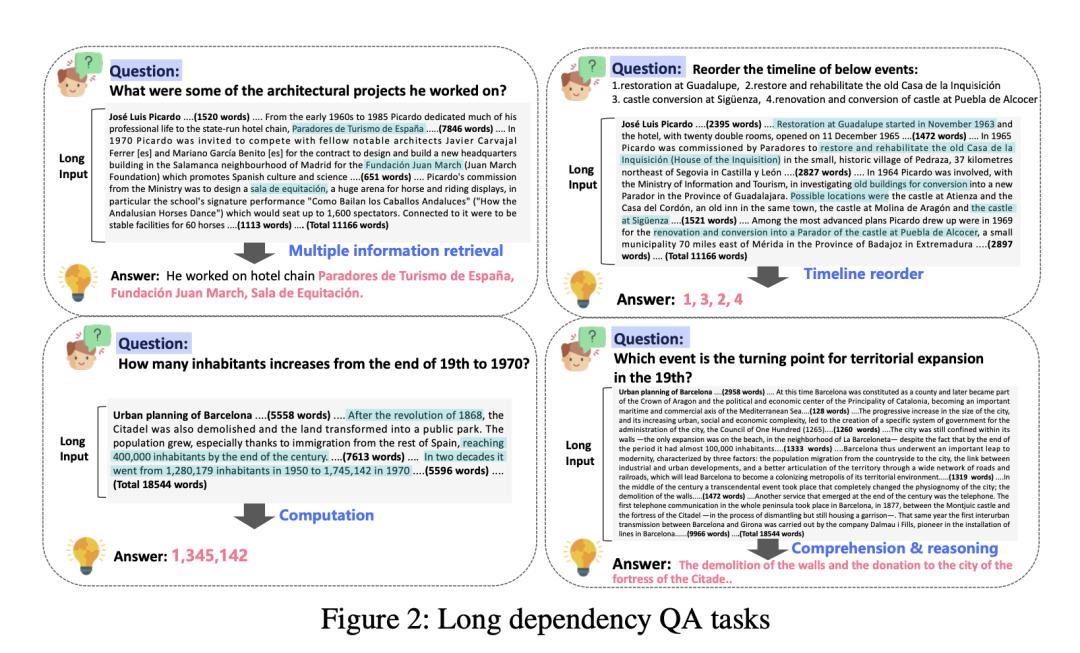

Long dependency QA長(zhǎng)依賴性問(wèn)答:花費(fèi)了大量精力手動(dòng)編制了約1.1k個(gè)真正的長(zhǎng)依賴性質(zhì)量保證對(duì)。該工作手動(dòng)設(shè)計(jì)了4個(gè)長(zhǎng)依賴性任務(wù):多重信息檢索、時(shí)間軸重排、計(jì)算、理解和推理,如圖2所示。

圖片

圖片

a.多重信息檢索Multiple information retrieval

與傳統(tǒng)的短期檢索任務(wù)完全不同,對(duì)于一個(gè)特定的答案,整個(gè)文本中通常存在多種多樣的證據(jù)。這項(xiàng)任務(wù)要求從廣泛分布的冗長(zhǎng)文本中提取大量信息,然后匯總證據(jù),得出最終答案。證據(jù)的呈現(xiàn)方式非常明顯,可以直接在原文的句子或章節(jié)中找到。

b.計(jì)算Computation

與前一項(xiàng)任務(wù)類似,它首先需要從大量文本中進(jìn)行多重信息檢索。文本中的大部分證據(jù)都以數(shù)字?jǐn)?shù)據(jù)的形式出現(xiàn),通常以問(wèn)題的形式出現(xiàn),如詢問(wèn)數(shù)量、頻率、持續(xù)時(shí)間、具體數(shù)字等。

要做出準(zhǔn)確的回答,必須深刻理解問(wèn)題及其與所提供的數(shù)字?jǐn)?shù)據(jù)之間的關(guān)聯(lián)。這一過(guò)程在很大程度上依賴于掌握大量背景信息的能力,同時(shí)還涉及一定程度的數(shù)學(xué)推理能力。

c.時(shí)間軸重排Timeline reorder

這項(xiàng)任務(wù)采用了較為傳統(tǒng)的形式,其中包括"請(qǐng)將下列事件的時(shí)間線重新排序"的指令,以及一組以排列順序呈現(xiàn)的事件。任務(wù)的目的是將這些事件按照時(shí)間順序排列在全文中。

這些事件直接來(lái)源于原文,可以是摘錄的片段,也可以是概括的事實(shí)信息。要成功完成這項(xiàng)任務(wù),就必須記住或全面理解文件的中心故事情節(jié),并評(píng)估模型在時(shí)間意識(shí)方面的熟練程度。

d.理解和推理Comprehension and reasoning

這項(xiàng)任務(wù)不僅要求對(duì)問(wèn)題有深刻的理解,還要求進(jìn)行復(fù)雜的推理,以辨別尋找適當(dāng)證據(jù)的內(nèi)在含義。最常見(jiàn)的問(wèn)題模式涉及對(duì)因果關(guān)系、影響、貢獻(xiàn)、態(tài)度以及與各種事件相關(guān)的基本屬性的探究。

這項(xiàng)任務(wù)的答案在原文中并不明顯。它們往往需要多步推理來(lái)模擬內(nèi)在的聯(lián)系和依賴關(guān)系,從而有助于通過(guò)復(fù)雜的分析過(guò)程獲得答案。

2、短依賴任務(wù)

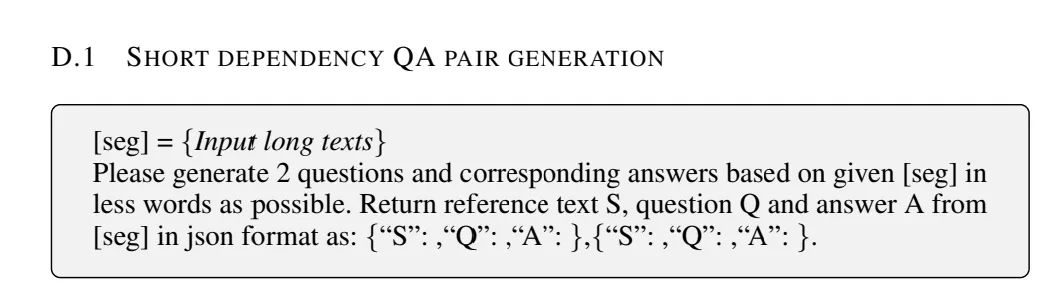

短依賴任務(wù)包括Question Answering (QA) 任務(wù)和Cloze任務(wù)。為了生成簡(jiǎn)短的依賴關(guān)系問(wèn)題解答對(duì),該工作利用了GPT3.5-turbo-16k。這些簡(jiǎn)短的依賴關(guān)系問(wèn)答對(duì)通常不需要大量的證據(jù)檢索,可以從本地化的片段中提取。

圖片

圖片

該工作將每篇文章分為多個(gè)片段,并采用迭代方法來(lái)提示語(yǔ)言模型(LLM)根據(jù)這些片段生成QA對(duì),包括文章中的相關(guān)支持證據(jù)。

隨后對(duì)QA對(duì)進(jìn)行人工審核,通過(guò)過(guò)濾非必要的上下文和刪除多余的描述來(lái)完善部分答案。這一嚴(yán)格的整理過(guò)程是為了確保所生成的QA對(duì)的高質(zhì)量和相關(guān)性。

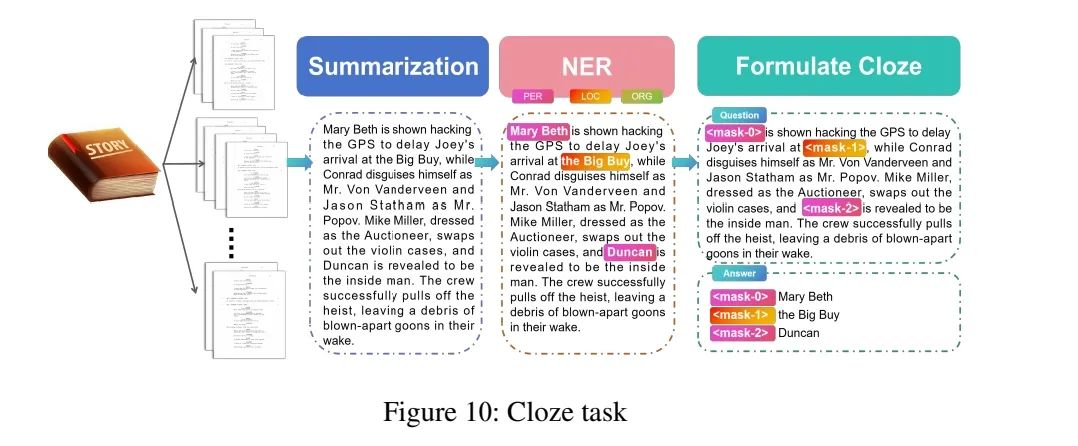

2、Cloze任務(wù)

最初,該工作將每個(gè)腳本分成不同長(zhǎng)度的片段。然后,該工作使用GPT3.5-turbo-16k生成與源片段一致的事實(shí)摘要以及提示中包含的一些限制條件(見(jiàn)附錄D)。

之后,使用BERT-large對(duì)生成的摘要進(jìn)行命名實(shí)體識(shí)別(NER),將類型限制為人名、地點(diǎn)和組織。

圖片

圖片

最后,從摘要中隨機(jī)選擇一定數(shù)量(不超過(guò)5個(gè))的實(shí)體作為占位符進(jìn)行屏蔽,標(biāo)記為""。該目標(biāo)是根據(jù)長(zhǎng)上下文預(yù)測(cè)被屏蔽的實(shí)體。

總結(jié)

本文主要針對(duì)長(zhǎng)文本評(píng)估,梳理了當(dāng)前具有代表性的長(zhǎng)文本評(píng)測(cè),包括Zero-SCROLLS、L-Eval、LongBench以及l(fā)oge四個(gè)基準(zhǔn)。

其中關(guān)于數(shù)據(jù)集的選取,任務(wù)的設(shè)計(jì),以及對(duì)現(xiàn)有模型的評(píng)估都具有很好的指引性,對(duì)于具體的細(xì)節(jié)信息,可以對(duì)參考文獻(xiàn)進(jìn)行查閱,會(huì)有更多的收獲。

參考文獻(xiàn)

1、https://arxiv.org/pdf/2311.04939.pdf

2、https://arxiv.org/abs/2308.14508

3、https://arxiv.org/pdf/2307.11088.pdf

4、https://arxiv.org/pdf/2305.14196.pdf

關(guān)于我們

老劉,劉煥勇,NLP開(kāi)源愛(ài)好者與踐行者,主頁(yè):https://liuhuanyong.github.io。