訓練130億大模型僅3天,北大提出Chat-UniVi統(tǒng)一圖片和視頻理解

- 論文地址:https://arxiv.org/pdf/2311.08046.pdf

- GitHub 地址:https://github.com/PKU-YuanGroup/Chat-UniVi

- Huggingface 地址:https://huggingface.co/Chat-UniVi

- Demo 地址:https://huggingface.co/spaces/Chat-UniVi/Chat-UniVi

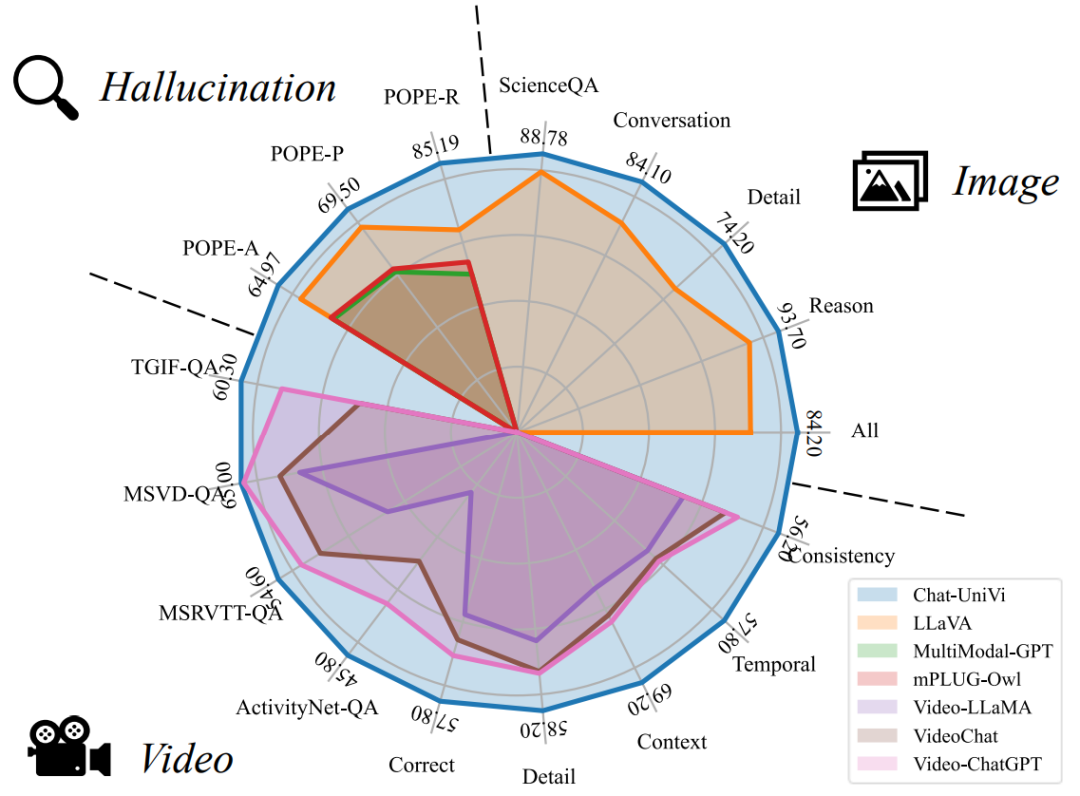

圖 1 Chat-UniVi 在圖片、視頻上的 17 個基準上達到先進的性能

具體來說,北京大學和中山大學的研究人員提出了一種名為 Chat-UniVi 的統(tǒng)一的視覺語言方案,其能通過統(tǒng)一的視覺表征同時處理圖片任務和視頻任務。作為一個統(tǒng)一的視覺理解模型,Chat-UniVi 以更少的視覺 token 數量,超過了專門針對圖片設計的多模態(tài)大模型和專門針對視頻設計的多模態(tài)大模型。更值得注意的是,所提出的統(tǒng)一的視覺表征極大減少了輸入視覺 token 的數量,大大降低了模型的訓練和推理成本,使得訓練一個具有 130 億參數的通用視覺語言大模型只需要三天。

在介紹本文方法之前,我們先看一下 Demo 展示:

方法介紹

現有的多模態(tài)語言模型通常只專注于圖片或視頻輸入。其中,專注于圖片理解的方法通常使用大量的視覺 token 來獲得更精細的空間分辨率。而專注于視頻理解的方法往往會犧牲每幀的空間分辨率,以輸入更多幀構建更精細的時間理解能力。

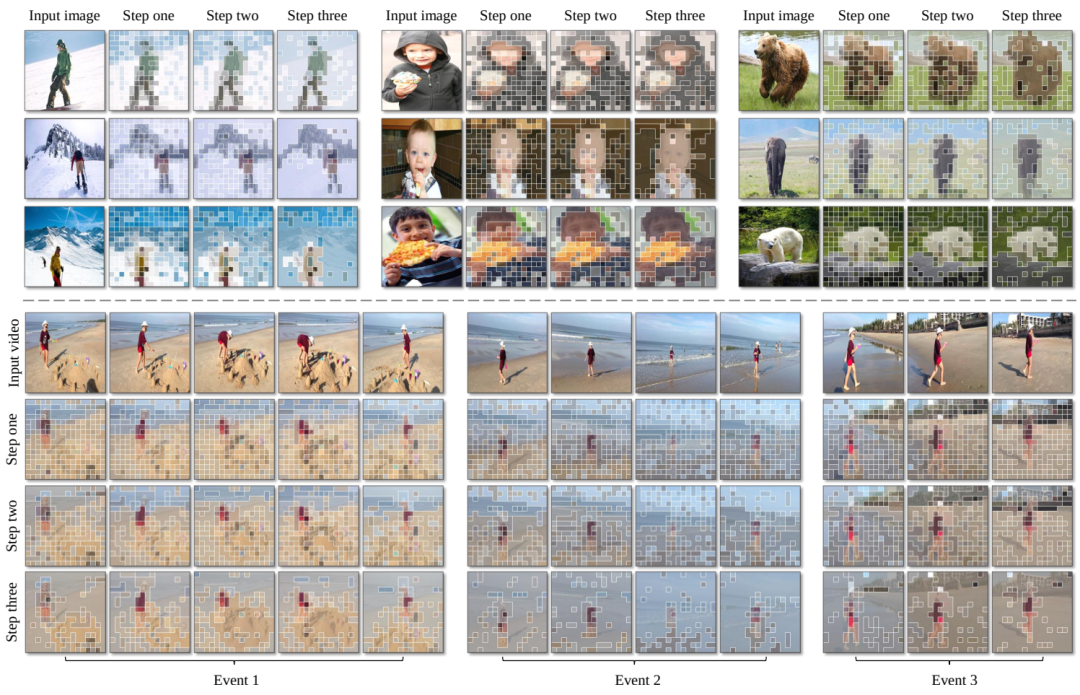

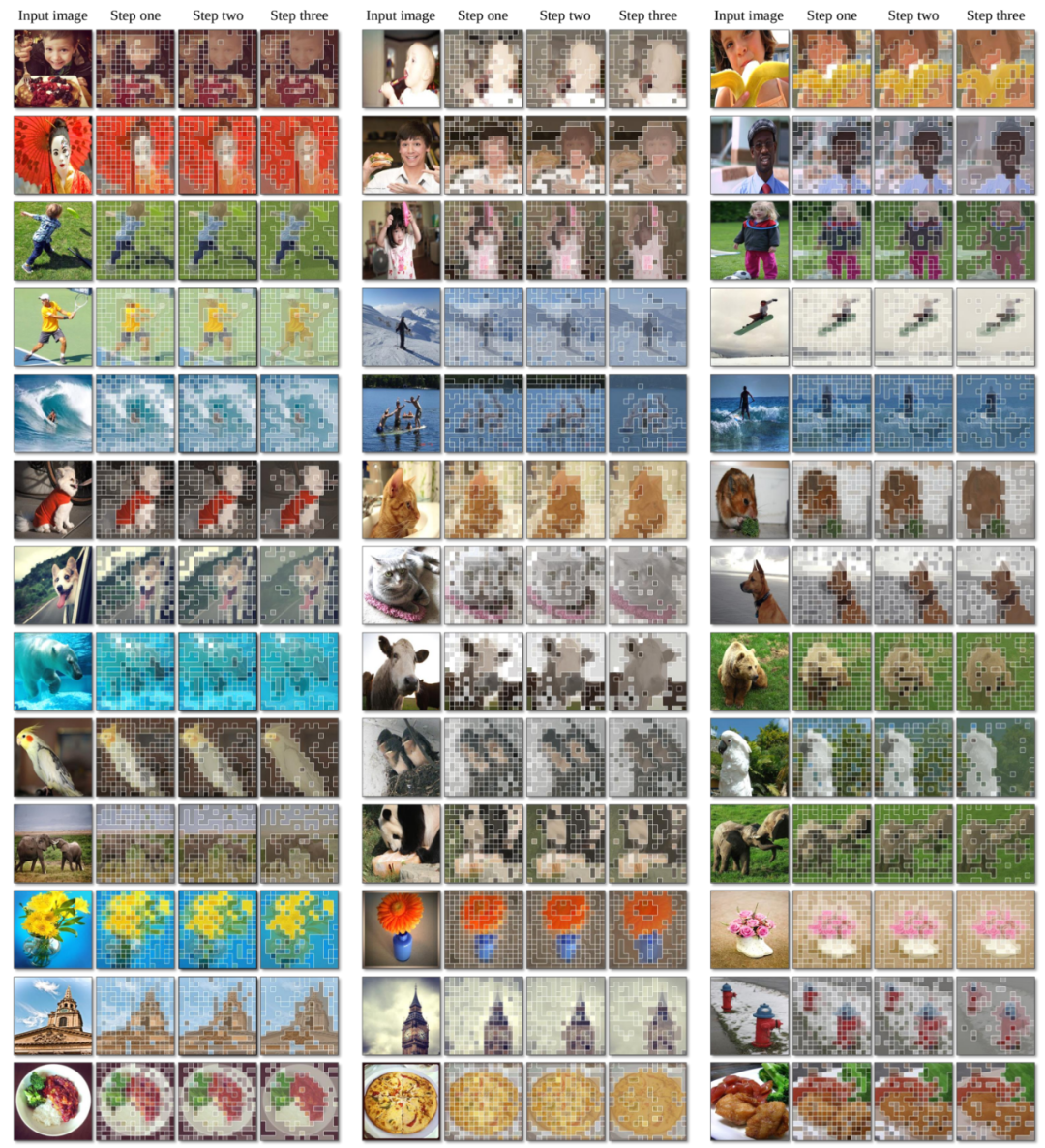

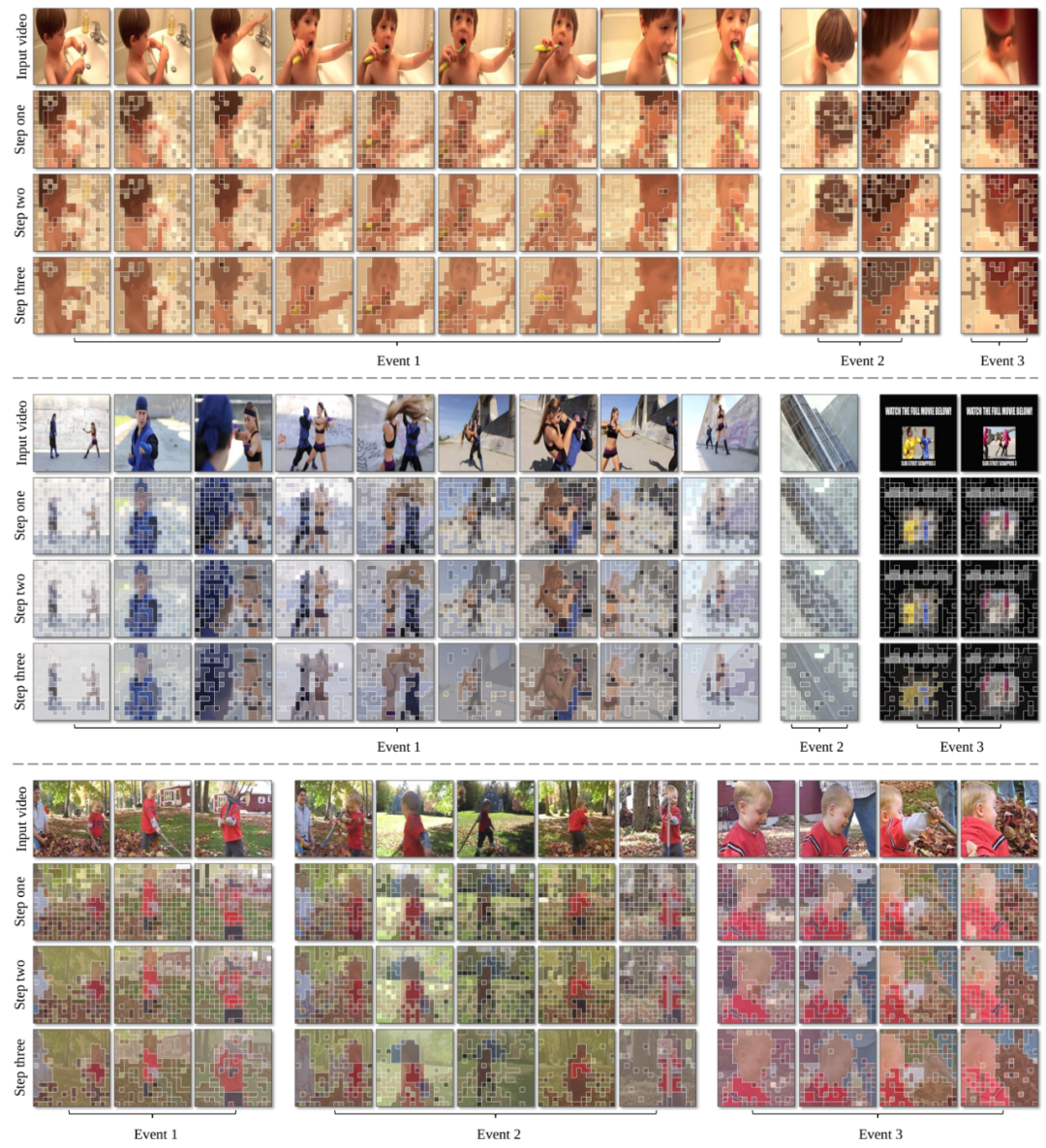

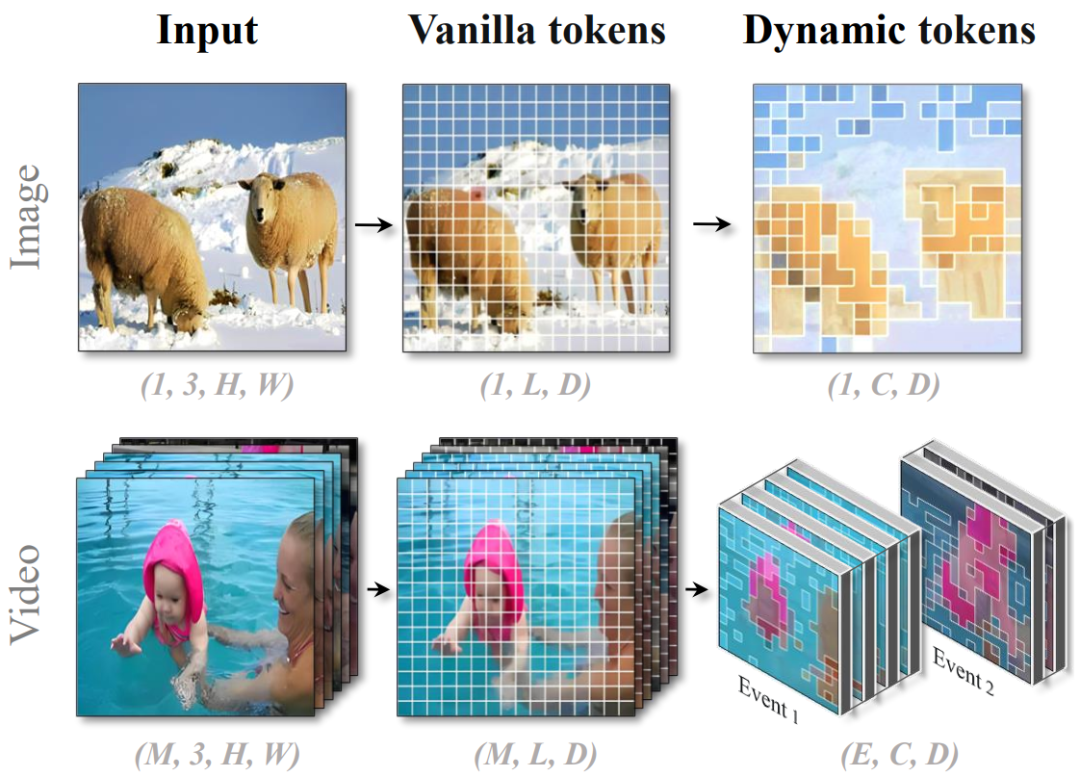

對此,研究人員提出使用一組動態(tài)視覺 token 統(tǒng)一表示圖片和視頻。如圖 2 所示,圖片可以通過不同大小的視覺 token 來建模。例如,主要對象 (即圖 2 中的羊) 需要使用更多視覺 token 進行細粒度表示,而背景 (即雪山) 只需使用一個視覺 token 即可充分建模。對于視頻來說,視頻首先會被分成多個關鍵事件,隨后視覺 token 會在事件內部進行拓展。這種圖片和視頻的統(tǒng)一表示大大減少了視覺 token 的數量,同時保持了模型的表達能力。值得注意的是,在該方法中,較長的視頻被分配了更多的視覺 token。因此,比現有的方法更適合于具有可變長度視頻的理解。

圖 2 Chat-UniVi 提出的統(tǒng)一視覺表征

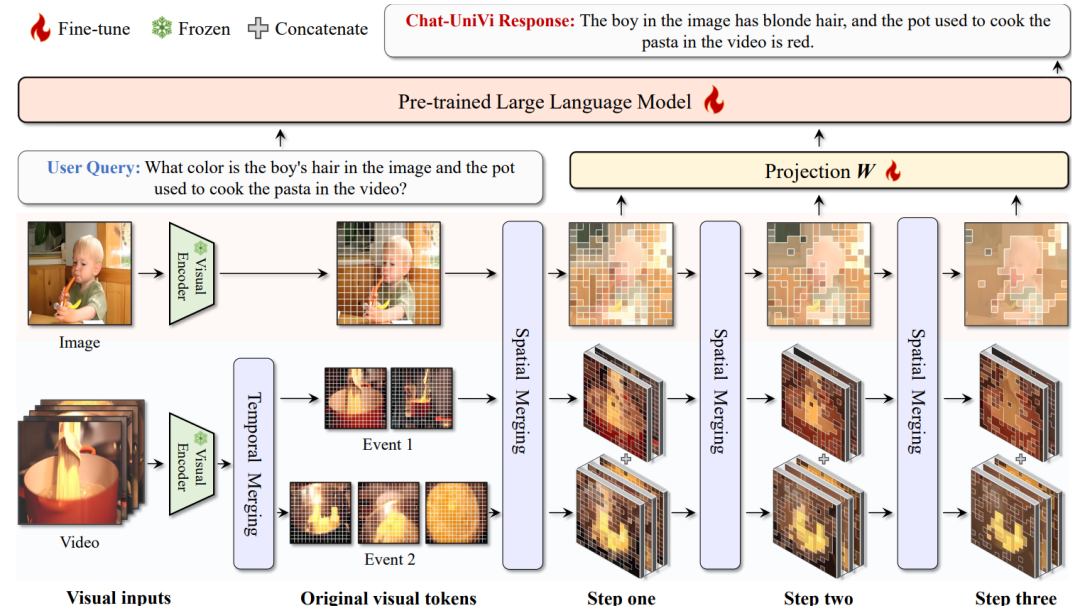

為了獲得這些動態(tài)的視覺 token,研究人員基于最近鄰的密度峰聚類算法,逐步對視覺 token 進行分組和合并。當涉及視頻時,同樣應用最近鄰的密度峰聚類算法來獲取事件的幀集合。為了進一步提升模型的性能,研究人員為 LLM 提供了一個多尺度表征,其中多尺度表征的上層特征表示高級語義概念,而下層特征強調視覺細節(jié)表示。

圖 3 Chat-UniVi 整體框架圖

Chat-UniVi 框架具有兩個引人注目的優(yōu)點:首先,其統(tǒng)一的圖片和視頻建模方法允許在圖片和視頻混合數據集上進行訓練,而無需任何修改即可直接應用于圖片和視頻任務。其次,多尺度表征有助于對圖片和視頻的全面理解,使 Chat-UniVi 能夠適應各種任務,包括使用高層次特征進行語義理解,使用低層次特征生成詳細描述。

Chat-UniVi 的訓練分為兩個階段:

(1)多模態(tài)預訓練。在第一階段,研究人員凍結 LLM 和視覺編碼器的同時只訓練投影矩陣。這種訓練策略使模型能夠有效地捕獲視覺信息,而不會對 LLM 的性能造成任何明顯的損害。

(2)聯(lián)合指令微調。在第二階段,研究人員在一個包含圖片和視頻的混合數據集上對整個模型進行了全參數微調。通過在混合數據集上的聯(lián)合訓練,Chat-UniVi 實現了對大量指令的卓越理解,并產生了更自然、更可靠的輸出。

實驗

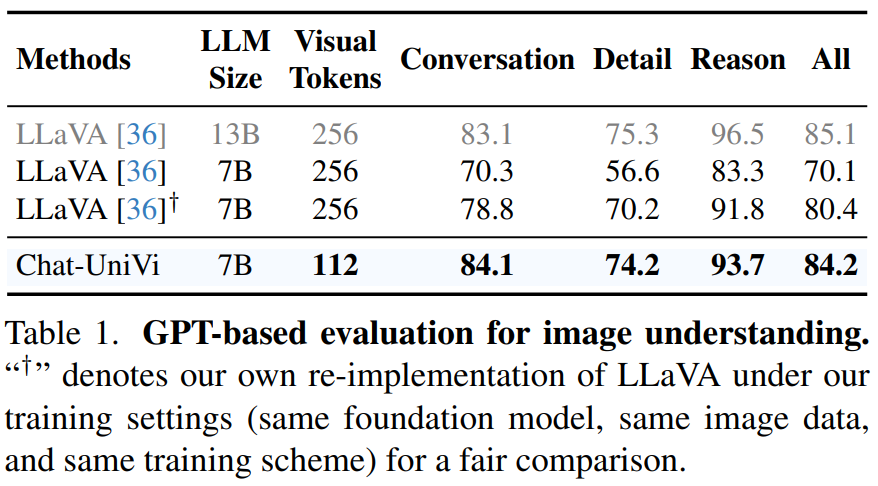

圖片理解實驗。Chat-UniVi 使用更少的視覺 token,同時實現卓越的性能。值得注意的是,Chat-UniVi 模型在 7B 參數下,也能達到 LLaVA 模型 13B 參數下的性能水平,證明了該方法的有效性。

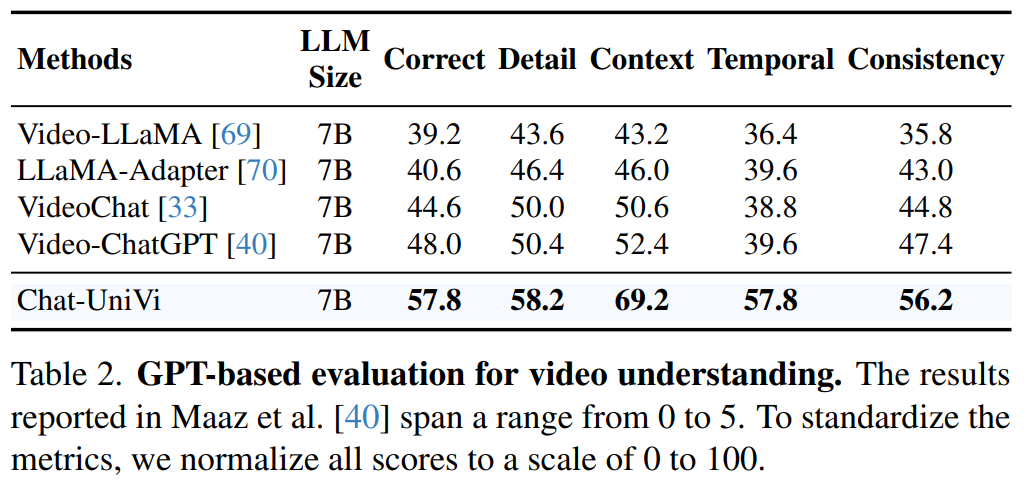

視頻理解實驗。Chat-UniVi 作為一個統(tǒng)一的視覺語言模型,超過了專門針對視頻設計的方法,例如 VideoChat 和 Video-ChatGPT。

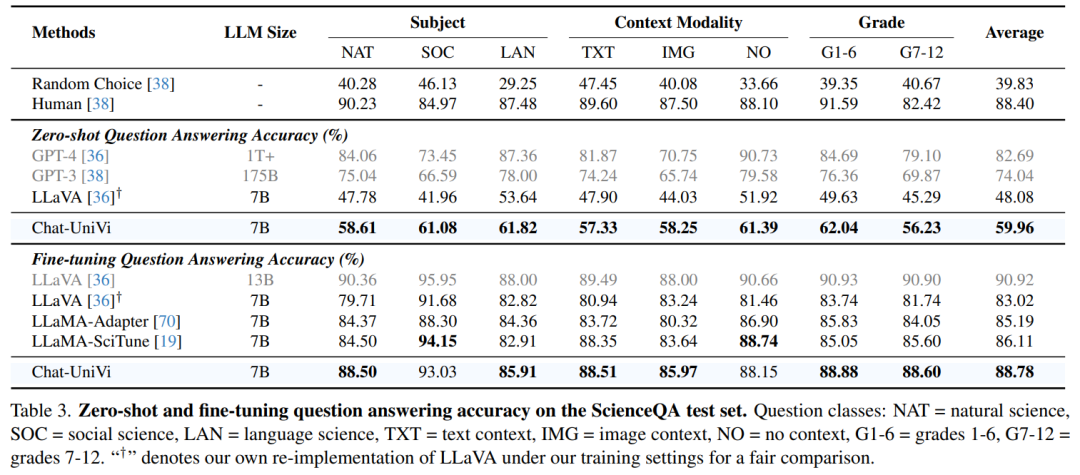

圖片問答實驗。Chat-UniVi 在 ScienceQA 數據集上獲得了有競爭力的性能。值得注意的是,Chat-UniVi 優(yōu)于專門針對科學問答進行優(yōu)化的 LLaMA-SciTune 模型,充分體現了該方法的優(yōu)越性。

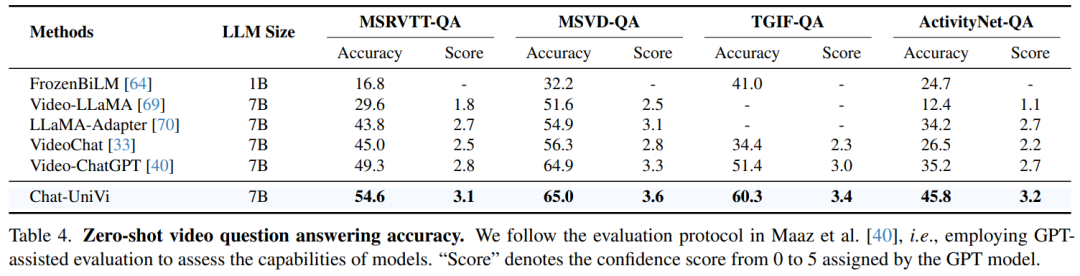

視頻問答實驗。在所有數據集上,Chat-UniVi 都優(yōu)于最先進的方法,例如 VideoChat 和 Video-ChatGPT。

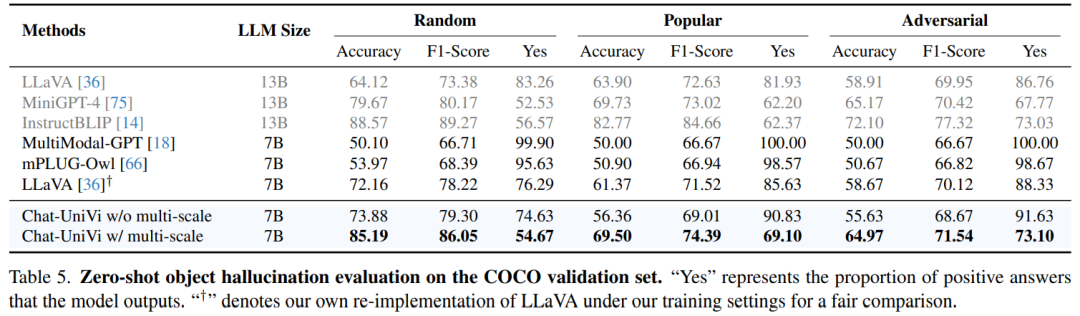

幻覺實驗。在幻覺評估上,Chat-UniVi 優(yōu)于最近提出的最先進的方法。此外,研究人員發(fā)現多尺度表征提高了抵抗幻覺的能力。值得注意的是,作為 7B 模型,Chat-UniVi 甚至優(yōu)于 13B 模型,如 MiniGPT4。研究人員將這一成功歸功于多尺度表征,多尺度表征使模型能夠同時感知高級語義概念和低級視覺外觀。

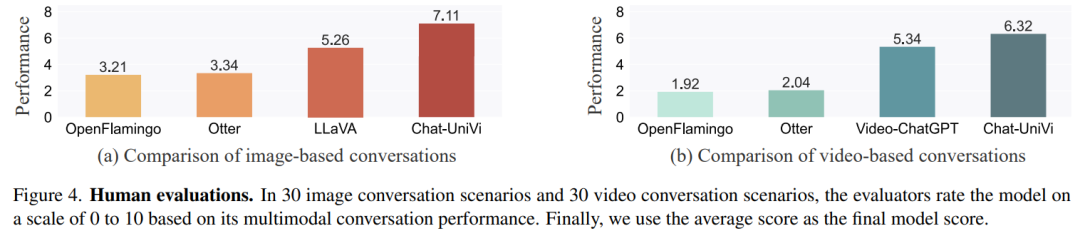

人工評測實驗。同時,研究人員也進行了人工評估實驗。研究人員發(fā)現基于 Flamingo 的方法在理解視頻的能力上存在局限性。這種限制歸因于它們使用 Q-Former 從不同長度的視頻中提取固定數量的視覺 token,這阻礙了它們在建模時間理解方面的有效性。相比之下,Chat-UniVi 作為一個統(tǒng)一的模型,不僅優(yōu)于基于 Flamingo 構建的方法,而且超過了專門為圖片和視頻設計的模型。

可視化。Chat-UniVi 所使用的動態(tài)視覺 token 有效地概括了對象和背景。這使 Chat-UniVi 能夠使用有限數量視覺 token 的同時構建圖片理解所需的細粒度的空間分辨率和視頻理解所需的細粒度時間分辨率。