不到60秒就能生成3D「手辦」,Meta發(fā)力3D生成,ChatGPT時(shí)刻要來(lái)了嗎?

一直以來(lái),創(chuàng)作 3D 內(nèi)容是設(shè)計(jì)和開(kāi)發(fā)視頻游戲、增強(qiáng)現(xiàn)實(shí)、虛擬現(xiàn)實(shí)以及影視特效中最重要的部分。

然而,3D 生成具有獨(dú)特而艱巨的挑戰(zhàn),這是圖像和視頻等其他生成內(nèi)容所不具備的。

- 首先,3D 內(nèi)容在藝術(shù)質(zhì)量、生成速度、3D 網(wǎng)格結(jié)構(gòu)和拓?fù)滟|(zhì)量、UV 貼圖結(jié)構(gòu)以及紋理清晰度和分辨率方面具有嚴(yán)格的標(biāo)準(zhǔn);

- 其次,與其他研究相比,可用的數(shù)據(jù)量少。雖然該領(lǐng)域有數(shù)十億張圖像和視頻可供學(xué)習(xí),但可用于訓(xùn)練的 3D 內(nèi)容數(shù)量要少三到四個(gè)數(shù)量級(jí)。因此,現(xiàn)階段的3D 生成還必須從非 3D 的圖像和視頻中學(xué)習(xí),而且需要從部分 2D 觀察中推斷出 3D 信息;

- 傳統(tǒng)方法生成的3D 資源通常難以實(shí)現(xiàn)逼真的照明和材質(zhì)屬性,從而限制了它們?cè)趯?zhuān)業(yè)工作流程中的實(shí)用性;

- 3D生成是一個(gè)非常耗費(fèi)算力的過(guò)程,主要因?yàn)樗婕暗綇?fù)雜的計(jì)算和大量的數(shù)據(jù)處理,如實(shí)時(shí)渲染、細(xì)節(jié)處理。并且由于算力不夠,可能會(huì)導(dǎo)致生成速度非常慢。

在生成式AI爆發(fā)的當(dāng)下,很多研究者開(kāi)始嘗試針對(duì)以上問(wèn)題提出解決方案。

剛剛,Meta發(fā)布了最新系統(tǒng)Meta 3D Gen (3DGen),其用不到一分鐘的時(shí)間,就能直接從文本生成3D資產(chǎn)。

- 論文地址:https://ai.meta.com/research/publications/meta-3d-gen/?cnotallow=24428397aaeb0cc6751570d48a532d36

3DGen支持基于物理的渲染 (PBR),這是在實(shí)際應(yīng)用中重新照明 3D 資產(chǎn)所必需的。此外,3DGen 還支持使用用戶提供的額外文本輸入對(duì)先前生成的(或藝術(shù)家創(chuàng)建的)3D 形狀進(jìn)行重新紋理化。

比如下面所展示的,借助3DGen,研究者渲染出了一只金屬色的小狗:

未來(lái)感滿滿的機(jī)器人:

3DGen還能對(duì)生成的對(duì)象紋理進(jìn)行進(jìn)一步編輯和定制,同樣的方法也可以應(yīng)用于藝術(shù)家創(chuàng)建的3D網(wǎng)格紋理而不需要修改。如下所示,3DGen將藝術(shù)家創(chuàng)建的3D資產(chǎn)渲染成彩色的蝴蝶。

蝴蝶「變身」為用粉色和綠色紗線編織的蝴蝶玩具。

通過(guò)展示可以看出,即使是復(fù)雜的文本提示,3DGen也能很好地遵循指令,生成的3D形狀和紋理質(zhì)量也比較好。

以下是論文中的具體信息。

Meta 3D Gen基本原理

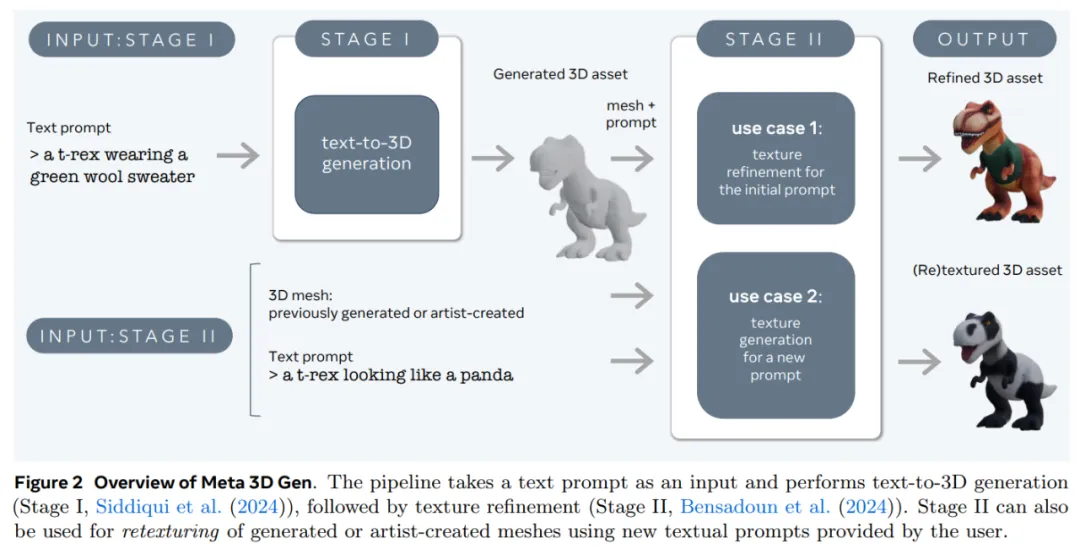

Meta 3D Gen 是一種兩階段方法,包括兩個(gè)關(guān)鍵組件:用于創(chuàng)建 3D 網(wǎng)格的 Meta 3D AssetGen 和用于生成紋理的 Meta 3D TextureGen。

這些技術(shù)協(xié)同工作,可生成具有高分辨率紋理和PBR材質(zhì)的 3D 資產(chǎn)。Meta表示,該流程的速度是現(xiàn)有解決方案的 3 到 10 倍。

第一階段為3D 資產(chǎn)生成階段。在這一階段,根據(jù)用戶提供的文本提示,Meta 3D AssetGen(簡(jiǎn)稱(chēng) AssetGen)創(chuàng)建初始 3D 資產(chǎn)。此步驟生成具有紋理和 PBR 材質(zhì)貼圖的 3D 網(wǎng)格。推理時(shí)間約為 30 秒。

接下來(lái)是第二階段。給定第一階段生成的 3D 資產(chǎn)和用于生成的初始文本提示,第二階段將基于該資產(chǎn)和提示生成更高質(zhì)量的紋理和 PBR 貼圖。第二階段用到了文本到紋理生成器 Meta 3D TextureGen(簡(jiǎn)稱(chēng)為 TextureGen)。推理時(shí)間約為 20 秒。

此外,給定一個(gè)無(wú)紋理的 3D 網(wǎng)格和描述其所需外觀的提示,第二階段還可用于從頭開(kāi)始為該 3D 資產(chǎn)生成紋理(網(wǎng)格可以是先前生成的,也可以是藝術(shù)家創(chuàng)建的)。推理時(shí)間約為 20 秒。

下圖為第一階段和第二階段可視化對(duì)比。后者往往具有更高的視覺(jué)美感,看起來(lái)更逼真,細(xì)節(jié)頻率更高。

我們不難發(fā)現(xiàn),3DGen 以 AssetGen 和 TextureGen 為基礎(chǔ),將3D 對(duì)象的三個(gè)關(guān)鍵信息進(jìn)行了很好的互補(bǔ):視圖空間(對(duì)象的圖像)、體積空間(3D 形狀和外觀)和 UV 空間(紋理)。

此過(guò)程從 AssetGen 開(kāi)始,通過(guò)使用一個(gè)多視角和多通道的文本到圖像生成器,生成關(guān)于物體的幾個(gè)相對(duì)一致的視圖。接著,AssetGen中的一個(gè)重建網(wǎng)絡(luò)會(huì)在體積空間中提取出3D對(duì)象的第一個(gè)版本。此過(guò)程接著進(jìn)行網(wǎng)格提取,建立對(duì)象的3D形狀和其紋理的初步版本,這一系列步驟構(gòu)成了從文本描述到3D模型的轉(zhuǎn)換過(guò)程。最后,TextureGen 組件利用視圖空間和 UV 空間生成的組合來(lái)重新生成紋理,提高紋理質(zhì)量和分辨率,同時(shí)保持對(duì)初始提示的保真度。

實(shí)驗(yàn)對(duì)比

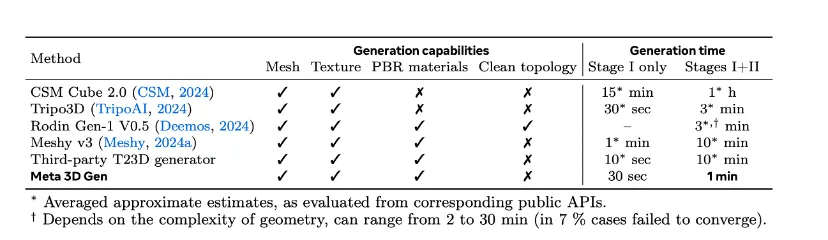

運(yùn)行時(shí)間和功能上的對(duì)比

論文將3DGen的性能與業(yè)界領(lǐng)先的文本到3D生成模型進(jìn)行了比較,包括 CSM、Tripo3D、Rodin Gen-1 V0.5、Meshy v3等。

在時(shí)間上,stage1最快的是Tripo3D(經(jīng)過(guò)筆者實(shí)測(cè),Tripo3D線上版本目前stage1為10秒,stage2是2分鐘);stage2最快的是Meta 3D Gen,Tripo3D緊隨其后,Rodin Gen-1 V0.5排名第三,用了2-30分鐘完成。

在功能上,除了Rodin支持重拓?fù)渲猓P者實(shí)測(cè)Tripo3D也支持retopology。

定量評(píng)測(cè)指標(biāo)

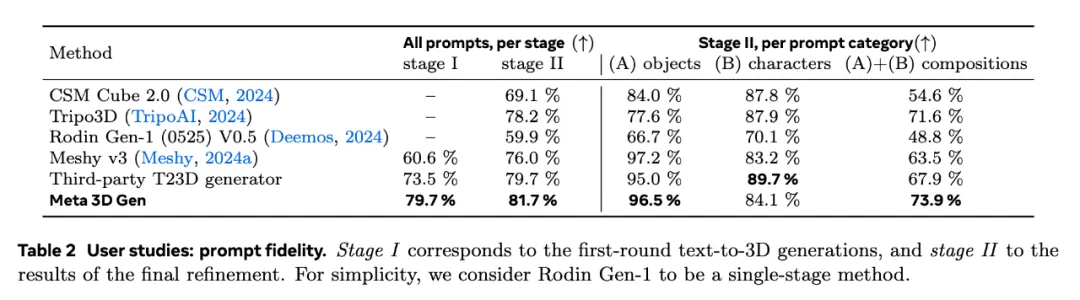

表2主要表現(xiàn)了不同模型遵循 prompt的結(jié)果。主要關(guān)注text-to-3D,實(shí)驗(yàn)中用了來(lái)自2023 Google DreamFusion論文中的404個(gè)prompt,細(xì)分為物體(156)、角色(106) ,組合角色物體 (141),難度由低到高。定量對(duì)比部分全部是user study(用戶偏好)。

結(jié)果表明:在text-to-3D比較重要的prompt fidelity指標(biāo)上:

- 綜合排序?yàn)椋篗eta 3D Gen > Third-party T23D generator > Tripo3D > Meshy v3 > CSM Cube 2.0 > Rodin Gen-1 。其中前三名差距很小(3個(gè)點(diǎn)的差距,404個(gè)prompt中的12個(gè))。CSM和Rodin相較其他方法有明顯差異,Rodin和3DGen相比,兩者相差 21.8個(gè)點(diǎn)。

- 分項(xiàng)評(píng)測(cè)方面,最簡(jiǎn)單的objects中表現(xiàn)最好的是Meshy v3。角色類(lèi)和復(fù)雜組合概念的表現(xiàn)代表了技術(shù)水準(zhǔn),也是3D產(chǎn)業(yè)應(yīng)用中最重要的部分,Meta在復(fù)雜組合上排名第一,Tripo3D則是難度越高表現(xiàn)越強(qiáng),僅次于Meta,和第一名差距很小。

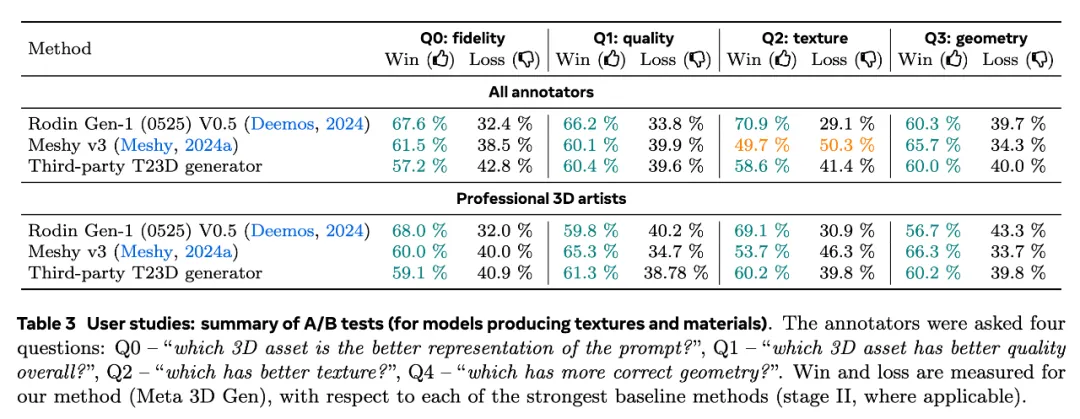

表3比較了Meta和其他方法的A/B win rate和loss rate結(jié)果,數(shù)字win rate越低代表所對(duì)比方法越強(qiáng),loss rate越高代表所對(duì)比方法越強(qiáng),可以得出:

- Meshy v3紋理分最高、Rodin紋理分最低;

- Rodin幾何分比較高;

- 在綜合性一致性、整體質(zhì)量方面,Rodin表現(xiàn)不佳;

- All users和專(zhuān)業(yè)用戶打分標(biāo)準(zhǔn)可以看出略有不同,但排名趨勢(shì)是一樣的:對(duì)幾何和紋理的正確性給予了更多的權(quán)重;

上圖橫坐標(biāo)是前面提到的prompt復(fù)雜度,縱坐標(biāo)是Meta win rate,低于50%說(shuō)明對(duì)比方法比Meta好,折線越低說(shuō)明方法越好。圖中比較了多個(gè)維度,包括prompt還原度、綜合視覺(jué)質(zhì)量、幾何視覺(jué)質(zhì)量、紋理細(xì)節(jié)、紋理瑕疵等指標(biāo)。

Meta在論文中談到越復(fù)雜的prompt,他們的方法優(yōu)勢(shì)越明顯,這個(gè)其實(shí)和前面Table 2中Tripo3D的趨勢(shì)和優(yōu)勢(shì)是一致的。可以推測(cè)如果這里加上Tripo3D,Tripo和Meta應(yīng)該不分伯仲。

定性質(zhì)量對(duì)比

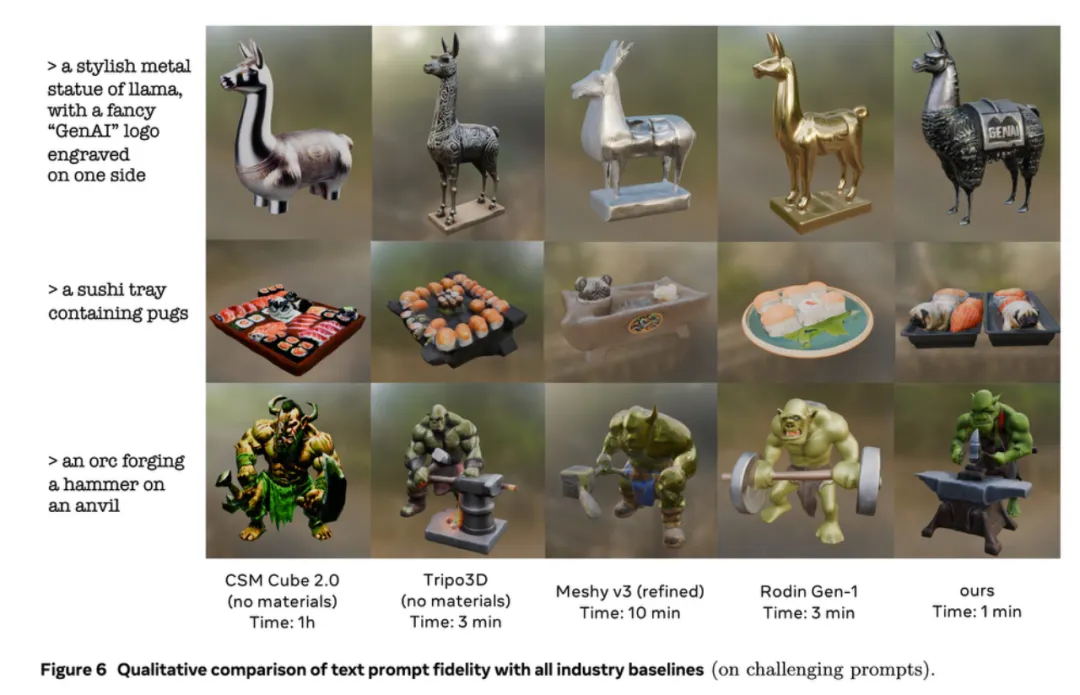

在這篇論文中,Meta還給出了幾個(gè)模型的定性結(jié)果對(duì)比圖,我們可以從這些圖中看出一些差別。

從prompt遵循程度來(lái)看,3DGen表現(xiàn)優(yōu)秀,比如對(duì)于第一行的羊駝雕塑,它可以把prompt中提到的logo文字寫(xiě)上。但以第三行的case為例,CSM的語(yǔ)義理解較弱,Tripo則展現(xiàn)了其他模型都失敗的「被鍛造的錘子」,甚至還基于推理生成了3DGen沒(méi)有考慮到的炭火。

但綜合幾何細(xì)節(jié)和紋理細(xì)節(jié)來(lái)看,3DGen的紋理細(xì)節(jié)略顯粗糙,Meshy和Rodin的第一行幾乎沒(méi)什么紋理,而Tripo3D的紋理結(jié)果則要好得多,幾何細(xì)節(jié)非常豐富,人、物也更保真,不像3DGen一樣有時(shí)候臉會(huì)垮掉。

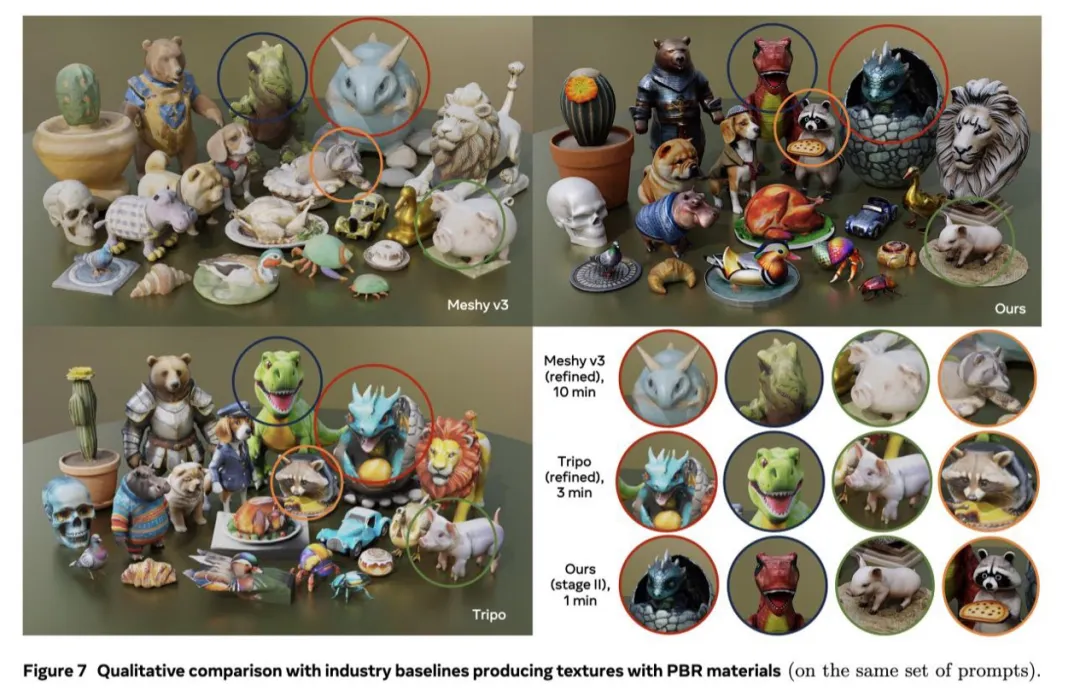

圖7表現(xiàn)了同一場(chǎng)景下的比較結(jié)果,包括 Tripo3D 、Meshy v3 、以及 3DGen。綜合來(lái)看,Meshy方法生成的紋理瑕疵多一些、生成的幾何粗糙一些;放大來(lái)看,Tripo和3DGen效果不相上下,但Tripo生成結(jié)果更形象、靈動(dòng)一些。

筆者用Tripo嘗試了測(cè)試集中的龍蛋效果

3D生成來(lái)到「ChatGPT時(shí)刻」前夜

3D生成賽道其實(shí)一直是資本市場(chǎng)的寵兒。A16Z接連對(duì)3D生成賽道出手,除了最近名聲大噪的Luma Labs之外,Meta論文中提到的CSM,Google系的Yellow,還有曾經(jīng)爭(zhēng)議較大的Kaedim都是A16Z的被投明星企業(yè)。

在Meta論文中參與比較的工作中Meshy出自知名學(xué)者胡淵鳴的團(tuán)隊(duì),Tripo則出自之前和Stability AI發(fā)布TripoSR的團(tuán)隊(duì)VAST。

Meta此篇論文中引用了不少VAST團(tuán)隊(duì)的論文,不僅包括TripoSR,也包括剛被ECCV收錄的UniDream、曾經(jīng)爆火的Wonder3D、Triplane meets Gaussian splatting等等。

據(jù)筆者根據(jù)Tripo官方海外媒體信息,全球開(kāi)發(fā)者已經(jīng)基于TRIPO生成了近四百萬(wàn)個(gè)3D模型,TripoSR上線一周就在Github上拿到了3K+的star量。基于這種人氣,Tripo社區(qū)也推出了全球第一個(gè)AI 3D全球渲染大賽。

據(jù)筆者調(diào)研,不管是CG還是3D打印領(lǐng)域都有許多目前的落地探索,不管是全球最大的3D素材交易網(wǎng)站CG模型網(wǎng)定向邀請(qǐng)創(chuàng)作者測(cè)試,還是3D打印龍頭開(kāi)始探索AI,都體現(xiàn)出比想象中更快的商業(yè)化落地速度。

VAST上線Anycubic的模型社區(qū)網(wǎng)站Makeronline和CG模型網(wǎng)

Keadim則選擇和初創(chuàng)團(tuán)隊(duì)Nakkara一起探索3D打印業(yè)務(wù):

總體來(lái)看,3D生成技術(shù)在學(xué)術(shù)和行業(yè)落地層面都不斷取得突破性進(jìn)展,我們有理由相信,3D大模型會(huì)釋放更多潛力。