不止3D高斯!最新綜述一覽最先進的3D重建技術

本文經自動駕駛之心公眾號授權轉載,轉載請聯系出處。

寫在前面&筆者的個人理解

基于圖像的3D重建是一項具有挑戰性的任務,涉及從一組輸入圖像推斷目標或場景的3D形狀。基于學習的方法因其直接估計3D形狀的能力而受到關注。這篇綜述論文的重點是最先進的3D重建技術,包括生成新穎的、看不見的視圖。概述了高斯飛濺方法的最新發展,包括輸入類型、模型結構、輸出表示和訓練策略。還討論了尚未解決的挑戰和未來的方向。鑒于該領域的快速進展以及增強3D重建方法的眾多機會,對算法進行全面檢查似乎至關重要。因此,本研究對高斯散射的最新進展進行了全面的概述。

(大拇指往上滑,點擊最上方的卡片關注我,整個操作只會花你 1.328 秒,然后帶走未來、所有、免費的干貨,萬一有內容對您有幫助呢~)

三維重建與新視圖合成入門

3D重建和NVS是計算機圖形學中兩個密切相關的領域,旨在捕捉和渲染物理場景的逼真3D表示。3D重建涉及從通常從不同視點捕獲的一系列2D圖像中提取幾何和外觀信息。盡管有許多用于3D掃描的技術,但這種對不同2D圖像的捕捉是收集關于3D環境的信息的非常簡單且計算成本低廉的方式。然后,這些信息可以用于創建場景的3D模型,該3D模型可以用于各種目的,例如虛擬現實(VR)應用、增強現實(AR)覆蓋或計算機輔助設計(CAD)建模。

另一方面,NVS專注于從先前獲取的3D模型生成場景的新2D視圖。這允許從任何期望的視點創建場景的逼真圖像,即使原始圖像不是從那個角度拍攝的。深度學習的最新進展導致了3D重建和NVS的顯著改進。深度學習模型可用于有效地從圖像中提取3D幾何結構和外觀,此類模型也可用于從3D模型中生成逼真的新穎視圖。因此,這些技術在各種應用中越來越受歡迎,預計它們在未來將發揮更重要的作用。

本節將介紹如何存儲或表示3D數據,然后介紹用于該任務的最常用的公開數據集,然后將擴展各種算法,主要關注高斯飛濺。

3D數據表示

三維數據的復雜空間性質,包括體積維度,提供了目標和環境的詳細表示。這對于在各個研究領域創建沉浸式模擬和精確模型至關重要。三維數據的多維結構允許結合深度、寬度和高度,從而在建筑設計和醫學成像技術等學科中取得重大進步。

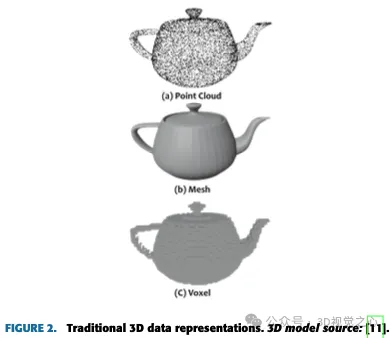

數據表示的選擇在眾多3D深度學習系統的設計中起著至關重要的作用。點云缺乏網格狀結構,通常不能直接進行卷積。另一方面,以網格狀結構為特征的體素表示通常會產生高的計算內存需求。

3D表示的演變伴隨著3D數據或模型的存儲方式。最常用的3D數據表示可以分為傳統方法和新穎方法。

Traditional Approaches:

- Point cloud

- Mesh

- Voxel

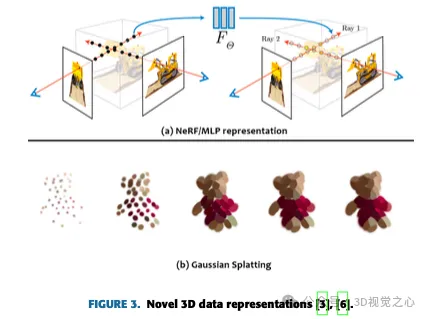

Novel Approaches:

- Neural Network/Multi layer perceptron (MLP)

- Gaussian Splats

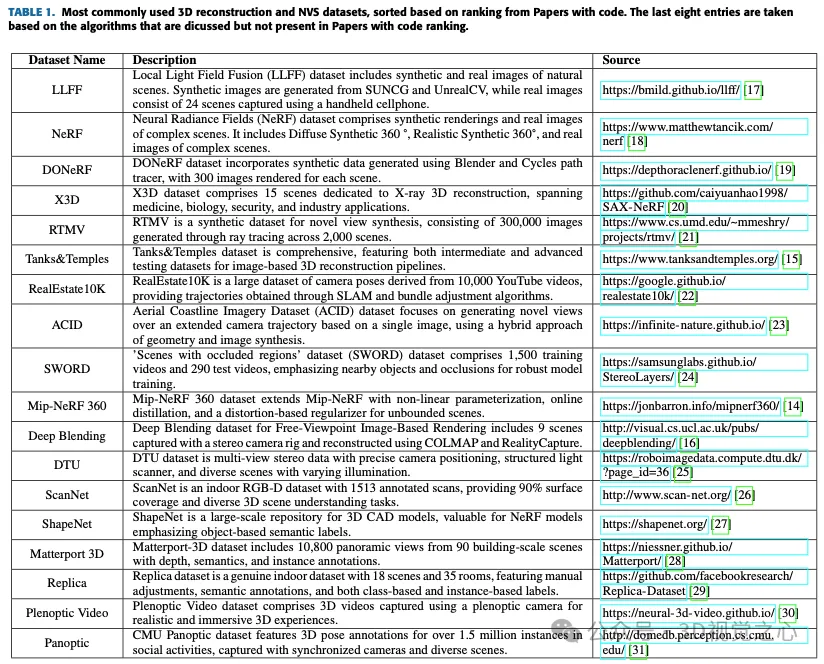

數據集

三維重建與NVS技術

為了評估該領域的當前進展,進行了一項文獻研究,確定并仔細審查了相關的學術著作。分析特別集中在兩個關鍵領域:三維重建和NVS。從多個相機圖像進行3D體積重建的發展跨越了幾十年,在計算機圖形學、機器人和醫學成像中有著不同的應用。下一部分將探討該技術的現狀。

攝影測量:自20世紀80年代以來,出現了先進的攝影測量和立體視覺技術,自動識別立體圖像對中的對應點。攝影測量是一種將攝影和計算機視覺相結合來生成物體或場景的3D模型的方法。它需要從各種角度捕捉圖像,利用Agisoft Metashape等軟件來估計相機位置并生成點云。該點云隨后被轉換為有紋理的3D網格,從而能夠創建重建目標或場景的詳細和照片級真實感可視化。

Structure from motion:在20世紀90年代,SFM技術獲得了突出地位,能夠從2D圖像序列中重建3D結構和相機運動。SFM是從一組2D圖像中估計場景的3D結構的過程。SFM需要圖像之間的點相關性。通過匹配特征或跟蹤多個圖像中的點來找到對應的點,并進行三角測量以找到3D位置。

深度學習:近年來,深度學習技術,特別是卷積神經網絡(CNNs)得到了融合。基于深度學習的方法在三維重建中加快了步伐。最值得注意的是3D占用網絡,這是一種為3D場景理解和重建而設計的神經網絡架構。它通過將3D空間劃分為小的體積單元或體素來操作,每個體素表示它是包含目標還是為空空間。這些網絡使用深度學習技術,如3D卷積神經網絡,來預測體素占用率,使其對機器人、自動駕駛汽車、增強現實和3D場景重建等應用具有價值。這些網絡在很大程度上依賴于卷積和變換器。它們對于避免碰撞、路徑規劃和與物理世界的實時交互等任務至關重要。此外,3D占用網絡可以估計不確定性,但在處理動態或復雜場景時可能存在計算限制。神經網絡架構的進步不斷提高其準確性和效率。

神經輻射場:NeRF于2020年推出,它將神經網絡與經典的三維重建原理相結合,在計算機視覺和圖形學中引起了顯著關注。它通過建模體積函數、通過神經網絡預測顏色和密度來重建詳細的3D場景。NeRFs在計算機圖形學和虛擬現實中得到了廣泛應用。最近,NeRF通過廣泛的研究提高了準確性和效率。最近的研究還探討了NeRF在水下場景中的適用性。雖然提供3D場景幾何的魯棒表示,但計算需求等挑戰仍然存在。未來的NeRF研究需要專注于可解釋性、實時渲染、新穎的應用程序和可擴展性,為虛擬現實、游戲和機器人技術開辟道路。

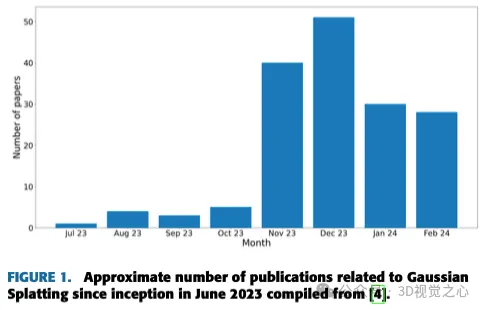

高斯散射:最后,在2023年,3D高斯散射作為一種新的實時3D渲染技術出現了。在下一節中,將詳細討論這種方法。

GAUSSIAN SPLATTING的基礎

高斯飛濺使用許多3D高斯或粒子來描繪3D場景,每個高斯或粒子都配有位置、方向、比例、不透明度和顏色信息。若要渲染這些粒子,請將其轉換為二維空間,并對其進行戰略性組織以實現最佳渲染。

圖4顯示了高斯飛濺算法的體系結構。在原始算法中,采取了以下步驟:

- Structure from motion

- Convert to gaussian splats

- Training

- Differentiable Gaussian rasterization

STATE OF ART

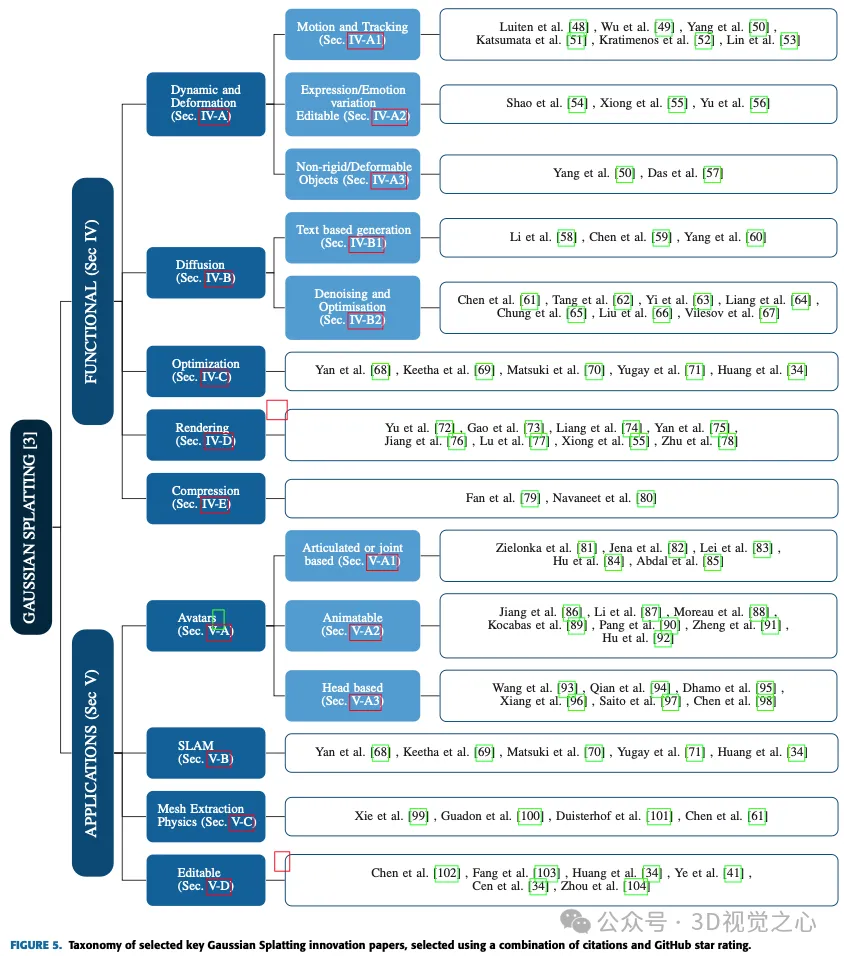

在接下來的兩節中,將探索高斯飛濺的各種應用和進步,深入研究其在自動駕駛、化身、壓縮、擴散、動力學和變形、編輯、基于文本的生成、網格提取和物理、正則化和優化、渲染、稀疏表示以及同時定位和映射(SLAM)等領域的不同實現。將對每個子類別進行檢查,以深入了解高斯飛濺方法在應對特定挑戰和在這些不同領域取得顯著進展方面的多用途。圖5顯示了所有方法的完整列表。

FUNCTIONAL ADVANCEMENTS

本節考察了自首次引入高斯飛濺算法以來在功能能力方面取得的進展。

動態及變形

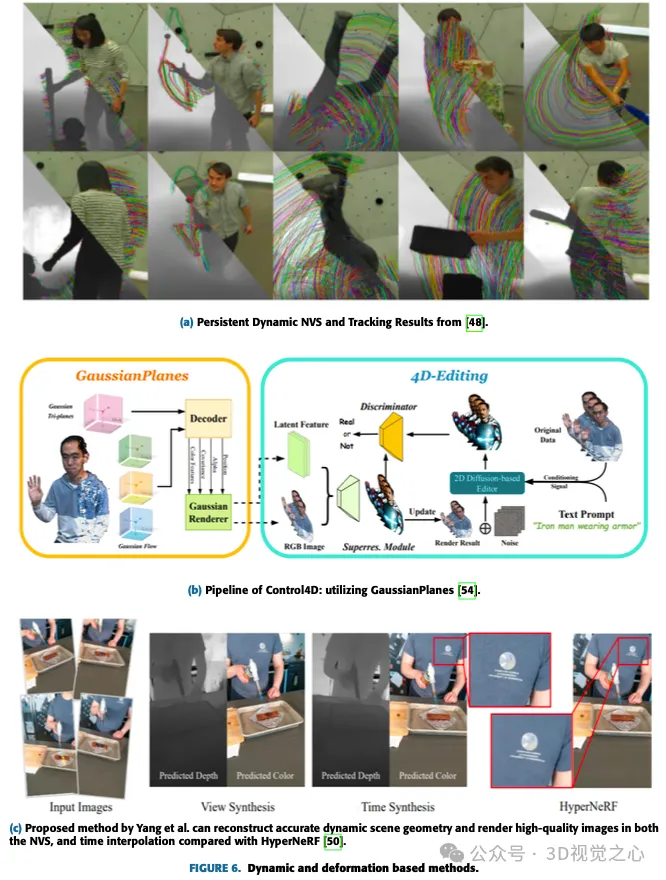

與一般的高斯飛濺相比,其中3D協方差矩陣的所有參數僅取決于輸入圖像,在這種情況下,為了捕捉飛濺隨時間的動態,一些參數取決于時間或時間步長。例如,位置取決于時間步長或幀。該位置可以由下一幀以時間一致的方式更新。還可以學習一些潛在的編碼,這些編碼可以用于在渲染期間的每個時間步長中編輯或傳播高斯,以實現某些效果,如化身中的表情變化,以及向非剛體施加力。圖6顯示了一些基于動力學和變形的方法。

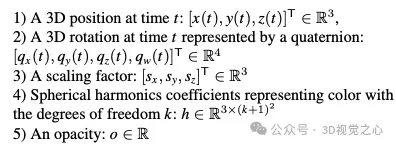

動態和可變形模型可以很容易地通過對原始高斯飛濺表示的輕微修改來表示:

Motion and Tracking

大多數與動態高斯飛濺相關的工作都擴展到跨時間步長的3D高斯運動跟蹤,而不是每個時間步長都有一個單獨的飛濺。Katsumata等人提出了位置的傅立葉近似和旋轉四元數的線性近似。

Luiten等人的論文介紹了一種在動態場景中捕獲所有3D點的全6個自由度的方法。通過結合局部剛度約束,動態3D高斯表示一致的空間旋轉,實現了密集的6自由度跟蹤和重建,而無需對應或流輸入。該方法在2D跟蹤中優于PIP,實現了10倍低的中值軌跡誤差、更高的軌跡精度和100%的生存率。這種通用的表示方式有助于4維視頻編輯、第一人稱視圖合成和動態場景生成等應用。

Lin等人介紹了一種新的雙域變形模型(DDDM),該模型被明確設計為對每個高斯點的屬性變形進行建模。該模型使用頻域的傅立葉級數擬合和時域的多項式擬合來捕獲與時間相關的殘差。DDDM擅長處理復雜視頻場景中的變形,無需為每幀訓練單獨的3D高斯飛濺(3D-GS)模型。值得注意的是,離散高斯點顯式變形建模保證了快速訓練和4D場景渲染,類似于用于靜態3D重建的原始3D-GS。這種方法具有顯著的效率提高,與3D-GS建模相比,訓練速度幾乎快了5倍。然而,在最終渲染中,在保持高保真度薄結構方面存在增強的機會。

Expression or Emotion variation and Editable in Avatars

Shao等人介紹了GaussianPlanes,這是一種通過在三維空間和時間中基于平面的分解實現的4D表示,提高了4D編輯的有效性。此外,Control4D利用4D生成器優化不一致照片的連續創建空間,從而獲得更好的一致性和質量。所提出的方法使用GaussianPlanes來訓練4D肖像場景的隱式表示,然后使用高斯渲染將其渲染為潛在特征和RGB圖像。基于生成對抗性網絡(GAN)的生成器和基于2D擴散的編輯器對數據集進行細化,并生成真實和虛假圖像進行區分。判別結果有助于生成器和鑒別器的迭代更新。然而,由于依賴于具有流量表示的規范高斯點云,該方法在處理快速和廣泛的非剛性運動方面面臨挑戰。該方法受ControlNet的約束,將編輯限制在粗略級別,并阻止精確的表達或動作編輯。此外,編輯過程需要迭代優化,缺少一個單一步驟的解決方案。

Non-Rigid or deformable objects

隱式神經表示在動態場景重建和渲染中帶來了重大變革。然而,當代動態神經渲染方法在捕捉復雜細節和實現動態場景實時渲染方面遇到了挑戰。

為了應對這些挑戰,Yang等人提出了用于高保真單目動態場景重建的可變形3D高斯。提出了一種新的可變形3D-GS方法。該方法利用了在具有變形場的規范空間中學習的3D高斯,該變形場專門為單目動態場景設計。該方法引入了一種為真實世界的單目動態場景量身定制的退火平滑訓練(AST)機制,有效地解決了錯誤姿勢對時間插值任務的影響,而不引入額外的訓練開銷。通過使用差分高斯光柵化器,可變形的3D高斯不僅提高了渲染質量,而且實現了實時速度,在這兩個方面都超過了現有的方法。該方法被證明非常適合于諸如NVS之類的任務,并且由于其基于點的性質而為后期生產任務提供了多功能性。實驗結果強調了該方法優越的渲染效果和實時性,證實了其在動態場景建模中的有效性。

DIFFUSION

擴散和高斯飛濺是一種從文本描述/提示生成3D目標的強大技術。它結合了兩種不同方法的優點:擴散模型和高斯散射。擴散模型是一種神經網絡,可以學習從有噪聲的輸入中生成圖像。通過向模型提供一系列越來越干凈的圖像,模型學會扭轉圖像損壞的過程,最終從完全隨機的輸入中生成干凈的圖像。這可以用于從文本描述生成圖像,因為模型可以學習將單詞與相應的視覺特征相關聯。具有擴散和高斯飛濺的文本到3D管道的工作原理是首先使用擴散模型從文本描述生成初始3D點云。然后使用高斯散射將點云轉換為一組高斯球體。最后,對高斯球體進行渲染,以生成目標的3D圖像。

Text based generation

Yi等人的工作介紹了Gaussian Dreamer,這是一種文本到3D的方法,通過高斯分裂無縫連接3D和2D擴散模型,確保3D一致性和復雜的細節生成。圖7顯示了所提出的生成圖像的模型。為了進一步豐富內容,引入了噪聲點增長和顏色擾動來補充初始化的3D高斯。該方法的特點是簡單有效,在單個GPU上15分鐘內生成3D實例,與以前的方法相比,速度優越。生成的三維實例可以直接實時渲染,突出了該方法的實用性。總體框架包括使用3D擴散模型先驗進行初始化,并使用2D擴散模型進行優化,通過利用兩個擴散模型的優勢,能夠從文本提示創建高質量和多樣化的3D資產。

Chen等人提出了基于高斯散射的文本到3D生成(GSGEN),這是一種利用3D高斯作為表示的文本到三維生成方法。通過利用幾何先驗,強調高斯散點在文本到三維生成中的獨特優勢。兩階段優化策略結合了二維和三維擴散的聯合指導,在幾何優化中形成連貫的粗糙結構,然后在基于緊湊性的外觀細化中致密化。

Denoising and Optimisation

李等人的GaussianDiffusion框架代表了一種新穎的文本到三維方法,利用高斯飛濺和Langevin動力學擴散模型來加速渲染并實現無與倫比的真實感。結構化噪聲的引入解決了多視圖幾何挑戰,而變分高斯散射模型則緩解了收斂問題和偽影。雖然目前的結果顯示真實性有所提高,但正在進行的研究旨在細化變分高斯引入的模糊度和霧度,以進一步增強。

楊等人對現有的擴散先驗進行了徹底的檢查,提出了一個統一的框架,通過優化去噪分數來改進這些先驗。該方法的多功能性擴展到各種用例,始終如一地提供實質性的性能增強。在實驗評估中,我們的方法取得了前所未有的性能,超過了當代的方法。盡管它在細化3D生成的紋理方面取得了成功,但在增強生成的3D模型的幾何結構方面仍有改進的空間。

OPTIMIZATION AND SPEED

本小節將討論研究人員為更快的訓練和/或推理速度而開發的技術。在Chung等人的研究中,引入了一種方法來優化高斯散射,以使用有限數量的圖像進行3D場景表示,同時緩解過擬合問題。用高斯散點表示3D場景的傳統方法可能導致過擬合,特別是當可用圖像有限時。該技術使用來自預先訓練的單目深度估計模型的深度圖作為幾何指南,并與來自SFM管道的稀疏特征點對齊。這些有助于優化3D高斯散射,減少浮動偽影并確保幾何相干性。所提出的深度引導優化策略在LLFF數據集上進行了測試,與僅使用圖像相比,顯示了改進的幾何結構。該研究包括引入提前停止策略和深度圖的平滑項,這兩項都有助于提高性能。然而,也承認存在局限性,例如依賴于單目深度估計模型的準確性以及依賴于COLMAP的性能。建議未來的工作探索相互依存的估計深度,并解決深度估計困難地區的挑戰,如無紋理平原或天空。

傅等人介紹了COLMAP Free 3D Gaussian Splatting(CF-3DGS),這是一種新的端到端框架,用于從序列圖像中同時進行相機姿態估計和NVS,解決了以前方法中相機運動量大和訓練持續時間長帶來的挑戰。與NeRF的隱式表示不同,CF-3DGS利用顯式點云來表示場景。該方法順序處理輸入幀,逐步擴展3D高斯以重建整個場景,在具有挑戰性的場景(如360°視頻)上展示了增強的性能和穩健性。該方法以順序的方式聯合優化相機姿勢和3D-GS,使其特別適合視頻流或有序的圖像采集。高斯飛濺的使用能夠實現快速的訓練和推理速度,展示了這種方法相對于以前方法的優勢。在證明有效性的同時,人們承認,順序優化將應用程序主要限制在有序的圖像集合上,這為在未來的研究中探索無序圖像集合的擴展留下了空間。

RENDERING AND SHADING METHODS

Yu等人在3D-GS中觀察到,特別是當改變采樣率時,NVS中會出現偽影。引入的解決方案包括結合3D平滑濾波器來調節3D高斯基元的最大頻率,從而解決分布外渲染中的偽影。此外,2D膨脹濾波器被2D Mip濾波器取代,以解決混疊和膨脹問題。對基準數據集的評估證明了Mip Splatting的有效性,尤其是在修改采樣率時。所提出的修改是原則性的、直截了當的,需要對原始3D-GS代碼進行最小的更改。然而,也存在公認的局限性,例如高斯濾波器近似引入的誤差和訓練開銷的輕微增加。該研究將Mip Splatting作為一種具有競爭力的解決方案,展示了其與最先進的方法的性能相當,以及在分發外場景中的卓越泛化能力,展示了它在實現任意規模的無別名渲染方面的潛力。

Gao等人提出了一種新的3D點云渲染方法,該方法能夠從多視圖圖像中分解材質和照明。該框架支持以可區分的方式對場景進行編輯、光線跟蹤和實時重新照明。場景中的每個點都由“可重新照明”的3D高斯表示,攜帶有關其法線方向、雙向反射分布函數(BRDF)等材料特性以及來自不同方向的入射光的信息。為了精確的照明估計,入射光被分為全局和局部分量,并考慮基于視角的可見性。場景優化利用3D高斯飛濺,而基于物理的可微分渲染處理BRDF和照明分解。一種創新的基于點的光線跟蹤方法利用邊界體層次結構,在實時渲染過程中實現了高效的可見性烘焙和逼真的陰影。實驗表明,與現有方法相比,BRDF估計和視圖渲染效果更好。然而,對于沒有明確邊界和優化過程中需要目標遮罩的場景,仍然存在挑戰。未來的工作可以探索集成多視圖立體(MVS)線索,以提高通過3D高斯散射生成的點云的幾何精度。這種“可靠的3D高斯”管道展示了很有前途的實時渲染功能,并通過基于點云的方法為革命性地基于網格的圖形打開了大門,該方法允許重新照明、編輯和光線跟蹤。

COMPRESSION

Fan等人介紹了一種用于壓縮渲染中使用的3D高斯表示的新技術。他們的方法根據其重要性識別并刪除冗余高斯,類似于網絡修剪,確保對視覺質量的影響最小。利用知識提取和偽視圖增強,LightGaussian將信息傳遞到具有較少球面諧波的較低復雜度表示,從而進一步減少冗余。此外,一種稱為VecTree量化的混合方案通過量化屬性值來優化表示,從而在精度沒有顯著損失的情況下實現更小的尺寸。與標準方法相比,LightGaussian實現了超過15倍的平均壓縮比,在Mip NeRF 360和Tanks&Temples等數據集上,渲染速度從139 FPS顯著提高到215 FPS。所涉及的關鍵步驟是計算全局顯著性、修剪高斯、用偽視圖提取知識以及使用VecTree量化屬性。總的來說,LightGaussian為將基于大點的表示轉換為緊湊格式提供了一個突破性的解決方案,從而顯著減少了數據冗余,并大幅提高了渲染效率。

應用和案例研究

本節深入探討了自2023年7月高斯飛濺算法問世以來,該算法在應用方面的顯著進步。這些進步在各種領域都有特定的用途,如化身、SLAM、網格提取和物理模擬。當應用于這些專門的用例時,Gaussian Splatting在不同的應用場景中展示了它的多功能性和有效性。

AVATARS

隨著AR/VR應用熱潮的興起,高斯飛濺的大量研究都集中在開發人類的數字化身上。從較少的視角捕捉主題并構建3D模型是一項具有挑戰性的任務,高斯飛濺正幫助研究人員和行業實現這一目標。

Joint angles or articulation

這種高斯散射技術專注于根據關節角度對人體進行建模。這類模型的一些參數反映了三維關節的位置、角度和其他類似的參數。對輸入幀進行解碼以找出當前幀的3D關節位置和角度。

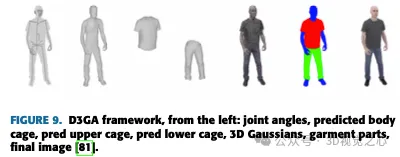

Zielonka等人提出了一種使用高斯散射的人體表示模型,并利用創新的3D-GS技術實現了實時渲染。與現有的照片級真實感可駕駛化身不同,可駕駛3D高斯飛濺(D3GA)不依賴于訓練期間的精確3D配準或測試期間的密集輸入圖像。相反,它利用密集校準的多視圖視頻進行實時渲染,并引入了由關節中的關鍵點和角度驅動的基于四面體籠的變形,使其對涉及通信的應用程序有效,如圖9所示。

Animatable

這些方法通常訓練依賴于位姿的高斯圖來捕捉復雜的動態外觀,包括服裝中更精細的細節,從而產生高質量的化身。其中一些方法還支持實時渲染功能。

姜等人提出了HiFi4G,這種方法可以有效地渲染真實的人類。HiFi4G將3D高斯表示與非剛性跟蹤相結合,采用運動先驗的對偶圖機制和具有自適應時空正則化器的4D高斯優化。HiFi4G實現了大約25倍的壓縮率,每幀需要不到2MB的存儲空間,在優化速度、渲染質量和存儲開銷方面表現出色,如圖10所示。它提出了一種緊湊的4D高斯表示,橋接高斯飛濺和非剛性跟蹤。然而,對分割的依賴性、對導致偽影的較差分割的敏感性,以及對每幀重建和網格跟蹤的需求都造成了限制。未來的研究可能側重于加速優化過程和減少GPU排序依賴性,以便在網絡查看器和移動設備上進行更廣泛的部署。

Head based

以前的頭部化身方法大多依賴于固定的顯式基元(網格、點)或隱式曲面(SDF)。基于高斯散射的模型將為AR/VR和基于濾鏡的應用的興起鋪平道路,讓用戶嘗試不同的妝容、色調、發型等。

王等人利用規范的高斯變換來表示動態場景。使用顯式“動態”三平面作為參數化頭部幾何的有效容器,與底層幾何和三平面中的因子很好地對齊,作者獲得了正則高斯的對齊正則因子。使用微小的MLP,因子被解碼為3D高斯基元的不透明度和球面諧波系數。Quin等人創建了具有可控視角、姿勢和表情的超逼真頭部化身。在化身重構過程中,作者同時對變形模型參數和高斯splat參數進行了優化。該作品展示了化身在各種具有挑戰性的場景中的動畫能力。Dhamo等人提出了HeadGaS,這是一種混合模型,以可學習的潛在特征為基礎,擴展了3D-GS的顯式表示。然后,這些特征可以與來自參數化頭部模型的低維參數線性混合,以導出依賴于表情的最終顏色和不透明度值。圖11顯示了一些示例圖像。

SLAM

SLAM是自動駕駛汽車中使用的一種技術,用于同時構建地圖并確定車輛在該地圖內的位置。它使車輛能夠導航和繪制未知環境的地圖。顧名思義,視覺SLAM(vSLAM)依賴于來自相機和各種圖像傳感器的圖像。這種方法適用于各種相機類型,包括簡單、復眼和RGB-D相機,使其成為一種具有成本效益的解決方案。通過攝像頭,可以將地標檢測與基于圖形的優化相結合,增強SLAM實現的靈活性。單眼SLAM是vSLAM的一個子集,使用單個相機,在深度感知方面面臨挑戰,這可以通過結合額外的傳感器來解決,如里程計和慣性測量單元(IMU)的編碼器。與vSLAM相關的關鍵技術包括SFM、視覺里程計和束調整。視覺SLAM算法分為兩大類:稀疏方法,采用特征點匹配(例如,并行跟蹤和映射,ORB-SLAM),密集方法,利用整體圖像亮度(例如,DTAM,LSD-SLAM,DSO,SVO)。

網格提取與物理

高斯散射可以用于基于物理的模擬和渲染。通過在三維高斯核中添加更多的參數,可以對速度、應變和其他力學特性進行建模。這就是為什么在幾個月內開發了各種方法,包括使用高斯散射模擬物理。

謝等人介紹了一種基于連續體力學的三維高斯運動學方法,采用偏微分方程(PDE)來驅動高斯核及其相關球面諧波的演化。這一創新允許使用統一的模擬渲染管道,通過消除對顯式目標網格的需要來簡化運動生成。他們的方法通過在各種材料上進行全面的基準測試和實驗,展示了多功能性,在具有簡單動力學的場景中展示了實時性能。作者介紹了PhysGaussian,這是一個同時無縫生成基于物理的動力學和照片逼真渲染的框架。在承認框架中缺乏陰影演化和使用單點求積進行體積積分等局限性的同時,作者提出了未來工作的途徑,包括在材料點法(MPM)中采用高階求積,并探索神經網絡的集成以實現更真實的建模。該框架可以擴展到處理各種材料,如液體,并結合利用大型語言模型(LLM)進步的用戶控件。圖13顯示了PhysGaussian框架的訓練過程。

編輯

高斯飛濺還將其翅膀擴展到場景的3D編輯和點操縱。使用將要討論的最新進展,甚至可以對場景進行基于提示的3D編輯。這些方法不僅將場景表示為3D高斯圖,而且對場景具有語義和爭議性的理解。

Chen等人介紹了GaussianEditor,這是一種基于高斯Splatting的新型三維編輯算法,旨在克服傳統三維編輯方法的局限性。雖然依賴于網格或點云的傳統方法難以進行逼真的描繪,但像NeRF這樣的隱式3D表示面臨著處理速度慢和控制有限的挑戰。GaussianEditor通過利用3D-GS來解決這些問題,通過高斯語義跟蹤增強精度和控制,并引入層次高斯飛濺(HGS),在生成指導下獲得穩定和精細的結果。該算法包括一種專門的3D修復方法,用于有效地去除和集成物體,在廣泛的實驗中顯示出卓越的控制能力、功效和快速性能。圖14顯示了Chen等人測試的各種文本提示。GaussianEditor標志著3D編輯的重大進步,提供了增強的有效性、速度和可控性。該研究的貢獻包括引入高斯語義跟蹤進行詳細編輯控制,提出HGS在生成指導下實現穩定收斂,開發用于快速刪除和添加目標的3D修復算法,以及大量實驗證明該方法優于以前的3D編輯方法。盡管GaussianEditor取得了進步,但它依賴于二維擴散模型進行有效監督,在處理復雜提示方面存在局限性,這是基于類似模型的其他三維編輯方法面臨的共同挑戰。

討論

傳統上,3D場景是使用網格和點來表示的,因為它們的顯式性質以及與基于GPU/CUDA的快速光柵化的兼容性。然而,最近的進步,如NeRF方法,專注于連續場景表示,采用了多層感知器優化等技術,通過體積射線行進進行新的視圖合成。雖然連續表示有助于優化,但渲染所需的隨機采樣會引入昂貴的噪聲。高斯飛濺通過利用3D高斯表示進行優化,實現最先進的視覺質量和有競爭力的訓練時間,彌補了這一差距。此外,基于瓦片的飛濺解決方案可確保實時渲染具有頂級質量。在渲染3D場景時,高斯飛濺在質量和效率方面提供了一些最佳結果。

高斯飛濺已經發展到通過修改其原始表示來處理動態和可變形目標。這涉及到合并參數,如3D位置、旋轉、縮放因子和顏色和不透明度的球面諧波系數。該領域的最新進展包括引入稀疏性損失以鼓勵ba-sis軌跡共享,引入雙域變形模型以捕獲與時間相關的殘差,以及將生成器網絡與3D高斯渲染連接起來的高斯殼映射。還努力解決非剛性跟蹤、化身表情變化和高效渲染逼真人類表現等挑戰。這些進步共同致力于在處理動態和可變形目標時實現實時渲染、優化效率和高質量結果。

在另一個方面,擴散和高斯飛濺協同作用,從文本提示創建3D目標。擴散模型是一種神經網絡,它通過一系列越來越干凈的圖像來逆轉圖像損壞的過程,從而學習從有噪聲的輸入中生成圖像。在文本到三維管道中,擴散模型根據文本描述生成初始三維點云,然后使用高斯散射將其轉換為高斯球體。渲染的高斯球體生成最終的三維目標圖像。該領域的進展包括使用結構化噪聲來解決多視圖幾何挑戰,引入變分高斯散射模型來解決收斂問題,以及優化去噪分數以增強擴散先驗,旨在實現基于文本的3D生成中無與倫比的真實性和性能。

高斯飛濺已被廣泛應用于AR/VR應用的數字化身的創建。這涉及到從最小數量的視點捕捉目標并構建3D模型。該技術已被用于建模人體關節、關節角度和其他參數,從而能夠生成富有表現力和可控的化身。這一領域的進步包括開發捕捉高頻面部細節、保留夸張表情和有效變形化身的方法。此外,還提出了混合模型,將顯式表示與可學習的潛在特征相結合,以實現與表達相關的最終顏色和不透明度值。這些進步旨在增強生成的3D模型的幾何形狀和紋理,以滿足AR/VR應用中對逼真和可控化身日益增長的需求。

Gaussian Splatting還在SLAM中找到了多功能的應用,在GPU上提供實時跟蹤和建圖功能。通過使用3D高斯表示和可微分的飛濺光柵化管道,它實現了真實世界和合成場景的快速和真實感渲染。該技術擴展到網格提取和基于物理的模擬,允許在沒有明確目標網格的情況下對機械特性進行建模。連續介質力學和偏微分方程的進步使高斯核得以進化,簡化了運動生成。值得注意的是,優化涉及高效的數據結構,如OpenVDB、用于對齊的正則化項和用于減少誤差的物理啟發項,從而提高了整體效率和準確性。在壓縮和提高高斯散射渲染效率方面也做了其他工作。

對比

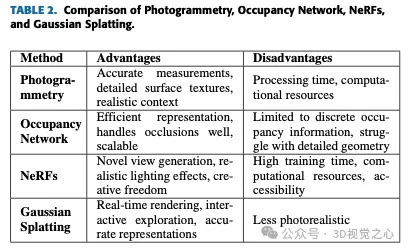

從表2可以清楚地看出,在撰寫本文時,高斯飛濺是最接近實時渲染和動態場景表示的選項。占用網絡根本不是為NVS用例量身定制的。攝影測量是創建具有強烈背景感的高度準確和逼真的模型的理想選擇。NeRF擅長生成新穎的視圖和逼真的照明效果,提供創作自由和處理復雜場景。高斯飛濺在其實時渲染功能和交互式探索方面大放異彩,使其適用于動態應用程序。每種方法都有其利基市場,并相互補充,為3D重建和可視化提供了各種各樣的工具。

挑戰和限制

盡管高斯飛濺是一種非常穩健的技術,但它也有一些需要注意的地方。其中一些列出如下:

- 1)計算復雜性:高斯散射需要對每個像素的高斯函數進行評估,這可能是計算密集型的,尤其是在處理大量點或粒子時。

- 2)內存使用:存儲高斯飛濺的中間結果,例如每個點對相鄰像素的加權貢獻,可能會消耗大量內存。

- 3)邊緣偽影:高斯散射會在圖像的邊緣或高對比度區域附近產生不希望的偽影,如振鈴或模糊。

- 4)性能與準確性的權衡:實現高質量的結果可能需要使用大的內核大小或評估每個像素的多個高斯函數,這會影響性能。

- 5)與其他渲染技術的集成:在保持性能和視覺連貫性的同時,將高斯散射與陰影貼圖或環境遮擋等其他技術集成可能會很復雜。

未來方向

實時3D重建技術將實現計算機圖形學和相關領域的多種功能,例如實時交互式探索3D場景或模型,通過即時反饋操縱視點和目標。它還可以實時渲染具有移動目標或不斷變化的環境的動態場景,增強真實感和沉浸感。實時3D重建可用于仿真和訓練環境,為汽車、航空航天和醫學等領域的虛擬場景提供逼真的視覺反饋。它還將支持沉浸式AR和VR體驗的實時渲染,用戶可以實時與虛擬目標或環境交互。總體而言,實時高斯飛濺增強了計算機圖形、可視化、模擬和沉浸式技術中各種應用的效率、交互性和真實性。

結論

在本文中,我們討論了與用于三維重建和新視圖合成的高斯散射相關的各種功能和應用方面。它涵蓋了動態和變形建模、運動跟蹤、非剛性/可變形目標、表情/情緒變化、基于文本的生成擴散、去噪、優化、化身、可動畫目標、基于頭部的建模、同步定位和規劃、網格提取和物理、優化技術、編輯功能、渲染方法、壓縮等主題。

具體而言,本文深入探討了基于圖像的3D重建的挑戰和進展,基于學習的方法在改進3D形狀估計中的作用,以及高斯飛濺技術在處理動態場景、交互式目標操作、3D分割和場景編輯中的潛在應用和未來方向。

高斯飛濺在不同領域具有變革意義,包括計算機生成圖像、VR/AR、機器人、電影和動畫、汽車設計、零售、環境研究和航空航天應用。然而,值得注意的是,與NeRFs等其他方法相比,高斯散射在實現真實感方面可能存在局限性。此外,還應考慮與過擬合、計算資源和渲染質量限制相關的挑戰。盡管存在這些局限性,但高斯散射的持續研究和進步仍在繼續解決這些挑戰,并進一步提高該方法的有效性和適用性。