AI生圖格局大震!Stable Diffusion 3開源倒計時,2B單機可跑碾壓閉源Midjourney

萬眾矚目的Stable Diffusion 3,終于要正式開源了!

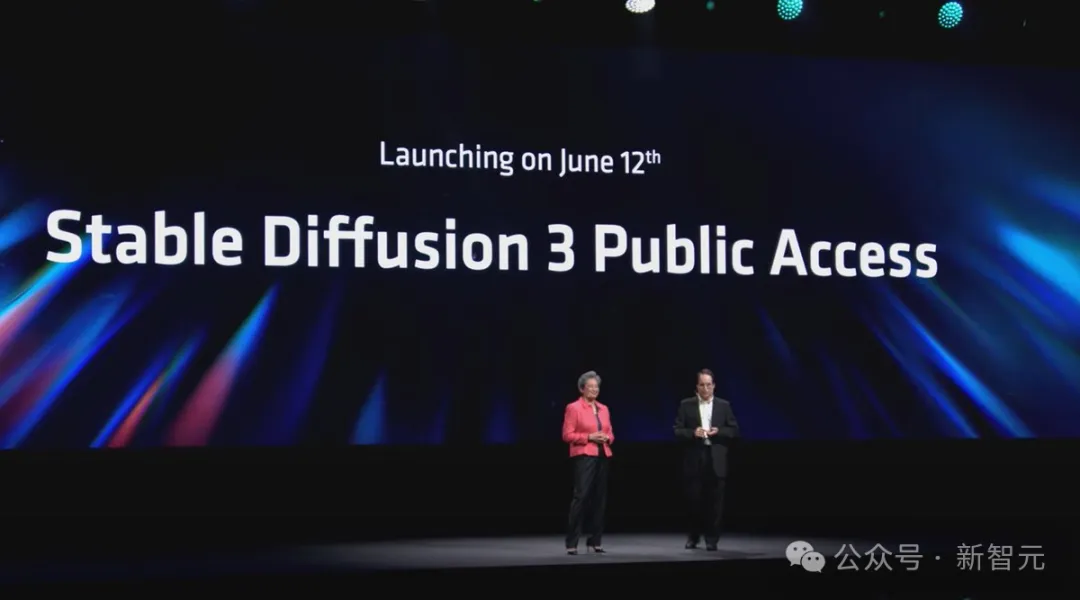

幾天前,在Computex 2024大會上,Stability AI聯合首席執行官Christian Laforte正式官宣:SD 3 Medium將在6月12日公開發布。

據悉,之后還會開源4B和8B的版本。

消息一出,網友們就激動地奔走相告。

種種跡象表明,SD3明天的開源應該是鐵板釘釘了。

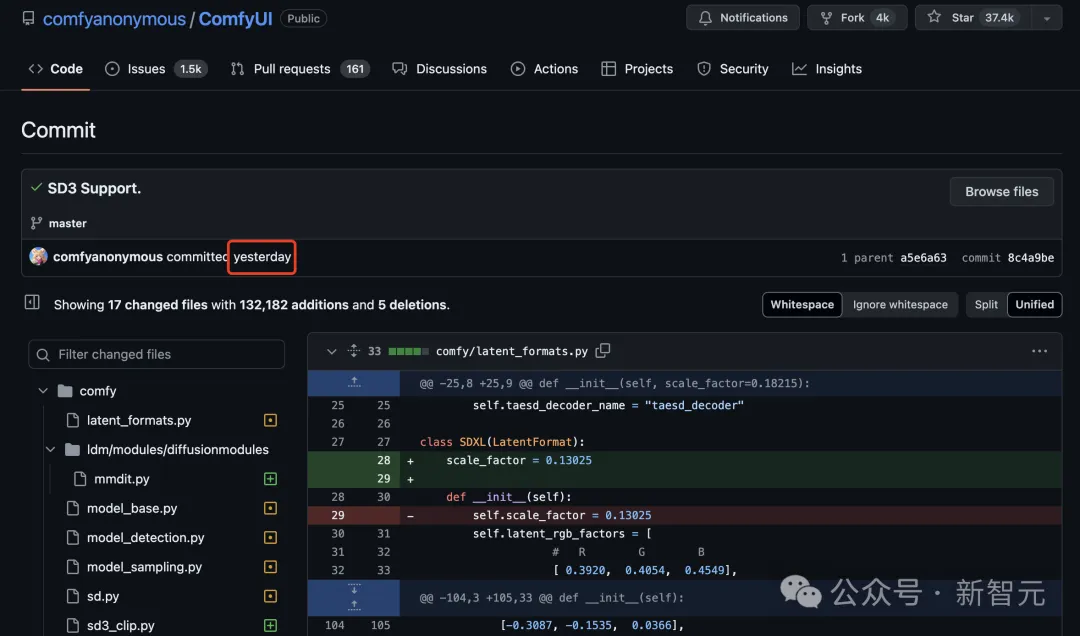

目前,ComfyUI已經提交了對SD3支持的版本。

網友表示,如果此事是真的,那可就太瘋狂了,生圖圈子將成第一個開源碾壓閉源的賽道!

這邊AI生圖王者Midjourney剛剛放出功能更新,網友們就在評論區紛紛留言:SD3一旦開源,你們就完蛋了。

網友們紛紛搬好板凳,坐等SD3的權重發布了。

欠債1億的獨角獸,仍堅持做開源英雄?

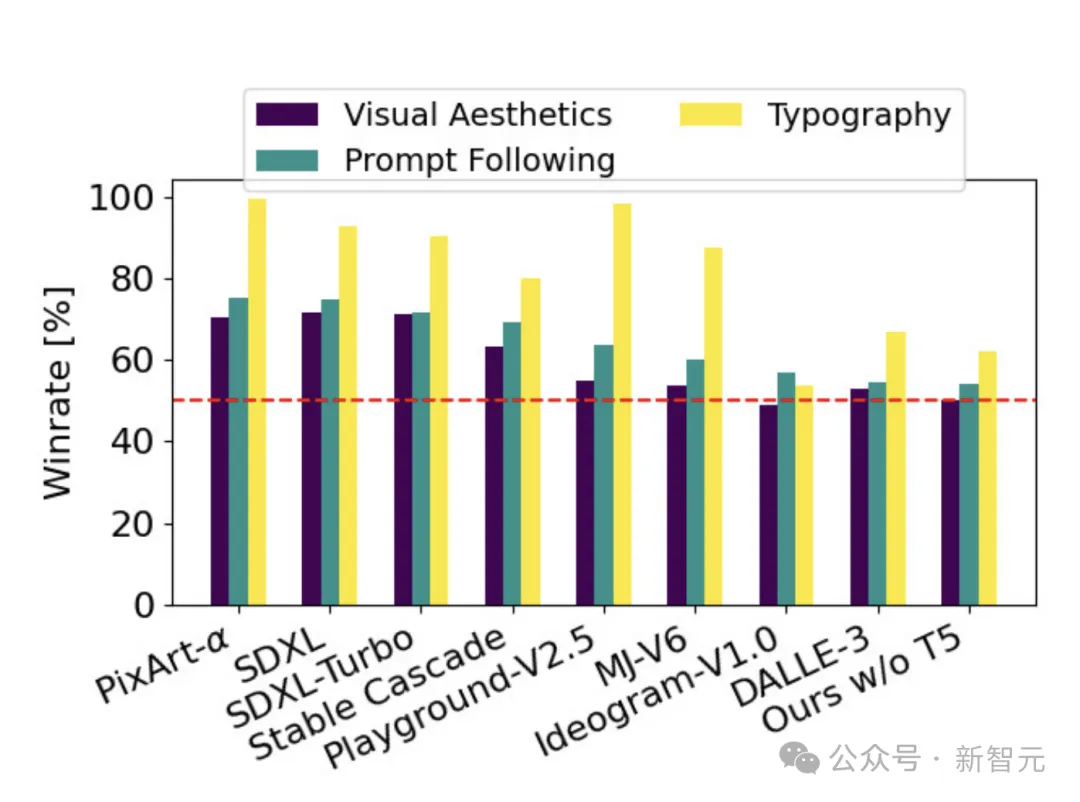

兩個月前,Stable Diffusion 3一橫空出世,立刻在人類偏好評估中斬下DALL-E 3和Midjourney v6,一舉成為該領域的SOTA。

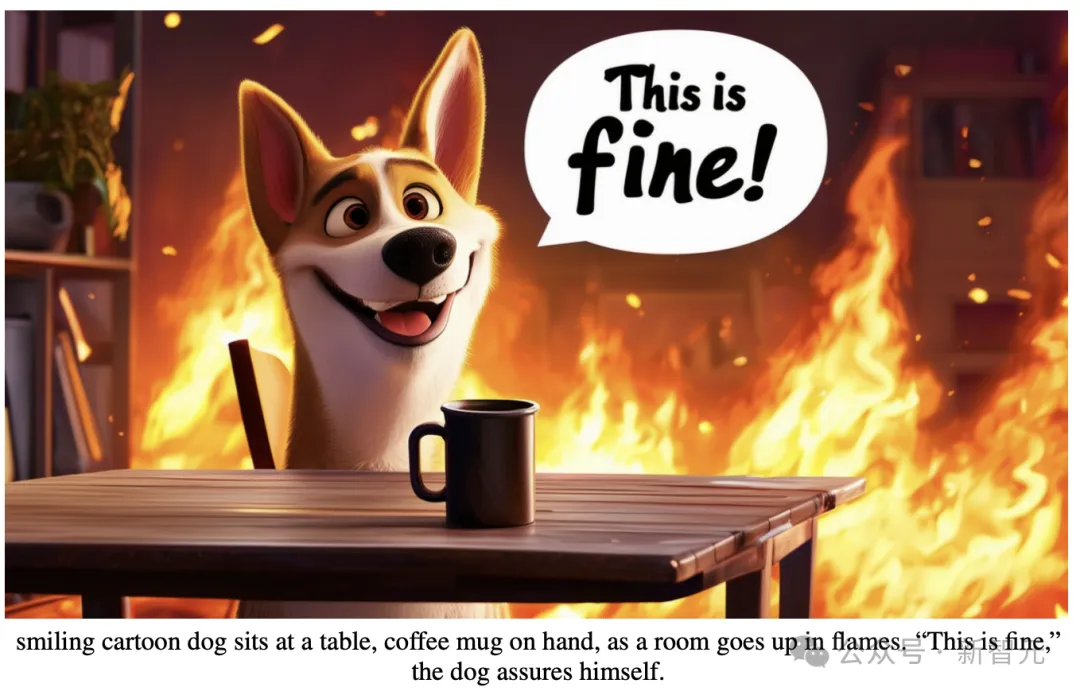

因為攻克了AI圖像生成領域著名的「正確性」測試,SD3一時名聲大噪,引發了極大熱度。

雖然放出的模型效果驚艷全網,但選擇開源也讓公司的收入入不敷出。隨后就是滿身黑歷史的CEO跑路、人才出走等負面事件,讓Stability AI這頭獨角獸的前途風雨飄搖,一度陷入欠下1億美元的「賣身」傳聞。

在繁榮時期的Stability AI收到過不少橄欖枝,卻斷然拒絕收購。然而虧損超3000萬美元、拖欠1億美元賬單的事實,揭示了所有開源公司共同的困境——

如果選擇將代碼、權重和產品API免費開放,即便保留部分高級功能,也很難吸引到付費用戶。

如果在這種情況下,SD3依然堅持開源,叫Stability AI一聲「開源英雄」絕不為過。

強大的架構、更好的明暗對比度、提示遵循、訓練結果、模型合并、圖像分辨率……SD3的開源給我們帶來的貢獻可太多了!

現在,所有人都在翹首以盼。

將對開源社區影響重大

Stable Diffusion3的開源,為何意義如此重大?

在reddit的StableDiffusion社區,一位網友給出了以下總結,讓我們從非技術視角,理解SD3的重要性,以及對AI社區的重大影響。

作者表示,自己希望能讓外行人都明白,為何Stable Diffusion 3如此重要。

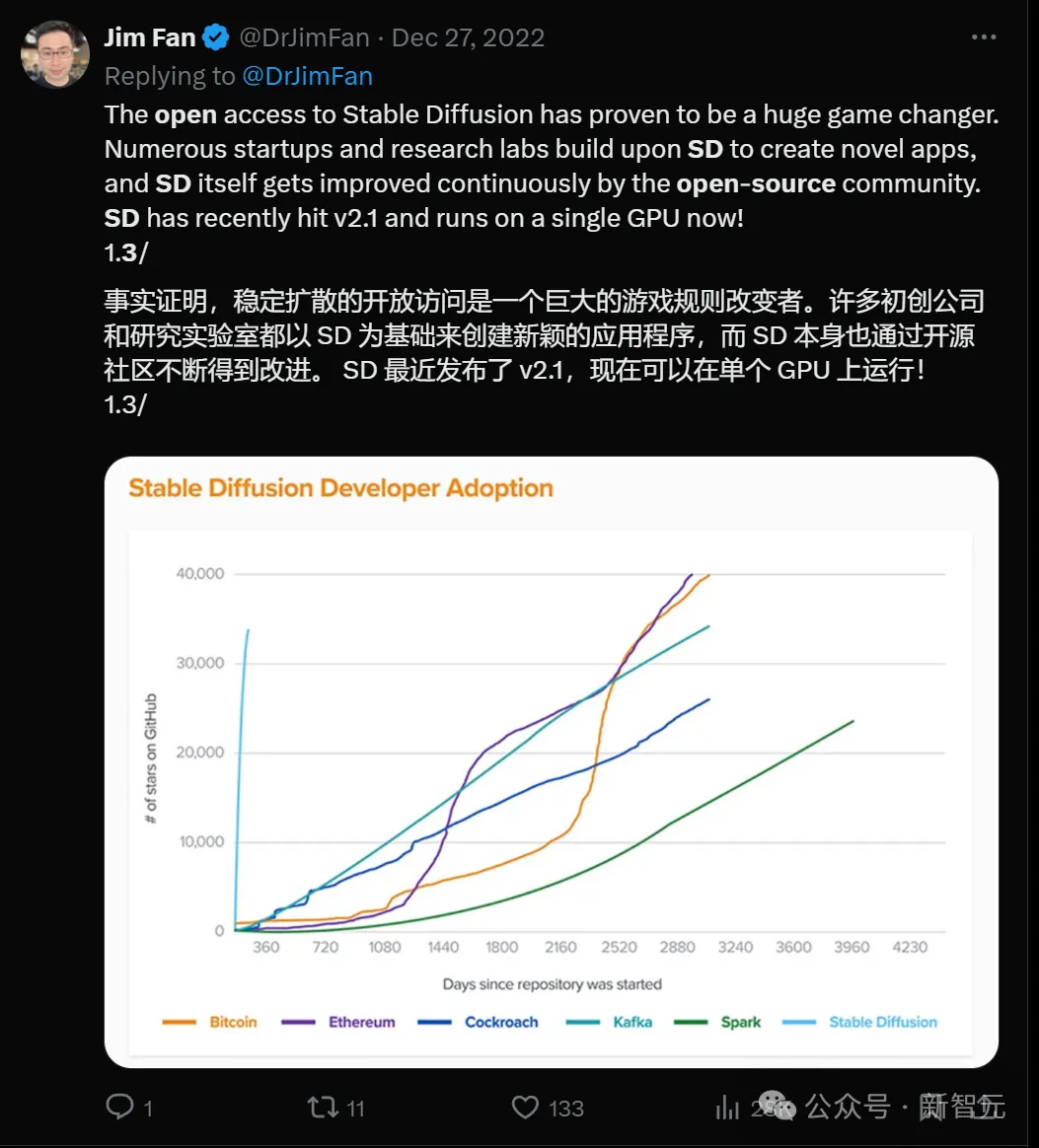

曾經Stable Diffusion的開源,就改變了游戲規則

VAE是無名英雄

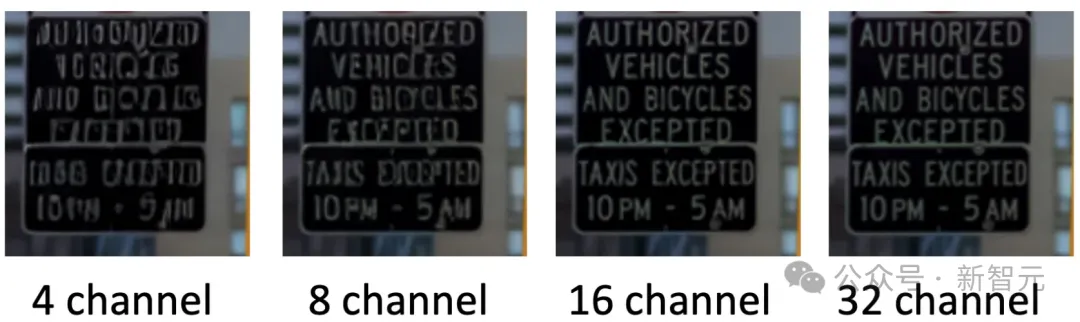

VAE(變分自編碼器)非常特別,因為它讓提供了16個通道的特征和顏色數據供我們使用,而之前的模型只有4個通道。

下面的四張圖顯示出,這將產生多大的影響。

Emu論文地址:https://arxiv.org/pdf/2309.15807

這也就意味著,模型在訓練時會捕獲更多細節。

不僅模型的質量會更好,而且實際上會帶來更快的訓練速度,從而使主要的MMDiT模型(也就是實現生成的主要模型)能夠更好地捕捉細節。

感興趣的讀者可以閱讀下面這篇技術性解讀:

文章地址:https://huggingface.co/blog/TimothyAlexisVass/explaining-the-sdxl-latent-space#the-8-bit-pixel-space-has-3-channels

與舊的模型相比,新的16通道VAE在512x512分辨率下的表現,可以說令人難以置信——即使在較小的圖像尺寸下,通道維度上的特征數量也足以捕捉到很好的細節。

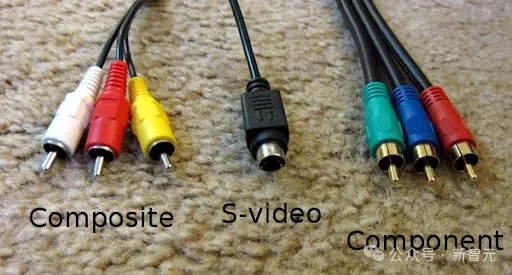

為了更好地說明這一點,我們可以用視頻領域的標準來做個類比——

VHS和DVD都是標準定義的480i/480p,但DVD顯然捕捉到了更多細節,甚至在硬件和軟件的升頻器上表現也很好。

或者,可以用復古游戲玩家的說法來類比——

- 復合視頻線(Composite cables) -> SD1.X的VAE

- S-Video線 -> SDXL的VAE

- 組件視頻線(Component cables) -> SD3的VAE

因此,將VAE應用到如今我們的AI工作流程中,一切都將變得更加高效。

在視頻生成方面,則可以在低分辨率下訓練以適應虛擬內存(VRAM),然后通過分辨率增強流程來保留細節。

我們不需要訓練/微調文本編碼器了

眾所周知,訓練文本編碼器可以提升基于SD1.X模型和SDXL模型的性能。

然而在這位網友看來,從長遠來看,這其實是低效的,因為在實際應用中存在大量的微調和模型合并。

這會在推理過程中導致大量的重新加權,從而引起混亂,使得在創作過程中捕捉細節變得更加困難。

雖然在小規模應用中可以這樣做,但隨著社區的擴大,訓練文本編碼器就變得極其繁瑣了。

從技術角度來看,CLIP模型本身就很難訓練和微調,因此如果嘗試同時處理三個模型,可能會面臨一場艱難的苦斗。

而現在,我們或許根本不需要微調文本編碼器了!

第一個原因是,VAE相比舊模型,捕捉了更多的細節。

第二個原因則是,無論我們使用哪種變體,SD3都經過了適當且魯棒的caption訓練,以捕捉大多數人認為重要的所有細節。

在SD3中,可以讓新的架構和VAE為我們捕捉這些細節,這樣我們就可以更好地利用多個LoRA模型,實現更魯棒的生成。

加速新的AI研究

目前,生成式AI社區和LLM社區之間還缺乏一定的協作。

在這位網友看來,隨著MMDiT架構更好地與LLM社區對齊,會有更多的開發者進入生成式AI社區,帶來大量豐富的研究和方法。

這將造成的影響,或許是十分重大的。

此前,LLM社區就創建了很多應用于生成式AI的偉大方法(比如LoRA就是從文本建模中派生出來的),然而,由于架構之間缺乏互操作性操作性(當前SD使用的是UNet,SD3使用的是Transformer塊),會讓許多人望而卻步。

如果兩個領域的開發者和研究者開始合作,擴展許多跨領域的多模態功能,比如文本、圖像、音頻、視頻等,比如會創造出許多獨屬于開源社區的非常棒的體驗。

舊方法更加完善

自從Stable Diffusion誕生以來,我們可以在眨眼間生成圖像、視頻、音頻,甚至3D模型。

如今在谷歌Scholar上,關于Stable Diffusion的論文已經有7500多篇了。

微調方法、ControlNet、適配器、分段方法等理論,在SD上應該會比從前的架構表現得更好。

而且因為架構簡單,模型會變得更易訪問和使用。

事實上,由于SD3的強大圖像-文本對齊和VAE,有些方法可能我們再也不需要了。

比如在音頻擴散、視頻擴散和3D擴散模型領域,就可以在新架構上用這些方法訓練,進一步提高模型的質量和魯棒性。

顯然,ControlNets和適配器會變得更好,因為SD3實際上是使用多模態架構構建的。

這也就意味著,SD3在不同模態之間,會有更好的關系理解。

如今我們在構建新方法時,就可以在同一空間內利用這些模態,再結合上更好的文本理解和強大的VAE,SD3的前途簡直不可限量!

CEO「跑路」,開源成謎

趕在2月份的時候,Stable Diffusion迭代到了第3個版本。

然而僅一個月的時間,背后核心團隊卻被曝出集體離職。

更讓人意想不到的是,身為CEO的Emad也緊跟辭職,退出了董事會。

顯然,SD3隨后的開源,也變得迷霧重重。

當時,外界的猜測是,Stability AI的動蕩是Emad一手釀成的。

彭博對20位現任前任員工、投資者等采訪了解到,Emad在治理公司方面缺乏經驗,組織結構混亂。

更有甚者,公司還習慣性地拖欠工資和稅款。

Emad近日又成立了一家初創公司Schelling AI,專注去中心化AI系統

其實, 在23年底,公司內部不穩定的現象已經出現了苗頭。

作為聯創之一的Cyrus Hodes便起訴Emad是個「騙子」。

他指控,在公司進行重大融資幾個月前,Emad曾誘騙自己以100美元價格出售15%股份。

其實,Stability AI創立之后,便以模型「開源」深受社區關注和好評。

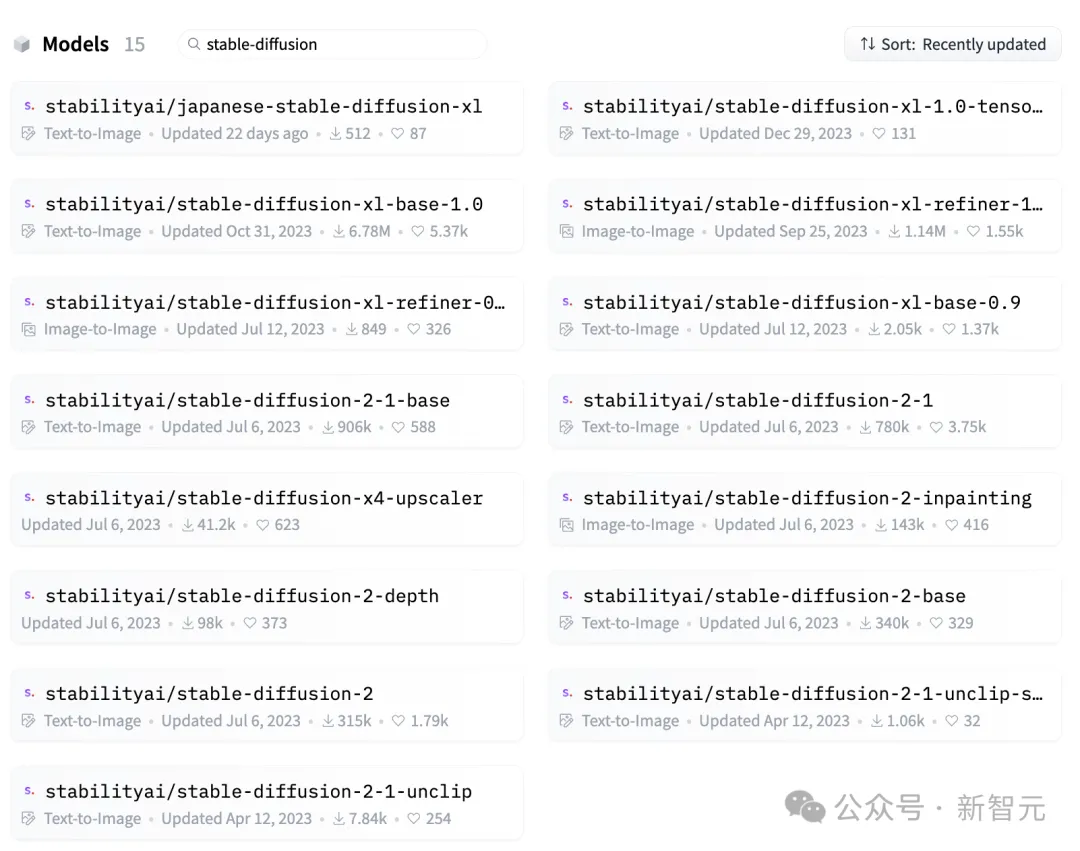

它先后發布了多款模型「全家桶」,包括語言模型Stable LM、視頻模型Stable Video Diffusiion、音頻模型Stable Audio。

而比起具有里程碑意義的Stable Diffusion,一代和二代模型系列在開源社區有300-400萬下載量。

在開源背后,需要的是Stability AI不斷開啟「燒錢」模式。

但顯然,這種入不敷出的方式,根本無法支撐這家公司持續性發展。

前段時間,Information爆料稱,Stability AI第一季度的營收不足500萬美元。而且,公司虧損超過了3000萬美元,還對外拖欠了近1億美元的巨額賬單。

更有傳聞稱,Stability AI正尋求賣身。

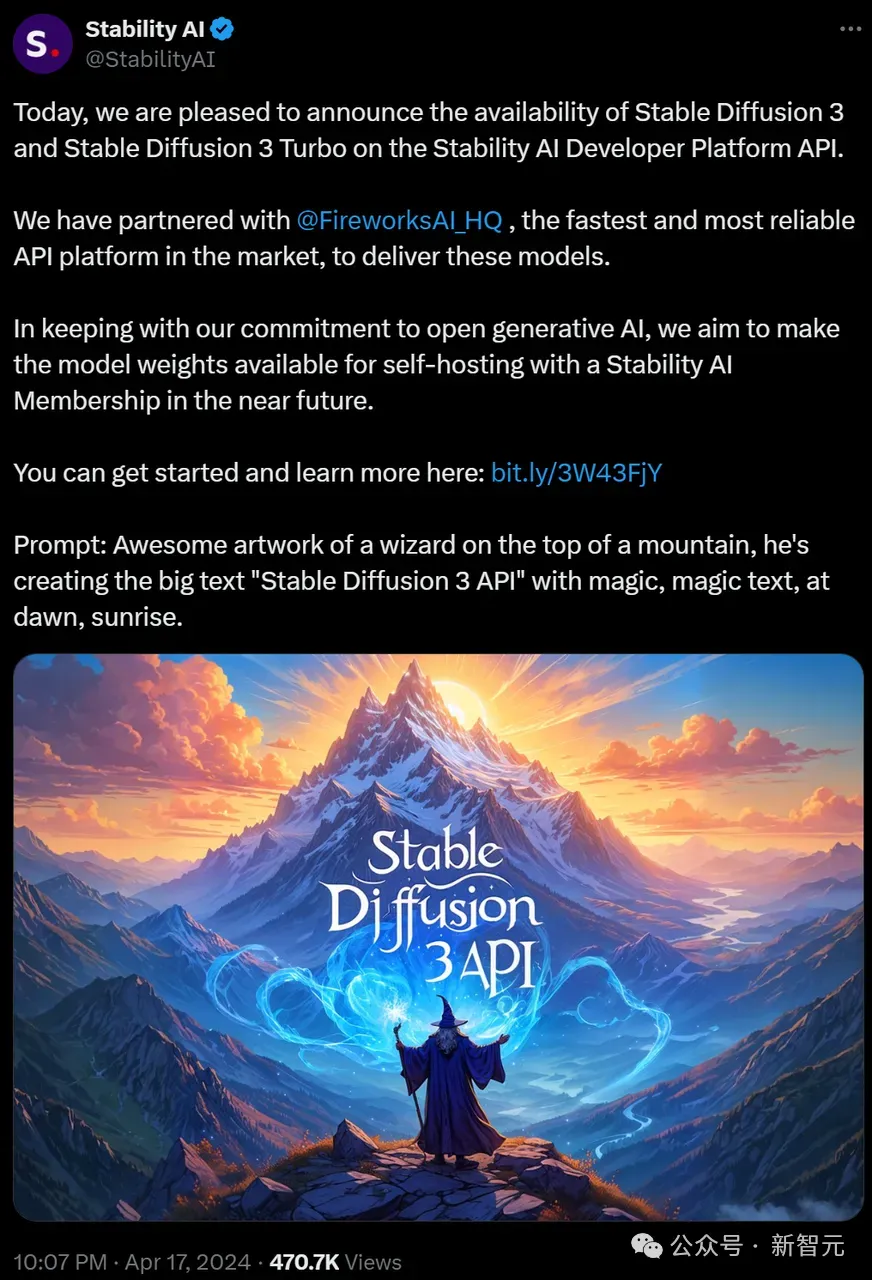

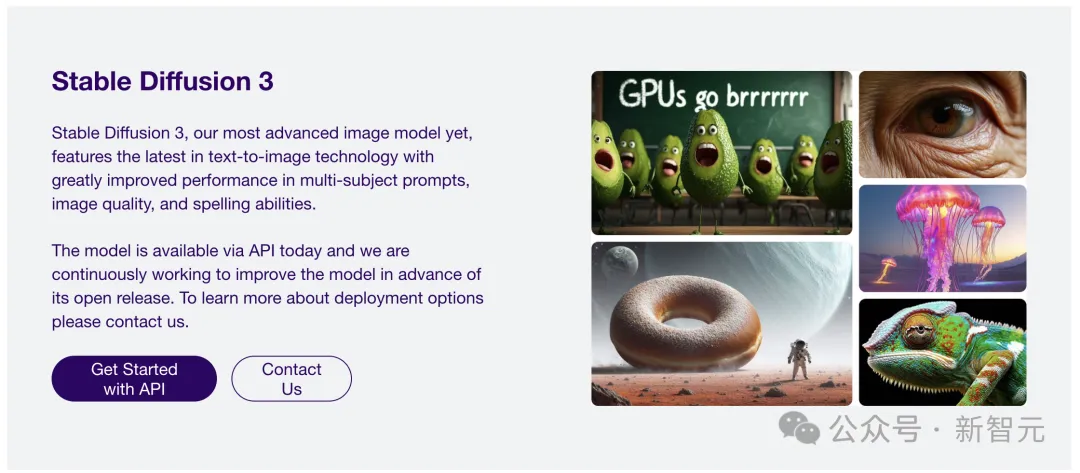

而在SD3發布之后,官方宣布稱在對齊之后正式開源,結果等了3個多月,依然只是API的開放。

有Reddit網友在線發起了提問,為Stability AI尋求賺錢出路,以保證SD3能夠順利放出。

20億參數版本先上線

好在,ComputeX大會上,終于等到了SD3的官宣開源。

一些網友紛紛收到了Stability AI郵件,即將開源的SD3 Medium是一個20億參數的模型。

不過,有人對此質疑道,「Stability AI愚弄了所有的人,他們開源的是一個名為『SD3 Medium』的模型,其實內部還有Large和X-Large版本還未發布,這才是人們期待的真正的SD3」。

關于更大版本的開源,Stability AI自家員工表示,40億、80億參數的版本未來都將會陸續上線。

Stable Diffusion 3技術回顧

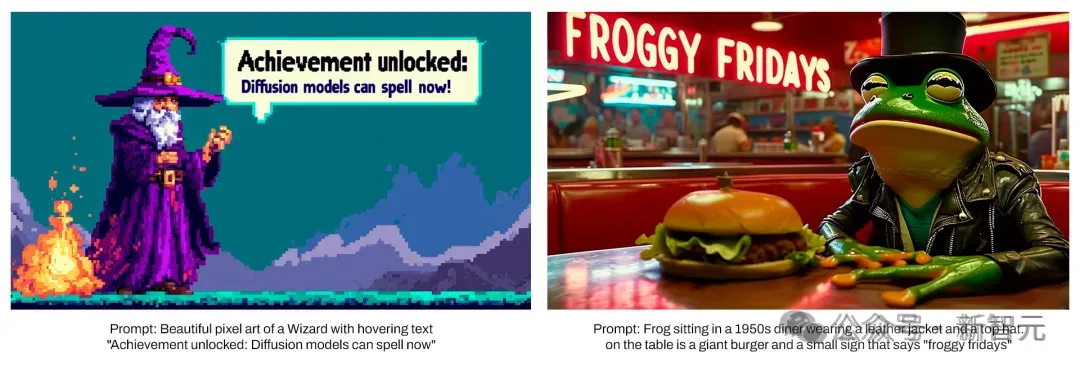

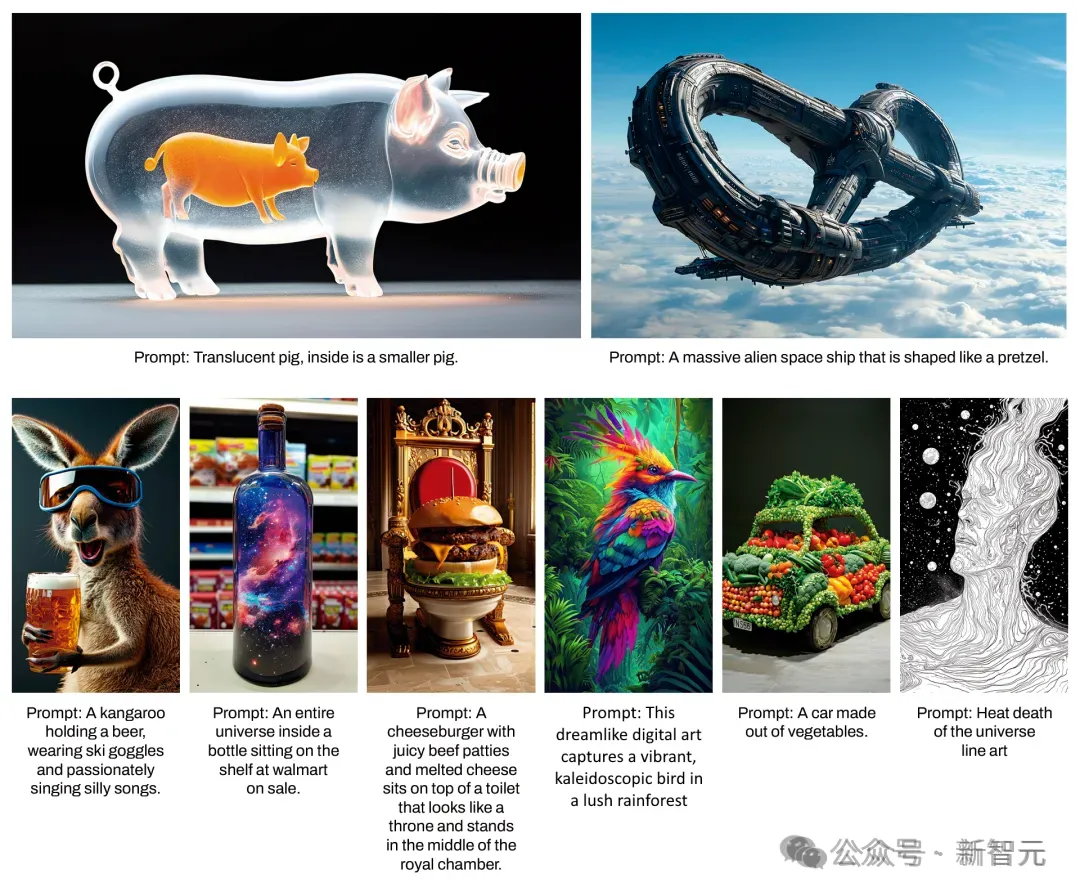

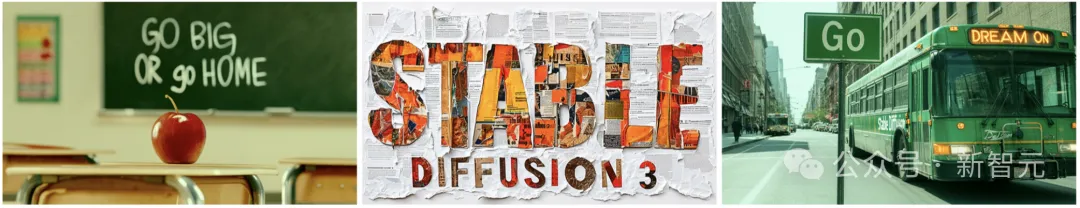

SD3的誕生已經在圖像質量、多個對象、拼寫能力方面,都得到了顯著提升,讓AI生圖再創新里程碑。

發布當天,前CEO Emad承諾道,SD3未來將會開源,目前還在測試階段。

甚至,它還涌現出了對物理世界的理解。

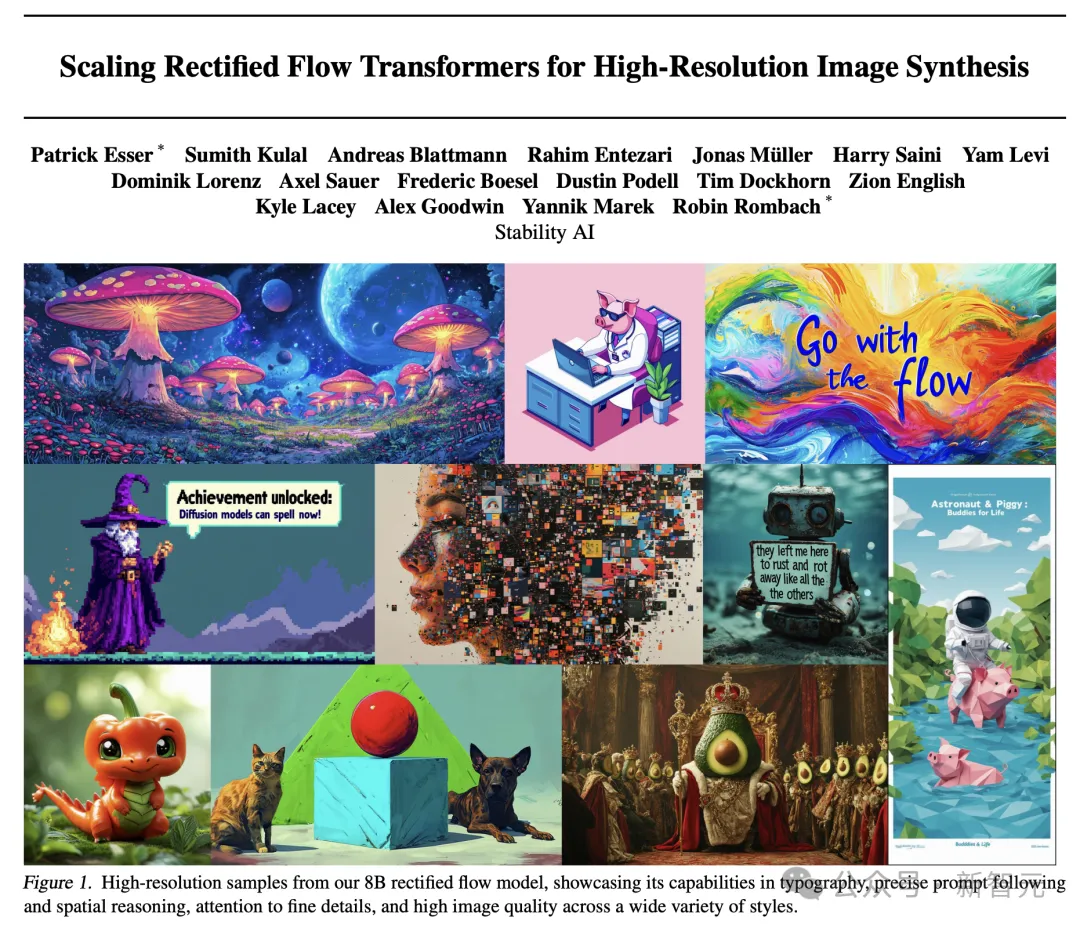

緊接著3月,Stability AI公布了新模型最詳實的技術報告。

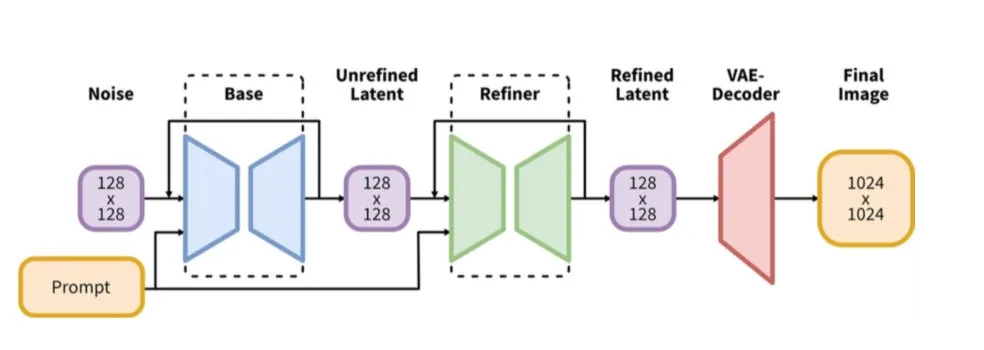

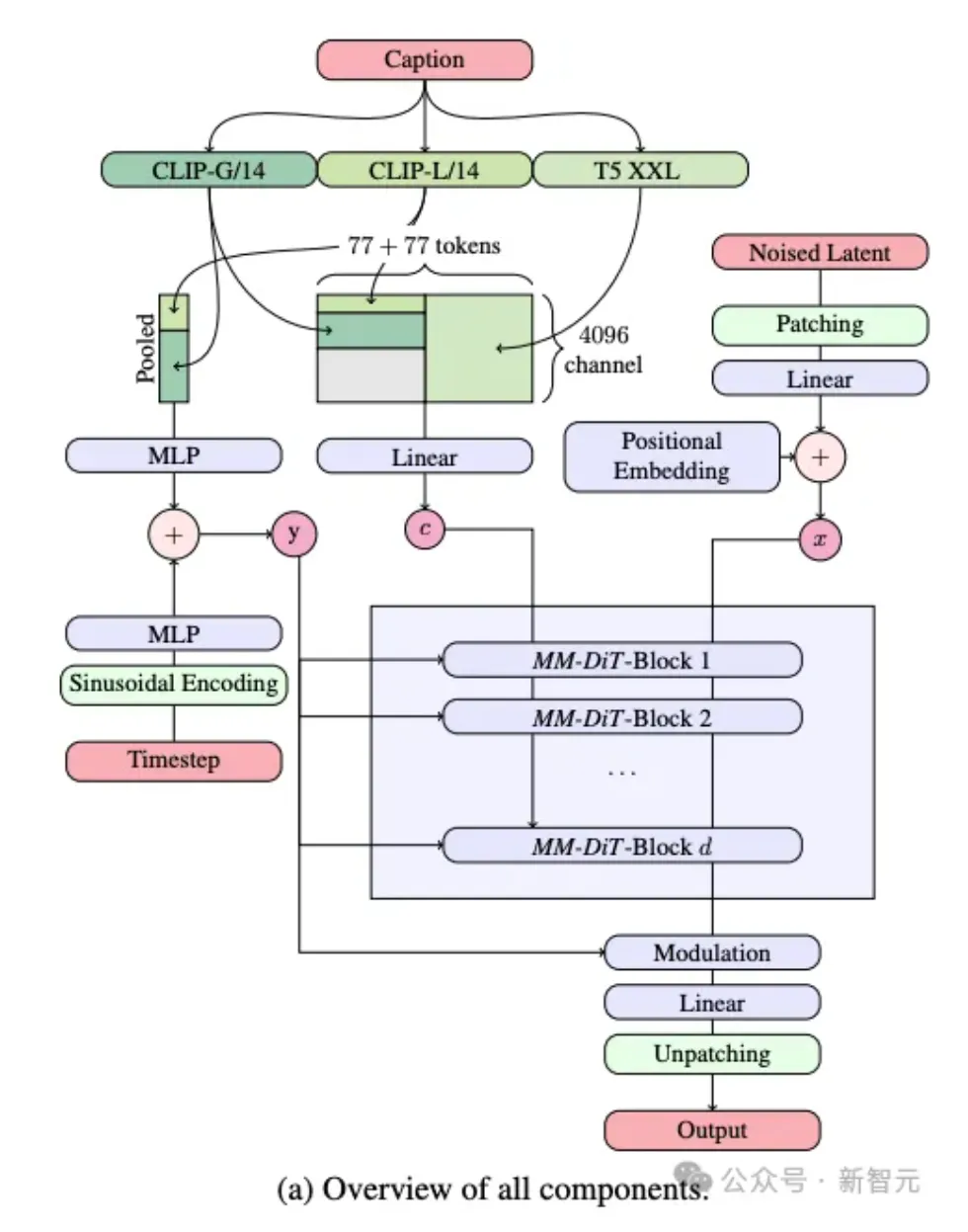

論文中,首次介紹了Stable Diffusion 3背后核心技術——改進版的Diffusion模型和一個基于DiT的文生圖全新架構!

論文地址:https://stabilityai-public-packages.s3.us-west-2.amazonaws.com/Stable+Diffusion+3+Paper.pdf

與之前的版本對比,SD3明顯在圖像質量生成上,實現了很大的改進,不僅支持多主題提示。

最重要的是,文字拼寫的效果也變好了。

這一切竟是因為,其背后框架的改進和創新。

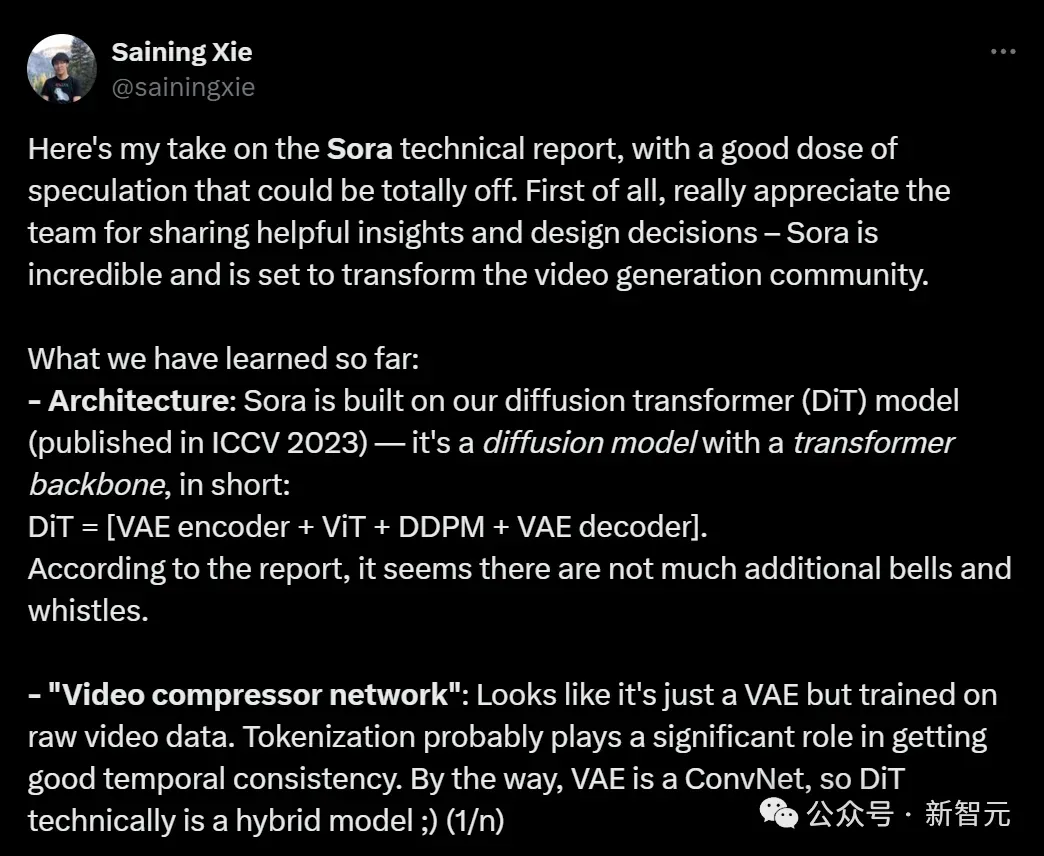

它用上了與Sora同樣的DiT架構,靈感來源于紐約大學助理教授謝賽寧的研究。

而在以前的Stable Diffusion版本中,并未采用Transformer技術。

在文生圖的任務中,SD3需要同時考慮文本+圖像兩種模態。

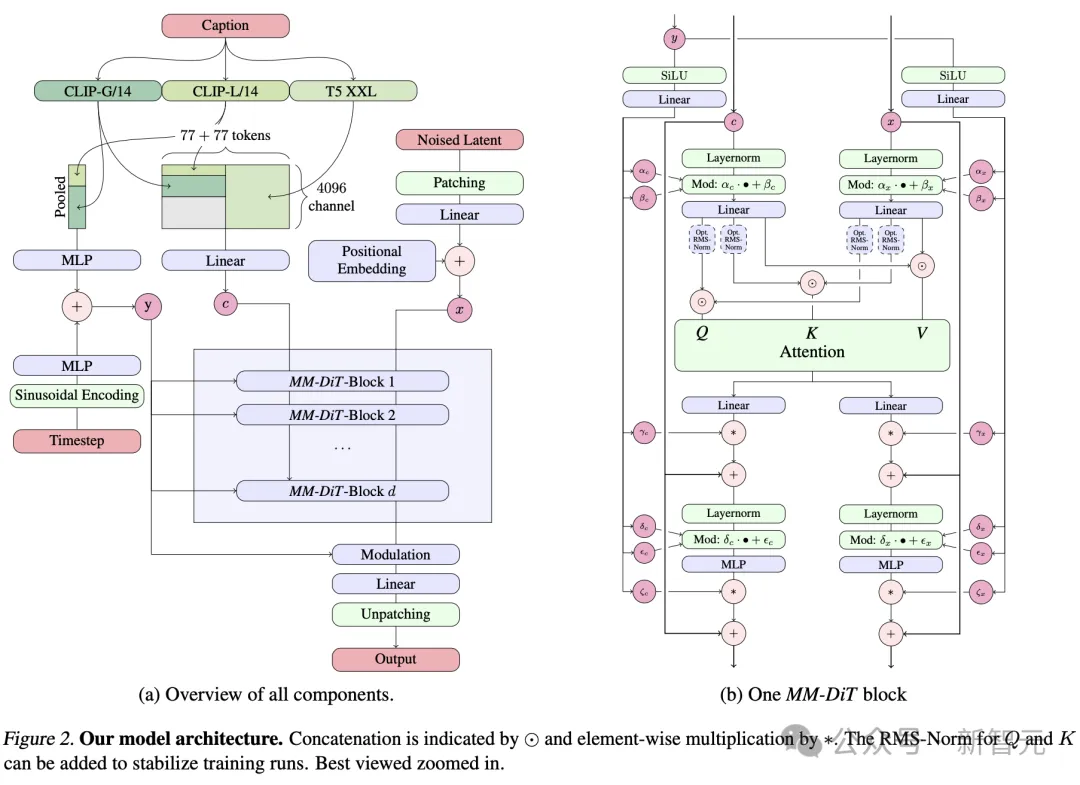

因此,研究者提出了一種全新的架構,稱為——MMDiT(多模態Diffusion Transformer),專為處理這種多模態的能力。

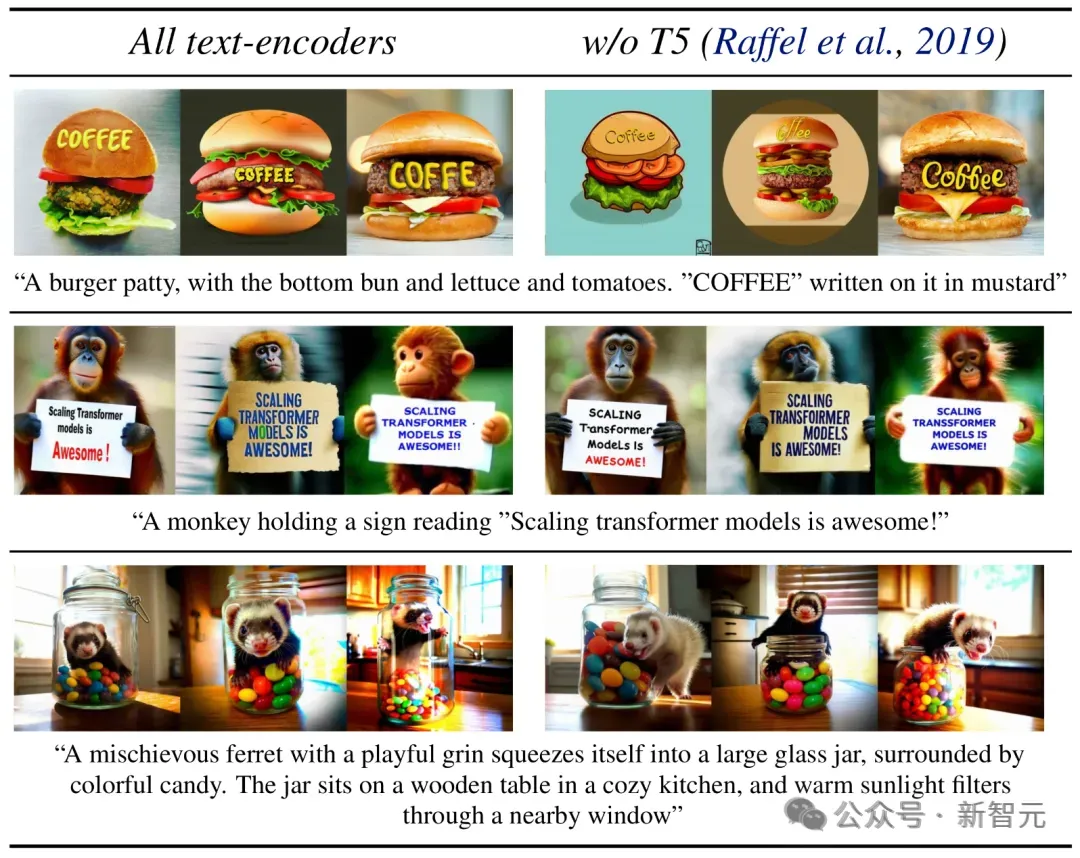

具體而言,模型采用了三種不同的文本嵌入模型——兩個CLIP模型和一個T5 ,來處理文本信息。

與此同時,還采用了一個自編碼模型來編碼圖像token。

因為文本和圖像嵌入在概念上有很大不同,下圖右中可以看出,研究者對兩種模態使用了兩種不同的權重。

基于這種獨特的架構,使得圖像和文本信息之間可以相互流動和交互,從而在生成的結果中提高對內容的整體理解和視覺表現。

而且,這種架構未來還可以輕松擴展到其他包括視頻在內的多種模態。

實驗評估中,SD3在人類偏好評估中超越了DALL-E 3和Midjourney v6,成為該領域的SOTA模型。

而且,SD3是一個模型系列,提供了8億到80億參數版本,意味著可以在終端設備可跑,大大降低了AI應用的門檻。

網友們對此激動不已,紛紛催更他們快速上線。

SD3開源倒計時開啟,接下來坐等上手了。