新開源之王來了!1320億參數,邏輯數理全面打贏Grok,還比Llama2-70B快1倍

“最強”開源大模型之爭,又有新王入局:

大數據巨頭Databricks,剛剛發布MoE大模型DBRX,并宣稱:

它在基準測試中擊敗了此前所有開源模型。

包括同為混合專家模型的Grok-1和Mixtral。

新王攪局,迅速引發了開源社區的熱議。

畢竟,僅從紙面數據來看,DBRX頗具特點:總參數量為1320億,但因為是混合專家模型,每次激活參數量僅為360億。

就是說,在總參數量接近Llama2-70B的2倍的情況下,DBRX的生成速度也比Llama2-70B快1倍。

△DBRX vs Llama2-70B

另外,DBRX是在12T token上從頭訓練的,訓練數據量是Llama2的6倍,也就是Chinchilla定律推薦量的18倍。

網友們的第一反應be like:

首席科學家:打賭輸了就把頭發染藍

來看DBRX的具體細節。

DBRX由16個專家模型組成,每次訓練推理會有4個專家處于激活狀態。其上下文長度為32K。

為了訓練DBRX,Databricks團隊從云廠商那里租用了3072個H100。

一個細節是,團隊向Wired透露,經過兩個月的訓練之后,DBRX已經在基準測試中取得了不錯的分數。而在那個時候,他們買的云資源還能再跑一個星期。

團隊因此產生了小小的分歧:是用這些資源來訓練一個小杯版本,還是再投喂給模型一些高質量數據,用課程學習(curriculum learning)的方法來提高DBRX在一些特定任務上的能力?

經過一番熱烈的內部討論,Databricks團隊最終決定走課程學習路線。

正是這一決策使他們收獲頗豐:

Databricks首席科學家Jonathan Frankle(就叫他老弗吧)認為,課程學習使得DBRX“產生了有意義的變化”。

具象化一點來說,就是老弗本來覺得DBRX可能搞不太定代碼生成,還打賭說如果他判斷錯了,就去把頭發染成藍色。

而這是他的最新照片:

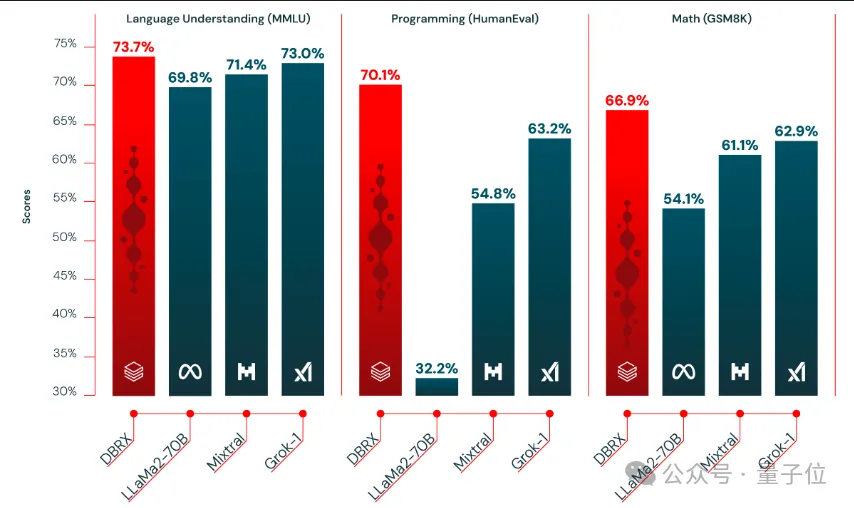

回到正題,DBRX的測試結果顯示,它在語言理解、編程、數學和邏輯方面都達到了SOTA,擊敗包括Llama2-70B、Mixtral和Grok-1在內的一眾開源大模型。

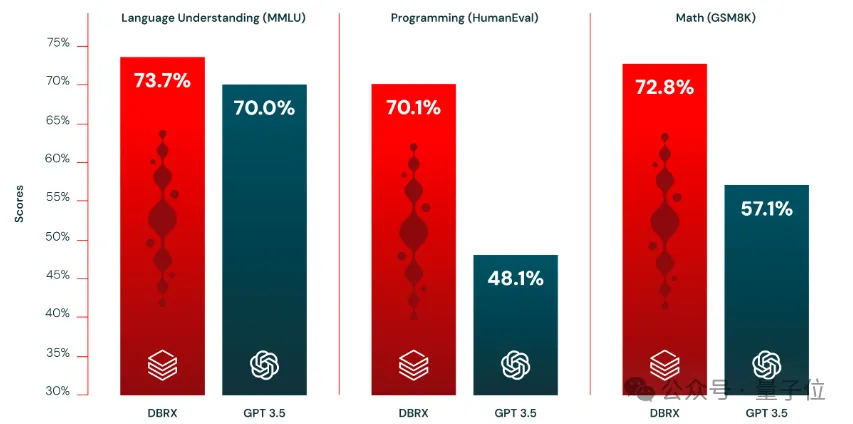

還在大多數基準測試中都擊敗了GPT-3.5。

Databricks這次開源了DBRX的兩個版本:DBRX Base和DBRX Instruct,前者是預訓練基礎模型,后者則經過指令微調。

老弗還對Wired透露,他們團隊接下來計劃對模型訓練的那個“最后一周”展開研究,看看DBRX這樣強大的模型是如何在其中收獲額外技能的。

值得一提的是,去年6月,Databricks以13億美元(約93億人民幣)的價格,買下了僅62名員工的AI初創公司MosaicML——

就是發布了MPT系列開源模型的那家。

老弗當時就是MosaicML的首席科學家。此后,他和他的團隊一起留在了Databricks。

開源社區嗨翻

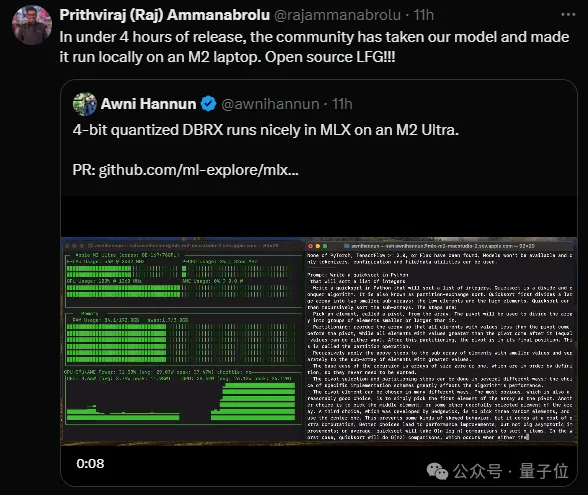

DBRX發布不到4小時,已經有人把它成功部署到蘋果M2芯片筆記本電腦上了。

而大模型競技場也第一時間開放了DBRX-instruct的投票。

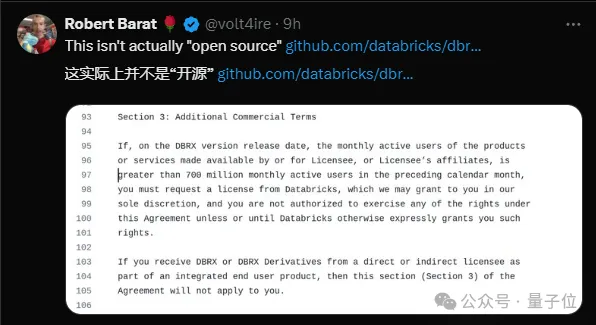

不過,也有人對DBRX的“開源”提出了質疑:

根據Databricks公布的協議,基于DBRX打造的產品,如果月活超過7億,就必須另行向Databricks提交申請。