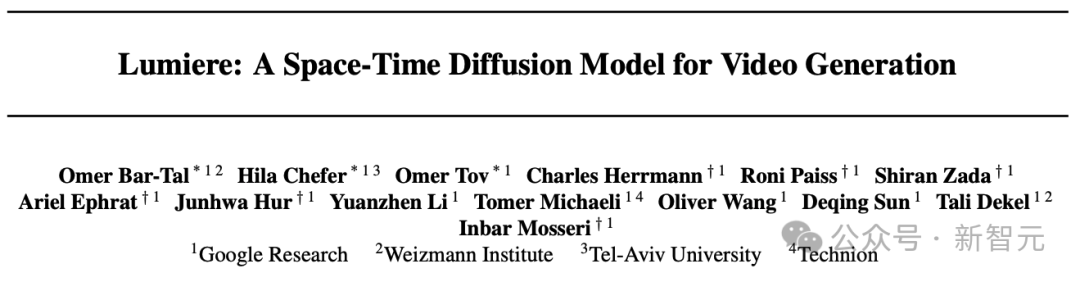

拳打Gen-2腳踢Pika,谷歌爆肝7個月祭出AI視頻大模型!首提時空架構(gòu),時長史詩級延長

AI視頻賽道上,谷歌又再次放出王炸級更新!

這個名為Google Lumiere的模型,是個大規(guī)模視頻擴(kuò)散模型,徹底改變了AI視頻的游戲規(guī)則。

跟其他模型不同,Lumiere憑借最先進(jìn)的時空U-Net架構(gòu),在一次一致的通道中生成整個視頻。

具體來說,現(xiàn)有AI生成視頻的模型,大多是在生成的簡短視頻的基礎(chǔ)上并對其進(jìn)行時間采樣而完成任務(wù)。

而谷歌推出的新模型Google Lumiere是通過是聯(lián)合空間和「時間」下采樣(downsampling)來實(shí)現(xiàn)生成,這樣能顯著增加生成視頻的長度和生成的質(zhì)量。

論文地址:https://arxiv.org/abs/2401.12945

值得一提的是,這是谷歌團(tuán)隊歷時7個月做出的最新成果。

對于這驚人的「谷歌速度」,網(wǎng)友們紛紛表示驚嘆——

谷歌從來不睡覺啊?

開發(fā)者回答:不睡

居然做出了走路、跳舞這樣的人體力學(xué)視頻,我的天,我以為這需要6到12個月才能做出來,AI真的是在以閃電般的速度發(fā)展。(我的工作流中需要這個模型)

全新STUNet架構(gòu):時間更長更連貫

為了解決AI視頻長度不足,運(yùn)動連貫性和一致性很低,偽影重重等一系列問題,研究人員提出了一個名為Space-Time U-Net(STUNet)的架構(gòu)。

傳統(tǒng)視頻模型生成的視頻往往會出現(xiàn)奇怪的動作和偽影

能夠?qū)W習(xí)將視頻信號在空間和時間上同時進(jìn)行下采樣和上采樣,并在網(wǎng)絡(luò)的壓縮空間時間表征上執(zhí)行主要計算。

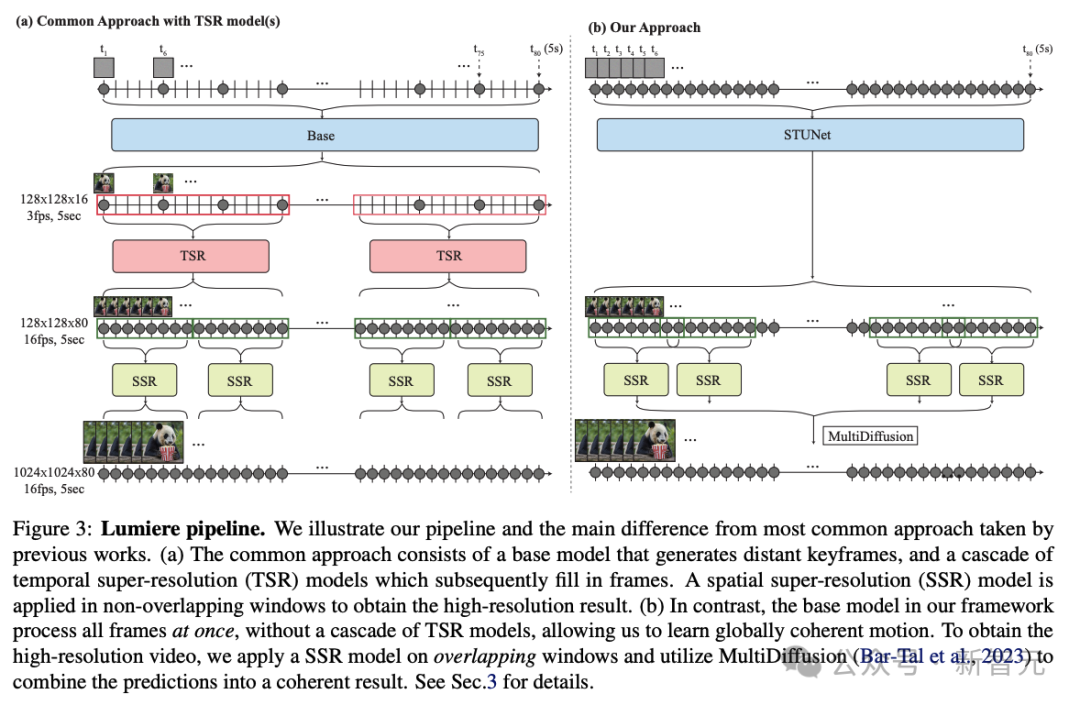

相比之前的文本到視頻模型采用級聯(lián)設(shè)計的方式,先由基模型生成關(guān)鍵幀,然后使用一系列時序超分辨率模型在非重疊段內(nèi)進(jìn)行插值幀的生成。

STUNet可以學(xué)習(xí)直接生成全幀率的低分辨率視頻。這種設(shè)計避免了時序級聯(lián)結(jié)構(gòu)在生成全局連貫運(yùn)動時固有的限制。

STUNet架構(gòu)可以直接生成5秒長的80幀視頻,時間長度超過大多數(shù)媒體中的平均鏡頭長度,這可以產(chǎn)生比之前模型更連貫一致的運(yùn)動。

功能豐富,效果拔群

視頻編輯/修復(fù)

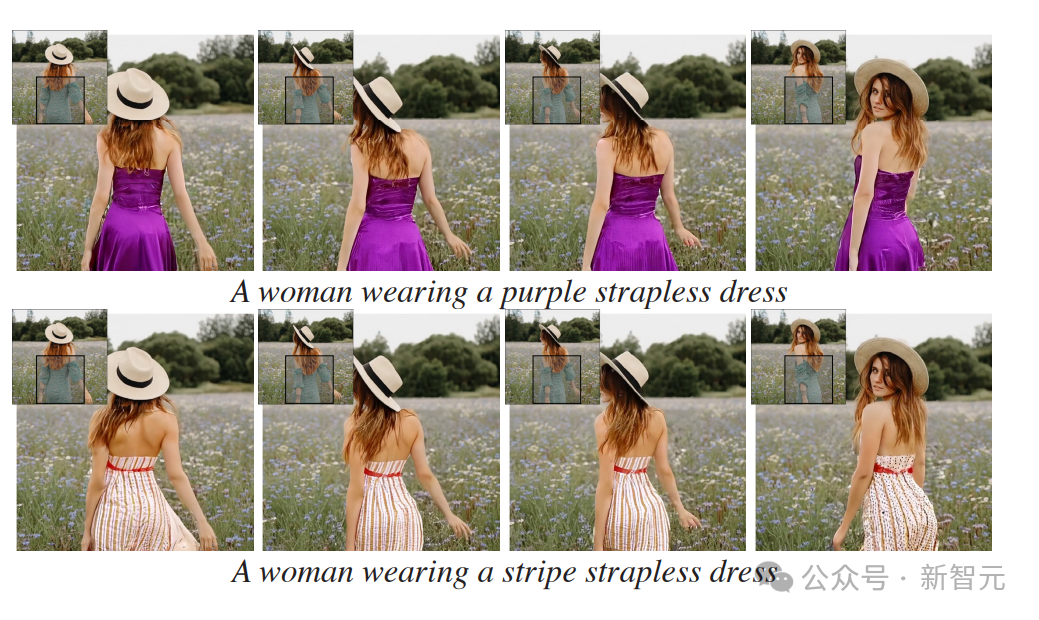

這項功能可以讓我們編輯視頻,或者在視頻中插入對象。

比如這個穿綠底白花裙的女孩,只要選中衣服區(qū)域,輸入文字修改要求,就能瞬間把她的裙子改成紅白條紋裙、金色抹胸裙。

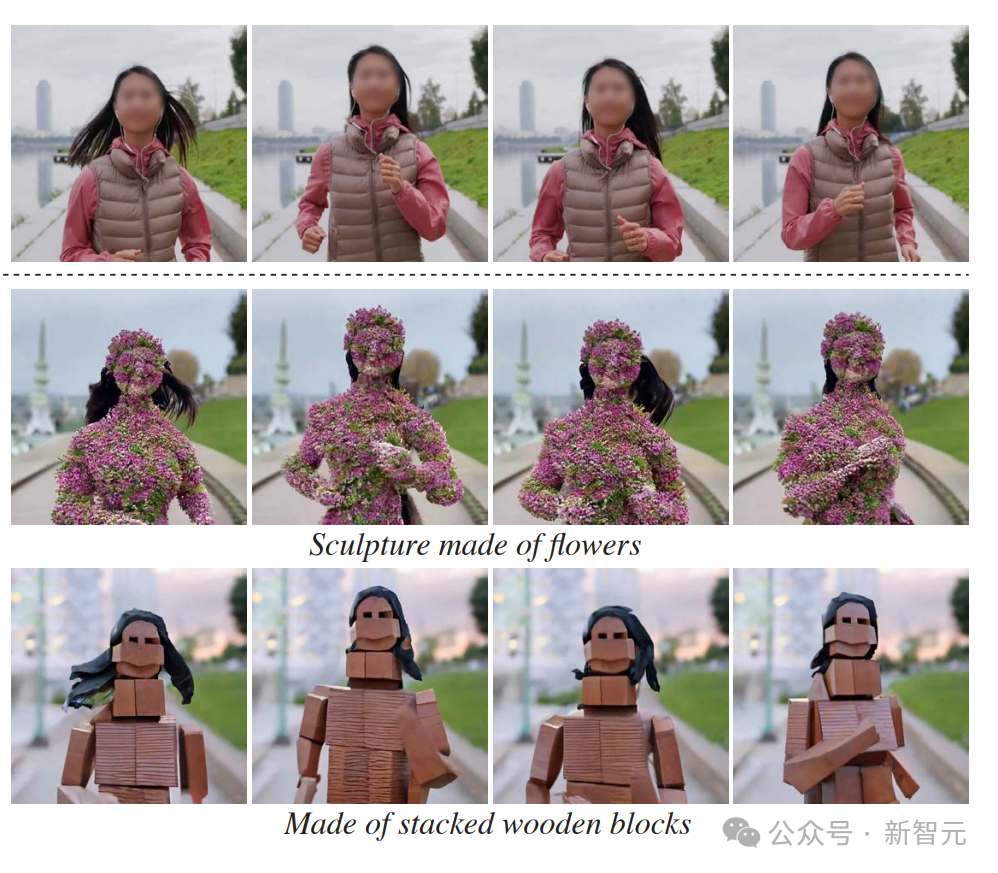

正在跑步的女孩,只要用文字編輯,就可以讓她長滿鮮花,或者變成木磚風(fēng)、折紙風(fēng)、樂高風(fēng)。

也可以專門針對視頻中某一部分的內(nèi)容進(jìn)行修改和編輯。

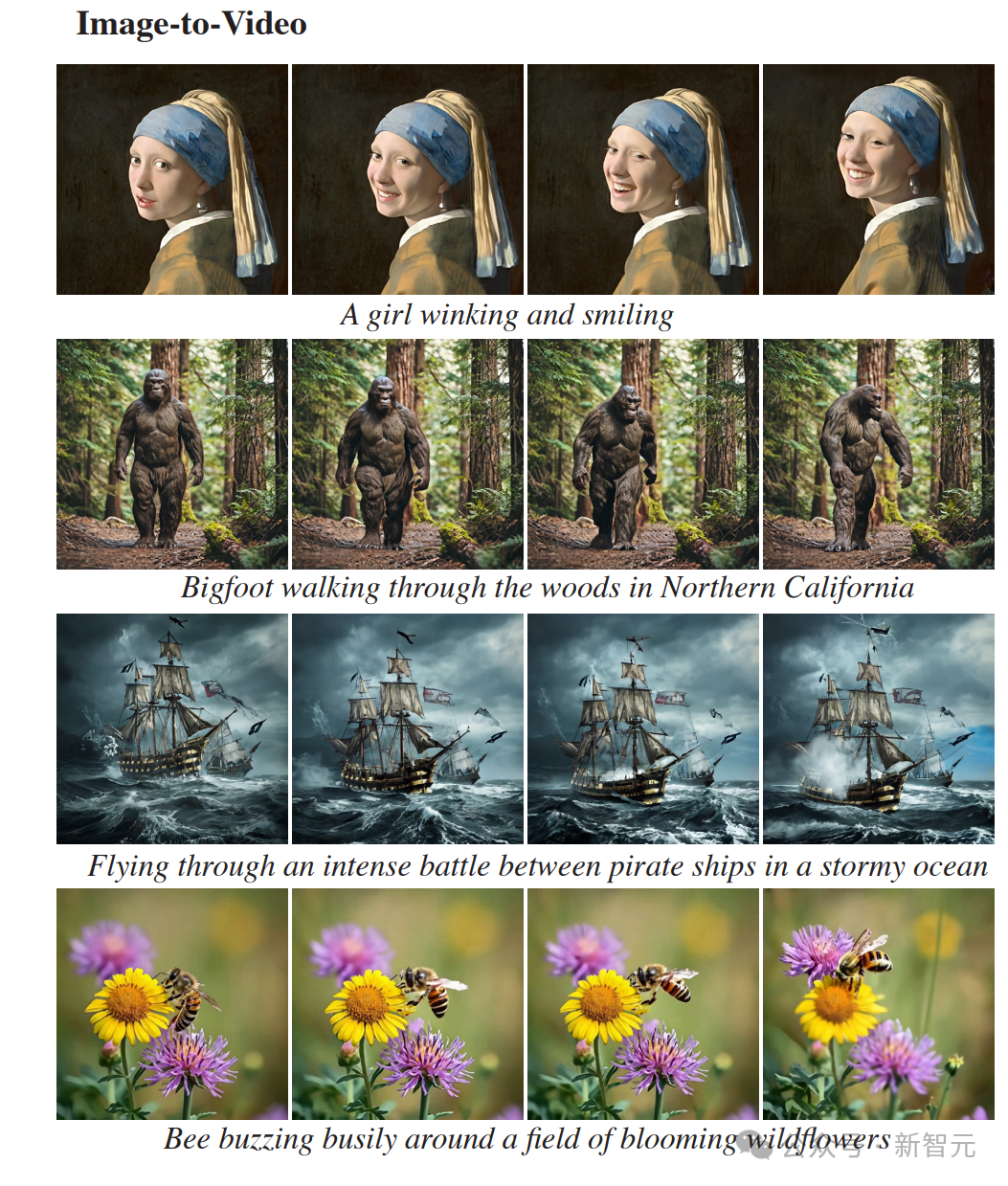

圖生視頻

Lumiere另外一個非常好用的功能,就是將靜止圖像轉(zhuǎn)換為動態(tài)視頻。

輸入文字提示,就能讓戴珍珠耳環(huán)的少女從名畫中走出,張嘴笑了起來。

梵高畫的《星空》,夜空中的星星和云層真的開始流動了起來。

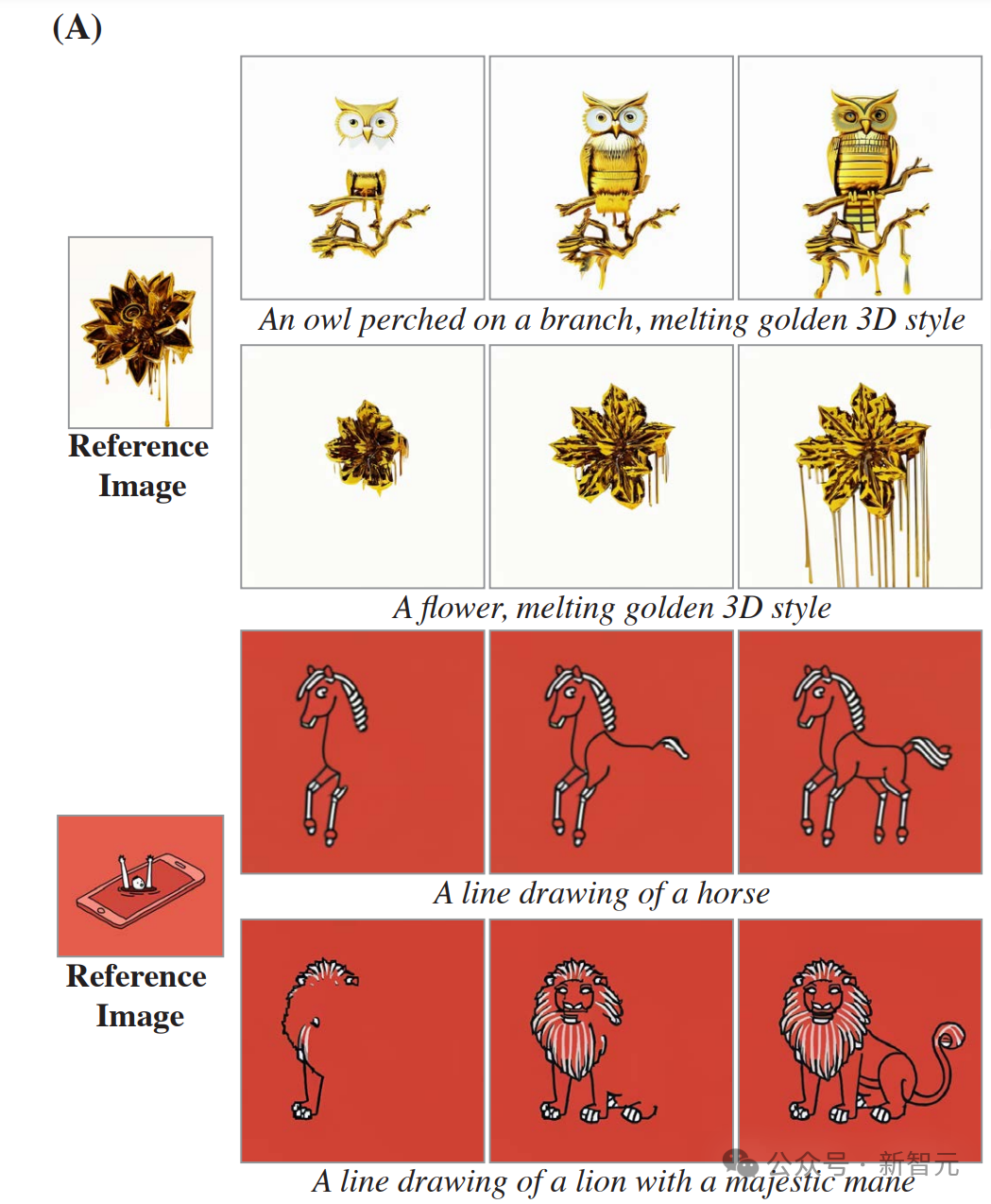

風(fēng)格化生成

Lumiere能生成各種指定藝術(shù)風(fēng)格的視頻。

只要給出一個指定的風(fēng)格,再通過文字提示,就能按照類似風(fēng)格生成非常多的視頻。

可以看到,對比參考靜圖的風(fēng)格來看,生成視頻的風(fēng)格復(fù)現(xiàn)得非常精準(zhǔn)。

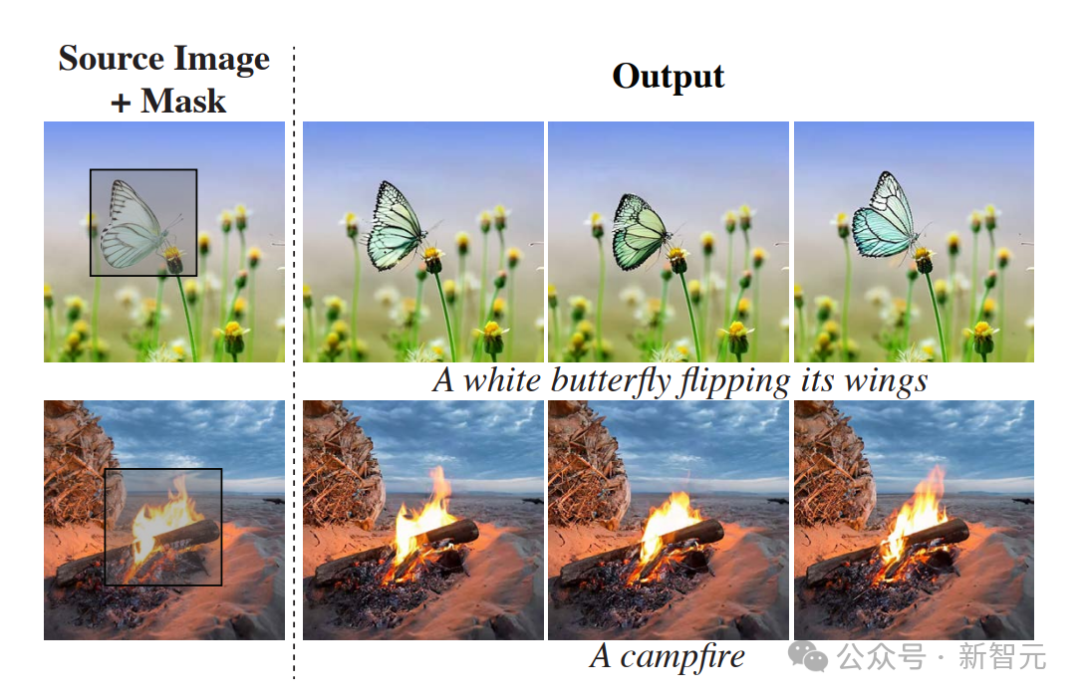

動作筆刷

通過這個名為Cinemagraphs(又名 Motion Brush)的風(fēng)格,我們可以選中靜圖中的特定部分,讓它動起來。

選中圖中的這團(tuán)火焰,它就開始熊熊燃燒起來。

選中圖中的煙,火車就開始冒出汩汩濃煙來。

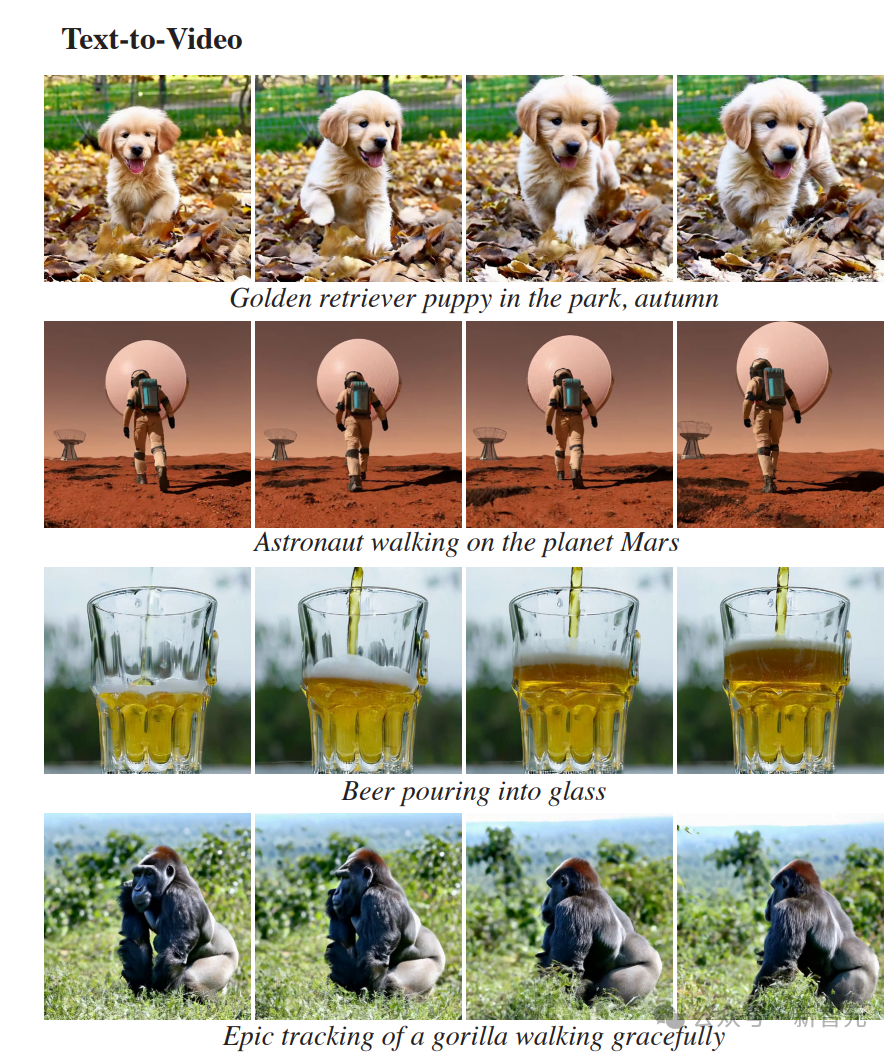

文生視頻

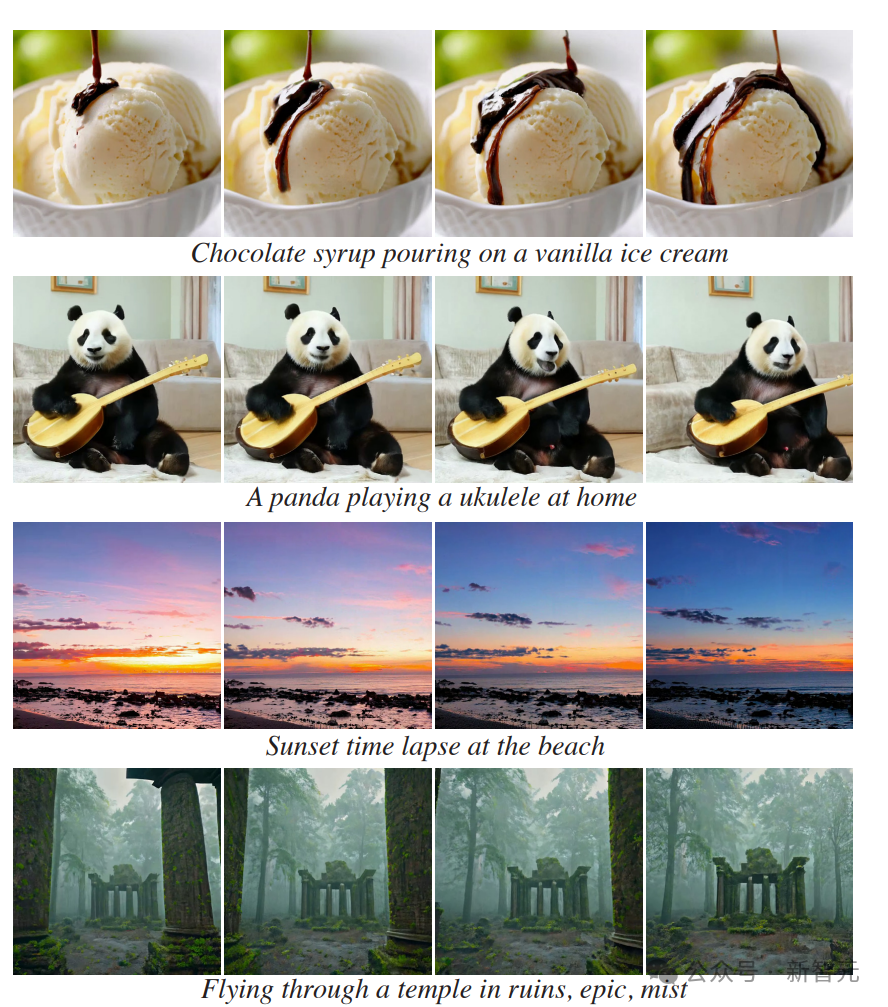

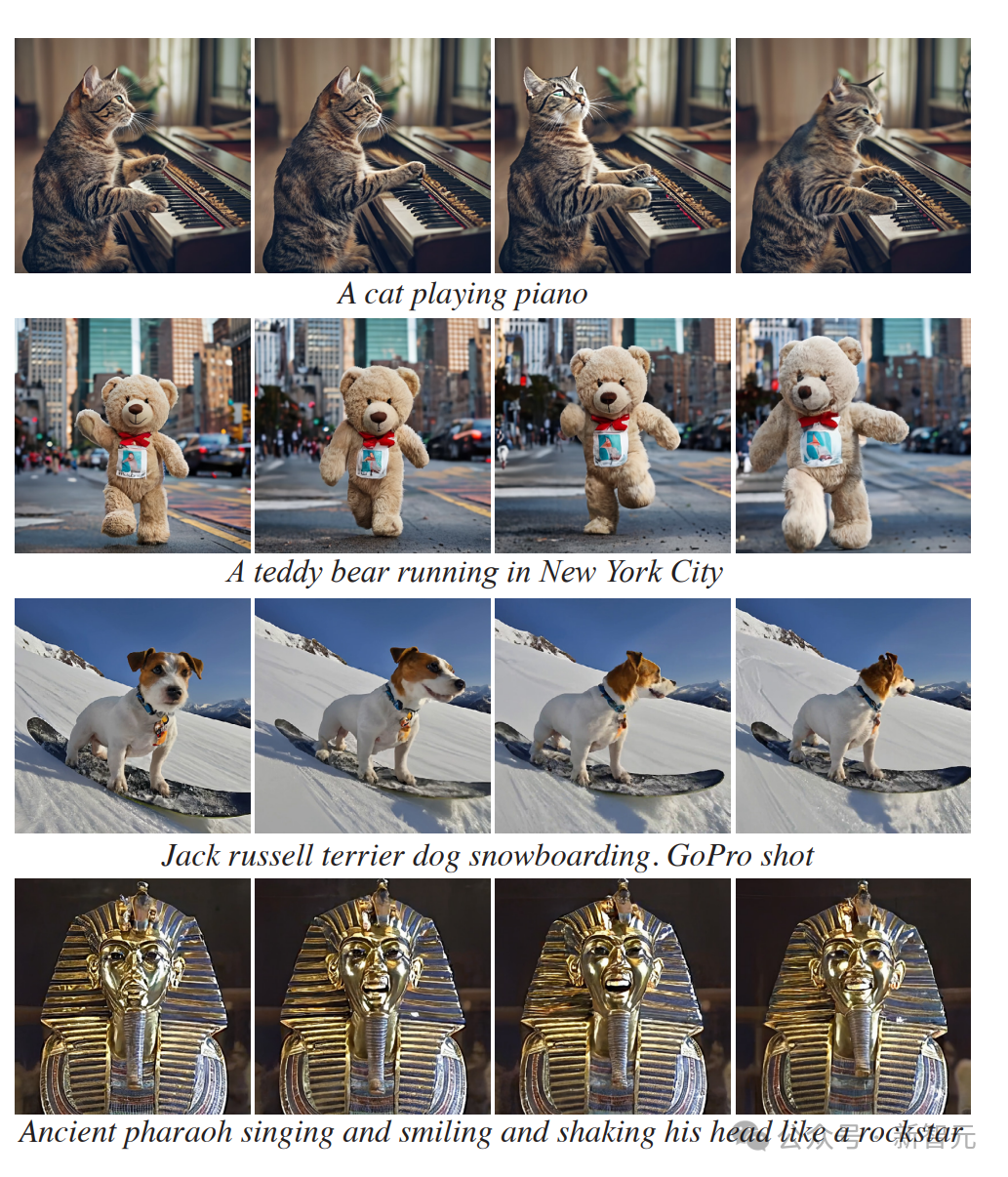

當(dāng)然,Lumiere也可以直接從文本生成詳細(xì)的視頻。

無論是一個在火星基地周圍漫步的宇航員。

還是一只戴著太陽鏡開著車的狗。

或者飛過一座廢棄的廟宇,在遺跡中穿行。

還可以針對視頻中缺失的部分進(jìn)行補(bǔ)充。

STUNet架構(gòu)帶來的全新突破

這次,谷歌的研究者采用了跟以往不同的方法,引入了新的T2V擴(kuò)散框架,該框架可以立即生成視頻的完整持續(xù)時間。

為了實(shí)現(xiàn)這一目標(biāo),他們使用了STUNet架構(gòu),這個架構(gòu)可以學(xué)習(xí)在空間和時間上對信號進(jìn)行下采樣,并且以壓縮的時空表征形式,執(zhí)行大部分計算。

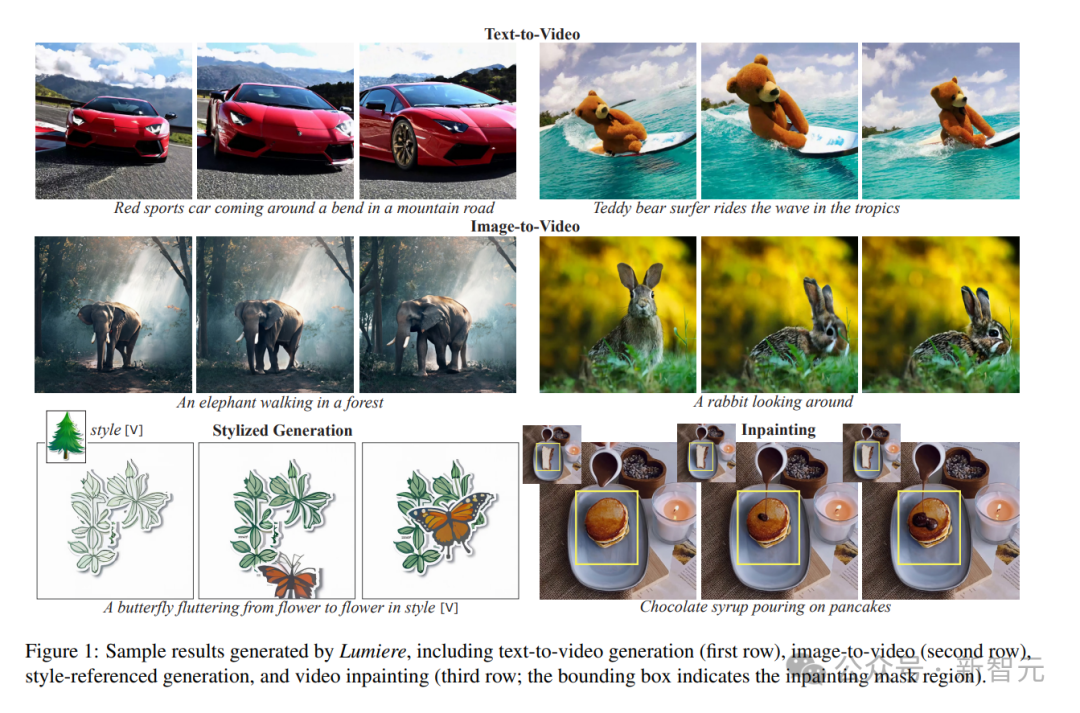

Lumiere生成的示例結(jié)果,包括文本到視頻生成(第一行)、圖像到視頻(第二行)、風(fēng)格引用生成和視頻修復(fù)(第三行邊界框表示修復(fù)掩碼區(qū)域)

采用這種方法,就能夠以16fps(或5秒)生成80幀,這比大多數(shù)使用單一基礎(chǔ)模型的媒體要好。

跟之前的工作相比,產(chǎn)生了更多的全局連貫運(yùn)動。

令人驚訝的是,這種設(shè)計選擇被以前的T2V模型忽視了,這些模型遵循慣例,在架構(gòu)中僅包含空間下采樣和上采樣操作,并在整個網(wǎng)絡(luò)中保持固定的時間分辨率。

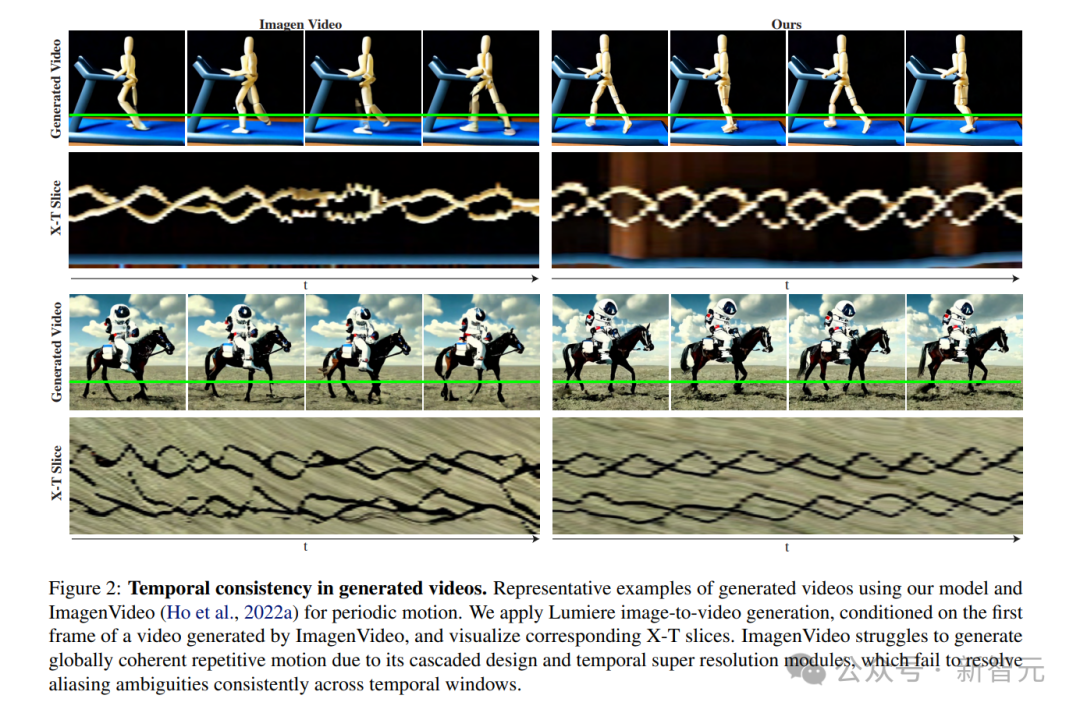

使用Lumiere和ImagenVideo進(jìn)行周期性運(yùn)動生成視頻的代表性示例。研究者應(yīng)用 Lumiere圖像到視頻生成,以ImagenVideo生成的視頻的第一幀為條件,可視化相應(yīng)的X-T切片。由于其級聯(lián)設(shè)計和時間超分辨率模塊,Imagenvideo難以生成全局連貫的重復(fù)運(yùn)動,而這些模塊無法跨時間窗口,一致地解決混疊模糊問題

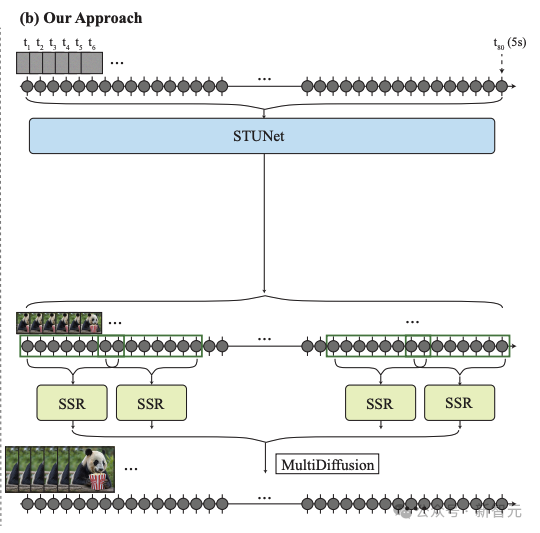

研究人員的框架由基本模型和空間超分辨率(SSR)模型組成。

如上圖3b所示,研究人員的基礎(chǔ)模型以粗略的空間分辨率生成完整的剪輯。

他們的基礎(chǔ)模型的輸出使用時間感知的SSR模型進(jìn)行空間上采樣,從而產(chǎn)生高分辨率視頻。

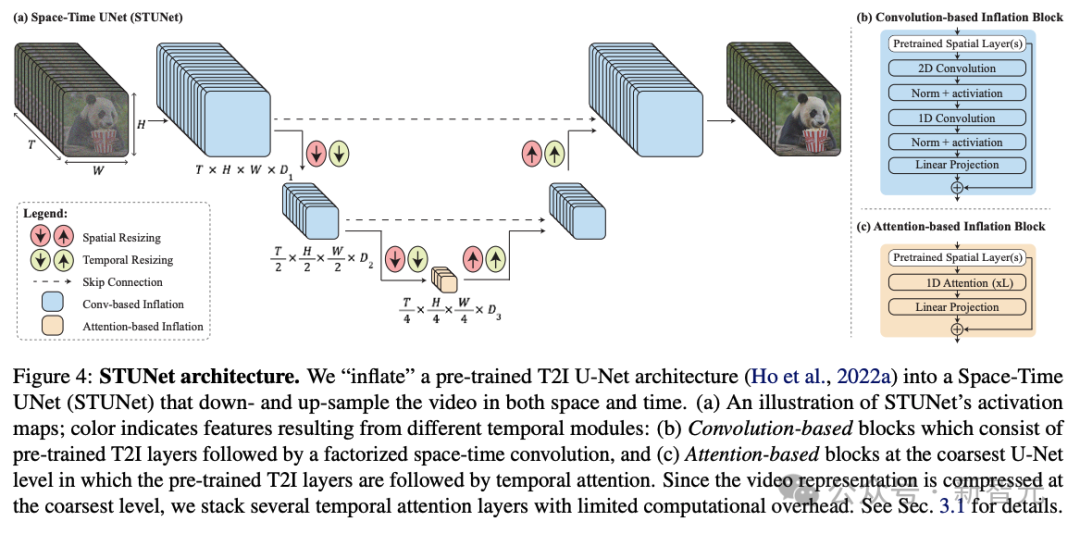

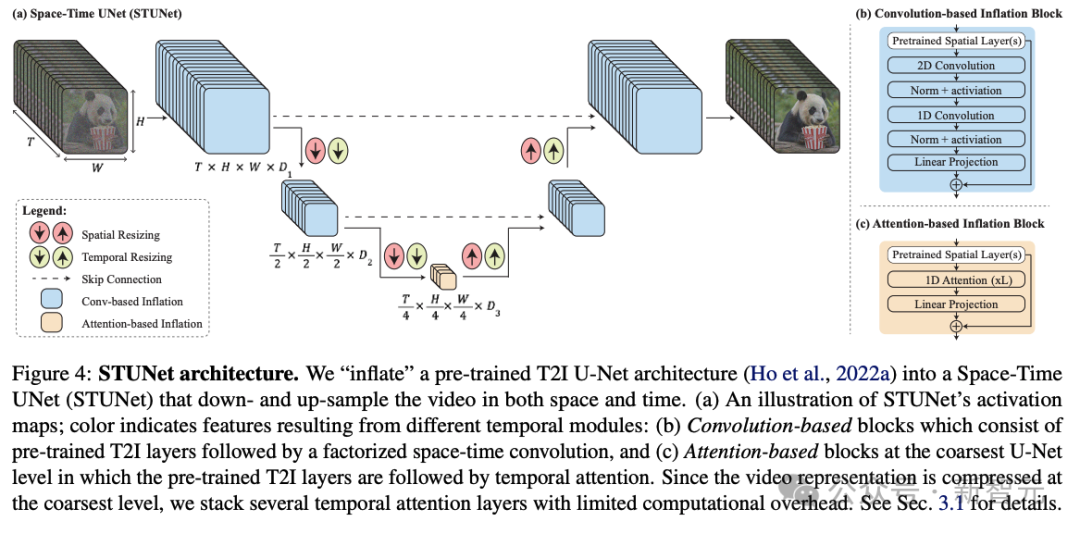

研究人員的架構(gòu)如上圖所示。

他們在T2I架構(gòu)中交織時間塊,并在每個預(yù)訓(xùn)練的空間調(diào)整大小模塊之后插入時間下采樣和上采樣模塊(圖4a)。時間塊包括時間卷積(圖4b)和時間注意力(圖4c)。

具體來說,在除了最粗糙的級別之外的所有級別中,他們插入因式分解的時空卷積(圖4b),與全3D卷積相比,它允許增加網(wǎng)絡(luò)中的非線性,同時降低計算成本,并與一維卷積。

由于時間注意力的計算要求與幀數(shù)呈二次方關(guān)系,因此他們僅在最粗分辨率下合并時間注意力,其中包含視頻的時空壓縮表示。

在低維特征圖上進(jìn)行操作允許他們以有限的計算開銷堆疊多個時間注意力塊。

研究人員訓(xùn)練新添加的參數(shù),并保持預(yù)訓(xùn)練T2I的權(quán)重固定。值得注意的是,常見的膨脹方法確保在初始化時,T2V模型相當(dāng)于預(yù)訓(xùn)練的T2I模型,即生成視頻作為獨(dú)立圖像樣本的集合。

然而,在研究人員的例子中,由于時間下采樣和上采樣模塊,不可能滿足這個屬性。

他們憑經(jīng)驗(yàn)發(fā)現(xiàn),初始化這些模塊以使它們執(zhí)行最近鄰下采樣和上采樣操作會產(chǎn)生一個良好的起點(diǎn)(就損失函數(shù)而言)。

應(yīng)用展示

以下是文生視頻和圖像生視頻的示例。

從圖像到視頻的示例中,最左邊的幀是作為條件提供給模型的。

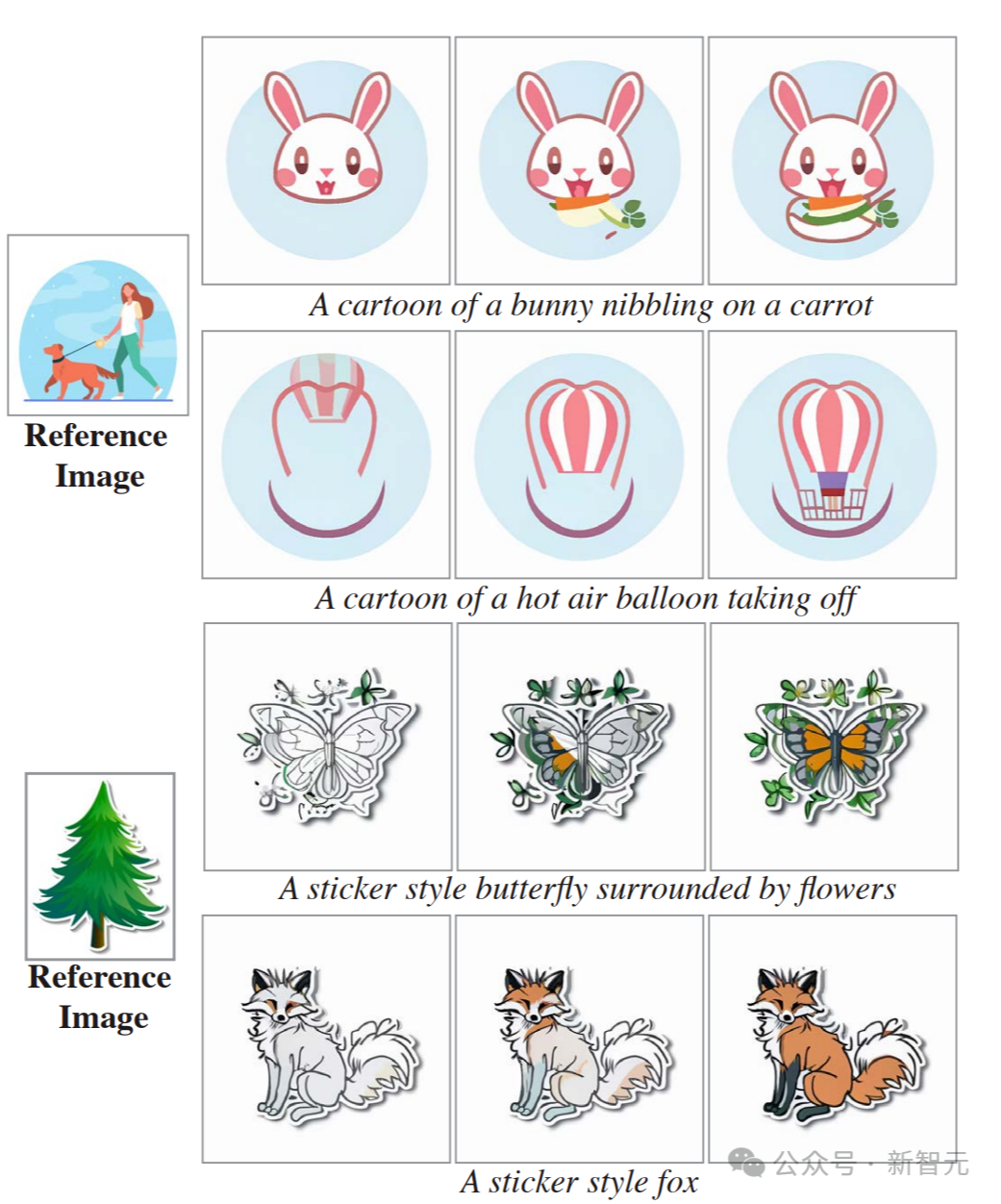

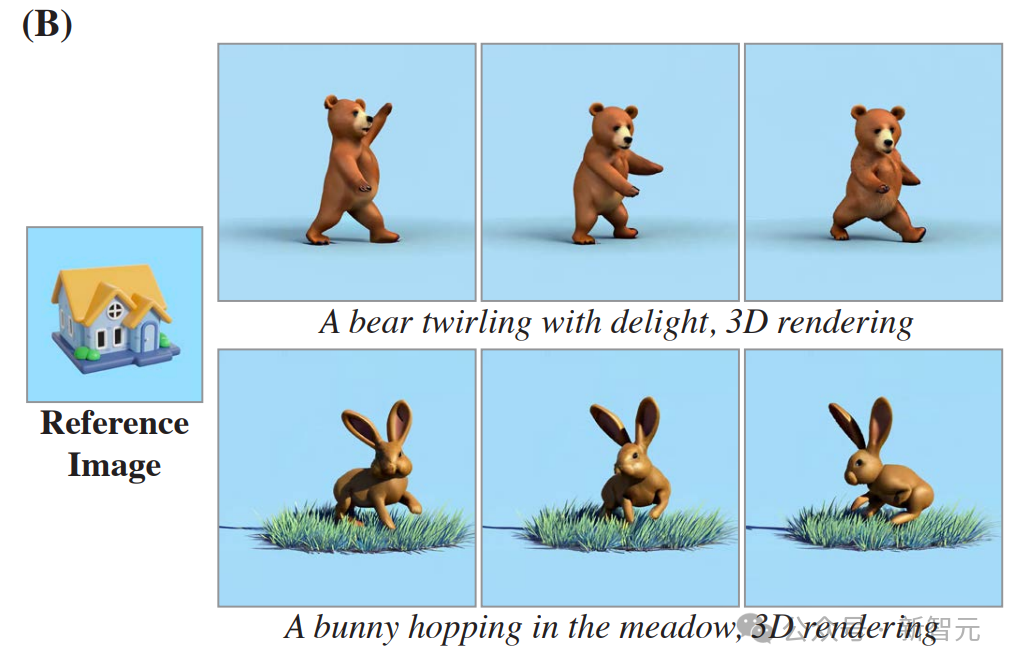

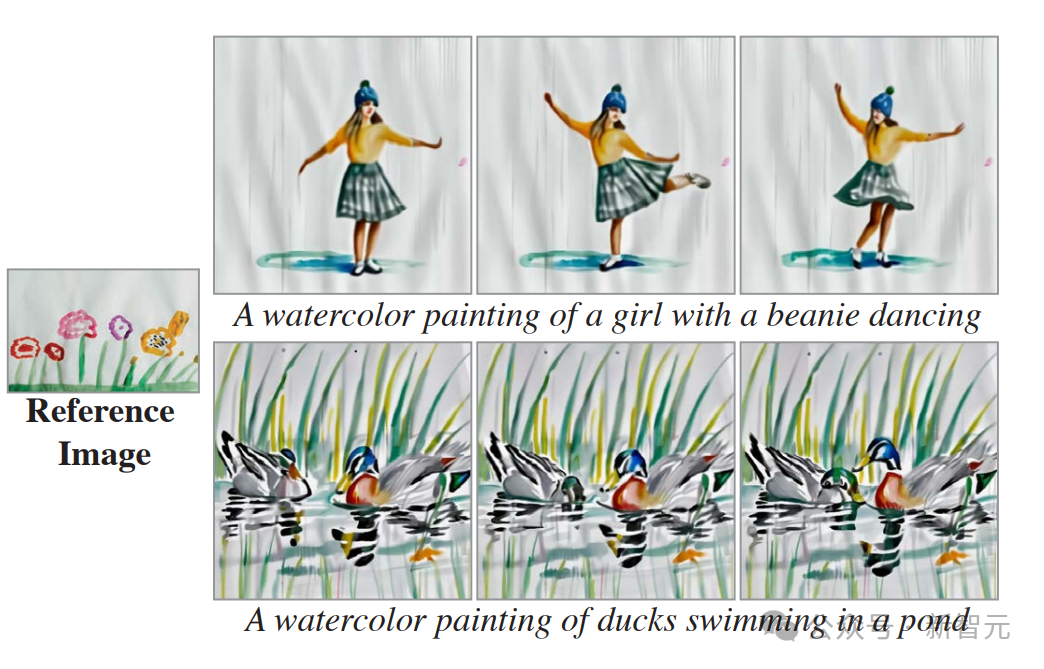

以下是風(fēng)格化生成的示例。

給定起始風(fēng)格圖像及其相應(yīng)的一組微調(diào)文本到圖像權(quán)重,就可以在模型空間層的微調(diào)權(quán)重和預(yù)訓(xùn)練權(quán)重之間執(zhí)行線性插值。

研究者展示了(A)矢量藝術(shù)風(fēng)格和(B)寫實(shí)風(fēng)格的結(jié)果。

這證明了,Lumiere能夠?yàn)槊糠N空間風(fēng)格創(chuàng)造性地匹配不同的運(yùn)動(幀從左到右顯示)。

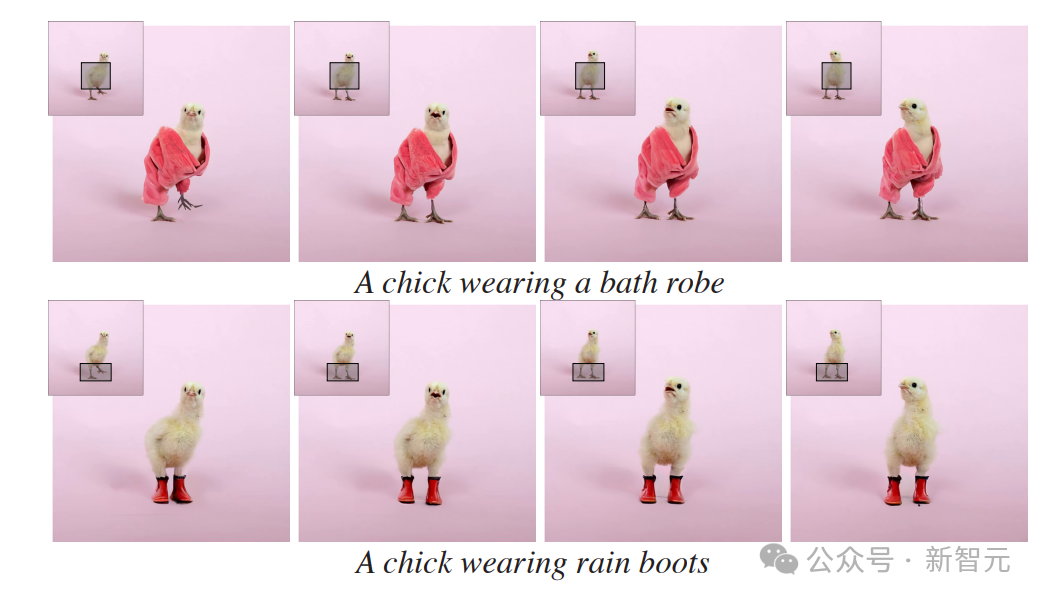

以下是使用Lumiere進(jìn)行視頻修復(fù)的示例。

對于每個輸入視頻(每個幀的左上角),研究者都使用了Lumiere對視頻的掩碼區(qū)域進(jìn)行了動畫處理。

以下為動態(tài)圖像的示例。

僅給定輸入圖像和掩碼(左),研究者的方法會生成一個視頻,其中標(biāo)記區(qū)域是動態(tài)的,其余部分保持靜態(tài)(右)。

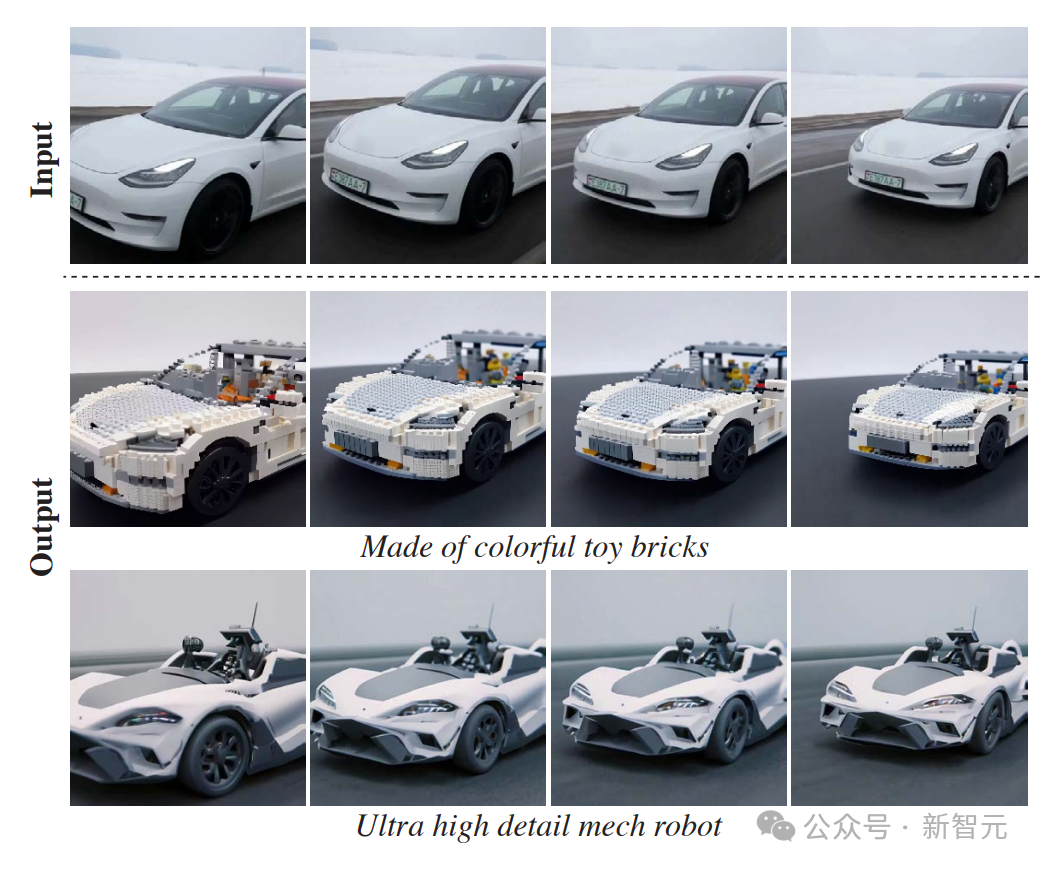

以下是通過SDEdit進(jìn)行視頻生視頻的示例。

Lumiere基本模型可以生成全幀率視頻,無需TSR級聯(lián),從而為下游應(yīng)用程序提供更直觀的界面。

研究者通過使用SDEdit來演示此屬性,從而實(shí)現(xiàn)一致的視頻風(fēng)格化。

在第一行顯示給定輸入視頻的幾個幀,下面幾行顯示相應(yīng)的編輯幀。

與Gen-2和Pika等模型的對比和評估

定性評估

研究人員在下圖中展示了他們的模型和基線之間的定性比較。

研究人員觀察到Gen-2和Pika表現(xiàn)出較高的每幀視覺質(zhì)量,然而,它們的輸出的特點(diǎn)是運(yùn)動量非常有限,通常會產(chǎn)生接近靜態(tài)的視頻。

ImagenVideo產(chǎn)生合理的運(yùn)動量,但整體視覺質(zhì)量較低。AnimateDiff和ZeroScope表現(xiàn)出明顯的運(yùn)動,但也容易出現(xiàn)視覺偽影。

此外,它們生成的視頻持續(xù)時間較短,分別為2秒和3.6秒。

相比之下,研究人員的方法生成的5秒視頻具有更高的運(yùn)動幅度,同時保持時間一致性和整體質(zhì)量。

定量評估

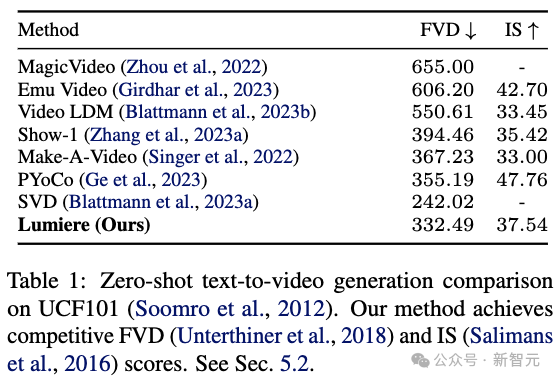

研究人員在UCF101上定量評估了他們的零樣本文本到視頻生成方法。

上表1展示了他們的方法和之前工作的區(qū)別(FVD)和初始分?jǐn)?shù)(IS)。

研究人員的系統(tǒng)取得了具有競爭力的FVD和IS分?jǐn)?shù)。然而,正如之前的工作中所討論的,這些指標(biāo)并不能準(zhǔn)確地反映人類的感知,并且可能會受到低級細(xì)節(jié)以及參考UCF101數(shù)據(jù)和T2V訓(xùn)練數(shù)據(jù)之間的分布變化。

此外,該協(xié)議僅使用生成視頻中的16幀,因此無法捕獲長期運(yùn)動。

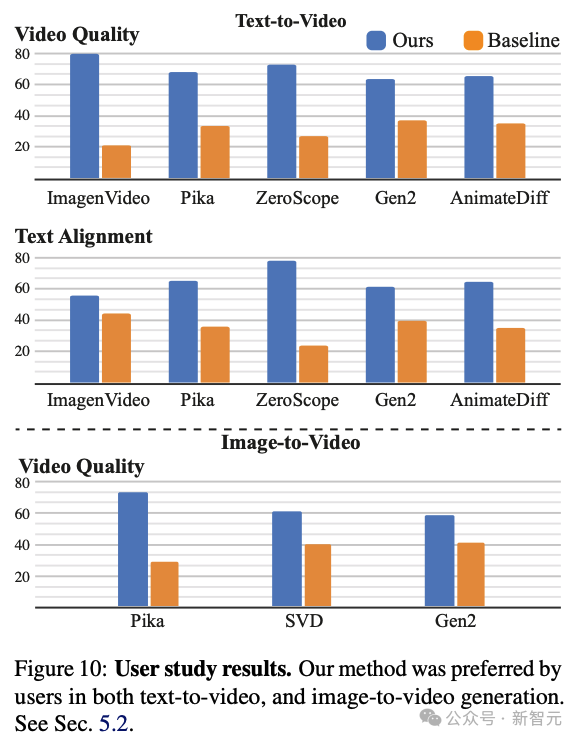

用戶研究

研究人員采用了之前的工作中使用的兩種選擇強(qiáng)制選擇(2AFC)協(xié)議。

在該協(xié)議中,向參與者展示了一對隨機(jī)選擇的視頻:一個由研究人員的模型生成,另一個由一種基線方法生成。然后,參與者被要求選擇他們認(rèn)為在視覺質(zhì)量和動作方面更好的視頻。

此外,他們還被要求選擇與目標(biāo)文本提示更準(zhǔn)確匹配的視頻。研究人員利用 Amazon Mechanical Turk(AMT)平臺收集了約400個用戶對每個基線和問題的判斷。

如上圖所示,研究人員的方法比所有基線都更受用戶青睞,并且與文本提示聯(lián)系更加緊密。

請注意,ZeroScope和AnimateDiff分別僅生成3.6秒和2秒的視頻,因此在與它們進(jìn)行比較時,研究人員會修剪視頻以匹配其持續(xù)時間。

研究人員進(jìn)一步進(jìn)行了一項用戶研究,將他們的圖像到視頻模型與Pika、Stable Video Diffusion(SVD)和Gen-2進(jìn)行比較。

請注意,SVD圖像到視頻模型不以文本為條件,因此研究人員將調(diào)查重點(diǎn)放在視頻質(zhì)量上。如上圖所示,與基線相比,研究人員的方法更受用戶青睞。